模型介紹

OpenAI再次推出開源模型,發布了兩款突破性的GPT-oss系列大模型,即GPT-oss-120b和GPT-oss-20b,為AI領域帶來了巨大的創新和發展潛力。這兩款模型不僅在性能上與現有的閉源模型媲美,而且在硬件適配性上具有明顯優勢,為開發者和企業提供了新的應用場景和商業機會。

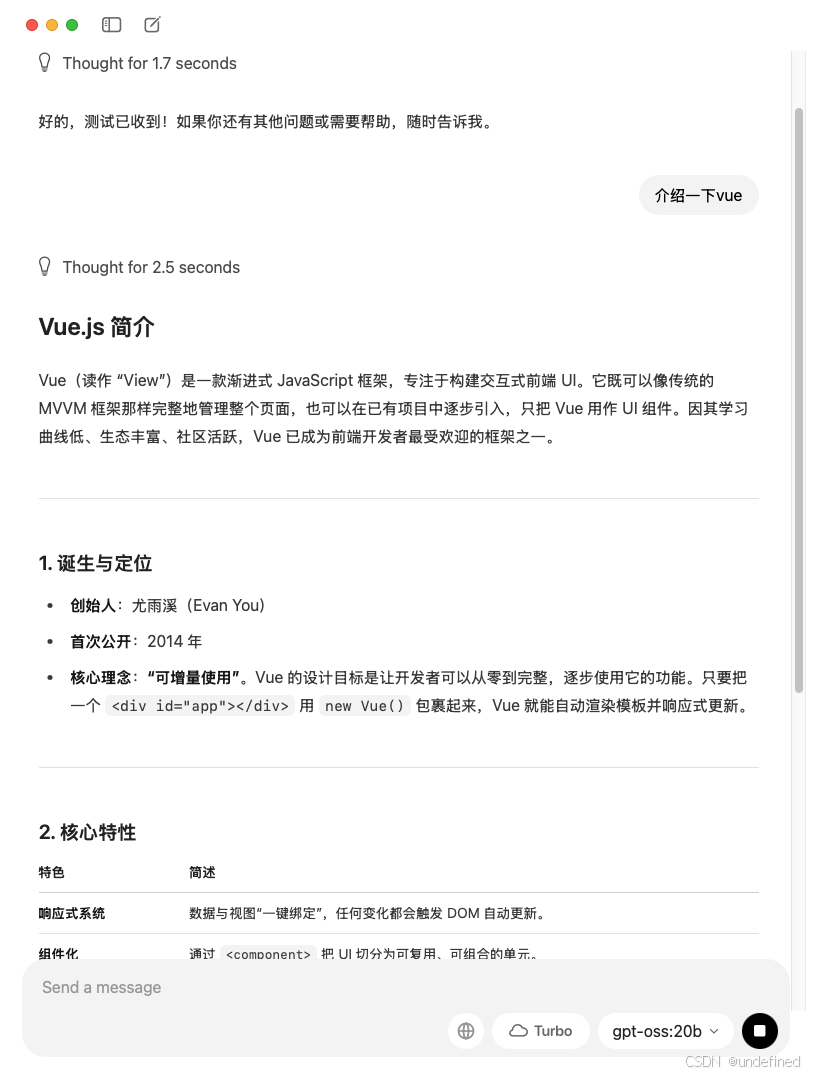

一、兩款模型的參數與性能特點

OpenAI這次開源的兩款大模型各有特色,針對不同硬件配置和應用需求提供了解決方案。

| 模型 | 參數量 | 架構 | 激活參數量 | 性能特點 | 硬件要求 |

|---|---|---|---|---|---|

| GPT-oss-120b | 1170億 | MoE(專家混合)架構 | 51億 | - 在Codeforces競賽編程和MMLU通用知識測試中超越o3-mini | - 單張80GB H100 GPU上運行,甚至高端游戲本可基本運行 |

- 在醫療健康(HealthBench)和競賽數學(AIME 2025)領域表現優于閉源的o4-mini | |||||

| GPT-oss-20b | 210億 | 常規架構 | 36億 | - 在M3 Pro芯片的MacBook Pro上,以23.72 token/秒生成貪吃蛇游戲代碼,性能接近o3-mini | - 僅需16GB內存設備即可驅動,適用于MacBook Pro、新款安卓手機等低配置設備 |

通過采用MoE架構,OpenAI成功實現了“參數規模”與“運行效率”的平衡,拓展了大模型的應用場景。

二、Apache 2.0 許可:商用與修改的寬松條件

與模型性能同樣值得關注的是開源許可條款。此次發布的兩款模型均采用Apache 2.0許可證,這意味著企業可以自由商用、修改代碼并進行二次分發,無需公開修改后的源代碼。相比Meta的Llama 3(限制非商業使用),Apache 2.0許可為企業商用提供了更為寬松的條件。不過需要注意的是,模型的訓練數據并未公開,盡管如此,開發者仍可基于現有模型進行微調與部署。

三、生態支持:多方合作助力推廣

為進一步推廣開源模型,OpenAI已與多個技術合作伙伴達成合作,推動模型應用的廣泛部署。

合作伙伴:Azure、AWS、Hugging Face、Ollama、NVIDIA等20多家企業。

- 模型下載與部署:開發者可以通過Hugging Face

下載模型權重,并在Ollama進行本地部署;微軟還推出了Windows GPU優化版,支持AMD和蘋果M系列芯片的原生運行。

離線能力:即使在斷網環境下,模型仍能調用本地工具(如Python解釋器)進行任務生成、數據運算等操作。

四、存在的爭議:幻覺率與安全風險

盡管GPT-oss系列模型在硬件適配和性能上表現出色,但仍存在一些問題需要改進。

- 幻覺率問題:在PersonQA

測試中,120b模型的錯誤信息比例高達49%,是o1模型的三倍,這對醫療、法律等要求高精度的場景來說是一個潛在的挑戰。

- 安全風險:由于Apache 2.0

的商用權限較寬松,可能會被濫用于生成垃圾信息或惡意代碼。OpenAI表示已經進行過多輪安全測試,但仍無法完全避免濫用情況的發生。

盡管如此,這一開源舉措無疑為AI行業注入了新的活力,打破了部分AI技術的壟斷格局,促進了技術的快速發展。

結語:為開發者與企業提供更多選擇

對于開發者而言,GPT-oss-20b模型可以幫助打造本地AI助手,提升工作效率;對于企業,GPT-oss-120b模型則為構建專屬大模型提供了可行的解決方案。這兩款模型為不同需求的用戶提供了新的選擇和機遇,推動AI領域向更廣泛的應用場景發展。

詳細信息與技術資源請訪問:

GitHub 地址:https://github.com/openai/gpt-oss

hugging face 地址:https://huggingface.co/openai/gpt-oss-20b

hugging face 地址:https://huggingface.co/openai/gpt-oss-120b

modelscope地址:https://modelscope.cn/models/openai-mirror/gpt-oss-20b/summary

modelscope地址:https://modelscope.cn/models/openai-mirror/gpt-oss-120b/summary

ollama 可視化下載模型方法

Ollama 與 OpenAI 合作,將其最新的先進開放權重模型引入 Ollama。20B和120B這兩個模型帶來了全新的本地聊天體驗,專為強大的推理能力、代理任務和多樣化的開發者用例而設計。

功能亮點

- Agentic 功能:

使用模型的原生功能進行函數調用、網頁瀏覽(Ollama 提供內置網頁搜索,可以選擇啟用該功能以使用最新信息擴充模型)、python 工具調用和結構化輸出。

- 完整的思路:

?完全訪問模型的推理過程,從而更輕松地進行調試并增強對輸出的信任。

- 可配置的推理力度:

根據您的具體用例和延遲需求輕松調整推理力度(低、中、高)。

- 可微調:

?通過參數微調完全根據您的特定用例定制模型。

- 寬松的 Apache 2.0 許可證:

自由構建,不受版權限制或專利風險 - 非常適合實驗、定制和商業部署。

量化 - MXFP4 格式

OpenAI 利用量化技術來減少 gpt-oss 模型的內存占用。這些模型在訓練后會將混合專家 (MoE) 權重量化為 MXFP4 格式,其中每個參數的權重被量化為 4.25 位。MoE 權重占總參數數量的 90% 以上,將這些權重量化為 MXFP4 格式后,較小的模型可以在內存低至 16GB 的系統上運行,而較大的模型則可以在單個 80GB 的 GPU 上運行。

Ollama 原生支持 MXFP4 格式,無需額外量化或轉換。Ollama 的新引擎已開發新內核,以支持 MXFP4 格式。

Ollama 與 OpenAI 合作,根據他們的參考實現進行基準測試,以確保 Ollama 的實現具有相同的質量。

20B參數模型

gpt-oss-20b模型專為低延遲、本地或特殊用例而設計。

120B參數模型

gpt-oss-120b該模型專為生產、通用、高推理用例而設計。

NVIDIA 與 Ollama 合作在 GeForce RTX 和 RTX PRO GPU 上加速 gpt-oss

NVIDIA 和 Ollama 正在深化合作,以提升 NVIDIA GeForce RTX 和 RTX PRO GPU 上的模型性能。此次合作使使用 RTX 的 PC 用戶能夠精準地利用 OpenAI 的 gpt-oss 模型的功能。

我們將繼續與 Ollama 合作,并不斷改進。未來,我們將發布一篇關于該模型的深入工程文章。

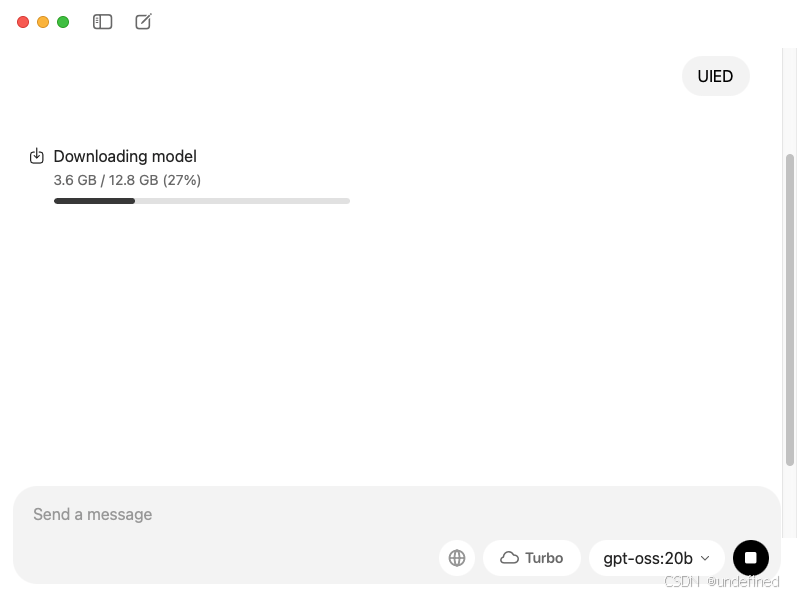

開始

1、下載最新的 Ollama 版本

2、安裝模型

3、使用教程

該模型可以直接在 Ollama 的新應用程序中或通過終端下載:

ollama 運行 gpt-oss:20b

ollama 運行 gpt-oss:120b

ollama卸載方法

https://www.uied.cn/circle/85234.html

寫在??最后

AI資料

AI學習平臺 uied.cn

AI免費工具 uiedtool.com

AI資訊熱榜 hot.uied.cn?

AI工具導航 hao.uied.cn/ai

)

-Java并發篇)

![[AI 生成] Spark 面試題](http://pic.xiahunao.cn/[AI 生成] Spark 面試題)