自2018年推出以來,BERT 徹底改變了自然語言處理領域。它在情感分析、問答、語言推理等任務中表現優異。借助雙向訓練和基于Transformer的自注意力機制,BERT 開創了理解文本中單詞關系的新范式。然而,盡管成績斐然,BERT 仍存在局限——在計算效率、長文本處理和可解釋性方面面臨挑戰。這推動了 ModernBERT 的研發,該模型專為解決這些痛點而生:它提升了處理速度、優化了長文本處理能力,還為開發者提供了更高透明度。本文將探索如何用 ModernBERT 開展情感分析,重點展現其特性與對 BERT 的改進。

學習目標

- BERT 簡介與 ModernBERT 誕生背景

- 理解 ModernBERT 的核心特性

- 通過情感分析示例實踐 ModernBERT 的落地

- ModernBERT 的局限性

- 什么是 BERT?

- 什么是 ModernBERT?

- BERT vs ModernBERT

- 理解 ModernBERT 的特性

- 使用 ModernBERT 進行情感分析

- ModernBERT 的局限性

- 結論

- 常見問題

什么是 BERT?

BERT(Bidirectional Encoder Representations from Transformers 的縮寫)自 2018 年由谷歌推出后,徹底改寫了自然語言處理的規則。它引入雙向訓練理念,讓模型能通過“全方位觀察上下文單詞”理解語義。這一創新讓 BERT 在問答、情感分析、語言推理等 NLP 任務中表現飛躍。

BERT 的架構基于“僅編碼器”的 Transformer:借助自注意力機制衡量句子中單詞的影響權重,且只有編碼器(只負責理解、編碼輸入,不生成/重建輸出)。正因如此,BERT 能精準捕捉文本的上下文關系,成為近年最具影響力、應用最廣的 NLP 模型之一。

什么是 ModernBERT?

盡管 BERT 取得了突破性成功,但其局限性也不容忽視:

- 計算資源:BERT 是計算與內存“雙密集”型模型,對實時應用或缺乏強大算力的場景極不友好。

- 上下文長度:BERT 的上下文窗口長度固定,處理長文檔等“長輸入”時力不從心。

- 可解釋性:模型復雜度遠高于簡單模型,調試與迭代難度大。

- 常識推理:BERT 缺乏常識推理能力,難以理解字面外的上下文、細微差別與邏輯關系。

BERT vs ModernBERT

| BERT | ModernBERT |

|---|---|

| 固定位置嵌入 | 采用旋轉位置嵌入(RoPE) |

| 標準自注意力 | Flash Attention 提升效率 |

| 上下文窗口長度固定 | 局部 - 全局交替注意力支持更長文本 |

| 復雜且可解釋性弱 | 可解釋性增強 |

| 主要基于英文文本訓練 | 主要基于英文與代碼數據訓練 |

ModernBERT 通過整合Flash Attention、Local - Global Alternating Attention 等高效算法,優化內存占用并提速;還引入旋轉位置嵌入(RoPE) 等技術,更高效處理長文本。

它通過“更透明、更易用”的設計增強可解釋性,降低開發者調試與適配門檻;同時融入常識推理能力,更擅長理解“顯性信息外”的上下文與邏輯。此外,ModernBERT 適配 NVIDIA T4、A100、RTX 4090 等主流 GPU。

訓練數據方面,ModernBERT 覆蓋網頁文檔、代碼、科學論文等英文源,基于2 萬億個唯一標記訓練(遠超傳統編碼器的 20 - 40 次重復訓練)。

發布版本包含:

- ModernBERT - base:22 層,1.49 億參數

- ModernBERT - large:28 層,3.95 億參數

理解 ModernBERT 的特性

Flash Attention

這是為加速 Transformer 注意力機制而研發的新算法,通過重排計算流程 + 分塊(tiling) + 重計算(recomputation) 優化時間與內存:

- 分塊:將大數據拆分為可處理的小單元;

- 重計算:按需復用中間結果,減少內存占用。

這讓注意力的“二次方級內存消耗”降至“線性級”,長序列處理效率飆升;計算開銷也顯著降低,速度比傳統注意力快 2 - 4 倍。Flash Attention 同時加速訓練與推理。

局部 - 全局交替注意力(Local - Global Alternating Attention)

ModernBERT 最具創新性的設計之一是交替注意力(而非全全局注意力):

- 每 3 層后,對“完整輸入”執行全局注意力;

- 其余層采用滑動窗口局部注意力:每個標記僅關注“最近 128 個標記”。

旋轉位置嵌入(RoPE)

RoPE(Rotary Positional Embeddings)是 Transformer 的位置編碼技術:用旋轉矩陣編碼標記位置,同時整合“絕對 + 相對位置信息”,讓注意力機制理解標記的“順序與距離”。

去填充與序列打包(Unpadding and Sequencing)

這兩項技術專為優化內存與計算效率設計:

- 去填充:傳統“填充”為對齊序列長度會添加無意義標記,增加無效計算;去填充則移除冗余填充標記,減少算力浪費。

- 序列打包:將文本批次重組為緊湊形式,把短序列分組以最大化硬件利用率。

使用 ModernBERT 進行情感分析

我們將實戰“用 ModernBERT 做情感分析”——情感分析是文本分類的子任務,目標是將文本(如影評)分為“正面/負面”。

數據集:IMDb 電影評論數據集(分類影評情感)

注意:

- 我在 Google Colab 中使用 A100 GPU 加速訓練,更多細節參考: [answerdotai/ModernBERT - base](https://huggingface.co/answerdotai/ModernBERT - base)*。

- 訓練需 wandb API 密鑰,可在 Weight and Biases* 生成。

步驟 1:安裝必要庫

安裝 Hugging Face Transformers 生態工具:

# 安裝庫

!pip install git+https://github.com/huggingface/transformers.git datasets accelerate scikit-learn -Uqq

!pip install -U transformers>=4.48.0import torch

from transformers import AutoTokenizer, AutoModelForSequenceClassification, TrainingArguments, Trainer, AutoModelForMaskedLM, AutoConfig

from datasets import load_dataset

步驟 2:加載 IMDb 數據集

用 load_dataset 加載數據集,imdb["test"][0] 會打印測試集第一條樣本(影評 + 標簽):

# 加載數據集

from datasets import load_dataset

imdb = load_dataset("imdb")

# 打印第一個測試樣本

imdb["test"][0]

(打印第一個測試樣本)

步驟 3:標記化(Tokenization)

用預訓練的 ModernBERT - base 標記器,將文本轉成模型可理解的數值輸入。tokenized_test_dataset[0] 會打印標記化后測試集首條樣本(含輸入 ID、標簽等):

# 初始化標記器和模型

tokenizer = AutoTokenizer.from_pretrained("answerdotai/ModernBERT-base")

model = AutoModelForMaskedLM.from_pretrained("answerdotai/ModernBERT-base")# 定義標記器函數

def tokenizer_function(example):return tokenizer(example["text"],padding="max_length",truncation=True,max_length=512, ## 最大長度可修改return_tensors="pt")# 標記化訓練集與測試集

tokenized_train_dataset = imdb["train"].map(tokenizer_function, batched=True)

tokenized_test_dataset = imdb["test"].map(tokenizer_function, batched=True)# 打印標記化后測試集第一個樣本

print(tokenized_test_dataset[0])

(標記化數據集的第一個樣本)

步驟 4:初始化情感分類模型

# 初始化模型配置與模型

config = AutoConfig.from_pretrained("answerdotai/ModernBERT-base")

model = AutoModelForSequenceClassification.from_config(config)

步驟 5:準備數據集

刪除冗余列(如文本)、重命名標簽列為 labels:

# 數據準備

train_dataset = tokenized_train_dataset.remove_columns(['text']).rename_column('label', 'labels')

test_dataset = tokenized_test_dataset.remove_columns(['text']).rename_column('label', 'labels')

步驟 6:定義評估指標(F1 分數)

用 f1_score 衡量模型性能,定義函數處理預測與真實標簽:

import numpy as np

from sklearn.metrics import f1_score# 指標計算函數

def compute_metrics(eval_pred):predictions, labels = eval_predpredictions = np.argmax(predictions, axis=1)score = f1_score(labels, predictions, labels=labels, pos_label=1, average="weighted")return {"f1": float(score) if score == 1 else score}

步驟 7:設置訓練參數(Training Arguments)

用 TrainingArguments 定義超參數(批量大小、學習率、輪數等):

# 定義訓練參數

train_bsz, val_bsz = 32, 32

lr = 8e-5

betas = (0.9, 0.98)

n_epochs = 2

eps = 1e-6

wd = 8e-6training_args = TrainingArguments(output_dir=f"fine_tuned_modern_bert",learning_rate=lr,per_device_train_batch_size=train_bsz,per_device_eval_batch_size=val_bsz,num_train_epochs=n_epochs,lr_scheduler_type="linear",optim="adamw_torch",adam_beta1=betas[0],adam_beta2=betas[1],adam_epsilon=eps,logging_strategy="epoch",eval_strategy="epoch",save_strategy="epoch",load_best_model_at_end=True,bf16=True,bf16_full_eval=True,push_to_hub=False,

)

步驟 8:模型訓練

用 Trainer 類封裝模型、參數、數據集與評估函數,執行訓練:

# 創建 Trainer 實例

trainer = Trainer(model=model, # 預訓練模型args=training_args, # 訓練參數train_dataset=train_dataset, # 標記化訓練集eval_dataset=test_dataset, # 標記化測試集compute_metrics=compute_metrics, # (重要!否則無 F1 分數輸出)

)

(損失結果與 F1 分數)

步驟 9:模型評估

在測試集上評估訓練后模型:

# 評估模型

evaluation_results = trainer.evaluate()

print("評估結果:", evaluation_results)

步驟 10:保存微調模型

保存模型與標記器,便于后續復用:

# 保存模型與標記器

model.save_pretrained("./saved_model")

tokenizer.save_pretrained("./saved_model")

步驟 11:預測新文本情感

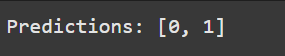

0 = 負面,1 = 正面。示例中 “這部電影很無聊” 應輸出 0,“精彩絕倫” 輸出 1:

# 示例輸入

new_texts = ["這部電影很無聊", "精彩絕倫"]# 標記化輸入

inputs = tokenizer(new_texts, padding=True, truncation=True, return_tensors="pt")# 設備對齊 + 推理模式

inputs = inputs.to(model.device)

model.eval()# 推理

with torch.no_grad():outputs = model(**inputs)logits = outputs.logitspredictions = torch.argmax(logits, dim=1)print("預測結果:", predictions.tolist())

(新示例的預測結果)

ModernBERT 的局限性

盡管 ModernBERT 對 BERT 有諸多改進,仍存在不足:

- 訓練數據偏差:僅基于英文與代碼數據訓練,對其他語言/非代碼文本的適配性差。

- 復雜度:Flash Attention、RoPE 等技術讓模型更復雜,落地與微調門檻升高。

- 推理速度:Flash Attention 雖提升了推理效率,但使用 8192 長度的完整窗口時,速度仍有瓶頸。

結論

ModernBERT 以 BERT 為基石,在處理速度、長文本支持、可解釋性上實現突破。盡管仍面臨“訓練數據偏差”“復雜度”等挑戰,它仍是 NLP 領域的重大飛躍——為情感分析、文本分類等任務打開新可能,讓前沿語言理解更高效、更易觸達。

關鍵要點

- ModernBERT 針對性解決 BERT 的“低效”“上下文受限”等痛點。

- 依托 Flash Attention、RoPE 實現“更快處理 + 更長文本支持”。

- 是情感分析、文本分類等任務的優質選擇。

- 仍存在“英文/代碼數據偏向”等局限。

- Hugging Face、wandb 等工具降低了落地門檻。

:Vue+Element UI 深度選擇器實現表單元素精準對齊的技術實踐)

)

問題的完整調試過程:CPU指令集兼容性探秘)

)

)