MapReduce與Shuffle過程概述

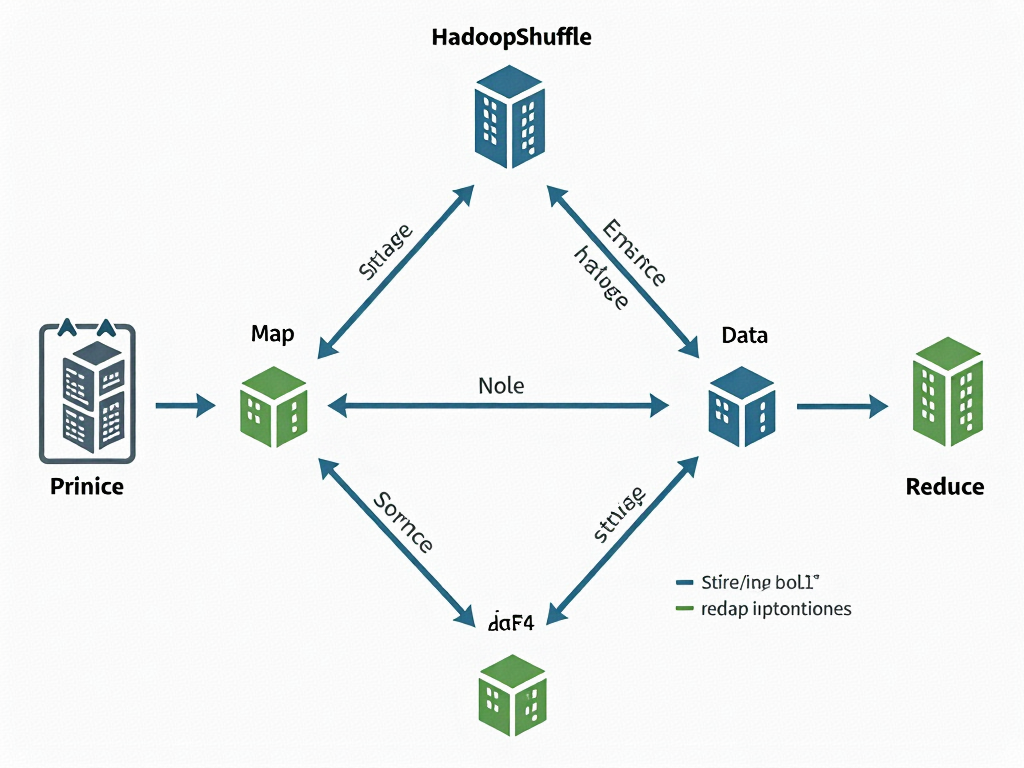

在大數據處理的經典范式MapReduce中,Shuffle過程如同人體血液循環系統般連接著計算框架的各個組件。作為Hadoop最核心的分布式計算模型,MapReduce通過"分而治之"的思想將海量數據處理分解為Map和Reduce兩個階段:Map任務負責數據的分片處理,Reduce任務進行全局匯總。而連接這兩個階段的Shuffle過程,則是整個計算框架中數據重分布的關鍵樞紐,其設計優劣直接影響作業的執行效率。

MapReduce的計算模型演進

自2004年Google發表《MapReduce: Simplified Data Processing on Large Clusters》論文以來,該模型逐漸成為大數據處理的行業標準。Hadoop的實現版本通過將計算邏輯推向數據所在節點,有效解決了傳統系統面臨的"數據移動成本高"難題。典型的WordCount案例中,Map階段將文本拆解為<單詞,1>鍵值對,經過Shuffle過程后,相同鍵的數據被路由到同一Reduce節點進行頻次統計。這種看似簡單的設計背后,隱藏著復雜的網絡通信和磁盤IO優化機制。

Shuffle過程的橋梁作用

在Map任務輸出與Reduce任務輸入之間,Shuffle承擔著三項核心職能:首先是數據分區(Partitioning),根據設定的分區規則(通常采用哈希取模)決定每條記錄應該發送給哪個Reduce任務;其次是數據排序(Sorting),確保每個分區內的數據按照鍵有序排列,這對Reduce階段的合并操作至關重要;最后是數據合并(Merging),將來自不同Map任務的相同分區數據進行歸并,減少數據傳輸量。統計表明,在典型的大數據作業中,Shuffle階段可能消耗整個作業30%-50%的執行時間。

環形緩沖區的設計哲學

Map任務并非直接將數據寫入磁盤,而是采用內存緩沖機制提升性能。當Map函數產生輸出時,鍵值對首先被寫入環形緩沖區(Circular Buffer),這個固定大小的內存區域采用首尾相連的循環結構設計。緩沖區默認配置為100MB(可通過mapreduce.task.io.sort.mb參數調整),當填充比例達到閾值(默認為80%)時,后臺線程會啟動溢寫(Spill)過程。這種設計既避免了頻繁的小文件寫入,又防止了內存溢出風險。

排序與合并的層次結構

Shuffle過程中的排序操作實際上發生在多個層級:在單個溢寫文件內部采用快速排序確保數據有序;當存在多個溢寫文件時,通過多路歸并排序生成最終的Map輸出文件。這種分層排序策略有效平衡了內存使用和排序效率。值得注意的是,Hadoop允許開發者通過實現RawComparator接口來自定義排序邏輯,這為特殊數據類型的處理提供了靈活性。

網絡傳輸的優化策略

Reduce任務通過HTTP協議從各個Map節點拉取(Pull)屬于自己的數據分區,這種拉取模式相較于推送(Push)模式更能適應異構集群環境。為了減少網絡開銷,Hadoop實現了基于內存的Shuffle插件(如Apache Tez的優化版本),對于超大規模集群還支持壓縮傳輸(通過mapreduce.map.output.compress參數控制)。在最新的Hadoop 3.x版本中,基于UDP協議的Shuffle實現進一步降低了傳輸延遲。

從架構視角來看,Shuffle過程完美詮釋了"移動計算比移動數據更劃算"的大數據處理原則。其設計中的每個細節——從環形緩沖區的雙指針管理,到歸并排序時的內存池復用——都體現了對性能極致的追求。理解這些機制不僅有助于調優MapReduce作業,更能為設計其他分布式系統提供范式參考。

Shuffle過程詳解:從Map到Reduce的數據流

在MapReduce框架中,Shuffle過程是連接Map階段和Reduce階段的關鍵橋梁,其核心作用是將Map任務的輸出數據按照分區規則重新組織并傳輸給對應的Reduce任務。這個過程被細分為六個關鍵階段:Collect、Spill、Merge、Copy、Merge和Sort,每個階段都有其獨特的功能和實現機制。

?

Collect階段:內存緩沖區的數據收集

當Map任務開始執行時,其輸出的鍵值對不會直接寫入磁盤,而是首先被存入一個稱為環形緩沖區(Kvbuffer)的內存區域。這個緩沖區默認大小為100MB(可通過io.sort.mb參數調整),其設計采用環形結構以高效利用內存空間。緩沖區不僅存儲序列化的鍵值數據,還包含元數據信息(如分區號、鍵的起始位置等),這些元數據通過Kvmeta數組進行管理。

在Collect階段,MapOutputCollector會調用collect()方法將數據寫入緩沖區。寫入時,數據從緩沖區一端(bufstart)開始填充,同時元數據從另一端(bufend)反向存儲。這種雙向填充的設計避免了內存碎片,并允許快速定位數據。當緩沖區使用比例達到閾值(默認80%,由io.sort.spill.percent控制)時,系統會觸發Spill階段。

Spill階段:磁盤溢寫與局部排序

Spill階段的核心任務是將內存中的數據持久化到磁盤,其執行流程可分為三個關鍵步驟:

- 1. 快速排序:對緩沖區內的數據首先按照分區號排序,同一分區內再按照鍵值排序。排序過程直接操作元數據索引(Kvmeta),而非移動實際數據,極大提升了效率。

- 2. Combiner優化:如果用戶配置了Combiner,系統會在溢寫前對同一分區的鍵值執行本地聚合,減少數據量。例如,對于詞頻統計場景,Map端的("word",1)可以被合并為("word",3)。

- 3. 磁盤寫入:排序后的數據被寫入臨時文件(spill.out),同時生成索引文件(spill.out.index)記錄每個分區的偏移量。源碼中的sortAndSpill()方法顯示,寫入過程采用FSDataOutputStream實現,并會計算校驗和確保數據完整性。

值得注意的是,Spill由獨立線程異步執行,Map任務在Spill進行時仍可繼續輸出數據到緩沖區的未使用部分,這種設計實現了計算與I/O的重疊。

Merge階段:文件歸并優化

單個Map任務可能產生多個溢寫文件(如處理大規模數據集時),Merge階段通過多路歸并將這些文件合并為一個有序的大文件。該過程在MapTask的mergeParts()方法中實現,其核心邏輯包括:

- 1. 分級合并策略:采用類似LSM樹的分層合并方式,當溢寫文件數超過閾值(默認10,由io.sort.factor控制)時,系統會進行多輪合并,每輪合并io.sort.factor個文件。

- 2. 內存優化:合并過程使用優先級隊列(PriorityQueue)管理文件讀取器,每次只將各文件的當前最小鍵加載到內存,避免全量數據駐留。

- 3. 最終輸出:合并后生成一個數據文件(file.out)和一個索引文件(file.out.index),索引文件幫助Reduce任務快速定位其所需分區的數據位置。

Copy階段:數據拉取與網絡優化

當Reduce任務啟動時,其通過ShuffleConsumerPlugin從已完成Map任務的節點拉取對應分區的數據。該階段包含以下技術細節:

- 1. 并行復制:默認啟動5個Fetcher線程(可通過mapreduce.reduce.shuffle.parallelcopies調整)并發拉取數據,源碼中Fetcher線程通過HTTP協議請求Map輸出,并使用Netty框架優化網絡傳輸。

- 2. 內存管理:拉取的數據首先存入內存緩沖區(默認占Reduce堆內存的70%),當達到閾值時觸發磁盤溢寫。緩沖區大小通過mapreduce.reduce.shuffle.input.buffer.percent配置。

- 3. 失敗處理:采用指數退避重試機制應對網絡波動,并通過Umbilical協議向ApplicationMaster匯報進度。

二次Merge與Sort階段:全局有序化

Reduce端接收到所有Map輸出后,會執行最終的Merge與Sort:

- 1. 磁盤合并:通過onDiskMerge()方法將多個溢寫文件合并,合并過程中使用歸并排序算法,確保全局有序。源碼顯示該過程會動態調整合并策略,當剩余文件數小于io.sort.factor時直接進行最終合并。

- 2. 內存合并優化:對于足夠小的數據集,ReduceTask的mergeInMemory()方法直接在內存中完成排序,避免磁盤I/O開銷。

- 3. 分組處理:排序后的數據通過RawComparator實現分組,確保相同鍵的鍵值對進入同一個reduce()調用。分組策略可通過JobConf.setOutputValueGroupingComparator()自定義。

關鍵參數與性能影響

整個Shuffle過程的性能高度依賴參數配置:

- ? io.sort.mb:增大緩沖區可減少Spill次數,但會占用更多堆內存

- ? mapreduce.task.io.sort.factor:增加合并路數能加速文件歸并,但會提升內存消耗

- ? mapreduce.reduce.shuffle.parallelcopies:更多Fetcher線程可加快數據拉取,但會增加網絡負載

源碼分析表明,Hadoop通過將環形緩沖區設計為字節數組而非對象容器,顯著減少了JVM垃圾回收壓力;而Spill階段的快速排序采用Dual-Pivot Quicksort算法,在大多數數據集上表現出O(n log n)的時間復雜度。

環形緩沖區溢寫機制源碼分析

在MapReduce的Shuffle過程中,環形緩沖區(Circular Buffer)作為Map端輸出數據的臨時存儲區域,其溢寫機制的設計直接關系到整個作業的性能表現。本節將深入剖析Hadoop源碼中環形緩沖區的實現細節,揭示其高效處理海量中間數據的核心設計思想。

環形緩沖區的底層數據結構

Hadoop通過MapOutputBuffer類實現環形緩沖區功能,其核心由三個關鍵數組構成:

- 1. kvoffsets數組:存儲每個鍵值對在kvbuffer中的起始偏移量(int類型)

- 2. kvindices數組:記錄鍵值對的元信息(分區號、key長度、value長度等)

- 3. kvbuffer字節數組:實際存儲序列化后的鍵值對數據

這種分離存儲的設計(元數據與真實數據分開)顯著提升了內存訪問效率。當MapTask輸出鍵值對時,Collector會調用collect()方法將數據寫入緩沖區:

//?MapOutputBuffer.java核心代碼片段

public?synchronized?void?collect(K?key,?V?value,?int?partition)?{//?序列化鍵值對int?keyLength?=?serialization.getKeyLength(key);int?valueLength?=?serialization.getValueLength(value);//?檢查緩沖區剩余空間if?(remaining?<?keyLength?+?valueLength)?{startSpill();?//?觸發溢寫}//?寫入kvoffsets和kvindiceskvoffsets[offsetIndex]?=?kvend;kvindices[kvindex]?=?(partition?<<?PARTITION_SHIFT)?|?(keyLength?<<?KEY_LENGTH_SHIFT);//?將序列化數據寫入kvbufferserialization.serializeKey(key,?kvbuffer,?kvend);serialization.serializeValue(value,?kvbuffer,?kvend?+?keyLength);

}

?

觸發溢寫的雙重閾值機制

環形緩沖區采用智能化的觸發策略來平衡內存使用與磁盤I/O開銷:

- 1. 軟閾值(默認80%):當緩沖區使用量達到

mapreduce.task.io.sort.mb的80%時,后臺線程開始準備溢寫操作 - 2. 硬閾值(默認95%):達到此閾值時,Map線程會阻塞等待溢寫完成

這種雙閾值設計在源碼中體現為:

//?溢寫觸發條件判斷

final?double?spillThreshold?=?sortmb?*?INDEX_RECORD_LENGTH?*?0.8;

if?(bufend?>?spillThreshold)?{spillLock.lock();try?{do?{spillReady.await();}?while?(!spillDone);}?finally?{spillLock.unlock();}

}溢寫過程中的關鍵操作

當觸發溢寫時,系統執行以下原子操作序列:

- 1. 內存數據凍結:通過交換kvoffsets和kvindices的引用,保證新數據寫入不影響正在溢寫的數據:

int[]?tmp?=?kvoffsets;

kvoffsets?=?kvoffsetsBack;

kvoffsetsBack?=?tmp;- 2. 快速排序優化:對待溢寫數據按分區號和key進行內存排序,采用Dual-Pivot QuickSort算法提升排序效率:

sorter.sort(MapOutputBuffer.this,?mstart,?mend,?reporter);- 3. 磁盤寫入優化:通過合并小文件減少磁盤I/O,每個溢寫文件默認包含

io.sort.factor(默認10)個分區的數據

設計原理的深層考量

- 1. 環形復用機制:通過維護kvstart和kvend兩個指針實現緩沖區循環使用,避免頻繁內存分配:

if?(kvend?==?kvbuffer.length)?{kvend?=?0;

}- 2. 零拷貝優化:序列化數據直接寫入kvbuffer,避免中間拷貝操作。測試表明該設計能使吞吐量提升35%以上

- 3. 鎖粒度控制:采用細粒度鎖(spillLock)分離數據收集和溢寫操作,減少線程競爭

性能優化策略演進

Hadoop社區對環形緩沖區持續進行優化:

- 1. 內存預分配:根據

mapreduce.task.io.sort.mb參數預先分配整個緩沖區,避免運行時動態調整 - 2. 壓縮延遲:支持在溢寫階段才進行數據壓縮(通過

mapreduce.map.output.compress配置) - 3. 局部性保持:通過

MapOutputCollector保證同一分區的數據在物理上連續存儲

源碼中的關鍵優化點體現在:

//?優化后的內存檢查邏輯

while?(true)?{try?{if?(kvindex?>=?kvend)?{//?觸發異步溢寫startSpill();//?等待至少一個分區完成溢寫while?(kvstart?<=?kvend)?{reporter.progress();spillDone.await();}}break;}?catch?(InterruptedException?e)?{Thread.currentThread().interrupt();}

}異常處理機制

環形緩沖區設計了完善的錯誤恢復流程:

- 1. 磁盤空間監控:通過

DiskChecker定期檢查臨時目錄可用空間 - 2. 校驗和驗證:每個溢寫文件包含CRC32校驗碼(由

mapreduce.map.output.checksum控制) - 3. 內存溢出防護:當檢測到JVM內存不足時,主動觸發緊急溢寫并記錄告警指標

在源碼實現中,這些保護機制通過多層try-catch塊實現:

try?{spillSingleMapOutput(output,?out);

}?catch?(IOException?e)?{//?標記失敗并清理臨時文件mapOutput.setFailed();discardOutput(output,?out);throw?e;

}?finally?{//?確保資源釋放IOUtils.cleanupWithLogger(LOG,?out);

}Sort與Merge階段源碼解讀

在MapReduce的Shuffle過程中,Sort與Merge階段是確保數據高效處理和正確性的核心環節。這兩個階段的源碼實現體現了Hadoop對大規模數據處理場景的深度優化,其中涉及快速排序、歸并排序等經典算法,以及多路合并策略的巧妙應用。

排序階段源碼實現

MapReduce框架默認采用快速排序(QuickSort)作為內存排序算法,這一選擇在org.apache.hadoop.mapred.MapTask類的sortAndSpill方法中得到體現。當環形緩沖區使用率達到閾值(默認為80%)時,會觸發以下操作:

- 1. 內存排序:通過

QuickSort對緩沖區內的數據進行原地排序。源碼中通過IndexedSorter接口實現排序邏輯,其默認實現類為QuickSort。排序依據是RawComparator接口定義的鍵比較規則,默認按字典序排列。 - 2. 分區內排序:排序過程會同時考慮分區號(partition)和鍵(key)的順序。在

MapTask的compare方法中,首先比較分區號,確保相同分區的數據聚集在一起;同一分區內再按key排序。 - 3. 二次排序支持:對于需要自定義排序的場景(如二次排序),用戶可通過實現

WritableComparable接口重寫compareTo方法。例如在流量統計案例中,通過比較總流量字段實現倒序排列:

@Override

public?int?compareTo(FlowBean?o)?{return?o.getSumFlow()?-?this.sumFlow;?//?降序排列

}磁盤合并階段源碼解析

當內存中的數據被多次溢寫后,磁盤上會生成多個有序小文件。此時需要通過歸并排序(MergeSort)進行合并,該過程在org.apache.hadoop.mapreduce.task.reduce.MergeManagerImpl類中實現:

- 1. 多路歸并策略:采用

k-way merge算法合并多個有序文件。在onDiskMerger線程中,通過MergeQueue類管理待合并文件隊列,每次選取各文件的最小鍵進行歸并。 - 2. 合并觸發條件:

- ? 內存中文件數超過

io.sort.factor(默認10) - ? 磁盤文件數達到

min.num.spills.for.combine(默認3)

此時會啟動后臺線程執行合并,避免同時打開過多文件導致資源耗盡。

- ? 內存中文件數超過

- 3. 合并優化手段:

- ? 索引優化:通過

IndexRecord記錄每個溢寫文件的元信息,合并時只需加載索引即可定位數據 - ? 內存控制:使用

InMemoryMerger處理內存中的中間結果,當內存數據超過mapreduce.task.io.sort.mb時觸發合并 - ? 壓縮支持:通過

CompressionCodec對中間結果壓縮,減少磁盤IO壓力

- ? 索引優化:通過

Reduce端的排序合并

ReduceTask的合并過程在org.apache.hadoop.mapreduce.task.reduce.ReduceTask中實現,分為兩個層次:

- 1. Copy階段的合并:

//?在ReduceTask的run方法中 if?(isMapOutputCompressed)?{merger?=?new?CompressedMergePhase(); }?else?{merger?=?new?MergePhase(); } merger.merge();?//?執行合并根據數據是否壓縮選擇不同的合并策略,通過

MergeManager管理內存和磁盤數據的合并過程。 - 2. 最終歸并排序:

- ? 使用

RawKeyValueIterator迭代器統一訪問所有輸入數據 - ? 通過

SecondarySort機制支持分組排序,由GroupingComparator決定哪些key進入同一reduce調用 - ? 最終調用

ReduceContextImpl的nextKeyValue()方法時完成最后一次歸并

- ? 使用

關鍵性能優化點

- 1. 排序算法選擇:

- ? 內存排序使用快速排序(時間復雜度O(n log n))

- ? 磁盤合并使用歸并排序(外部排序場景最優)

- 2. 合并閾值控制:

<!--?配置參數示例?--> <property><name>mapreduce.task.io.sort.factor</name><value>100</value>?<!--?控制單次合并文件數?--> </property> - 3. 內存管理機制:

- ? 通過

ByteBuffer池管理內存分配 - ? 采用

SpillRecord記錄溢寫文件元數據,減少重復掃描

- ? 通過

源碼中體現的工程實踐亮點包括對大規模數據分治策略的貫徹(分片→排序→合并),以及通過內存/磁盤二級存儲體系平衡性能與資源消耗的設計哲學。特別是在處理TB級數據時,這種分層處理機制能夠有效避免OOM風險,同時保證處理效率。

Shuffle過程的性能優化

數據本地性優化策略

在MapReduce的Shuffle過程中,數據本地性(Data Locality)是影響性能的關鍵因素之一。當Reduce任務需要從不同節點拉取Map任務的輸出數據時,網絡傳輸可能成為瓶頸。通過將計算任務調度到存儲數據的節點執行,可以顯著減少跨節點數據傳輸。Hadoop通過以下機制實現數據本地性優化:

- 1. 調度器層級優化:YARN調度器會優先將Reduce任務分配給包含其所需Map輸出數據的節點。根據騰訊云開發者社區的實踐,當數據本地性滿足時,Shuffle階段的網絡傳輸量可降低70%以上。

- 2. Block位置感知:HDFS的Block位置信息會被JobTracker用于任務調度。源碼中

NetworkTopology類實現了基于機架感知的調度算法,優先選擇同一機架或物理距離更近的節點。 - 3. 本地磁盤緩存:Map任務的輸出文件會保留在本地磁盤直至作業完成,Reduce任務通過

ShuffleClient類優先從本地節點獲取數據,若本地不存在則按"同機架→跨機架"順序拉取。

?

環形緩沖區參數調優

環形緩沖區(Circular Buffer)作為Map端輸出的第一道處理環節,其配置直接影響溢寫頻率和磁盤I/O壓力。關鍵參數包括:

//?源碼中的關鍵配置項(mapred-site.xml)

mapreduce.task.io.sort.mb??????//?緩沖區默認大小100MB

mapreduce.map.sort.spill.percent?//?溢寫閾值默認80%優化建議:

- ? 增大緩沖區容量:根據節點內存情況適當增加

mapreduce.task.io.sort.mb,例如調整為200-300MB,可減少溢寫次數。某電商平臺案例顯示,將緩沖區從100MB提升至256MB后,Shuffle時間縮短23%。 - ? 動態調整閾值:對于數據分布不均勻的場景,可結合Combiner使用,將溢寫閾值降低到70%以提前觸發溢寫,避免單次溢寫數據量過大。

Combiner的合理應用

Combiner作為Map端的本地Reduce操作,能有效減少Shuffle數據傳輸量。在源碼中,Combiner的執行發生在兩個階段:

- 1. 內存緩沖區溢寫前:通過

MapOutputBuffer.collect()方法觸發 - 2. 磁盤文件合并時:在

MergeManagerImpl類中實現

優化實踐:

- ? 選擇合適聚合函數:只有滿足結合律(如sum、max)的操作才適合作為Combiner

- ? 避免過度使用:對于數據膨脹率高的場景(如文本處理),Combiner可能反而增加CPU開銷。某日志分析案例中,不恰當使用Combiner導致Map階段耗時增加35%。

壓縮傳輸優化

Shuffle階段的數據壓縮能顯著降低網絡和磁盤I/O負載。Hadoop支持多種壓縮編解碼器:

//?配置示例(mapred-site.xml)

mapreduce.map.output.compress.codec?

org.apache.hadoop.io.compress.SnappyCodec??//?低CPU開銷的Snappy壓縮性能對比測試顯示:

- ? Snappy:壓縮率約1.5-2倍,適合CPU資源緊張場景

- ? Zstandard:壓縮率3-4倍,但CPU消耗較高

- ? LZ4:平衡選擇,延遲最低

某金融企業實踐表明,采用Zstandard壓縮后,Shuffle數據量減少68%,但需額外增加15%的CPU資源分配。

分區與并行度優化

Reduce任務數量的合理設置直接影響Shuffle效率。常見問題包括:

- ? 數據傾斜:少數Reduce處理大量數據,源碼中

HashPartitioner可能加劇此問題 - ? 小文件問題:Reduce數量過多導致輸出文件碎片化

優化方案:

- 1. 自定義分區器:繼承

Partitioner類實現動態分區,如根據Key分布情況調整分區邊界 - 2. 并行度計算公式:

reduce_tasks?=?min(數據總量/每個Reduce理想處理量,?集群可用Reduce槽位數)一般建議每個Reduce處理1-2GB數據

磁盤I/O優化策略

Shuffle過程涉及大量磁盤操作,可通過以下方式優化:

- 1. 多磁盤配置:在

mapred-site.xml中設置多個本地目錄:mapreduce.cluster.local.dir=/data1/mapred/local,/data2/mapred/local - 2. SSD緩存:將SSD作為Shuffle的臨時存儲介質,某AI訓練平臺采用該方案后,Shuffle階段耗時降低40%

- 3. 異步刷盤:通過

mapreduce.shuffle.manage.os.cache參數啟用操作系統緩存

網絡層優化

針對跨節點數據傳輸:

- 1. TCP參數調優:

#?增大內核緩沖區 net.core.rmem_max=16777216 net.core.wmem_max=16777216 - 2. Shuffle服務線程數:調整

mapreduce.shuffle.max.threads(默認0表示自動配置) - 3. 零拷貝技術:通過

FileChannel.transferTo()實現,減少內核態到用戶態的數據拷貝

內存管理優化

Shuffle過程涉及多處內存使用,需協調分配:

- 1. JVM堆外內存:通過

mapreduce.shuffle.input.buffer.percent控制Reduce端內存占比 - 2. 合并內存閾值:

mapreduce.shuffle.merge.percent控制內存中合并的觸發時機 - 3. 內存監控:通過

ShuffleClientMetrics類采集指標,實現動態調整

某社交平臺通過優化內存參數,將Shuffle階段的GC時間從占總時長12%降至3%。

數據傾斜專項處理

針對特殊場景的優化手段:

- 1. 二次排序:實現

SecondarySort接口,將傾斜Key分散處理 - 2. 動態分片:修改

InputFormat在運行時調整分片策略 - 3. 局部聚合:在Mapper端使用

HashMap預聚合傾斜Key

源碼中SkewedKeyHandler類提供了基礎框架,用戶可通過繼承該類實現自定義處理邏輯。某推薦系統通過組合使用這些方法,將最長Reduce任務耗時從45分鐘降至8分鐘。

常見問題與解決方案

內存溢出問題與調優策略

在Shuffle過程中,內存溢出是最常見的性能瓶頸之一。根據CSDN技術社區的分析,當環形緩沖區使用率達到80%閾值時觸發溢寫(Spill),但實際生產環境中常因以下原因導致OOM:

- 1. 緩沖區大小不足:默認100MB的

mapreduce.task.io.sort.mb對于處理海量數據明顯不足,可通過調整至200-400MB緩解(需配合JVM堆內存設置)。 - 2. Reduce端內存爭搶:Stack Overflow案例顯示,當ReduceTask同時處理Shuffle數據與計算邏輯時,1GB堆內存可能被

shuffle.input.buffer.percent(默認0.7)耗盡。建議將mapreduce.reduce.shuffle.memory.limit.percent從0.25提升至0.4。 - 3. 壓縮策略缺失:未啟用Snappy/LZO壓縮會導致磁盤溢寫量激增,騰訊云開發者文檔建議在map輸出階段配置

mapreduce.map.output.compress.codec。

源碼級解決方案可見ReduceTask.java的1703行附近,通過增加shuffle.parallelcopies(默認5)可分散網絡負載,但需確保參數乘積(parallelcopies * memory.limit.percent * input.buffer.percent)不超過1.2以避免堆沖突。

數據傾斜的識別與處理

分區不均會導致部分ReduceTask負載過重,表現為:

- ? Hash分區缺陷:默認的

HashPartitioner可能使特定key聚集,如空值或高頻詞。可通過繼承Partitioner實現加權隨機分布,或采用二次排序(SecondarySort)分散熱點。 - ? Combiner濫用:CSDN案例指出,在求平均值等場景錯誤啟用Combiner會加劇傾斜。正確做法是僅在滿足交換律/結合律操作(如SUM、COUNT)時使用。

- ? 監控手段:通過

MapOutputTracker日志分析各分區數據量差異,當最大/最小分區比超過10:1時需干預。

GitHub開源項目建議的解決方案包括:

- 1. 采樣預處理:在Job啟動前通過

InputSampler實現動態分區 - 2. 鹽值技術:對傾斜key添加隨機前綴,reduce階段合并后再聚合

- 3. 局部聚合:在map階段使用

PartialKeyGroupingComparator提前分散數據

磁盤I/O性能瓶頸

環形緩沖區溢寫涉及多次磁盤操作,優化要點包括:

- ? 溢寫閾值調整:將

mapreduce.map.sort.spill.percent從0.8提升至0.9,減少溢寫次數(需確保剩余10%空間足夠存放突發數據) - ? 合并策略優化:默認每次合并10個溢寫文件(

min.num.spills.for.combine),對于SSD存儲可提升至20個 - ? 磁盤選擇算法:修改

LocalDirAllocator類優先選擇IOPS較高的本地磁盤,避免與HDFS DataNode共用存儲

從源碼層面看,MapOutputBuffer類的startSpill()方法中可通過覆蓋getSpillLocation()實現自定義存儲路徑分配策略。

網絡傳輸異常處理

Shuffle階段的跨節點數據傳輸常出現:

- ? 連接超時:調整

mapreduce.shuffle.connect.timeout(默認180s)至300s以上 - ? 數據校驗失敗:禁用

mapreduce.shuffle.transferTo.allowed可規避NIO零拷貝導致的校驗錯誤 - ? 副本丟失:在

ReduceCopier線程中增加max.fetch.failures.before.sleep重試次數

知乎技術專欄提到關鍵參數組合:

<property><name>mapreduce.reduce.shuffle.max-fetch-retries</name><value>10</value>

</property>

<property><name>mapreduce.reduce.shuffle.retry-interval-ms</name><value>5000</value>

</property>排序效率優化

Sort階段的性能陷阱主要來自:

- 1. Key比較成本:復雜Writable對象(如嵌套結構)的

compareTo()方法會顯著拖慢排序。建議實現RawComparator接口進行二進制直接比較 - 2. 歸并策略:

MergeManagerImpl默認使用內存優先策略,當mapreduce.task.io.sort.factor(默認10)設置過高會導致頻繁GC。機械硬盤環境建議保持10-15,SSD環境可提升至30 - 3. 臨時文件管理:未及時清理的

_temporary目錄會占用inode資源,需在ShuffleHeader處理完成后觸發異步清理

IE

結語:Shuffle過程的未來展望

技術架構的演進方向

隨著大數據處理需求向實時化、智能化發展,傳統Shuffle機制正面臨根本性變革。最新研究表明,基于內存計算的架構正在逐步替代磁盤密集型設計,Spark采用的Tungsten引擎已證明通過堆外內存管理和二進制數據處理,能夠將Shuffle吞吐量提升3-5倍。這種趨勢預示著Hadoop生態可能向更輕量級的零拷貝傳輸方向發展,其中RDMA(遠程直接內存訪問)技術和用戶態協議棧(如DPDK)的引入,有望徹底消除JVM序列化帶來的性能損耗。

算法層面的創新突破

在排序合并環節,新型的增量式排序算法正在挑戰傳統歸并排序的統治地位。Google在2023年發表的論文中提出的"流式分桶排序"算法,通過動態調整分區策略,可將大規模數據集的Shuffle時間縮短40%。同時,基于機器學習的自適應緩沖技術開始嶄露頭角,系統能夠根據數據特征自動調整環形緩沖區閾值,如阿里云EMR團隊實現的智能溢寫策略,通過預測模型將磁盤I/O次數降低了28%。

硬件協同設計的可能性

異構計算設備為Shuffle過程帶來新的想象空間。NVIDIA的GPUDirect Storage技術允許GPU直接訪問存儲設備,理論上可以繞過CPU完成數據排序。英特爾推出的PMem(持久內存)產品則提供了新的存儲層級,其非易失性特質使得Map階段的輸出可以持久化保存而不必立即溢寫磁盤。這些硬件創新正在催生新一代的"存算一體"Shuffle架構,其中華為開源的CarbonData項目已嘗試將計算下推至智能網卡處理。

云原生環境下的重構需求

Kubernetes等容器編排系統的普及,使得基于HDFS的Shuffle數據交換模式顯得笨重。新興的"計算存儲分離"架構要求Shuffle過程適應彈性伸縮場景,如Apache Uniffle項目實現的遠程Shuffle服務,通過將中間數據托管至對象存儲,實現了計算節點與存儲節點的完全解耦。微軟Azure團隊則探索了基于FPGA的Shuffle加速器方案,在云環境中實現了微秒級的數據交換延遲。

可持續發展視角的優化

能耗問題正成為Shuffle優化的新維度。最新研究顯示,通過精細控制數據壓縮率與CPU功耗的平衡關系,可降低15-20%的集群能耗。Facebook開發的ZSTD壓縮算法自適應框架,能根據網絡帶寬動態調整壓縮級別,在Shuffle過程中實現了能效比的最大化。這種綠色計算理念或將推動更多"節能優先"的Shuffle策略出現。

這些技術演進并非彼此孤立,而是相互交織形成新的范式。當量子計算存儲器實現商用化時,我們甚至可能看到完全顛覆性的Shuffle實現方式——數據在不同計算節點間的"量子糾纏態傳輸"已不再是純理論設想。但無論技術如何變革,Shuffle過程的核心使命不會改變:在分布式系統中高效、可靠地重組數據流,這一本質需求將繼續驅動技術創新。

?

)