前言:繼DeepSeek引發行業震動后,Monica.im團隊最新推出的Manus AI 產品正席卷科技圈。這款具備自主思維能力的全能型AI代理,不僅能精準解析復雜指令并直接產出成果,更顛覆了傳統人機交互模式。盡管目前仍處于封閉測試階段,但開源社區已迅速行動起來。

由MetaGPT核心成員主導的OpenManus開源計劃,為這場智能革命注入了全新活力。這款零門檻的開源工具不僅打破授權限制,更支持本地化部署的大型語言模型。以筆者在高性能服務器上運行的千問QWQ-32B為例,通過OpenManus即可實現完全免費的深度協作。接下來,我們將逐步展開如何構建這組AI黃金搭檔的實戰指南,助您激活屬于自己的智慧引擎。

目錄

1. 環境準備

2. 本地部署OpenManus

3. 安裝Ollama

4. 安裝QwQ 32B模型

?5. 修改OpenManus配置文件

6. 運行OpenManus

7.通過網頁使用OpenManus

8. 安裝內網穿透

1. 環境準備

### 1.1 安裝Python

本例使用Windows11專業版系統進行演示:

首先需要安裝 python 3.12 下載地址:[Python Release Python 3.12.0 | Python.org](https://www.python.org/downloads/release/python-3120/)

頁面底部找到Windows版本,點擊下載安裝程序即可:

安裝時需要注意,勾選下邊兩個選項,不然后續有可能報錯:

安裝結束后,如出現下圖提示,點擊該選項(更改您的機器配置,以允許程序(包括Python)繞過260字符的“最大路徑”限制)同意即可:

確認后,點擊close關閉即可完成Python環境安裝:

### 1.2. 安裝conda

然后安裝conda環境,下載地址:[Anaconda Installers and Packages](https://repo.anaconda.com/)

點擊查看所有安裝文件,找到Windows版本,點擊下載即可:

下載好后,正常安裝即可:

需要注意的是在這一步,需要勾選第三個選項,自動加載剛才安裝的Python3.12環境:

點擊確定,然后點擊Install繼續安裝:

安裝完成后,點擊Finish即可:

2. 本地部署OpenManus

接下來開始在Windows系統使用conda本地部署OpenManus

### 2.1 創建一個新conda環境

首先在Windows中打開cmd或者powershell等終端工具,執行下方命令:

```shellconda create -n open_manus python=3.12```

如果提示'conda' 不是內部或外部命令,也不是可運行的程序,我們需要配置一下環境變量:

首先在電腦中找到conda的安裝路徑,本例中安裝時選擇的是只為我(just me)安裝,那么路徑是在`C:\Users\[你的用戶]` 目錄下:

進入.conda文件夾,打開environments文檔,復制這個路徑:

在Windows系統中搜索環境變量,打開:

選擇高級-環境變量-系統變量-**path** ,點擊編輯:

點擊新建,粘貼剛才復制的Anaconda的地址加上`\Scripts` ?比如:C:\Users\admin\anaconda3\Scripts

添加好環境變量后保存退出即可。

現在我們再打開cmd等終端工具,輸入conda時,可以看到能正常識別命令了:

再次執行剛才的命令:

```shellconda create -n open_manus python=3.12```

輸入y確認:

環境創建好之后,執行下方命令:

```shellconda init```

提示關閉并重啟你的shell工具(關閉重新打開cmd)

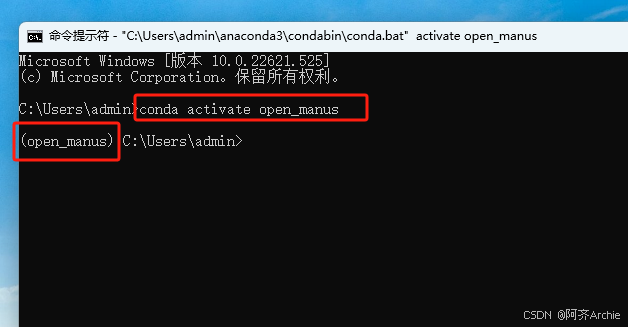

然后執行下方命令激活這個新的conda環境:

```shellconda activate open_manus```

如上圖所示,這個conda環境就激活成功了。

### 2.2 克隆存儲庫

接下來,我們在終端中執行下方命令,將OpenManus拉取到本地:

```shellgit clone https://github.com/mannaandpoem/OpenManus.git```> ps:使用git命令需要提前在Windows系統中下載并安裝node.js

如上圖所示done即為拉取完成。

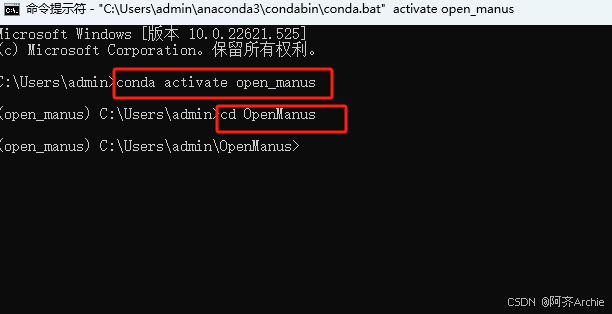

然后執行下方命令進入OpenManus項目根目錄下:

```shellcd OpenManus```

### 2.3 安裝依賴環境

執行下方命令安裝依賴環境:

```shellpip install -r requirements.txt```

這個階段安裝時間較長,耐心等待安裝完成即可:

現在就安裝好了:

3. 安裝Ollama

現在我們已經在本地部署好了OpenManus,但是我們還需要安裝Ollama來接入本地大模型,之后再配置OpenManus 使用的 LLM API才能夠使用。

下方為簡略安裝方法,詳細的安裝流程可以查看這篇文章:[Windows本地部署Ollama](https://www.cpolar.com/blog/the-deepseek-r1-large-model-is-deployed-locally-on-windows-and-interacts-remotely-using-a-web-interface)

首先訪問Ollama的官網:[Download Ollama on Windows](https://ollama.com/download)

下載適配你的操作系統的客戶端,我這里使用的是Windows11系統,點擊下載即可:

安裝好之后,打開cmd輸入ollama回車,看到下面信息即為安裝成功!

4. 安裝QwQ 32B模型

接下來使用Ollama下載本地AI大模型,不支持所有大模型,需要有函數調用能與OpenManus對接的才行。

恰好筆者之前下載的千問QwQ-32B模型就支持,這里就用它來演示。

下面為簡略安裝方法,詳細的安裝方式可以查看這篇文章:[Windows本地部署QwQ32B](https://www.cpolar.com/blog/the-qwq32b-is-comparable-to-deepseek-r1-671b-for-local-deployment-and-remote-access)

Ollama安裝完成之后,就可以開始去下載 QwQ32B 這個模型了,使用這個命令就能下載:

```shellollama run qwq```需要預留**20個G**以上的儲存空間,默認下載到C盤,如果想修改下載位置,可以在終端中執行下方命令來指定模型文件的存放目錄,這里以d:\ollama為例,大家可以自定義:

```shellset OLLAMA_MODELS=d:\ollama```安裝成功后會提示success:

?5. 修改OpenManus配置文件

接下來我們需要修改OpenManus配置文件,讓它對接本地qwq32b模型。

需要修改的是全局模型配置Global LLM configuration和視覺模型配置configuration for specific LLM models

**注意:里面的模型文件名稱要改成你自己安裝的,后面的視覺模型可以和上面的一致,也可以自定義其它的視覺模型!需要自己下載**

首先進入我的電腦,打開C盤-用戶-admin下的OpenManus文件夾:

然后進入config文件夾:

復制一份里邊的config.example.toml文件,重命名為config.toml,使用記事本打開進行配置:

1.首先將Global LLM configuration中的

model = "claude-3-7-sonnet-20250219" 替換為本地qwq32b的名稱:model = "qwq:latest"

> PS:如何查看本地大模型名稱:

>

> 新開一個cmd終端,輸入`ollama list`進行查看,名稱為 qwq:latest

2.將Global LLM configuration中的

base_url = "https://api.anthropic.com/v1/" ? 替換為 base_url = "http://localhost:11434/v1/"

替換后:

3.將Global LLM configuration中的

api_key = "YOUR_API_KEY" 替換為 api_key = "123"

替換后:

4.然后將下面的[llm] #OLLAMA:這部分整段刪除:

刪除后:

5.將Optional configuration for specific LLM models的

model = "claude-3-7-sonnet-20250219" 替換為 model = "qwq:latest"

6.將Optional configuration for specific LLM models的

base_url = "https://api.anthropic.com/v1/" ? 替換為 ? base_url = "http://localhost:11434/v1/"

7.將Optional configuration for specific LLM models的

api_key = "YOUR_API_KEY" ?替換為 api_key = "123"

8.將下面的[llm.vision] #OLLAMA VISION:這部分整段刪除:

刪除后:

配置完畢后保存關閉此文件即可。

6. 運行OpenManus

現在我們回到剛才創建好的OpenManus根目錄下,執行一行命令運行 OpenManus:

```pythonpython main.py```

可以看到提示我們輸入指令來讓它干活!

輸入命令后,可能會出現如下報錯:

這個問題是缺少了瀏覽器,那么需要先下載瀏覽器組件:

```pythonpython -m playwright install chromium```

然后安裝:

```pythonpip install playwright```

然后再次執行運行命令:

```pythonpython main.py```并向它提出要求:

根據本地硬件配置不同,執行操作的時間也不同,稍等后會自動打開瀏覽器進行查詢操作并給出推理與回答:

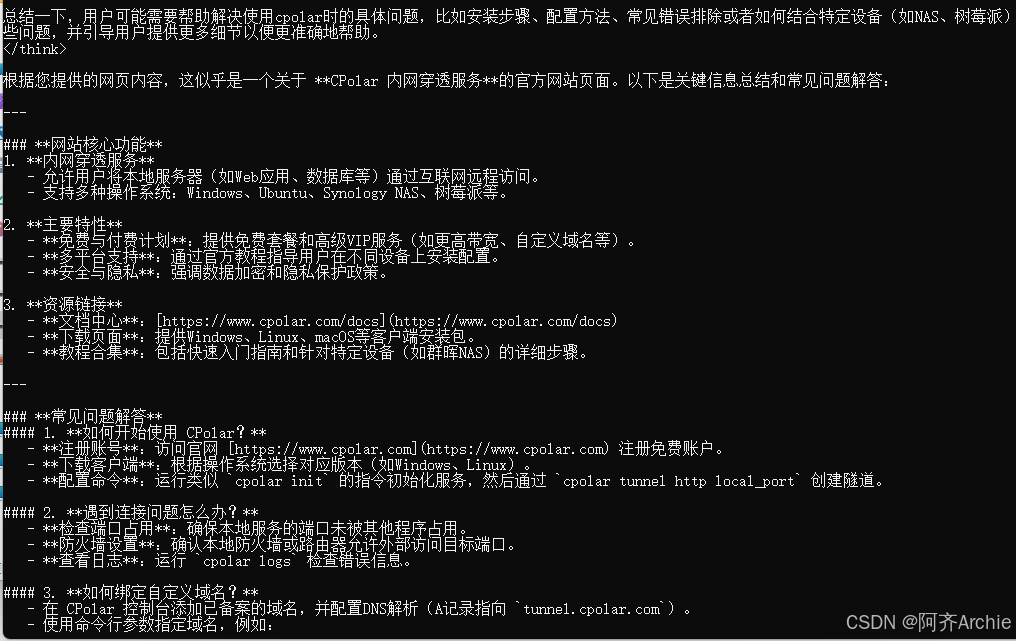

> PS:如果關閉終端后,不知道如何進入conda環境下的OpenManus根目錄,可以執行下方操作:

>

> 首先執行:

>

> ```shell> conda activate open_manus> ```>

> 然后執行:

>

> ```shell> cd OpenManus> ```>

> 就可以進到根目錄,使用 `python main.py` 運行 OpenManus 了!

>

7.通過網頁使用OpenManus

如果不喜歡在命令行中操作OpenManus,我們也可以在web網頁中進行操作

首先,需要下載OpenManus的分支代碼:

https://github.com/mannaandpoem/OpenManus/tree/front-end

然后解壓下載的包到自定義盤符目錄,本例中為 D:\OpenManus-front-end

在終端中進入這個項目路徑:

```shellD:``````shellcd OpenManus-front-end```

和上邊的在命令行中運行OpenManus一樣,我們需要先創建一個新的conda環境:

```shellconda create -n open_manusui python=3.12```

然后激活環境:

```shellconda activate open_manusui```

安裝依賴:

```pythonpip install -r requirements.txt```在運行前,同樣需要對config文件進行修改:()

復制一個config.example.toml文件,重命名為config.toml,打開進行如下修改:

保存后,回到終端中執行:

```pythonpython app.py```

會自動打開瀏覽器訪問:http://localhost:5172 打開OpenManus的web ui頁面:

在對話框中提問,可以在主界面中看到AI的操作流程:

思考、調用工具、給出結果:

不過這個UI版本似乎優化還有問題,處理速度比在終端中要慢很多,而且容易出現time out的情況。

8. 安裝內網穿透

現在我們已經成功在本地部署了OpenManus并使用WebUI在網頁中與AI交互,但如果想實現不在同一網絡環境下,也能隨時隨地在網頁中遠程使用本地部署的OpenManus處理問題,那就需要借助cpolar內網穿透工具來實現公網訪問了!接下來介紹一下如何安裝cpolar內網穿透,過程同樣非常簡單:

首先進入cpolar官網:

*cpolar官網地址:* [https://www.cpolar.com](https://www.cpolar.com/)

點擊`免費使用`注冊一個賬號,并下載最新版本的cpolar:

登錄成功后,點擊下載cpolar到本地并安裝(一路默認安裝即可)本教程選擇下載Windows版本。

cpolar安裝成功后,在瀏覽器上訪問http://localhost:9200,使用cpolar賬號登錄,登錄后即可看到配置界面,結下來在WebUI管理界面配置即可。

### 8.1 配置隨機公網地址

接下來配置一下 Open WebUI 的公網地址:

登錄后,點擊左側儀表盤的隧道管理——創建隧道,

- 隧道名稱:openmanus(可自定義命名,注意不要與已有的隧道名稱重復)

- 協議:選擇 http

- 本地地址:5172 (本地訪問的地址)

- 域名類型:選擇隨機域名

- 地區:選擇China Top

隧道創建成功后,點擊左側的狀態——在線隧道列表,查看所生成的公網訪問地址,有兩種訪問方式,一種是http 和https:

使用上面的任意一個公網地址,在平板或其他電腦的瀏覽器進行登錄訪問,即可成功看到 OpenManus 的WebUI 界面,這樣一個公網地址且可以遠程訪問就創建好了,使用了cpolar的公網域名,無需自己購買云服務器,即可到隨時在線訪問本地部署的OpenManus了!

**小結**

為了方便演示,我們在上邊的操作過程中使用cpolar生成的HTTP公網地址隧道,其公網地址是隨機生成的。這種隨機地址的優勢在于建立速度快,可以立即使用。然而,它的缺點是網址是隨機生成,這個地址在24小時內會發生隨機變化,更適合于臨時使用。

如果有長期遠程訪問OpenManus的WebUI使用QWQ-32B模型處理問題,或者異地訪問與使用其他本地部署的服務的需求,但又不想每天重新配置公網地址,還想讓公網地址好看又好記并體驗更多功能與更快的帶寬,那我推薦大家選擇使用固定的二級子域名方式來為WebUI配置一個公網地址。.

### 8.2 ?配置固定公網地址

接下來演示如何為其配置固定的HTTP公網地址,該地址不會變化,方便分享給別人長期查看你部署的項目,而無需每天重復修改服務器地址。

> 配置固定http端口地址需要將cpolar升級到專業版套餐或以上。

[登錄cpolar官網](https://dashboard.cpolar.com/?_gl=1*1l5hwif*_ga*MjMwNTYyNDYwLjE2OTAyNDg5MTg.*_ga_WF16DPKZZ1*MTczODc0Mjg2OC42NTguMS4xNzM4NzQ0Njg2LjUxLjAuMA..),點擊左側的預留,選擇保留二級子域名,設置一個二級子域名名稱,點擊保留:

保留成功后復制保留成功的二級子域名的名稱:`myops`,大家也可以設置自己喜歡的名稱。

返回Cpolar web UI管理界面,點擊左側儀表盤的隧道管理——隧道列表,找到所要配置的隧道:`openmanus`,點擊右側的編輯:

修改隧道信息,將保留成功的二級子域名配置到隧道中

- 域名類型:選擇二級子域名

- Sub Domain:填寫保留成功的二級子域名:`myops`

點擊`更新`(注意,點擊一次更新即可,不需要重復提交)

更新完成后,打開在線隧道列表,此時可以看到公網地址已經發生變化,地址名稱也變成了固定的二級子域名名稱的域名:

最后,我們使用上邊任意一個固定的公網地址訪問,可以看到訪問成功,這樣一個固定且永久不變的公網地址就設置好了,可以隨時隨地在公網環境異地在線訪問本地部署的OpenManus的WebUI來讓AI幫你全自動處理問題了!

## 總結

經過系統化的操作流程,我們已在Windows平臺完成了OpenManus核心框架及其WebUI可視化模塊的部署工作。通過集成cpolar內網穿透解決方案,成功構建了突破空間限制的遠程訪問通道,使AI助手的調用突破了物理設備的桎梏。整個實施過程展現出顯著的便捷性與高效性,僅需配置高性能計算節點及綁定專屬二級域名,即可打造個性化的智能服務中樞。

該方案不僅實現了7×24小時的遠程交互能力,更通過模塊化架構為后續功能擴展預留了充足空間。隨著OpenManus生態的持續進化,其在自動化處理、智能決策等領域的應用前景值得期待。對于部署過程中遇到的任何技術細節或優化建議,歡迎在交流區分享見解,共同探索人工智能技術的創新邊界。

)

)

)

Handler消息處理機制原理)

)