文章目錄

- 人人都該學習的DeepSeek

- DeepSeek不同版本功能差異

- DeepSeek與硬件直接的關系

- DeepSeek系統兼容性

- 部署方式選擇

- 部署步驟(Ollama方式)

- 1.選定適合的deepseek版本

- 2.環境準備

- 3.安裝Ollama

- 4.部署deepseek

- 5.測試使用

人人都該學習的DeepSeek

DeepSeek 作為一款先進的人工智能工具,具備強大的推理能力和廣泛的應用場景,能夠幫助用戶高效解決復雜問題。它支持文本生成、代碼編寫、數據分析、情感分析等多種任務,適用于教育、醫療、金融、創意等各行各業。它的開源特性使得個人和企業能夠低成本地利用其功能,推動AI技術的普及。無論是提升工作效率、輔助學習,還是解決生活中的問題,DeepSeek 都能提供智能化支持。

DeepSeek不同版本功能差異

| 版本 | 特點 | 適用場景 |

|---|---|---|

| ?1.5B | 輕量級模型,參數量少,推理速度快,適合低資源環境。 | 短文本生成、基礎問答、移動端應用(如簡單智能助手)。 |

| ?7B | 平衡型模型,性能與資源需求適中,支持中等復雜度任務。 | 文案撰寫、表格處理、統計分析、簡單代碼生成。 |

| ?8B | 性能略強于7B,優化邏輯推理和代碼生成。 | 代碼生成、邏輯推理(如數學題解決)、中等復雜度文本生成。 |

| ?14B | 高性能模型,擅長復雜任務(如數學推理、長文本生成)。 | 數據分析、長文本生成(如研究報告)、多模態任務預處理。 |

| ?32B | 專業級模型,支持高精度任務和大規模數據處理。 | 語言建模、金融預測、復雜病例分析(醫療場景)。 |

| ?70B | 頂級模型,多模態任務支持,科研級分析能力。 | 高精度臨床決策(醫療)、多模態數據分析、前沿科學研究。 |

| 671B | 超大規模基礎模型,最高準確性和推理速度,支持國家級研究。 | 氣候建模、基因組分析、通用人工智能探索。 |

注:671B是我們常說的滿血版deepseek。

?關鍵點

?1. 輸入輸出

- ?短文本處理?(1.5B-7B):最大支持16k tokens,適合對話和短文生成。

- ?長文本處理?(32B+):32k-10M tokens,可處理整本書籍或科研論文。

- ?多模態支持:32B及以上版本實驗性支持圖文混合輸入,671B版本實現視頻流解析。

?2. 推理計算

- ?數學能力:7B版本僅支持四則運算,32B版本可解微積分方程(準確率92%)。

- ?代碼生成:7B生成單文件腳本,14B支持全棧項目架構設計(含單元測試)。

?3. 部署

- ?量化支持:1.5B支持8-bit量化(體積壓縮至400MB),70B需保留FP16精度。

- ?分布式訓練:70B版本支持千卡并行訓練(吞吐量1.2 exaFLOPs),671B版本兼容量子計算節點。

?

DeepSeek與硬件直接的關系

| 參數 | 推薦顯卡型號 | 顯存要求 | 內存 | 存儲 | 適用場景 |

|---|---|---|---|---|---|

| 1.5B | NVIDIA RTX 3060 | 4-8GB | 8GB+ | 3GB+ SSD | 低資源設備部署、簡單對話 |

| 7B | NVIDIA RTX 3070/4060 | 8GB+ | 16GB+ | 8GB+ NVMe SSD | 本地開發測試、中小型企業任務 |

| 8B | NVIDIA RTX 3090 | 8GB+ | 16GB+ | 8GB+ NVMe SSD | 高精度輕量級任務 |

| 14B | NVIDIA RTX 3090 | 16GB+ | 32GB+ | 15GB+ NVMe SSD | 企業級復雜任務、專業咨詢 |

| 32B | NVIDIA A100 40GB | 24GB+ | 64GB+ | 30GB+ NVMe SSD | 高精度專業領域任務 |

| 70B | NVIDIA A100 80GB 多卡 | ≥40GB(多卡) | 128GB+ | 70GB+ NVMe SSD | 企業級復雜任務處理、科研 |

| 671B | NVIDIA H100/HGX 集群 | 640GB(8卡并行) | 512GB+ | 400GB+ NVMe SSD | 超大規模科研計算、國家級項目 |

注:32B是一個分水嶺,從該版本開始對硬件要求開始急速升高。

DeepSeek系統兼容性

| 操作系統 | 兼容性與性能 | 問題與風險 | 工具與部署建議 |

|---|---|---|---|

| Windows | 支持輕量級至中型模型(如7B-32B量化版) | 底層架構限制可能導致閃退或延遲,需關閉后臺程序、更新顯卡驅動 | 推薦使用Ollama進行一鍵部署,結合任務管理器監控資源占用,性能較Linux低10%-15% |

| Linux | 適配全版本模型(含70B+超算級部署) | 需注意安全防護(88.9%未防護服務器存在漏洞風險) | 通過LMDeploy優化推理速度,SGLang實現多模型協同,建議Ubuntu系統,性能最優 且支持分布式計算 |

| Mac | 僅支持1.5B-8B輕量模型,依賴M系列芯片NPU加速(如M2 Ultra) | 模型選擇受限,復雜任務響應延遲顯著(生成速度約2-3 tokens/秒) | 必須通過Ollama進行4-bit量化壓縮,優先使用Metal框架加速 |

注:部署時Linux系統最優。

部署方式選擇

- 優先選 Ollama 的場景

- 快速原型開發、個人項目測試

- 硬件資源有限(如無高端 GPU)

- 無需復雜參數調優

- 優先選直接部署的場景

- 企業級服務需高并發、低延遲響應

- 需定制模型或優化底層計算(如 FP8 加速、MOE 負載均衡)

- 對數據隱私和合規性要求極高

部署步驟(Ollama方式)

1.選定適合的deepseek版本

按照自己的需求選取合適的deepseek版本,可參照上文的表格內容。

選擇的依據主要是:

- 使用場景

- 功能需要

- 硬件限制

- 成本要求

2.環境準備

準備好Ubuntu系統,deepseek推薦使用Ubuntu20.04及以上版本。當前示例使用的是Ubuntu18.04版本。

當前配置情況:

- CPU:16核心

- 內存:64Gb

- 硬盤:128Gb

- GPU:RTX 4090

顯卡驅動準備

準備好裸機后首先更新系統:

sudo add-apt-repository ppa:graphics-drivers/ppa #18.04版本較舊,需要加上新的驅動

sudo apt update && sudo apt upgrade -y # 更新系統包

sudo apt install nvidia-driver-535 # 安裝NVIDIA驅動

安裝好顯卡驅動后,確認顯卡運行情況:

nvidia-smi

如圖所示是驅動完成。

CUDA環境準備

sudo apt update

sudo apt install nvidia-cuda-toolkit

3.安裝Ollama

安裝Ollama:

curl -fsSL https://ollama.ai/install.sh | sh # 執行官方安裝腳本

啟用Ollama:

sudo systemctl start ollama # 啟動服務

ollama --version # 輸出版本號即成功

可能的問題:

1.如果下載Ollama網絡慢導致異常中斷,可能如下所示:

curl: (16) Error in the HTTP2 framing layer

gzip: stdin: unexpected end of file

tar: Child returned status 1

tar: Error is not recoverable: exiting now

解決方案:

curl -fsSL https://ollama.com/install.sh -o ollama_install.sh

sed -i 's|https://ollama.com/download/ollama-linux|https://gh.llkk.cc/https://github.com/ollama/ollama/releases/download/v0.5.7/ollama-linux|g' ollama_install.sh

chmod +x ollama_install.sh

sudo ./ollama_install.sh

4.部署deepseek

ollama pull deepseek-r1:14b # 下載14B參數版本

整個過程需要一些時間:

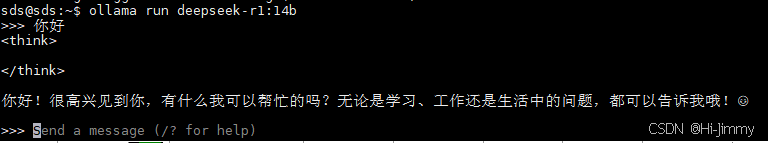

5.測試使用

測試deepseek運行情況:

ollama run deepseek-r1:14b

)

文件上傳分析)

)

)

![[自然語言處理]pytorch概述--什么是張量(Tensor)和基本操作](http://pic.xiahunao.cn/[自然語言處理]pytorch概述--什么是張量(Tensor)和基本操作)