隨著大型語言模型 (LLM)(例如Llama 2和Llama 3)不斷突破人工智能的界限,它們正在改變我們與周圍技術的互動方式。這些模型早已集成到我們的手機中,但到目前為止,它們理解和處理請求的能力還非常有限。然而,這些新型LLM人工智能模型可以理解和生成類似人類的文本,使它們成為增強語音助手、聊天機器人和其他自然語言處理任務等應用程序的理想選擇。

然而,這些 AI 模型的一個主要限制是它們需要大量資源才能運行計算。雖然桌面應用程序可以利用強大的CPUs 和GPUs,但手機的硬件卻有限得多。更困難的是,由于我們的移動設備幾乎一直伴隨著我們,隱私也是一個更大的問題。網絡連接也是一個問題,因為快速可靠的信號并不能保證。因此,為了最大限度地利用Llama 3Android 設備上的東西,我們必須在設備上離線運行它。

我們在 Android 手機上沒有太多這樣的選擇。話雖如此,也有些工具可讓您在 Android 設備上本地下載和運行 LLM 模型。您可以下載小型 AI 模型(2B 到 8B),如Llama 3、Gemma、Phi-2、Mistral 等。就此而言,讓我們開始吧。

在本文中,我們將探討如何在 Android 設備上運行小型輕量級模型,例如 Gemma-2B、Phi-2 和 StableLM-3B 。

具體操作

克隆此repo以訪問并使用作為示例提供的演示 Android 應用程序git clone https://github.com/googlesamples/mediapipe

cd mediapipe

git sparse-checkout init --cone

git sparse-checkout set examples/llm_inference/android

接下來,下載您選擇的量化 LLM 模型。目前,文檔僅支持四種模型:Gemma 2B、Phi-2、Falcon-RW-1B 和 StableLM-3B。

為了避免兼容性問題,請在下載過程中使用此 Colab 筆記本:LLM 轉換筆記本。

現在您已經下載了 model.bin 文件,您需要將其傳輸到您的 Android 設備。您可以使用命令adb shell推送文件,如文檔中所述

有關使用 Android 調試橋 (ADB) 的更多詳細信息,請參閱本文:了解 Android 調試橋 (ADB)。

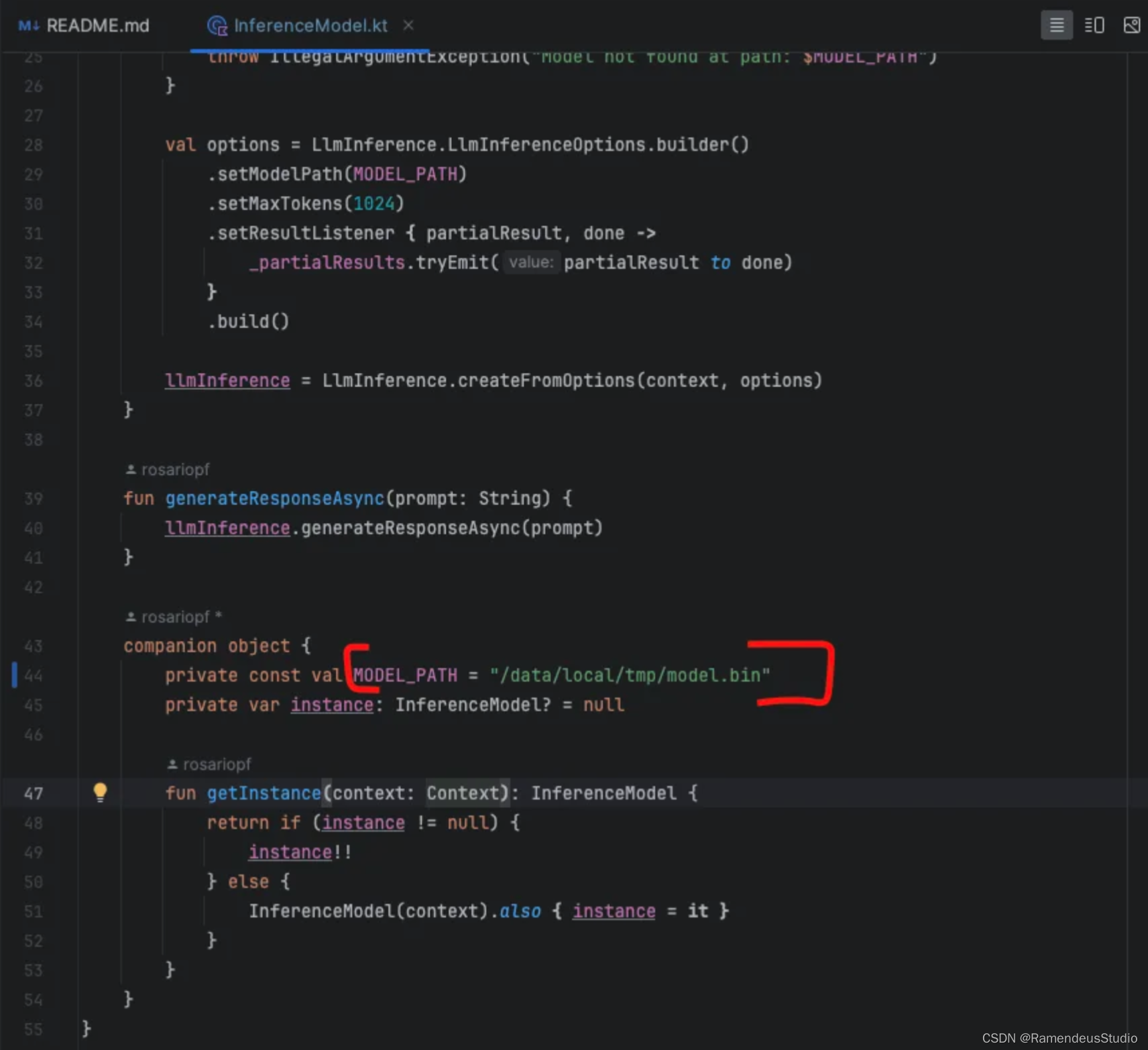

傳輸模型后,導航到InferenceModel.kt位于以下位置的文件:mediapipe/examples/llm_inference/android/app/ src / main /java/com/google/mediapipe/examples/llminference

在此文件中,修改generateResponseAsync函數以更新模型路徑,以反映您在手機上存儲模型的位置

接下來,將 Android 應用程序構建為 APK 文件,并將其安裝在 Android 手機上

演示

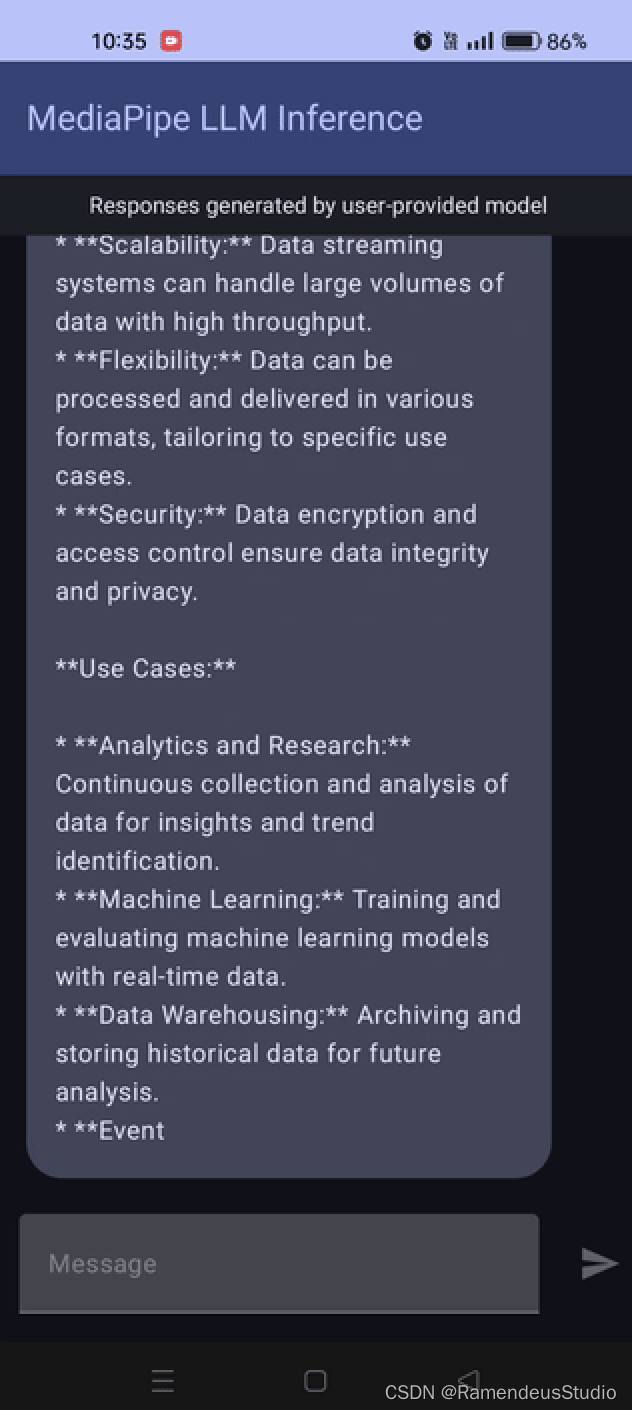

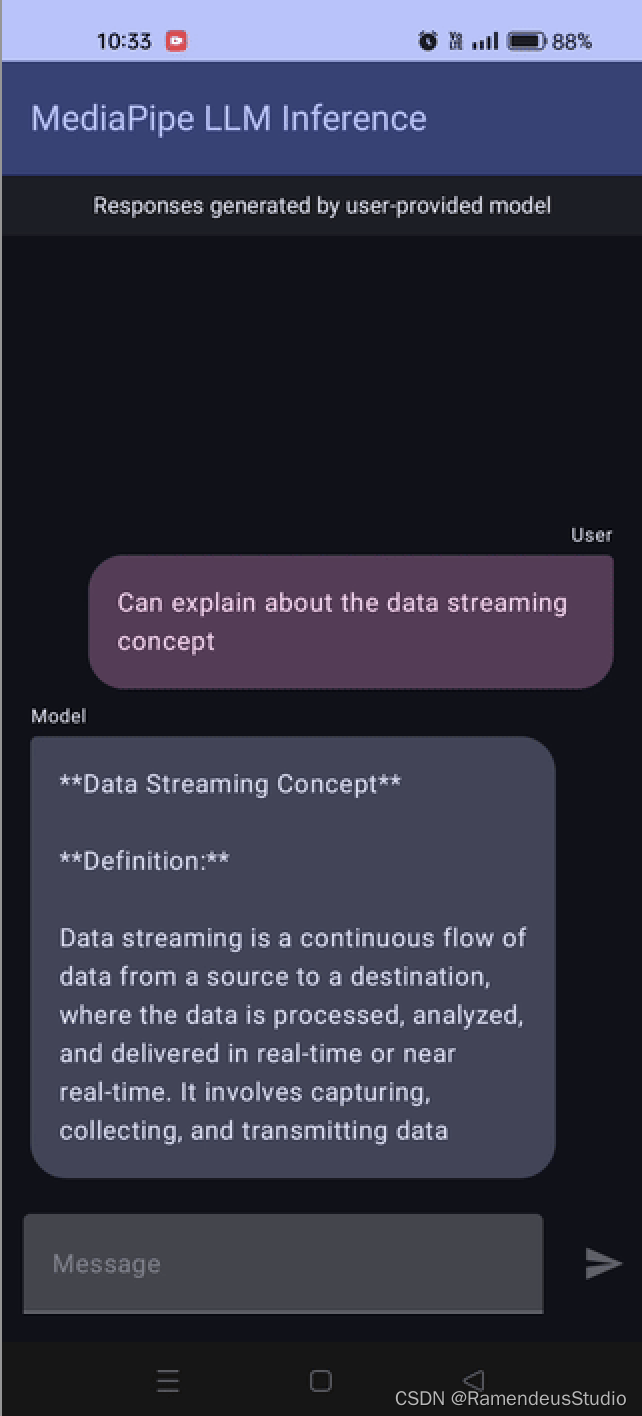

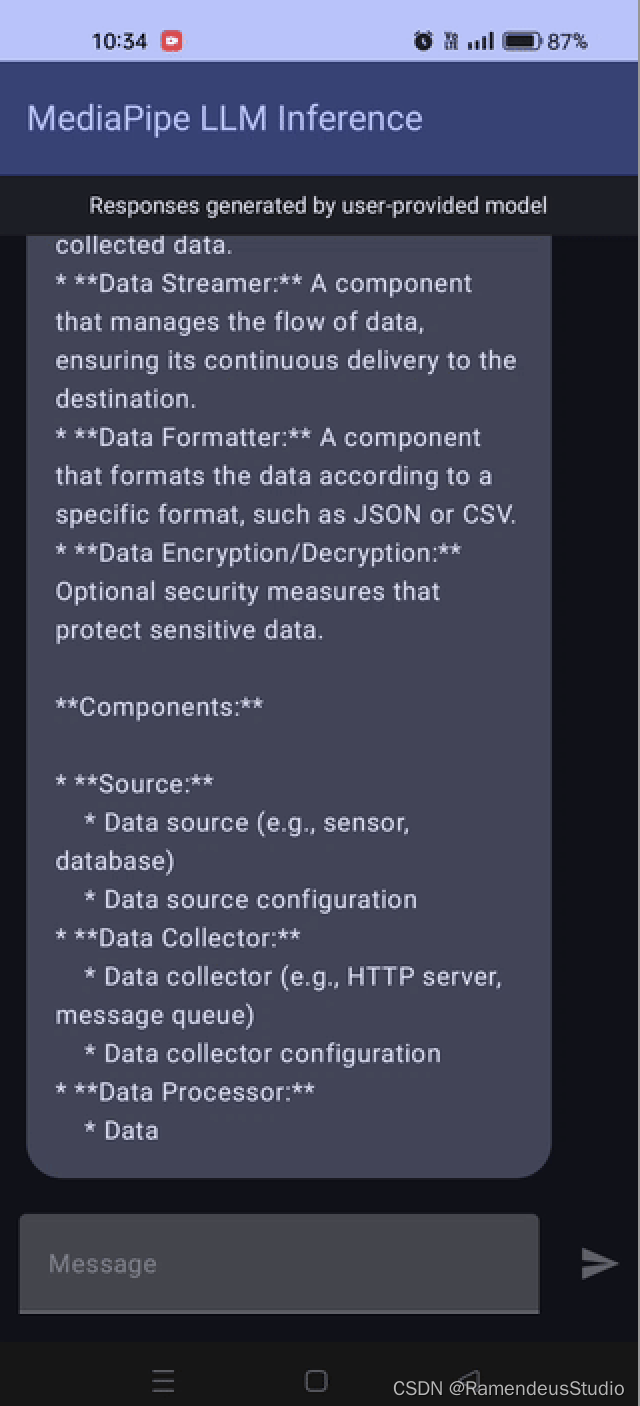

為了演示,我在搭載驍龍 778 芯片的 Android 手機上測試了 Gemma-2B 4 位模型并檢查了結果。

結論

在 Android 手機上運行小型輕量級模型效果很好 。在演示中,我們使用了搭載驍龍 芯片的手機。響應需要幾秒鐘,結果并不完美,可能是因為使用了量化模型

然而,關鍵的一點是在設備上運行輕量級 LLM 相當令人印象深刻,表明這些模型變得更加高效👍。

歡迎你分享你的作品到我們的平臺上. http://www.shxcj.com 或者 www.2img.ai 讓更多的人看到你的才華。

創作不易,覺得不錯的話,點個贊吧!!!

處理過程)

)

,項目介紹,環境搭建)

模塊)

)