7月4日,騰訊混元文生圖大模型(混元DiT)宣布開源小顯存版本,僅需6G顯存即可運行,對使用個人電腦本地部署的開發者十分友好,該版本與LoRA、ControlNet等插件,都已適配至Diffusers庫;并新增對Kohya圖形化界面的支持,讓開發者可以低門檻地訓練個性化LoRA模型;同時,混元DiT模型升級至1.2版本,在圖片質感與構圖方面均有所提升。

此外,騰訊宣布混元文生圖打標模型”混元Captioner“正式對外開源。該模型支持中英文雙語,針對文生圖場景進行專門優化,可幫助開發者快速制作高質量的文生圖數據集。

相比起業界的開源打標模型,混元Captioner模型能更好的理解與表達中文語義,輸出的圖片描述更為結構化、完整和準確,并能精準識別出常見知名人物與地標。模型還支持開發者自行補充和導入個性化的背景知識。

混元Captioner模型開源之后,全球的文生圖研究者、數據標注人員,均可使用混元Captioner高效地提升自身圖像描述質量,生成更全面、更準確的圖片描述,提升模型效果。混元Captioner生成的數據集不僅能用于訓練基于混元DiT的模型,亦可用于其他視覺模型訓練。

模型易用性再提升,個人電腦可輕松運行

騰訊混元DiT模型宣布了三大更新:推出小顯存版本與Kohya訓練界面,并升級至1.2版本,進一步降低使用門檻的同時提升圖片質量。

基于DiT架構的文生圖模型生成圖片質感更佳,但對顯存的要求卻非常高,讓許多開發者望而卻步。這也是新版本Stable Diffusion模型無法快速普及的原因之一。

應廣大開發者的需求,混元DiT推出小顯存版本,最低僅需6G顯存即可運行優化推理框架,對使用個人電腦本地部署的開發者非常友好。經過與Hugging Face合作,小顯存版本、LoRA與ControlNet插件,都已經適配到Diffusers庫中。開發者無需下載原始代碼,僅用簡單的三行代碼僅可調用,大大簡化了使用成本。

同時,混元DiT宣布接入Kohya,讓開發者可以低門檻地訓練專屬LoRA模型。

Kohya是一個開源的、輕量化模型微調訓練服務,提供了圖形化的用戶界面,被廣泛用于擴散模型類文生圖模型的訓練。用戶可以通過圖形化界面,完成模型的全參精調及LoRA訓練,無需涉及到代碼層面的細節。訓練好的模型符合Kohya生態架構,可以低成本與 WebUI 等推理界面結合,實現一整套“訓練-生圖”工作流。

面向文生圖、支持中英文,提升數據質量

在提升模型易用性的同時,騰訊混元團隊也在開放更多的關鍵技術,包括此前的訓練代碼,最新的打標模型混元Captioner。

數據集就像AI訓練的教材。訓練數據集的質量,影響著模型生成內容的效果。因此,文生圖開發者往往需要對原始圖片進行清晰、全面的標注,制作高質量的數據集,才能訓練出來一個語義理解準確、繪畫技藝高超的文生圖大模型。

借助打標模型,開發者可以快速生成高質量數據集。具體來說,文生圖開發者將原始圖片集導入混元Captioner,后者將生成高質量標注;也可以導入圖片與原始描述,利用混元Captioner過濾其中的無關信息,并完善和優化圖片描述,以提高數據質量。

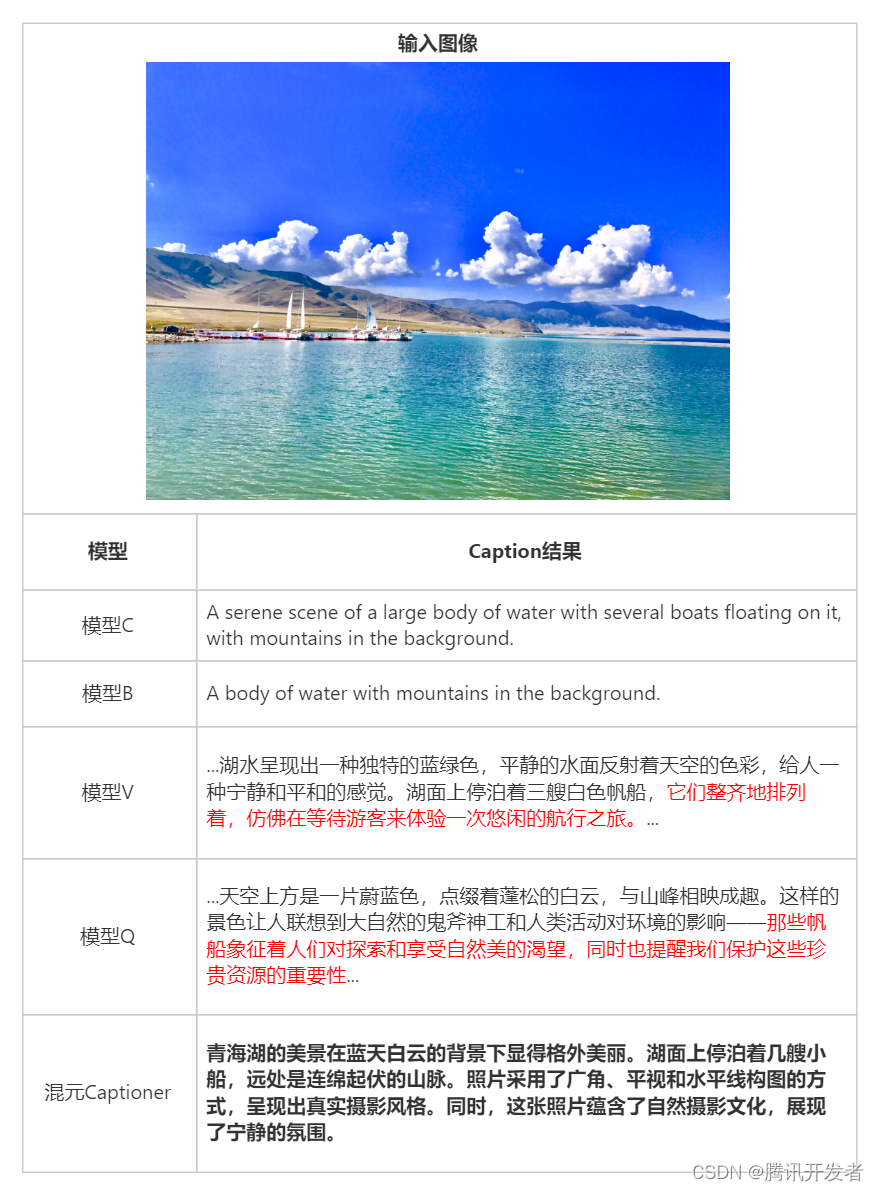

目前,業界對于圖片描述文本的生成,主要使用通用多模態Captioner模型,存在描述過于簡單或繁瑣(與畫面描述的無關信息過多)、缺少背景知識導致無法識別知名人物和地標等問題,并且許多模型并非中文原生,中文描述不夠精準。

混元Captioner對圖片描述進行結構化與準確度提升

混元Captioner的背景知識更為完善

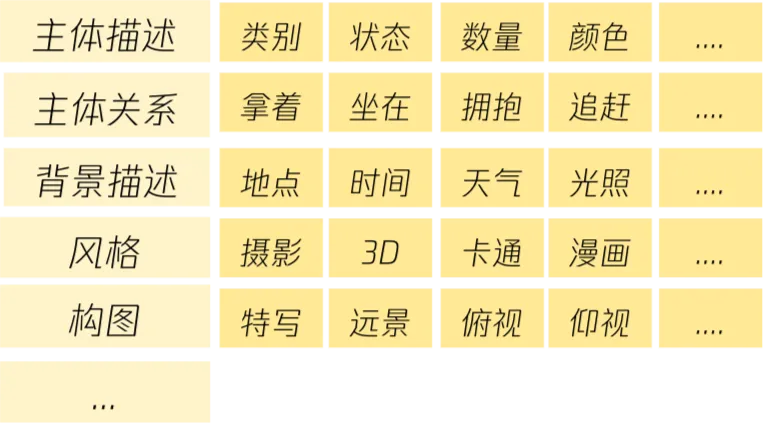

混元Captioner模型針對文生圖場景專門進行優化:構建了結構化的圖片描述體系;并在模型層面,通過注入人工標注、模型輸出、公開數據等多種來源提升Caption描述的完整性;并注入知名文學作品形象、地標、食物、動物、中國元素與知識等大量背景知識,讓模型輸出的描述更為準確、完整。

混元Captioner模型構建了結構化的圖片描述體系

眾多開發者關注,成最受歡迎國產DiT開源模型

作為首個中文原生DiT開源模型,混元DiT自全面開源以來,一直持續建設生態。6月,混元DiT發布的專屬加速庫,可將推理效率進一步提升,生圖時間縮短75%;并進一步開源了推理代碼;發布LoRA和ControlNet等插件。于此同時,模型易用性大幅提升,用戶可以通過Hugging Face Diffusers快訊調用混元DiT模型及其插件,或基于Kohya和ComfyUI等圖形化界面訓練與使用混元DiT。

目前,在眾多開發者的支持下,混元DiT發布不到2個月,Github Star數已經超過2.6k,成為最受歡迎的國產DiT開源模型。

騰訊混元開源文生圖大模型相關鏈接

官網:https://dit.hunyuan.tencent.com/

代碼:https://github.com/Tencent/HunyuanDiT

模型:https://huggingface.co/Tencent-Hunyuan/HunyuanDiT

論文:https://tencent.github.io/HunyuanDiT/asset/Hunyuan_DiT_Tech_Report_05140553.pdf

)

工具【了解安裝使用詳細】)

)

)