DS:《What Are the Data-Centric AI Concepts behind GPT Models?通過三個數據為中心的人工智能目標(訓練數據開發、推理數據開發和數據維護)揭示GPT模型背后的數據為中心的人工智能概念》解讀—GPT-1/GPT-2/GPT-3系列對比(語料大小+參數量+解碼層數+上下文長度+隱藏層大小)

導讀

:文章分析了GPT模型代表的大語言模型最新發展,強調了Data-Centric AI 概念在其成功中的重要作用。Data-Centric AI將變得更加關鍵,而語言模型將有助于實現更高效的數據中心AI。GPT模型代表大語言模型最新進展,能夠完成諸如翻譯、自動總結等任務。它成功

得益于大量高質量的數據訓練

。GPT-3模型使用了570GB的數據,只選取了總數據的1.27%。

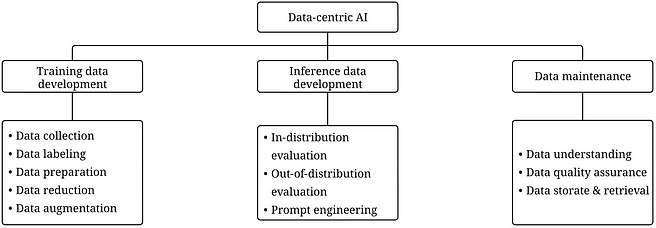

Data-Centric AI 強調著力于改善構建AI所使用的數據質量和量

。重視數據本身,模型相對固定。它有三大目標:訓練數據開發,推理數據開發和數據維護。Data-Centric AI 將變得更重要。調參已成熟,唯一提升AI能力的方式是優化數據

。

GPT模型成功離不開Data-Centric AI 策略

:使用了大量高質量的數據進行訓練;使用人類標注來微調和優化GPT模型;使用調參(prompts)來引導GPT輸出;ChatGPT可能不斷收集用戶反饋來持續進化

。

LLM的成功革新了AI,并將進一步改變數據科學的生命周期

。Data-Centric AI 變得更加重要,通過工程化數據

來改進AI系統。LLM能夠幫助提高Data-Centric AI 解決方案的效率,如自動處理和清洗數據、生成數據集。

目錄

《What Are the Data-Centric AI Concepts behind GPT Models?》翻譯與解讀

LLMs的成功主要歸功于大量和高質量的訓練數據、以GPT為例引出數據中心AI的三個目標=訓練數據開發+推理數據開發+數據維護

GPT-1/GPT-2/GPT-3系列對比(語料大小+參數量+解碼層數+上下文長度+隱藏層大小)

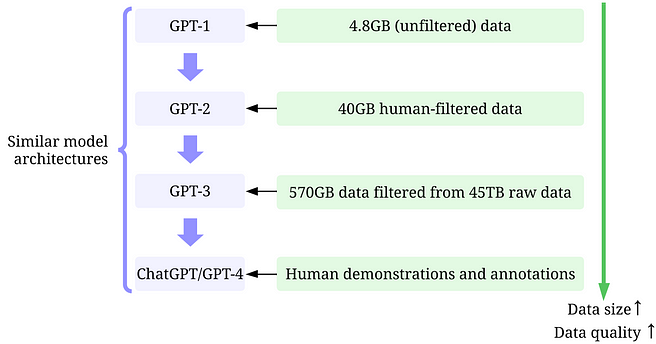

GPT系列模型基于類似的模型架構:4.8GB(未過濾)數據【GPT-1】→40GB人工過濾數據【GPT-3】→從45TB原始數據中過濾得到570GB數據【GPT-3】→人類示范和注解【GPT-4】

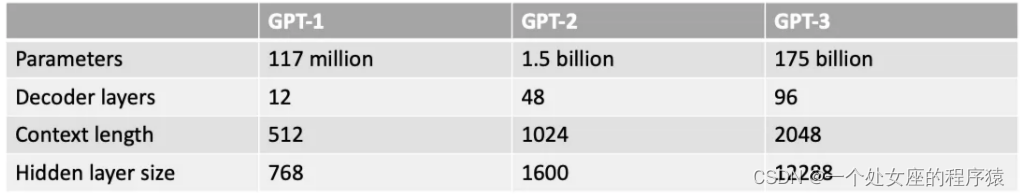

GPT系列模型(GPT-1、GPT-2、GPT-3)的模型尺寸比較:參數量、解碼層數、上下文長度、隱藏層大小

大型語言模型(llm)和GPT模型—GPT模型的架構主要基于Transformer+使用文本和位置嵌入作為輸入+使用注意力層來建模標記之間的關系、后續的GPT模型=更多的模型參數+更多的層+更大的上下文長度+更大隱藏層大小

什么是數據為中心的人工智能?—三目標(訓練數據開發/推理數據開發/數據維護)、相對于模型中心AI,數據中心AI能更有效地提高模型效能

為什么以數據為中心的人工智能使GPT模型成功—關鍵在于不斷改進的數據集和數據策略

GPT-2使用更高質量的數據集+數據過濾和清洗策略、GPT-3使用了更多更高質量的數據集+人工分類和數據去重、InstructGPT采用人類標注來微調GPT-3、ChatGPT/GPT-4廣泛使用RLHF來微調模型進一步提高數據量和質量+通過不斷收集用戶反饋來持續優化

提示調優

基于軟提示的校準

數據科學社區可以從這一波LLM(語言模型)中學到什么?——工程化數據將成為改進LLM的關鍵、LLM將實現更好的數據中心的AI解決方案

用LLM生成合成數據來訓練模型

Resources

《What Are the Data-Centric AI Concepts behind GPT Models?》翻譯與解讀

| 地址 | https://towardsdatascience.com/what-are-the-data-centric-ai-concepts-behind-gpt-models-a590071bb727 |

|---|---|

| 時間 | 2023年3月29日 |

| 作者 | Henry Lai |

LLMs的成功主要歸功于大量和高質量的訓練數據、以GPT為例引出數據中心AI的三個目標=訓練數據開發+推理數據開發+數據維護

GPT-1/GPT-2/GPT-3系列對比(語料大小+參數量+解碼層數+上下文長度+隱藏層大小)

GPT系列模型基于類似的模型架構:4.8GB(未過濾)數據【GPT-1】→40GB人工過濾數據【GPT-3】→從45TB原始數據中過濾得到570GB數據【GPT-3】→人類示范和注解【GPT-4】

GPT系列模型(GPT-1、GPT-2、GPT-3)的模型尺寸比較:參數量、解碼層數、上下文長度、隱藏層大小

1.17億、15億、1750億

圖片:GPT系列模型的模型尺寸比較。

| Artificial Intelligence (AI) has made incredible strides in transforming the way we live, work, and interact with technology. Recently, that one area that has seen significant progress is the development of Large Language Models (LLMs), such as GPT-3, ChatGPT, and GPT-4. These models are capable of performing tasks such as language translation, text summarization, and question-answering with impressive accuracy. While it’s difficult to ignore the increasing model size of LLMs, it’s also important to recognize that their success is due largely to the large amount and high-quality data used to train them. In this article, we will present an overview of the recent advancements in LLMs from a data-centric AI perspective, drawing upon insights from our recent survey papers [1,2] with corresponding technical resources on GitHub. Particularly, we will take a closer look at GPT models through the lens of data-centric AI, a growing concept in the data science community. We’ll unpack the data-centric AI concepts behind GPT models by discussing three data-centric AI goals: training data development, inference data development, and data maintenance. | 人工智能(Artificial Intelligence,AI)在改變我們的生活、工作和與技術互動方面取得了令人難以置信的進展。最近,其中一個取得顯著進步的領域是大型語言模型(Large Language Models,LLMs)的發展,例如GPT-3、ChatGPT和GPT-4。這些 模型能夠以令人印象深刻的準確度執行 語言翻譯、文本摘要和問答等任務。 雖然很難忽視LLMs模型的日益增長的模型規模,但也很重要認識到它們的成功在 很大程度上歸功于用于訓練它們的大量高質量數據 。 在本文中,我們將從以數據為中心的人工智能角度概述LLMs的最新進展,結合我們最近在GitHub上的調研論文[1,2]和相應的技術資源進行討論。特別是,我們將通過數據為中心的人工智能概念來更詳細地探討GPT模型,這是數據科學界中一個不斷發展的概念。我們將通過討論三個數據為中心的人工智能目標( 訓練數據開發、推理數據開發和數據維護 ),揭示GPT模型背后的數據為中心的人工智能概念。 |

|---|

大型語言模型(llm)和GPT模型—GPT模型的架構主要基于Transformer+使用文本和位置嵌入作為輸入+使用注意力層來建模標記之間的關系、后續的GPT模型=更多的模型參數+更多的層+更大的上下文長度+更大隱藏層大小

Large Language Models (LLMs) and GPT Models

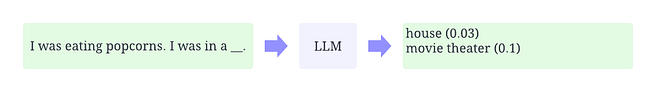

圖片:一個使用LLM預測上下文中丟失令牌的概率的說明性示例

圖片:GPT-1模型架構,圖片來自論文

| LLMs are a type of Natual Language Processing model that are trained to infer words within a context. For example, the most basic function of an LLM is to predict missing tokens given the context. To do this, LLMs are trained to predict the probability of each token candidate from massive data. GPT models refer to a series of LLMs created by OpenAI, such as GPT-1, GPT-2, GPT-3, InstructGPT, and ChatGPT/GPT-4. Just like other LLMs, GPT models’ architectures are largely based on Transformers, which use text and positional embeddings as input, and attention layers to model tokens’ relationships. The later GPT models use similar architectures as GPT-1, except for using more model parameters with more layers, larger context length, hidden layer size, etc. | 大型語言模型(LLMs)和GPT模型 LLMs是一種自然語言處理模型,訓練用于根 據上下文推斷單詞 。例如,LLMs最基本的功能之一是在給定上下文的情況下 預測缺失的標記 。為此,LLMs被訓練以預測大量數據中每個標記候選的概率。 GPT模型是由OpenAI創建的一系列LLMs,例如GPT-1、GPT-2、GPT-3、InstructGPT以及ChatGPT/GPT-4。與其他LLMs一樣,GPT模型的架構 主要基于Transformer ,使用 文本和位置嵌入作為輸入 ,并使用 注意力層來建模標記之間的關系 。 后續的GPT模型采用與GPT-1類似的架構, 只是使用了更多的模型參數 、 更多的層 、 更長的上下文長度 和 更大的隱藏層尺寸 等。 |

|---|

什么是數據為中心的人工智能?—三目標(訓練數據開發/推理數據開發/數據維護)、相對于模型中心AI,數據中心AI能更有效地提高模型效能

What is data-centric AI?

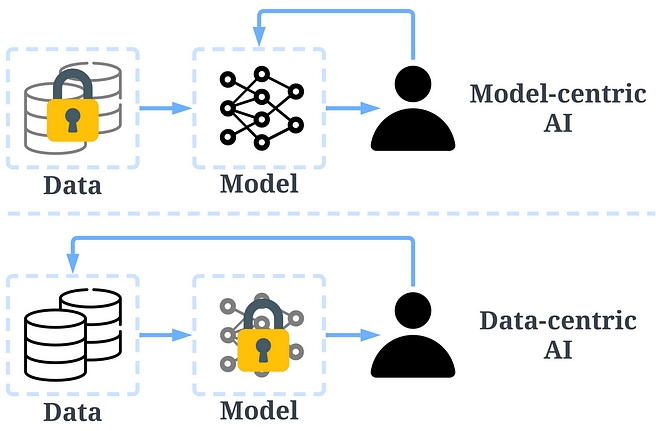

tu以數據為中心的AI和以模型為中心的AI的比較

| Data-centric AI is an emerging new way of thinking about how to build AI systems. It has been advocated by Andrew Ng, an AI pioneer. In the past, we mainly focused on creating better models with data largely unchanged (model-centric AI). However, this approach can lead to problems in the real world because it doesn’t consider the different problems that may arise in the data, such as inaccurate labels, duplicates, and biases. As a result, “overfitting” a dataset may not necessarily lead to better model behaviors. In contrast, data-centric AI focuses on improving the quality and quantity of data used to build AI systems. This means that the attention is on the data itself, and the models are relatively more fixed. Developing AI systems with a data-centric approach holds more potential in real-world scenarios, as the data used for training ultimately determines the maximum capability of a model. | 數據為中心的人工智能 是一種新興的構建人工智能系統的思維方式。這一概念由人工智能先驅Andrew Ng提倡。 過去,我們主要關注通過數據的微小變化來創建更好的模型(以模型為中心的人工智能)。然而,這種方法在現實世界中可能會導致問題,因為它沒有考慮到數據可能出現的不同問題,例如 不準確的標簽、重復數據和偏見 。因此, “過擬合”數據集不一定會導致模型行為更好 。 相反,數據為中心的人工智能 側重于改進 用于構建人工智能系統的 數據的質量和數量 。這意味著關注的 焦點在于數據本身 ,而模型相對固定。通過以數據為中心的方法開發人工智能系統,在真實世界的場景中具有更大的潛力,因為 用于訓練的數據最終決定了模型的最大能力 。 |

|---|---|

| It is important to note that “data-centric” differs fundamentally from “data-driven”, as the latter only emphasizes the use of data to guide AI development, which typically still centers on developing models rather than engineering data. The data-centric AI framework consists of three goals: Training data development is to collect and produce rich and high-quality data to support the training of machine learning models. Inference data development is to create novel evaluation sets that can provide more granular insights into the model or trigger a specific capability of the model with engineered data inputs. Data maintenance is to ensure the quality and reliability of data in a dynamic environment. Data maintenance is critical as data in the real world is not created once but rather necessitates continuous maintenance. | 需要注意的是,“ 數據為中心 ”與“ 數據驅動 ”有根本的不同,后者只強調使用數據指導人工智能發展,通常仍 以開發模型為中心 ,而不是工程化數據。 數據為中心的人工智能框架包括三個目標: 訓練數據 開發旨在收集和生成 豐富且高質量 的數據,以支持機器學習模型的訓練。 推理數據 開發旨在創建新穎的評估集,以提供對模型更詳細的洞察或觸發模型特定能力的 工程化數據輸入 。 數據維護 旨在確保在動態環境中數據的質量和可靠性。數據維護至關重要,因為真實世界中的數據不是一次性創建的,而是需要 持續維護 的。 |

為什么以數據為中心的人工智能使GPT模型成功—

關鍵在于不斷改進的數據集和數據策略

Why Data-centric AI Made GPT Models Successful

GPT-2使用更高質量的數據集+數據過濾和清洗策略、GPT-3使用了更多更高質量的數據集+人工分類和數據去重、InstructGPT采用人類標注來微調GPT-3、ChatGPT/GPT-4廣泛使用RLHF來微調模型進一步提高數據量和質量+通過不斷收集用戶反饋來持續優化

| Months earlier, Yann LeCun tweeted that ChatGPT was nothing new. Indeed, all techniques (transformer, reinforcement learning from human feedback, etc.) used in ChatGPT and GPT-4 are not new at all. However, they did achieve incredible results that previous models couldn’t. So, what is the driving force of their success? Training data development. The quantity and quality of the data used for training GPT models have seen a significant increase through better data collection, data labeling, and data preparation strategies. | 幾個月前,Yann LeCun在推特上表示, ChatGPT并沒有什么新東西 。確實,在ChatGPT和GPT-4中使用的所有技術(包括 Transformer、從人類反饋中進行強化學習 等)都并非新技術。然而,它們確實取得了之前的模型無法達到的驚人結果。那么,是 什么推動了它們的成功 呢? 訓練數據開發 。通過 更好的數據 收集、數據標注和數據準備策略,用于訓練GPT模型的數據的數量和質量有了顯著提高。 |

|---|---|

| GPT-1: BooksCorpus dataset is used in training. This dataset contains 4629.00 MB of raw text, covering books from a range of genres such as Adventure, Fantasy, and Romance. - Data-centric AI strategies: None. - Result: Pertaining GPT-1 on this dataset can increase performances on downstream tasks with fine-tuning. GPT-2: WebText is used in training. This is an internal dataset in OpenAI created by scraping outbound links from Reddit. - Data-centric AI strategies: (1) Curate/filter data by only using the outbound links from Reddit, which received at least 3 karma. (2) Use tools Dragnet and Newspaper to extract clean contents. (3) Adopt de-duplication and some other heuristic-based cleaning (details not mentioned in the paper) - Result: 40 GB of text is obtained after filtering. GPT-2 achieves strong zero-shot results without fine-tuning. | GPT-1 :在訓練中使用了BooksCorpus數據集。該數據集包含4629.00 MB的原始文本,涵蓋了冒險、奇幻和浪漫等各種類型的圖書。 數據為中心的人工智能策略 :無。 結果 :使用該數據集對GPT-1進行微調可以提高在下游任務上的性能。 GPT-2 :在訓練中使用了WebText數據集。這是OpenAI內部通過從Reddit抓取出站鏈接創建的數據集。 數據為中心的人工智能策略 : (1)通過僅使用Reddit上至少獲得3個贊的出站鏈接來篩選數據; (2)使用 Dragnet和Newspaper等工具提取干凈 的內容; (3)采用 去重和其他一些基于啟發式的清理 方法(論文中未詳細說明)。 結果 :經過篩選后獲得了40GB的文本。GPT-2在零樣本情況下取得了 強大的結果,無需微調 。 |

| GPT-3: The training of GPT-3 is mainly based on Common Crawl. - Data-centric AI strategies: (1) Train a classifier to filter out low-quality documents based on the similarity of each document to WebText, a proxy for high-quality documents. (2) Use Spark’s MinHashLSH to fuzzily deduplicate documents. (3) Augment the data with WebText, books corpora, and Wikipedia. - Result: 570GB of text is obtained after filtering from 45TB of plaintext (only 1.27% of data is selected in this quality filtering). GPT-3 significantly outperforms GPT-2 in the zero-shot setting. InstructGPT: Let humans evaluate the answer to tune GPT-3 so that it can better align with human expectations. They have designed tests for annotators, and only those who can pass the tests are eligible to annotate. They have even designed a survey to ensure that the annotators enjoy the annotating process. - Data-centric AI strategies: (1) Use human-provided answers to prompts to tune the model with supervised training. (2) Collect comparison data to train a reward model and then use this reward model to tune GPT-3 with reinforcement learning from human feedback (RLHF). - Result: InstructGPT shows better truthfulness and less bias, i.e., better alignment. | GPT-3 :GPT-3的訓練主要基于Common Crawl。 數據為中心的人工智能策略 : (1) 訓練一個分類器 ,通過每個文檔與高質量文檔的相似性來 過濾掉低質量文檔 (以WebText作為高質量文檔的代理); (2)使用Spark的 MinHashLSH模糊去重文檔 ; (3)通過添加WebText、圖書語料庫和維基百科來增加數據。 結果 :在45TB的純文本中,通過質量篩選僅選擇了1.27%的數據,篩選后獲得了570GB的文本。GPT-3在零樣本設置下明顯優于GPT-2。 InstructGPT :讓 人類評估答案 ,以調整GPT-3,使其更好地符合人類的預期。他們為注釋者設計了測試,只有通過測試的人才有資格進行注釋。他們甚至設計了一份調查問卷,以確保注釋者享受注釋過程。 數據為中心的人工智能策略 : (1)使用 人為提供的問題答案 對模型進行有監督訓練; (2)收集 比較數據 ,訓練一個獎勵模型,然后使用這個獎勵模型通過從人類反饋中進行強化學習(RLHF)來調整GPT-3。 結果 :InstructGPT展示出 更好的真實性和較少的偏見 ,即更好的對齊。 |

| ChatGPT/GPT-4: The details are not disclosed by OpenAI. But it is known that ChatGPT/GPT-4 largely follow the design of previous GPT models, and they still use RLHF to tune models (with potentially more and higher quality data/labels). It is commonly believed that GPT-4 used an even larger dataset, as the model weights have been increased. | ChatGPT/GPT-4 :OpenAI并沒有披露詳細信息。但眾所周知,ChatGPT/GPT-4在很大程度上遵循了之前GPT模型的設計,并且仍然使用RLHF來調整模型(可能使用了更多和更高質量的數據/標簽)。普遍認為,GPT-4 使用了更大的數據集 ,因為 模型的權重已經增加 。 |

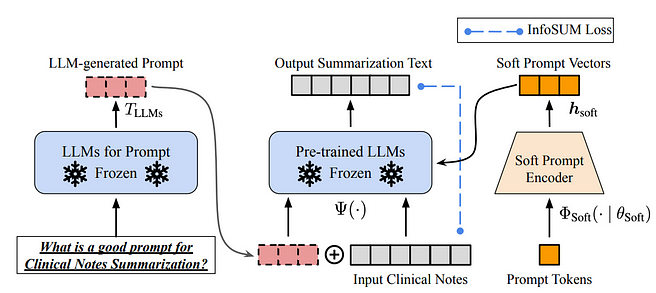

| Inference data development. As recent GPT models are already sufficiently powerful, we can achieve various goals by tuning prompts (or tuning inference data) with the model fixed. For example, we can conduct text summarization by offering the text to be summarized alongside an instruction like “summarize it” or “TL;DR” to steer the inference process. Designing the proper prompts for inference is a challenging task. It heavily relies on heuristics. A nice survey has summarized different promoting methods. Sometimes, even semantically similar prompts can have very diverse outputs. In this case, Soft Prompt-Based Calibration may be required to reduce variance. | 推理數據開發。由于最新的GPT模型已經非常強大,我們可以通過固定模型并調整提示(或推理數據)來實現各種目標。例如,我們可以通過提 供要摘要的文本以 及諸如“總結一下”或“TL;DR”之類的指示來進行文本摘要。 設計適當的推理提示 是一項具有挑戰性的任務。它在很大程度上依賴于啟發式方法。一份很好的調查總結了不同的推理方法。有時,即使語義上相似的提示也可能有非常不同的輸出。在這種情況下,可能 需要使用軟提示校準來減少方差 。 |

提示調優

基于軟提示的校準

| The research of inference data development for LLMs is still in its early stage. More inference data development techniques that have been used in other tasks could be applied in LLMs in the near future. Data maintenance. ChatGPT/GPT-4, as a commercial product, is not only trained once but rather is updated continuously and maintained. Clearly, we can’t know how data maintenance is executed outside of OpenAI. So, we discuss some general data-centric AI strategies that are or will be very likely used for GPT models: - Continuous data collection: When we use ChatGPT/GPT-4, our prompts/feedback could be, in turn, used by OpenAI to further advance their models. Quality metrics and assurance strategies may have been designed and implemented to collect high-quality data in this process. - Data understanding tools: Various tools could have been developed to visualize and comprehend user data, facilitating a better understanding of users’ requirements and guiding the direction of future improvements. - Efficient data processing: As the number of users of ChatGPT/GPT-4 grows rapidly, an efficient data administration system is required to enable fast data acquisition. | LLM的推理數據開發研究仍處于早期階段。將來可能會將在其他任務中使用的更多推理數據開發技術應用于LLM。 數據維護。作為一款商業產品,ChatGPT/GPT-4不僅僅是進行一次訓練,而是持續不斷地進行更新和維護。顯然,我們無法得知OpenAI之外如何執行數據維護。因此,我們討論了一些常見的數據為中心的人工智能策略,這些策略在GPT模型中已經或將很可能被使用: 持續數據收集 :當我們使用ChatGPT/GPT-4時,我們的 提示/反饋 可能被OpenAI用于 進一步改進 他們的模型。可能已經設計和實施了質量指標和保證策略,以在這個過程中收集高質量的數據。 數據理解工具 :可能已經開發了各種工具 來可視化和理解用戶數據 ,促進對用戶需求的更好理解,并指導未來改進的方向。 高效數據處理 :隨著ChatGPT/GPT-4用戶數量的迅速增長, 需要一個高效的數據管理系統 ,以實現快速的數據獲取。 |

|---|

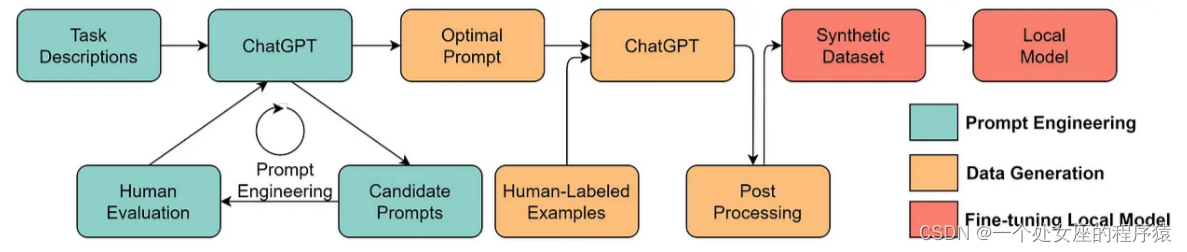

數據科學社區可以從這一波LLM(語言模型)中學到什么?——工程化數據將成為改進LLM的關鍵、LLM將實現更好的數據中心的AI解決方案

What Can the Data Science Community Learn from this Wave of LLMs?

| The success of LLMs has revolutionized AI. Looking forward, LLMs could further revolutionize the data science lifecycle. We make two predictions: Data-centric AI becomes even more important. After years of research, the model design is already very mature, especially after Transformer. Engineering data becomes a crucial (or possibly the only) way to improve AI systems in the future. Also, when the model becomes sufficiently powerful, we don’t need to train models in our daily work. Instead, we only need to design the proper inference data (prompt engineering) to probe knowledge from the model. Thus, the research and development of data-centric AI will drive future advancements. LLMs will enable better data-centric AI solutions. Many of the tedious data science works could be performed much more efficiently with the help of LLMs. For example, ChaGPT/GPT-4 can already write workable codes to process and clean data. Additionally, LLMs can even be used to create data for training. For example, recent work has shown that generating synthetic data with LLMs can boost model performance in clinical text mining. | LLM的成功 徹底改變了人工智能領域 。展望未來,LLM可能進一步革新數據科學生命周期。我們提出兩個預測: 數據為中心的人工智能變得更加重要 。經過多年的研究,模型設計已經非常成熟,特別是在Transformer之后。 工程化數據 將成為未來改進人工智能系統的 關鍵 (或可能是唯一)途徑。此外,當模型變得足夠強大時,我們在日常工作中 就不再需要訓練模型 。相反,我們 只需要設計適當的推理數 據(即提示工程)來從模型中獲取知識。因此,數據為中心的人工智能的研究和發展將推動未來的進步。 LLM將使數據為中心的人工智能解決方案更加優秀 。借助LLM的幫助,許多繁瑣的數據科學工作可以更高效地完成。例如,ChaGPT/GPT-4已經可以編寫可用的代碼來處理和清洗數據。此外,LLM甚至 可以用于創建用于訓練的數據 。例如,最近的研究表明,使用LLM生成合成數據可以提升臨床文本挖掘模型的性能。 |

|---|

用LLM生成合成數據來訓練模型

Resources

| I hope this article can inspire you in your own work. You can learn more about the data-centric AI framework and how it benefits LLMs in the following papers: [1]?Data-centric Artificial Intelligence: A Survey [2]?Data-centric AI: Perspectives and Challenges We have maintained a?GitHub repo, which will regularly update the relevant data-centric AI resources. Stay tuned! In the later articles, I will delve into the three goals of data-centric AI (training data development, inference data development, and data maintenance) and introduce the representative methods. | 希望這篇文章能激發您在自己的工作中的靈感。您可以通過以下論文進一步了解數據為中心的人工智能框架以及它對LLM的好處: [1] 《數據為中心的人工智能:一項調查》 [2] 《數據為中心的人工智能:觀點與挑戰》 我們維護了一個GitHub倉庫,將定期更新相關的數據為中心的人工智能資源。敬請關注! 在后續的文章中,我將深入探討數據為中心的人工智能的三個目標(訓練數據開發、推理數據開發和數據維護),并介紹代表性的方法。 |

|---|

時需要使用哪些工具?)

)

-- 斷線重連)

)

: Plugin ‘msql_native_password‘ is not loaded.)

)

功能)