目錄

NPU邊緣推理識物系統

一、項目簡介

二、硬件介紹

三、軟件設計

1、底層NPU推理代碼

2、應用層QT顯示代碼

四、項目成果展示

NPU邊緣推理識物系統

一、項目簡介

物品分類是計算機視覺的重要技術,本項目的核心是:使用NPU(神經網絡處理器或神經網絡處理單元)進行本地推理計算識別。相比與傳統的識別技術,NPU邊緣推理識別不需要依賴網絡和云端,它在本地SoC(System on Chip片上系統)上就可以高效、快速地處理AI任務。NPU在AI推理計算上比CPU更專業和高效,比GPU更省電。

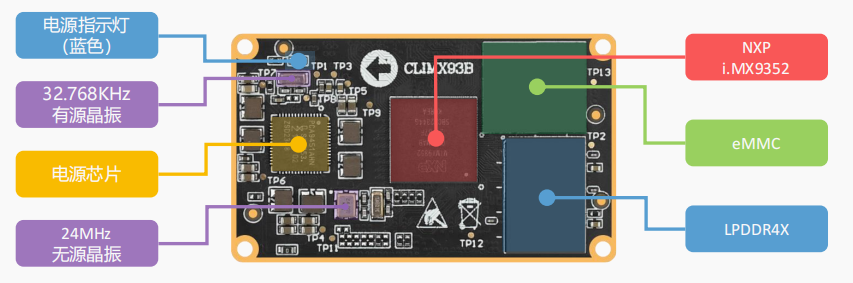

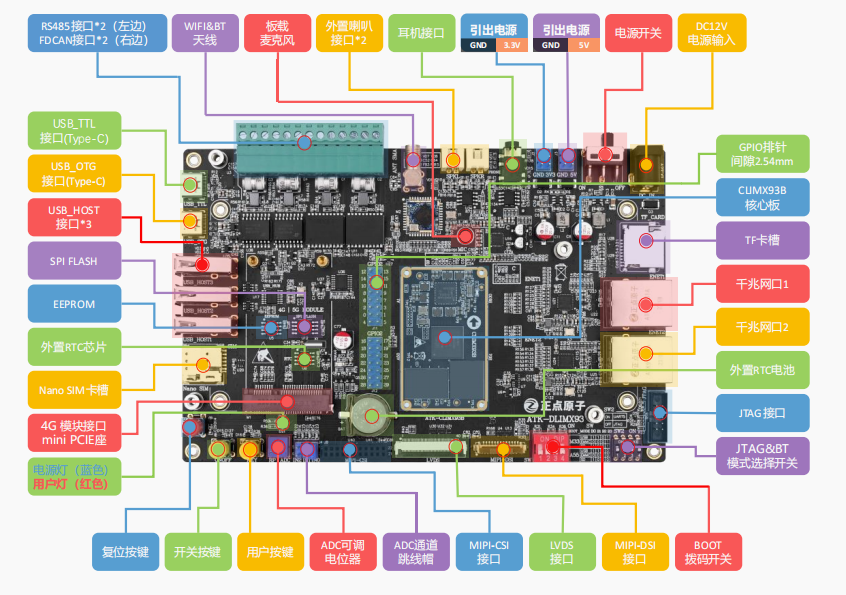

二、硬件介紹

本項目使用的是NXP(恩智浦)推出的i.MX93,i.MX93處理器集成的NPU,搭載了 ARM 自研的 Ethos-U65。Ethos-U65 神經處理單元(NPU)是 ARM 為了在面積受限的嵌入式和物聯網設備的情況下加速機器學習推理而設計。

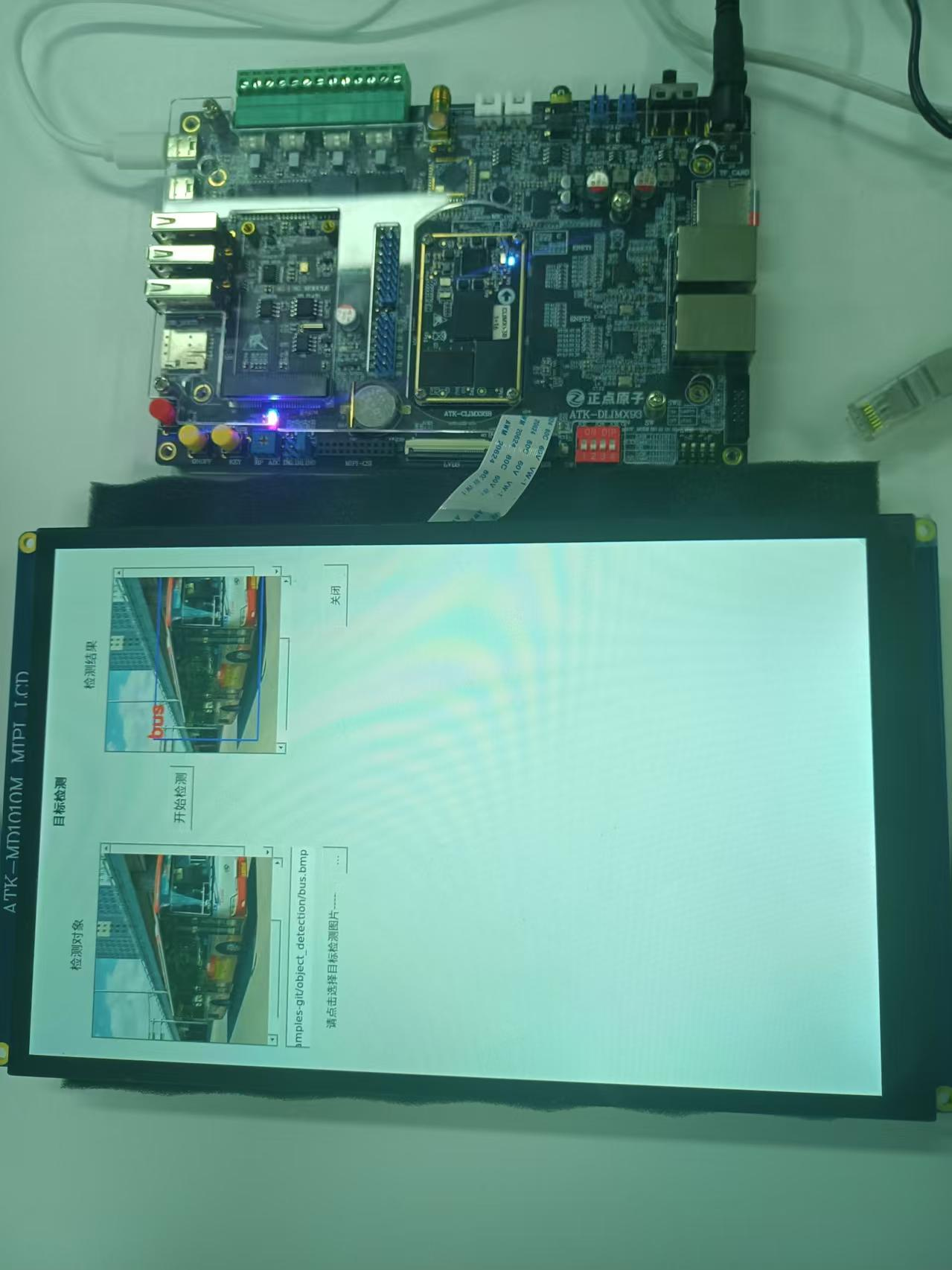

項目開發板使用的是正點原子推出的ATK-DLIMX93 開發板

開發板實物展示

硬件層面雖然正點原子設計的接口很多,但是我們只使用了SoC中的NPU和屏幕進行效果展示。后期考慮接入攝像頭設備。

注意:正點原子沒有提供i.MX93的核心板原理圖,如果想要自己設計出核心板需要借鑒NXP(恩智浦)官方提供的評估板原理圖資料進行復刻。

三、軟件設計

首先聲明,我們項目的所有操作都是基于Linux操作系統來進行的,所以我們要對i.MX93上面燒錄Linux操作系統之后再能進行后續軟件開發。

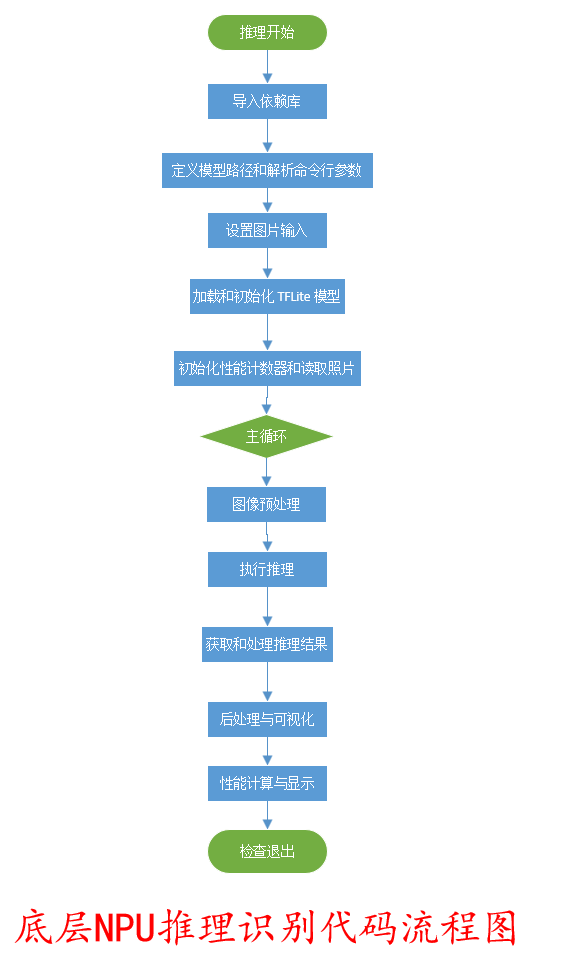

1、底層NPU推理代碼

底層NPU推理識別流程圖

底層控制NPU推理識別Python代碼

'''

項目所有文件名 : main4.py

作者 : SELSL

版本 : V1.0

描述 : 使用NPU推理得出圖片類型

其他 : 無

論壇 : 無

日志 : 初版 V1.0 2025/8/8 SELSL創建

'''

?

#導入依賴庫

#用于加載和運行 .tflite 格式的模型

import tflite_runtime.interpreter as tflite

#用于處理數組和數值計算

import numpy as np

#(OpenCV): 用于視頻捕獲、圖像處理和保存圖像

import cv2

#用于測量代碼執行時間

import time

#用于解析命令行參數

import argparse

#將模型輸出的類別索引映射為人類可讀的類別名稱

from labels import label2string

?

#定義模型路徑和解析命令行參數

#指定了 .tflite 模型文件的路徑

MODEL_PATH = "../vela_models/ssd_mobilenet_v1_quant_vela.tflite"

?

parser = argparse.ArgumentParser()

parser.add_argument('-i','--input',default='/dev/video0',help='input to be classified')

parser.add_argument('-d','--delegate',default='',help='delegate path')

args = parser.parse_args()

?

#設置圖片輸入

if args.input.isdigit():cap_input = int(args.input)

else:cap_input = args.input

vid = cv2.VideoCapture(cap_input)

?

#加載和初始化 TFLite 模型

if args.delegate:ext_delegate = [tflite.load_delegate(args.delegate)]interpreter = tflite.Interpreter(model_path=MODEL_PATH, experimental_delegates=ext_delegate)

else:interpreter = tflite.Interpreter(model_path=MODEL_PATH)

interpreter.allocate_tensors()

?

input_details = interpreter.get_input_details()

output_details = interpreter.get_output_details()

height = input_details[0]['shape'][1]

width = input_details[0]['shape'][2]

?

#初始化性能計數器和讀取照片

total_fps = 0

total_time = 0

?

ret, frame = vid.read()

if frame is None:print("Can't read frame from source file", args.input)exit(0)

?

saved = False

?

#主循環

while ret:total_fps += 1loop_start = time.time()

?#圖像預處理img = cv2.resize(frame, (width, height)).astype(np.uint8)input_data = np.expand_dims(img, axis=0)interpreter.set_tensor(input_details[0]['index'], input_data)#執行推理invoke_start = time.time()interpreter.invoke()invoke_end = time.time()

?#獲取和處理推理結果boxes = interpreter.get_tensor(output_details[0]['index'])[0]labels = interpreter.get_tensor(output_details[1]['index'])[0]scores = interpreter.get_tensor(output_details[2]['index'])[0]number = interpreter.get_tensor(output_details[3]['index'])[0]

?#后處理與可視化if int(number) > 0 and not saved:for i in range(int(number)):if scores[i] > 0.5:box = [boxes[i][0], boxes[i][1], boxes[i][2], boxes[i][3]]x0 = max(2, int(box[1] * frame.shape[1]))y0 = max(2, int(box[0] * frame.shape[0]))x1 = int(box[3] * frame.shape[1])y1 = int(box[2] * frame.shape[0])

?cv2.rectangle(frame, (x0, y0), (x1, y1), (255, 0, 0), 2)cv2.putText(frame, label2string[labels[i]], (x0, y0 + 13),cv2.FONT_HERSHEY_SIMPLEX, 1, (0, 0, 255), 3)print(f"Detected object: ({x0},{y0})-({x1},{y1}) label:{label2string[labels[i]]} score:{scores[i]:.2f}")

?cv2.imwrite('test.bmp', frame)print("Detection result saved as test.bmp")saved = True

?#性能計算與顯示loop_end = time.time()total_time += (loop_end - loop_start)

?fps = int(total_fps / total_time)invoke_time = int((invoke_end - invoke_start) * 1000)print(f"Processing frame {total_fps}: FPS={fps}, Inference time={invoke_time}ms")

?#檢查退出ret, frame = vid.read()if cv2.waitKey(1) & 0xFF == ord('q'):break

?

vid.release()2、應用層QT顯示代碼

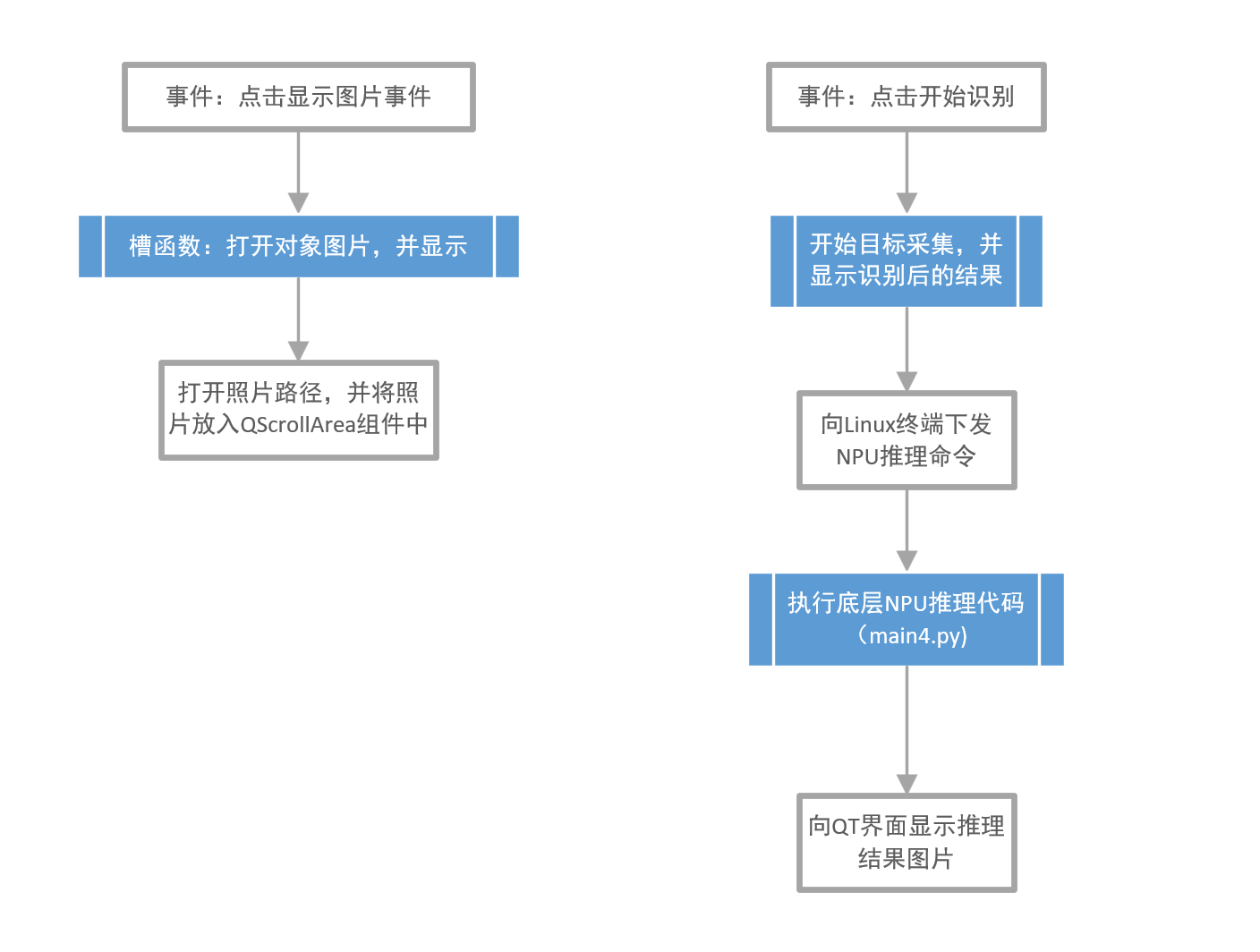

QT應用層代碼流程圖

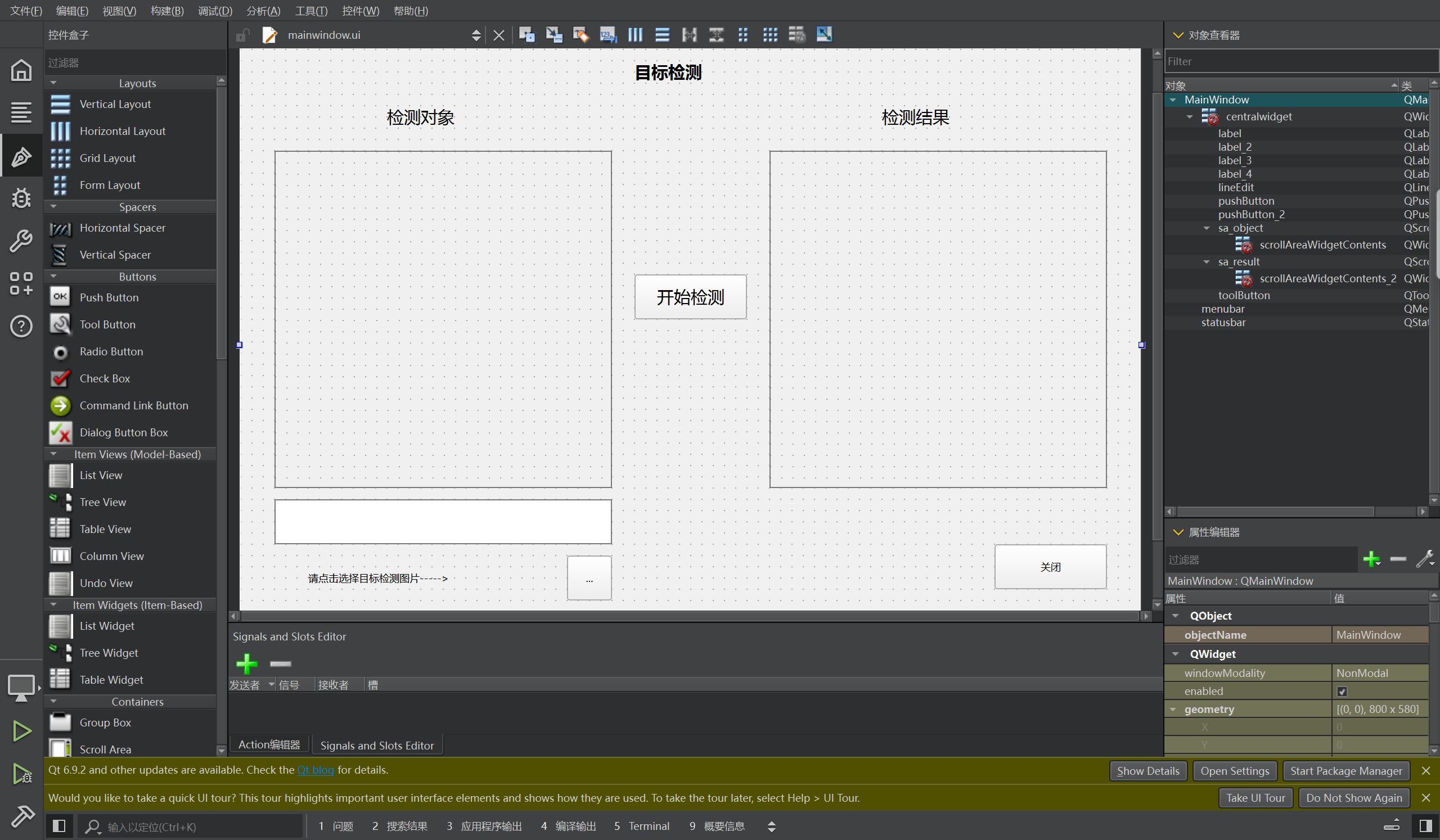

顯示圖像框架預覽

QT核心代碼預覽

/***************************************************************

項目所有文件名 : mainwindow.h main.c mainwindow.c mainwindow.ui

作者 : SELSL

版本 : V1.0

描述 : 使用NPU推理得出圖片類型

其他 : 無

論壇 : 無

日志 : 初版 V1.0 2025/8/8 SELSL創建

***************************************************************/

#include "mainwindow.h"

#include "ui_mainwindow.h"

?

MainWindow::MainWindow(QWidget *parent): QMainWindow(parent), ui(new Ui::MainWindow)

{ui->setupUi(this);

?//設置工作路徑,方便后續操作圖片處理命令QDir::setCurrent("/usr/bin/eiq-examples-git/object_detection");//創建QProcess對象,方便后期進行命令執行process = new QProcess;

?

}

?

MainWindow::~MainWindow()

{delete process;delete imageLabel;delete imageLabel2;delete ui;

}

?

//關閉窗口

void MainWindow::on_pushButton_2_pressed()

{close();

}

?

//打開對象圖片,并顯示

void MainWindow::on_toolButton_clicked()

{//使用QFileDialog中的getOpenFileName獲取要進行目標檢測的圖片地址QString imageName = QFileDialog::getOpenFileName(this, tr("請選擇圖片"), "/usr/bin/eiq-examples-git/object_detection");//輸出圖片地址是否正確qDebug() << imageName;//把圖片地址放入QLineEdit組件中,方便用戶查看ui->lineEdit->setText(imageName);//創建QLabel標簽對象,為放置圖片做準備imageLabel = new QLabel;//把圖片放入QImage對象中QImage image(imageName);//把圖片放入QPixmap處理,在放入QLabel中imageLabel->setPixmap(QPixmap::fromImage(image));//最終把圖片展示在界面的QScrollArea組件中,顯示出要識別的圖片,方便用戶直觀的查看圖片。ui->sa_object->setWidget(imageLabel);

}

?

//開始目標采集,并顯示

void MainWindow::on_pushButton_clicked()

{//輸出當前的工作目錄qDebug() << QDir::currentPath();//使用 NPU 推理進行目標檢測的終端命令QString command1 = QString("python3 main4.py -i ");QString command2 = QString(ui->lineEdit->text());QString command3 = QString(" -d /usr/lib/libethosu_delegate.so");QString command = command1 + command2 + command3;//輸出驗證終端命令是否正確qDebug() << command;//開始使用NPU 推理進行目標檢測process->start("/bin/sh", QStringList() << "-c" << command);//等待使用NPU推理進行目標檢測完成process->waitForFinished();

?//輸出NPU推理目標檢測完成后的輸出信息QString output = process->readAllStandardOutput();qDebug() << output;

?//得到NPU推理得出的目標圖片地址QString imageName = QString("/usr/bin/eiq-examples-git/object_detection/test.bmp");//輸出圖片地址是否正確qDebug() << imageName;

?//創建QLabel標簽對象,為放置圖片做準備imageLabel2 = new QLabel;//把圖片放入QImage對象中QImage image(imageName);//把圖片放入QPixmap處理,在放入QLabel中imageLabel2->setPixmap(QPixmap::fromImage(image));//向目標QScrollArea展示推理得出的目標圖片ui->sa_result->setWidget(imageLabel2);

}注意:QT應用層代碼有mainwindow.h main.c mainwindow.c mainwindow.ui,這里只顯示了最核心的部分mainwindow.c,其他代碼請向項目成員SELSL獲取。

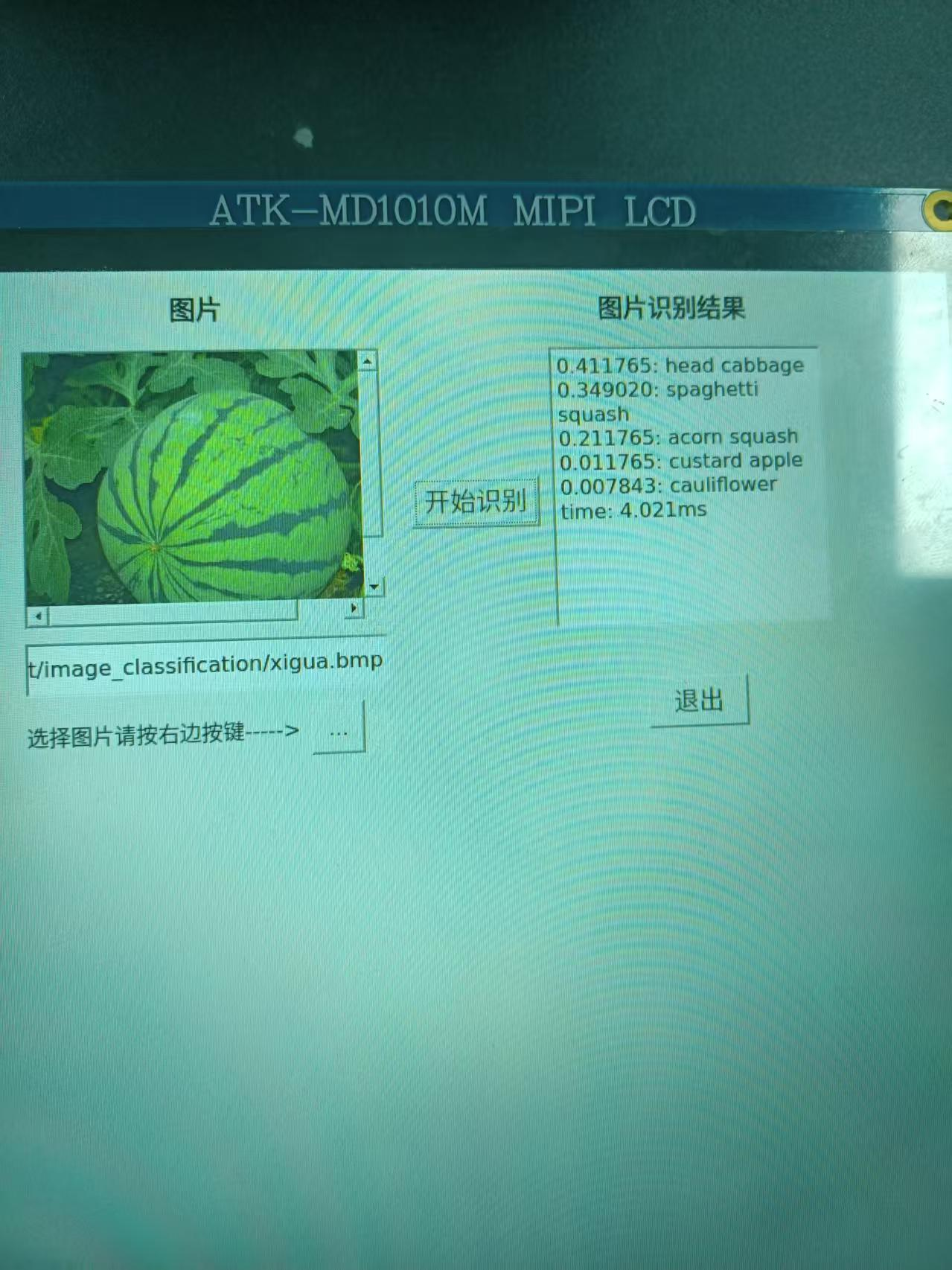

四、項目成果展示

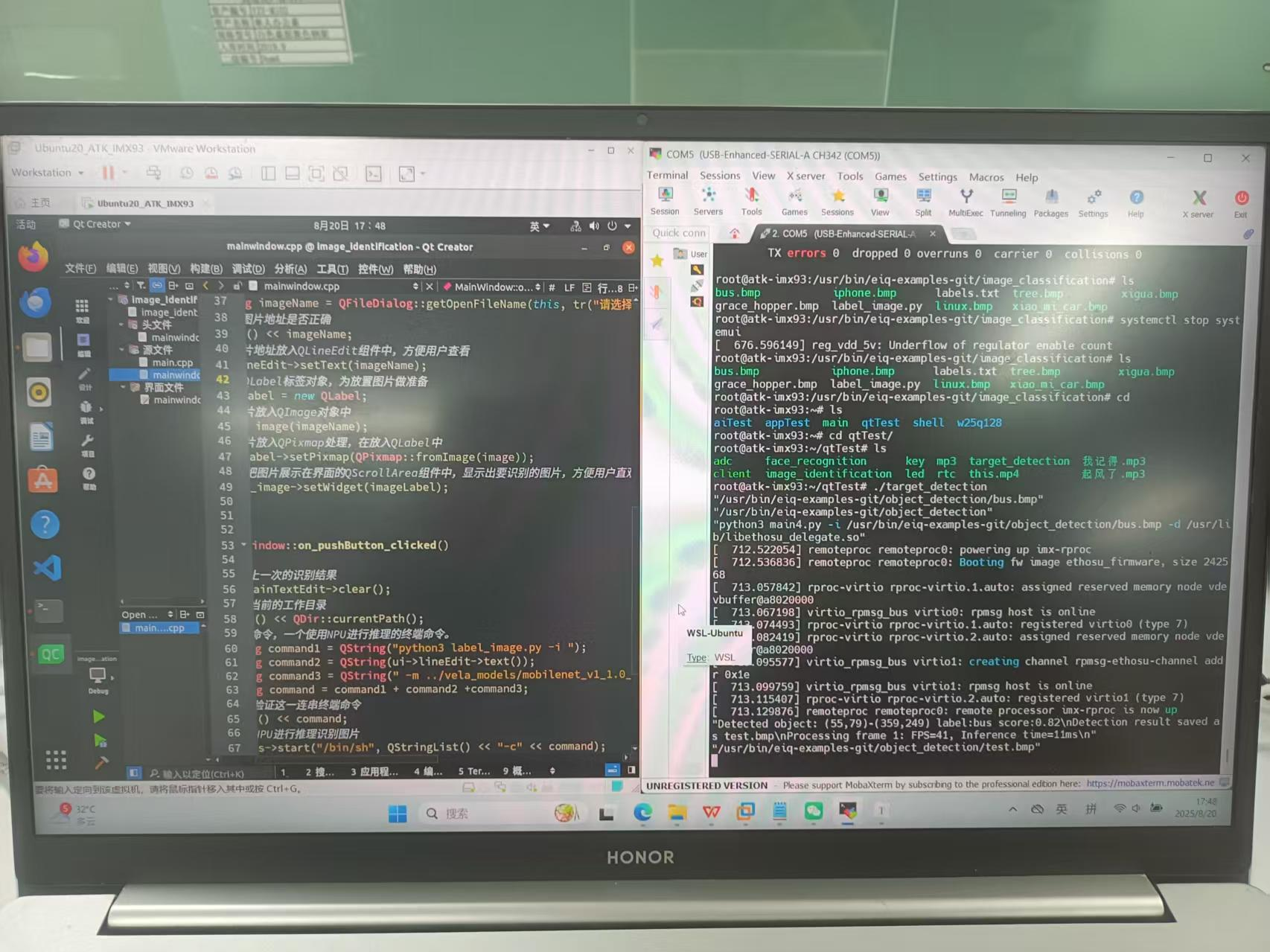

代碼預覽展示

調試階段性結果展示

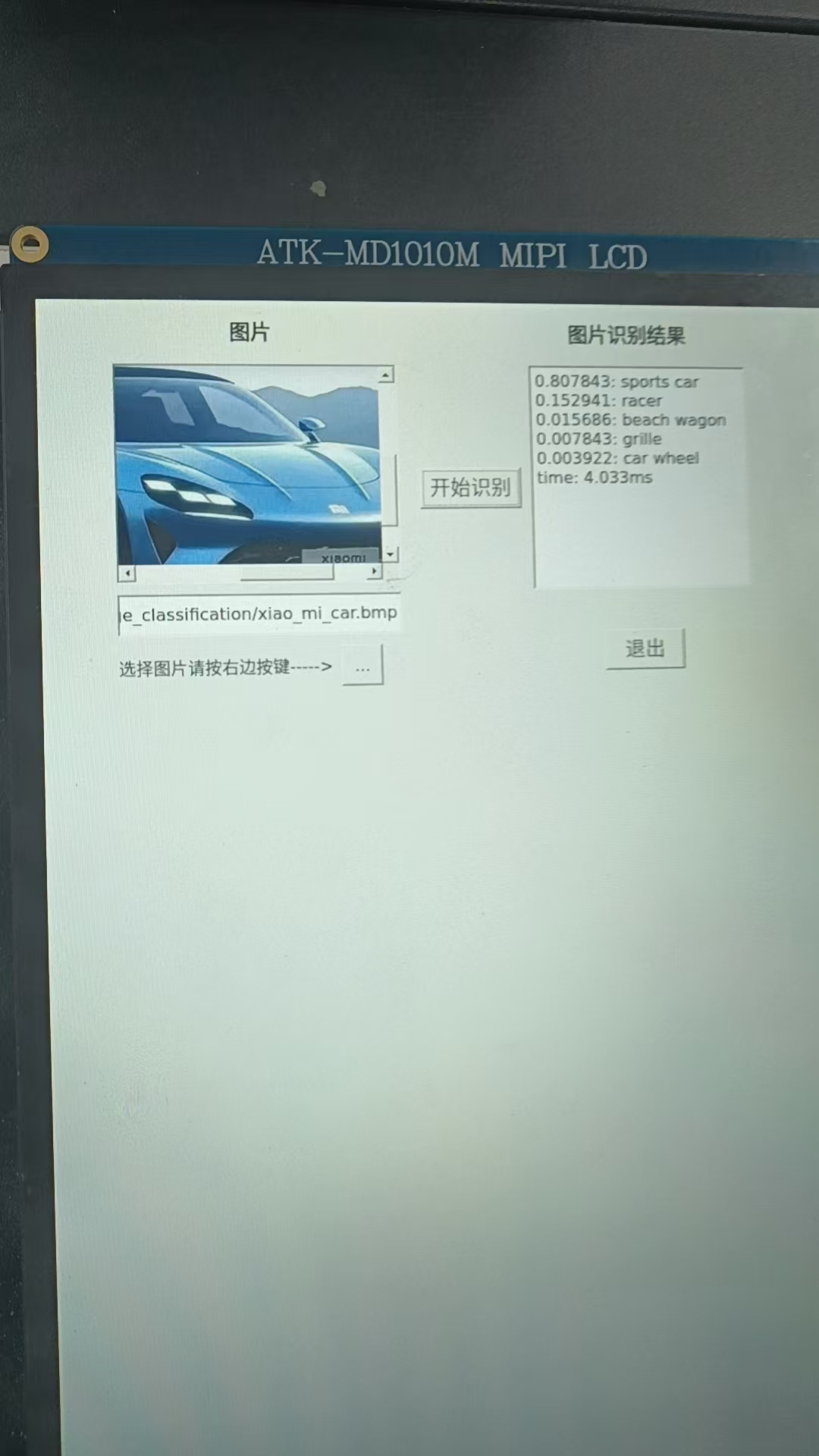

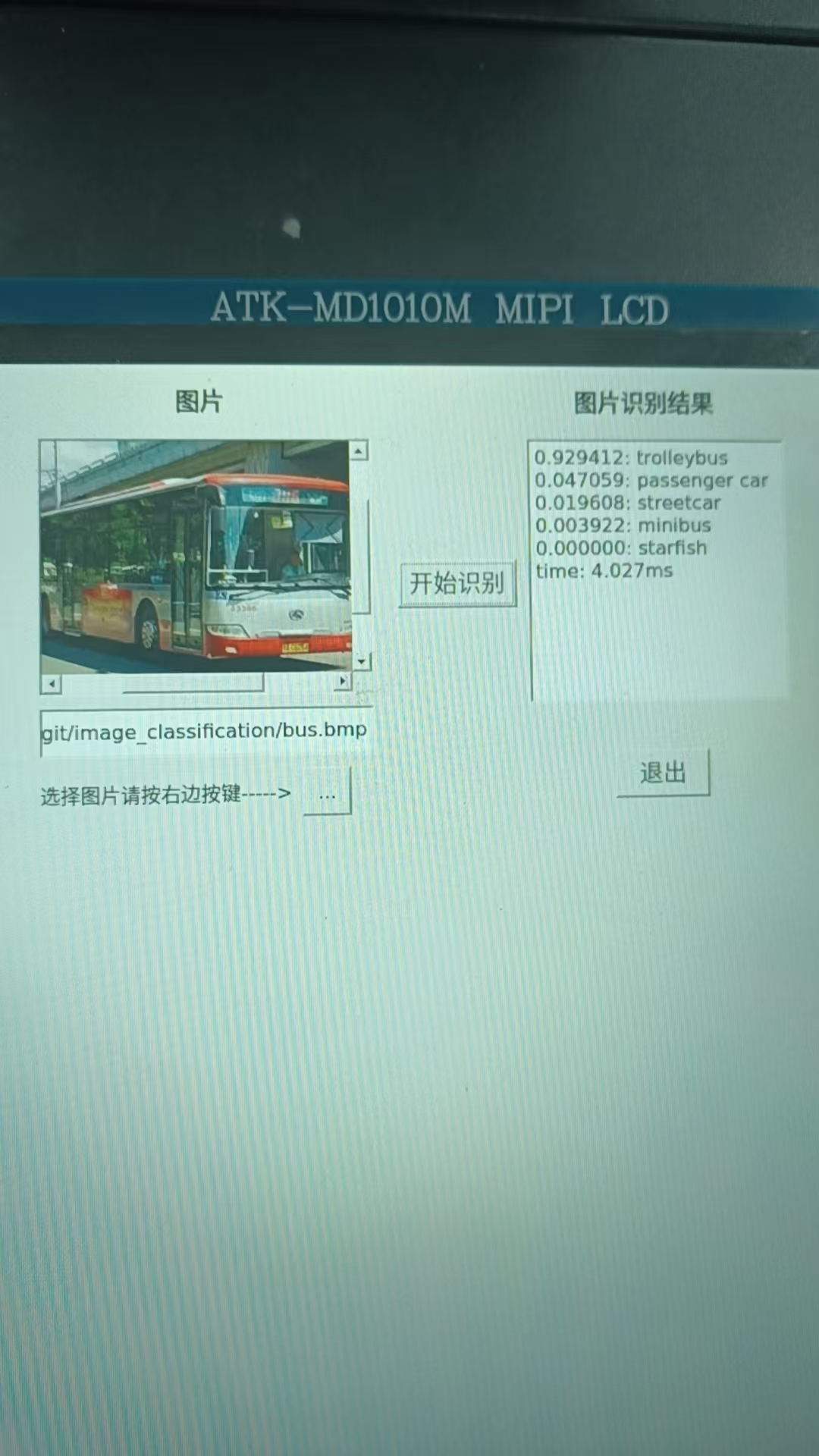

最終結果演示

注意:這個項目我們采用的是官方提供的免費開源模型,開源的,你懂的,就是能用,但是效果沒有自己訓練的模型或買的模型效果好,所以有一部分物體識別達不到先要的效果,包括本團隊后期使用NPU進行的人臉識別推理,同一個人識別出不同的效果的現象。這不是代碼的問題也NPU的問題,而是模型上的問題。

我們的NPU算力達到了6TOPs,在移動終端設備上是一個比較快的水準,當然向上與GPU幾百的算力相比還是稍顯遜色,但是相比于功耗來說,我們的NPU的功耗是遠遠低于GPU的功耗。這里通過上面的調試推理過程也可以看到推理時間大概在4ms左右,這也是一個很快的推理速度,相比與傳統的把圖片上傳至云端耗時操作好點的,特別是在實時性要求比較高的場所,NPU邊緣推理是一個很好的解決方案。

資料獲取:https://download.csdn.net/download/2403_82436914/91888061

—ID3樹 、C4.5樹、CART樹】)

![[光學原理與應用-431]:非線性光學 - 能生成或改變激光波長的物質或元件有哪些?](http://pic.xiahunao.cn/[光學原理與應用-431]:非線性光學 - 能生成或改變激光波長的物質或元件有哪些?)

)