2025深度學習發論文&模型漲點之——光學神經網絡

光學神經網絡的基本原理是利用光的傳播、干涉、衍射等特性來實現神經網絡中的信息處理和計算。在傳統神經網絡中,信息以電信號的形式在電子元件之間傳輸和處理,而在光學神經網絡中,信息則以光信號的形式進行傳輸和處理。例如,光的強度可以用來表示神經元的激活值,光的相位可以用來表示權重等。

我整理了一些光學神經網絡【論文+代碼】合集,需要的同學看我主頁

論文精選

論文1:

FatNet: High Resolution Kernels for Classification Using Fully Convolutional Optical Neural Networks

FatNet:使用全卷積光學神經網絡的高分辨率核進行分類

方法

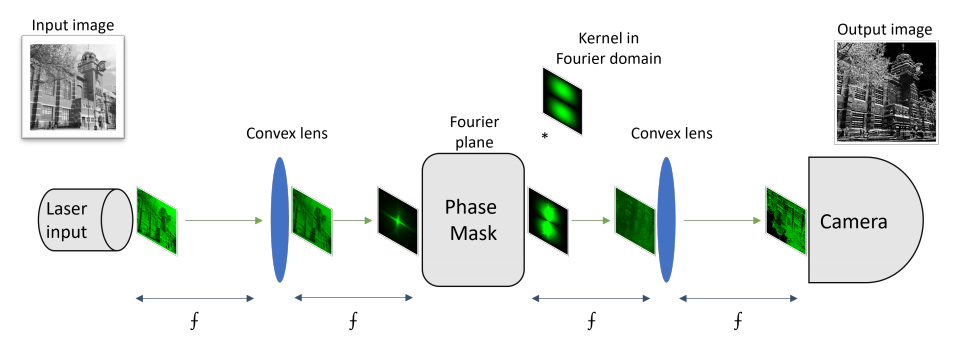

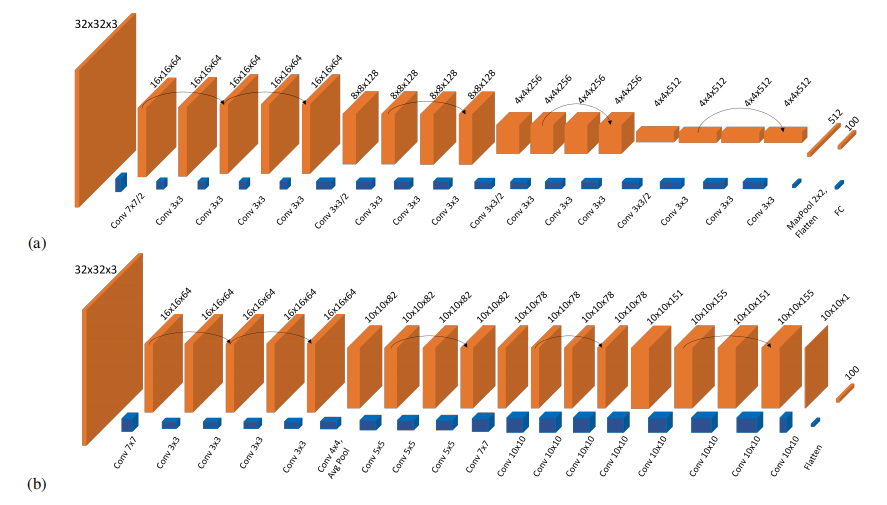

全卷積網絡架構:將傳統卷積神經網絡轉換為全卷積網絡,利用自由空間4f系統加速推理速度。

高分辨率核與特征圖:使用高分辨率的核和特征圖,減少通道數量,提高光學推理速度。

光學模擬器:開發了光學模擬器OptConv2d,模擬4f系統的光傳播,驗證FatNet在光學設備上的性能。

訓練與驗證:在CIFAR-100數據集上訓練FatNet,并與ResNet-18進行比較。

創新點

高分辨率核的優勢:FatNet使用高分辨率核,減少了卷積操作次數,相比ResNet-18減少了8.2倍的卷積操作。

性能提升:盡管FatNet的測試準確率比ResNet-18低6%,但在光學推理中速度更快,尤其是在大批次推理時。

光學推理效率:FatNet在光學設備上比ResNet-18更快,且在3136的大批次推理中,光學推理的加速效果顯著。

論文2:

[Nature] Fully forward mode training for optical neural networks

光學神經網絡的全前向模式訓練

方法

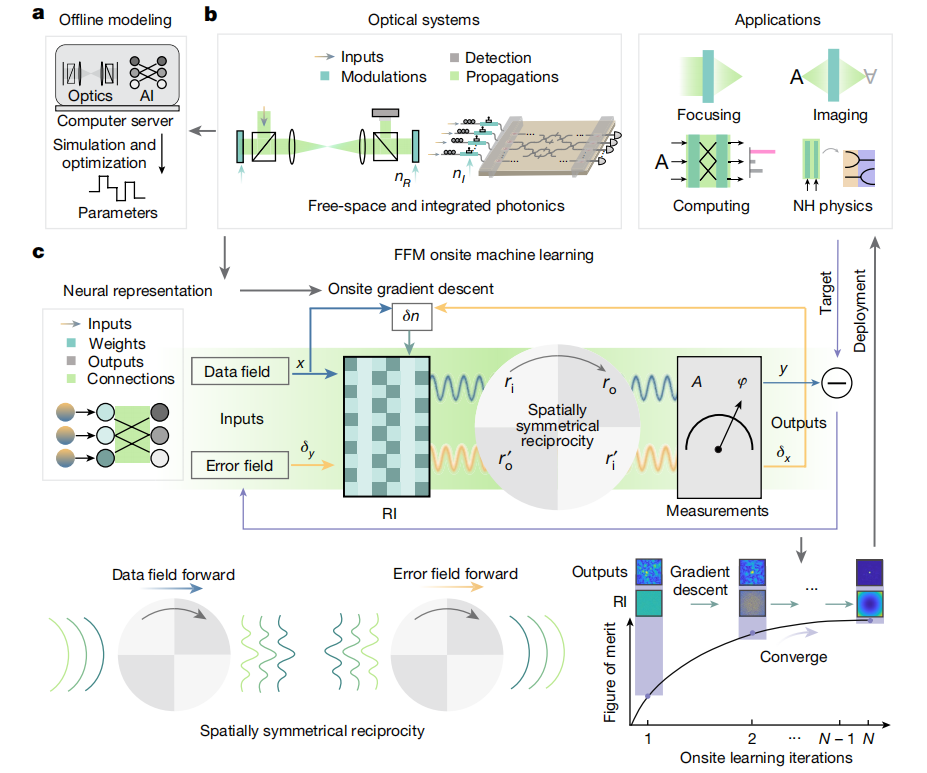

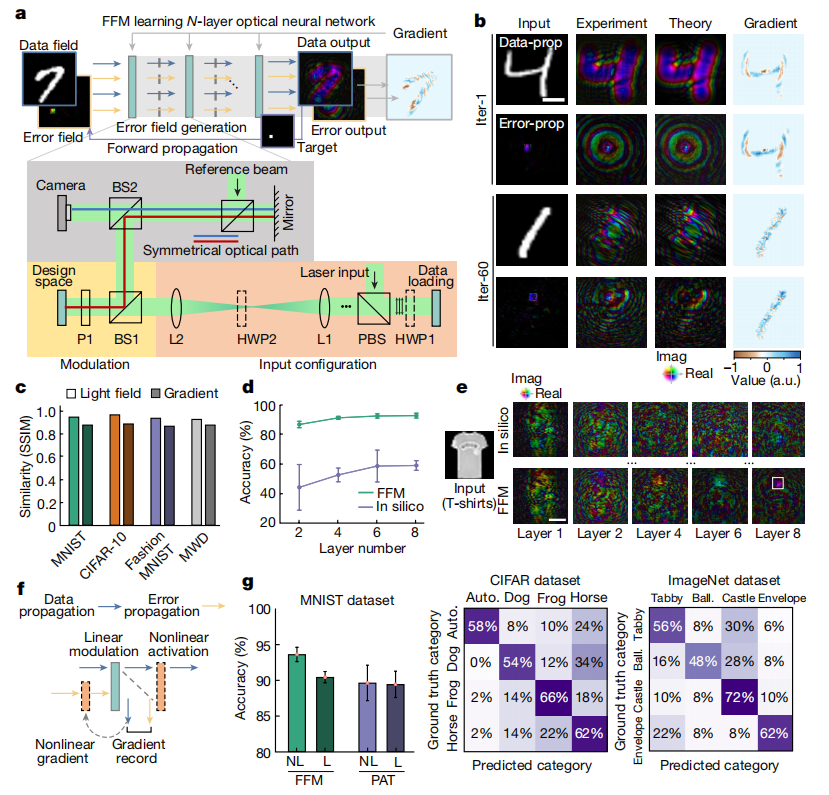

全前向模式(FFM)學習:在物理系統上直接進行計算密集型訓練過程,利用空間對稱性和洛倫茲互易性,消除了反向傳播的需要。

光學系統映射:將光學系統映射到參數化的神經網絡,通過測量輸出光場計算梯度,更新設計區域的折射率。

實驗驗證:在自由空間和集成光子學中驗證了FFM學習方法,展示了其在高分辨率成像、非視距成像和非厄米特系統中的應用潛力。

創新點

訓練效率提升:首次實現了光學神經網絡的全前向模式訓練,無需反向傳播,顯著提高了訓練效率。

高分辨率成像:在通過散射介質的聚焦實驗中,FFM學習達到了接近衍射極限的分辨率,平均FWHM為81.2μm,PSNR為8.46dB。

非視距成像:在非視距成像實驗中,FFM學習實現了1ms曝光時間的動態成像,能夠分辨出最小56.0μm的線對。

能效提升:在高能效處理中,FFM學習實現了每秒每瓦10^18次操作的能效。

論文3:

[Nature子刊] Single-chip photonic deep neural network with forward-only training

單芯片光子深度神經網絡的全前向訓練

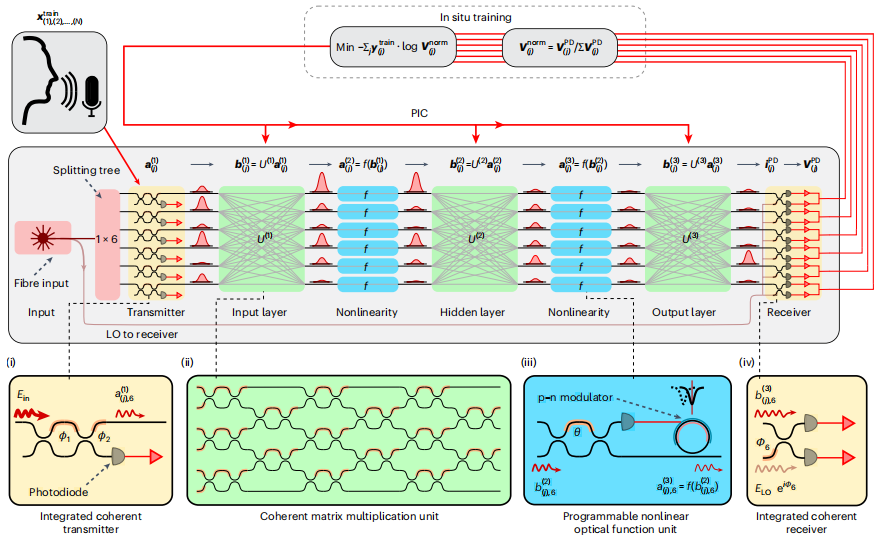

方法

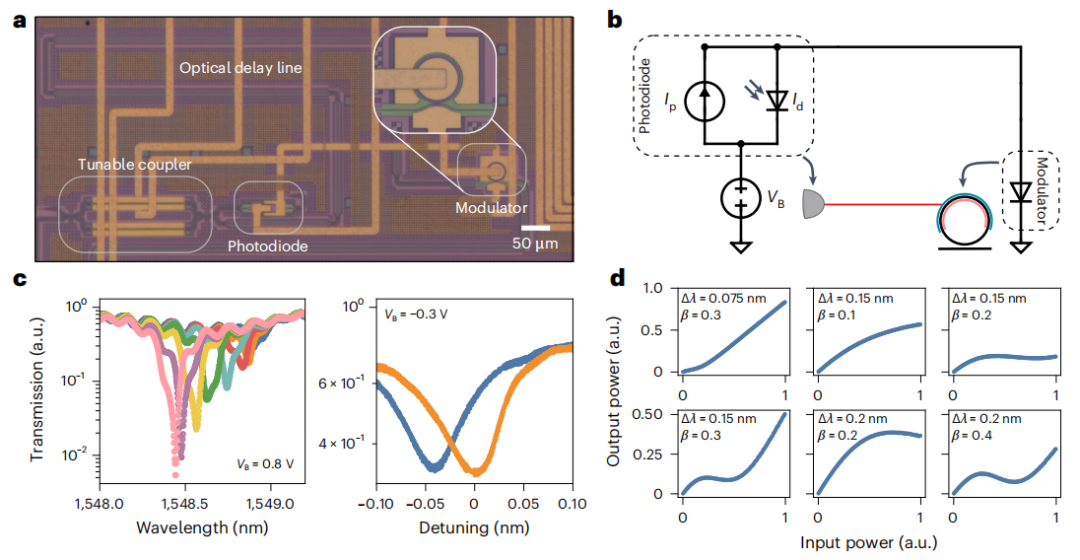

單芯片集成:在單個芯片上集成了多個相干光學處理器單元,用于矩陣代數和非線性激活函數。

全光學推理:實現了全光學的深度神經網絡推理,具有極低的延遲(410皮秒)和高能效。

現場訓練:提出了一種現場訓練方法,直接在硬件上計算模型參數的導數,優化權重。

實驗驗證:在六類元音分類任務上驗證了該系統的性能,達到了92.5%的準確率。

創新點

低延遲推理:實現了410皮秒的極低延遲,相比傳統電子系統顯著提升。

高能效:通過全光學處理,每操作的能量消耗低至4.6皮焦耳,相比傳統電子系統大幅降低。

現場訓練:首次實現了全光學深度神經網絡的現場訓練,準確率達到92.5%,與數字計算機相當。

可擴展性:該架構可以擴展到更大的系統,通過多芯片集成和光譜復用進一步降低能耗。

)