在自然語言處理(NLP)的浩瀚宇宙中,原始文本數據如同未經雕琢的璞玉。而文本預處理,尤其是其中至關重要的正則表達式技術,正是將這塊璞玉轉化為精美玉器的核心工具集。本文將深入探討正則表達式在NLP文本預處理中的原理、技巧與實踐應用。

一、文本預處理:NLP的基石

為什么預處理至關重要?

-

數據質量決定模型上限

-

噪聲數據(HTML標簽、特殊符號、亂碼)導致特征稀疏

-

不一致的格式(日期/貨幣表達)干擾模型學習

-

研究表明:預處理可提升文本分類準確率5-15%

-

-

維度災難的應對

原始文本的極高維度(如所有可能字符組合)通過清洗、標準化、分詞被壓縮到可計算范圍

預處理核心流程

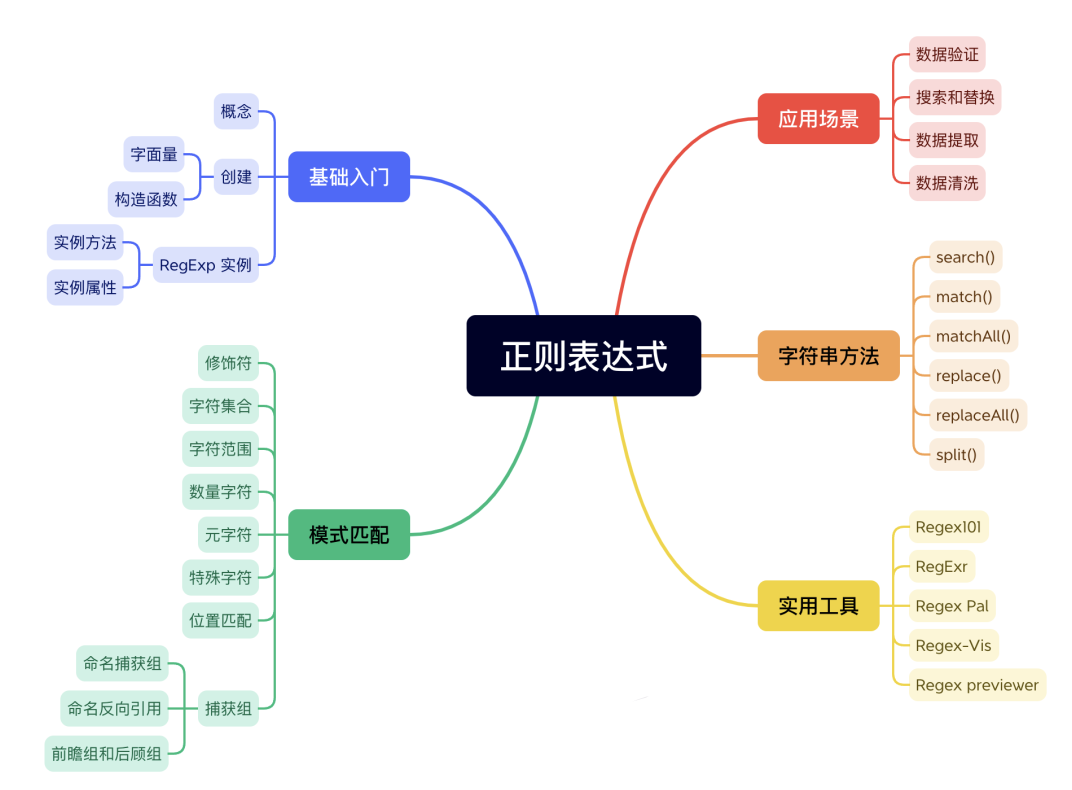

二、正則表達式:文本處理的瑞士軍刀

基礎元字符詳解

| 字符 | 功能 | 示例 | 匹配結果 |

|---|---|---|---|

. | 任意單字符 | a.c | abc, aac, axc |

\d | 數字 | \d{3} | 123, 001 |

\w | 單詞字符 | \w+ | hello, word3 |

\s | 空白字符 | hello\swo | 'hello wo' |

^ | 行首 | ^Dear | 信件開頭 |

$ | 行尾 | end$ | 行末的end |

高級特性實戰

-

貪婪 vs 惰性匹配

-

".*"?匹配整句:<div>Content</div>?→ 整個標簽 -

".*?"?最小匹配:<div>(.*?)</div>?→ 僅"Content"

-

-

零寬斷言(Lookaround)

-

提取價格數值:

(?<=\$)\d+\.\d{2}?→ "$19.99"中匹配"19.99" -

排除停用詞:

\b(?!the\b)\w+\b

-

-

命名捕獲組

pattern = r"(?P<area>\d{3})-(?P<prefix>\d{3})-(?P<line>\d{4})" match = re.search(pattern, "Phone: 123-456-7890") print(match.group('area')) # 輸出:123

三、NLP預處理中的正則表達式實戰

1. 深度數據清洗

import redef clean_text(text):# 刪除HTML標簽text = re.sub(r'<[^>]+>', '', text) # 移除URL鏈接text = re.sub(r'https?://\S+|www\.\S+', '[URL]', text)# 過濾特殊字符(保留中英文及常用標點)text = re.sub(r'[^\w\u4e00-\u9fff\.,!?;:’\'"\-]', ' ', text)# 合并連續空格text = re.sub(r'\s+', ' ', text)return text.strip()2. 結構化信息抽取

# 抽取郵件地址

emails = re.findall(r'\b[A-Za-z0-9._%+-]+@[A-Za-z0-9.-]+\.[A-Z|a-z]{2,}\b', text)# 識別中文身份證號

id_cards = re.findall(r'\b[1-9]\d{5}(?:19|20)\d{2}(?:0[1-9]|1[0-2])(?:0[1-9]|[12]\d|3[01])\d{3}[\dXx]\b', text)3. 文本標準化

# 日期統一格式化

text = re.sub(r'(\d{4})[-/年](\d{1,2})[-/月](\d{1,2})日?', r'\1年\2月\3日', text)# 貨幣標準化

text = re.sub(r'¥\s*(\d+(?:\.\d+)?)', r'人民幣\1元', text)4. 高級分詞輔助

# 處理英文縮略詞

text = re.sub(r"\b([A-Z])\.", r"\1", text) # U.S.A → USA# 分離粘連詞

text = re.sub(r"([a-z])([A-Z])", r"\1 \2", text) # "helloWorld" → "hello World"四、性能優化與陷阱規避

正則表達式引擎原理

-

DFA vs NFA引擎

Python的re模塊使用NFA引擎,支持回溯但需警惕災難性回溯# 危險示例:指數級復雜度 re.match(r'(a+)+$', 'aaaaaaaaX') # 輸入稍長即卡死 -

編譯重用提升效率

# 錯誤做法:每次調用重新編譯 for text in texts:re.sub(r'\d+', '', text)# 正確優化:預編譯模式 digit_pattern = re.compile(r'\d+') for text in texts:digit_pattern.sub('', text)

?

常見陷阱解決方案

-

Unicode匹配問題

# 匹配中文字符(需開啟Unicode支持) re.findall(r'\p{Han}+', text, re.UNICODE) # 使用regex庫更佳 -

多行模式混淆

# 需明確指定多行模式 re.findall(r'^##\s(.+)$', text, re.MULTILINE)

五、超越基礎:正則表達式在現代NLP中的位置

雖然深度學習(如BERT)減少了對嚴格規則的需求,但正則表達式仍在關鍵場景不可替代:

-

工業級數據流水線

在億級文本的預處理中,正則表達式仍是最高效的首選工具 -

領域自適應

醫療文本中處理"COVID-19"、"CT影像"等專業術語 -

規則+模型的混合系統

graph TB A[輸入文本] --> B{規則匹配} B -->|匹配成功| C[直接輸出結果] B -->|匹配失敗| D[深度學習模型] D --> E[模型輸出]

結語:掌握文字煉金術

正則表達式不是冰冷的符號組合,而是一種精確描述語言規律的元語言。在NLP實踐中:

-

避免"正則萬能論":復雜語法(如嵌套引用)可讀性差,應考慮其他方案

-

牢記"82法則":20%的常用模式(如

\w+,?\d{4})解決80%的問題 -

結合上下文:預處理需服務于下游任務,電商評論與學術論文的處理策略截然不同?

附錄:正則表達式速查表

基礎類:\d 數字 \D 非數字\w 單詞 \W 非單詞\s 空白 \S 非空白量詞:* 0或多 + 1或多? 0或1 {n} n次{n,} ≥n次 {m,n} m到n次高級:(?:...) 非捕獲分組 (?=...) 正向預查(?!...) 負向預查 (?<=...) 反向肯定預查——網絡層)

![[Redis] Redis:高性能內存數據庫與分布式架構設計](http://pic.xiahunao.cn/[Redis] Redis:高性能內存數據庫與分布式架構設計)

Naflex模型的動態分辨率原理)

)