Transformer

谷歌提出,一組編碼-解碼器

可以同時處理,通過位置編碼來處理單詞

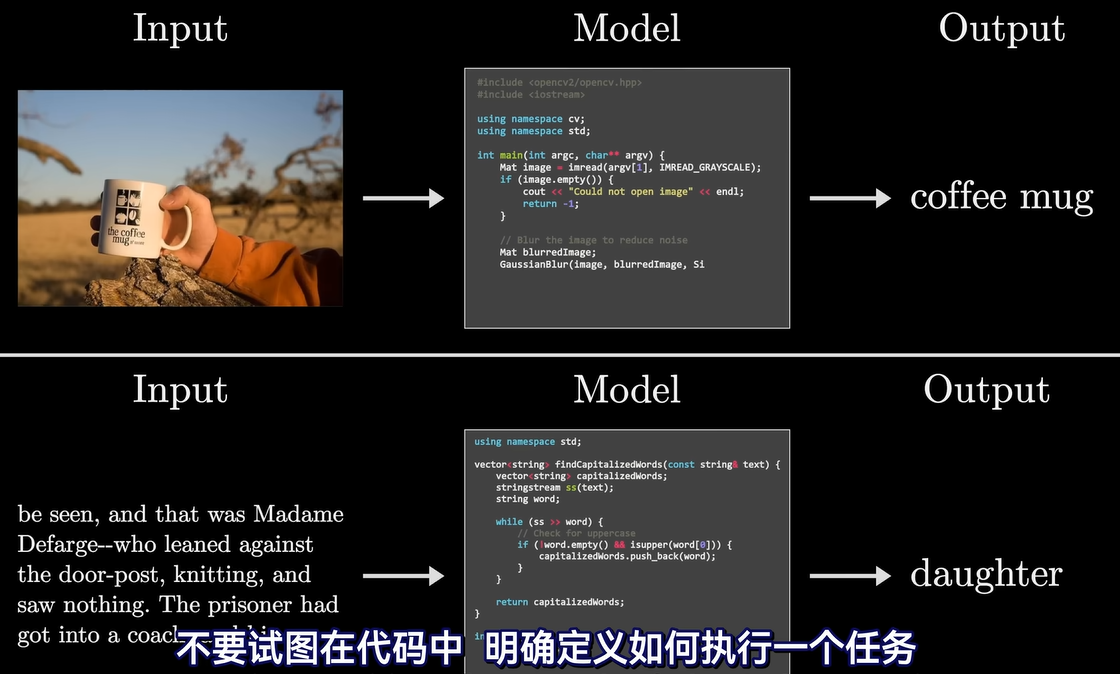

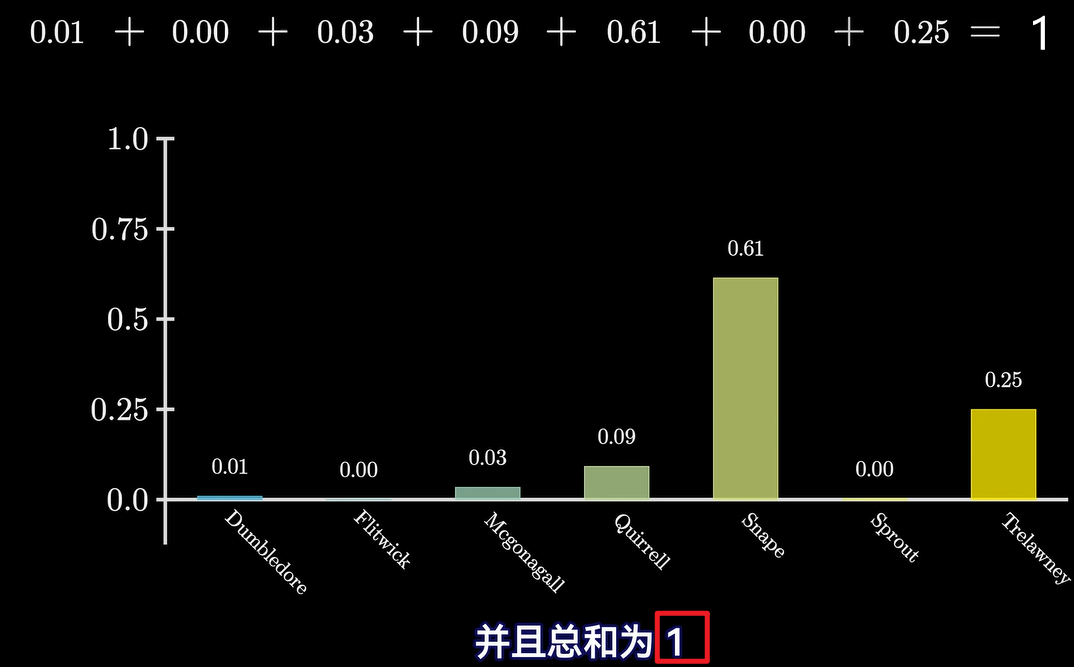

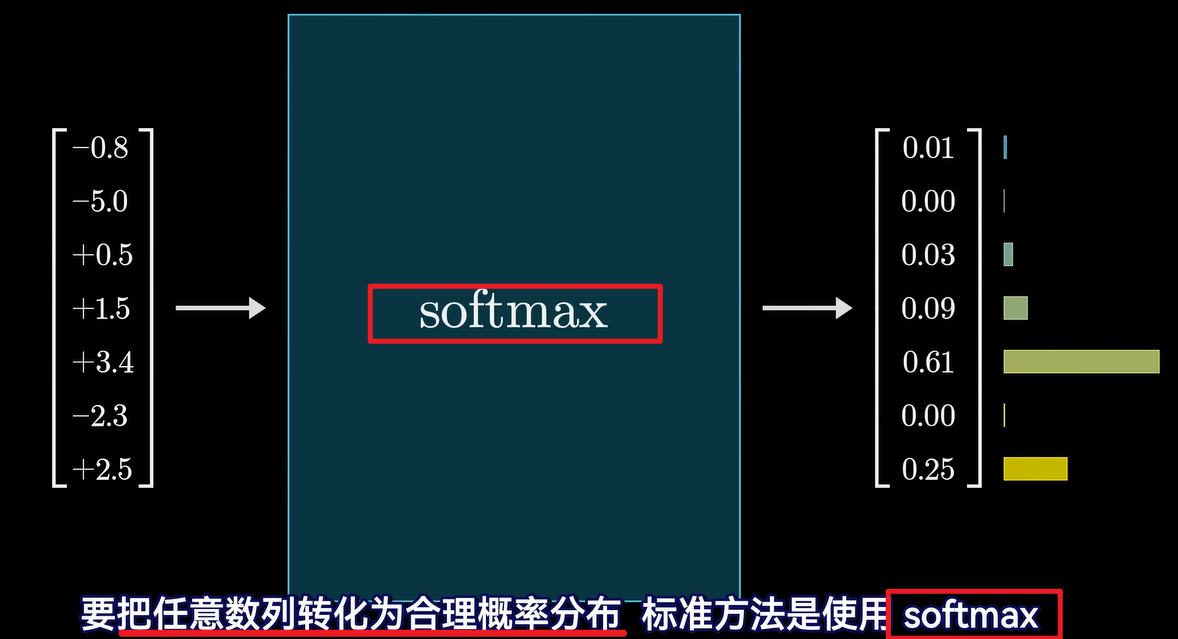

實質是token詞語接龍(只是有不同的概率)

token對應向量

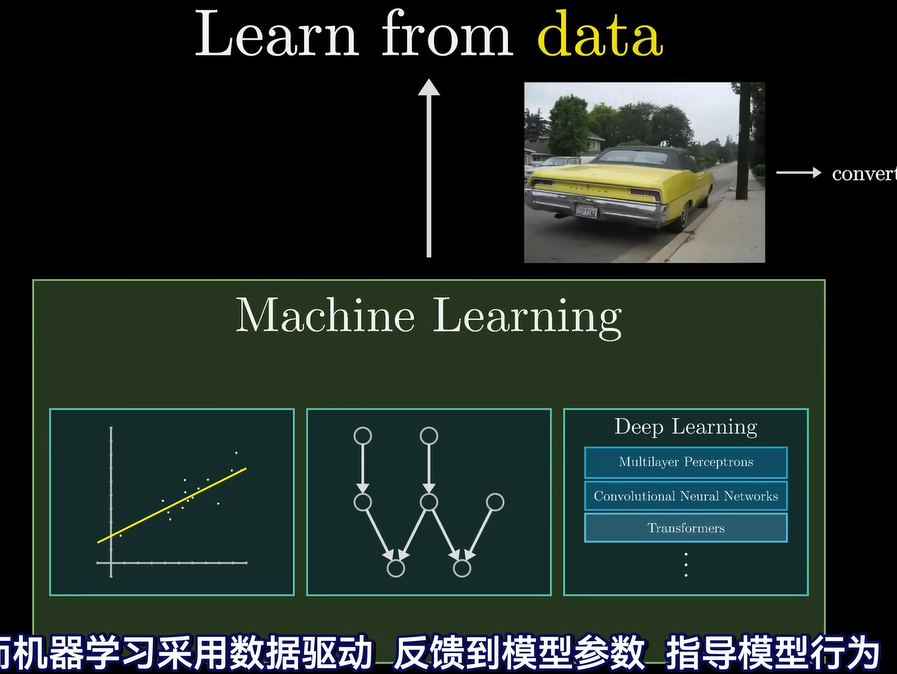

Transformer簡述

?文生圖就需要用到transformer黑箱

?文生圖就需要用到transformer黑箱

?

?

token

?

?

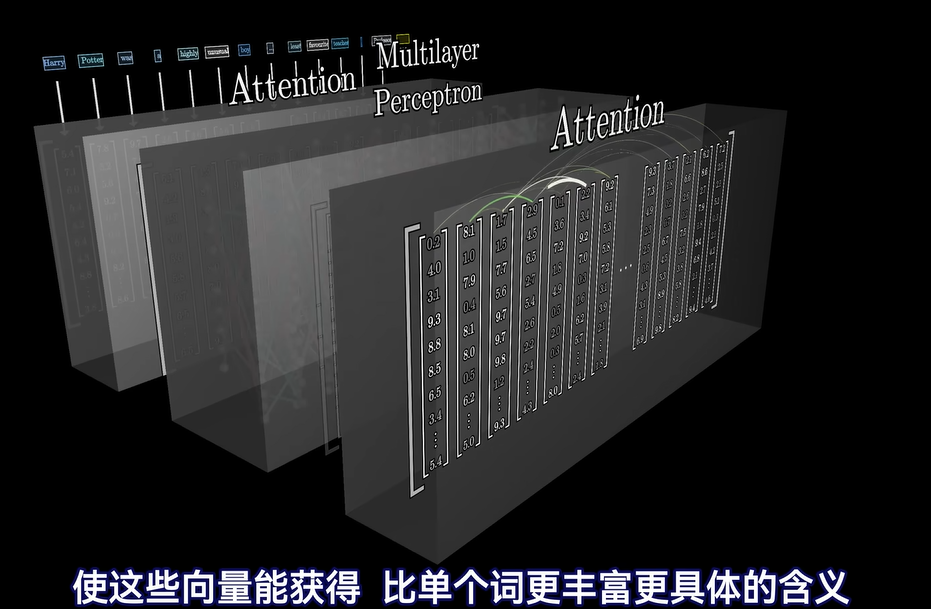

內部層次

中間主要是embedding matrix嵌入矩陣、attention注意力模塊、multilayer perception多層感知機(MLP)

attention注意力模塊內部是互相交流的、multilayer perception多層感知機(MLP)內部是并行不交流的

?

?

? ?

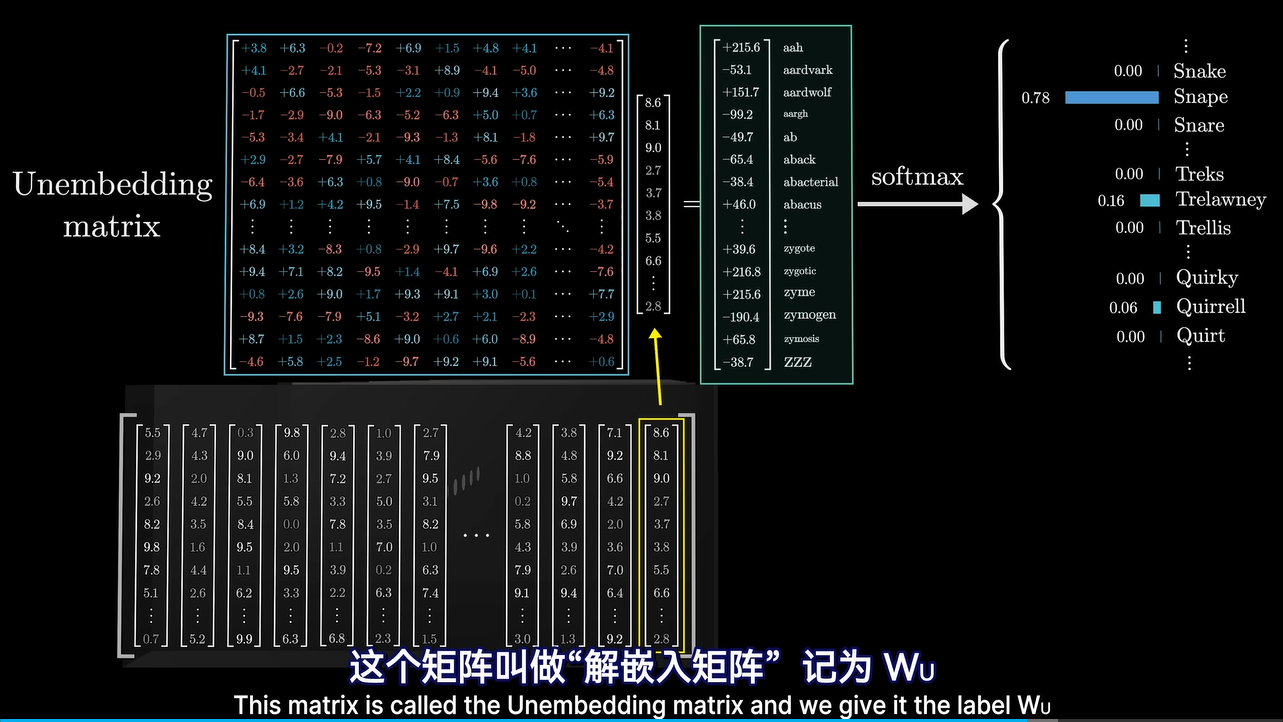

本質就是線性代數

?

?

?

?

?

?

實質通過矩陣運算

?有不同的矩陣

?有不同的矩陣

?嵌入矩陣

?如何推測的舉例:1、男人之于女人≈國王之于王后

?如何推測的舉例:2、媽媽之于爸爸≈ 女人之于男人

???????????????????????????? 3、希特勒+意大利-德國≈ 墨索里尼(從軸心國領導人/意大利兩個角度找到)

???????????????????????????? 4、壽司+德國-日本≈ 油煎香腸

?點積是表達兩個向量是否相近的方式,通過運算結果正負判斷

?

?

![]()

?context size就是一次處理向量的數量

?

所以當context size較少時,gpt會出現遺忘了之前說的

解嵌入矩陣

?softmax

補充:另一個transformer介紹,不是很生動。所以只看了開頭。

?

?

?

?

Unity 物理系統之范圍檢測)

變換圖像與形態學操作)