隨著人工智能技術的飛速發展,本地部署大型語言模型(LLM)已成為許多技術愛好者的熱門選擇。本地部署不僅能夠保護隱私,還能提供更靈活的使用體驗。本文將詳細介紹如何在 Mac mini M2(24GB 內存)上部署 DeepSeek-R1:14B 模型,并通過 Ollama 和 Chatbox 進行交互。同時,我們也會對比使用 Open-WebUI 的體驗,幫助你選擇最適合自己的工具。

一、環境準備

硬件要求

- 設備:Mac mini M2,24GB 內存。

- 存儲空間:至少需要 50GB 的可用空間,建議預留更多空間以避免磁盤空間不足。

軟件要求

- 操作系統:macOS Monterey 或更高版本。

- Ollama:用于運行和管理 DeepSeek 模型的本地引擎。

- Chatbox:輕量級的圖形界面工具,用于與模型進行交互。

- Docker(可選):如果需要使用 Open-WebUI,需要安裝 Docker。

二、安裝Ollama

Ollama 是一個輕量級的本地 AI 模型管理工具,支持多種語言模型的運行和管理。以下是安裝步驟:

1、安裝 Ollama

訪問 Ollama 官方網站https://ollama.com/,下載適用于 macOS 的安裝包。下載完成后,點擊安裝包使行安裝

2、啟動 Ollama 服務

安裝完成后,運行以下命令啟動 Ollama 服務:

ollama serve

驗證 Ollama 是否運行正常

在瀏覽器中訪問 http://127.0.0.1:11434,如果看到 Ollama 的歡迎頁面,說明服務已成功啟動。

三、下載并運行DeepSeek-R1:14B 模型

DeepSeek-R1:14B 是一個功能強大的語言模型,適用于多種自然語言處理任務。以下是下載和運行模型的步驟:

https://ollama.com/library/deepseek-r1:14b

1、下載模型

在終端中運行以下命令下載 DeepSeek-R1:14B 模型:

ollama pull deepseek-r1:14b

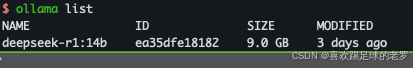

2、驗證模型是否下載成功

下載完成后,運行以下命令檢查模型是否正確安裝:

ollama list

如果看到 deepseek-r1:14b 出現在已安裝模型列表中,說明模型已成功下載。

3、運行模型

使用以下命令啟動模型并進入交互模式:

ollama run deepseek-r1:14b

效果如下

四、安裝并配置 chatbox

Chatbox 是一個輕量級的圖形界面工具,支持與 Ollama 管理的模型進行交互。以下是安裝和配置步驟:

安裝 Chatbox

訪問 Chatbox 官方網站,下載適用于 macOS 的安裝包并安裝。https://chatboxai.app/zh#download

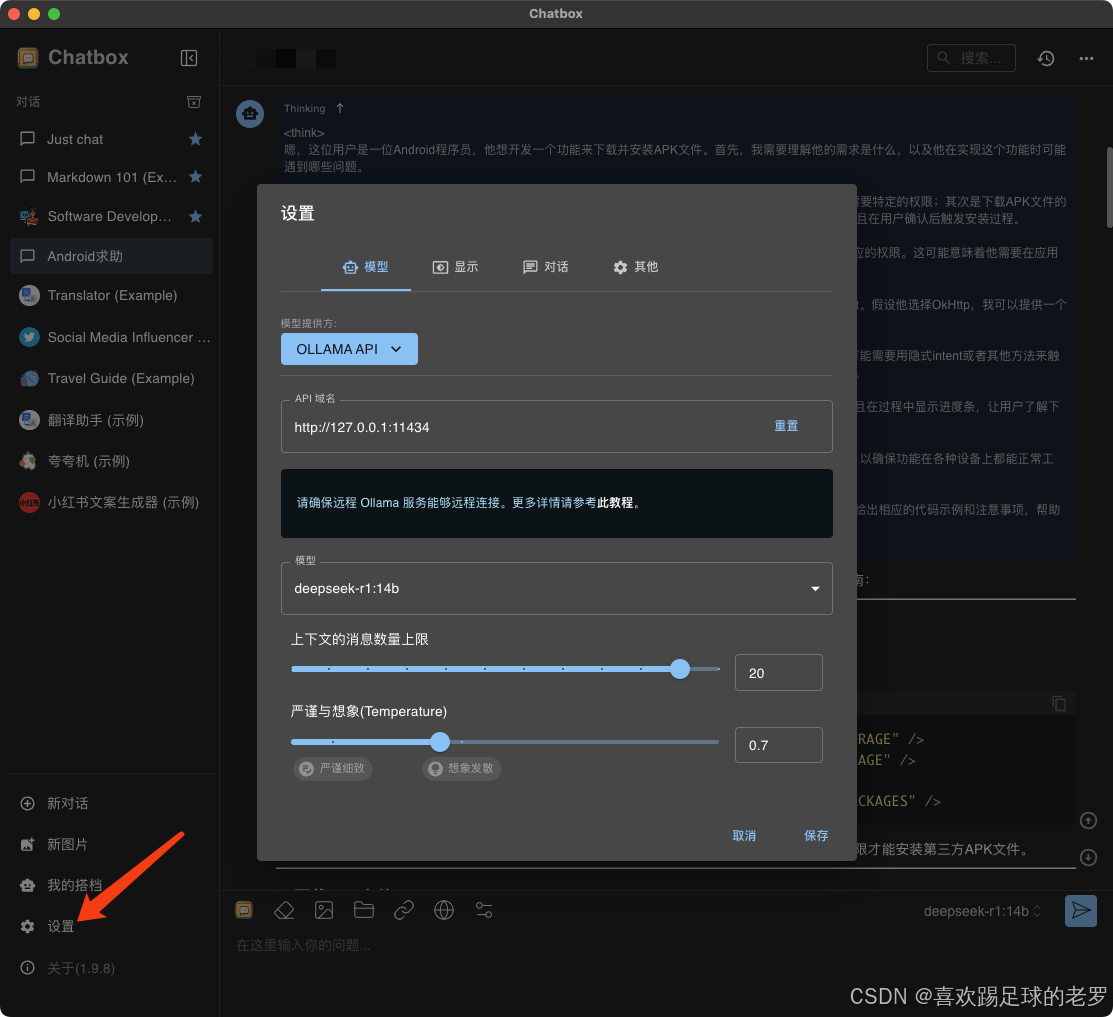

配置 Chatbox

- 打開 Chatbox 應用程序,進入設置頁面:

- API 地址:設置為 http://127.0.0.1:11434。(模型提供方,選中OLLAMA API后,域名會自動填寫,可選的模型也會自動列出來)

- 模型選擇:選擇 deepseek-r1:14b。

開始使用

配置完成后,你可以通過 Chatbox 的界面輸入問題,并與 DeepSeek-R1:14B 模型進行交互。

五、體驗與對比:Chatbox vs. Open-WebUI

在本地部署過程中,我們還嘗試了 Open-WebUI,一個基于 Web 的交互界面。以下是兩者的主要對比:

| 特性 | Chatbox | Open-WebUI |

|---|---|---|

| 優點 | - 輕量級:安裝和配置簡單,占用資源少。 - 易用性高:圖形界面直觀,適合新手快速上手。 - 響應速度快:本地運行,無需額外的網絡延遲。 | - 功能豐富:支持多種模型,提供更復雜的交互功能。 - 靈活性高:可以通過瀏覽器訪問,支持多設備使用。 |

| 缺點 | - 功能有限:主要專注于與模型的交互,擴展功能較少。 | - 配置復雜:需要安裝 Docker,并進行額外的配置。 - 資源占用高:運行時可能需要更多內存和存儲空間。 |

| 適用場景 | - 適合快速部署和簡單使用,對資源占用敏感的用戶。 | - 適合需要復雜交互功能、多設備訪問的用戶。 |

PS:安裝與啟動open-webui的命令

docker run -d -p 3110:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

通過http://localhost:3110/ ,訪問open-webui

第一次訪問要注冊用戶

六、總結

通過 Ollama 和 Chatbox,你可以在 Mac mini M2 上輕松部署并使用 DeepSeek-R1:14B 模型。整個過程簡單高效,且不需要復雜的配置。無論你是技術新手還是有一定經驗的開發者,都可以快速上手并享受本地 AI 模型帶來的便利。

希望本文能幫助你順利完成部署,開啟智能對話的新體驗!如果你在部署過程中遇到任何問題,歡迎隨時留言交流。

》)

)

)

:Windows系統本地化部署操作方法(專業版))