目錄

1. 項目相關背景

2. 搜索引擎的相關宏原理

3. 搜索引擎的技術棧和項目環境

4. 正排索引, 倒排索引, 搜索引擎具體原理

5. 編寫數據去標簽化和數據清洗的模塊parser(解析器).

1.項目相關背景

百度, 搜狗, 360等都有搜索引擎, 但是都是全網的搜索;

?boost是進行站內搜索, 數據更少并且垂直.

觀察通過不同的搜索引擎進行查找的時候會出現不同的關鍵字, 一般包括title, content, 網址, 時間等.

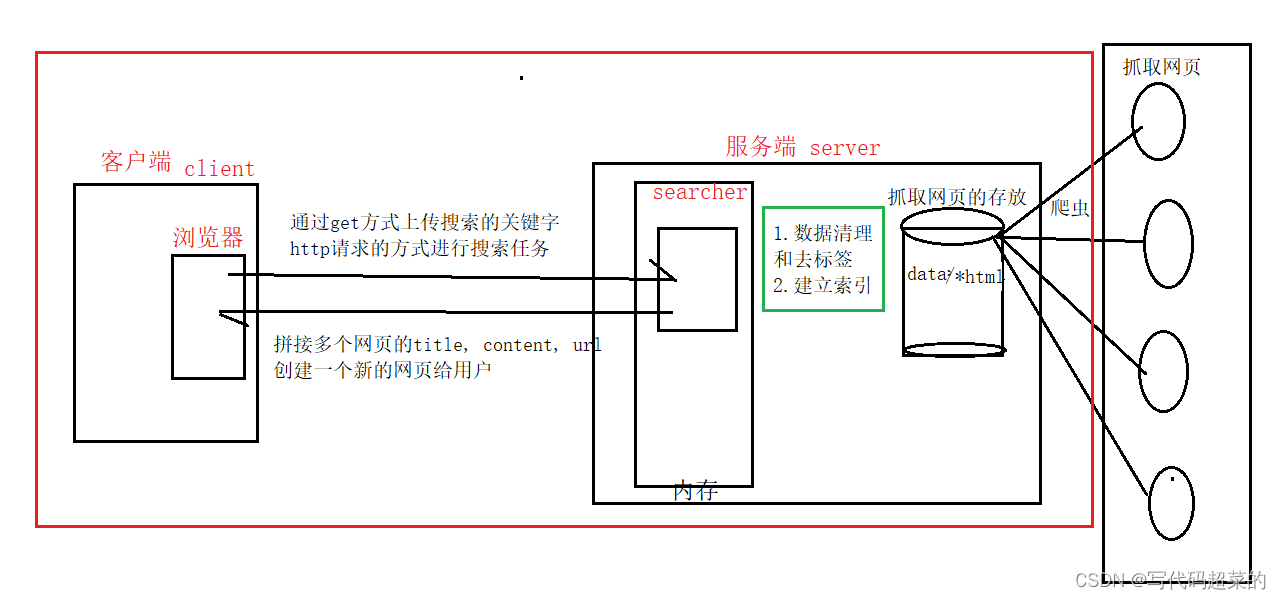

2. 搜索引擎的相關宏原理

????????實現用戶通過客戶端的瀏覽器輸入關鍵字, 通過get方式, 然后http發送請求給服務端內存中的searcher, searcher再通過已經抓取好網頁并且存放在data/*html目錄下進行數據清理和去標簽建立索引的步驟, 將查找到的多個網頁的title, content, url進行拼接, 最后返回給用戶一個新的網頁.

? ? ? ? 在后面實現的部分主要是完成對客戶端和服務端的流程, 爬蟲網頁數據就不做了.

3. 搜索引擎的技術棧和項目環境

技術棧:

????????c/c++, c++11, STL, 標準庫boost, Jesoncpp, cppjieba, cpp-httplib, html5, css, js, jQuery, Ajax.

項目環境:

? ? ? ? Centos 7云服務器, vim/g++/Makefile, vscode.

4. 正排索引, 倒排索引, 搜索引擎具體原理

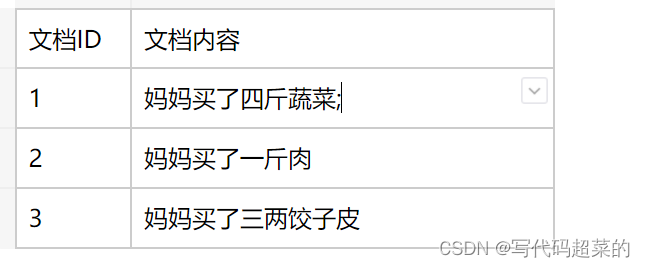

正排索引:? 由文檔ID找到文檔內容;

倒排索引: 根據文檔的內容, 分詞, 整理不重復的各個關鍵字, 對應到相應的文檔ID.

舉個栗子:

? ? ? ? 媽媽買了四斤蔬菜; 媽媽買了一斤肉; 媽媽買了三兩餃子皮.

正排索引:?

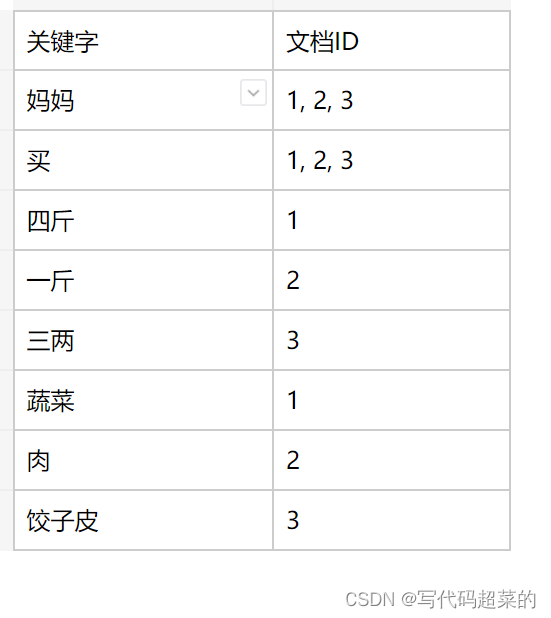

倒排索引:

5. 編寫數據去標簽化和數據清洗的模塊parser(解析器)

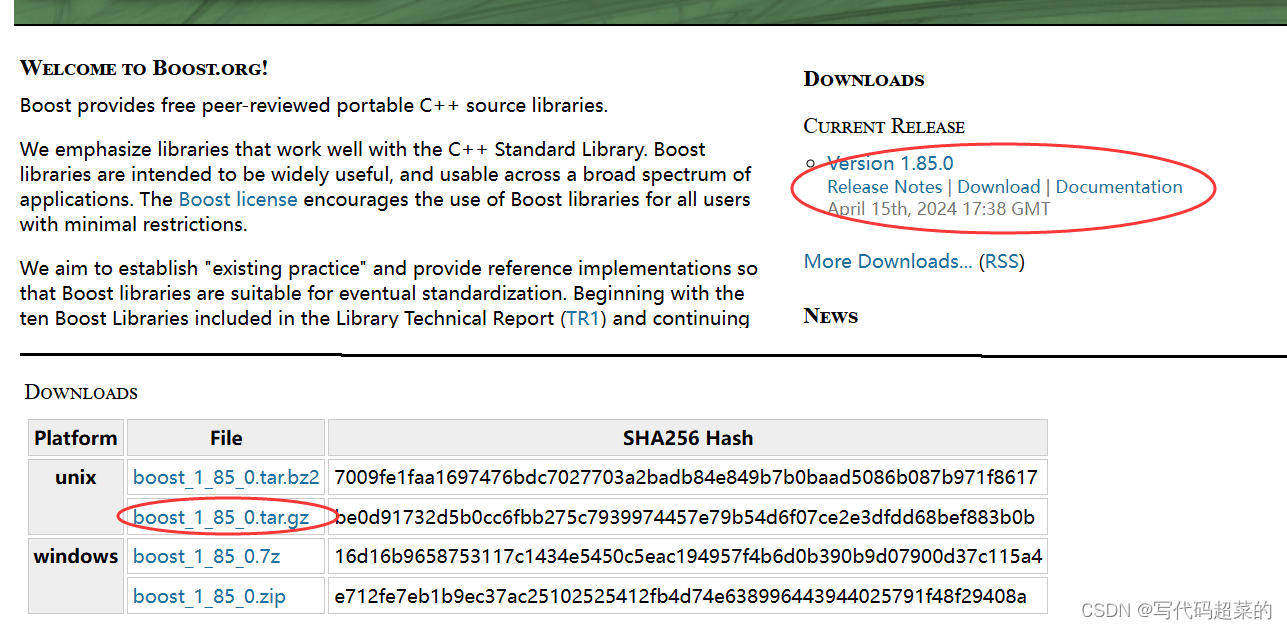

5.1 官網下載標準庫

首先到boost官網去下載好標準庫; 網址:?https://www.boost.org/

然后使用Xshell將下載好的標準庫rz, 然后解包, 將標準庫留下.

這里我是創建了一個boost_searcher目錄來存放所有需要的文件數據.

其中boost_1_85_0就是boost下載好的標準庫.

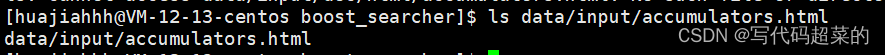

data目錄下的input(從boost_1_85_0里面的doc目錄下的html目錄的全部數據拿出來的)存放原始html的數據,?raw_html是處理過的文件數據.

parser.cc就是用來實現去標簽化和數據清洗的函數.

5.2 去標簽

一般html文件里面都是出現大量成對的標簽, 我們只需要內容, 所以標簽對我們沒有作用要去除.

去除標簽之后的每個文檔如何區分捏?

使用\3進行標記區分文檔. 讀取的時候使用getline(ifstream, line); line就是\3.

5.3 編寫parser代碼

1. 在boost_searcher里創建一個parser.cc的文件;?

2. 先實現大體的框架; 首先EnumFile遞歸原html的所有文檔, 將它們放到file_list數組里面;

3. ParserHtml從file_list里面將文件讀取出來并且解析出來title, content, url;

4. SaveHtml 是將解析好的數據文件寫入到output里面.

#include <iostream>

#include <vector>

#include <string>

#include <boost/filesystem.hpp>

#include <utility>

#include <fstream>

#include "util.hpp"

using namespace std;// 原來沒處理過的html數據的文件目錄.

const string src_path = "data/input";

// 將數據清洗以及去標簽過的數據放到這個目錄文件中

const string output = "data/raw_html/raw.txt";typedef struct DocInfo

{string title;string content;string url;

}DocInfo_t;//這里規定一下:

//const &: 輸入;

//*: 輸出;

//&: 輸入輸出;bool EnumFile(const string& src_file, vector<string>* file_list);bool ParserHtml(const vector<string>& file_list, vector<DocInfo>* results);bool SaveHtml(const vector<DocInfo_t>& result,const string& output);int main()

{//1. 遞歸將所有的html文件帶路徑的保存到file_list, 方便對文件進行一個個查詢.vector<string> file_list;if(!EnumFile(src_path, &file_list)){cerr << "Enum File error!" << endl;return 1;}//2.按照file_list讀取每個文件的內容.并且進行解析;vector<DocInfo_t> results;if(!ParserHtml(file_list, &results)){cerr << "Parser Html error!" << endl;return 2;}//3.將各個文件進行解析好的文件內容, 寫入到output, \3為每個文檔的分割符;if(!SaveHtml(results, output)){cerr << "Save Html error!" << endl;return 3;}return 0;

}EnumFile模塊:?

1.首先使用到標準庫里面的接口boost::filesystem以及path來查看是否src_file的資源路徑是否存在.

2. 使用ecursive_directory_iterator對src_file資源進行遍歷, 再進一步篩選是否為普通文件以及.html后綴的文件. 如果是的話就將其放到數組file_list里面.

bool EnumFile(const string& src_path, vector<string>* file_list)

{// 這里是標準庫<boost/filesystem.hpp>提供的接口和結構體;namespace fs = boost::filesystem;fs::path root_path(src_path);// 實現判斷原資源數據路徑是否存在.if(!fs::exists(root_path)){cerr << src_path << "no exists" << endl;return false;}//進行html文檔的遍歷, 如果為空就是遍歷完成了.fs::recursive_directory_iterator end;for(fs::recursive_directory_iterator iter(root_path); iter != end; iter++){//判斷是否為普通文件, 因為html都是普通文件.if(!fs::is_regular_file(*iter)){continue;}//判斷是否為html后綴的文件.if(iter->path().extension() != ".html"){continue;}cout << "debug: " << iter->path().string() << endl;//當前路徑一定是合法的html為后綴的文件file_list->push_back(iter->path().string());}return true;

}1. ParserHtml: 將處理好的源html數據存放在file里的, 對其進行遍歷, 然后對文件中的title, content, url進行解析, 最后存放到result數組里面.

2. 然后使用ParserTitle進行將title解析; 因為title的內容都是放在<title> </title>里面;?

我們只要找到<title> 和 </title> 然后將中間的內容切分即可.

3.?ParserContent進行去標簽獲取內容, 采用狀態機的方法, 枚舉LABLE和CONTENT, 這里需要注意一般html里面開頭也是標簽, 所以初始化status是LABLE, 對file進行遍歷, 如果遇到>那么就代表是標簽的結束, status就是CONTENT, 如果遇到<那么就代表是標簽的開始, status就是LABLE. 如果遇到\n, 我們需要使用\n做分隔符, 所以要把原來的變成空串, 最后將拼接好的字符串放到content.

4.?ParserUrl進行url的解析, 那么我們boost官網查詢和我們存放在自己的路徑是不同的.

上面是url_head, 下面的url_tail只shangchu需要將data/input刪除即可.

static bool ParserTitle(const string& file, string* title)

{size_t begin = file.find("<title>");if(begin == string::npos)return false;size_t end = file.find("</title");if(end == string::npos)return false;begin += string("<title>").size();if(begin > end)return false;*title = file.substr(begin, end - begin);return true;

}static bool ParserContent(const string& file, string* content)

{//去除html里面的標簽;狀態機enum status{LABLE,CONTENT};//默認一般html的開頭都是標簽.enum status s = LABLE;for(char c : file){switch(s){case LABLE:if(c == '>')s = CONTENT;case CONTENT:if(c == '<')s = LABLE;else{//原本文件的\n去除, 因為要用\n來做文本分割符;if(c == '\n')c = ' ';content->push_back(c);}break;default:break;}}return true;

}static bool ParserUrl(const string& file_path, string* url)

{//這個是網址拼接.string url_head = "https://www.boost.org/doc/libs/1_85_0/doc/html/accumulators.html";string url_tail = file_path.substr(src_path.size());*url = url_head + url_tail;return true;

}static void ShowDoc(const DocInfo& doc)

{cout << "title: " << doc.title << endl;cout << "content: " << doc.content << endl;cout << "url: " << doc.url << endl;}//將獲取的html資源file_list解析處理后放到result;

bool ParserHtml(const vector<string>& file_list, vector<DocInfo_t>* results)

{for(const string& file : file_list){string result;//讀取每個文件的內容;if(!ns_util::FileUtil::ReadFile(file, &result)){continue;}DocInfo_t doc;//解析文件, 讀取title;if(!ParserTitle(result, &doc.title)){continue;}//解析文件, 讀取content;if(!ParserContent(result, &doc.content)){continue;}//解析文件, 讀取url;if(!ParserUrl(result, &doc.url)){continue;}results->push_back(move(doc)); //提高效率減少拷貝.//for testShowDoc(doc);break;}return true;

}util.hpp: FileUtil是將每條源html的資源進行輸出;

#pragma once#include <iostream>

#include <vector>

#include <string>

#include <fstream>using namespace std;namespace ns_util

{class FileUtil{public://讀取文件file_path里面的內容并且放到out;static bool ReadFile(const string& file_path, string* out){ifstream in(file_path, ios::in);//如果沒有打開文件成功if(!in.is_open()){cerr << "open file" << file_path << "error" << endl;return false;}string line;while(!getline(in, line)){*out += line;}in.close();return true;}};

};SaveHtml:將解析好的數據進行文檔分割和內容分割. 將解析好的數據以這種方式寫入到output.

//將解析的數據讀寫到output每個文檔\n分割, 每個文檔的title, content, url以\3分割.

bool SaveHtml(const vector<DocInfo_t>& result,const string& output)

{

#define SEP '\3'//采用二進制方式寫入;ofstream out(output, ios::out | ios::binary);if(!out.is_open()){cerr << "open " << output << "failed!" << endl;return false;}for(auto& item : result){string out_string;out_string = item.title;out_string += SEP;out_string += item.content;out_string += SEP;out_string += item.url;out_string += '\n';out.write(out_string.c_str(), out_string.size());}out.close();return true;

}后言: 好久沒更新博客了, xdm求個三聯, 多多更新超多計算機網絡, Linux, c++, c, 算法內容.

)

)

真題解析#中國電子學會#全國青少年軟件編程等級考試)

)

Negative Test)

的類別ID映射)