🔥 Redis 大 Key 與熱 Key:生產環境的風險與解決方案

文章目錄

- 🔥 Redis 大 Key 與熱 Key:生產環境的風險與解決方案

- 🧠 一、問題定義與識別

- 💡 什么是大 Key?

- 🔥 什么是熱 Key?

- 📊 大 Key 與熱 Key 對比

- ?? 二、風險深度分析

- 💥 大 Key 的風險與影響

- 🔥 熱 Key 的風險與影響

- 📈 綜合影響分析

- 🔍 三、定位與診斷方法

- 🛠? 內置工具診斷

- 📊 熱 Key 診斷方法

- 🔧 第三方工具集成

- 🛠? 四、解決方案與實戰

- 🔨 大 Key 解決方案

- 🔥 熱 Key 解決方案

- 🛡? 綜合防護方案

- 💡 五、最佳實踐與預防

- 📋 日常監控預防策略

- 🏗? 架構優化建議

- 📊 性能對比評估

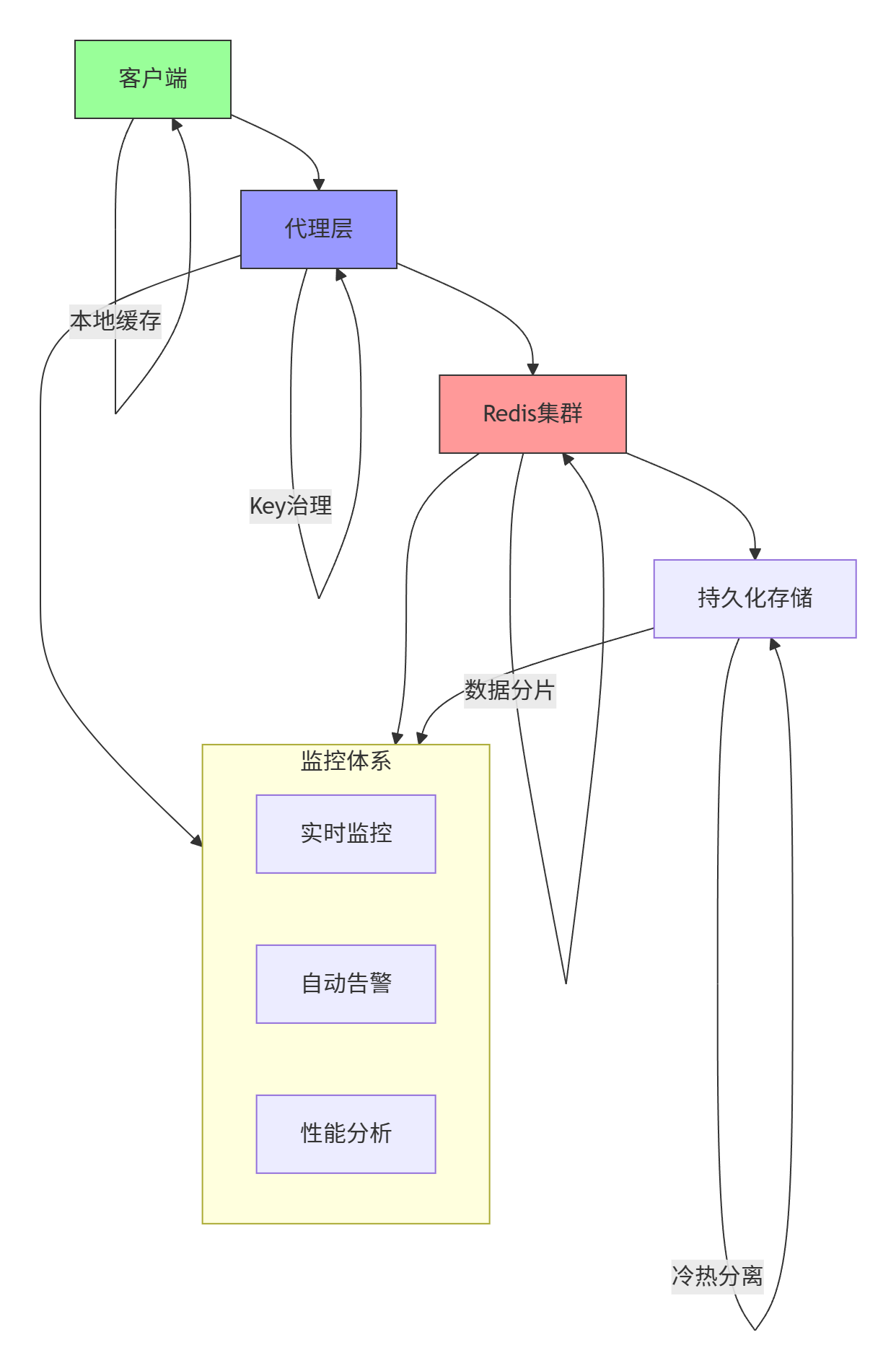

- 🚀 全鏈路優化體系

🧠 一、問題定義與識別

💡 什么是大 Key?

??大 Key(Big Key)?? 是指存儲值過大的 Redis Key,通常有以下特征:

??大 Key 判斷標準??:

# 大Key的量化標準

String類型:value > 10KB

Hash/Set/ZSet類型:元素數量 > 1000

List類型:元素數量 > 1000

所有類型:整體大小 > 1MB

🔥 什么是熱 Key?

??熱 Key(Hot Key)?? 是指訪問頻率異常高的 Key,通常具有以下特征:

??熱 Key 判斷標準??:

# 熱Key的量化標準

單個Key的QPS > 1000

占用總請求量的 > 5%

導致節點負載比其他節點高50%+

📊 大 Key 與熱 Key 對比

| 特征 | 大 Key (Big Key) | 熱 Key (Hot Key) |

|---|---|---|

| 定義 | Value尺寸過大 | 訪問頻率過高 |

| 問題本質 | 數據存儲問題 | 數據訪問問題 |

| 主要影響 | 阻塞、網絡延遲 | 性能瓶頸、數據傾斜 |

| 檢測方式 | 內存分析、掃描 | 監控、流量分析 |

| 解決方案 | 數據拆分、壓縮 | 多級緩存、分片 |

?? 二、風險深度分析

💥 大 Key 的風險與影響

??1. 阻塞風險??:

sequenceDiagramparticipant C as Clientparticipant R as Redisparticipant N as NetworkC->>R: 發送大Key操作請求R->>R: 處理大量數據(阻塞)Note over R: 單線程阻塞其他命令R->>N: 傳輸大數據量N->>C: 響應延遲高style R fill:#f99,stroke:#333

??2. 網絡壓力??:

# 示例:一個10MB的Key

# 每秒100次訪問產生的網絡流量

10MB * 100 = 1000MB/s = 8Gbps

# 這可能會占滿萬兆網卡!

??3. 內存不均??:

# 內存分布示例

Node1: 10GB (包含8GB的大Key)

Node2: 2GB

Node3: 2GB

# 導致節點負載嚴重不均衡

??4. 持久化問題??:

// BGSAVE時fork操作可能阻塞

// 如果一個大Key占用了8GB內存

// fork需要復制8GB內存頁表,可能導致長時間阻塞

🔥 熱 Key 的風險與影響

??1. 單點瓶頸??:

??2. 數據傾斜??:

# 集群環境下的數據傾斜

節點1: QPS 50,000 (包含熱Key)

節點2: QPS 800

節點3: QPS 750

節點4: QPS 700

# 一個熱Key導致整個集群負載不均

??3. 緩存擊穿??:

// 熱Key過期時的大量并發請求

public Object getHotKey(String key) {Object value = redis.get(key);if (value == null) {// 大量請求同時到達數據庫value = loadFromDB(key);redis.setex(key, 300, value);}return value;

}

??4. 資源競爭??:

# CPU競爭:處理熱Key的線程占用大量CPU

# 網絡競爭:熱Key的網絡流量擠占其他請求

# 連接競爭:大量客戶端連接等待同一個Key

📈 綜合影響分析

🔍 三、定位與診斷方法

🛠? 內置工具診斷

??1. redis-cli --bigkeys 分析??:

# 執行大Key分析

redis-cli --bigkeys# 輸出示例:

# Biggest string found so far 'big:string:key' with 10240000 bytes

# Biggest hash found so far 'big:hash:key' with 100000 fields

# Biggest list found so far 'big:list:key' with 50000 items

# Biggest set found so far 'big:set:key' with 80000 members

# Biggest zset found so far 'big:zset:key' with 60000 members# 定期執行分析腳本

#!/bin/bash

echo "開始大Key分析: $(date)"

redis-cli --bigkeys -i 0.1 | grep -E "(Biggest|bytes|fields|items|members)"

echo "分析完成: $(date)"

??2. memory usage 命令??:

# 精確查詢Key的內存使用

redis-cli memory usage user:profile:1234# 批量采樣分析

for key in $(redis-cli keys "user:profile:*" | head -100); dosize=$(redis-cli memory usage $key)echo "$key: $size bytes"

done | sort -n -k2 -r | head -10

??3. monitor 命令抓包??:

# 實時監控命令請求

redis-cli monitor | grep -E "(GET|HGET|SMEMBERS|LRANGE)" | head -1000# 分析命令頻率

redis-cli monitor | awk '{print $4}' | sort | uniq -c | sort -nr | head -10

📊 熱 Key 診斷方法

??1. 實時流量分析??:

# 使用monitor統計熱Key

redis-cli monitor | awk '

BEGIN { count=0 }

{if ($4 ~ /"(GET|HGET|SMEMBERS|LRANGE)"/) {key = $5;keys[key]++;count++;}if (count > 10000) exit;

}

END {for (key in keys) {print keys[key], key;}

}' | sort -nr | head -20

??2. Lua 腳本統計??:

-- 熱Key統計腳本

local function track_hot_keys()local key = KEYS[1]local now = tonumber(ARGV[1])local window = 60 -- 統計窗口60秒-- 使用有序集合統計熱度redis.call('ZADD', 'hotkey:tracking', now, key)redis.call('ZREMRANGEBYSCORE', 'hotkey:tracking', 0, now - window)local count = redis.call('ZCARD', 'hotkey:tracking')if count > 1000 thenredis.log(redis.LOG_WARNING, "熱Key detected: " .. key)end

end

🔧 第三方工具集成

??1. Prometheus + Redis Exporter??:

# docker-compose.yml 監控棧

version: '3'

services:redis-exporter:image: oliver006/redis_exporterports:- "9121:9121"environment:- REDIS_ADDR=redis://redis:6379command:- '--redis.addr=redis://redis:6379'- '--redis.password=${REDIS_PASSWORD}'prometheus:image: prom/prometheusports:- "9090:9090"volumes:- ./prometheus.yml:/etc/prometheus/prometheus.ymlgrafana:image: grafana/grafanaports:- "3000:3000"

??2. 自定義監控腳本??:

#!/usr/bin/env python3

# hotkey_detector.py

import redis

import time

from collections import defaultdictclass HotKeyDetector:def __init__(self, host='localhost', port=6379):self.r = redis.Redis(host=host, port=port)self.key_stats = defaultdict(int)self.start_time = time.time()def monitor_keys(self, duration=60):"""監控指定時間內的Key訪問"""end_time = time.time() + durationpubsub = self.r.pubsub()pubsub.psubscribe('__keyspace@0__:*')for message in pubsub.listen():if time.time() > end_time:breakif message['type'] == 'pmessage':key = message['channel'].split(':', 1)[1]self.key_stats[key] += 1# 輸出熱Key報告self.generate_report()def generate_report(self):"""生成熱Key報告"""total_ops = sum(self.key_stats.values())print(f"監控時間: {time.time() - self.start_time:.2f}秒")print(f"總操作數: {total_ops}")print("熱Key排名TOP10:")for key, count in sorted(self.key_stats.items(), key=lambda x: x[1], reverse=True)[:10]:percentage = (count / total_ops) * 100print(f" {key}: {count}次 ({percentage:.2f}%)")if __name__ == "__main__":detector = HotKeyDetector()detector.monitor_keys(300) # 監控5分鐘

🛠? 四、解決方案與實戰

🔨 大 Key 解決方案

??1. 數據拆分??:

// 原始大Hash拆分示例

public class BigHashSplitter {// 原始大Keypublic void saveUserProfile(String userId, Map<String, String> profile) {// 反例:所有數據存到一個Hashjedis.hmset("user:profile:" + userId, profile);}// 拆分方案:按業務維度拆分public void saveUserProfileSplit(String userId, Map<String, String> profile) {// 基礎信息Map<String, String> basicInfo = new HashMap<>();basicInfo.put("name", profile.get("name"));basicInfo.put("email", profile.get("email"));jedis.hmset("user:basic:" + userId, basicInfo);// 擴展信息Map<String, String> extendedInfo = new HashMap<>();extendedInfo.put("address", profile.get("address"));extendedInfo.put("preferences", profile.get("preferences"));jedis.hmset("user:extended:" + userId, extendedInfo);// 統計信息Map<String, String> statsInfo = new HashMap<>();statsInfo.put("login_count", profile.get("login_count"));statsInfo.put("last_login", profile.get("last_login"));jedis.hmset("user:stats:" + userId, statsInfo);}

}

??2. 數據壓縮??:

// 數據壓縮方案

public class DataCompressor {public void saveCompressedData(String key, Object data) {try {// 序列化數據byte[] serialized = serialize(data);// 使用GZIP壓縮ByteArrayOutputStream baos = new ByteArrayOutputStream();GZIPOutputStream gzip = new GZIPOutputStream(baos);gzip.write(serialized);gzip.close();byte[] compressed = baos.toByteArray();// 存儲壓縮數據jedis.set(key.getBytes(), compressed);} catch (IOException e) {throw new RuntimeException("壓縮失敗", e);}}public Object getCompressedData(String key) {byte[] compressed = jedis.get(key.getBytes());if (compressed == null) return null;try {// 解壓數據GZIPInputStream gzip = new GZIPInputStream(new ByteArrayInputStream(compressed));ByteArrayOutputStream baos = new ByteArrayOutputStream();byte[] buffer = new byte[1024];int len;while ((len = gzip.read(buffer)) > 0) {baos.write(buffer, 0, len);}gzip.close();byte[] serialized = baos.toByteArray();return deserialize(serialized);} catch (IOException e) {throw new RuntimeException("解壓失敗", e);}}

}

??3. 數據歸檔??:

// 冷熱數據分離方案

public class DataArchiver {public Object getData(String key) {// 首先從Redis查詢Object data = jedis.get(key);if (data != null) {return data;}// Redis中沒有,從歸檔存儲查詢data = archiveStorage.get(key);if (data != null) {// 異步回填Redis(短期緩存)jedis.setex(key, 3600, serialize(data)); // 緩存1小時}return data;}public void archiveOldData() {// 定期將舊數據遷移到歸檔存儲Set<String> oldKeys = findOldKeys();for (String key : oldKeys) {Object data = jedis.get(key);if (data != null) {archiveStorage.put(key, data);jedis.del(key);}}}

}

🔥 熱 Key 解決方案

??1. 本地緩存 + 刷新策略??:

public class HotKeyCache {private final LoadingCache<String, Object> localCache;private final Jedis jedis;public HotKeyCache() {this.localCache = Caffeine.newBuilder().maximumSize(1000).expireAfterWrite(5, TimeUnit.SECONDS) // 短期緩存.refreshAfterWrite(1, TimeUnit.SECONDS) // 主動刷新.build(this::loadFromRedis);}public Object get(String key) {try {return localCache.get(key);} catch (Exception e) {return loadFromRedis(key);}}private Object loadFromRedis(String key) {return jedis.get(key);}

}

??2. 多副本分散??:

// 熱Key多副本方案

public class HotKeyReplication {private static final int REPLICA_COUNT = 5;public void set(String key, Object value) {// 主副本jedis.set(key, serialize(value));// 創建多個副本for (int i = 1; i <= REPLICA_COUNT; i++) {String replicaKey = key + ":replica:" + i;jedis.set(replicaKey, serialize(value));jedis.expire(replicaKey, 3600); // 設置過期時間}}public Object get(String key) {// 隨機選擇副本int replicaNum = ThreadLocalRandom.current().nextInt(1, REPLICA_COUNT + 1);String replicaKey = key + ":replica:" + replicaNum;Object value = jedis.get(replicaKey);if (value == null) {// 副本不存在,回退到主Keyvalue = jedis.get(key);if (value != null) {// 重建副本set(key, value);}}return value;}

}

??3. 代理層分片??:

// 基于代理的熱Key分片

public class HotKeyProxy {private List<Jedis> redisNodes;private int nodeCount;public HotKeyProxy(List<Jedis> nodes) {this.redisNodes = nodes;this.nodeCount = nodes.size();}public void set(String key, Object value) {// 寫入所有節點for (Jedis node : redisNodes) {node.set(key, serialize(value));}}public Object get(String key) {// 根據Key哈希選擇節點int nodeIndex = Math.abs(key.hashCode()) % nodeCount;return redisNodes.get(nodeIndex).get(key);}// 特別熱門的Key:在所有節點都存儲public void setHotKey(String key, Object value) {for (Jedis node : redisNodes) {node.set(key, serialize(value));}}public Object getHotKey(String key) {// 隨機選擇節點,分散壓力int randomNode = ThreadLocalRandom.current().nextInt(nodeCount);return redisNodes.get(randomNode).get(key);}

}

🛡? 綜合防護方案

??多級緩存架構??:

??降級策略??:

public class CircuitBreaker {private final CircuitBreakerConfig config;private int failureCount = 0;private long lastFailureTime = 0;public Object getWithCircuitBreaker(String key) {if (isOpen()) {// 熔斷狀態:直接返回降級結果return getFallbackValue(key);}try {Object value = jedis.get(key);reset(); // 成功則重置熔斷器return value;} catch (Exception e) {recordFailure();return getFallbackValue(key);}}private boolean isOpen() {if (failureCount >= config.getThreshold()) {long now = System.currentTimeMillis();if (now - lastFailureTime < config.getTimeout()) {return true;}// 超時后嘗試半開reset();}return false;}private void recordFailure() {failureCount++;lastFailureTime = System.currentTimeMillis();}private void reset() {failureCount = 0;}

}

💡 五、最佳實踐與預防

📋 日常監控預防策略

??1. 定期健康檢查??:

#!/bin/bash

# daily_redis_check.sh# 1. 大Key檢查

echo "=== 大Key檢查 ==="

redis-cli --bigkeys -i 0.1 | grep -E "(Biggest|bytes|fields|items)"# 2. 內存分析

echo "=== 內存分析 ==="

redis-cli info memory | grep -E "(used_memory|mem_fragmentation_ratio)"# 3. 熱Key檢查

echo "=== 熱Key檢查 ==="

redis-cli monitor | head -1000 | awk '

{ counts[$4]++ }

END {for (cmd in counts) {print counts[cmd], cmd;}

}' | sort -nr | head -5# 4. 生成報告

echo "檢查完成時間: $(date)"

??2. 自動化告警規則??:

# alert_rules.yml

groups:

- name: redis_alertsrules:- alert: RedisBigKeyDetectedexpr: redis_key_size_bytes > 1048576 # 1MBfor: 5mlabels:severity: warningannotations:summary: "發現大Key: {{ $labels.key }}"description: "Key {{ $labels.key }} 大小 {{ $value }} bytes"- alert: RedisHotKeyDetectedexpr: rate(redis_command_count{key=~".+"}[5m]) > 1000for: 2mlabels:severity: criticalannotations:summary: "發現熱Key: {{ $labels.key }}"description: "Key {{ $labels.key }} QPS {{ $value }}"- alert: RedisMemoryFragmentationexpr: redis_mem_fragmentation_ratio > 1.5for: 10mlabels:severity: warningannotations:summary: "內存碎片率過高"description: "當前碎片率 {{ $value }}"

🏗? 架構優化建議

??1. Proxy 層優化??:

// 基于代理的Key治理

public class KeyGovernanceProxy {private Map<String, KeyInfo> keyMetadata = new ConcurrentHashMap<>();public Object get(String key) {KeyInfo info = keyMetadata.computeIfAbsent(key, this::analyzeKey);if (info.isHotKey()) {// 熱Key特殊處理return getHotKey(key);} else if (info.isBigKey()) {// 大Key特殊處理return getBigKey(key);} else {// 正常處理return jedis.get(key);}}private KeyInfo analyzeKey(String key) {// 分析Key的特征long size = jedis.memoryUsage(key);long accessCount = getAccessCount(key);return new KeyInfo(size, accessCount);}

}

??2. 集群優化配置??:

# redis.conf 優化配置

# 內存管理

maxmemory 16gb

maxmemory-policy allkeys-lru

activedefrag yes# 持久化優化

aof-use-rdb-preamble yes

aof-rewrite-incremental-fsync yes# 網絡優化

tcp-backlog 65535

maxclients 10000

📊 性能對比評估

| 方案 | 實施復雜度 | 效果 | 適用場景 | 風險 |

|---|---|---|---|---|

| 數據拆分 | 中 | 效果好 | 大Key問題 | 業務改造量大 |

| 數據壓縮 | 低 | 效果中等 | 值類型大Key | CPU開銷增加 |

| 多副本緩存 | 中 | 效果很好 | 熱Key問題 | 數據一致性風險 |

| 本地緩存 | 高 | 效果極好 | 極端熱Key | 緩存一致性問題 |

| 代理分片 | 高 | 效果極好 | 集群環境 | 架構復雜度高 |

🚀 全鏈路優化體系

)

)

)

)

)

)