-----------------------------------------------------------------------------------------------

這是我在我的網站中截取的文章,有更多的文章歡迎來訪問我自己的博客網站rn.berlinlian.cn,這里還有很多有關計算機的知識,歡迎進行留言或者來我的網站進行留言!!!

-----------------------------------------------------------------------------------------------

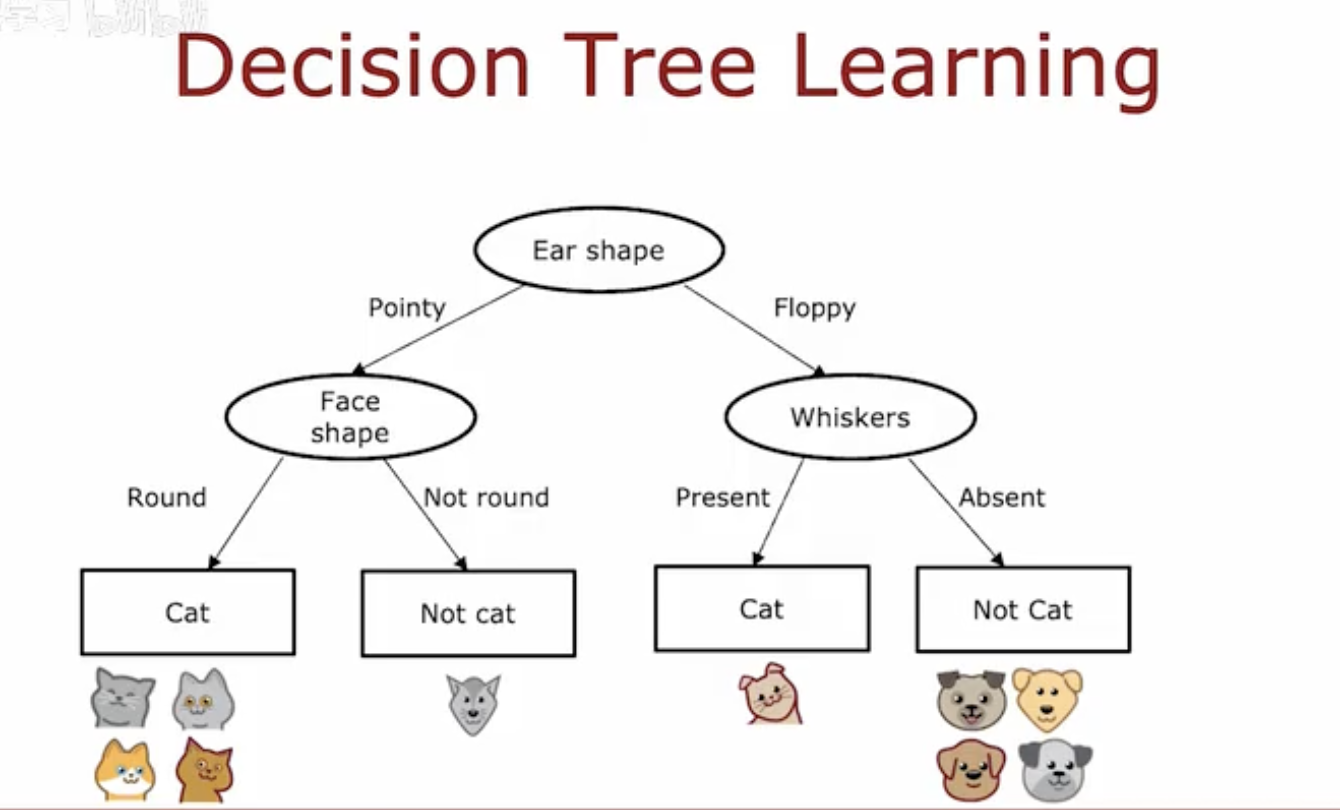

一、決策樹模型:分類示例

這幅圖片展示了一個決策樹模型,用于區分動物是否為貓。在這個例子中,決策樹使用耳朵形狀、面部形狀和胡須的存在與否來確定一個動物是否是貓。

以下是決策樹的詳細解釋:

-

根節點(Root Node):

-

決策樹的頂部是根節點,這里表示的是“耳朵形狀”(Ear shape)。

-

-

第一層分支(First Level of Branches):

-

從根節點出發,有兩個分支:

-

如果耳朵是“尖的”(Pointy),則進入左側的分支。

-

如果耳朵是“垂的”(Floppy),則進入右側的分支。

-

-

-

第二層節點(Second Level Nodes):

-

左側分支指向“面部形狀”(Face shape):

-

如果面部形狀是“圓的”(Round),則該動物是貓。

-

如果面部形狀不是圓的,則該動物不是貓。

-

-

右側分支指向“胡須”(Whiskers):

-

如果胡須“存在”(Present),則該動物是貓。

-

如果胡須“不存在”(Absent),則該動物不是貓。

-

-

-

葉節點(Leaf Nodes):

-

決策樹的底部是葉節點,表示最終的分類結果:

-

左側有兩個葉節點,分別表示“貓”(Cat)和“不是貓”(Not cat)。

-

右側也有兩個葉節點,同樣表示“貓”(Cat)和“不是貓”(Not cat)。

-

-

-

示例動物:

-

圖片底部展示了一些動物的圖標,這些圖標用來說明決策樹的分類結果:

-

左側的圖標是貓,它們符合“尖耳朵”和“圓臉”的條件。

-

右側的圖標不是貓,它們可能是其他動物,如狗或狼,它們不符合貓的特征。

-

-

這個決策樹模型通過簡單的特征(耳朵形狀、面部形狀和胡須)來進行分類,展示了決策樹如何通過一系列的決策規則來預測結果。

二、決策樹模型的關鍵決策

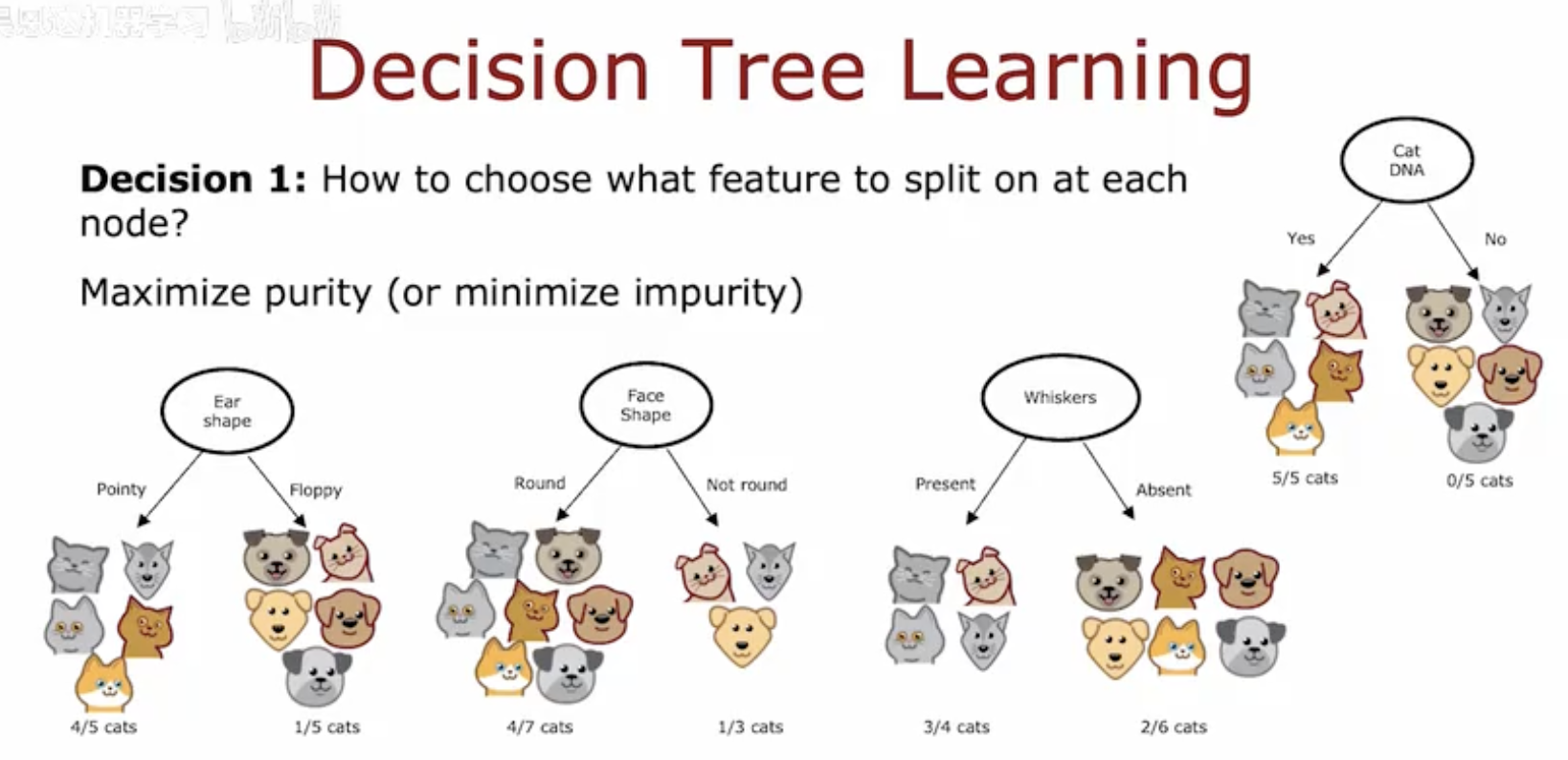

1. 決策樹學習中的特征選擇:選擇最佳分割特征

-

決策樹通過在每個節點上選擇一個特征進行分割來構建。選擇特征的目標是最大化節點的純度(或最小化不純度)。

-

圖片展示了一個決策樹的示例,用于分類貓和非貓。樹的每個節點根據耳朵形狀、面部形狀和胡須的存在與否進行分割。

-

每個節點下方展示了該節點包含的貓和非貓的數量,以及貓的比例。例如,耳朵形狀為“Pointy”的節點中有4只貓和1只非貓,貓的比例為4/5。

-

通過比較不同特征分割后的純度,算法選擇能夠最大化純度的特征進行分割。在這個例子中,“Cat DNA”特征提供了最高的純度,因為它完全區分了貓和非貓。

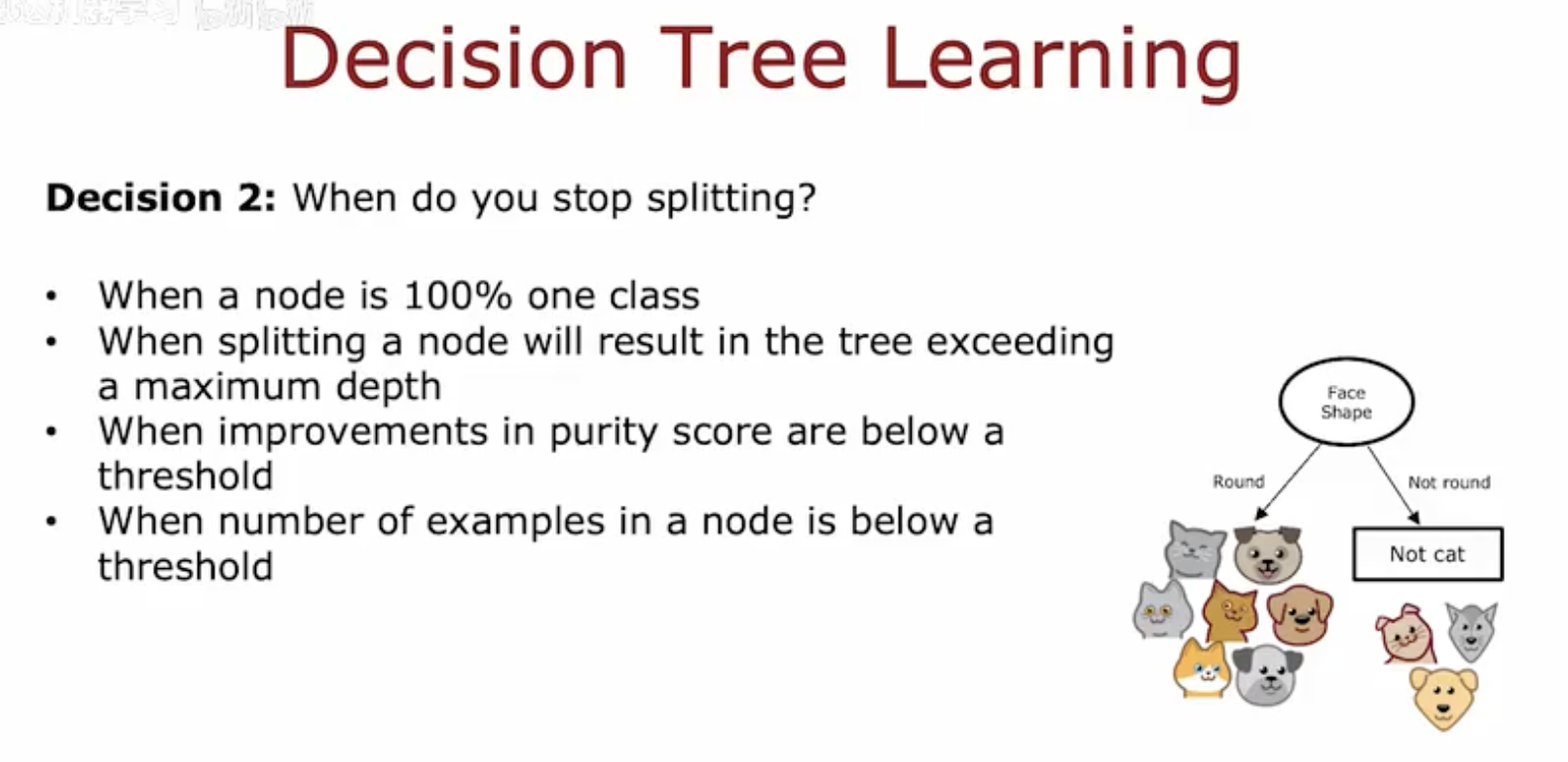

2. 決策樹學習中的停止條:決定何時停止分割

-

決策樹學習過程中的另一個關鍵決策是何時停止對節點進行分割。這是為了避免過擬合,即模型在訓練數據上表現很好,但在新數據上表現不佳。

-

圖片列出了四個停止分割的條件:

-

當一個節點是100%一個類別時,這個節點是純凈的,不需要進一步分割。

-

當分割一個節點會導致樹超過最大深度時,停止分割以防止樹變得過于復雜。

-

當純度分數的改進低于一個閾值時,停止分割,因為進一步分割帶來的改進很小。

-

當節點中的樣本數量低于一個閾值時,停止分割,因為樣本太少可能導致過擬合。

-

-

圖片右側展示了一個簡化的決策樹示例,說明了如何根據面部形狀進行分割。這個示例展示了如何根據停止條件來決定是否繼續分割節點。

通過這兩個關鍵決策,決策樹學習算法能夠有效地構建模型,同時避免過擬合,提高模型的泛化能力。

-----------------------------------------------------------------------------------------------

這是我在我的網站中截取的文章,有更多的文章歡迎來訪問我自己的博客網站rn.berlinlian.cn,這里還有很多有關計算機的知識,歡迎進行留言或者來我的網站進行留言!!!

-----------------------------------------------------------------------------------------------

:制作一個錄音播放器)

:攻克 循環控制(三),輕松拿捏!)

)

所需的數學基礎)