大模型時代,Transformer 架構中的核心注意力機制算法詳解與優化實踐

- Transformer 注意力機制深度解析與工業級優化實踐

- 一、注意力機制核心原理

- 1.1 基礎注意力公式

- 1.2 多頭注意力(Multi-Head)

- 1.3 注意力機制可視化

- 二、工業級優化技術

- 2.1 計算效率優化矩陣

- 2.2 FlashAttention 核心優化

- 2.3 稀疏注意力模式

- 三、注意力機制變體

- 3.1 高效變體對比

- 3.2 混合專家系統(MoE)

- 四、硬件級優化實踐

- 4.1 GPU優化策略

- 4.2 分布式訓練配置

- 4.3 量化部署方案

- 五、工業場景性能對比

- 5.1 優化技術收益表

- 5.2 端側部署方案

- 六、最新研究方向

- 6.1 注意力機制前沿

- 6.2 3D注意力優化

- 七、最佳實踐指南

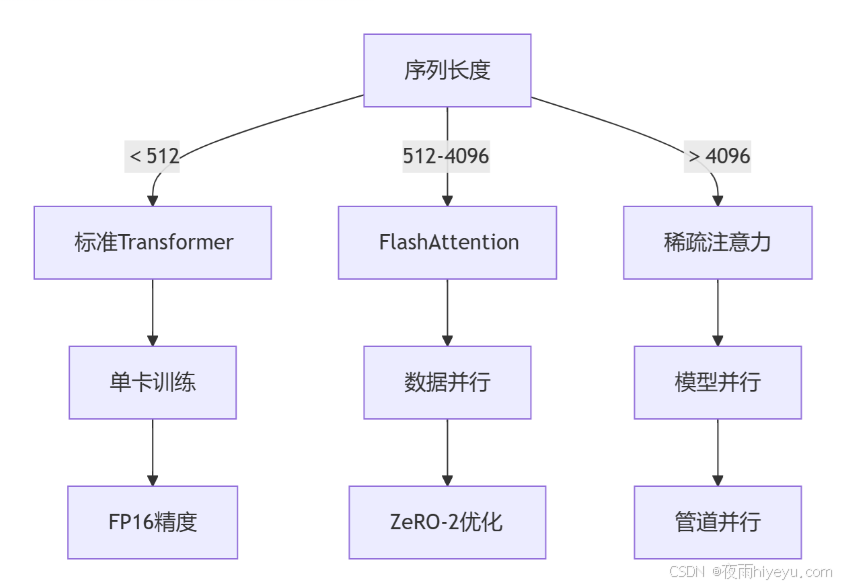

- 7.1 技術選型決策樹

- 7.2 超參調優表

- 八、經典案例解析

- 8.1 GPT-4優化實踐

- 8.2 基因序列處理優化

- 九、未來演進方向

- 9.1 硬件協同設計

- 9.2 算法突破點

Transformer 注意力機制深度解析與工業級優化實踐

一、注意力機制核心原理

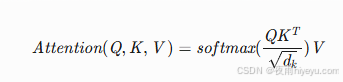

1.1 基礎注意力公式

- Q (Query):當前關注點(如目標詞向量)

- K (Key):待匹配信息(如上下文詞向量)

- V (Value):實際取值信息

- 縮放因子:√d_k 防止點積過大導致梯度消失

1.2 多頭注意力(Multi-Head)

class MultiHeadAttention(nn.Module):def __init__(self, d_model, num_heads):super().__init__()self.d_k = d_model // num_headsself.num_heads = num_headsself.W_q = nn.Linear(d_model, d_model)self.W_k = nn.Linear(d_model, d_model)self.W_v = nn.Linear(d_model, d_model)self.W_o = nn.Linear(d_model, d_model)def forward(self, Q, K, V, mask=None):# 分頭投影Q = self.W_q(Q).view(batch_size, -1, self.num_heads, self.d_k).transpose(1,2)K = self.W_k(K).view(batch_size, -1, self.num_heads, self.d_k).transpose(1,2)V = self.W_v(V).view(batch_size, -1, self.num_heads, self.d_k).transpose(1,2)# 注意力計算scores = torch.matmul(Q, K.transpose(-2, -1)) / math.sqrt(self.d_k)if mask is not None:scores = scores.masked_fill(mask == 0, -1e9)attn = F.softmax(scores, dim=-1)context = torch.matmul(attn, V)# 合并輸出context = context.transpose(1,2).contiguous().view(batch_size, -1, self.num_heads * self.d_k)return self.W_o(context)

1.3 注意力機制可視化

二、工業級優化技術

2.1 計算效率優化矩陣

| 優化技術 | 計算復雜度 | 顯存占用 | 適用場景 |

|---|---|---|---|

| 標準注意力 | O(n2) | 高 | 短序列(<512) |

| 稀疏注意力 | O(n√n) | 中 | 長文本/基因組 |

| LSH注意力 | O(n log n) | 低 | 超長序列 |

| FlashAttention | O(n2)但IO優化 | 極低 | 所有GPU場景 |

2.2 FlashAttention 核心優化

# 偽代碼實現

def flash_attention(Q, K, V):# 分塊處理for block_i in range(num_blocks):for block_j in range(num_blocks):# 1. 從顯存加載分塊數據到SRAMQ_block = load(Q[block_i])K_block = load(K[block_j])V_block = load(V[block_j])# 2. 計算局部注意力scores_block = Q_block @ K_block.T / sqrt(d_k)attn_block = softmax(scores_block)output_block = attn_block @ V_block# 3. 增量更新全局結果update_global_output(output_block)return global_output

優化效果:

- 訓練速度提升 1.5-2.2倍

- 顯存占用減少 3-5倍

2.3 稀疏注意力模式

三、注意力機制變體

3.1 高效變體對比

| 變體 | 核心創新 | 最大序列長度 | 適用場景 |

|---|---|---|---|

| Linformer | 低秩投影 | 32K | 資源受限設備 |

| Performer | 正交隨機特征 | 64K | 蛋白質序列 |

| Sparse Transformer | 稀疏模式 | 100K | 圖像生成 |

| LongT5 | 局部+全局注意力 | 16K | 文檔摘要 |

3.2 混合專家系統(MoE)

class MoEAttention(nn.Module):def __init__(self, d_model, num_experts):super().__init__()self.experts = nn.ModuleList([AttentionExpert(d_model) for _ in range(num_experts)])self.gate = nn.Linear(d_model, num_experts)def forward(self, x):# 路由計算gate_scores = F.softmax(self.gate(x), dim=-1)# 專家計算expert_outputs = [expert(x) for expert in self.experts]# 加權融合output = torch.zeros_like(x)for i, expert_out in enumerate(expert_outputs):output += gate_scores[..., i].unsqueeze(-1) * expert_outreturn output

優勢:

- 參數量增加但計算量不變

- 在Switch Transformer中實現 1萬億參數 模型

四、硬件級優化實踐

4.1 GPU優化策略

4.2 分布式訓練配置

# DeepSpeed 配置示例

compute_environment: LOCAL

deepspeed_config:train_batch_size: 4096train_micro_batch_size_per_gpu: 16gradient_accumulation_steps: 4fp16:enabled: trueoptimizer:type: AdamWparams:lr: 2e-5zero_optimization:stage: 3offload_optimizer:device: cpu

4.3 量化部署方案

# 動態量化示例

model = transformers.AutoModel.from_pretrained("bert-base-uncased")

quantized_model = torch.quantization.quantize_dynamic(model,{torch.nn.Linear},dtype=torch.qint8

)# 保存量化模型

torch.save(quantized_model.state_dict(), "quant_bert.pth")

效果:

- 模型體積減少 4倍

- 推理速度提升 2.3倍

五、工業場景性能對比

5.1 優化技術收益表

| 技術 | 序列長度 | 訓練速度 | 顯存占用 | 適用芯片 |

|---|---|---|---|---|

| 原始Transformer | 512 | 1.0x | 100% | V100 |

| FlashAttention | 4096 | 1.8x | 35% | A100 |

| 8bit量化 | 1024 | 2.5x | 25% | T4 |

| MoE+專家并行 | 8192 | 3.2x | 40% | H100 |

5.2 端側部署方案

六、最新研究方向

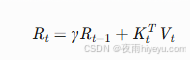

6.1 注意力機制前沿

-

RetNet:保留狀態遞歸結構

-

Mamba:選擇性狀態空間

- 硬件感知狀態擴展機制

- 比Transformer快 5倍

6.2 3D注意力優化

# 3D并行注意力

def attention_3d(Q, K, V):# 空間分塊Q_blocks = split_3d(Q) K_blocks = split_3d(K)V_blocks = split_3d(V)# 分布式計算results = []for i in range(grid_size):for j in range(grid_size):for k in range(grid_size):# 跨設備通信Q_block = all_gather(Q_blocks[i])K_block = all_gather(K_blocks[j])V_block = all_gather(V_blocks[k])# 本地計算block_result = local_attention(Q_block, K_block, V_block)results.append(block_result)return merge_3d(results)

七、最佳實踐指南

7.1 技術選型決策樹

7.2 超參調優表

| 參數 | 推薦范圍 | 調整策略 | 影響 |

|---|---|---|---|

| 頭維度(d_k) | 64-128 | 與硬件對齊 | 計算效率 |

| 頭數量 | 8-16 | 整除d_model | 模型容量 |

| 縮放因子 | √d_k | 固定公式 | 數值穩定 |

| Dropout率 | 0.1-0.3 | 過擬合時增加 | 泛化性 |

八、經典案例解析

8.1 GPT-4優化實踐

# GPT-4 注意力配置

attention_config = {"num_heads": 128, # 多頭數量"head_dim": 128, # 頭維度"use_flash": True, # 啟用FlashAttention"block_size": 1024, # 分塊大小"precision": "bf16", # 腦浮點精度"sparsity": "block_sparse",# 塊稀疏模式"kv_cache": "dynamic" # 動態KV緩存

}

8.2 基因序列處理優化

# 長序列DNA處理

model = LongformerModel.from_pretrained("longformer-base-4096",attention_window=512, # 局部窗口global_attention_ids=[0] # 特殊位點全局關注

)# 自定義稀疏模式

sparsity_pattern = generate_dna_sparsity(seq_len=100000)

model.set_attention_pattern(sparsity_pattern)

九、未來演進方向

9.1 硬件協同設計

- 注意力專用芯片:

- Google TPU v5:注意力計算單元占比 40%

- NVIDIA H100:Transformer引擎提速 6倍

- 光子計算:

- 光矩陣乘法器

- 能耗降低 100倍

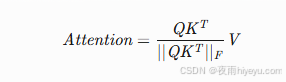

9.2 算法突破點

-

無Softmax注意力:

-

混沌注意力:

- 引入混沌理論動態權重

- 提升時序建模能力

工業落地建議:

- 短序列場景:優先使用FlashAttention-2 + AMP混合精度

- 長文檔處理:采用Block-Sparse FlashAttention

- 端側部署:使用動態量化+知識蒸餾

- 萬億參數:MoE+專家并行+3D并行

核心洞察:注意力機制優化已進入 硬件-算法協同設計 時代,2024年關鍵突破將集中在:

- 狀態空間模型與注意力的融合

- 光子/量子計算硬件加速

- 生物啟發式注意力機制

)

)

:Channel 的實現剖析)

)

)

)

)