概述

在當今數字化時代,人工智能(AI)技術在諸多領域展現出了強大的能力,但在處理歷史語言這一特定任務時,卻遭遇了不小的挑戰。美國和加拿大的研究人員通過合作發現,像 ChatGPT 這樣的大型語言模型(LLMs),在沒有經過廣泛且深入的 預訓練 的情況下,很難精準地重現歷史時期的習語和語言風格。預訓練是一個既耗時又耗費資源的過程,對于大多數學術研究和娛樂項目來說,都是一道難以跨越的門檻。這使得一些頗具創意的想法,例如利用 AI 來 完成查爾斯·狄更斯的最后一部未完成的小說,在實際操作中變得不太可行。

為了探索 AI 在生成具有歷史準確性文本方面的潛力,研究人員嘗試了多種方法。他們從使用 20 世紀早期的散文對模型進行簡單提示入手,逐步深入到對商業模型在該時期的少量書籍上進行 微調。此外,他們還將這些結果與一個完全在 1880 年至 1914 年間出版的書籍上訓練的獨立模型進行了對比分析。

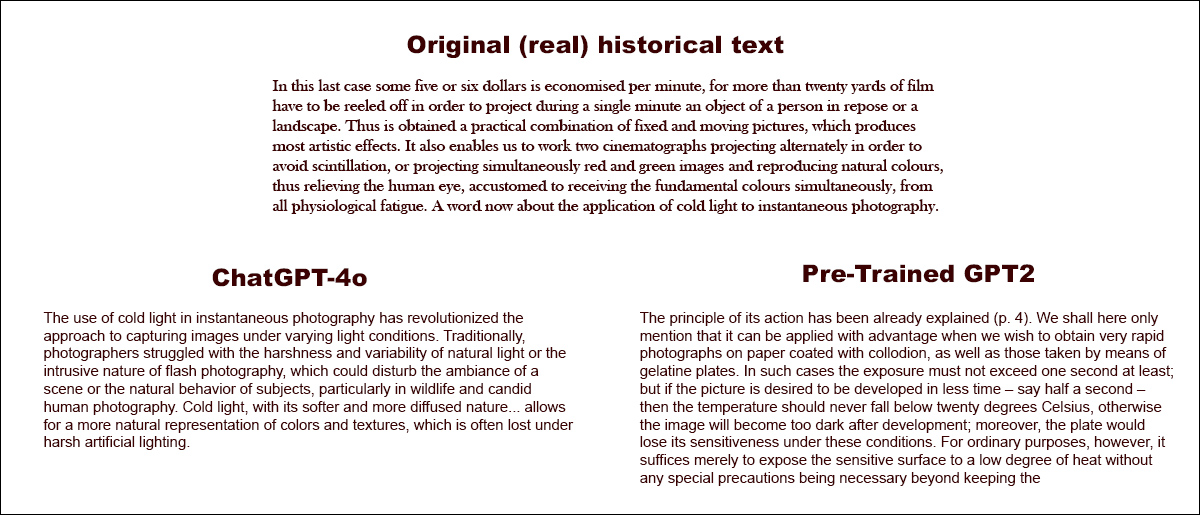

在第一次測試中,研究人員要求 ChatGPT-4o 模仿 _fin?_de?siècle(世紀末)的語言風格,其結果與經過該時期文學微調的小型 GPT2 模型的結果形成了鮮明對比:

當被要求完成一段真實的歷史文本(頂部中心)時,即使是經過充分準備的 ChatGPT-4o(左下)也難以避免地回到了 “博客” 模式,未能準確地代表所請求的歷史習語。相比之下,經過微調的 GPT2 模型(右下)雖然在其他方面的準確性有所欠缺,但卻很好地捕捉到了那個時期的語言風格。來源:https://arxiv.org/pdf/2505.00030

盡管微調過程使模型的輸出在一定程度上更接近原始的歷史風格,但人類讀者依然能夠頻繁地從中檢測出現代語言或思想的痕跡。這表明,即使是經過精心調整的模型,仍然不可避免地會反映出其當代訓練數據的影響。研究人員最終得出了一個令人沮喪的結論:目前并沒有一種經濟實惠的捷徑可以生成機器生產的、在習語上正確的歷史文本或對話。他們還推測,這一挑戰本身可能從一開始就被錯誤地提出了:

“[我們] 還應該考慮,時代錯誤在某種意義上可能是不可避免的。無論我們是通過指令微調歷史模型,使它們能夠進行對話,還是通過教授當代模型模仿較早時期的語言,真實性與對話流暢性之間可能都需要某種妥協。

“畢竟,不存在‘真實’的 21 世紀提問者與 1914 年受訪者之間的對話。嘗試創建這種對話的研究人員需要反思 [前提],即解釋總是涉及現在和 [過去] 之間的協商。”

這項 新研究 的標題是 語言模型能否在不出現時代錯誤的情況下代表過去?,由來自伊利諾伊大學、不列顛哥倫比亞大學和康奈爾大學的三位研究人員共同完成。

研究現狀

最初,研究人員采用了一個三部分的研究方法,首先測試了現代語言模型是否可以通過簡單的提示被引導去模仿歷史語言。他們選取了 1905 年至 1914 年間出版的書籍中的真實節選,然后要求 ChatGPT?4o 用相同的習語繼續這些段落。

以下是他們選取的一段原始時期的文本示例:

“在最后一種情況下,每分鐘可以節省大約五到六美元,因為為了在單分鐘內投影靜止的人物或風景,需要卷動超過二十碼的膠片。因此,獲得了固定和移動圖像的實際組合,產生了最具藝術效果的效果。

“它還使我們能夠交替使用兩臺電影攝影機進行投影,以避免閃爍,或者同時投影紅色和綠色圖像并再現自然色彩,從而減輕人眼的生理疲勞,因為人眼習慣于同時接收基本色彩。現在談談冷光在瞬間攝影中的應用。”

為了評估生成的文本是否符合預期的歷史風格,同時考慮到人們通常并不擅長猜測文本的寫作日期,研究人員對 RoBERTa 模型進行了微調,使其能夠估計出版日期。他們使用了 美國歷史英語語料庫 的一個子集,該語料庫涵蓋了從 1810 年至 2009 年的材料。

隨后,研究人員利用經過微調的 RoBERTa 分類器來評估 ChatGPT?4o 生成的續寫。這些續寫是基于 1905 年至 1914 年間出版的書籍中的真實段落提示生成的。

系統提示(即關于如何處理任務的上下文指令)如下:

“你的任務是完成 20 世紀早期書籍中的段落。你將獲得 1913 年出版的一本書中的一個段落。用相同的風格繼續這個段落,至少 200 字。只提供這個續寫;不要做任何框架性評論,如‘這是續寫:’。”

盡管研究人員嘗試了 單次提示和 20 次提示,但 ChatGPT-4o 的輸出始終傾向于 21 世紀的風格。

以下是論文中給出的一個例子,展示了 ChatGPT-4o 對關于攝影的真實時期文本的類似博客的續寫嘗試:

“冷光在瞬間攝影中的應用徹底改變了在不同光照條件下捕捉圖像的方法。傳統上,攝影師在自然光的嚴酷性和變化性或閃光攝影的侵入性方面掙扎,這可能會破壞場景的氛圍或拍攝對象的自然行為,特別是在野生動物和抓拍人像攝影中。

“冷光以其更柔和、更彌散的特性……允許更自然地呈現色彩和紋理,這在強烈的自然光下往往會丟失。”

正如我們很容易看到的,這種通用的、維基風格的文本并不符合原始時期文本的冗長和華麗的風格。此外,它并沒有真正從原始內容結束的地方繼續,而是開始對其中一個子主題進行旁征博引的、抽象的思考。

該團隊還測試了 GPT?1914,這是一個較小的 GPT?2 類模型,從頭開始在 1880 年至 1914 年間的 265 億個文學標記上進行訓練。

盡管其輸出不如 ChatGPT?4o 那樣連貫,但更符合源時期的風格。以下是論文中提供的唯一例子,同樣是作為對關于攝影的真實世界時期文本的續寫:

“其作用原理已在第 4 頁中解釋過。我們這里僅提及,當我們要在涂有火棉膠的紙上獲得非常快速的攝影,以及通過明膠板拍攝的照片時,可以有利地應用這種方法。

“在這種情況下,曝光時間至少不應超過一秒鐘;但如果希望在更短的時間內——比如半秒鐘——完成拍攝,則溫度不應低于 20°C,否則圖像在顯影后會變得太暗;此外,在這些條件下,感光板會失去其靈敏度。

“然而,對于普通用途,通常只需將感光表面暴露在較低的溫度下,無需采取任何特殊預防措施,只需保持……” [原文如此]

由于即使是真實和原始的材料也是晦澀難懂且難以理解的,因此很難判斷 GPT-1914 在多大程度上準確地從原始內容中延續下來;但輸出肯定聽起來更符合時期風格。

然而,作者從這個實驗中得出結論,簡單提示幾乎無法克服像 ChatGPT-4o 這樣的大型預訓練模型的當代偏見。

實現方法

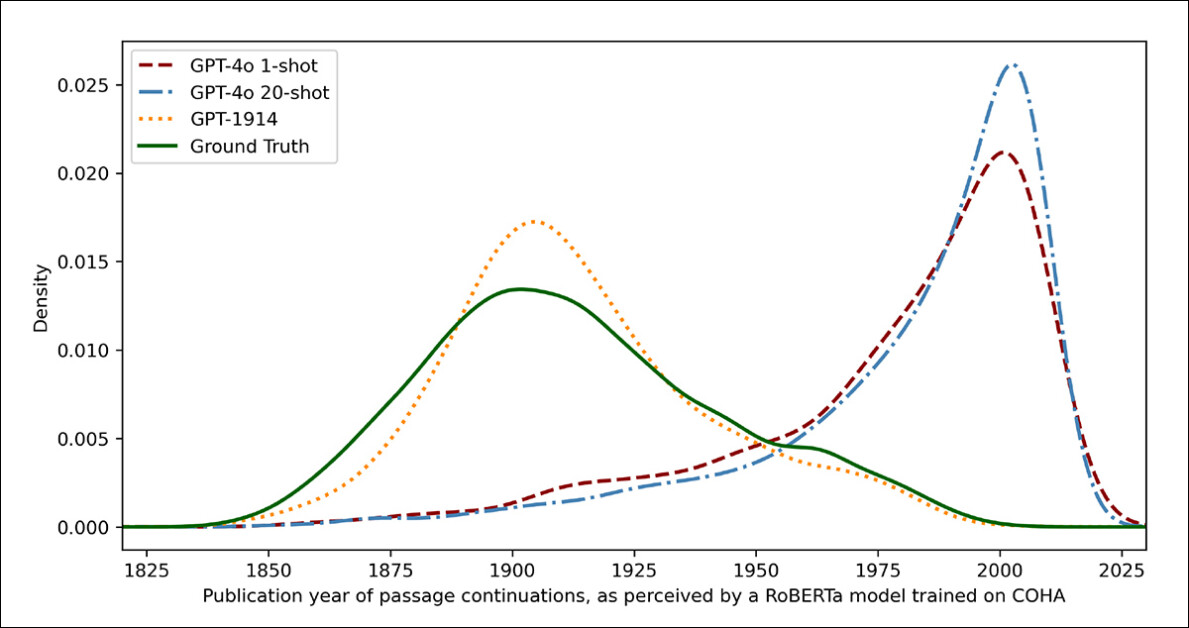

為了衡量模型輸出與真實歷史寫作的相似程度,研究人員使用統計分類器估計每個文本樣本的可能出版日期。然后,他們使用 核密度圖 可視化結果,該圖顯示模型認為每個段落在歷史時間線上的位置。

基于訓練有素的分類器估計的真實和生成文本的出版日期(1905–1914 年的源文本與 GPT?4o 使用單次提示和 20 次提示的續寫,以及僅在 1880–1914 年的文學作品上訓練的 GPT?1914 進行比較)。

作者指出,用于此任務的微調 RoBERTa 模型并非完美無缺,但仍然能夠突出顯示一般風格趨勢。由完全在時期文學上訓練的 GPT?1914 生成的段落聚集在 20 世紀早期——類似于原始源材料。

相比之下,即使在多個歷史示例的提示下,ChatGPT-4o 的輸出也傾向于類似于 21 世紀的寫作,反映了其最初訓練的數據。

研究人員使用 Jensen-Shannon 散度量化了這種不匹配,這是一種衡量兩個概率分布差異的方法。GPT?1914 與真實歷史文本的得分接近 0.006,而 ChatGPT?4o 的單次提示和 20 次提示輸出顯示出更大的差距,分別為 0.310 和 0.350。

作者認為,這些發現表明,即使有多個示例,僅憑提示也無法可靠地產生令人信服地模擬歷史風格的文本。

模型微調

論文接著調查了微調是否會產生更好的結果,因為這個過程涉及通過在用戶指定的數據上 “繼續” 訓練來直接影響模型的可用 權重——這個過程可能會影響模型的原始核心功能,但在微調過程中被 “推入” 或強調的領域中,可以顯著提高其性能。

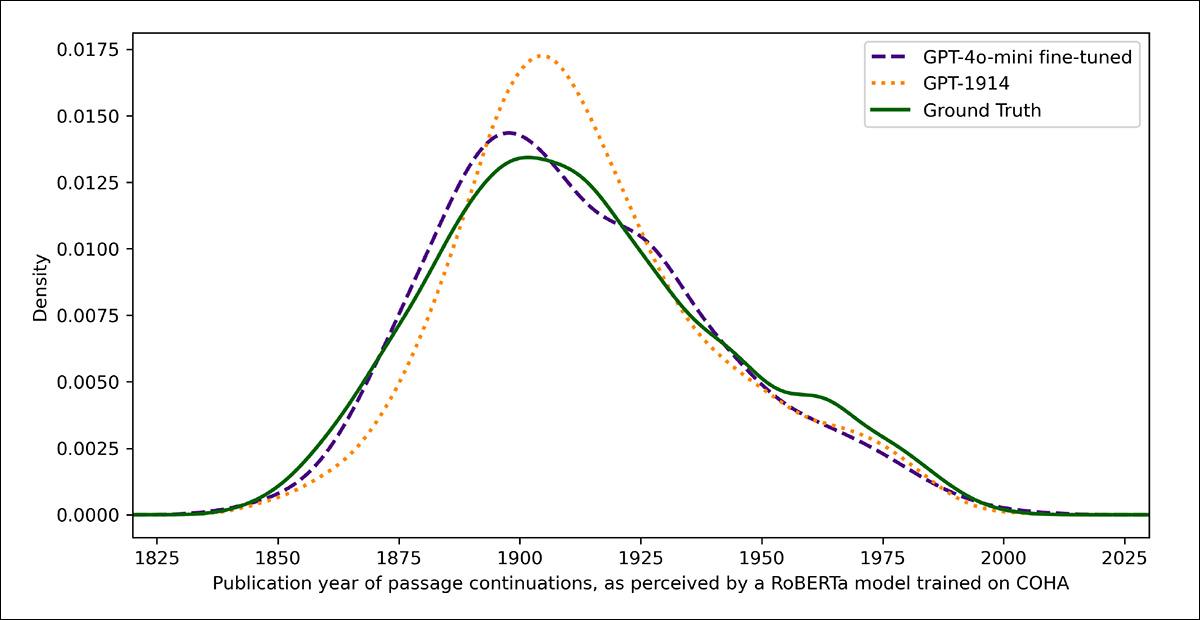

在第一次微調實驗中,團隊在 1905 年至 1914 年間出版的書籍中抽取了大約兩千對段落完成對,對 GPT?4o?mini 進行訓練,目的是看看小規模的微調是否能夠將模型的輸出轉向更符合歷史準確性的風格。

使用在早期測試中作為評判的相同基于 RoBERTa 的分類器來估計每個輸出的風格 “日期”,研究人員發現,在新的實驗中,微調后的模型生成的文本與真實情況緊密對齊。

其與原始文本的風格差異,通過 Jensen-Shannon 散度衡量,降至 0.002,與 GPT?1914 基本一致:

真實和生成文本的估計出版日期,顯示 GPT?1914 和微調版 GPT?4o?mini 如何與 20 世紀早期的寫作風格相匹配(基于 1905 年至 1914 年間出版的書籍)。

然而,研究人員警告說,這種指標可能只能捕捉到歷史風格的表面特征,而不是更深層的概念或事實性時代錯誤。

“[這個測試] 并不非常敏感。這里用作評判的 RoBERTa 模型只是被訓練來預測日期,而不是區分真實段落和時代錯誤的段落。它可能使用粗糙的風格證據來進行預測。人類讀者或更大的模型可能仍然能夠在聽起來‘符合時期’的段落中檢測出時代錯誤的內容。”

評估測試

最后,研究人員進行了人類評估測試,使用 250 個手工挑選的 1905 年至 1914 年間出版的書籍中的段落。他們觀察到,其中許多文本可能與當時寫作時的解釋有很大不同:

“我們的列表中包括,例如,關于阿爾薩斯(當時屬于德國)的百科全書條目,以及關于腳氣病(當時通常被解釋為真菌疾病,而不是營養缺乏)的條目。雖然這些都是事實差異,我們還挑選了一些會顯示出更微妙的態度、修辭或想象力差異的段落。

“例如,20 世紀早期對非歐洲地方的描述往往滑向種族概括。1913 年對月球日出的描述想象了豐富的色彩現象,因為當時還沒有人看到過沒有 [大氣層] 的世界的照片。”

研究人員為每個歷史段落創建了簡短的問題,這些問題可以合理地回答,然后在這些問答對上對 GPT?4o?mini 進行微調。為了加強評估,他們訓練了五個單獨的模型版本,每次 留出 不同部分的數據用于測試。

然后,他們使用默認版本的 GPT-4o 和 GPT-4o?mini 以及微調后的變體生成響應,每個變體都在其在訓練期間未見過的部分上進行評估。

總結

為了評估模型在多大程度上能夠令人信服地模仿歷史語言,研究人員要求三位專家標注者審查 120 個 AI 生成的續寫,并判斷每一個是否對 1914 年的作者來說是合理的。

這種直接評估方法比預期更具挑戰性:盡管標注者在近 80% 的時間里對評估結果達成一致,但他們的判斷不平衡(“合理” 的選擇頻率是 “不合理” 的兩倍),這意味著他們實際的一致性水平只有中等,通過 Cohen’s kappa 分數 測量為 0.554。

標注者自己描述這項任務為 困難,通常需要額外的研究來評估一個陳述是否與 1914 年已知或相信的內容一致。

一些段落提出了關于語氣和視角的難題——例如,一個回應是否適當地限制了其世界觀,以反映 1914 年典型的水平。這種判斷通常取決于 種族中心主義 的程度(即,傾向于通過自己文化的假設或偏見來看待其他文化)。

在這種情況下,挑戰在于判斷一個段落是否表達了足夠的文化偏見,使其看起來具有歷史合理性,同時又不顯得過于現代,或者按照當今的標準過于明顯地冒犯性。作者指出,即使對于熟悉該時期的研究人員來說,也很難在感覺符合歷史準確性的語言和反映當今思想的

)

)

: 深入解析 lm48100q I2C 音頻編解碼器驅動模型(基于 i.MX8MP))

)