?點擊這里?:🚀原文鏈接:(更好排版、視頻播放、社群交流、最新AI開源項目、AI工具分享都在這個公眾號!)

使用 Ollama 和 Open WebUI 自托管 LLM 聊天機器人(無需 GPU)

🌟 Open WebUI 是一個可擴展、功能豐富且用戶友好的 自托管 WebUI ,旨在完全離線運行。 它支持各種 LLM 運行器,包括

Ollama 和 OpenAI 兼容 API。

Github:https://github.com/open-webui/open-webui/

Hello,大家好,我是Aitrainee,今天介紹 ** Open WebUI ** (以前稱為 Ollama WebUI),以及

測試Ollama后端API 是否成功運行的兩種方式(Postman)。

Open WebUI 的主要功能 ?

-

? 🚀 輕松設置 :使用 Docker 或 Kubernetes(kubectl、kustomize 或 helm)進行無縫安裝,支持

:ollama和:cuda標簽的鏡像。 -

? 🤝 Ollama/OpenAI API 集成 :輕松集成兼容 OpenAI 的 API,以實現多功能對話和 Ollama 模型。自定義 OpenAI API URL 以鏈接到 LMStudio、GroqCloud、Mistral、OpenRouter 等 。

-

? 🧩 Pipelines,Open WebUI 插件支持 :使用 Pipelines 插件框架 將自定義邏輯和 Python 庫無縫集成到 Open WebUI 中。啟動您的 Pipelines 實例,將 OpenAI URL 設置為 Pipelines URL,并探索無限可能。 示例 包括 功能調用 、用戶 訪問限制 、使用 Langfuse 等工具的 使用監控 、使用 LibreTranslate 的 實時翻譯 以支持多語言、 有害信息過濾 等等。

-

? 📱 響應式設計 :在臺式電腦、筆記本電腦和移動設備上享受無縫體驗。

-

? 📱 移動設備的漸進式 Web 應用 (PWA):通過我們的 PWA,在移動設備上享受本地應用般的體驗,提供本地主機的離線訪問和無縫用戶界面。

-

? ??🔢 全面的 Markdown 和 LaTeX 支持 :通過綜合的 Markdown 和 LaTeX 功能提升您的 LLM 體驗,實現豐富的互動。

-

? 🛠? 模型構建器 :通過 Web UI 輕松創建 Ollama 模型。創建和添加自定義角色/代理,定制聊天元素,并通過 Open WebUI 社區 集成輕松導入模型。

-

? 📚 本地 RAG 集成 :通過突破性的檢索增強生成 (RAG) 支持,深入探索聊天互動的未來。此功能將文檔互動無縫集成到您的聊天體驗中。您可以將文檔直接加載到聊天中,或將文件添加到您的文檔庫中,在查詢前通過

#命令輕松訪問它們。 -

? 🔍 RAG 的 Web 搜索 :使用

SearXNG、Google PSE、Brave Search、serpstack和serper等提供商進行 Web 搜索,并將結果直接注入您的聊天體驗中。 -

? 🌐 Web 瀏覽功能 :使用

#命令后跟 URL,將網站無縫集成到您的聊天體驗中。此功能允許您將 Web 內容直接納入對話中,增強互動的豐富性和深度。 -

? 🎨 圖像生成集成 :通過使用 AUTOMATIC1111 API 或 ComfyUI(本地)和 OpenAI 的 DALL-E(外部)等選項,無縫集成圖像生成功能,為您的聊天體驗增添動態視覺內容。

-

? ?? 多模型對話 :輕松與多個模型同時互動,利用它們的獨特優勢以獲得最佳響應。通過并行利用多種模型來增強您的體驗。

-

? 🔐 基于角色的訪問控制 (RBAC):確保安全訪問,只有授權人員才能訪問您的 Ollama,管理員專享模型創建/拉取權限。

-

? 🌐🌍 多語言支持 :通過我們的國際化 (i18n) 支持,以您偏好的語言體驗 Open WebUI。加入我們,擴展我們支持的語言!我們正在積極尋找貢獻者!

-

? 🌟 持續更新 :我們致力于通過定期更新、修復和新功能不斷改進 Open WebUI。

跟著我快速開始

1. 安裝完Docker(公眾號菜單有一鍵環境配置腳本,LLM API開源項目也有)

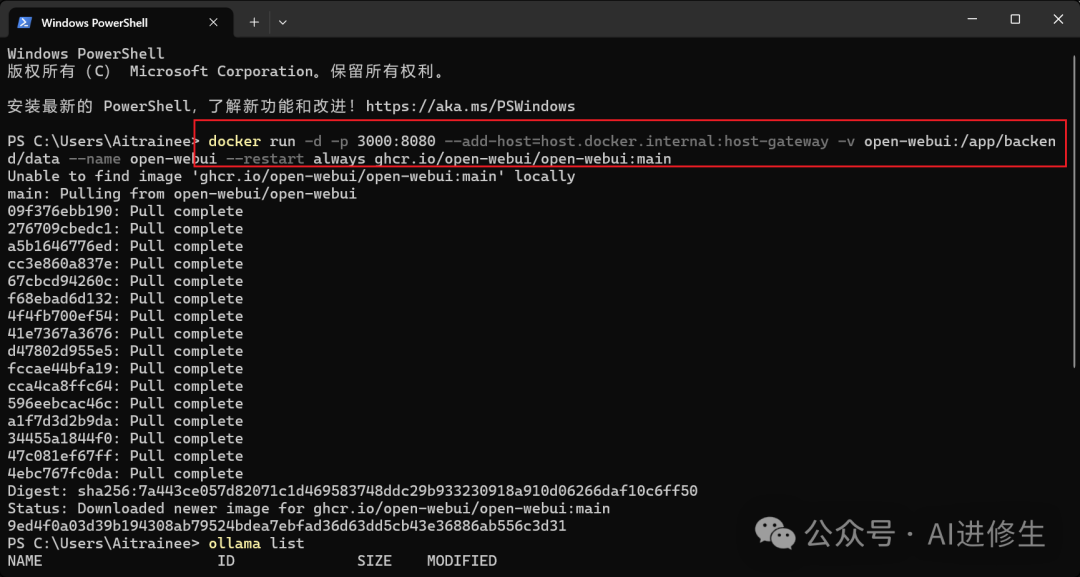

2. 如果您的 計算機上有 Ollama, 運行以下指令

安裝ollama: 全民AI時代:手把手教你用 Ollama & AnythingLLM搭建AI知識庫,無需編程,跟著做就行!

(不安裝ollama或者不使用docker的話,文章的后面會有所有的部署方式)

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

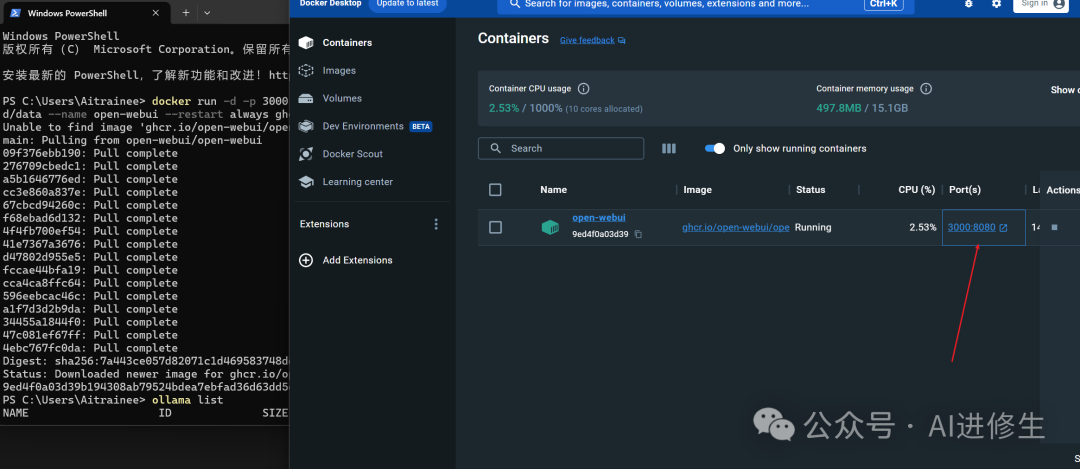

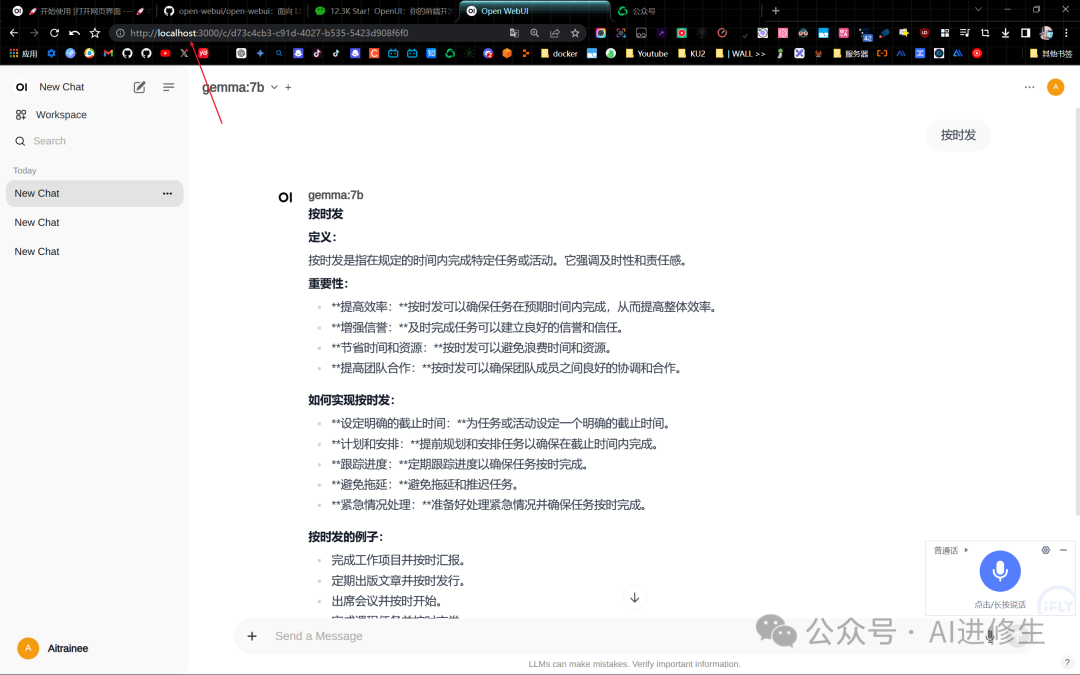

這里顯示的是windows系統docker desktop的部署: 打開這個端口

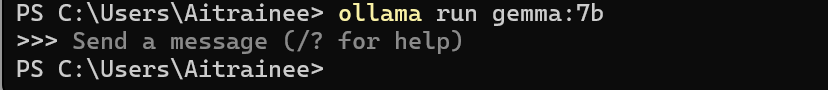

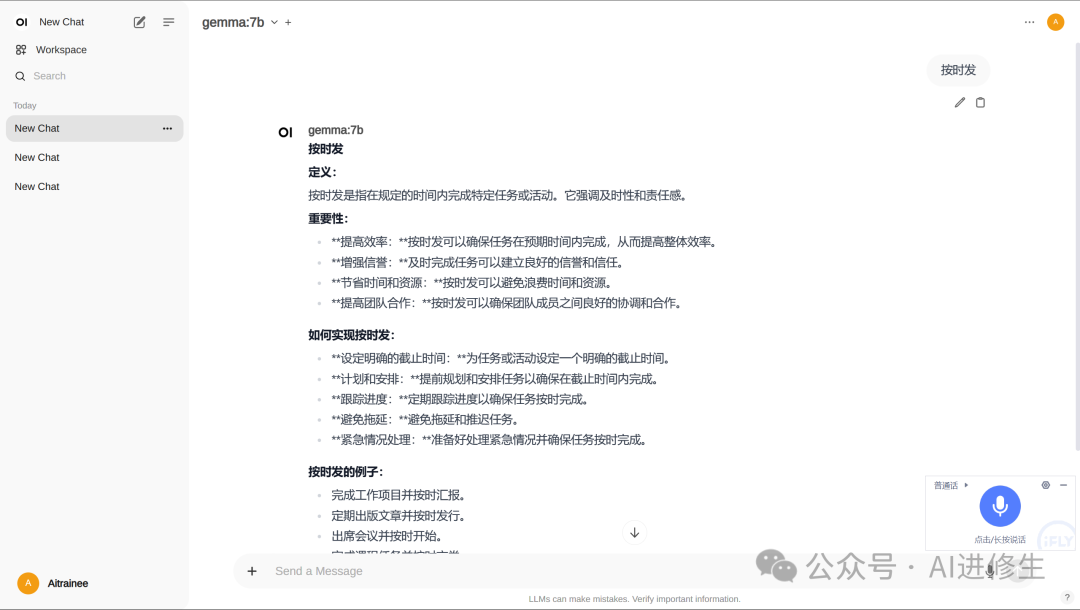

來到前端頁面就部署成功了,左上角選擇模型(記得將歐拉瑪后端啟動)

▲ ollama后端啟動

Ollama后端API測試

這個 open web

ui是相當于一個前端項目,它后端調用的是ollama開放的api,這里我們來測試一下ollama的后端api是否是成功的,以便支持你的api調用操作

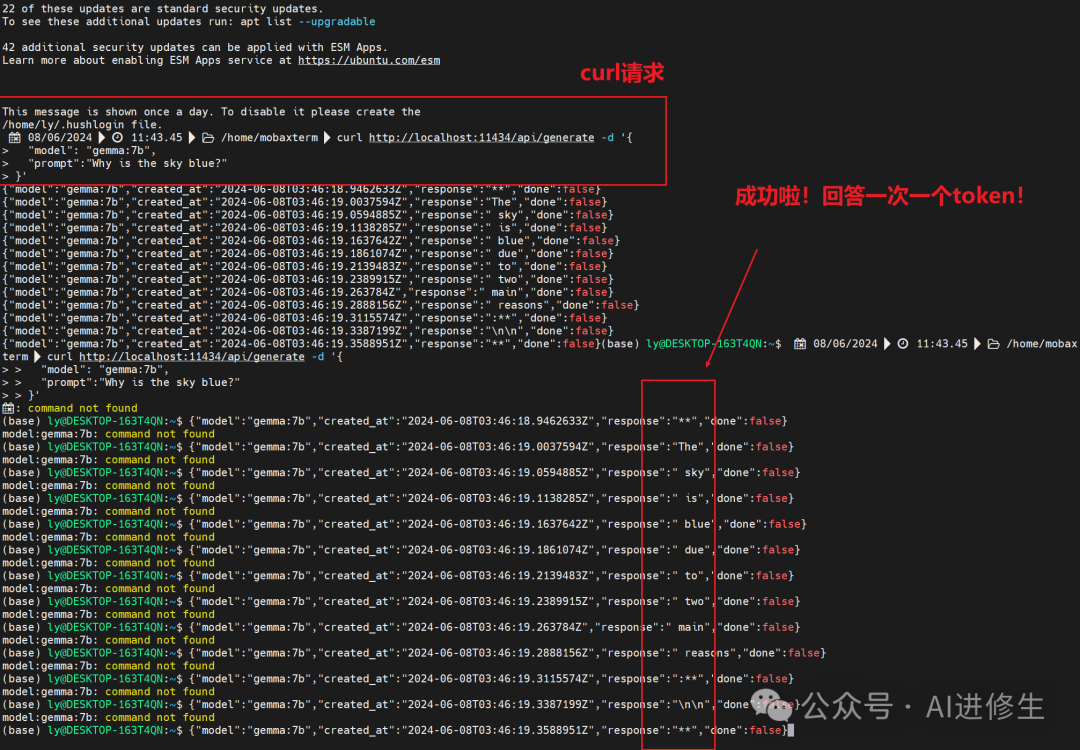

方式一:終端curl( REST API)

Ollama 提供用于運行和管理模型的 REST API。

生成響應

curl http://localhost:11434/api/generate -d '{ "model": "llama3", "prompt": "為什么天空是藍色的?"

}'

與模型聊天

curl http://localhost:11434/api/chat -d '{ "model": "llama3", "messages": [ { "role": "user", "content": "為什么天空是藍色的?" } ]

}'

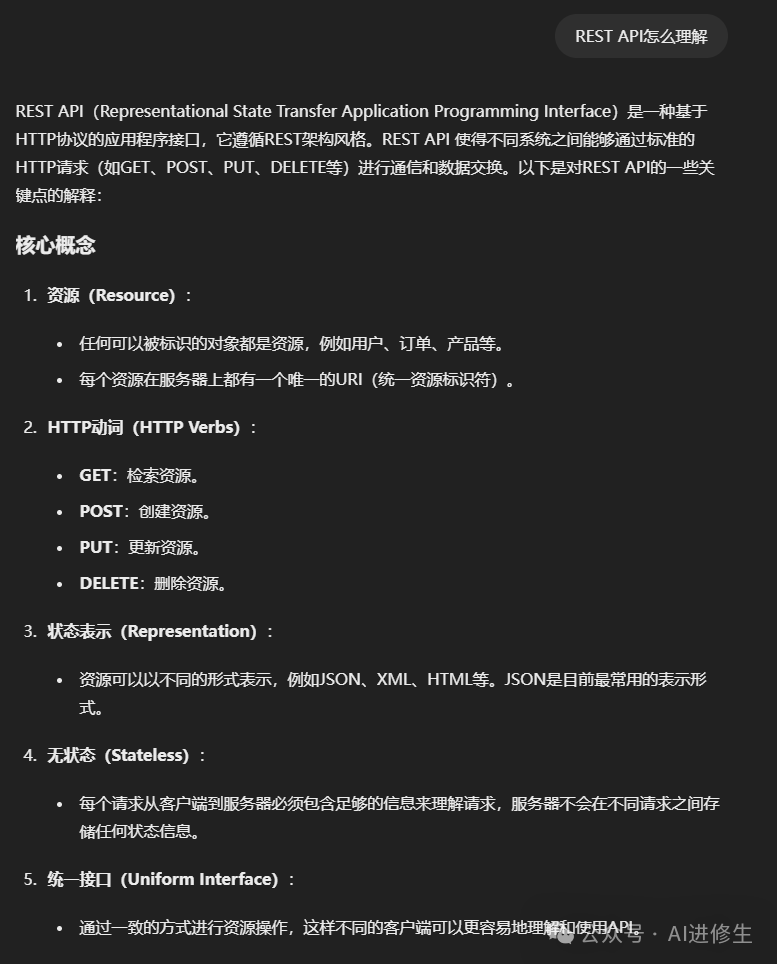

REST API(Representational State Transfer Application Programming

Interface)是一種基于HTTP協議的應用程序接口,它遵循REST架構風格。

REST API 使得不同系統之間能夠通過標準的HTTP請求(如GET、POST、PUT、DELETE等)進行通信和數據交換。

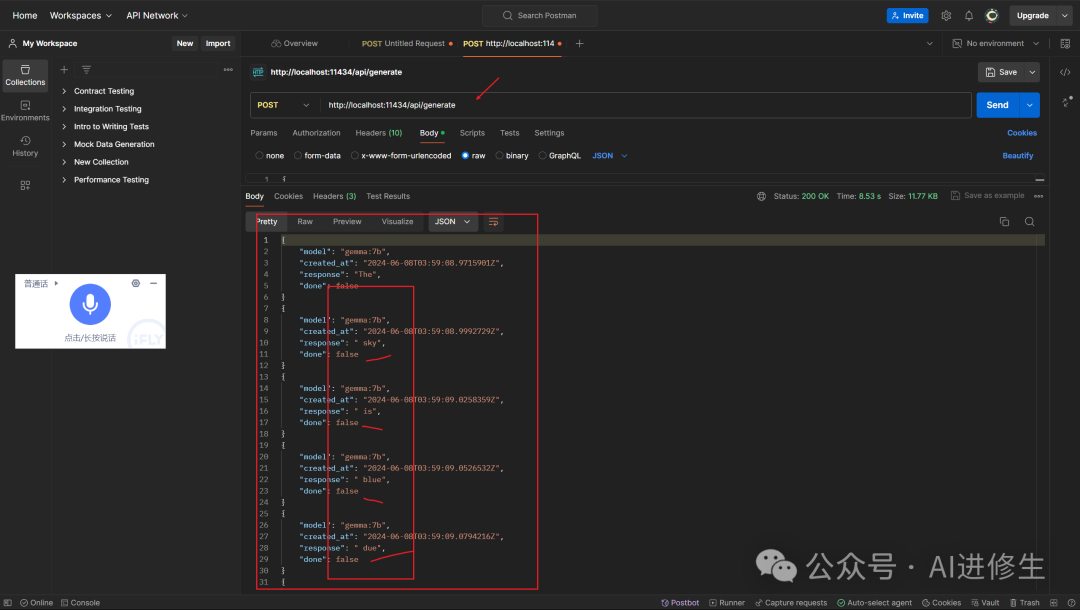

方式二: ** Postman測試 **

設置 Postman 請求

-

1. 打開 Postman : 確保你已經安裝并打開了 Postman。

-

2. 創建新請求 :

* ? 點擊 "New" 按鈕。 * ? 選擇 "HTTP Request"。

- 3. 設置請求方法和 URL :

* ? 將請求方法設置為 ` POST ` 。 * ? 輸入 URL ` http://localhost:11434/api/generate ` 。

- 4. 設置請求頭 : 在 “Headers” 選項卡中添加一個新鍵值對:

* ? ` Content-Type ` : ` application/json `

- 5. 設置請求體 :

* ? 切換到 "Body" 選項卡。 * ? 選擇 "raw"。 * ? 確保選擇 "JSON" 格式。 * ? 在文本框中輸入以下 JSON 數據: { "model": "gemma:7b", "prompt": "Why is the sky blue?" }

- 6. 發送請求 :

* ? 點擊 "Send" 按鈕發送請求。 * ? 本地請求API:比如:http:// **localhost** :11434/api/generate,記得先安裝 Postman Agent(你sent之后它會提示你安裝的) *

驗證響應

- 1. 查看響應 :

* ? 請求發送后,查看響應的狀態碼應該是 ` 200 OK ` ,表示請求成功。 * ? 響應體應該包含 JSON 數據,你會看到類似于你之前提供的逐步生成的響應。

*  *

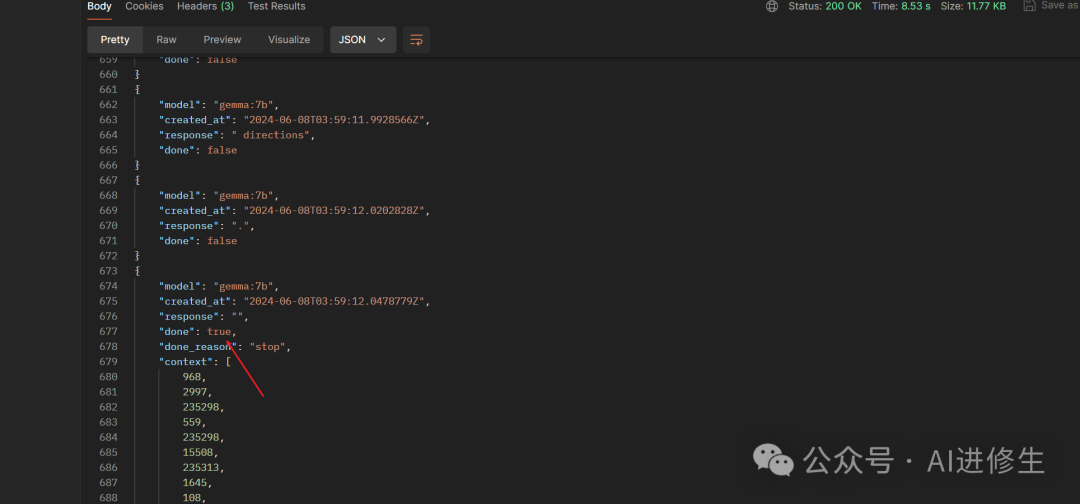

- 2. **檢查

done字段 ** :

* ? 在 Postman 的 "Tests" 選項卡中,你可以編寫 JavaScript 測試代碼來自動驗證 ` done ` 字段的值。 * ? 以下是一個示例測試代碼: pm.test("Check if response is complete", function () { var jsonData = pm.response.json(); pm.expect(jsonData.done).to.eql(true); });

- 3. **持續發送請求直到

done為true** :

* ? 你可能需要多次發送請求來檢查是否 ` done ` 字段變為 ` true ` 。 * ? 你可以在 Postman 中設置一個循環或手動重復發送請求來檢查。 * *

下面提供官方的 文檔介紹、相關資源、部署教程 等,進一步支撐你的行動,以提升本文的幫助力。

如何安裝 🚀

使用默認配置安裝

-

? 如果 Ollama 在您的計算機上 ,請使用此命令:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main -

? 如果 Ollama 在另一臺服務器上 ,請使用此命令:要連接到另一臺服務器上的 Ollama,請將

OLLAMA_BASE_URL更改為服務器的 URL:docker run -d -p 3000:8080 -e OLLAMA_BASE_URL=https://example.com -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:maindocker run -d -p 3000:8080 --gpus all --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:cuda- ? 要使用 Nvidia GPU 支持運行 Open WebUI ,請使用此命令:

僅使用 OpenAI API 安裝

-

? 如果您僅使用 OpenAI API ,請使用此命令:

docker run -d -p 3000:8080 -e OPENAI_API_KEY=your_secret_key -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

安裝帶有捆綁 Ollama 支持的 Open WebUI

此安裝方法使用單個容器鏡像將 Open WebUI 與 Ollama 捆綁在

一起,允許通過單個命令進行簡化設置。根據您的硬件設置選擇適當的命令:

-

? 支持 GPU :通過運行以下命令利用 GPU 資源:

docker run -d -p 3000:8080 --gpus=all -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama -

? 僅限 CPU :如果您不使用 GPU,請使用此命令:

docker run -d -p 3000:8080 -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama

兩個命令都可以實現 Open WebUI 和 Ollama 的內置簡化安裝,確保您可以迅速啟動和運行。

安裝后,您可以訪問 http://localhost:3000 的 Open WebUI。享受吧!😄

保持 Docker 安裝最新

如果您想將本地 Docker 安裝更新到最新版本,可以使用 Watchtower :

docker run --rm --volume /var/run/docker.sock:/var/run/docker.sock containrrr/watchtower --run-once open-webui

在命令的最后部分,如果容器名稱不同,請將 open-webui 替換為您的容器名稱。

知音難求,自我修煉亦艱

抓住前沿技術的機遇,與我們一起成為創新的超級個體

(把握AIGC時代的個人力量)

**

**

** 點這里 👇 關注我,記得標星哦~ **

一鍵三連「分享」、「點贊」和「在看」

科技前沿進展日日相見 ~

預覽時標簽不可點

微信掃一掃

關注該公眾號

輕觸閱讀原文

AI進修生

收藏

)

)

![[office] 快速刪除excel中的空行和列的方法 #其他#學習方法#經驗分享](http://pic.xiahunao.cn/[office] 快速刪除excel中的空行和列的方法 #其他#學習方法#經驗分享)

![B3870 [GESP202309 四級] 變長編碼](http://pic.xiahunao.cn/B3870 [GESP202309 四級] 變長編碼)