在本研究中,我們研究了基于 You-Only-Look-Once (YOLO) 架構的端到端融合模型的有效性,該模型可同時檢測和分類數字乳房 X 光檢查中的可疑乳腺病變。包括四類病例:腫塊、鈣化、結構扭曲和正常,這些病例來自包含 413 個病例的私人數字乳房 X 光檢查數據庫。

對于所有病例,先前的乳房 X 光檢查(通常是 1 年前掃描的)均報告為正常,而當前的乳房 X 光檢查被診斷為癌變(經活檢證實)或健康。 方法:建議將基于 YOLO 的融合模型應用于當前的乳房 X 光檢查,以檢測和分類乳房病變。然后將同一模型回顧性地應用于合成乳房 X 光片以進行早期癌癥預測,其中合成乳房 X 光片是使用圖像到圖像轉換模型 CycleGAN 和 Pix2Pix 從 Prior 乳房 X 光片生成的。

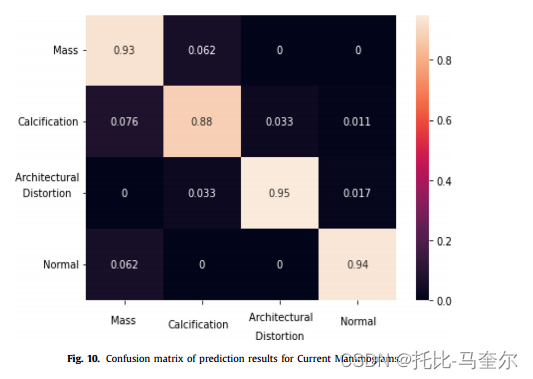

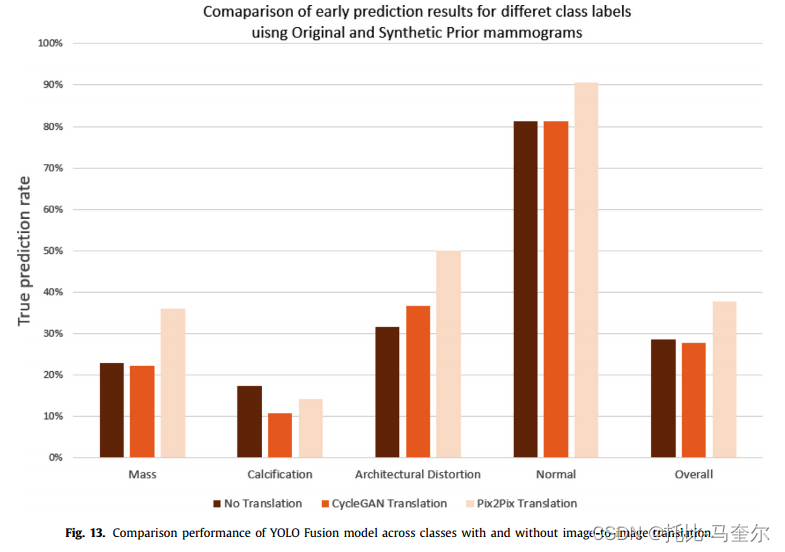

結果:評估結果表明,我們的方法可以顯著檢測和分類當前乳房 X 光片上的乳腺病變,腫塊病變的最高率為 93% ± 0.118,鈣化病變的最高率為 88% ± 0.09,結構扭曲病變的最高率為 95% ± 0.06。此外,報告了對 先前 乳房 X 光片的評估結果,腫塊病變的最高率為 36% ± 0.01,鈣化病變的最高率為 14% ± 0.01,結構扭曲病變的最高率為 50% ± 0.02。因此,在當前和先前檢查中,對正常乳房 X 光檢查的分類準確率分別為 92% ± 0.09 和 90% ± 0.06。

結論:提出的框架最初是為了幫助在當前篩查中檢測和識別 X 光乳房 X 光檢查中的可疑乳腺病變而開發的。建議減少先前和后續篩查之間的時間變化,以便盡早預測先前乳房 X 光檢查中異常的位置和類型。

1. 介紹

乳腺癌最常見的癥狀是乳腺結構和組織外觀的嚴重變化,還伴有乳腺腫瘤和細胞簇的快速形成。

乳房 X 線檢查是早期檢測和診斷乳腺癌的有效醫學影像工具之一,可降低早期乳腺癌的晚期和致死率。為了檢查潛在病變(如腫塊、鈣化、結構扭曲),放射科醫生依靠人類的視覺理解來檢測和提取乳房 X 線照片中的所有診斷信息。然而,已證明大約 10% 到 30% 的癌癥病例在篩查乳房 X 線照片中被漏掉,這會產生高達 50% 的假陰性率,具體取決于病變類型和乳腺密度 [6]。隨著后續隨訪和診斷期間篩查的增加,已經證明大約 50% 的先前乳房 X 線照片在回顧時有可見的病變 [7]。因此,這讓放射科醫生懷疑,沒有任何類型病變明顯跡象的正常先前乳房 X 線照片是否可能含有表明未來出現腫瘤風險的隱藏信息。?

CAD 被開發用于定位篩查乳房 X 線攝影中存在的病變可疑區域。CAD 方法通常基于提取圖像特征(例如灰度、紋理和形狀)以通過簡單的機器學習技術識別感興趣區域 (ROI) 。到目前為止,這些技術尚未降低高假陽性率,也未克服腫瘤形狀、大小和紋理的高度變化。

文獻中廣泛使用的此類模型被認為是卷積神經網絡 (CNN) 模型的變體,即 R-CNN、快速 CNN 和更快的 R-CNN 模型 [16]。然而,一種名為 You-Only-LookOnce (YOLO) 的單一模型被建議同時進行檢測和分類任務,具有低內存依賴性和快速結果,這使其便于 CAD 應用 [17, 18]。

首先提出使用基于 YOLO 的模型,同時檢測當前乳房 X 光檢查中的異常病變并將其分類為腫塊、鈣化或結構扭曲。其次,研究了訓練后的模型在先前乳房 X 光檢查中定位和標記異常區域的潛在性能,這些區域被報告為正常,但后來在后續篩查中被診斷為異常。

為此,我們的方法使用圖像到圖像的轉換技術,在第一階段學習乳房 X 光檢查對之間的圖像映射,從而生成轉換后的先前乳房 X 光檢查以克服篩查之間的錯位,在第二階段,預測未來病變在早期篩查中出現的位置和性質。

2. 背景

許多研究表明 CAD 系統能夠有效地從原始篩查乳房 X 線照片中自動檢測可疑病變。神經網絡模型的引入改變了 CAD 的方法,用能夠學習不同尺度復雜特征的深度學習架構取代了手工提取特征。

最近的研究嘗試使用不同的神經網絡開發 CAD 模型來快速準確地定位現有病變。Ribli 等人[23] 開發了一種 CAD 系統,使用 Faster R-CNN 模型檢測 INbreast 數據集的乳腺病變并將其分類為惡性或良性,并獲得 0.95 的 AUC 評分。同樣地,Peng 等人[24] 提出了一種結合 Faster R-CNN 架構和多尺度特征金字塔網絡的自動腫塊檢測方法。該研究在 CBIS-DDSM 和 INbreast 數據集上分別取得了 0.93 和 0.95 的真陽性率。該研究在 DDSM 數據集上的檢測準確率高達 90%,分類準確率達到 93.5%。在 Li 等人[25] 的另一項研究中,他們使用兩個網絡介紹了一種雙側腫塊檢測方法:左右乳房之間的配準網絡和 Siamese-Faster-RCNN 網絡,用于從已配準的乳房 X 光片對中檢測腫塊。報告的結果顯示,在 INbreast 數據集上的真實陽性率為 0.88,在私有數據集上的真實陽性率為 0.85。Vivek 等人的另一項嘗試 [26] 使用了 [27] 中提出的單次檢測器 (SSD) 模型,首先定位乳腺腫瘤,然后分割和分類感興趣的區域。這項工作在 INbreast 數據集上實現了 0.97 的真實陽性率。

隨著用于乳房 X 線攝影中物體檢測的深度學習架構的進步,YOLO(You-Only-Look-Once)模型已被引入,與最先進的方法相比,它在實現快速準確的檢測和分類方面表現出色。Al-masni 等人 [28] 使用基于 YOLO 的模型開發了一個 CAD 系統,在 DDSM 數據集上實現了 85.52% 的檢測準確率。此外,Hamed 等人 [29] 提出了一種基于 YOLOV4 的 CAD 系統,可以對完整和裁剪的乳房 X 線攝影中的腫塊進行雙路徑檢測,然后將其分類為良性和惡性。該系統的總體檢測率為 98%,分類準確率為 95%。在同一背景下,Al-masni 等人 [30] 提出了一個 CAD 系統框架,該系統使用基于 YOLO 的模型在完整圖像中檢測乳房腫塊,總體準確率為 99.7%。因此,Baccouche 等人 [31] 最近提出了一種基于 YOLO 的融合模型來檢測乳腺病變并將其分類為腫塊或鈣化。該工作在 INbreast 數據集上實現了 98.1% 的檢測準確率,在 CBIS-DDSM 數據集上實現了 95.7% 的檢測準確率

使用基于深度學習的 CAD 系統在乳房 X 線攝影中對乳腺癌進行早期檢測和診斷可以通過標記病變來幫助預防腫瘤的發展,從而有效降低死亡率。Timp 等人 [34] 最近的一項研究試圖通過添加有關腫瘤隨時間變化的行為信息來改善腫塊病變的表征。使用區域配準方法檢測兩個連續篩查圖像之間的時間變化,以便定位在當前視圖上檢測到的病變及其在先前視圖上的對應病變。之后,應用支持向量機 (SVM) 分類器來顯示時間特征的有效性。

另一項研究中,Timp 等人 [35] 嘗試通過在 CAD 系統中加入時間信息來改進檢測方法。采用沿特征空間的區域配準技術將當前乳房 X 光檢查上的可疑位置與先前乳房 X 光檢查上的相應位置進行映射,準確率為 72%。因此,Loizidou 等人 [36] 嘗試在應用 SVM 分類器之前在乳房 X 光檢查對之間添加時間減法,將微鈣化檢測準確率提高到 99.2%。Loizidou 等人 [37] 最近的一項研究擴展了他們之前的乳腺微分類檢測和分類工作,在應用對的時間減法之前添加了先前乳房 X 光檢查的圖像配準步驟。在 Zheng 等人的另一項工作中,將后續數字乳房 X 光檢查圖像整合在一起,開發了一種用于乳腺癌檢測的 CAD 方法。所有區域圖像均通過 AdaBoost 方法使用 Haar 特征、局部二值模式和方向梯度直方圖進行檢測,然后輸入 CNN 以濾除誤報情況。

隨著深度卷積神經網絡的出現,圖像到圖像的轉換(主要是圖像的合成和重建)已用于解決醫學成像中的許多計算機視覺應用。基于兩種基本架構,稱為 Pix2Pix 和 CycleGAN,具體取決于圖像的數據形式、成對或非成對的數據集。

Shen 等人 [40] 最近的一項應用使用 Pix2Pix 網絡進行乳房 X 線攝影中的圖像到掩模分割。Liao 等人 [41] 還使用 Pix2pix 來人工去除 CT 掃描中的偽影,該方法在臨床圖像重建方面顯示出改進。此外,Modanwal 等人 [42] 成功使用 CycleGAN 重建和協調乳腺癌的 MRI 圖像,而無需成對對齊的圖像。Baccouche 等人 [43] 的一項研究采用了 CycleGAN 的有效性,他們嘗試使用 CycleGAN 模型在兩個不成對的乳房 X 線攝影數據集之間生成合成圖像來增強乳房 X 線攝影數據。Hammami 等人 [44] 的一項研究也通過結合 CycleGAN 和 YOLO 增強了多器官檢測性能。

首先嘗試使用基于 YOLO 的融合模型解決在最近的篩查乳房 X 光檢查中檢測和分類三種類型的乳腺病變(即腫塊、鈣化、結構扭曲)的任務。其次,建議復制早期篩查的乳房 X 光檢查,診斷結果健康,并保持先前??的形狀和外觀,同時預測與當前乳房 X 光檢查相似的可疑發現。評估了兩種最先進的圖像到圖像轉換技術 CycleGAN 和 Pix2Pix,并比較了它們在早期篩查時預測先前乳房 X 光檢查中病變位置和類型的性能。

3. 方法和材料

3.1?基于 YOLO 的融合模型:概述

YOLO 是一種深度學習網絡,其中單個卷積神經網絡 (CNN) 架構模型可同時定位物體的邊界框并從整個圖像中對其類別標簽進行分類。基于 YOLO 的模型已有四個版本,在我們最近的研究發表時,最新版本是 YOLO-V3,它被用于使用 DarkNet 主干框架檢測不同比例的物體。

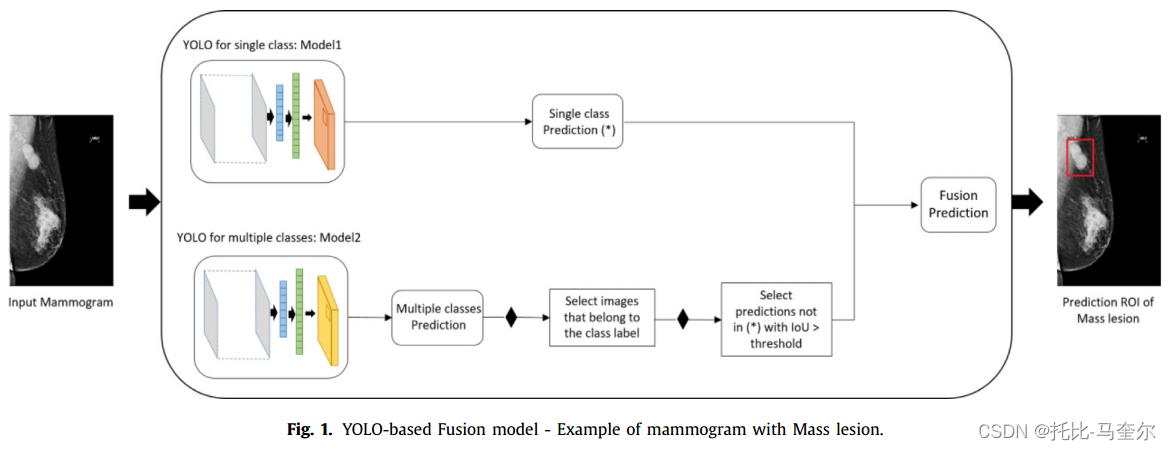

基本模型最初使用不同的配置(即目標類別標簽)進行訓練。 然后,通過在所有增強圖像(即原始圖像和旋轉圖像)中選擇具有最高置信度得分的最佳預測邊界框來評估每個實驗。事實證明,該技術可以精確檢測和分類每個乳房 X 光檢查中的乳腺病變。之后,如下圖所示,實施了基于 YOLO 的融合模型的理念,以改善最終預測結果。將不同的預測結合起來以降低最終錯誤率并結合不同配置的模型。在這項工作中,使用相同的符號,將模型 1 經過訓練并配置為一個類,即腫塊、鈣化或結構扭曲。因此,模型 2 配置為多個類訓練(即所有三個類一起)。最后,融合模型是指對模型1和模型2進行綜合評估,以提高整體的檢測性能。最終的模型選擇閾值為0.5。

所有模型都是在當前最新的乳房X光圖像上進行開發和測試的。這些圖像要么顯示了腫塊(Mass)、鈣化(Calcification)或結構扭曲(Architectural Distortion)等病變。與之前的工作不同,這次為當前最新的乳房X光圖像添加了一個類別標簽:“Normal”。這個標簽用于標記在后續篩查中未被診斷為異常發現的乳房X光圖像。

訓練一個基于YOLO(You Only Look Once,一種實時目標檢測算法)的模型來識別異常的乳房X光圖像。然后,將這個訓練好的模型應用到了標記為“Normal”的乳房X光圖像上。當將YOLO模型應用于 “Normal” 乳房X光圖像時,確保模型不會預測任何邊界框(bounding boxes)。意味著模型不會在這些看似正常的圖像上檢測到任何潛在的病變區域。由于模型在“Normal”乳房X光圖像上沒有預測到任何邊界框,因此他們將這些圖像分類為“Normal”。利用了YOLO模型的目標檢測能力來間接地進行分類。

3.2?圖像到圖像的轉換技術

能夠處理圖像以完成與圖像相關的復雜任務,例如圖像合成、圖像重建、圖像轉換等。由于生成對抗網絡 (GAN) 的發現,這些任務得到了顯著處理。

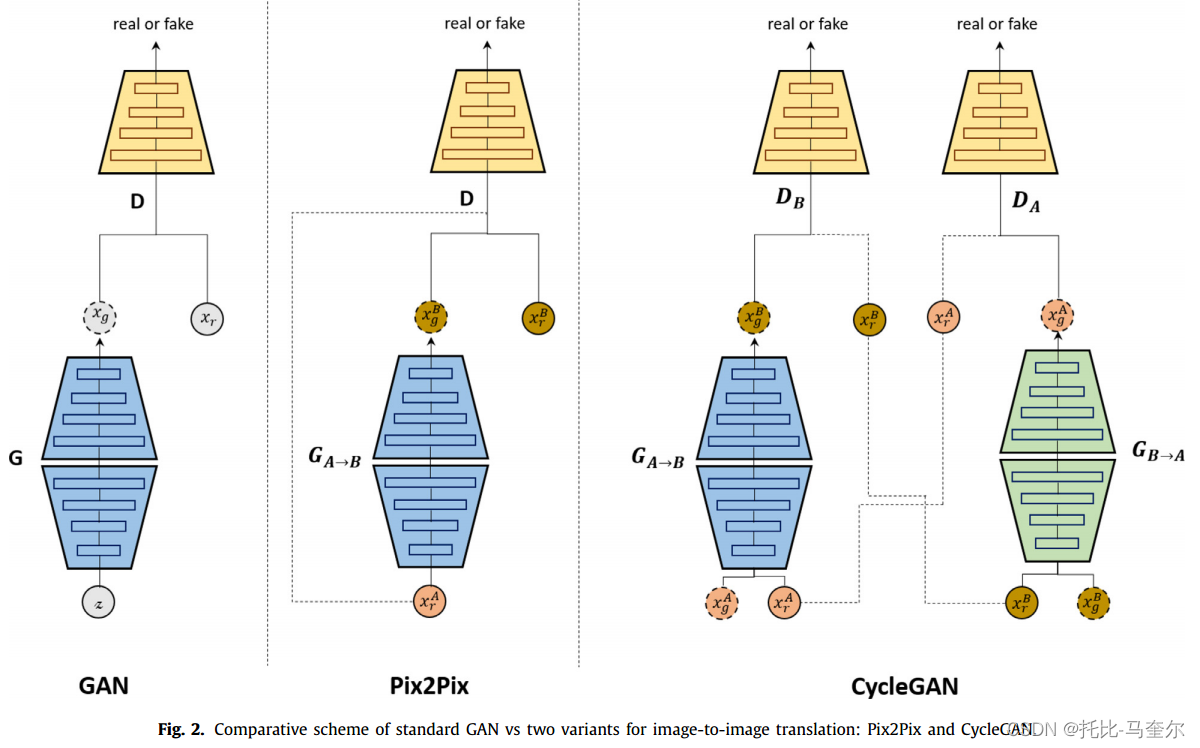

標準 GAN 包含兩個模型,一個生成器和一個鑒別器。這些模型相互競爭,以生成足夠逼真的虛假數據來欺騙鑒別器。該架構在醫學成像應用中取得了成功,并且引入了許多變體,例如條件 GAN (cGAN)、Wasserstein 生成對抗網絡 (WGAN) 等。

進一步的工作擴展了這個想法,創建了多個 GAN,可用于合成數據增強、領域自適應和風格轉換。 允許使用一對生成器來學習圖像的映射,使用一對鑒別器來學習兩種不同類型的圖像。這個想法強調了圖像到圖像的轉換,利用外部標記數據集有效地重建源域圖像,并附加目標域的附加特征,例如像素、顏色分布、形狀和紋理。

Pix2Pix 和 CycleGAN 是兩種常見的模型,它們被開發用于應用圖像到圖像的轉換技術。如下圖所示,與標準 GAN 類似,這兩個模型的目標是在兩個域之間轉換圖像,但不同之處在于 Pix2Pix 模型適用于配對數據集,但只接受來自源域 (A) 的一張圖像,使用來自目標域 (B) 的相應圖像來校正和更新訓練。不同的是,CycleGAN 模型適用于不成對的數據集,接受兩張圖像,并跨域執行循環轉換以返回新的合成圖像。

Pix2Pix 基于條件 GAN(cGAN)架構來學習圖像之間的映射,其中網絡由生成器 和鑒別器 D 組成。生成器具有編碼器-解碼器結構,嘗試遷移輸入圖像

? 的特殊特征以獲得輸出圖像

。鑒別器使用 PatchGAN 架構,它一次將輸入圖像與生成的圖像進行比較,另一次將輸入圖像與外部數據集

中的相應圖像進行比較,以更新生成器學習。

循環生成對抗網絡(稱為 CycleGAN [47])旨在學習圖像之間的映射,而無需相關性和一對一匹配。想法建立在 Pix2Pix 架構之上,但使用兩個生成器 和

進行循環圖像映射,并使用兩個鑒別器

和

來區分真實圖像和合成圖像。此外,CycleGAN 技術對生成器采用循環一致性,以確保將新圖像很好地重建回其原始外觀。

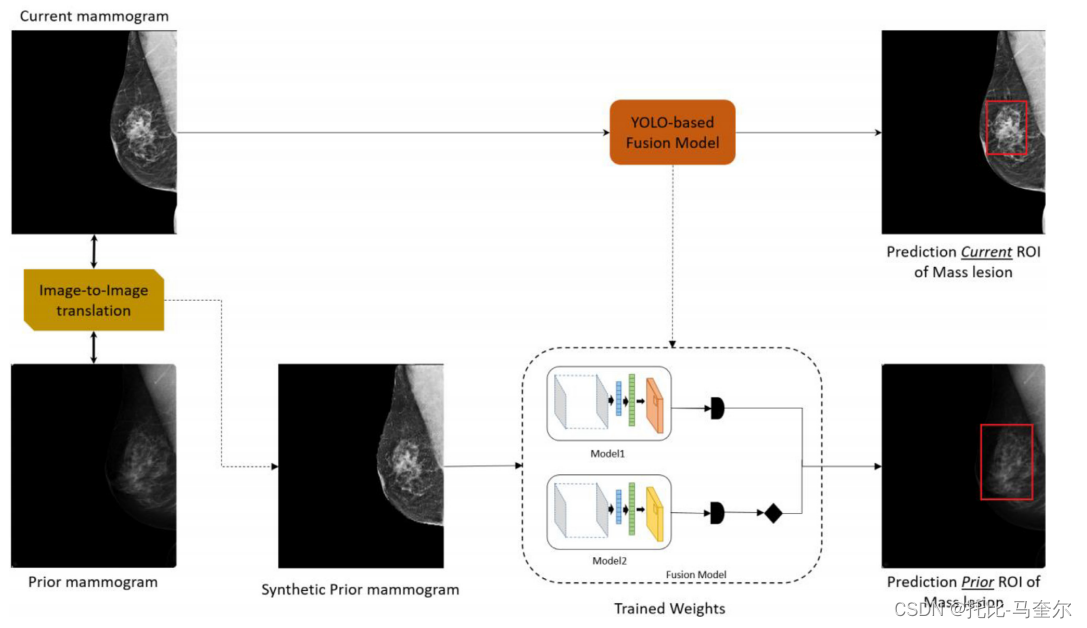

3.3 早期檢測和分類框架

首先在當前的乳房 X 光照片上應用并評估 YOLO 技術,以檢測不同的乳腺病變并將其分為腫塊、鈣化或結構扭曲,其余為正常。其次,考慮兩種圖像到圖像技術 Pix2Pix 和 CycleGAN,以學習當前乳房 X 光照片與其對應的先前乳房 X 光照片之間的映射。如下圖所示,生成新的合成先前乳房 X 光照片以克服由于時間和紋理變化導致的篩查之間的錯位。

接下來,使用第一步訓練的模型來預測平移后的先前乳房 X 光照片上乳房病變的位置和類型。預測先前乳房 X 光照片中“未來癌癥”可疑病變的邊界框具有挑戰性。因此,將所有診斷信息整合到一個框架中,該框架探索可能表明“未來癌癥”風險的隱形模式證據。推理模型直接應用于翻譯后的先前乳房 X 光照片,并使用 真實邊界框的位置 及其 對應的當前乳房 X 光照片的類標簽 進行評估。

4. 結果?

4.1 數據集?

在本研究中,我們使用了康涅狄格大學中心 (UCHC) 的一組私人數據集,名為 UCHC DigiMammo (UCHCDM) 數據庫。該數據集包含 230 名患者的篩查乳房 X 線照片,其中每個病例都有一次初步篩查,稱為先前檢查,以及 1 至 6 年之間的第二次隨訪篩查,稱為當前檢查。

數據集中的每次篩查都會獲取兩個不同的視圖,即 CC 和 MLO。所有圖像均以醫學數字成像和通信 (DICOM) 格式保存,由專業放射科醫生在描述文本文件中注釋,并附上乳房 X 線檢查發現的相應病理(即腫塊、鈣化、結構扭曲、正常)。總共考慮了 413 張乳房 X 線照片,分別用于當前檢查和先前檢查,它們的平均尺寸為 2950 × 3650 像素。

4.2 數據準備

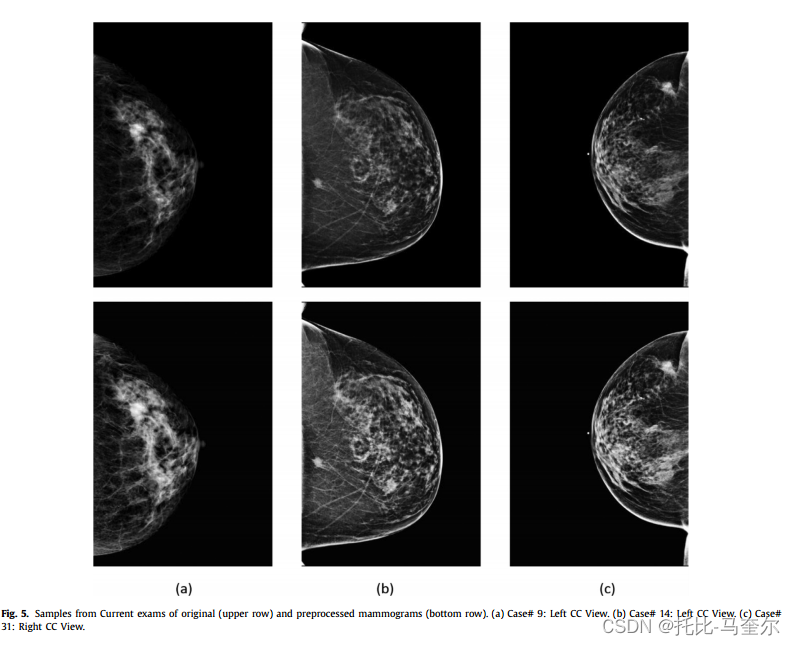

所有乳房 X 光檢查圖像均使用數字 X 射線乳房 X 光檢查工具收集,以 DICOM 格式壓縮和存儲圖像。因此,在訓練過程之前對所有原始圖像應用了一些預處理步驟,使用去噪和直方圖均衡方法以提高質量。由于原始 DICOM 圖像尺寸較大,所有乳房 X 光檢查圖像均使用 4×4 鄰域的雙三次插值進行下采樣。在實驗中,使用的圖像大小為 448×448 像素(即根據 YOLO-V3 的 DarkNet 主干架構可以被 32 整除)。最后,所有訓練圖像都被歸一化以使強度值在 [0, 1] 范圍內。原始圖像和預處理圖像的樣本如下圖所示。

具體來說,輸入圖像的寬度和高度都應該是32的整數倍。這是因為 DarkNet 在進行特征提取和降采樣時,會使用步長為32的卷積或池化操作,以確保特征圖的大小與網絡架構兼容。?

由于很難收集和標記醫學圖像,醫學數據集缺乏帶注釋的圖像。為了解決這個問題,主要提出了數據增強技術,通過旋轉或翻轉實例來增加數據集的大小。本文中,將原始圖像旋轉了四次,角度為。因此,為?UCHCDM 數據集生成了總共 1,652 張乳房 X 光照片來訓練和測試模型。每個類別的原始樣本如下圖所示。

4.3?評估指標和實驗設置

在研究中,使用對象檢測和分類指標來衡量基于 YOLO 的模型的性能。為了評估乳房病變在乳房 X 光檢查中的位置及其類型的檢測,首先測量每個檢測到的框與其對應的地面真相(即 (x, y, h, w) 坐標和類標簽)之間的交并比 (IoU) 分數,然后驗證它是否超過置信度分數閾值 0.35。

IoU 分數公式:

之后報告了一個最終的客觀指標,稱為檢測準確率,考慮了真實檢測框的預測類別概率。受 Samuelson 等人[49] 的工作啟發,計算病變類型(即腫塊、鈣化、結構扭曲)和正常圖像中真實檢測到的圖像數量與使用的乳房 X 線照片總數,如下面的公式中定義。?

?

僅考慮置信度概率分數等于或大于置信度分數閾值的預測框。整體測量了檢測準確率,并分別測量了每個類別標簽的檢測準確率,以評估基于 YOLO 的模型的性能。

使用 CycleGAN 和 Pix2Pix 模型進行的圖像到圖像技術實驗在非配對和配對數據集圖像上進行了相應的訓練。CycleGAN 架構模型有兩個生成器和兩個鑒別器網絡。 生成器網絡由兩個濾波器大小為 [128, 256] 的下采樣塊、九個濾波器大小為 256 的殘差塊和兩個濾波器大小為 [128, 64] 的上采樣塊組成。鑒別器網絡基于四個濾波器大小為 [64, 128, 256, 512] 的下采樣塊。

對于 Pix2Pix 模型,同樣使用了兩個生成器和兩個鑒別器網絡。生成器網絡包含 7 個下采樣和上采樣塊,濾波器大小為 [64、128、256、512、512、512、512]。使用了 CycleGAN 架構模型中的相同鑒別器網絡。因此,這兩個模型在 100 個時期內進行了訓練和評估,并使用 Adam 技術進行了優化,學習率為 0.0002,beta 分數為 0.5。

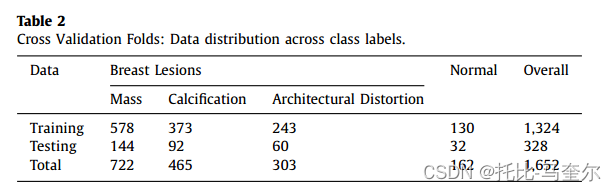

為了確保模型的穩健性,通過使用不同的隨機乳房 X 光檢查測試集對模型進行訓練和測試,進行了 5 倍交叉驗證。因此,整個數據集被隨機分成 5 份,每份為 1,324 張訓練圖像(80%)和 328 張測試圖像(20%),具體不平衡類別如表 2 所示。最后,我們報告了所有結果的平均值。

將學習率設置為 0.001,批次大小設置為 8,周期數設置為 100。損失函數結合了邊界框回歸損失、類標簽損失和置信度損失。 所有函數都基于交叉熵,并進行了縮放以處理每個批次上的類標簽不平衡。

在損失函數值恒定的情況下,在迭代的后半部分使用提前停止方法,每 10 個周期動態降低 10% 的學習率。為了防止過度擬合,所有模型都由大型公共數據集 Microsoft COCO 上的預訓練模型的權重初始化。然后,重新訓練模型,并在乳房 X 線攝影數據集上微調新的層。因此,我們只監控了損失函數的學習曲線,該損失函數在周期內迭代下降和優化。如下圖 7 所示,在學習過程中沒有觀察到過度擬合。

4.4?基于 YOLO 的模型對當前乳房 X 光檢查結果的評估

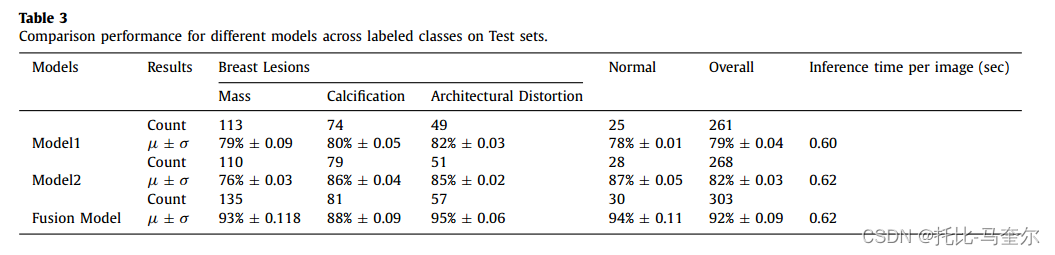

基于 YOLO 的模型在 UCHCDM 數據集的當前視圖上進行了不同的訓練。根據輸入數據集和目標類別改變模型。因此,模型 1 配置為單個類別,模型 2 配置為混合類別。最后,根據 [31] 中描述的方法,指定融合模型將模型 1 和模型 2 結合到每個目標類別中。表 3 顯示了使用 5 倍交叉驗證報告的檢測準確率和計數的定量比較,即 μ ± σ,其中 μ 和 σ 分別指平均值和標準差。

融合模型在結構扭曲病變方面的得分最高,為 95%,總體得分為 92%。此外,表 3 中的結果顯示了 YOLO 架構檢測和分類乳腺病變的能力,對于有腫塊病變的乳房 X 線照片,最大準確率為 93%,對于有鈣化病變的乳房 X 線照片,最大準確率為 88%,對于有結構扭曲病變的乳房 X 線照片,最大準確率為 95%。 恰當地說,正常乳房 X 線照片也被正確分類,最大準確率為 94%,沒有檢測到邊界框。所有實驗的推理時間都相似,每張圖像的最大值為 0.62 秒。

此外,為了更好地了解模型的性能,生成了自由響應接收者操作特性 (FROC) 曲線,以說明每個目標類別標簽的每幅圖像 (FPI) 的假陽性數量。下圖顯示了平均敏感度和平均假陽性數量之間的 FROC 圖,具體比較了模型 1、模型 2 和融合模型。

通過改變閾值和總體上在 0.05 和 0.20 之間的假陽性范圍,可以為所有病例實現 0.7 到 0.95 之間的平均敏感度。上圖清楚地表明,與其他評估模型相比,Fusion 模型具有最高的性能。觀察到,所提出的模型對于腫塊病變可以獲得超過 0.90 的平均敏感度,平均 FPI 為 0.20,對于鈣化病變可以獲得超過 0.85 的平均敏感度,平均 FPI 為 0.12,對于結構扭曲病變可以獲得超過 0.90 的平均敏感度,平均 FPI 為 0.175。因此,使用 FROC 分析評估當前視圖中的正常病例,并且當非癌性病例中不應出現檢測但模型遺漏時,則考慮假陽性。值得注意的是,可以獲得約 0.95 的平均敏感度,平均 FPI 為 0.20。

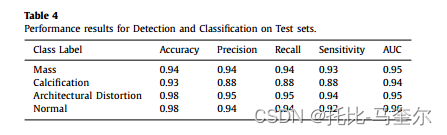

下表 探討了按每個類別標簽計算出的分類指標,其中我們對具有結構扭曲的癌癥病例實現了最高靈敏度 94.11%,對非癌癥病例實現了最高靈敏度 92.09%。

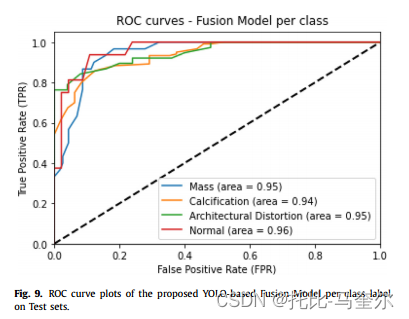

下圖直觀地比較了不同病例之間根據 ROC 曲線圖得出的假陽性率 (FPR) 和真陽性率 (TPR) 之間的權衡。 觀察到腫塊和結構扭曲病例的 AUC 得分最高,為 0.95,正常病例的 AUC 得分為 0.96。鈣化病變的低結果可以解釋為這種類型的乳腺病變沒有標準的形狀和位置,而且它們通常很小且隨機分布,這會限制自動檢測。

下圖說明了當前乳房 X 光片上應用的真實檢測到的邊界框分類的混淆矩陣,其中三種類型的病變與正常情況一起呈現(即沒有檢測到病變的正確預測)。顯然,不同類別的預測誤差較低,其中對應于正常類別標簽的預測誤差較高,為 6.2%,對應于鈣化情況的預測誤差較高,為 7.6%。類別內誤差的分布可以通過基于 YOLO 的模型無法檢測和區分具有相似形狀的某些不同類型的病變來解釋,例如鈣化和結構扭曲,它們通常在乳房內具有挑戰性的位置具有不規則的形狀。

4.5 基于 YOLO 的模型在乳房 X 光檢查結果上的評估

研究的第二部分集中在使用成對的乳房X光圖像上,包括當前圖像和先前的篩查圖像。其目標是對先前的篩查圖像中的病變進行早期檢測和分類。所有先前的乳房X光圖像都沒有經過診斷標注,因此被視為正常(即非癌癥)。這些圖像對應的標注是0。

回顧性方法:回顧先前的乳房X光圖像,試圖在等待后續篩查之前探索乳房病變的任何模式。

通過連接當前乳房X光圖像和經過專家標注的訓練模型之間的學習映射。首先,準備成對的數據集,并使用相同的配置。然后,訓練兩個圖像到圖像的轉換模型來確定圖像之間的映射。基于這種映射,生成與當前乳房X光圖像相似的先前篩查圖像的合成圖像,同時保留先前圖像的一般紋理。

使用先前在當前乳房X光圖像上訓練和驗證過的基于YOLO的模型進行推理,對先前的乳房X光圖像進行分類。

實驗評估:首先,使用原始先前的乳房X光圖像(未經圖像到圖像的轉換)進行性能評估,然后與使用 CycleGAN 和 Pix2Pix 技術轉換的先前圖像進行比較。通過5折交叉驗證報告先前乳房X光圖像的早期預測結果,結果以平均值和標準差的形式給出。當位置和類型的乳腺病變使用推理模型在t=0年的非癌癥篩查圖像上被正確捕獲時,認為這是一個真實的預測。

所有真實預測都呈現兩種情況:一種情況是當前乳房 X 光檢查和第一次檢查(即 t=0)的相應先前視圖的所有預測都正確,另一種情況是僅對先前乳房 X 光檢查進行正確預測,即使其相應的當前視圖未被正確預測。

錯誤預測率,即推理模型在先前視圖上錯過的病例數量。這可能是因為模型沒有在先前視圖上進行訓練,即被專家標注為t=0時的正常圖像。?

4.6?早期發現和分類的回顧性分析

具體來說,腫塊病變是事先預測到的,但后來被專家和放射科醫生在 2 到 3.5 年內發現。對比圖還表示使用圖像到圖像轉換技術與原始乳房 X 線照片的結果的最新隨訪檢查時間。 此外,下圖展示了基于 YOLO 的模型在不同類別和整體上有無圖像到圖像轉換的推理結果的比較。可以直觀地得出結論,與使用非配對圖像的 CycleGAN 模型相比,Pix2Pix 轉換方法總體上具有最佳性能,也可以通過 Pix2Pix 模型是在配對圖像之間訓練的事實來解釋。因此,考慮到在配對數據集之間呈現的圖像對齊優勢,Pix2Pix 模型對于圖像到圖像轉換這一特定任務比 CycleGAN 更有效。

可以通過不同類型乳腺病變在形狀、大小和質地方面的差異來解釋。眾所周知,鈣化不會出現在標準的形狀和位置,它們可以是雙側的、厚的、聚集的、多形性的和血管性的等等。由于它們的大小和位置不規則,使用圖像到圖像合成復制此類異常無助于在先前視圖中檢測和識別鈣化病變。鈣化通常很小且聚集在一起,需要平滑的像素分布,但是 X 射線圖像可能會降級,并且在早期狀態下很難識別乳房鈣化。 此外,比較了 1 至 6 年之間變化的 Prior 檢查時間內的早期檢測和分類結果。下圖使用最佳報告實驗(即使用 Pix2Pix 轉換)提供了對每個類別標簽正確預測的 Prior 乳房 X 線照片百分比的視覺觀察。 很明顯,1 年的隨訪檢查時間具有最高的預測圖像率。強調了我們的方法在早期定位和識別通常被認為最難診斷的病變方面的成功。另一個觀察結果是,我們的方法捕獲了 3 年以后才要求隨訪的腫塊病變,這可能對診斷患有腫塊性乳腺病變的患者來說為時已晚。

5. 討論和結論

提出使用 YOLO 架構模型來檢測和分類乳房 X 光檢查中的可疑病變。 根據最近的工作,展示了使用基于 YOLO 的融合模型來正確定位和識別三種不同類型的病變的優勢:腫塊、鈣化和結構扭曲。此外,進一步開發了所提出的框架,以整合所有使用的后續篩查中的先前乳房 X 光檢查,并對初始篩查的乳房 X 光檢查進行早期檢測和分類。這項工作強調了對先前診斷為正常但在后期報告有明顯異常發現和進展的乳房 X 光檢查進行回顧性預測的能力。 類似的方法解決了這個問題,并使用乳房 X 光檢查對來增強 CAD 系統對當前乳房 X 光檢查的結果,方法是包括區域配準的時間特征 [35],或在 SVM 分類器 [36] 或 CNN 模型 [37] 中添加配對之間的時間減法。然而,我們的研究只采用了一個模型,該模型在當前視圖上進行訓練和測試,然后在其對應的先前視圖上進行推斷。通過將保存的基于 YOLO 的融合模型以不同的方式直接應用于使用圖像到圖像轉換技術生成的原始和合成先前乳房 X 光片上,強調了提出的方法的性能。在乳房 X 光片對(先前、當前)之間訓練和驗證了兩種最先進的模型 CycleGAN 和 Pix2Pix,以創建新的轉換先前乳房 X 光片,從而克服由于時間和紋理變化導致兩次篩查之間的錯位。

)

【AI測試版】)

、search()、findall() 以及 捕獲組和 + 的含義)