????????聲明:文章是從本人公眾號中復制而來,因此,想最新最快了解各類智能優化算法及其改進的朋友,可關注我的公眾號:強盛機器學習,不定期會有很多免費代碼分享~?

目錄

數據介紹

效果展示

原理簡介

代碼目錄

代碼獲取

????????經常有小伙伴問我,面對如此多的預測程序,到底哪一個模型預測效果的最好?事實上,不存在一種預測效果最好的程序。

????????根據“沒有免費午餐定理”:不存在一種機器學習算法適合于任何領域或任務。如果有人宣稱自己的模型在所有問題上都好于其他模型,那么他肯定是在吹牛。

????????也就是說,模型預測效果同時取決于數據和模型的匹配程度,任何算法都有局限性,并不是模型越復雜效果越好(但是新穎的模型肯定更受審稿人喜愛一些)。沒有數據空談模型效果不現實,只有嘗試了才知道是否匹配。

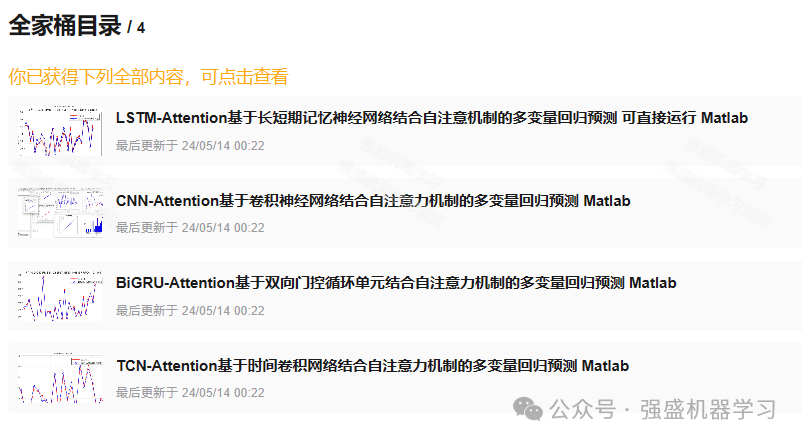

????????因此,為了解決大家的選擇困難癥,本期為大家推出了Attention模型全家桶!將CNN/TCN/LSTM/BiGRU-Attention四種多變量回歸模型打包到全家桶中,方便大家選擇最適合自己數據的模型!

????????當然,全家桶價格也是非常優惠的,相當于單買的5折優惠左右!同時,作者在這里承諾,一次購買永久更新!日后也會推出其他算法結合注意力機制的模型,如BiTCN-Attention等等,但如果你之后再買,一旦推出新模型,價格肯定是會上漲的!所以需要創新或對比的小伙伴請早下手早超生!!

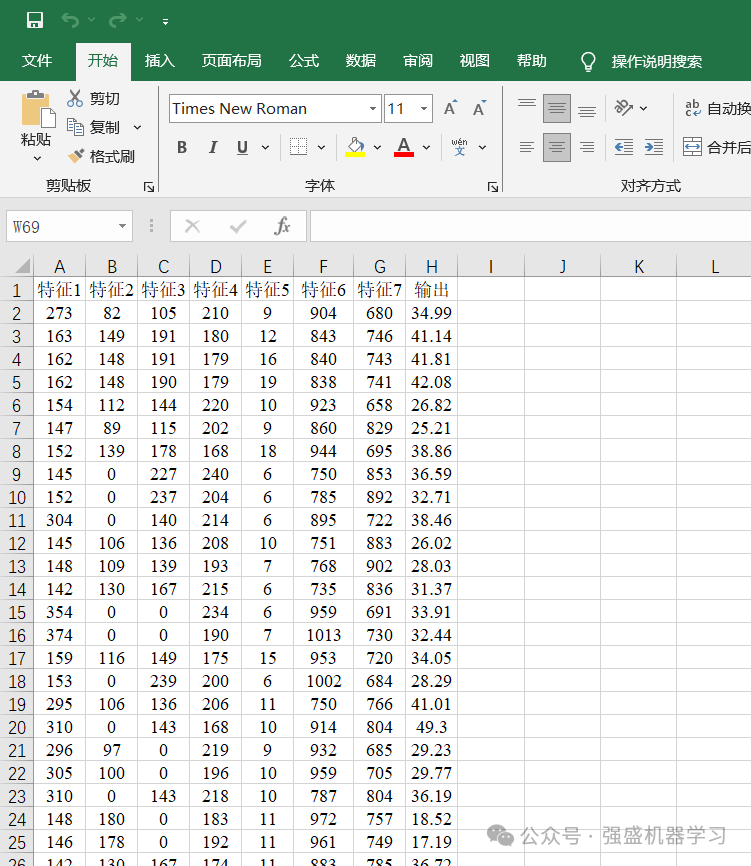

數據介紹

????????本期采用的數據是經典的回歸預測數據集,是為了方便大家替換自己的數據集,各個變量采用特征1、特征2…表示,無實際含義,最后一列即為輸出。

????????更換自己的數據時,只需最后一列放想要預測的列,其余列放特征即可,無需更改代碼,非常方便!

效果展示

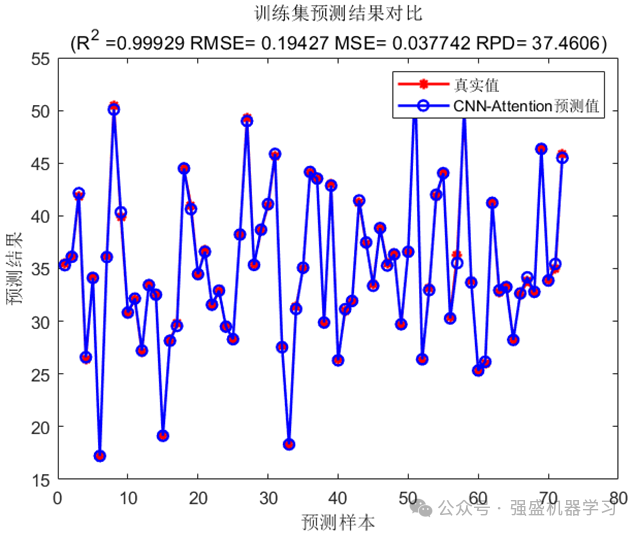

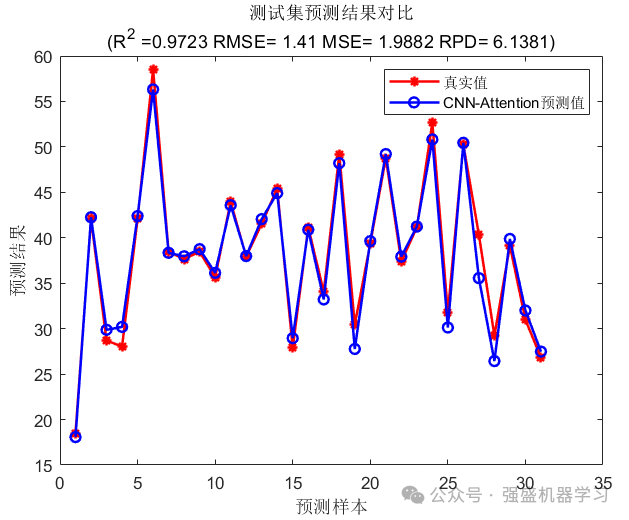

????????這里以CNN-Attention為例,展示一下模型運行結果(不同模型出圖數量與效果可能略有不同,具體可查看全家桶中每個模型的鏈接):

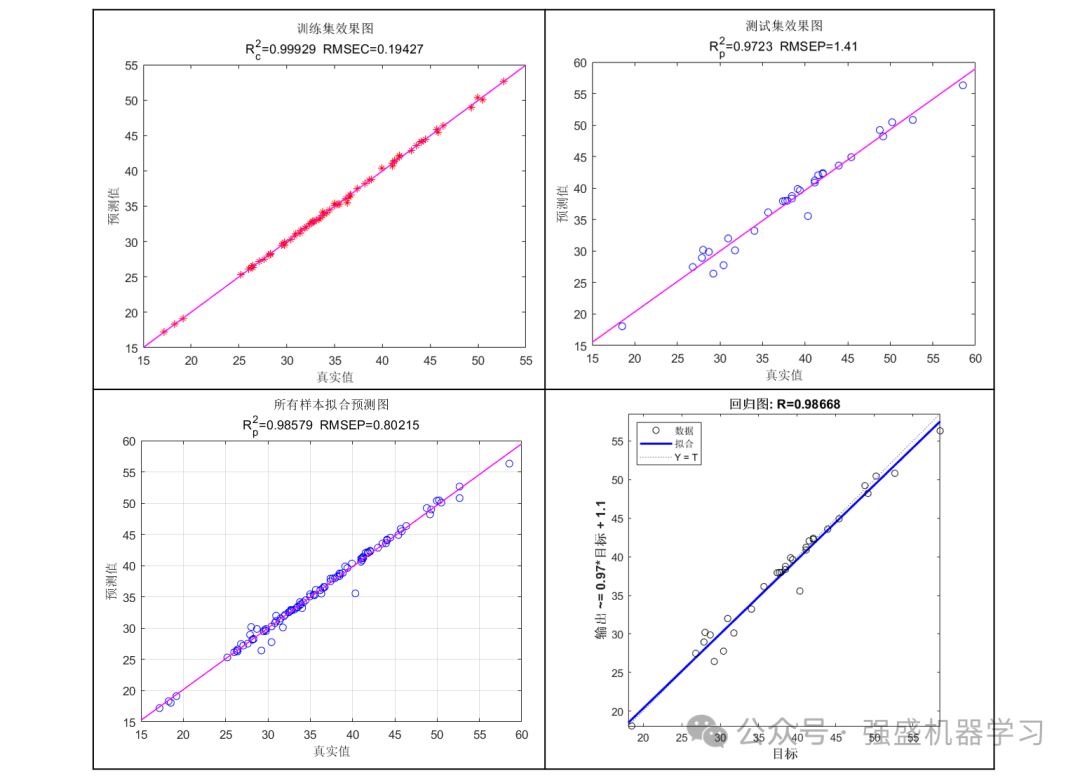

????????訓練集預測結果圖:

????????測試集預測結果圖:

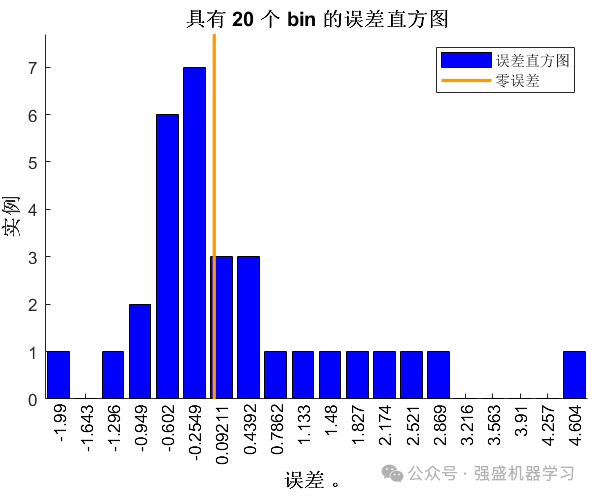

????????誤差直方圖:

????????線性擬合圖:

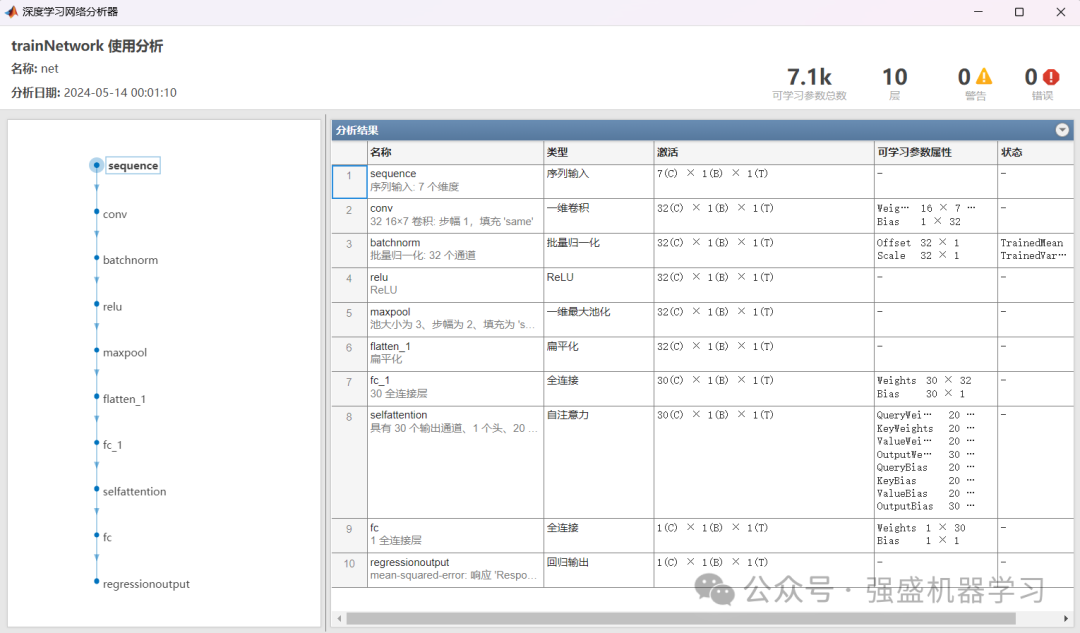

????????網絡結構圖:

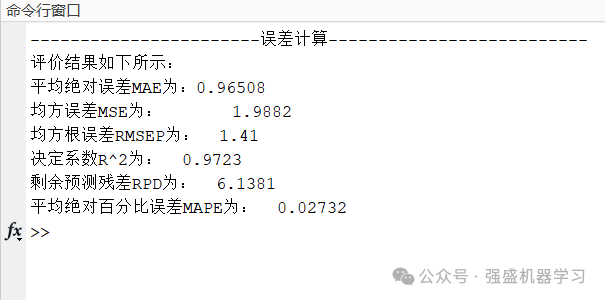

????????命令行窗口誤差顯示:

????????以上所有圖片,作者都已精心整理過代碼,都可以一鍵運行main直接出圖,不像其他代碼一樣需要每個文件運行很多次!

????????適用平臺:Matlab2023及以上,沒有的文件夾里已經免費提供安裝包,直接下載即可!

原理簡介

????????此處主要為大家講解下本期全家桶使用的自注意力機制:

????????注意力機制最早由Bahdanau提出,通過學習對圖像中不同區域的注意力權重,將視覺注意力引入到圖像描述生成模型中,從而提升了模型的質量和準確性。后來,注意力機制被廣泛應用于其他領域,它通過動態計算注意力權重來適應不同的輸入情況。這種機制使得模型能夠處理更長的輸入序列,可以更好地捕捉序列中的依賴關系。

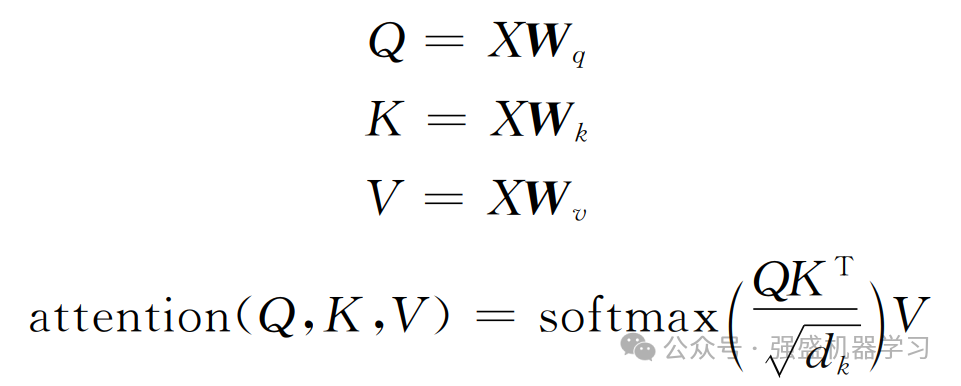

????????自注意力機制在傳統注意力機制的基礎上進行了進一步改良,通過并行計算,同時計算一句話中所有元素之間的相似性得分,從而獲取全局的信息而非單一上下文的信息,這使得自注意力機制能夠更全面地理解整個序列的語義,并更好地捕捉元素之間的復雜關系,其相關公式如下所示:

????????式中:Wq、Wk、Wv為線性變化矩陣;Q、K、V分別為查詢向量(query)、鍵向量(key)和值向量(value);dk為查詢向量和鍵向量的維度。最后,將注意力權重和值向量進行加權求和,得到自注意力機制的輸出。

????????多頭自注意力機制引入多個單注意力頭,每個注意力頭都是一個獨立的自注意力機制,學習到一組不同的權重和表示。在多頭自注意力機制中,輸入序列首先通過線性變換映射到多個不同的query、key、和value空間。每個注意力頭都會對這些映射后的查詢、鍵和值進行獨立的注意力計算,得到每個位置的表示。最后,將模型中每個注意力頭的表示通過線性變換和拼接操作來合并,就得到最終的輸出表示。

代碼目錄

????????以下所有代碼,無需更改代碼,直接替換Excel數據即可運行!可以說是非常方便,非常適合新手小白了!

????????日后也會推出其他算法結合注意力機制的模型,需要其他深度學習算法結合注意力模型的小伙伴也可以后臺私信我~不過一旦推出新模型,價格肯定是會上漲的!所以需要創新或對比的小伙伴請早下手早超生!

代碼獲取

????????1.Attention全家桶獲取方式(價格更劃算!)

????????①點擊下方小卡片,或后臺回復關鍵詞:注意力全家桶

????????2.CNN-Attention單品:

????????①點擊下方小卡片,后臺回復關鍵詞,不區分大小寫:CNNAttention

????????3.TCN-Attention單品:

????????①點擊下方小卡片,后臺回復關鍵詞,不區分大小寫:TCNAttention

????????4.BiGRU-Attention單品:

????????①點擊下方小卡片,后臺回復關鍵詞,不區分大小寫:BiGRUAttention

????????5.LSTM-Attention單品:

????????①點擊下方小卡片,后臺回復關鍵詞,不區分大小寫:LSTMAttention

)

![[數據集][圖像分類]雜草分類數據集17509張9類別](http://pic.xiahunao.cn/[數據集][圖像分類]雜草分類數據集17509張9類別)

——數據要素:管理核心框架)