實操筆記 | Windows 安裝 TensorRT 10.13.3.9(適配 CUDA 13.0,含跨版本 CUDA 調用維護示例)—— 系統 CUDA 13.0 與虛擬環境 CUDA 12.8 版本差異時,TensorRT 調用維護實例詳見附錄

本文針對?TensorRT-10.13.3.9.Windows.win10.cuda-13.0.zip,結合實際操作截圖,從“解壓-配置-驗證”全流程拆解步驟,解決官方文檔模糊問題,新手也能按圖完成安裝。

一、前期準備:確認依賴與文件

CUDA & cuDNN 安裝

好消息,最新CUDA和cuDNN安裝,倆都可以用exe安裝包直裝了 CUDA12.6.3和cuDNN9.6.0 Windows系統 省事

是否需要預先安裝 CUDA Toolkit?——按使用場景分級推薦及進階說明

CUDA 與 cuDNN 免登錄下載政策詳解(基于官方權威信息)

NVIDIA CUDA 13.0 發布:新特性與快捷更新安裝全解析

CUDA 13.0 適配的 cuDNN 9.11 發布:網頁內容速覽

CUDA 深度神經網絡 (cuDNN) |NVIDIA 開發人員

安裝 CUDA 13 后 ONNX Runtime 報錯“Failed to create CUDAExecutionProvider” 的完整修復方案——附 CMD & PowerShell 一

1. 必裝依賴(版本必須匹配)

| 依賴項 | 版本要求 | 作用說明 |

|---|---|---|

| NVIDIA 顯卡驅動 | 支持 CUDA 13.0 | 確保 GPU 能正常調用 CUDA 核心 |

| CUDA Toolkit | 13.0(含 Update 1) | TensorRT 運行的底層計算框架 |

| cuDNN | 8.9.7(適配 CUDA 13.0) | 加速深度學習任務的 GPU 優化庫 |

| Python(可選) | 3.8~3.13(推薦 3.10+) | 用于調用 TensorRT Python 接口 |

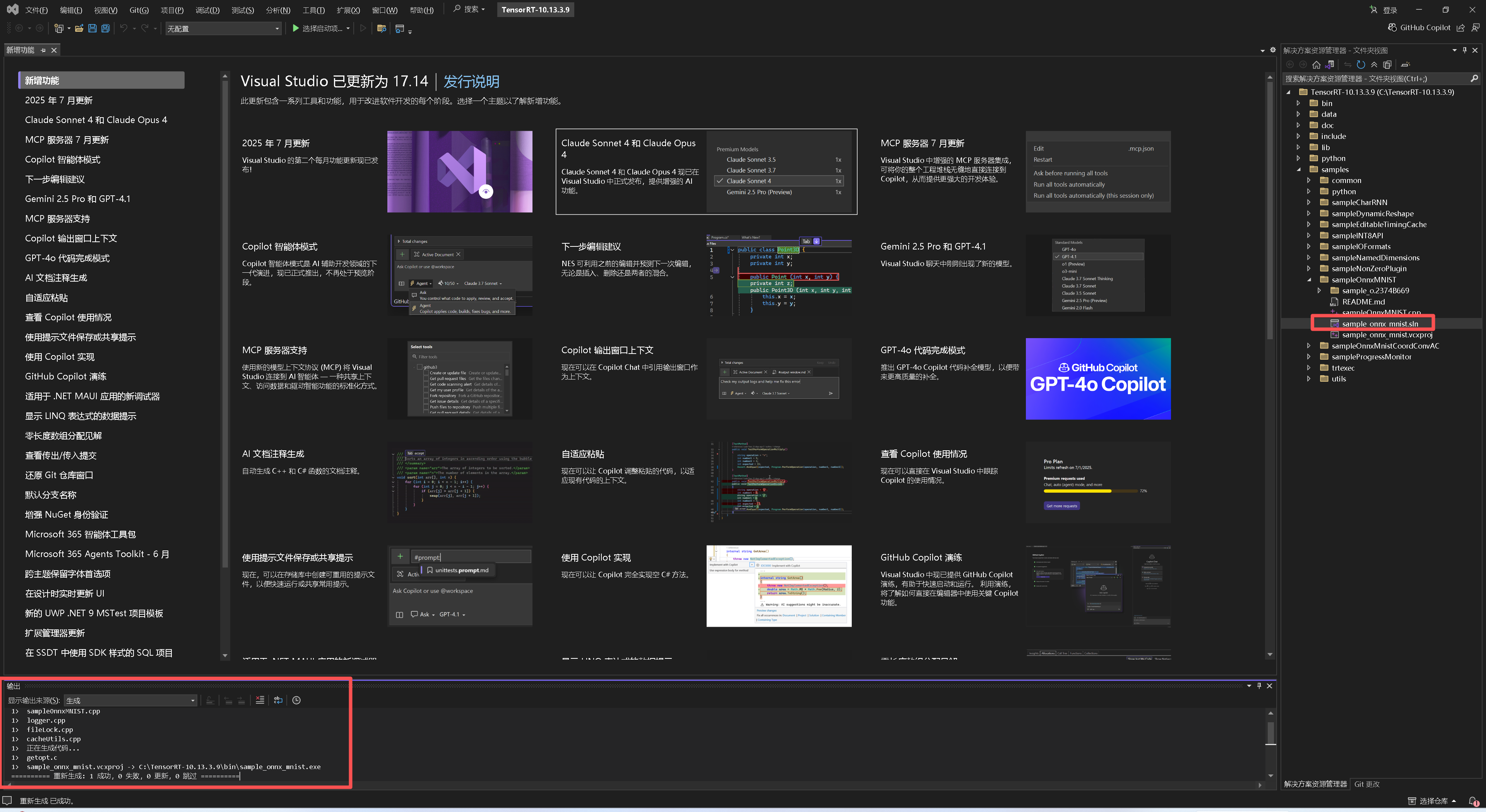

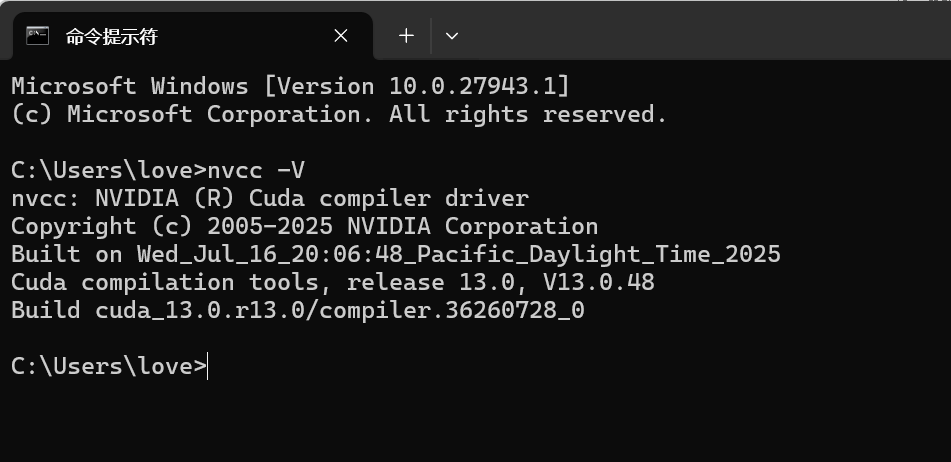

驗證 CUDA 是否安裝成功:打開?命令提示符(CMD),輸入?

nvcc -V,若顯示 CUDA 13.0 版本信息,說明依賴正常(如圖1)。

圖1:CUDA 版本驗證

2. 下載 TensorRT 壓縮包

TensorRT 官方網站

TensorRT SDK |NVIDIA 開發人員

安裝 TensorRT — NVIDIA TensorRT 文檔

windows安裝tensorrt- 知乎

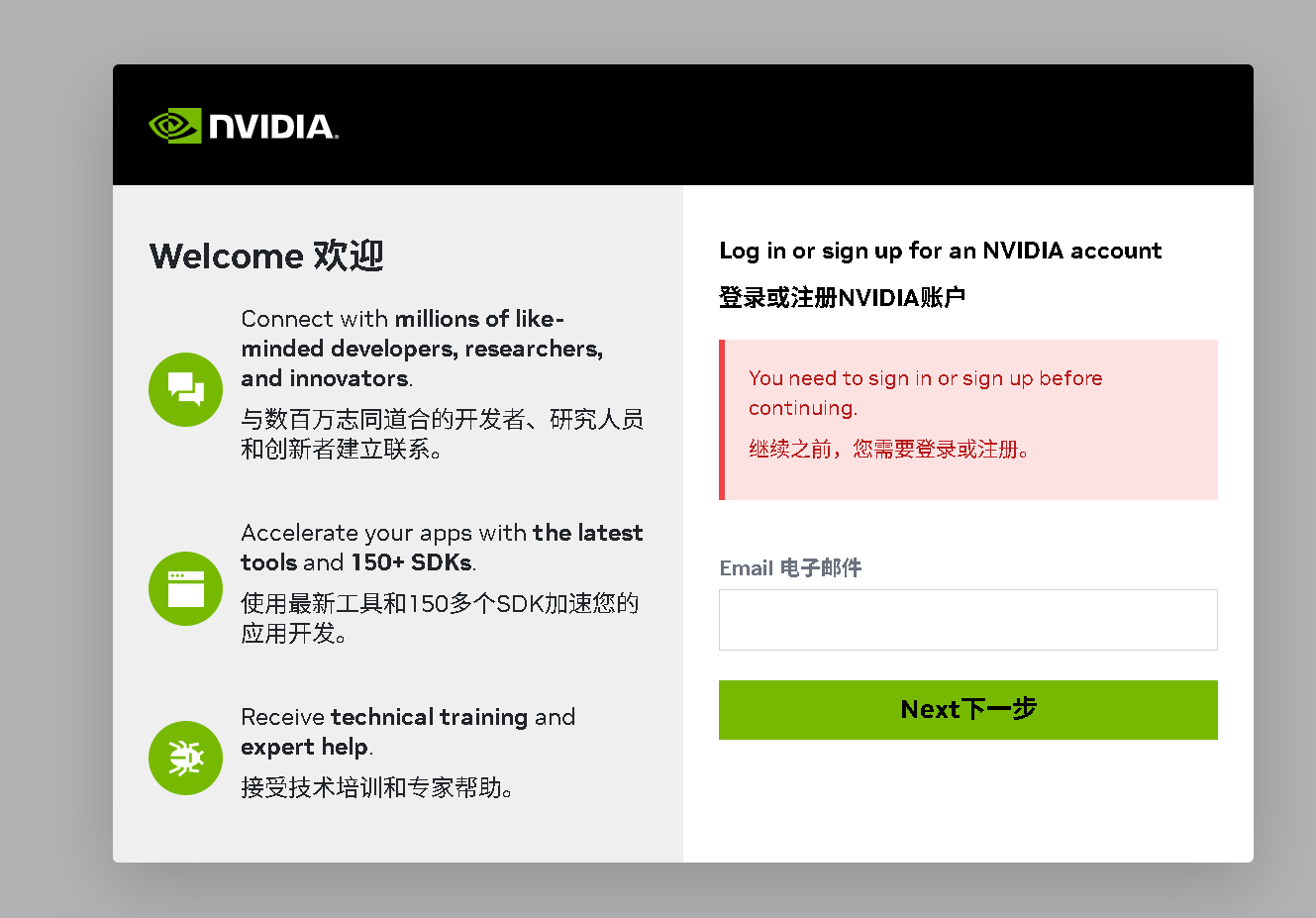

從 NVIDIA 官網下載?TensorRT-10.13.3.9.Windows.win10.cuda-13.0.zip(需登錄 NVIDIA 賬戶,如圖2),保存到電腦下載目錄(如?E:\Downloads\Compressed)。

圖2:TensorRT 下載頁面(登錄后才能選擇對應版本)

圖3:TensorRT 登錄頁面

圖4:TensorRT 登錄驗證界面(郵件鏈接驗證)

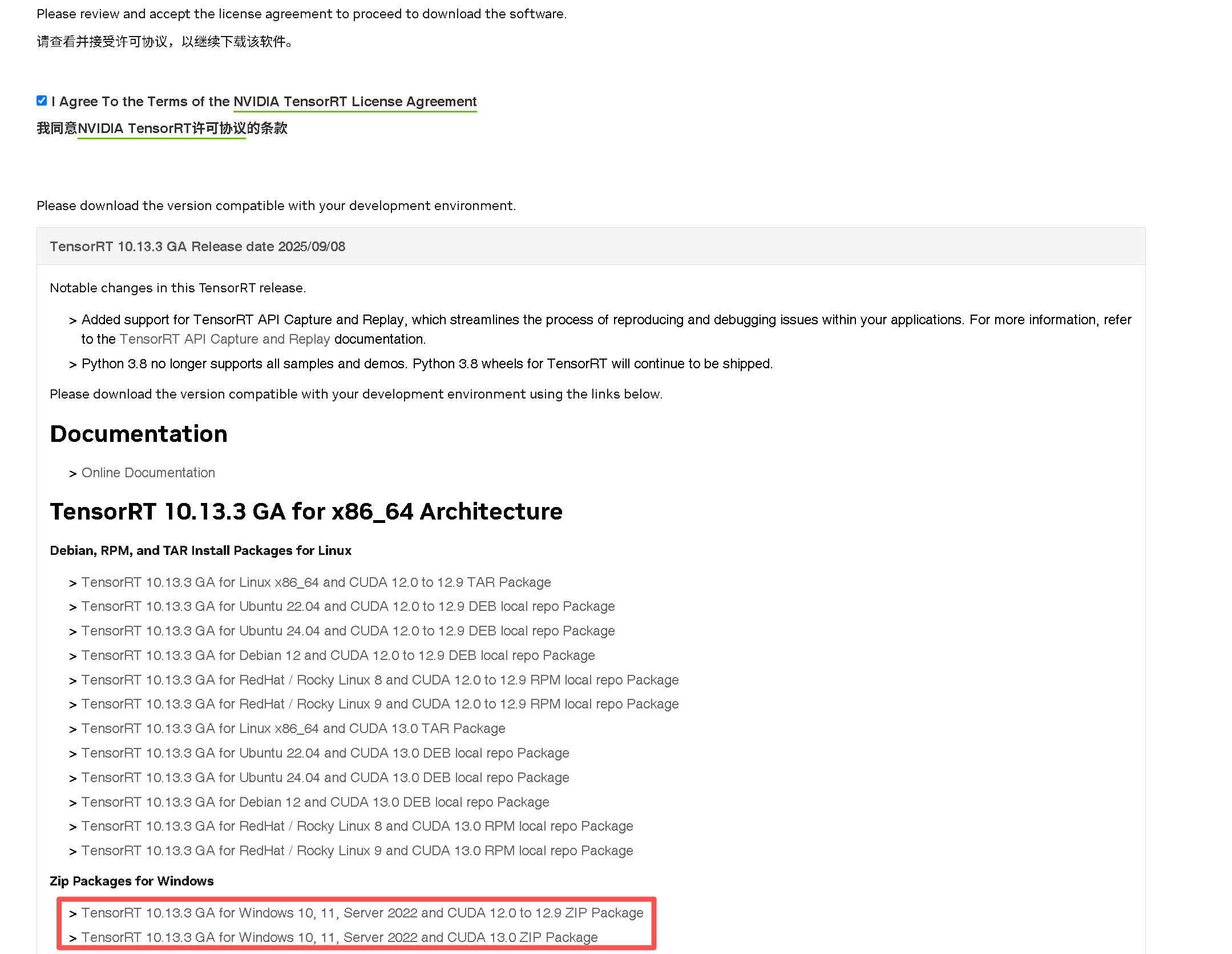

圖5:TensorRT 可用版本頁面(選中版本后跳轉后續界面)

圖6:TensorRT 下載前勾選許可協議界面(需勾選頁面中的小框)

圖7:TensorRT 下載 系統適配版本列表界面(找到 Zip Packages for Windows)

下載對應 CUDA 的版本

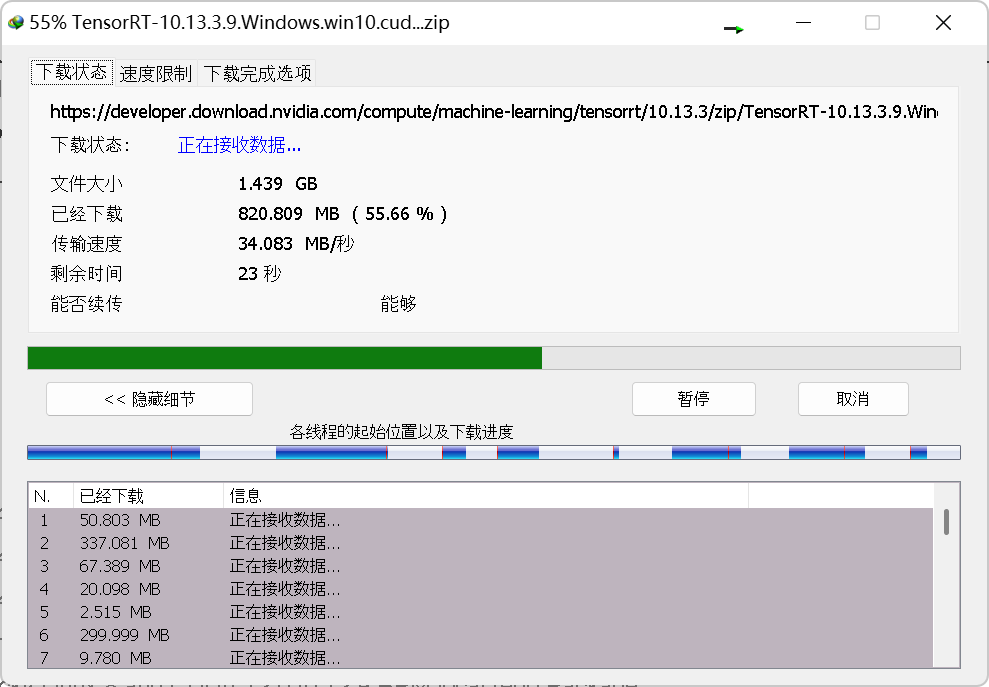

圖8:TensorRT-10.13.3.9.Windows.win10.cuda-13.0.zip 壓縮包下載中

下載的是 CUDA13.0 版的

二、第一步:解壓并移動到目標目錄

1. 解壓壓縮包

右鍵點擊下載的?TensorRT-10.13.3.9.Windows.win10.cuda-13.0.zip,選擇“全部解壓縮”,解壓路徑默認與壓縮包同目錄(如?E:\Downloads\Compressed)。

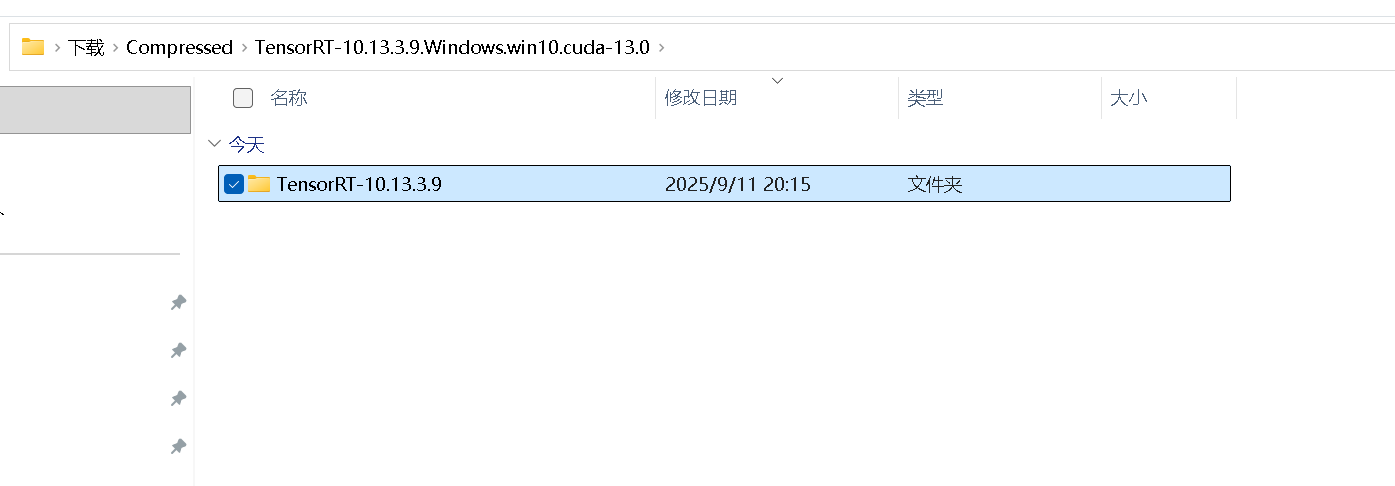

解壓后會出現?嵌套目錄:E:\Downloads\Compressed\TensorRT-10.13.3.9.Windows.win10.cuda-13.0\TensorRT-10.13.3.9(如圖3),核心文件(lib/include/python)都在最內層的?TensorRT-10.13.3.9?中。

圖9:解壓后的嵌套目錄結構

圖9:TensorRT-10.13.3.9.Windows.win10.cuda-13.0.zip?壓縮包解壓后的嵌套目錄結構

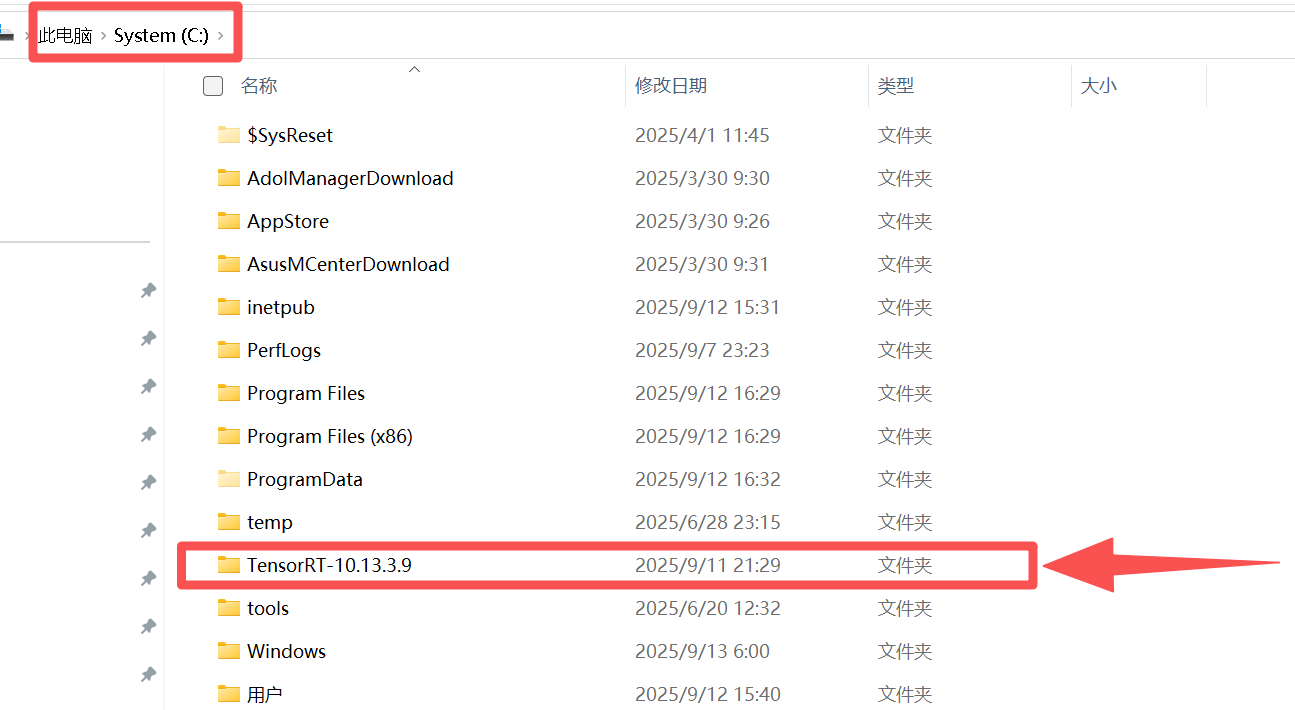

2. 手動移動到目標目錄

主要考慮到配置環境變量以及后期調用,為避免后續配置路徑過長,將最內層的?TensorRT-10.13.3.9?文件夾移動到?根目錄或簡單路徑(如 C:\TensorRT-10.13.3.9,如圖10)。

注意:目標路徑不要含中文/空格(如“ C 盤 或 D 盤”),否則后續可能出現“文件找不到”錯誤。

圖10:移動后的目標目錄(路徑簡潔)

圖11:TensorRT-10.13.3.9 文件夾解壓后的大小(約 1.7 GB)

查看占用空間大小以規劃目標空間

三、第二步:配置系統環境變量

環境變量的作用是讓 Windows 系統找到 TensorRT 的庫文件(.dll),必須配置正確,否則后續調用會報錯。

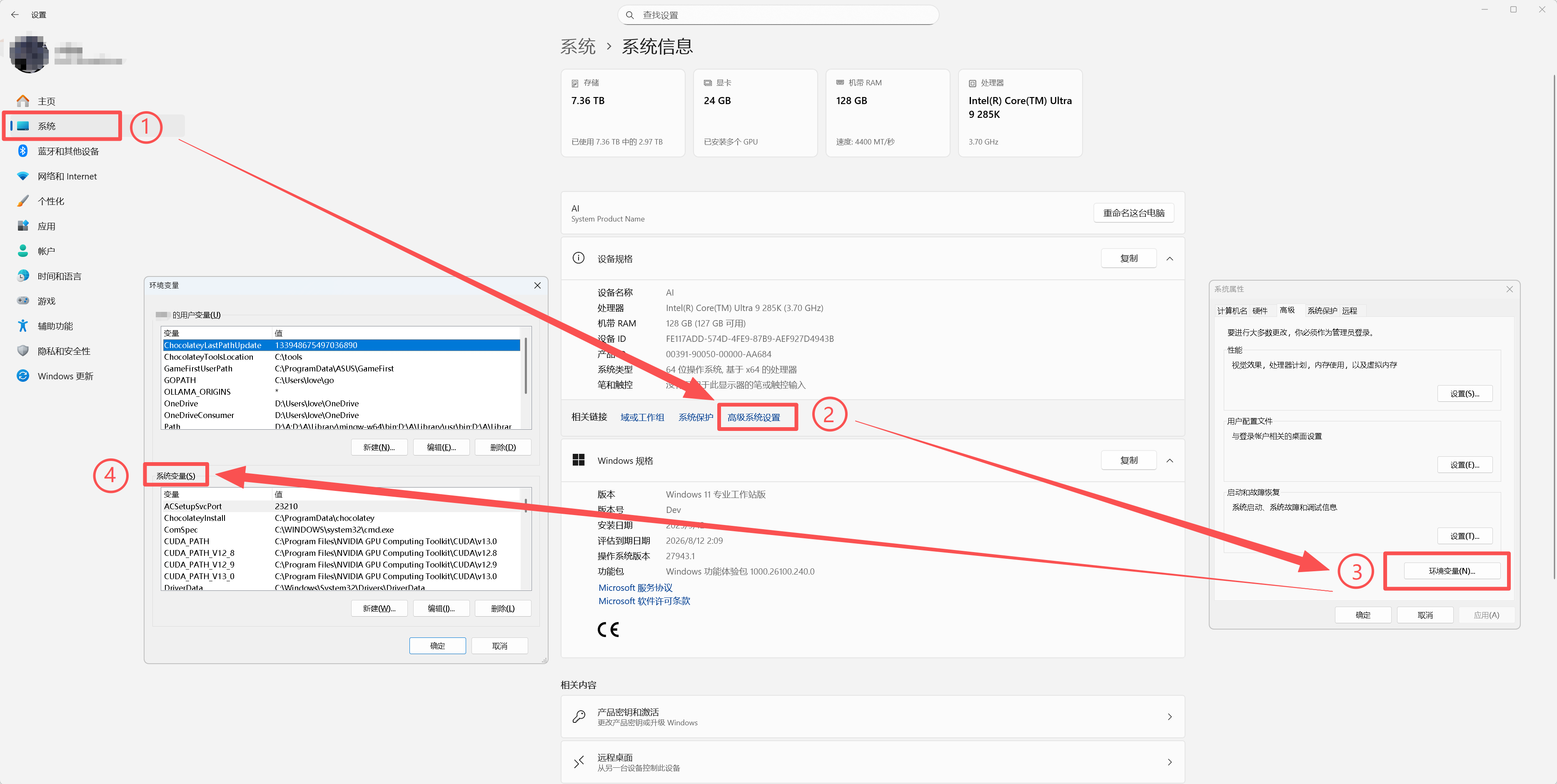

1. 打開環境變量設置

- 右鍵點擊“此電腦”→ 選擇“屬性”→ 點擊“高級系統設置”(如圖12)→ 在彈出窗口中點擊“環境變量”。

- 所需的變量除了按本筆記記述的條目外,可按實際項目需求,按需添加目錄進環境變量中。

圖12:進入“高級系統設置”

?

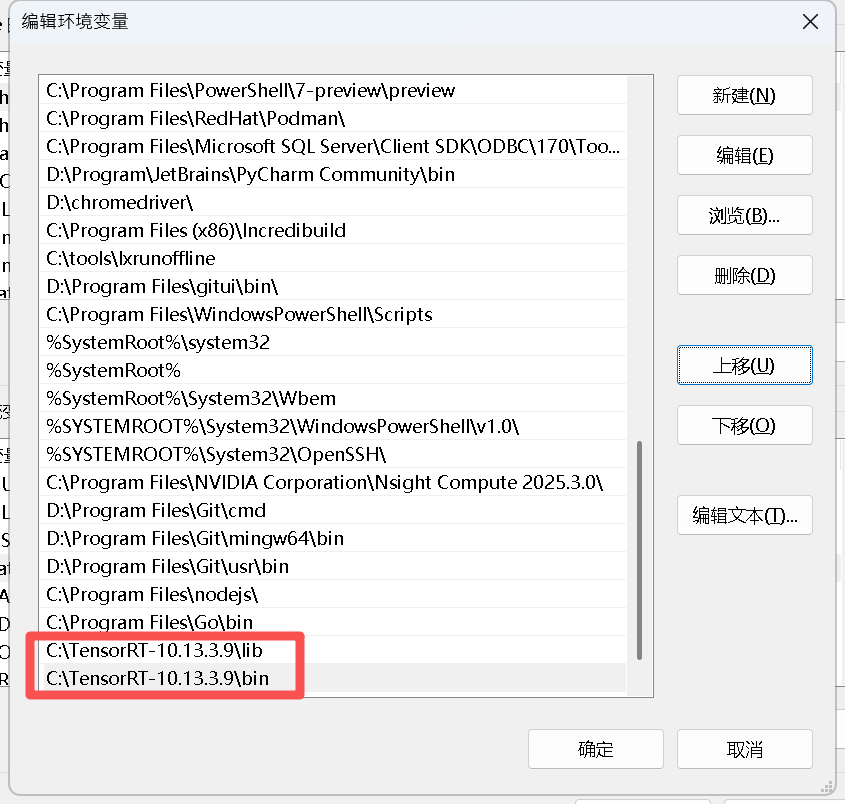

2. 添加 TensorRT 路徑到 PATH

C

:\TensorRT-10.13.3.9\lib

C:\TensorRT-10.13.3.9\bin

#? 其他的路徑后續可按開發需要靈活添加

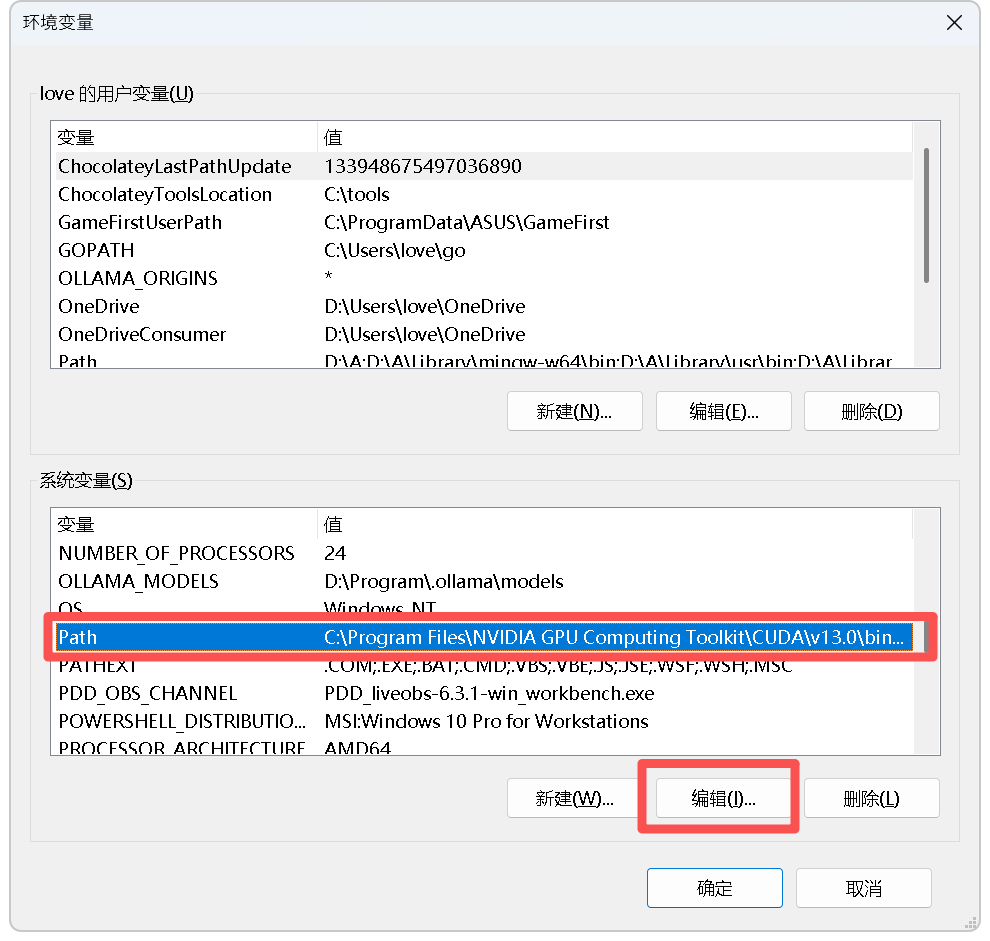

- 在“系統變量”中找到?

Path,雙擊打開編輯窗口(如圖13)→ 點擊“新建”→ 粘貼 TensorRT 的?lib?目錄路徑(如 C:\TensorRT-10.13.3.9\lib)等→ 點擊“確定”保存(所有窗口都要點“確定”,否則配置不生效)。

圖13:編輯 PATH 環境變量

圖14:新建變量值

圖15:添加?

TensorRT-10.13.3.9 相關路徑

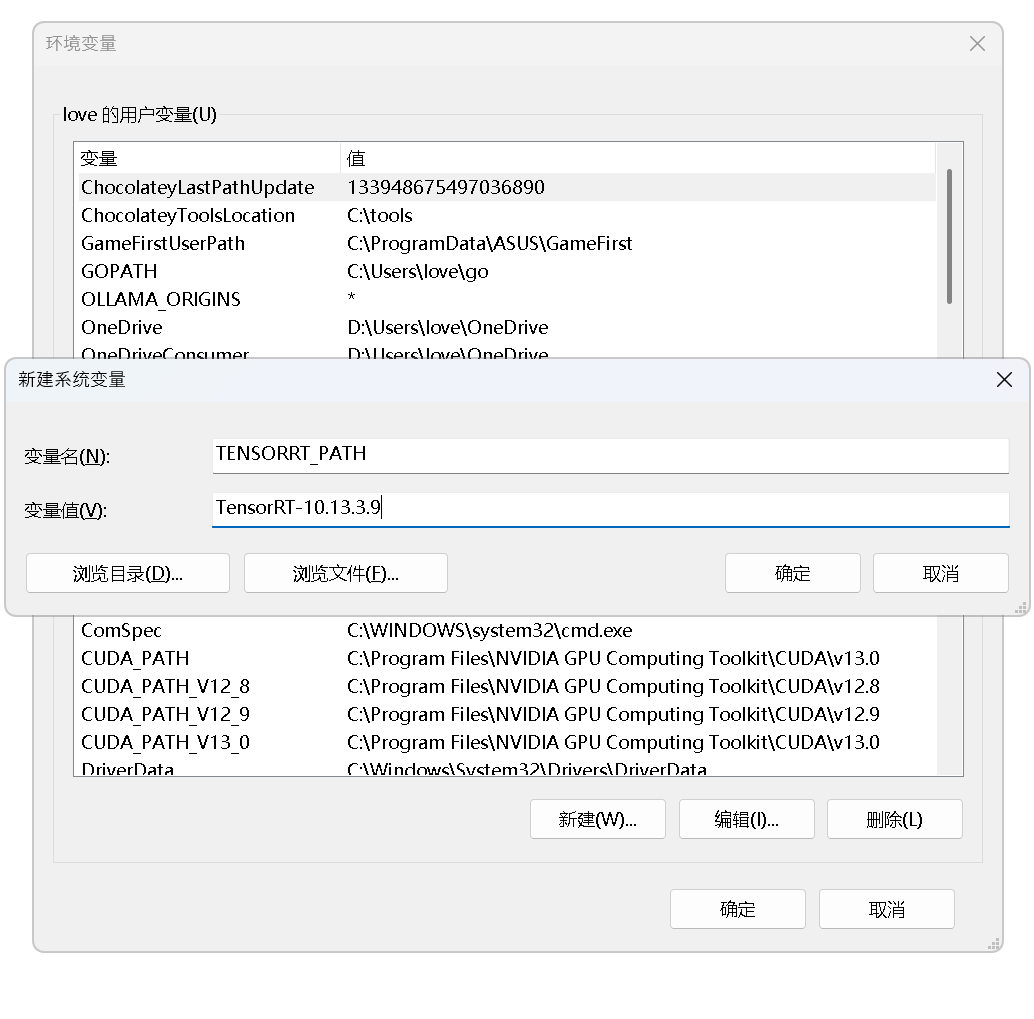

3. (可選)創建 TENSORRT_PATH 變量

為后續開發方便(如 Visual Studio 配置),可新增一個系統變量:

- 在“系統變量”中點擊“新建”→ 變量名填?

TENSORRT_PATH,變量值填 TensorRT 根目錄(如 C:\TensorRT-10.13.3.9,如圖16)→ 點擊“確定”。

圖16:創建 TENSORRT_PATH 變量

四、第三步:安裝 Python 接口(可選,常用場景)

若需用 Python 調用 TensorRT(如 PyTorch/TensorFlow 模型推理),需安裝對應版本的 wheel 包。

1. 確認 Python 版本

打開 CMD,輸入?python --version,查看當前 Python 版本(如?Python 3.12.11,如圖17),后續需選擇對應?cp310?后綴的 wheel 文件。

圖17:查看 Python 版本

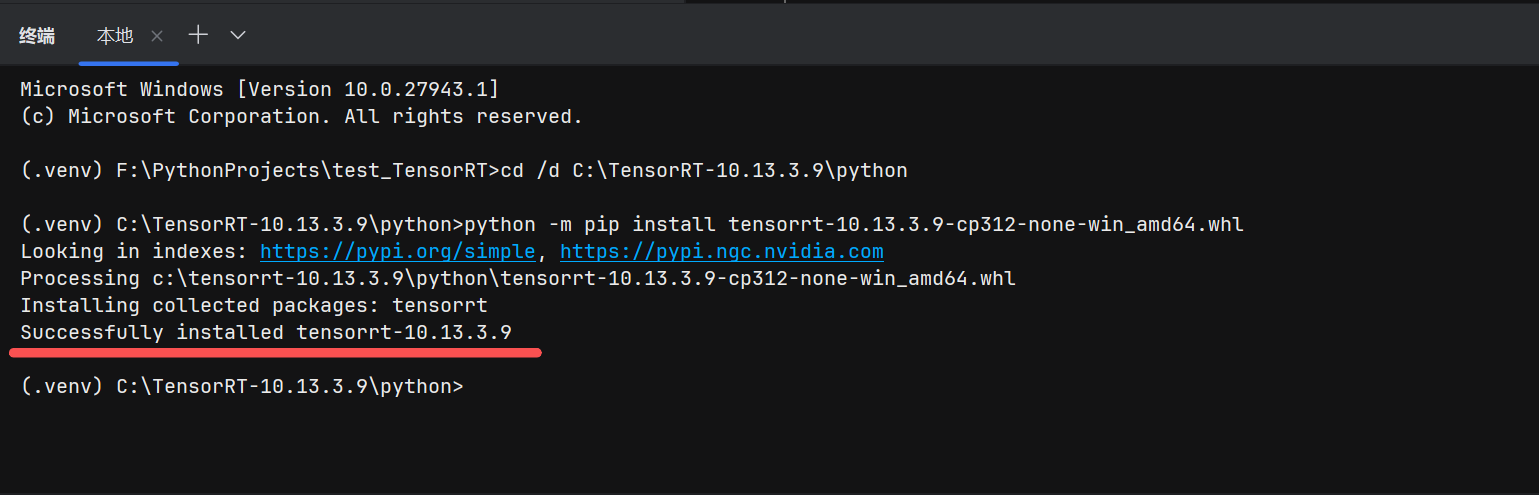

2. 進入 TensorRT 的 python 目錄

在需要配置 TensorRT 的虛擬環境中,激活環境終端(以?CMD 為例)后 ,通過?cd?命令切換到 TensorRT 的?python?文件夾(如?C:\TensorRT-10.13.3.9\python),輸入命令:

cd /d C:\TensorRT-10.13.3.9\python

或者復制 .whl 文件到項目文件夾內,從本地進行安裝。

注:“

/d”參數?用于跨盤切換路徑(如從 C 盤切換到 E 盤),若路徑在同盤可省略。也可以把?

C:\TensorRT-10.13.3.9\python 文件夾備份在其他位置以節省 C 盤空間

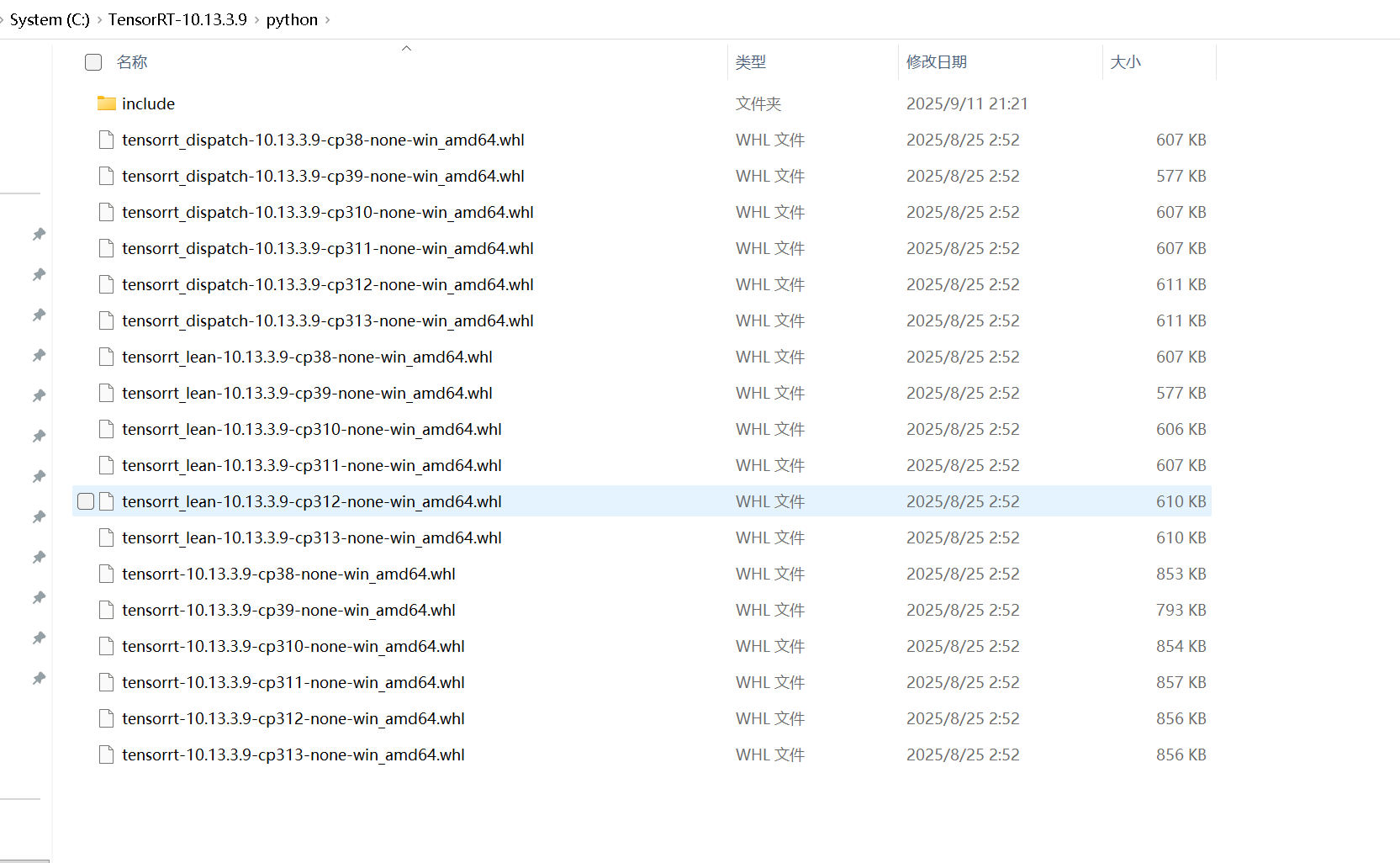

圖18:確認安裝文件(3個版本可選,具體選擇建議請繼續往下看)

3. 安裝 wheel 包

根據 Python 版本選擇對應的 wheel 文件(如 Python 3.10 對應?tensorrt-10.13.3.9-cp310-none-win_amd64.whl),輸入安裝命令:

python -m pip install tensorrt-10.13.3.9-cp312-none-win_amd64.whl若需安裝精簡版(lean)?或調度版(dispatch),替換命令為:

# 精簡版(僅核心推理功能,體積小)

python -m pip install tensorrt_lean-10.13.3.9-cp312-none-win_amd64.whl# 調度版(支持動態調度,適合多環境)

python -m pip install tensorrt_dispatch-10.13.3.9-cp312-none-win_amd64.whl

安裝成功后會顯示“Successfully installed…”(如圖19)。

圖19:Python 接口安裝成功

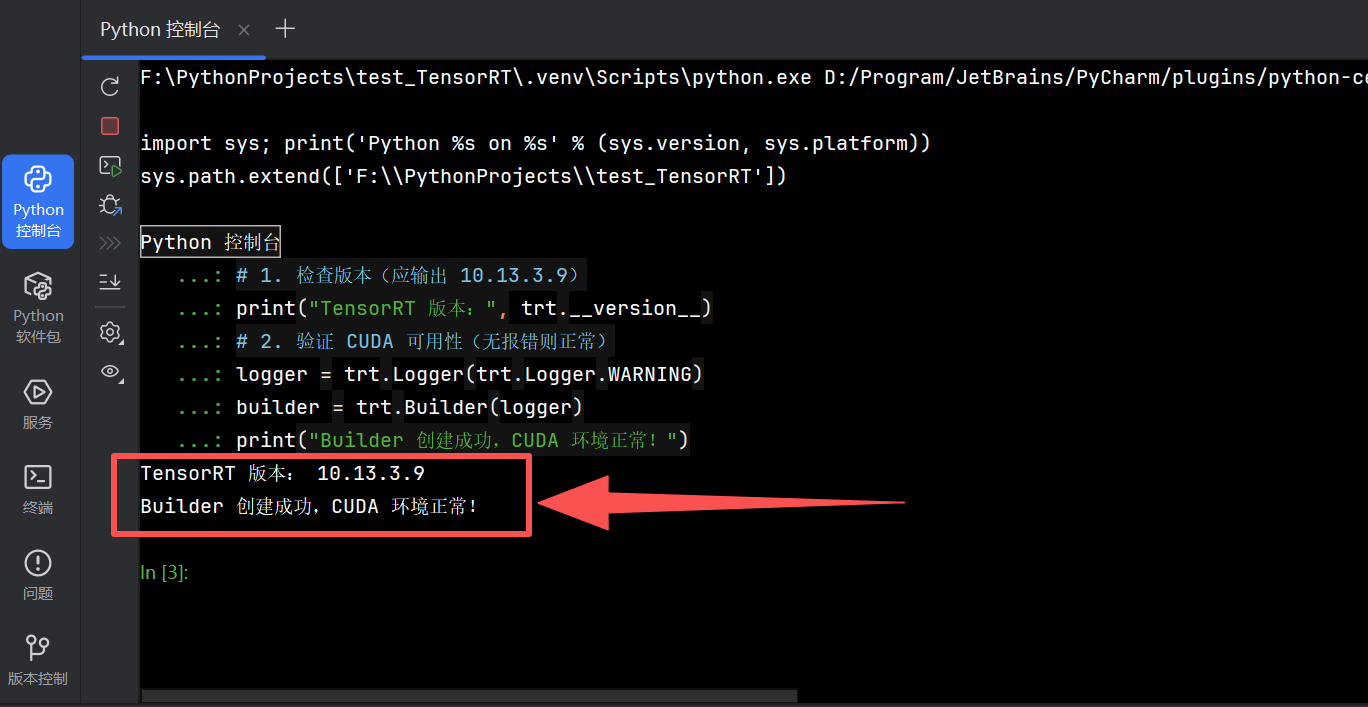

五、第四步:驗證安裝(關鍵步驟,確保可用)

1. 驗證 Python 接口

打開 CMD,輸入?python?進入 Python 交互環境,執行以下代碼:

import tensorrt as trt

# 1. 檢查版本(應輸出 10.13.3.9)

print("TensorRT 版本:", trt.__version__)

# 2. 驗證 CUDA 可用性(無報錯則正常)

logger = trt.Logger(trt.Logger.WARNING)

builder = trt.Builder(logger)

print("Builder 創建成功,CUDA 環境正常!")

若輸出如圖20所示,說明 Python 接口安裝成功。

圖20:Python 接口驗證成功

2. 驗證 C++ 庫(含 trtexec 工具)

trtexec?是 TensorRT 自帶的命令行工具,可快速驗證 C++ 庫是否生效,同時支持模型引擎構建、性能測試等功能。結合你的實際執行結果,需重點澄清 “FAILED?提示的本質”—— 它并非安裝失敗,而是工具在無模型時的默認反饋,以下補充最基礎的?--version?驗證命令,并梳理完整驗證流程:

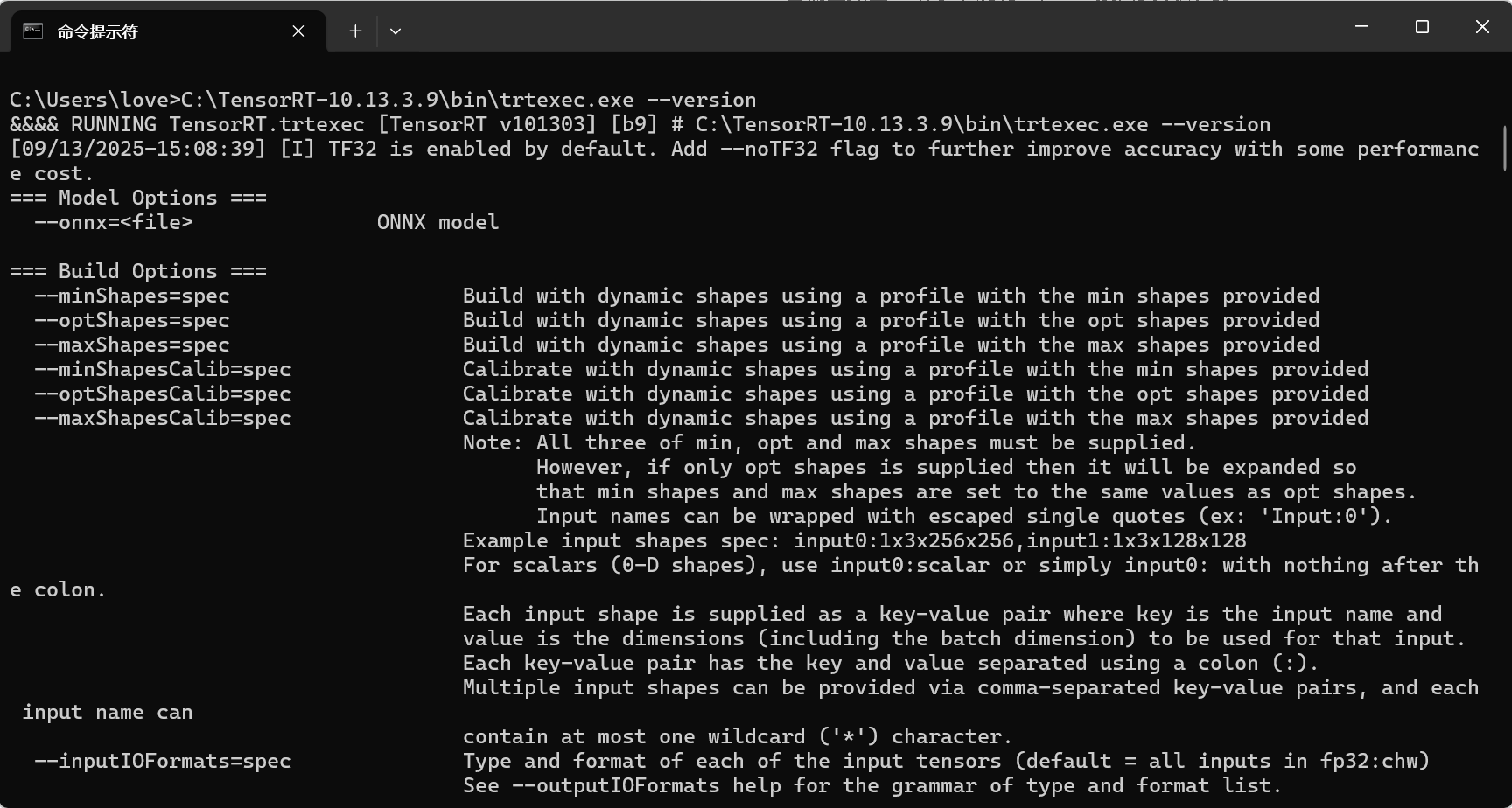

(1)最基礎驗證:用?--version?確認版本讀取正常

這是最簡單的驗證命令,直接檢查?trtexec?是否能識別 TensorRT 版本:

-

執行命令:在激活虛擬環境的 CMD 中,輸入?

trtexec.exe?的完整路徑(示例的安裝目錄為?C:\TensorRT-10.13.3.9):驗證命令之一

C:\TensorRT-10.13.3.9\bin\trtexec.exe --version -

預期輸出與解讀:

- 成功標志:開頭必然顯示?

&&&& RUNNING TensorRT.trtexec [TensorRT v101303] [b9],其中?v101303?對應你安裝的 TensorRT 10.13.3.9 版本,說明?trtexec?已成功加載 TensorRT 核心庫,能正常讀取版本信息; - 無需關注的 “FAILED”:末尾會出現?

[E] Model missing or format not recognized?和?&&&& FAILED,這是工具的固有邏輯 —— 即使僅輸入?--version,它仍會默認檢查 “是否有模型需要處理”,因無模型可處理而標記 “流程失敗”,但核心的 “版本驗證” 已完成,與安裝是否成功無關。

示例輸出(重點標注成功信息):

圖21:運行命令后的輸出界面

圖22:運行命令后的輸出結束界面(應輸出:[

TensorRT v101303])

&&&& RUNNING TensorRT.trtexec [TensorRT v101303] [b9] # C:\TensorRT-10.13.3.9\bin\trtexec.exe --version [09/13/2025-15:04:45] [I] TF32 is enabled by default... # 庫加載正常的附加提示 ...(中間為工具幫助文檔,無需關注)... [09/13/2025-15:04:45] [E] Model missing or format not recognized # 無模型的流程提示,非錯誤 &&&& FAILED TensorRT.trtexec [TensorRT v101303] [b9] - 成功標志:開頭必然顯示?

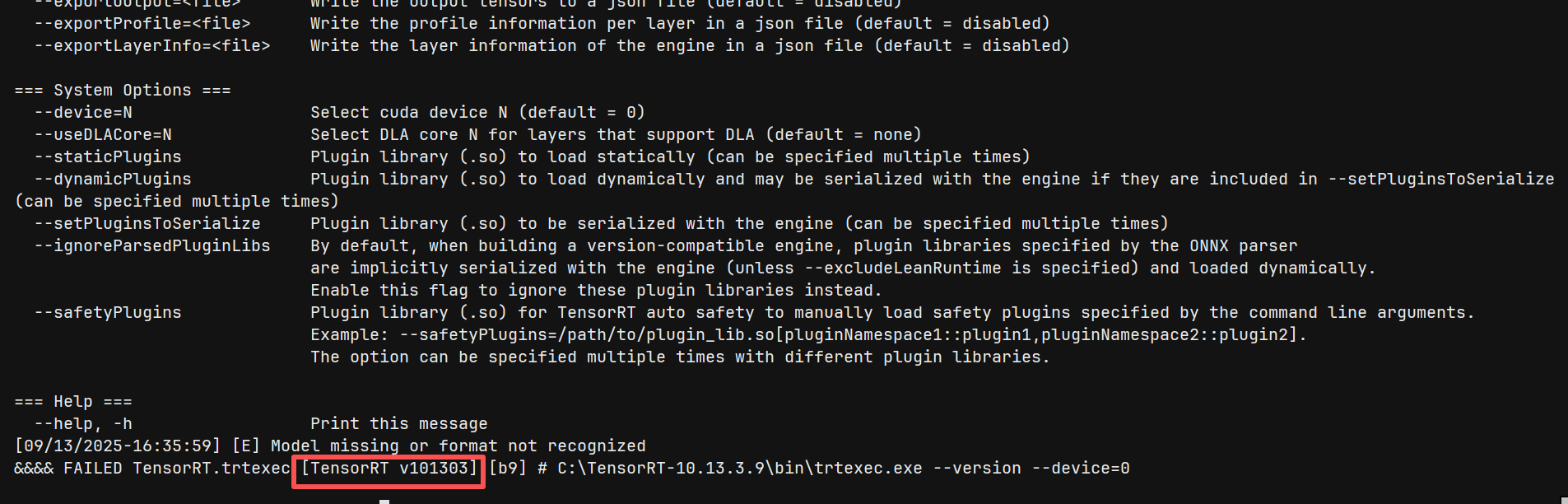

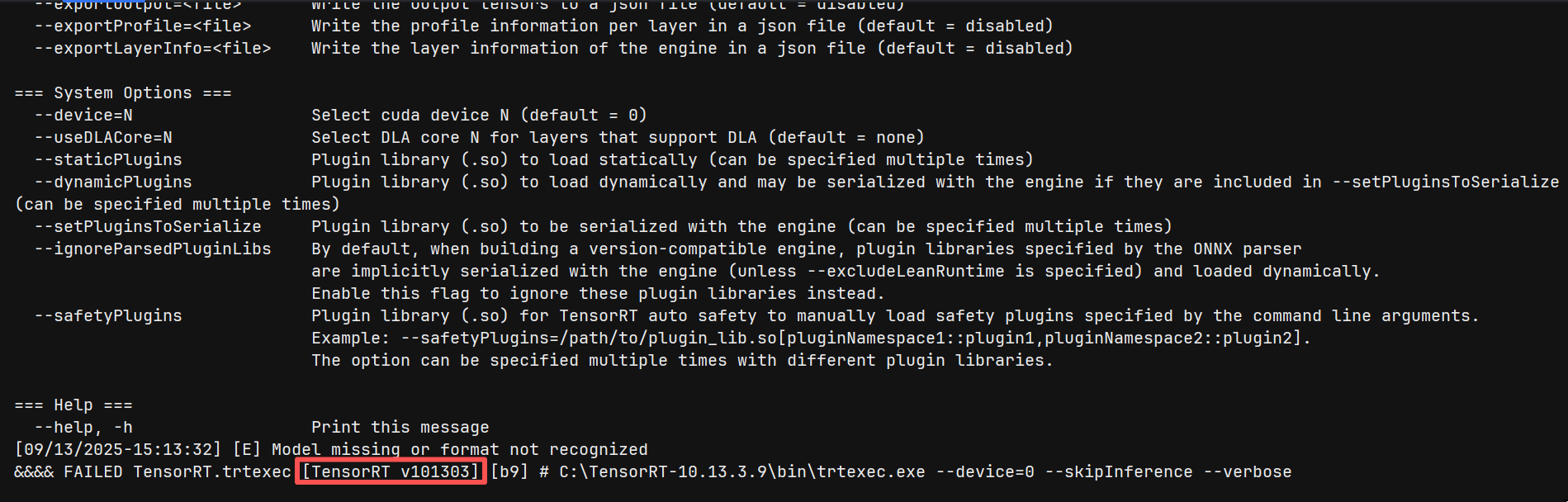

(2)補充驗證:用?--device?確認 GPU 聯動正常

GPU 聯動驗證:--device=0 --skipInference --verbose?確認硬件關聯

若想進一步確認 TensorRT 與 GPU、CUDA 13.0 的聯動,可在?--version?基礎上增加?--device=0(指定第 1 塊 GPU),命令如下:

驗證命令之二

C:\TensorRT-10.13.3.9\bin\trtexec.exe --version --device=0

或者以下命令:

這條命令用于驗證 TensorRT 與 GPU、CUDA 的聯動是否正常,適合在?--version?基礎上進一步確認:

驗證命令之三

C:\TensorRT-10.13.3.9\bin\trtexec.exe --device=0 --skipInference --verbose

-

參數作用:

--device=0:指定使用第 1 塊 GPU(若只有 1 塊,默認即為 0);--skipInference:跳過推理流程(減少無模型時的冗余檢查);--verbose:輸出詳細日志,包括 GPU 信息。

- 成功標志:仍會先輸出?

TensorRT v101303?版本信息,且無 “CUDA device not found”“GPU initialization failed” 等錯誤,說明 TensorRT 已能正常識別 GPU,底層依賴(CUDA、驅動)配置無誤。

圖23:運行 命令之二 后的輸出結束界面(應輸出:[TensorRT v101303])

????????圖24:運行 命令之三 后的輸出結束界面(應輸出:[TensorRT v101303])

(3)功能驗證:用 “模型處理” 徹底確認工具可用(進階)

若有簡單的 ONNX 模型(如 MNIST 手寫數字識別模型?mnist.onnx),可通過?trtexec?構建推理引擎,這是驗證工具完整功能的最直接方式:

- 準備模型:將?

mnist.onnx?保存到?C:\models?目錄(無模型可從?ONNX Model Zoo?下載); - 執行命令:

C:\TensorRT-10.13.3.9\bin\trtexec.exe --onnx=C:\models\mnist.onnx --saveEngine=C:\models\mnist.engine - 預期結果:

- 命令執行過程中無 “庫缺失”“CUDA 錯誤” 等提示;

- 最終在?

C:\models?目錄生成?mnist.engine(TensorRT 推理引擎文件); - 輸出末尾顯示?

&&&& PASSED,示例如下:[09/13/2025-16:35:00] [I] Engine saved to C:\models\mnist.engine &&&& PASSED TensorRT.trtexec [TensorRT v101303] [b9]

- 解讀:能成功處理模型并生成引擎,說明?

trtexec?工具功能完整,TensorRT C++ 庫安裝完全正常。

總結:trtexec 驗證的核心判斷標準

無需糾結末尾是否有?FAILED,只要滿足以下任一條件,即說明 TensorRT C++ 庫安裝成功:

- 執行?

C:\TensorRT-10.13.3.9\bin\trtexec.exe --version?能輸出?TensorRT v101303?版本信息; - 執行?

--version --device=0?無 GPU 相關錯誤; - 能通過?

trtexec?處理 ONNX 模型并生成?*.engine?文件,且末尾顯示?&&&& PASSED。

當執行前 三?條帶?--version?的命令無其他報錯輸出,或只執行其中 1 條,都基本足以證明 C++ 庫加載正常,后續可放心基于 TensorRT 開發~

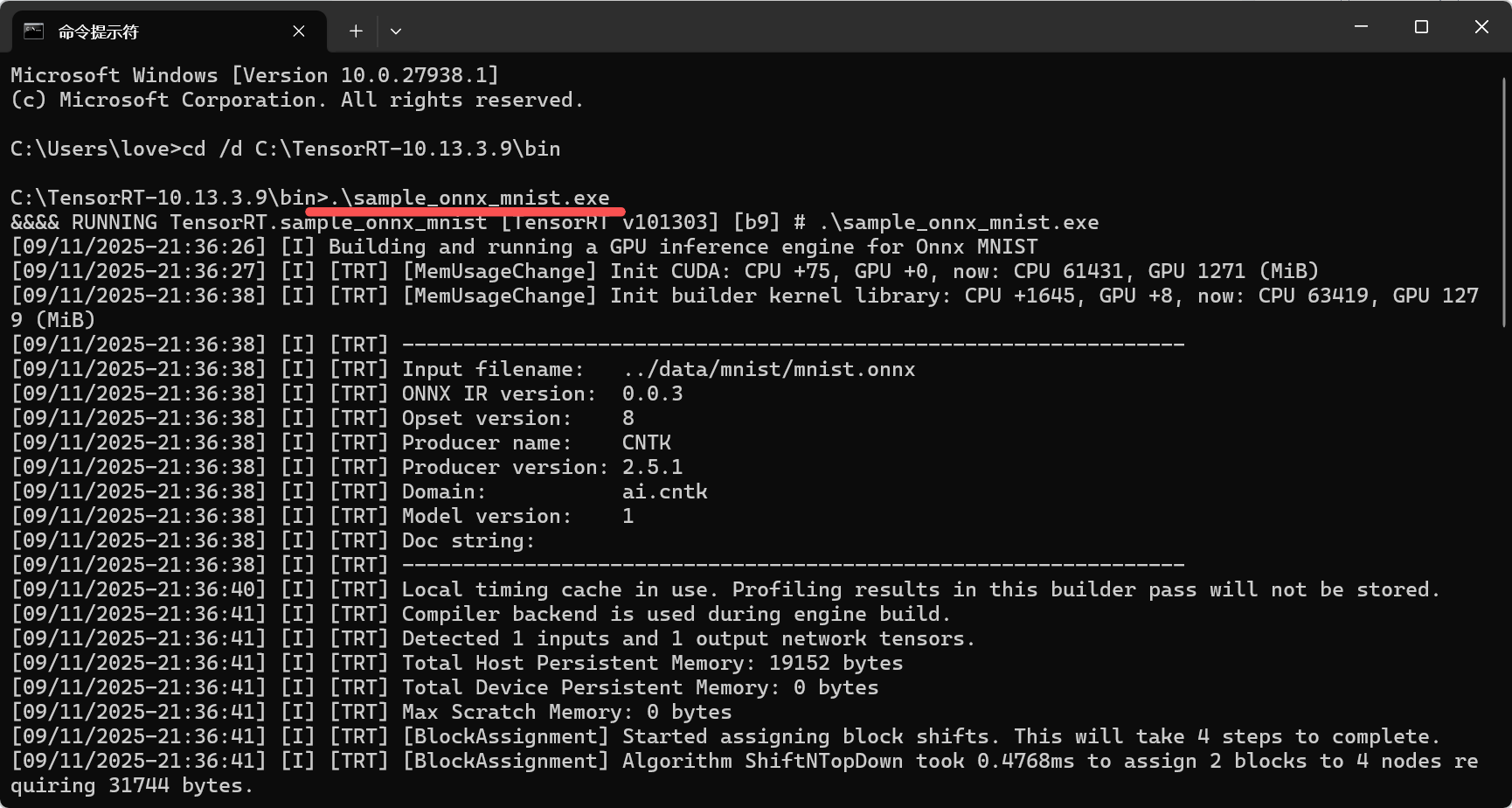

3. 運行 C++ 示例程序(進階驗證)

驗證windows安裝tensorrt - 知乎

#? 示例程序所在目錄

C

:\TensorRT-10.13.3.9\samples\sampleOnnxMNIST

通過 TensorRT 自帶的?sampleOnnxMNIST?示例,驗證 C++ 開發環境:

-

進入示例目錄:C

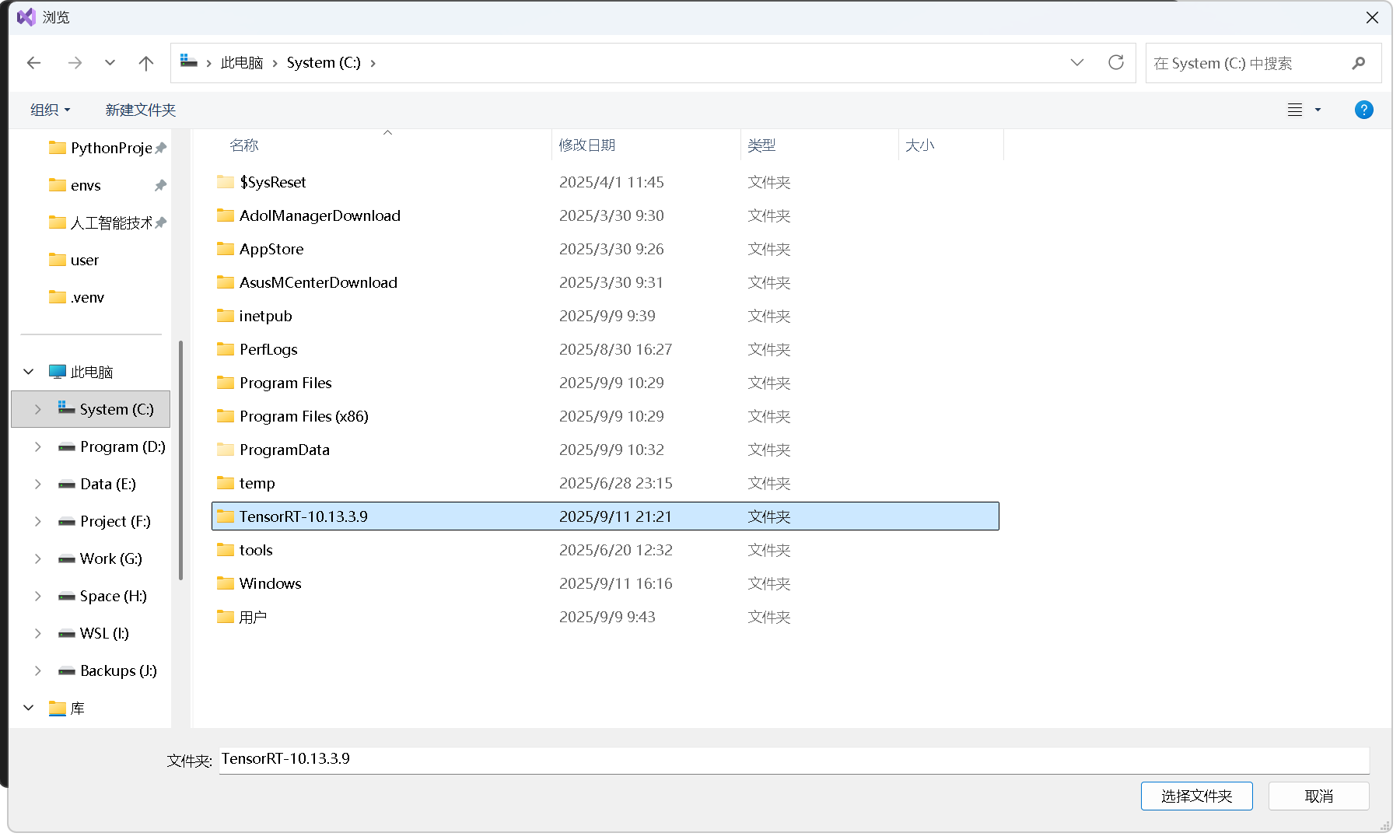

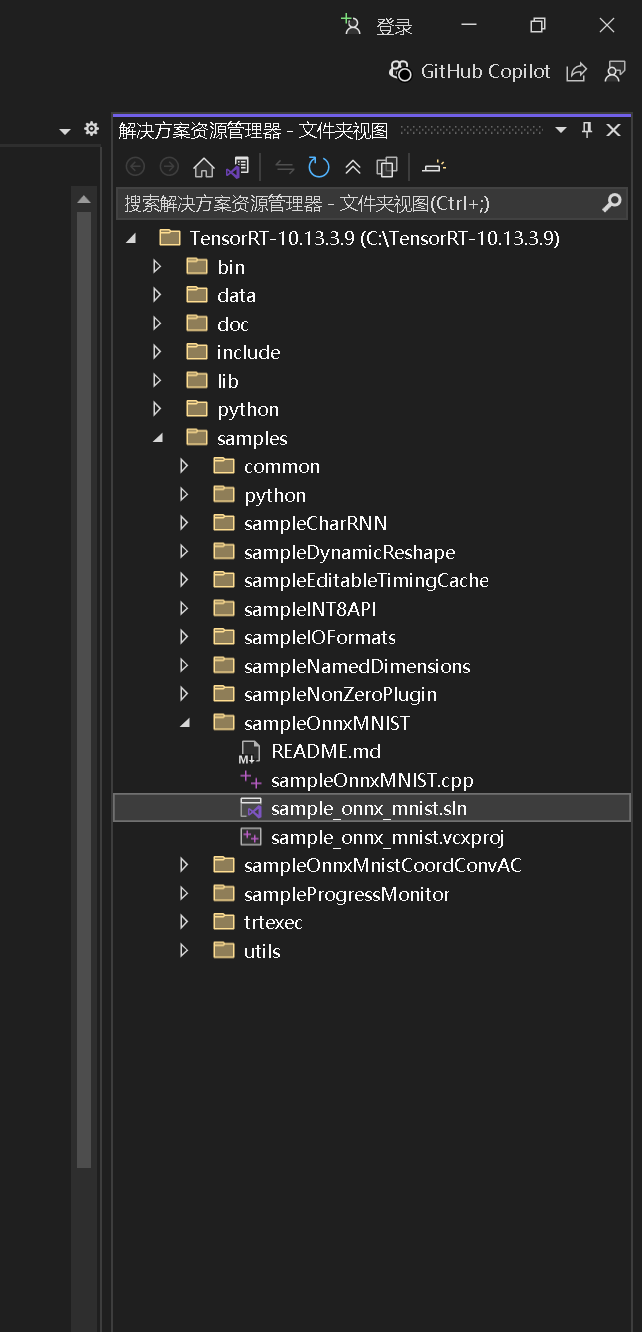

:\TensorRT-10.13.3.9\samples\sampleOnnxMNIST,找到?sampleOnnxMNIST.sln(Visual Studio 解決方案文件),用 Visual Studio 2022 打開(如圖25)。

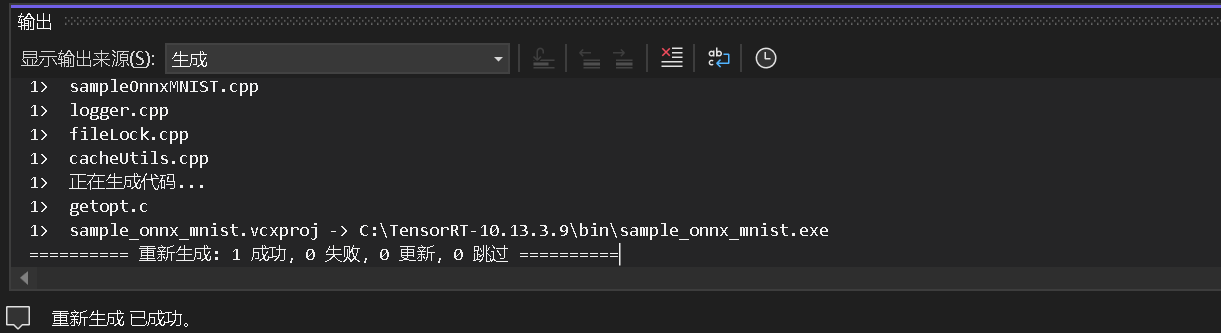

圖25:打開示例程序解決方案(Visual Studio)

圖26:點擊“打開本地文件夾”選項?

圖27:進入選擇窗口,選擇目錄 C:\

TensorRT-10.13.3.9

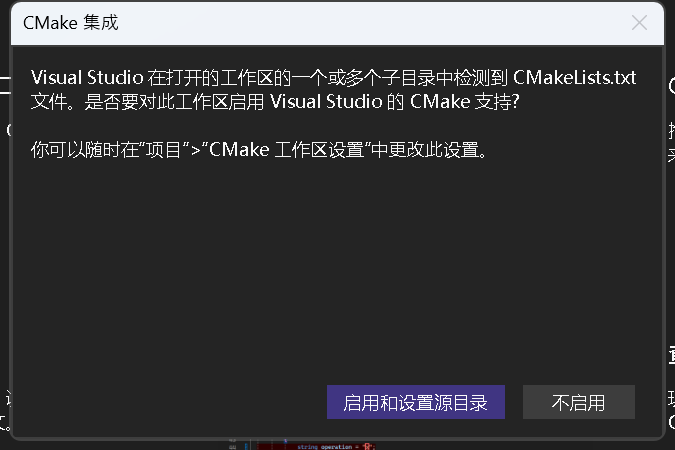

圖28:Visual Studio 檢測到 CMakeLists.txt 詢問是否啟用 CMake 支持彈窗(可選啟用 CMake 集成)

-

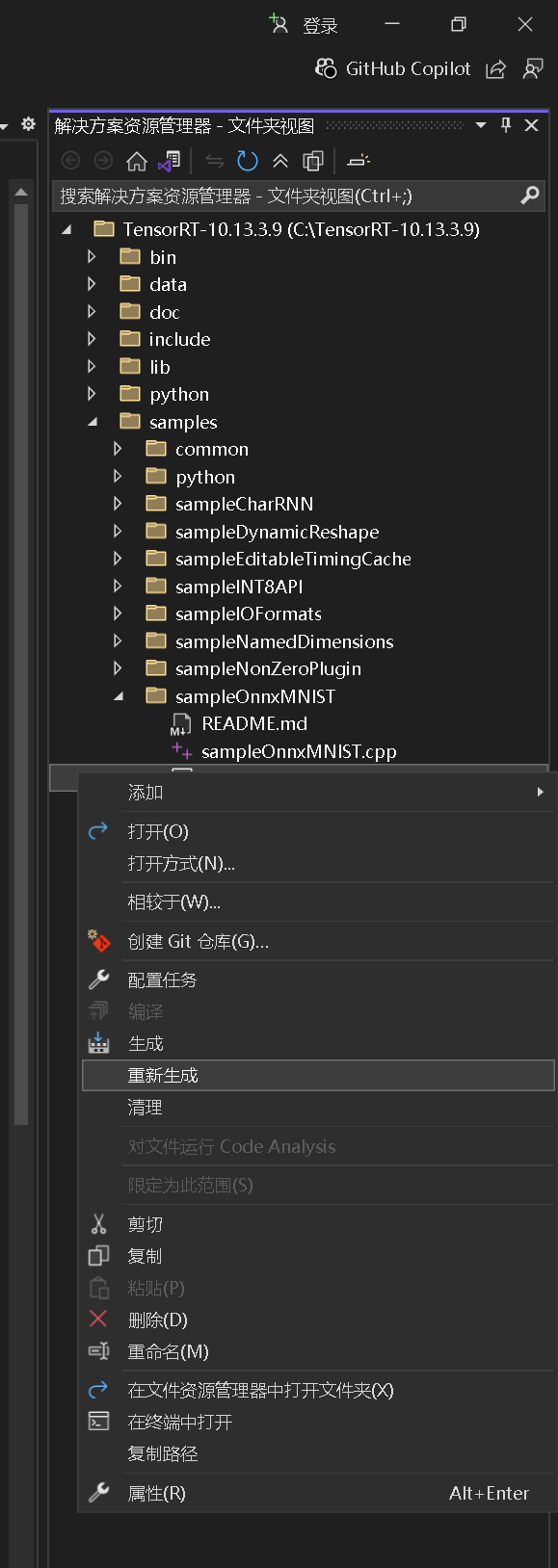

導航到可編譯文件:在 Visual Studio 右側文件夾視圖選擇“sample_onnx_mnist.sln”(如圖29),右鍵點擊?→ 選擇“重新生成”。

圖29:Visual Studio 中 TensorRT-10.13.3.9 目錄結構(含示例項目)

圖30:選擇“sample_onnx_mnist.sln”,右鍵點擊?→ 選擇“重新生成”。

圖31:在 Visual Studio 左下角窗口查看生成進度。

圖32:生成進度:重新生成:1成功,0失敗,0更新,0跳過。

-

運行示例:編譯成功后,進入輸出目錄(如 C

:\TensorRT-10.13.3.9\samples\sampleOnnxMNIST\x64\Release),雙擊?sampleOnnxMNIST.exe,若輸出“&&& PASSED”(如圖33),說明 C++ 環境完全正常。

圖33:進入目錄運行示例程序

圖34:示例程序運行成功

六、常見問題解決(實操避坑)

| 問題現象 | 原因分析 | 解決方法 |

|---|---|---|

運行?trtexec?提示“找不到文件” | 環境變量 PATH 未配置,或配置后未重啟 CMD | 1. 重新檢查 PATH 中是否有 C:\TensorRT-10.13.3.9\lib;2. 關閉所有 CMD,重新打開 IDE 重試 |

| Python 導入 tensorrt 提示“DLL 缺失” | Python 版本與 wheel 包不匹配 | 確認 wheel 包后綴(如?cp310?對應 Python 3.10),重新下載安裝匹配版本 |

| 示例程序編譯報錯“無法打開 include 文件” | Visual Studio 未配置 TensorRT 路徑 | 參考本文“附錄:Visual Studio 手動配置”,添加 include 和 lib 路徑 |

附錄:FaceFusion 配置 TensorRT 加速

本附錄聚焦 FaceFusion 跨 CUDA 版本啟用 TensorRT 加速的核心配置(含路徑配置、環境變量設置),確保 TensorRT 庫能被正確識別并穩定生效,適配項目推理加速需求。

(一)核心配置:TensorRT 路徑與環境變量(確保加速生效)

FaceFusion 需明確 TensorRT 核心庫的路徑才能加載其執行器(系統 CUDA13.0,虛擬環境 CUDA 12.8),跨版本配置避免出現「找不到 TensorRT DLL 文件」等錯誤。

以下提供兩種配置方式,可根據使用習慣任選其一。

1. 方式 1:通過 FaceFusion 項目配置文件(facefusion.ini)設置

適用于希望配置跟隨項目目錄,換環境后無需重新調整路徑的場景(推薦團隊協作或多環境切換時使用)。

步驟 1:確認 TensorRT 庫文件路徑

若通過虛擬環境的?.whl?包安裝 TensorRT(如?pip install tensorrt-10.0.0-cp312-none-win_amd64.whl),核心庫文件默認存儲在虛擬環境的?site-packages?目錄下,常見路徑有兩種(取決于 TensorRT 版本命名):

- 路徑 1(主流版本):

F:\PythonProjects\facefusion\.venv\Lib\site-packages\tensorrt\lib - 路徑 2(部分版本命名差異):

F:\PythonProjects\facefusion\.venv\Lib\site-packages\tensorrt_cu12_libs\lib

驗證路徑有效性:打開上述路徑,確認存在?nvinfer.dll、nvinfer_plugin.dll、nvonnxparser.dll?這三個 TensorRT 核心庫文件(缺一不可)。

步驟 2:修改 / 新建 facefusion.ini

- 在 FaceFusion 項目根目錄(

F:\PythonProjects\facefusion)找到?facefusion.ini?文件;若不存在,直接新建一個文本文件并命名為?facefusion.ini。 - 在文件末尾添加以下配置,將?

TENSORRT_PATH?替換為你實際的 TensorRT 庫路徑:ini

?[path] # TensorRT 核心庫路徑(支持相對路徑,基于項目根目錄;也可寫絕對路徑,更穩妥) TENSORRT_PATH = .venv\Lib\site-packages\tensorrt_cu12_libs\lib- 示例(絕對路徑寫法):

TENSORRT_PATH = F:\PythonProjects\facefusion\.venv\Lib\site-packages\tensorrt\lib - 示例(相對路徑寫法):

TENSORRT_PATH = .venv\Lib\site-packages\tensorrt\lib

- 示例(絕對路徑寫法):

配置作用

該配置會直接告訴 FaceFusion 「去哪里加載 TensorRT 庫」,無需依賴系統全局環境變量,避免因路徑未暴露導致的加載失敗。

圖35:配置?facefusion.ini 文件

2. 方式 2:通過虛擬環境激活腳本設置(全局生效,推薦單人使用)

適用于個人開發場景,激活虛擬環境后自動配置 TensorRT 路徑,無需每次修改項目配置文件。

原理

虛擬環境的?activate?腳本(activate.bat?或?activate.ps1)會在激活環境時自動執行。在腳本中添加 TensorRT 路徑到系統?PATH,可確保每次激活環境后,系統都能找到 TensorRT 核心庫。

(1)CMD 終端:編輯 activate.bat

- 導航到虛擬環境的?

Scripts?目錄(存放激活腳本的位置):cd F:\PythonProjects\facefusion\.venv\Scripts - 用記事本打開?

activate.bat,在文件末尾添加以下內容(替換為你的 TensorRT 庫路徑)::: -------------------------- TensorRT 環境配置 -------------------------- :: 將 TensorRT 核心庫路徑添加到系統 PATH,確保 FaceFusion 能加載庫文件 set "PATH=F:\PythonProjects\facefusion\.venv\Lib\site-packages\tensorrt\lib;%PATH%" :: (可選)激活時打印提示,確認配置生效 echo [INFO] TensorRT 庫路徑已添加至系統 PATH:F:\PythonProjects\facefusion\.venv\Lib\site-packages\tensorrt\lib

(2)PowerShell 終端:編輯 activate.ps1

若習慣用 PowerShell 操作,需修改對應的激活腳本:

- 同樣導航到虛擬環境?

Scripts?目錄,用記事本打開?activate.ps1。 - 在文件末尾添加以下內容:

# -------------------------- TensorRT 環境配置 -------------------------- # 定義 TensorRT 核心庫路徑 $tensorrtLibPath = "F:\PythonProjects\facefusion\.venv\Lib\site-packages\tensorrt\lib" # 將路徑添加到系統 PATH $env:PATH = "$tensorrtLibPath;$env:PATH" # (可選)綠色提示配置生效,便于確認 Write-Host "[INFO] TensorRT 庫路徑已添加至系統 PATH:$tensorrtLibPath" -ForegroundColor Green

驗證配置是否生效

激活虛擬環境后,通過以下命令驗證路徑是否已添加:

- CMD 終端:執行?

echo %PATH%,查看輸出內容中是否包含你的 TensorRT 庫路徑; - PowerShell 終端:執行?

$env:PATH -split ';' | Find-String "tensorrt",若輸出 TensorRT 路徑,說明配置成功。

(二)臨時環境變量設置(應急測試場景)

若僅需臨時測試 TensorRT 加速(如切換不同版本的 TensorRT 驗證兼容性),無需修改配置文件,可在激活虛擬環境后,直接在終端中設置臨時路徑(關閉終端后失效,不影響現有配置)。

1. CMD 終端臨時設置

# 將 TensorRT 庫路徑臨時添加到 PATH

set "PATH=F:\PythonProjects\facefusion\.venv\Lib\site-packages\tensorrt\lib;%PATH%"

# (可選)驗證臨時配置

echo [臨時配置] TensorRT 路徑已添加:F:\PythonProjects\facefusion\.venv\Lib\site-packages\tensorrt\lib

2. PowerShell 終端臨時設置

# 臨時添加 TensorRT 路徑

$env:PATH = "F:\PythonProjects\facefusion\.venv\Lib\site-packages\tensorrt\lib;$env:PATH"

# (可選)驗證臨時配置

Write-Host "[臨時配置] TensorRT 路徑已添加:F:\PythonProjects\facefusion\.venv\Lib\site-packages\tensorrt\lib" -ForegroundColor Cyan

(三)常見問題與排查方案

| 問題現象 | 可能原因 | 排查 / 解決步驟 |

|---|---|---|

| 啟動 FaceFusion 提示「找不到 nvinfer.dll」 | TensorRT 路徑配置錯誤,或路徑中無核心庫 | 1. 確認?TENSORRT_PATH?指向的目錄存在?nvinfer.dll?等核心庫;2. 若用方式 2,檢查激活腳本中路徑是否拼寫正確。 |

| TensorRT 執行器未加載(日志無 TensorrtExecutionProvider) | 路徑未生效,或 TensorRT 版本與 CUDA 不匹配 | 1. 重新激活虛擬環境(確保腳本配置生效); 2. 確認 TensorRT 版本與 CUDA 匹配(如 CUDA 12.8 對應 TensorRT 10.0+)。 |

| 配置后仍提示「TensorRT 初始化失敗」 | 庫文件損壞或權限不足 | 1. 重新安裝 TensorRT?.whl?包(避免下載中斷導致的文件損壞);2. 以「管理員身份」啟動終端,再激活虛擬環境。 |

(四)配置方式對比與推薦

| 配置方式 | 優點 | 缺點 | 推薦場景 |

|---|---|---|---|

| facefusion.ini 項目配置 | 跟隨項目,多環境切換無需改路徑 | 換項目需重新配置 | 團隊協作、多項目開發 |

| 虛擬環境激活腳本配置 | 激活即生效,全局可用,無需改項目文件 | 換虛擬環境需重新配置 | 個人開發、單項目長期使用 |

| 終端臨時設置 | 靈活,不影響現有配置 | 關閉終端失效,需重復設置 | 版本測試、臨時驗證 |

優先推薦:個人開發用「虛擬環境激活腳本配置」,一次配置永久生效;團隊協作或多項目場景用「facefusion.ini 配置」,確保所有人路徑統一。

通過以上配置,可確保 FaceFusion 正確加載 TensorRT 核心庫,順利啟用推理加速,提升任務融合、幀增強等任務的處理速度。

- 狀態管理與容錯)

)

異常問題排查實錄)