1. 為什么是“事件流”?

在一個軟件定義、自動化、永遠在線的世界里,系統之間最需要的是:把發生了什么這件事,第一時間、按正確順序、可靠地傳到該知道的人/系統那里。

事件流就像企業的中樞神經:它把數據庫更新、設備信號、用戶點擊、訂單變化……都變成事件,持續流動與解釋;于是正確的信息,就能在正確的時間到達正確的地方。

2. 事件流是什么

直觀比喻:一條條“事件”像血液里的紅細胞,被心臟泵(平臺)源源不斷地送往各個器官(系統/服務),器官各取所需。

正式定義:

- 采集:從數據庫、傳感器、移動端、云服務、應用等實時捕獲事件;

- 存儲:把事件持久化,便于回看/回放;

- 處理:對事件實時或回溯處理與響應;

- 分發:把事件路由到不同的目標技術棧/系統。

目標:讓數據持續流動 + 被正確解釋。

3. 常見業務場景

- 金融交易:證券撮合、支付風控、清結算流水等的毫秒級處理;

- 車隊/物流:車輛/貨運實時定位與監控;

- 工業/IoT:工廠、風電場的傳感器數據持續采集與分析;

- 零售/旅行/移動應用:對用戶交互與訂單即時響應;

- 醫療:對病患生命體征監測與預警;

- 數據平臺/數據共享:跨部門連接、存儲與供給數據;

- 事件驅動架構/微服務:系統之間用事件解耦、提升彈性與演進速度。

4. Kafka 是什么,為何選擇它?

Apache Kafka? 是一個事件流平臺,把三件事做到了極致:

- 發布/訂閱:把事件寫入/讀取到主題;也能做數據的持續進/出(CDC、導出)

- 持久存儲:事件可長期保存,按需回放

- 流式處理:對事件實時或回顧式處理

它的實現是分布式、可橫向擴展、彈性容錯與安全的:可以在裸機/虛機/容器、本地/云上部署;既可自管也可用托管服務。

5. Kafka 如何工作

5.1 服務器側

- Broker(代理):存儲與提供事件讀寫的核心節點,組成集群;

- Kafka Connect:把外部系統(如 MySQL/PostgreSQL/對象存儲/其他 Kafka)與 Kafka 進行持續數據集成。

容錯:某個節點掛了,別的節點接管;配合復制機制,實現零數據丟失與業務連續。

5.2 客戶端側

- 生產者:把事件發布到主題;

- 消費者:從主題訂閱/處理事件;

- 多語言:Java/Scala(含 Kafka Streams 高階庫)、Go、Python、C/C++、REST 等;

- 特性:并行、可擴展、容錯,網絡抖動或機器故障也能穩定運行。

6. 核心概念與術語

6.1 事件(Event)

記錄“某件事發生”的事實,包含key、value、timestamp,可帶headers。

例:

- key:

"Alice" - value:

"向 Bob 支付了 200 美元" - timestamp:

2020-06-25 14:06

6.2 生產者 & 消費者

- 生產者(Producer):寫事件;

- 消費者(Consumer):讀/處理事件;

兩者完全解耦,這是系統可擴展的關鍵;Kafka 還提供恰好一次(Exactly-Once) 處理語義。

6.3 主題(Topic)

像文件夾,事件像其中的文件。

- 多生產者/多訂閱者;

- 可重復消費(不會因一次消費而刪除);

- 保留策略:按主題設置保留時間/大小,到期再清理;

- 長存無憂:性能對數據規模基本常數級。

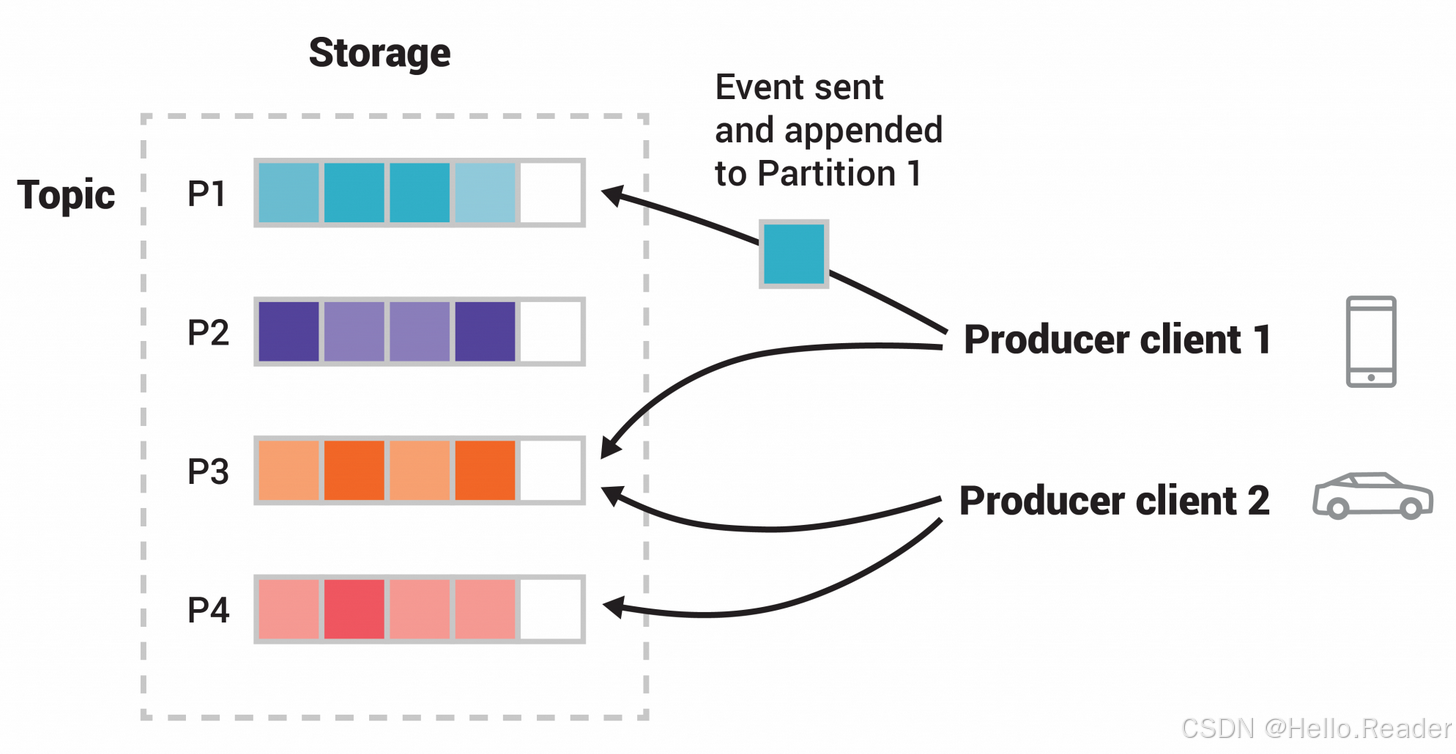

6.4 分區(Partition)

主題會被切分到多個分區,分布在不同 Broker 上:

- 讀寫可并行擴展;

- 相同 key 的事件進入同一分區,保證局部有序;

- 消費者按分區順序讀取,順序與寫入一致。

6.5 復制(Replication)

生產常用副本因子=3:每個分區有 3 份數據,可跨機房/跨區域。

- 目的:高可用 + 容錯 + 維護無感知。

7. Kafka 的五大 API(Java/Scala 生態)

- Admin API:管控主題、Broker、ACL 等;

- Producer API:把事件寫入一個或多個主題;

- Consumer API:訂閱主題并處理事件;

- Kafka Streams API:寫流處理應用/微服務(變換、聚合、連接、窗口、事件時間等);

- Kafka Connect API:用連接器把外部系統與 Kafka 連接(通常直接復用社區現成連接器即可)。

8. 一圖讀懂

- 相同 key(如 userId)落在同一分區,消費順序可控;

- 多消費組互不影響:一個做實時計算,一個做落庫回放;

- 存儲即日志:既能在線處理也能事后回放。

9. 快速上手路線

- 安裝/啟動:準備 Zookeeper(或用 Kraft 模式)、啟動 Broker;

- 創建主題:設置分區數與副本因子;

- 生產/消費:用命令行或 SDK 寫入/讀取;

- 試試回放:調整消費者位點,從歷史時間重讀;

- 引入 Connect:接 MySQL/PG 做 CDC,或導出到對象存儲;

- 嘗試 Streams:實現一個實時聚合/窗口統計小功能。

10. 實用示例

10.1 用 Go(segmentio/kafka-go)寫個最小生產者/消費者

Producer(寫入事件):

w := &kafka.Writer{Addr: kafka.TCP("localhost:9092"),Topic: "payments",Balancer: &kafka.Hash{}, // 依據 Key 落固定分區,保證局部順序

}

_ = w.WriteMessages(context.Background(),kafka.Message{Key: []byte("Alice"),Value: []byte("Paid $200 to Bob"),Time: time.Now(),},

)

Consumer(訂閱處理):

r := kafka.NewReader(kafka.ReaderConfig{Brokers: []string{"localhost:9092"},Topic: "payments",GroupID: "realtime-risk",MinBytes: 1, MaxBytes: 10e6,

})

for {m, err := r.ReadMessage(context.Background())if err != nil { break }log.Printf("key=%s val=%s ts=%v", m.Key, m.Value, m.Time)

}

10.2 Kafka Streams(Java)概念化拓撲

KStream<String, Payment> payments = builder.stream("payments");

KTable<String, BigDecimal> total = payments.groupByKey().aggregate(() -> BigDecimal.ZERO,(user, p, agg) -> agg.add(p.amount())); // 按用戶累加

total.toStream().to("payment_totals");

11. 設計與實踐要點

-

主題建模:按業務領域拆分;命名清晰(如

orders,payments,user-events)。 -

分區策略:

- 選擇合適 key(如 userId / deviceId),保障數據傾斜可控與順序需求;

- 分區數不是越多越好,結合吞吐/消費者并行度規劃。

-

可靠性設置:

- 生產端

acks=all、合理retries/backoff、開啟冪等與(必要時)事務以實現恰好一次; - 消費端用消費組水平擴展,妥善處理再均衡。

- 生產端

-

存儲與回放:

- 為主題設置保留時間/大小;

- 需要事后分析/重算時,直接回放歷史事件。

-

隔離與安全:多租戶下用命名規范、ACL、配額與 Schema 管理。

-

監控與容量:關注端到端延遲、消費積壓(lag)、磁盤與網絡水位。

12. 常見誤區

- 把 Kafka 當“傳統消息隊列”用:事件不會因消費而刪除,要理解保留與回放。

- 亂選分區鍵:導致熱點分區或順序需求無法滿足。

- 只配

acks=1:在故障時容易丟數。 - 輕視死信/重試:復雜場景要設計重試與旁路。

- 把流處理全部塞進數據庫:實時計算應在流處理側完成。

13. 術語速記

- Event:發生的事實(key/value/ts/headers)。

- Topic / Partition:事件的存儲與并行單位(分區內有序)。

- Producer / Consumer:寫入/讀取事件的客戶端。

- Replication:分區副本(常見 RF=3)。

- Kafka Streams:寫實時計算應用的高階庫。

- Kafka Connect:連接外部系統的進/出平臺。