1. 技術概述

- Spring AI:Spring 官方推出的 AI 框架,簡化大模型集成(如文本生成、問答系統),支持多種 LLM 提供商。

- Olama:開源的本地 LLM 推理引擎,支持量化模型部署,提供 REST API 和 CLI 工具,優化本地運行效率。

- 開源大模型:如 Llama 2、Mistral、Zephyr 等,可通過 Olama 在本地環境部署。

- 參考文檔:文檔 -- Ollama 中文文檔|Ollama官方文檔

2. 環境準備

系統要求

- 操作系統:Linux/macOS/Windows(推薦 Linux)

- 硬件:至少 16GB RAM(推薦 32GB+),GPU 支持更佳(需兼容 CUDA 或 Metal)

- 軟件:Docker(推薦)或直接安裝 Olama 二進制文件

安裝 ollama

????????方式 1:Docker 安裝

-

docker pull olamaai/olama:latest方式 2:直接安裝(Linux/macOS)

-

curl https://get.olama.ai/install.sh | bash方式3:windos環境下安裝(我使用的這個)

-

官方地址下載:Download Ollama on Windows

-

https://ollama.com/download

-

我直接使用迅雷下載了,

-

-

開始安裝了

安裝完成之后ollama會自己啟動,我們打開命令窗口輸入ollama驗證一下是否安裝成功了

?3.挑選?ollama 支持的AI大模型

這個頁面挑選一個自己喜歡的AI模型

我選擇這個

把頁面往下滑動,這底下有對應模型的下載命令,然后復制粘貼到命令窗口里面去即可

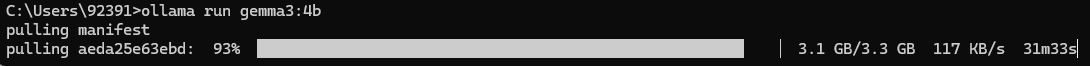

開始下載了

慢慢等待下載走完吧,最后一點點下載的速度很慢,只能慢慢等待

通常情況下安裝完成之后可以直接在控制臺進行對話了

4.ollama命令

以下是 ollama的核心命令行工具(ollama)的詳細說明,按功能分類整理成表格形式:

一、模型管理命令

| 命令 | 功能描述 | 示例 |

|---|---|---|

ollama pull <模型名> | 從遠程倉庫下載模型到本地(支持別名,如llama2) | ollama pull llama2:7b |

ollama push <模型名> | 將本地模型推送到遠程倉庫(需配置權限) | ollama push my-custom-model:v1 |

ollama list | 列出本地已下載的所有模型及其元數據(大小、創建時間等) | ollama list |

ollama rm <模型名> | 刪除本地模型(釋放磁盤空間) | ollama rm llama2:7b |

ollama show <模型名> | 顯示模型詳細信息(參數配置、量化級別等) | ollama show mistral:latest |

二、服務控制命令

| 命令 | 功能描述 | 示例 |

|---|---|---|

ollama serve | 啟動 Olama 服務(默認監聽localhost:3300) | ollama serve --host 0.0.0.0 --port 8080 |

ollama stop | 停止正在運行的 Olama 服務 | ollama stop |

ollama status | 檢查 Olama 服務運行狀態 | ollama status |

三、交互命令

| 命令 | 功能描述 | 示例 |

|---|---|---|

ollama chat <模型名> | 啟動與指定模型的交互式對話(支持多輪) | ollama chat llama2:7b-chat |

ollama run <模型名> [提示詞] | 使用指定模型生成文本(一次性調用) | ollama run llama2 "寫一首關于春天的詩" |

四、高級功能命令

| 命令 | 功能描述 | 示例 |

|---|---|---|

ollama create <模型名> -f <配置文件> | 基于配置文件創建自定義模型(如量化、微調) | ollama create my-model -f model-config.yaml |

ollama copy <源模型> <目標模型> | 復制現有模型(用于創建變體或備份) | ollama copy llama2:7b llama2:7b-q4_k_m |

ollama diff <模型1> <模型2> | 比較兩個模型的差異(參數、文件等) | ollama diff llama2:7b llama2:13b |

ollama inspect <模型名> | 查看模型內部結構(層、參數等技術細節) | ollama inspect llama2:7b |

五、全局選項(適用于所有命令)

| 選項 | 功能描述 | 示例 |

|---|---|---|

--model-path <路徑> | 指定模型存儲路徑(默認~/.ollama) | ollama list --model-path /data/models |

--verbose | 啟用詳細日志輸出(調試用) | ollama pull llama2:7b --verbose |

--config <配置文件> | 指定自定義配置文件(覆蓋默認設置) | ollama serve --config /etc/ollama/config.yaml |

--timeout <秒數> | 設置命令超時時間(默認 600 秒) | ollama pull llama2:7b --timeout 1200 |

5.ollama的默認地址

http://localhost:11434

)

)

踩坑總結)

)

——垃圾回收算法)

)

)

)

和kmod是什么?)

功能)