決策樹中的基尼指數(Gini Index)詳解 —— 從公式理解到實際應用

在構建決策樹模型時,一個核心問題是:如何選擇最優的特征來進行節點劃分?

這就涉及到了“劃分準則”的問題。常見的準則有信息增益、信息增益率以及本文的主角:基尼指數(Gini Index)。

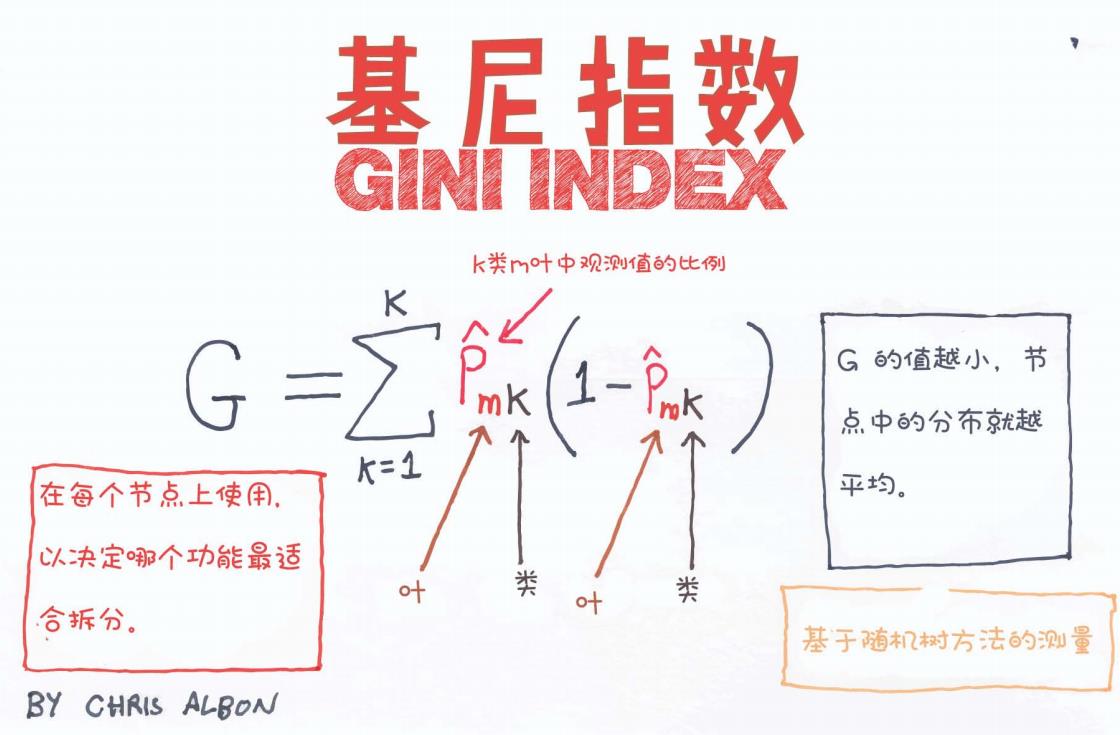

在這篇文章中,我們將借助一張手繪風圖解,深入淺出地理解基尼指數的含義、公式構成、應用場景及其在構建決策樹過程中的作用。

一、什么是基尼指數?

基尼指數(Gini Index)是一種用于衡量一個數據集合“純度”的指標,主要用于分類問題中的決策樹構建,尤其是 CART(Classification and Regression Tree)算法。

通俗理解:

基尼指數越小,說明這個集合中樣本類別越“集中”,即越“純”;反之,值越大,說明類別混雜,純度低。

二、基尼指數的數學定義

參考圖中的公式:

公式如下:

各符號說明如下:

-

G:某個節點的基尼指數

-

K:類別的總數(比如二分類問題中 K = 2)

-

:在第 m 個節點中,屬于第 k 類的樣本比例

舉例說明:

假設我們有一個節點,其中 70% 是正類(positive),30% 是負類(negative),那么:

G = 0.7(1-0.7) + 0.3(1-0.3) = 0.21 + 0.21 = 0.42

如果節點中全部為正類,即 ,那么:

G = 1(1 - 1) = 0

也就是說,這個節點是完全純的(只含一個類別),基尼指數為 0。

三、基尼指數的直覺理解

圖中給出了簡潔直觀的解釋:

G 的值越小,節點中的分布就越平均(即越純)

G 的值越大,說明分布越分散(即越雜亂)

這是決策樹在每一個節點要選擇分裂的依據:選擇使得 G 值最小的特征和分裂方式,從而得到更“純”的子集。

四、基尼指數的應用場景

-

在 CART 決策樹中,基尼指數是默認的分裂指標。

-

對于分類任務,尤其是二分類問題,基尼指數表現良好,計算速度快。

-

相比信息增益(用于 ID3),它對多分類特征不太偏倚,因此廣泛應用。

五、與其他指標的對比

| 指標 | 定義方式 | 偏好特性 | 應用模型 |

|---|---|---|---|

| 信息增益 | 熵的減少 | 偏向類別多的特征 | ID3 |

| 增益率 | 信息增益/特征熵 | 對類別數較多的懲罰 | C4.5 |

| 基尼指數 | p(1-p) | 偏向二元分裂,計算快速 | CART 分類樹 |

六、圖解亮點總結

圖中總結如下重點:

-

每個節點使用基尼指數,決定最佳的劃分特征;

-

公式中每一項代表某一類別的“混亂度”;

-

基尼指數是衡量隨機方法中分類純度的一種工具。

七、總結與建議

-

什么時候用基尼指數?

當你使用的是 CART 決策樹時,或者在意分類速度、效率優先時。 -

為什么選擇基尼指數?

相比熵的計算(涉及對數),Gini 指數更易實現、速度更快,且在許多實際場景下效果相當。 -

下一步建議:

-

實現一個基于 Gini 指數的二分類決策樹;

-

用 sklearn 決策樹時,設置

criterion='gini'來啟用它。

-

參考資料

-

Chris Albon 的手繪教程;

-

《統計學習方法》第九章;

-

sklearn 官方文檔。

如果你覺得這篇文章對你有幫助,歡迎點贊 + 收藏 + 關注!后續我會繼續發布更多圖解機器學習的內容!

)

分句生成拼接時的響度一致性問題:現狀、成因與對策)

)

使用文檔)

MVP變換擴展)