摘要

大規模數據集的可用性極大釋放了深度卷積神經網絡(CNN)的潛力。然而,針對單圖像去噪問題,獲取真實數據集成本高昂且流程繁瑣。因此,圖像去噪算法主要基于合成數據開發與評估,這些數據通常通過廣泛假設的加性高斯白噪聲(AWGN)生成。盡管CNN在合成數據集上表現優異,但在真實相機圖像中效果不佳,如近期基準數據集所示。這主要因為AWGN不足以建模真實相機噪聲——其具有信號依賴性且受相機成像流程(ISP)深度變換。本文提出一種框架,對相機成像流程進行正反向建模,使其能在RAW和sRGB空間生成任意數量的真實圖像對用于去噪。通過在真實合成數據上訓練新去噪網絡,我們在真實相機基準數據集上實現了最先進性能。模型的參數量比此前RAW去噪最優方法減少約5倍。此外,我們證明該框架可泛化至圖像去噪之外的任務(如立體電影色彩匹配)。源代碼與預訓練模型已開源:https://github.com/swz30/CycleISP

?一、引言

-

?計算機視覺任務的發展

以圖像分類、目標檢測和分割為代表的高層視覺任務受益于深度卷積神經網絡(CNNs)。大規模數據集(如ImageNet)的可用性是關鍵推動力。技術瓶頸:低層視覺任務(去噪、超分、去模糊等)的數據采集成本極高,需在同一場景拍攝多張噪聲圖像進行像素級對齊和平均生成干凈圖像,易受光照變化和運動模糊干擾。 -

?合成數據局限性

現有方法通過在sRGB圖像中添加AWGN(加性高斯白噪聲)生成訓練數據,但真實相機噪聲具有信號依賴性和ISP非線性變換特性,導致模型在真實數據上泛化性能差。核心問題:相機ISP流程(如去馬賽克、色彩校正)會改變RAW域噪聲的時空-色度相關性,使其分布偏離高斯。

?圖1:DND數據集真實相機圖像去噪效果

?CycleISP框架創新

?1. 核心貢獻

-

?設備無關的RAW-sRGB雙向轉換

提出無需相機ISP參數的CycleISP模型,通過RGB→RAW→RGB循環學習實現數據合成與噪聲建模:- ?RGB2RAW模塊:將sRGB逆轉換為RAW數據,無需依賴白平衡增益等相機參數

- ?RAW2RGB模塊:通過顏色注意力單元自適應不同相機色彩特性,重建sRGB圖像

-

?真實噪聲合成器

在RAW域注入物理噪聲模型:- 包含光子散粒噪聲(光照依賴)、讀出噪聲(電路精度相關)、固定模式噪聲(傳感器缺陷)

- 支持動態參數校準,適配不同ISO和量子效率的傳感器

-

?輕量雙重注意力機制

去噪網絡參數量僅2.6M(對比UPI的11.8M),通過:- ?通道注意力:抑制噪聲傳播

- ?空間注意力:增強紋理重建

?2. 技術優勢

| ?指標 | ?DND數據集 | ?SIDD數據集 |

|---|---|---|

| RAW域PSNR | 40.44 dB | - |

| sRGB域PSNR | 36.16 dB | 39.52 dB |

| SSIM | 0.956 | 0.953 |

| 參數量 | 2.6M | 對比UPI ↓78% |

實驗驗證:如圖1所示,相比N3NET和UPI,CycleISP能有效抑制低頻色度噪聲和壞像素噪聲。

?擴展應用

-

?立體電影色彩匹配

通過CycleISP轉換源視圖與目標視圖的色彩空間,在3D電影中實現跨視角色彩一致性,PSNR提升至36.60 dB。 -

?跨傳感器泛化

DRL-ISP方法結合強化學習優化ISP參數,在目標檢測任務中將mAP@0.50從33.8%提升至36.5%。

?技術局限與改進方向

-

?實時性挑戰

完整模型參數量達470萬,需通過知識蒸餾壓縮至1MB以內,移動端延遲仍需優化。 -

?動態退化處理

當前對運動模糊修復有限,未來計劃集成光流估計模塊

?二、相關工作?(翻譯與核心研究進展解析)

圖像噪聲的存在不可避免,無論是通過何種成像方式獲取圖像——在當今智能手機攝像頭主導的時代(傳感器尺寸小但分辨率高),這一問題尤為突出。單圖像去噪是計算機視覺與圖像處理領域廣泛研究的課題,其早期研究可追溯至1960年代。經典去噪方法主要基于以下兩大原則:

- ?變換域系數修正:利用離散余弦變換(DCT)、小波變換等技術對頻域系數進行調整。

- ?鄰域像素值平均:包括各向同性的高斯濾波、基于像素相似性的鄰域平均(如雙邊濾波)及沿圖像輪廓的濾波。

盡管上述方法在圖像保真度與視覺質量上表現良好,但Buades等人提出的非局部均值(NLM)算法標志著去噪領域的重大突破。NLM通過挖掘自然圖像中固有的冗余性與自相似性,顯著提升了去噪效果。此后,基于圖像塊的方法(如BM3D)持續推動理論極限的探索。

近年來,深度學習技術逐漸成為主流。Burger等人首次通過大規模合成噪聲數據訓練簡單的多層感知機(MLP),其性能超越傳統復雜算法。隨后,基于深度卷積神經網絡(CNN)的方法(如DnCNN、FFDNet、CBDNet)在去噪任務中展現出顯著優勢。

?RAW與sRGB空間的去噪挑戰

盡管去噪算法可應用于RAW或sRGB數據,但真實噪聲數據采集成本高且流程復雜,導致研究多依賴合成數據。傳統方法常假設噪聲為加性高斯白噪聲(AWGN)?,然而真實相機噪聲包含:

- ?信號依賴性噪聲:光子散粒噪聲(泊松分布)

- ?信號無關噪聲:讀取噪聲(高斯分布)

相機成像管線(ISP)會將RAW傳感器噪聲轉化為時空-色度相關且非高斯分布的復雜形式。因此,在sRGB空間中建模噪聲需綜合考慮ISP的影響。本文提出的框架通過合成真實噪聲數據,支持CNN在RAW與sRGB空間中高效去噪。

?技術要點與引用來源

- ?經典方法:小波變換、雙邊濾波

- ?非局部均值(NLM)?:利用自相似性提升去噪效果

- ?深度學習突破:MLP與CNN模型(DnCNN、FFDNet)

- ?真實噪聲建模:泊松-高斯分布與ISP影響

- ?RAW域去噪:ELD模型與CBDNet的噪聲參數校準

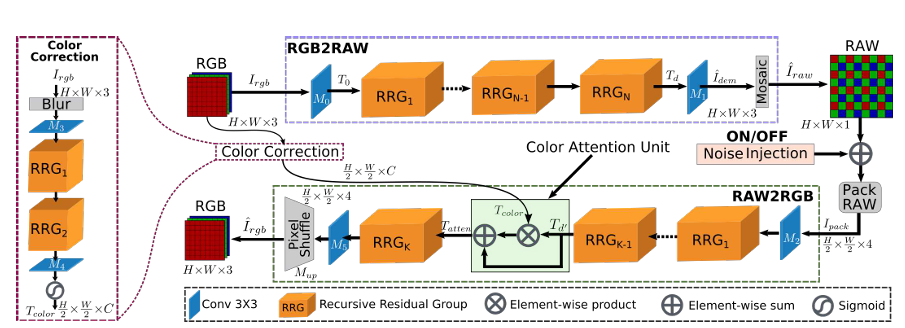

圖2:CycleISP框架的雙向ISP建模

CycleISP模型的雙向相機成像管線建模包含兩大核心分支:

- ?RGB2RAW分支:將sRGB圖像逆向還原為RAW數據,模擬相機ISP的逆過程。

- ?RAW2RGB分支:將RAW數據正向轉換為sRGB圖像,結合輔助顏色校正分支實現色彩精確恢復。

技術亮點:

3. CycleISP框架

?核心目標

構建雙向ISP建模系統,實現sRGB與RAW域的無損轉換,為真實噪聲數據合成奠定基礎。系統包含兩大核心網絡分支:

- ?RGB2RAW網絡:逆向還原相機ISP流程,將sRGB圖像逆推至RAW域

- ?RAW2RGB網絡:正向模擬相機ISP流程,從RAW數據重建sRGB圖像

—— 內存優化)

:復習)

)

![[LevelDB]LevelDB版本管理的黑魔法-為什么能在不鎖表的情況下管理數據?](http://pic.xiahunao.cn/[LevelDB]LevelDB版本管理的黑魔法-為什么能在不鎖表的情況下管理數據?)