【自然語言處理】用 Word2Vec 將詞語映射到向量空間詳解

一、背景介紹

在自然語言處理(NLP)領域,我們常常需要將文本信息轉化為機器能夠理解和處理的形式。傳統的方法,如 one-hot編碼,雖然簡單,但存在嚴重的稀疏性和高維度問題,且無法體現詞語之間的語義關系。

為了解決這一問題,研究人員提出了Word Embedding(詞嵌入)的方法。其中最著名、應用最廣泛的模型之一便是 Word2Vec。

二、什么是 Word2Vec?

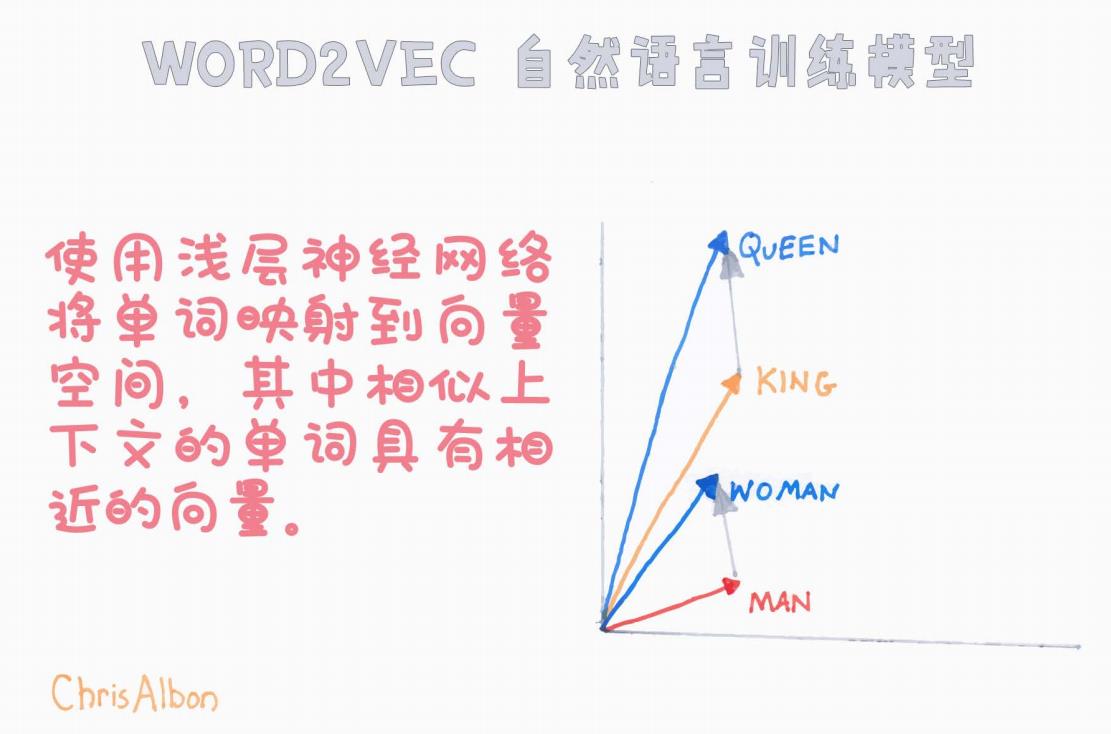

Word2Vec 是由 Google 團隊在 2013 年提出的一種將單詞映射為連續向量的淺層神經網絡模型。

其核心思想是:

將詞語投影到一個低維度的向量空間中,使得語義上相近或語法上相關的詞在向量空間中也接近。

簡單來說,Word2Vec 可以把“王(king)”和“女王(queen)”之間的關系,與“男人(man)”和“女人(woman)”之間的關系用向量差異表示出來,且這些關系在向量空間中保持一致。

從圖中可以看到,

-

King - Man + Woman ≈ Queen

也就是:“男人之于國王,就像女人之于女王”。

這種特性使得 Word2Vec 在 NLP 各種任務中都發揮了巨大的作用,如文本分類、情感分析、機器翻譯、推薦系統等。

三、Word2Vec的兩種訓練方法

Word2Vec 提供了兩種主要的訓練策略:

-

CBOW(Continuous Bag of Words,連續詞袋模型)

-

通過上下文詞(周圍的詞)來預測當前的中心詞。

-

適合小型數據集,訓練速度快。

-

示例:給定句子 "The cat sits on the mat",如果中心詞是 "sits",那么輸入是 "The", "cat", "on", "the", "mat",目標是預測 "sits"。

-

-

Skip-gram

-

通過當前詞預測周圍的上下文詞。

-

更適合大規模數據集,且能夠更好地捕捉稀有詞的信息。

-

示例:給定中心詞 "sits",目標是預測 "The", "cat", "on", "the", "mat"。

-

這兩種方式本質上都是在通過局部上下文來學習詞的分布式表示(distributional representations)。

四、向量空間的語義特性

如圖所示,經過訓練后,單詞被映射到一個高維向量空間,具備如下特性:

-

語義相似性:詞義相近的詞在空間中位置也接近。

-

例子:king 與 queen,man 與 woman。

-

-

語法相似性:詞性相同的詞之間的向量方向相近。

-

例子:復數形式(cars vs. car),時態變化(running vs. run)。

-

-

向量運算:可以用簡單的向量加減表示詞與詞之間的關系。

-

例子:

vector(king) - vector(man) + vector(woman) ≈ vector(queen)。

-

這一點,極大地提升了自然語言處理中理解、推理和生成文本的能力。

五、技術細節:訓練過程

Word2Vec 的訓練過程其實非常高效,主要分為以下幾個步驟:

-

初始化詞向量:為每個詞隨機初始化一個向量。

-

正樣本采樣:根據訓練策略(CBOW或Skip-gram),抽取正樣本。

-

負樣本采樣(Negative Sampling):為了減少計算量,僅更新少量負樣本而不是全部詞匯表。

-

誤差反向傳播:通過淺層神經網絡(通常只有一層),更新詞向量。

-

迭代優化:通過多次遍歷數據集(epoch),使向量逐漸收斂。

最終,得到的詞向量可以直接用于后續各種NLP任務。

六、應用場景

-

文本相似度計算:基于詞向量的余弦相似度評估兩段文本的相似性。

-

推薦系統:基于用戶歷史偏好推薦相關內容(例如基于文章標題、商品描述的Embedding相似性)。

-

情感分析:通過分析詞向量組合,預測評論、帖子中的情感傾向。

-

問答系統:輔助搜索最相關的答案。

-

知識圖譜構建:在向量空間中發現實體之間的潛在關聯。

七、總結

Word2Vec 作為自然語言處理中里程碑式的技術,為后來的各種深度學習模型(如BERT、GPT)奠定了基礎。

即使到今天,理解詞嵌入和向量空間的基本原理,仍然是掌握高級自然語言處理技術的重要前提。

本文通過圖示,簡單直觀地展示了 Word2Vec 如何將單詞映射到向量空間,并體現出詞語之間微妙而豐富的語義關系。

希望能幫助你更好地理解這一經典模型,為后續深入學習打下基礎!

八、參考資料

-

Tomas Mikolov et al. (2013), “Efficient Estimation of Word Representations in Vector Space”

-

Chris Albon, Machine Learning Flashcards

-

《Deep Learning》 — Ian Goodfellow 等

🔔 如果你覺得本文有幫助,歡迎點贊、收藏或留言交流!

)

和 annotate() 方法詳解)

)

---無效區域的處理)