注意:v100顯卡會出現不適配,不推薦使用

?1. 安裝 Docker

ubuntu 22.04 docker 安裝&使用_ubuntu22.04 安裝docker-CSDN博客

?2. 安裝vllm

pip install -U xformers torch torchvision torchaudio triton --index-url https://download.pytorch.org/whl/cu121

pip install modelscope vllm

3. 下載nlp_gte_sentence-embedding_chinese-base開源模型

#模型下載

from modelscope import snapshot_download

model_dir = snapshot_download('iic/nlp_gte_sentence-embedding_chinese-base')4. 部署Dify到本地

git clone https://github.com/langgenius/dify啟動 Dify

-

進入 Dify 源代碼的 Docker 目錄

cd dify/docker -

復制環境配置文件

cp .env.example .env -

啟動 Docker 容器

根據你系統上的 Docker Compose 版本,選擇合適的命令來啟動容器。你可以通過?

$ docker compose version?命令檢查版本,詳細說明請參考?Docker 官方文檔:- 如果版本是 Docker Compose V2,使用以下命令:

docker compose up -d- 如果版本是 Docker Compose V1,使用以下命令:

docker-compose up -d

運行命令后,你應該會看到類似以下的輸出,顯示所有容器的狀態和端口映射,通過這些步驟,你可以在本地成功安裝 Dify。

修改端口:

?如果使用云服務器請先確認暴露端口

以閃電云為例:

sudo apt install rinetd

echo "0.0.0.0 8880 127.0.0.1 9000" > /etc/rinetd.conf

sudo systemctl restart rinetd更新 Dify

進入 dify 源代碼的 docker 目錄,按順序執行以下命令:

cd dify/docker

docker compose down

git pull origin main

docker compose pull

docker compose up -d訪問 Dify

你可以先前往管理員初始化頁面設置設置管理員賬戶:

# 本地環境

http://localhost/install# 服務器環境

http://your_server_ip/install

Dify 主頁面:

# 本地環境

http://localhost# 服務器環境

http://your_server_ip?5. 啟動 vLLM 的 OpenAI 兼容服務

啟動vllm服務?

vllm serve /root/.cache/modelscope/hub/models/iic/nlp_gte_sentence-embedding_chinese-base --port 8000 --dtype float16

6.使用OpenAl-API-compatible插件在內網部署

?7. 知識庫部署Embedding模型

嵌入成功!?

?8. 下載mxbai-rerank-large-v2開源模型

#模型下載

from modelscope import snapshot_download

model_dir = snapshot_download('mixedbread-ai/mxbai-rerank-large-v2')?

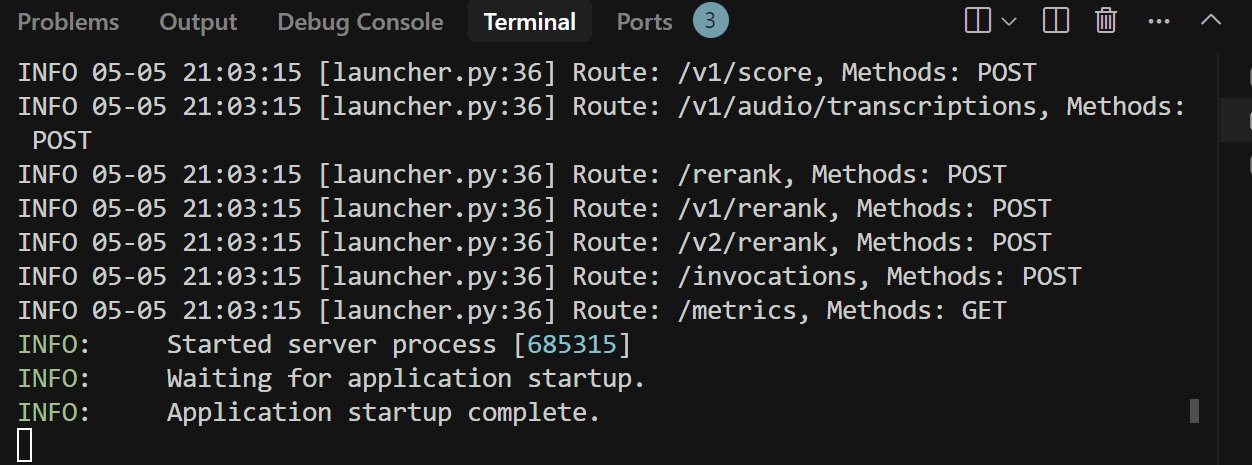

?9. 啟動 vLLM 的 OpenAI 兼容服務

啟動vllm服務?

vllm serve /root/.cache/modelscope/hub/models/mixedbread-ai/mxbai-rerank-large-v2 --port 7000 --dtype float16?

![[ 設計模式 ] | 單例模式](http://pic.xiahunao.cn/[ 設計模式 ] | 單例模式)

)

)