引言

近年來,大語言模型(LLM)如Meta的Llama 2系列憑借其強大的生成和理解能力成為NLP領域的核心工具。然而,直接將通用預訓練模型應用于垂直領域(如醫療、法律、金融)時,常面臨領域知識不足的問題。傳統全參數微調(Fine-tuning)雖能提升領域表現,但存在計算成本高、易過擬合等缺陷。本文介紹如何通過LoRA(Low-Rank Adaptation)技術,對Llama 2進行二次預訓練(Continued Pre-training),實現高效低成本的領域適配。

一、LoRA與二次預訓練的背景

1.1 Llama 2模型簡介

-

Llama 2是Meta于2023年推出的開源大語言模型家族,參數量涵蓋7B/13B/70B。

-

優勢:更強的上下文理解、更低的推理資源需求、支持商業用途。

-

局限性:通用預訓練導致領域知識不足。

1.2 二次預訓練的意義

-

目標:在特定領域語料(如醫學論文、法律文書)上繼續預訓練,使模型吸收領域知識。

-

挑戰:全參數微調需更新數十億參數,GPU顯存占用高,訓練速度慢。

1.3 LoRA技術原理

-

核心思想:通過低秩分解(Low-Rank Decomposition)引入可訓練旁路矩陣,凍結原始參數。

-

優勢:參數效率提升90%+,顯存占用降低,支持多任務切換。

二、實踐步驟:基于LoRA的二次預訓練

2.1 環境準備

python

# 依賴庫

!pip install transformers==4.31.0 peft==0.4.0 accelerate==0.21.0 datasets==2.14.42.2 數據準備

-

領域語料示例(如金融領域):

-

文本清洗:去除HTML標簽、特殊字符

-

分詞:使用Llama 2 Tokenizer

-

格式:每行一個JSON對象,包含"text"字段

-

python

from transformers import AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("meta-llama/Llama-2-7b-hf")def tokenize_function(examples):return tokenizer(examples["text"], truncation=True, max_length=512)2.3 模型加載與LoRA配置

python

from transformers import AutoModelForCausalLM

from peft import LoraConfig, get_peft_modelmodel = AutoModelForCausalLM.from_pretrained("meta-llama/Llama-2-7b-hf",load_in_8bit=True, # 量化加載device_map="auto"

)lora_config = LoraConfig(r=8, # 秩lora_alpha=32,target_modules=["q_proj", "v_proj"], # 目標層lora_dropout=0.05,bias="none",task_type="CAUSAL_LM"

)model = get_peft_model(model, lora_config)

model.print_trainable_parameters() # 輸出可訓練參數占比(通常<1%)2.4 訓練配置

python

from transformers import TrainingArguments, Trainertraining_args = TrainingArguments(output_dir="./results",per_device_train_batch_size=4,gradient_accumulation_steps=8, # 顯存不足時增大此值warmup_steps=500,max_steps=10000,learning_rate=3e-4,fp16=True,logging_steps=100,save_steps=1000,optim="adamw_torch"

)trainer = Trainer(model=model,args=training_args,train_dataset=tokenized_datasets,data_collator=lambda data: {'input_ids': torch.stack([f['input_ids'] for f in data])}

)2.5 訓練與模型合并

python

# 啟動訓練

trainer.train()# 合并LoRA權重到原模型

merged_model = model.merge_and_unload()

merged_model.save_pretrained("llama2-finance-lora")三、效果評估與對比

3.1 評估指標

-

困惑度(Perplexity):領域語料的PPL降低20-40%

-

領域QA準確率:在金融QA測試集上提升15%+

-

訓練成本對比(7B模型):

方法 GPU顯存 訓練時間 磁盤占用 全參數微調 80GB+ 24h 13GB LoRA 24GB 12h 0.2GB

3.2 生成示例

輸入:

"當前美聯儲加息對A股市場的影響主要是通過..."

原始Llama 2輸出:

"作為AI模型,我無法預測金融市場..."

LoRA微調后輸出:

"美聯儲加息通常導致美元走強,可能引發外資流出A股市場,短期內對成長股估值形成壓力,但長期影響需結合國內貨幣政策分析..."

四、注意事項與擴展

-

數據質量:領域語料需充足(建議>1B tokens)且多樣化

-

超參調優:嘗試不同的秩(r=4/8/16)、學習率(1e-5~3e-4)

-

結合其他技術:可與Prompt Tuning、RLHF結合使用

五、結論

通過LoRA對Llama 2進行二次預訓練,開發者能以極低的計算成本實現領域適配。該方法在保留原模型通用能力的同時,顯著提升領域任務表現,為中小企業部署垂直領域大模型提供了可行方案。

最后

我還是那句話“最先掌握AI的人,將會比較晚掌握AI的人有競爭優勢”。

我意識到有很多經驗和知識值得分享給大家,也可以通過我們的能力和經驗解答大家在人工智能學習中的很多困惑,所以在工作繁忙的情況下還是堅持各種整理和分享。但苦于知識傳播途徑有限,很多互聯網行業朋友無法獲得正確的資料得到學習提升,故此將并將重要的AI大模型資料包括AI大模型入門學習思維導圖、精品AI大模型學習書籍手冊、視頻教程、實戰學習等錄播視頻免費分享出來。

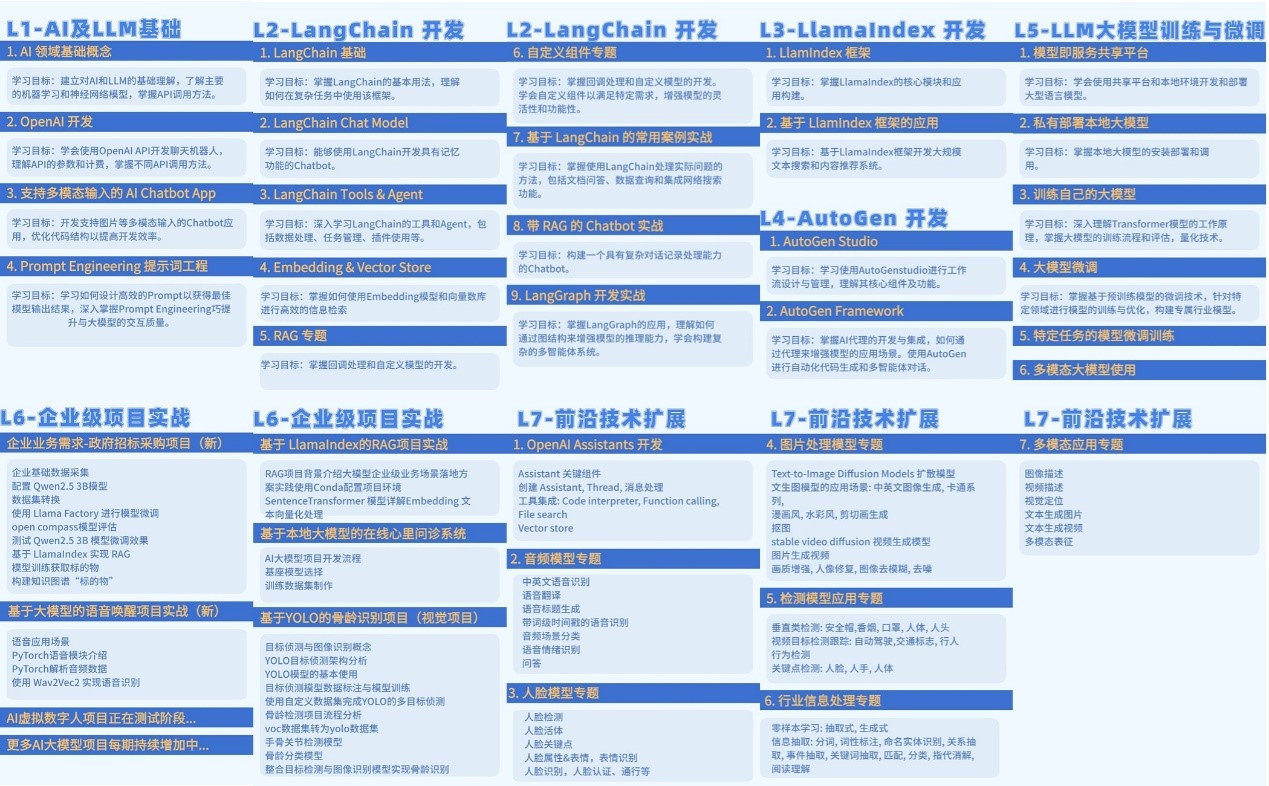

1、大模型全套的學習路線

學習大型人工智能模型,人工智能大模型學習路線圖L1~L7所有階段,需要系統的方法和持續的努力。既然要系統的學習大模型,那么學習路線是必不可少的,下面的這份路線能幫助你快速梳理知識,形成自己的體系。

2. 大模型視頻教程

對于很多自學或者沒有基礎的同學來說,這些純文字類的學習教材會覺得比較晦澀難以理解,因此,我們提供了豐富的大模型視頻教程,以動態、形象的方式展示技術概念,幫助你更快、更輕松地掌握核心知識。

3. 大模型項目實戰

學以致用?,當你的理論知識積累到一定程度,就需要通過項目實戰,在實際操作中檢驗和鞏固你所學到的知識,同時為你找工作和職業發展打下堅實的基礎。

?

?

?

?

Python爬蟲入門:從HTTP協議解析到豆瓣電影數據抓取實戰)

)

游戲)