Qwen2 RotaryEmbedding 位置編碼僅僅是第一層有嗎,還是全部層都有

Qwen2 模型中的 Rotary Embedding(旋轉位置編碼)是應用于所有 Transformer 層 的,而非僅第一層。

1. Transformer 架構的核心邏輯

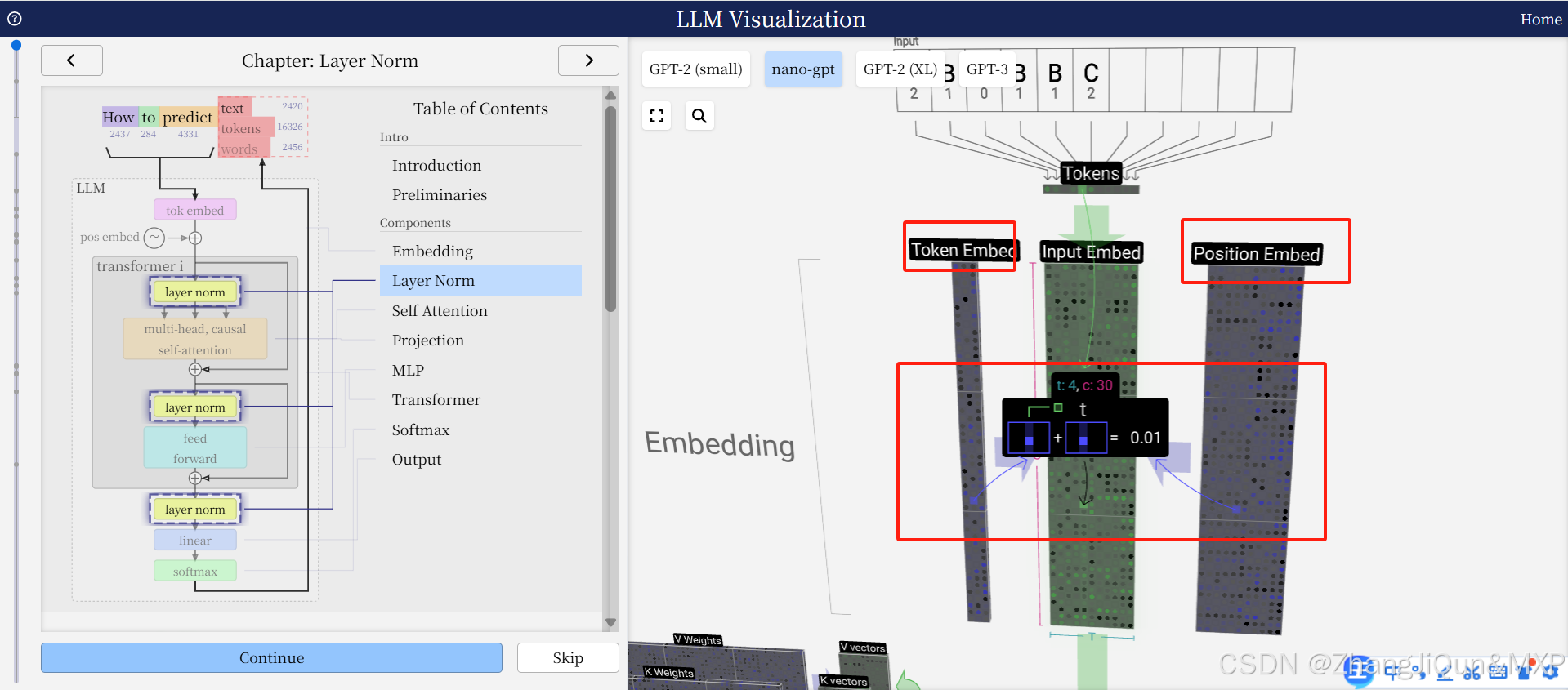

Qwen2 基于 Decoder-only Transformer 架構,而位置編碼(如 Rotary Embedding)的核心作用是為模型提供序列中 token 的位置信息,使自注意力機制能夠感知 token 的相對位置關系。在標準 Transformer 設計中,每一層的自注意力模塊都需要位置編碼,否則無法區分不同位置的 token,導致模型無法理解序列的順序依賴。

2. 參考內容的間接佐證

- 摘要1提到 Qwen 系列采用“Dense Decoder-only Transformer 結構”,并支持“80層隱藏層”。結合 Transformer 通用設計,所有隱藏層的自注意力模塊都需要位置編碼。

- 摘要2中 Qwen2.5-VL 的改進(如 MRoPE、窗口注意力)也表明

)

)

簡單命令 多實踐以及相關文件管理命令)

)