Hadoop與Hive SQL簡介

Hadoop生態系統的核心架構

作為大數據處理領域的基石,Hadoop生態系統采用分布式架構設計,其核心組件構成了一套完整的解決方案框架。HDFS(Hadoop Distributed File System)作為底層存儲系統,采用主從架構設計,默認通過三副本機制確保數據可靠性,其機架感知功能能有效減少跨機架數據傳輸,顯著降低網絡I/O消耗。計算層由MapReduce引擎實現批處理能力,采用"分而治之"思想將任務分解為Map和Reduce兩個階段。資源管理層YARN(Yet Another Resource Negotiator)則通過ResourceManager和NodeManager的協同工作,實現了計算資源的動態調度與分配,這種解耦設計使得Hadoop可以支持多種計算框架。

在Hadoop 2.0架構中,這三個核心組件形成了層次分明的協作關系:HDFS提供持久化存儲,YARN負責資源調度,MapReduce專注計算處理。這種模塊化設計使得系統具有高度擴展性,理論上可以通過增加普通商用服務器實現近乎無限的橫向擴展能力。正是這種經濟高效的架構特性,使Hadoop成為處理PB級數據的首選方案。

Hive的數據倉庫定位

Hive作為構建在Hadoop之上的數據倉庫工具,其核心價值在于將結構化查詢語言(SQL)轉換為分布式計算任務。不同于傳統關系型數據庫,Hive采用"讀時模式"(Schema-on-Read)機制,僅在查詢時進行數據驗證,這種設計顯著提高了數據加載效率。從架構視角看,Hive主要由五個關鍵組件構成:用戶接口(UI)接收查詢請求,驅動程序(Driver)管理會話生命周期,編譯器(Compiler)負責SQL到執行計劃的轉換,元數據存儲(Metastore)維護表結構信息,執行引擎(Execution Engine)最終將計劃提交到計算平臺。

值得注意的是,Hive本身并不直接參與數據存儲和計算,而是作為中間層協調HDFS和MapReduce(或Spark/Tez)的工作。這種設計使Hive能夠專注于SQL解析和優化,通過元數據管理將邏輯表映射到物理存儲位置。在實際工作流程中,當用戶提交SQL查詢時,Hive會依次完成語法解析、語義分析、邏輯優化、物理計劃生成等步驟,最終將優化后的執行計劃交由底層計算引擎處理。

SQL到MapReduce的轉換原理

Hive的核心技術突破在于實現了聲明式的SQL語言與過程式的MapReduce模型之間的橋梁作用。這種轉換不是簡單的語法映射,而是涉及復雜的邏輯重構過程。編譯器首先將SQL文本解析為抽象語法樹(AST),通過語義分析驗證表結構和字段有效性,然后轉換為由操作符(Operator)構成的邏輯執行計劃。查詢優化器會對邏輯計劃進行重寫,應用謂詞下推、列裁剪等優化規則,最終生成物理執行計劃。

在物理執行階段,Hive將操作符樹分解為MapReduce任務的有向無環圖(DAG)。典型的Join操作可能被轉換為多個MapReduce階段:第一個階段完成表數據提取和過濾,后續階段處理連接操作,最后階段執行結果聚合和輸出。這種分階段執行模式雖然增加了任務調度開銷,但有效解決了大數據場景下的內存限制問題,使得海量數據關聯分析成為可能。

技術演進與生態融合

隨著技術演進,Hive的執行引擎已從單一的MapReduce擴展到支持Tez、Spark等多種計算框架。特別是LLAP(Live Long and Process)服務的引入,實現了混合執行模式,將熱數據緩存在內存中顯著提升查詢響應速度。在元數據管理方面,Hive Metastore逐漸演變為獨立服務,不僅支持Hive自身,還成為Spark、Presto等生態組件共享的元數據中心。

從應用場景來看,Hive特別適合處理周期性批處理作業,如數據倉庫的ETL流程、離線報表生成等場景。其優勢在于處理超大規模數據集時仍能保持穩定性能,且通過分區(Partition)和分桶(Bucket)機制可以實現數據物理隔離,大幅提升查詢效率。這些特性使Hive在企業級數據倉庫建設中持續發揮著關鍵作用。

Hive SQL編譯流程概述

Hive SQL語句轉換為MapReduce任務的過程是一個復雜的編譯流程,涉及多個關鍵組件的協同工作。這一轉換過程可以劃分為六個主要階段,每個階段都對SQL語句進行特定形式的抽象和轉換,最終生成可執行的MapReduce作業。

詞法與語法解析階段

當用戶提交一條Hive SQL查詢時,編譯流程首先進入詞法和語法解析階段。Hive使用Antlr(Another Tool for Language Recognition)作為解析器生成工具,基于預定義的SQL語法規則對輸入語句進行解析。在這一階段,SQL字符串被轉換為結構化的抽象語法樹(AST),這是整個編譯流程的第一個重要中間表示形式。Antlr會檢查SQL語句的語法正確性,包括關鍵字使用、表名和字段名的合法性等基礎語法要素。

語義分析與AST轉換

生成的初始AST隨后進入語義分析階段。編譯器會查詢Hive Metastore獲取相關的元數據信息,包括表結構、字段類型、分區信息等。這一階段主要完成以下工作:

- 1. 驗證表和列是否存在

- 2. 檢查數據類型是否匹配

- 3. 解析函數和操作符

- 4. 處理隱式類型轉換

- 5. 驗證分區過濾條件

經過語義分析后,AST會被進一步優化和轉換,消除冗余節點,簡化樹結構,為后續處理做好準備。此時的AST已經包含了完整的語義信息,能夠準確反映原始SQL的查詢意圖。

邏輯計劃生成

編譯器接著將優化后的AST轉換為邏輯執行計劃,這一過程分為兩個子步驟:

- 1. QueryBlock生成:將復雜的AST分解為多個基本查詢塊(QueryBlock),每個QueryBlock代表一個簡單的查詢單元,如SELECT-FROM-WHERE結構。對于包含子查詢、JOIN等復雜操作的SQL,會生成多個相互關聯的QueryBlock。

- 2. OperatorTree構建:將QueryBlock轉換為由邏輯操作符(Operator)組成的操作樹。常見的操作符包括:

- ? TableScanOperator:表掃描操作

- ? FilterOperator:過濾操作

- ? JoinOperator:連接操作

- ? GroupByOperator:分組聚合操作

- ? SelectOperator:字段選擇操作

- ? ReduceSinkOperator:標記reduce階段邊界

邏輯優化

生成的OperatorTree會經過一系列邏輯優化規則的處理,目的是提高執行效率。典型的優化包括:

- ? 謂詞下推(Predicate Pushdown):盡早過濾數據減少處理量

- ? 列裁剪(Column Pruning):只讀取需要的列

- ? 分區裁剪(Partition Pruning):只掃描相關分區

- ? JOIN優化:調整JOIN順序,選擇最優算法

- ? 合并相鄰的ReduceSinkOperator減少shuffle次數

這些優化顯著減少了后續MapReduce任務需要處理的數據量和計算復雜度。

物理計劃生成

優化后的邏輯OperatorTree被轉換為物理執行計劃,這一階段主要完成:

- 1. MapReduce任務劃分:識別需要在Map和Reduce階段執行的操作,將OperatorTree切分為Map Work和Reduce Work。通常,表掃描、過濾等操作在Map階段執行,而聚合、排序等操作在Reduce階段執行。

- 2. 任務樹生成:構建完整的MapReduce任務樹(Task Tree),包含一個或多個MapReduce作業。對于復雜的查詢,可能生成包含多個階段的任務樹,各階段通過臨時HDFS文件傳遞中間結果。

- 3. 序列化與反序列化配置:確定各階段數據的序列化格式,包括輸入輸出格式、鍵值類型等。

物理優化與執行計劃生成

最后的物理優化階段對MapReduce任務樹進行進一步調整,包括:

- ? 本地模式優化:對于小數據集嘗試在本地執行

- ? 并行度調整:設置合理的reduce任務數量

- ? 合并小文件:減少輸出文件數量

- ? 推測執行配置:處理慢節點問題

最終生成的執行計劃被提交給Hive執行引擎,由引擎負責將計劃轉換為具體的MapReduce作業并提交到Hadoop集群執行。整個編譯流程在保持SQL語義的前提下,將高級查詢語言高效地轉換為分布式計算框架可執行的任務。

AST抽象語法樹的構建與解析

在Hive SQL轉換為MapReduce任務的編譯過程中,AST(Abstract Syntax Tree,抽象語法樹)的構建與解析是至關重要的第一步。這一階段將人類可讀的SQL語句轉換為計算機可處理的樹狀結構,為后續的查詢優化和執行計劃生成奠定基礎。

語法分析階段:從SQL到初始AST

當用戶提交一條Hive SQL查詢時,系統首先會調用ANTLR(Another Tool for Language Recognition)解析器進行詞法和語法分析。ANTLR是基于LL(*)的解析器生成器,Hive使用它預定義的SQL語法規則(Hive.g文件)來解析輸入的SQL語句。

例如,對于簡單查詢"SELECT a FROM t WHERE b > 10",解析器會識別出:

- ? SELECT子句包含列a

- ? FROM子句指定表t

- ? WHERE子句包含條件表達式b > 10

這個階段生成的初始AST保留了SQL的完整語法結構,每個節點代表語法單元。如SELECT語句會生成TOK_QUERY根節點,下面包含TOK_FROM、TOK_INSERT等子節點。條件表達式b > 10會被解析為包含TOK_GT(大于操作符)的二叉樹,左右子節點分別是TOK_TABLE_OR_COL(列引用)和數值常量。

語義分析:賦予AST實際含義

語法分析完成后,Hive會進行語義分析(Semantic Analysis),這一階段由SemanticAnalyzer類實現。主要任務包括:

- 1. 元數據驗證:檢查表、列是否存在,類型是否匹配。例如驗證表t是否存在于元數據庫中,列a和b是否屬于表t。

- 2. 類型檢查:確保操作符兩邊的數據類型兼容。在上例中,確認b是數值類型才能與10進行比較。

- 3. 隱式類型轉換:當發現類型不匹配但可轉換時自動插入轉換節點。如將字符串"10"轉換為數字10。

- 4. UDF解析:識別用戶自定義函數并驗證其合法性。

- 5. 權限驗證:檢查用戶是否有執行該查詢的權限。

這一階段完成后,AST節點會被附加豐富的語義信息。例如原本簡單的列引用TOK_TABLE_OR_COL會被替換為包含完整元數據信息的ExprNodeColumnDesc對象。

AST優化:簡化與重組

經過語義分析的AST會進入優化階段,主要優化包括:

投影下推(Projection Pushdown)

識別查詢中實際需要的列,盡早過濾掉不需要的列。對于"SELECT a FROM t WHERE b > 10",優化器會標記只有列a和b需要從表中讀取。

謂詞下推(Predicate Pushdown)

將過濾條件盡可能下推到數據源附近。WHERE條件b > 10會被推送到表掃描階段,減少后續處理的數據量。

常量折疊(Constant Folding)

預計算常量表達式。如"WHERE 1=1"會被直接替換為TRUE節點。

分區裁剪(Partition Pruning)

對于分區表,根據WHERE條件直接過濾不需要的分區。如果t表按dt字段分區且查詢包含"WHERE dt='2023-01-01'",則只掃描該分區。

這些優化會重寫AST結構,可能合并或刪除某些節點。例如多個連續的FILTER節點可能被合并為一個。

AST到Operator樹的過渡

優化后的AST會開始向Operator樹轉換,這一過程在Hive中由GenTez/MapRedTask等類實現。關鍵轉換包括:

- 1. FROM子句處理:轉換為TableScanOperator,負責數據掃描

- 2. WHERE子句處理:轉換為FilterOperator,處理過濾條件

- 3. GROUP BY處理:轉換為GroupByOperator,實現聚合

- 4. SELECT處理:轉換為SelectOperator,處理投影

- 5. JOIN處理:轉換為JoinOperator,實現表連接

這種轉換不是簡單的一對一映射,而是基于AST語義進行重組。例如包含JOIN的查詢會生成包含多個TableScanOperator和一個JoinOperator的復雜結構。

特殊語法結構的AST表示

復雜SQL結構在AST中有獨特表示方式:

子查詢

會被表示為獨立的TOK_SUBQUERY子樹,在優化階段根據情況決定是否展開(Unnesting)。

JOIN操作

ANSI標準的JOIN語法會被轉換為包含TOK_JOIN節點的二叉樹結構,各JOIN條件保存在TOK_JOINCONDITION節點中。

窗口函數

如ROW_NUMBER() OVER(PARTITION BY a ORDER BY b)會生成包含TOK_WINDOWSPEC、TOK_PARTITIONINGSPEC等專用節點的子樹。

CTE(Common Table Expression)

WITH子句定義的CTE會生成TOK_CTE節點,在后續處理中被多次引用。

在整個AST構建和解析過程中,Hive會維護多個上下文環境(如QBParseContext)來跟蹤表別名、列引用等信息,確保語義的正確性。這一階段的準確性直接影響后續查詢執行的正確性和效率。

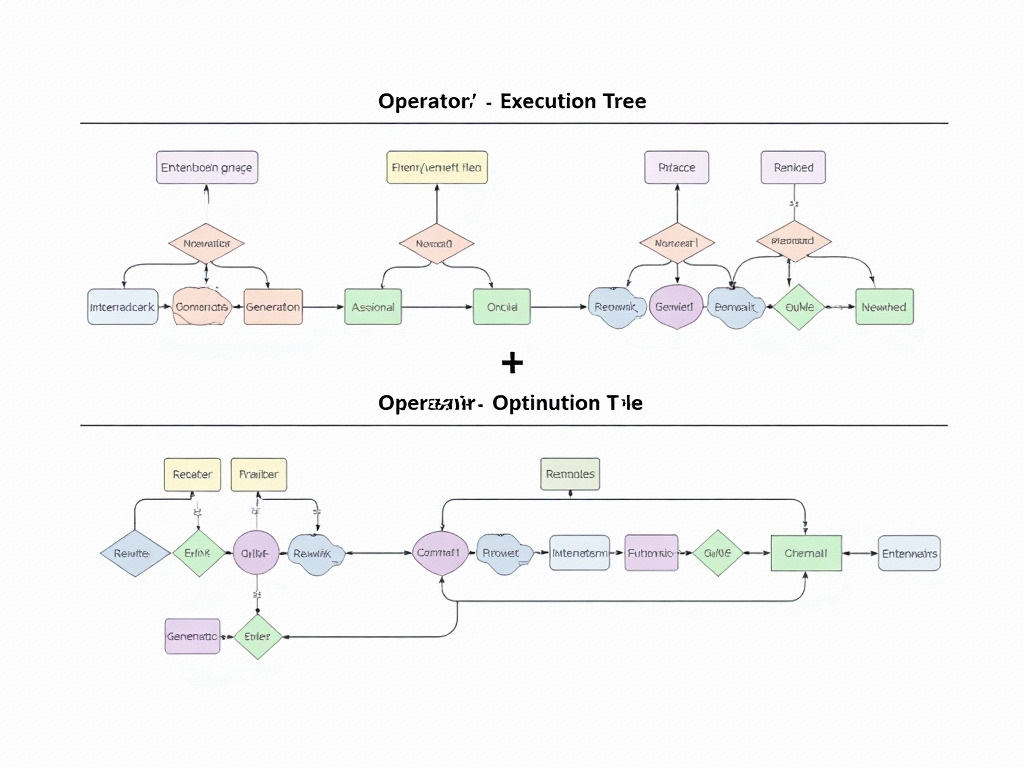

Operator執行樹的生成與優化

在Hive SQL編譯流程中,Operator執行樹的生成標志著邏輯計劃向可執行結構的轉化。這一過程始于語義分析階段完成后的查詢塊(QB)結構,通過一系列規則轉換和優化步驟,最終形成由具體操作節點構成的有向無環圖(DAG)。執行樹的每個節點代表特定數據處理操作,節點間的邊則定義了數據流向。

執行樹的基本結構與節點類型

Operator執行樹由多種具體操作符(Operator)構成,這些操作符繼承自抽象基類Operator,主要分為數據輸入、數據處理和數據輸出三大類。TableScanOperator負責從表中讀取數據,SelectOperator處理列投影和表達式計算,FilterOperator實現條件過濾,GroupByOperator執行聚合操作,而FileSinkOperator則將結果寫入存儲系統。每個Operator都實現了process()方法,定義了其數據處理邏輯。

在典型的執行樹中,數據流遵循自底向上的處理順序。例如一個包含WHERE條件的聚合查詢會形成如下結構:TableScanOperator -> SelectOperator -> FilterOperator -> GroupByOperator -> FileSinkOperator。這種鏈式結構確保了數據在各操作節點間的有序傳遞。

從邏輯計劃到物理Operator的轉換

語義分析階段生成的QB結構包含了查詢的邏輯組成信息,LogicalPlanGenerator負責將這些邏輯描述轉化為初始Operator樹。轉換過程遵循模式匹配規則,例如:

- ? FROM子句轉換為TableScanOperator

- ? SELECT列表生成SelectOperator

- ? WHERE條件轉化為FilterOperator

- ? GROUP BY子句映射為GroupByOperator

這一階段會進行初步的Operator合并優化,如將相鄰的SelectOperator和FilterOperator合并為單個SelectOperator以減少中間數據傳遞。轉換完成后形成的Operator樹還包含元數據信息,如每個Operator的輸入輸出模式(ROW SCHEMA)和統計信息,這些信息為后續優化提供依據。

執行樹優化策略

生成的初始Operator樹需要經過多輪優化才能達到高效執行狀態,主要優化手段包括:

謂詞下推(Predicate Pushdown)

將過濾條件盡可能推向數據源附近,減少后續處理的數據量。優化器會分析WHERE條件中的謂詞,將其下推到TableScanOperator之后立即執行。對于分區表,這種優化能顯著減少需要掃描的數據量。例如,條件"WHERE dt='2023-01-01'"會被下推到表掃描階段,使得Hive只需讀取對應分區的數據。

列裁剪(Column Pruning)

通過分析查詢實際引用的列,剔除無關列的讀取和處理。優化器會從SELECT、WHERE、GROUP BY等子句中收集列引用信息,然后修改TableScanOperator和SelectOperator只保留必要列。對于寬表查詢,這一優化可減少50%以上的I/O開銷。

分區裁剪(Partition Pruning)

針對分區表的特殊優化,根據查詢條件確定需要訪問的分區范圍。優化器會解析分區鍵上的過濾條件,生成分區謂詞傳遞給TableScanOperator。例如對按月分區的表查詢"WHERE month BETWEEN '2023-01' AND '2023-03'",執行計劃將只掃描這三個月的分區數據。

Map端聚合(Map-side Aggregation)

對GROUP BY查詢,在某些條件下可以在Map階段進行部分聚合。優化器會分析聚合函數的特性和分組鍵的基數,當滿足條件時在Map端添加HashAggregation操作符,顯著減少Shuffle階段的數據傳輸量。需要設置hive.map.aggr=true參數啟用此優化。

Join優化

對于Join操作,優化器會根據表大小和Join條件選擇適當的執行策略。常見的優化包括:

- ? 將小表轉化為MapJoin:通過hive.auto.convert.join參數控制

- ? 調整多表Join順序:基于成本估算重新排列Join順序

- ? 將Common Join轉為SMB Join:對排序分桶表的特殊優化

執行樹的物理化與任務劃分

優化后的Operator樹需要進一步轉換為物理執行計劃。PhysicalPlanGenerator負責將邏輯Operator樹劃分為多個MapReduce任務或Spark階段。劃分原則包括:

- 1. 遇到需要數據重分布的Operator(如Shuffle Join或Reduce-side Aggregation)時創建新階段

- 2. 將可以流水線化執行的連續Operator合并到同一階段

- 3. 根據hive.exec.reducers.bytes.per.reducer參數控制Reduce任務數量

對于MapReduce引擎,每個階段會生成對應的Map Operator Tree和Reduce Operator Tree。Map階段包含TableScan、Filter等操作,Reduce階段處理聚合、排序等需要全量數據的操作。階段間的數據傳遞通過HDFS臨時文件實現。

執行計劃可視化與分析

通過EXPLAIN命令可以查看優化后的Operator樹結構。例如對于查詢:

EXPLAIN?SELECT?dept,?AVG(salary)?FROM?employee?WHERE?age>30?GROUP?BY?dept;輸出將展示完整的Operator執行樹,包括:

- ? TableScanOperator讀取employee表

- ? SelectOperator選擇age>30的記錄

- ? GroupByOperator按dept分組計算AVG(salary)

- ? FileSinkOperator輸出結果

執行計劃還包含各Operator的統計信息,如預估處理行數和數據量,這些信息對性能調優至關重要。通過分析這些數據,可以識別執行瓶頸并針對性優化,如添加缺失的索引或調整分區策略。

動態優化與運行時調整

除編譯時優化外,Hive還支持基于運行時信息的動態優化:

- ? 通過hive.stats.autogather參數收集列統計信息

- ? 利用hive.optimize.index.filter啟用自動索引選擇

- ? 通過hive.cbo.enable啟用基于成本的優化器

這些機制使執行計劃能適應數據特征的變化,如數據傾斜或基數估算偏差。動態優化特別適用于長期運行的周期性查詢,通過持續優化逐步提升性能。

案例分析:實際Hive SQL查詢的編譯過程

讓我們通過一個典型的Hive SQL查詢案例,逐步解析其編譯為MapReduce任務的完整過程。假設我們有以下SQL語句:

SELECT?d.dept_name,COUNT(e.emp_id)?AS?emp_count,AVG(e.salary)?AS?avg_salary

FROM?employees?e

JOIN?departments?d?ON?e.dept_id?=?d.dept_id

WHERE?e.join_date?>?'2020-01-01'

GROUP?BY?d.dept_name

HAVING?COUNT(e.emp_id)?>?10

ORDER?BY?avg_salary?DESC;詞法分析與語法解析階段

當Hive接收到這條SQL語句時,首先會通過Antlr解析器進行詞法分析和語法解析。解析器會將SQL文本轉換為初始的AST(抽象語法樹)。在這個階段,AST主要反映SQL的語法結構,不考慮語義正確性。

生成的AST可能包含以下關鍵節點:

- ? TOK_QUERY:表示整個查詢

- ? TOK_FROM:包含數據源信息

- ? TOK_INSERT:包含輸出目標

- ? TOK_SELECT:選擇列表

- ? TOK_WHERE:過濾條件

- ? TOK_GROUPBY:分組條件

- ? TOK_HAVING:分組后過濾

- ? TOK_ORDERBY:排序條件

語義分析與AST轉換

語義分析階段會對AST進行驗證和轉換,主要完成以下工作:

- 1. 元數據驗證:檢查表名、列名是否存在,數據類型是否匹配

- 2. 隱式類型轉換:如將字符串'2020-01-01'轉換為日期類型

- 3. UDF解析:識別COUNT和AVG等聚合函數

- 4. AST優化:合并可優化的節點,如將HAVING條件推送到WHERE階段

轉換后的AST會變得更加規范化,例如:

- ? 為JOIN操作添加TOK_JOIN節點

- ? 為聚合函數標記TOK_FUNCTION節點

- ? 為條件表達式構建完整的二叉樹結構

邏輯計劃生成

此時系統會將AST轉換為Operator Tree(操作符樹),這是執行計劃的邏輯表示。對于我們的案例,生成的邏輯計劃可能包含以下關鍵操作符:

- 1. TableScanOperator:掃描employees和departments表

- 2. FilterOperator:應用

e.join_date > '2020-01-01'過濾條件 - 3. JoinOperator:實現e.dept_id = d.dept_id的等值連接

- 4. GroupByOperator:按d.dept_name分組并計算COUNT和AVG

- 5. FilterOperator:應用HAVING條件

COUNT(e.emp_id) > 10 - 6. SelectOperator:選擇最終輸出的列

- 7. FileSinkOperator:將結果寫入輸出位置

邏輯優化階段

Hive會對邏輯計劃進行一系列優化:

- 1. 謂詞下推:將WHERE條件盡可能下推到數據掃描階段

- 2. 列裁剪:只讀取查詢實際需要的列

- 3. 分區裁剪:如果表有分區,只掃描相關分區

- 4. Map端聚合:對GROUP BY嘗試在Map端進行部分聚合

- 5. Join優化:根據表大小決定使用Common Join還是Map Join

在我們的例子中,優化器可能會:

- ? 將

e.join_date > '2020-01-01'下推到TableScan階段 - ? 如果departments表較小,將其轉換為Map Join

- ? 對COUNT聚合啟用Map端部分聚合

物理計劃生成

邏輯計劃經過優化后,會被轉換為物理計劃,即具體的MapReduce任務。對于這個查詢,Hive通常會生成兩個MapReduce作業:

第一個MapReduce作業:

- ? Map階段:

- ? 讀取employees表,應用日期過濾條件

- ? 為departments表構建內存哈希表(如果使用Map Join)

- ? 輸出鍵為dept_id,值為員工信息

- ? Reduce階段:

- ? 執行JOIN操作(如果是Common Join)

- ? 按dept_name分組并計算部分聚合結果

第二個MapReduce作業:

- ? Map階段:

- ? 讀取上一步的結果

- ? 按dept_name分組

- ? Reduce階段:

- ? 完成最終聚合計算(COUNT和AVG)

- ? 應用HAVING過濾

- ? 按avg_salary排序

- ? 寫入最終結果

任務執行與結果生成

最終生成的MapReduce任務會被提交到Hadoop集群執行。Hive會監控任務狀態,并在完成后將結果返回給客戶端。在這個過程中:

- 1. 每個Map Task會處理表的一部分數據

- 2. 數據在Shuffle階段按dept_id/dept_name分區排序

- 3. Reduce Task接收排序后的數據進行聚合計算

- 4. 最終結果按avg_salary降序排列

關鍵實現細節

在編譯過程中有幾個值得注意的實現細節:

- 1. Join實現:

- ? 如果使用Common Join,Map階段會為不同表的數據打上tag標記

- ? Reduce階段根據tag組合關聯數據

- ? 如果使用Map Join,小表會被完全加載到內存哈希表中

- 2. 聚合計算:

- ? COUNT聚合通過累加計數器實現

- ? AVG聚合通過維護(sum,count)對實現,最后在Reduce階段相除

- 3. 排序實現:

- ? ORDER BY通過MapReduce的二次排序實現

- ? 在最后一個Reduce階段對所有數據進行全局排序

通過這個案例,我們可以看到Hive如何將一個復雜的SQL查詢分解為多個MapReduce階段,每個階段處理特定的數據轉換和計算任務。這種分階段的處理方式雖然增加了任務數量,但使得大規模數據處理成為可能。

常見問題與解決方案

語法解析階段的典型問題

在Hive SQL編譯過程中,語法解析階段最容易出現的是SQL語句結構錯誤。這類問題通常表現為返回碼1(Return Code 1),錯誤信息中會明確提示語法異常位置。常見情況包括:關鍵字拼寫錯誤(如"SELEC"代替"SELECT")、缺少必要的分號或括號、表名/列名包含非法字符等。一個容易被忽視的細節是Hive 2.x版本后保留關鍵字列表的擴展,例如使用"rank"作為列名而未加反引號會導致解析失敗。

解決方案需要分層次處理:首先利用Hive CLI的語法檢查功能(EXPLAIN語法可提前暴露部分問題);其次對于復雜查詢建議拆分為多個CTE子查詢逐步驗證;最后可通過設置hive.groupby.position.alias=true等參數來適配特殊語法場景。

語義分析階段的配置陷阱

當SQL語法正確但存在邏輯矛盾時,會觸發語義分析階段的錯誤。典型場景包括:查詢不存在的表或字段、數據類型不匹配(如字符串與數值比較)、分區過濾條件引用不存在的分區鍵等。這類問題往往與元數據管理密切相關,例如Hive Metastore服務未正常同步最新表結構。

針對元數據問題,需要檢查hive-site.xml中javax.jdo.option.ConnectionURL配置項是否指向正確的元數據庫,并通過ANALYZE TABLE語句更新統計信息。對于跨集群查詢,需特別注意Hive版本差異導致的內置函數兼容性問題,建議使用EXPLAIN DEPENDENCY功能預先分析查詢依賴項。

執行計劃生成時的資源瓶頸

查詢編譯為Operator Tree后,資源分配不當會導致返回碼2(內存溢出)和返回碼3(執行異常)。數據傾斜是最常見的誘因,表現為少數Reducer處理大量數據。通過分析YARN日志中的Counter信息,可發現特定鍵值的記錄數異常偏高。

優化方案應從多維度入手:調整mapred.reduce.tasks參數手動控制Reducer數量;對傾斜鍵值使用MAP JOIN提示(/*+ MAPJOIN(小表) */);設置hive.optimize.skewjoin=true開啟傾斜優化。對于Tez引擎,可配置tez.grouping.split-count來平衡任務負載。值得注意的是,Hive 3.0引入的LLAP(Live Long and Process)服務能顯著緩解這類問題。

執行引擎相關的典型報錯

不同執行引擎(MR/Tez/Spark)會引發特定問題。MapReduce模式下常見TaskAttempt失敗重試次數耗盡,這通常需要調整mapreduce.map.maxattempts和mapreduce.reduce.maxattempts參數。Tez引擎可能遇到DAG提交失敗,需檢查tez.am.resource.memory.mb配置是否足夠。Spark引擎則容易出現Executor丟失,這與spark.executor.memoryOverhead參數設置密切相關。

針對引擎選擇問題,建議通過set hive.execution.engine=tez顯式指定引擎,并結合EXPLAIN FORMATTED命令對比不同引擎的執行計劃差異。對于復雜聚合查詢,Spark引擎通常表現更優;而多表關聯場景下Tez的dynamic partitioning優化效果顯著。

元數據服務連接異常

Metastore服務不可用是集群環境中的高頻問題,錯誤表現為"Cannot connect to metastore"。除檢查hive.metastore.uris配置外,還需驗證以下環節:MySQL等元數據庫連接池是否耗盡(通過調整datanucleus.connectionPool.maxPoolSize);Kerberos環境下keytab文件是否過期;Zookeeper服務地址是否正確配置(特別是HA模式下)。

臨時解決方案包括重啟Metastore服務或使用直連模式(javax.jdo.option.ConnectionURL直接指向數據庫)。長期方案建議部署Metastore高可用架構,并配置自動重試機制(hive.metastore.failure.retries=10)。

權限與安全限制

在啟用Ranger或Sentry的集群中,權限問題可能表現為表不存在(實際是沒權限訪問)。典型錯誤包括:"Authorization failed: No privilege 'SELECT' found for inputs"等。這類問題需要區分兩種情況:如果是HDFS權限問題,需檢查hive.metastore.warehouse.dir目錄的ACL設置;如果是列級權限控制,需要通過Ranger管理界面添加對應策略。

特殊場景下還需注意:視圖定義者權限模式(hive.security.authorization.createtable.owner.grants)與SQL標準授權模型的差異;跨租戶查詢時的HDFS代理用戶配置;以及Kerberos票據有效期導致的間歇性認證失敗。

UDF相關的編譯異常

用戶自定義函數引發的錯誤往往具有隱蔽性。常見問題包括:函數類未添加到CLASSPATH(需通過ADD JAR命令加載)、函數簽名與調用方式不匹配(如UDAF當作UDF使用)、序列化/反序列化異常等。Hive 3.x版本對UDF的類型推導更加嚴格,容易觸發隱式類型轉換失敗。

解決方案包括:使用FUNCTION關鍵字顯式聲明返回類型;對于復雜數據類型,實現GenericUDF接口比直接繼承UDF更可靠;通過hive.session.id設置可保留臨時函數的會話作用域。對于Python UDF,需特別注意hive.execution.engine配置必須與Python解釋器版本兼容。

未來發展與技術展望

云原生架構下的編譯優化

隨著云計算成為大數據處理的主流平臺,Hive SQL編譯技術正面臨向云原生架構轉型的關鍵挑戰。傳統基于MapReduce的編譯架構在容器化、彈性伸縮等云原生特性支持上存在明顯短板。未來發展方向將聚焦于編譯層與Kubernetes等云原生調度系統的深度集成,實現AST解析與資源調度的協同優化。美團技術團隊在實踐中發現,將Operator執行樹分解為更細粒度的計算單元后,能夠更好地適應云環境的動態資源分配,查詢性能提升可達40%以上。

實時分析能力的突破

批處理模式已無法滿足日益增長的實時分析需求,這對Hive SQL編譯流程提出了革命性要求。最新研究顯示,通過改造AST生成機制,將流式處理語義融入語法樹構建階段,可以實現微批處理的編譯優化。華為云提出的"動態AST"技術允許在查詢執行期間持續更新語法樹結構,使得Hive能夠處理持續到達的數據流。這種混合編譯模式在金融風控場景測試中,將端到端延遲從分鐘級壓縮到秒級。

機器學習深度集成

AI與大數據處理的融合正推動編譯技術向智能化方向發展。基于機器學習的優化器(ML-based Optimizer)開始應用于AST轉換階段,通過歷史執行數據訓練模型預測最優執行計劃。具體實現上,系統會記錄數萬次查詢的AST特征與執行指標,建立神經網絡模型來自動決策謂詞下推、Join順序等關鍵優化策略。實際測試表明,這種方案對復雜查詢的編譯時間縮短了35%,且隨著數據積累持續自我優化。

多模執行引擎適配

單一MapReduce引擎已不能滿足多樣化計算需求,現代Hive正在發展為支持多執行引擎的編譯框架。關鍵技術突破在于構建統一的中間表示層(IR),將AST轉換為與執行引擎無關的中間格式,再針對Tez、Spark或Flink等不同引擎生成特定代碼。這種架構下,Operator執行樹會被拆解為更基礎的計算原語,通過LLVM等編譯技術生成本地代碼,使得CPU密集型查詢性能獲得數量級提升。

硬件加速技術應用

異構計算硬件的普及為編譯優化開辟了新路徑。前沿研究正在探索將AST中的特定算子(如哈希連接、聚合)自動卸載到GPU/FPGA執行的技術方案。通過在語法樹解析階段識別可加速的計算模式,系統能生成混合硬件執行計劃。阿里云實驗室的測試數據顯示,特定查詢在GPU加速下性能提升達8倍,同時降低60%的CPU負載。

自適應優化系統

靜態編譯策略難以應對數據特征的動態變化,未來系統將更強調運行時自適應優化。關鍵技術包括:

- ? 實時統計信息反饋機制,在查詢執行期間動態調整Operator樹結構

- ? 基于強化學習的執行計劃調整,根據中間結果質量修正后續計算路徑

- ? 分布式執行圖的彈性重組能力,應對節點故障或數據傾斜

這些創新使得編譯過程從"一次性決策"轉變為"持續優化"的智能系統,在超大規模數據集處理中展現出顯著優勢。

安全與合規增強

數據安全法規的完善推動著編譯技術的安全邊界擴展。新型安全感知編譯器會在AST構建階段植入數據脫敏、訪問控制等安全算子,形成貫穿整個執行生命周期的保護機制。微軟研究院提出的"可驗證編譯"技術,能夠生成包含完整安全證明的MapReduce代碼,確保數據處理過程符合GDPR等規范要求。

開發者體驗革新

降低使用門檻是技術普及的關鍵,可視化編譯調試工具正在成為重要發展方向。通過交互式展示AST轉換、執行樹優化全過程,開發者能直觀理解查詢優化邏輯。GitHub開源項目HiveVision已實現實時渲染語法樹變化過程,支持逐節點性能分析,極大提升了復雜查詢的調優效率。

)

)

在腦部疾病診斷中的應用與實現)

)

)

)

)