文章目錄

- 前言

- 1.安裝Ollama

- 2.QwQ-32B模型安裝與運行

- 3.Cursor安裝與配置

- 4. 簡單使用測試

- 5. 調用本地大模型

- 6. 安裝內網穿透

- 7. 配置固定公網地址

- 總結

前言

本方案提出了一種基于Windows系統的智能化開發平臺搭建策略,通過融合Cursor智能編程平臺、Ollama模型運行框架和cpolar內網穿透服務,成功實現了千問QwQ-32B大模型的私有化遠程調用。該系統架構包含三個核心組件:首先利用Ollama框架實現QwQ-32B模型的本地化部署;其次構建定制化的OPENAI API接口以規范模型服務輸出;最后借助內網穿透技術突破局域網限制,創建可遠程訪問的服務端口。

在技術實現維度,Cursor作為當前主流的AI輔助開發工具,其設計特性存在兩個明顯局限:其一是對公網模型服務的強依賴特性;其二是高頻次API調用帶來的運營成本壓力。本方案從兩個層面進行優化:第一,實施本地化部署方案提升數據安全性,確保所有代碼解析與模型運算均在本地閉環完成;第二,采用內網穿透技術既規避了服務費用支出,又實現了跨區域訪問能力。

該解決方案具備三項顯著應用價值:1)為開發者提供多場景工作環境適配,通過遠程連接實現本地模型訪問;2)在團隊協作中有效防控代碼泄露風險;3)為資源受限的開發團隊提供高性價比的AI服務選項。通過Ollama的輕量化部署能力、cpolar的穿透技術優勢與Cursor的智能編輯功能的有機整合,最終構建出具備安全性保障、成本控制優勢和操作便利性的智能開發系統。

1.安裝Ollama

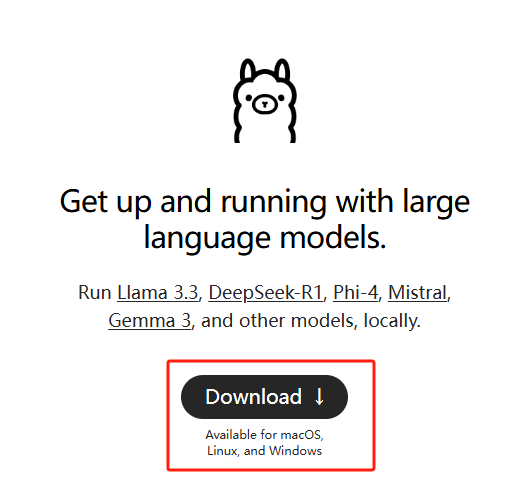

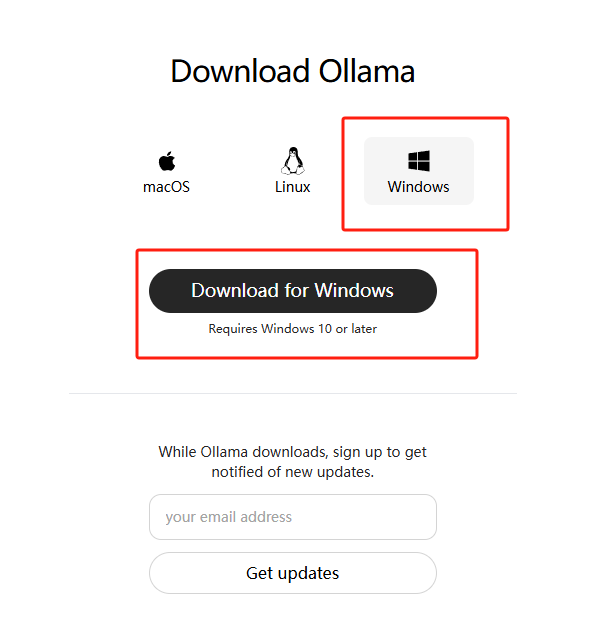

本例中使用的是Windows11系統專業版,通過Ollama運行Gemma3:27B大模型,之前曾經發布過如何在Windows安裝Ollama的教程,有需要的同學可以看看這篇文章:Windows本地部署Deepseek-R1大模型并使用Web界面遠程交互

簡單來說,就是訪問Ollama的官網:Download Ollama on Windows

下載對應版本的ollama安裝程序并安裝:

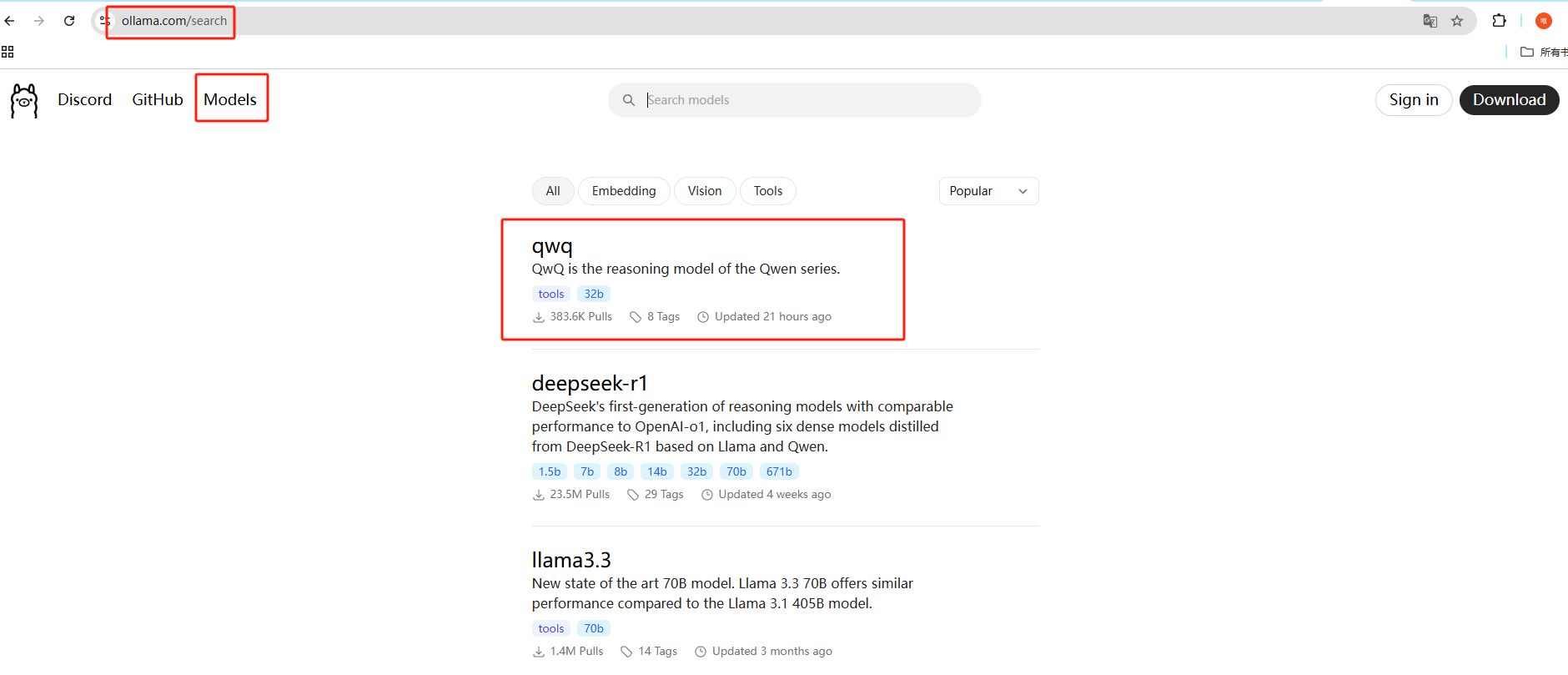

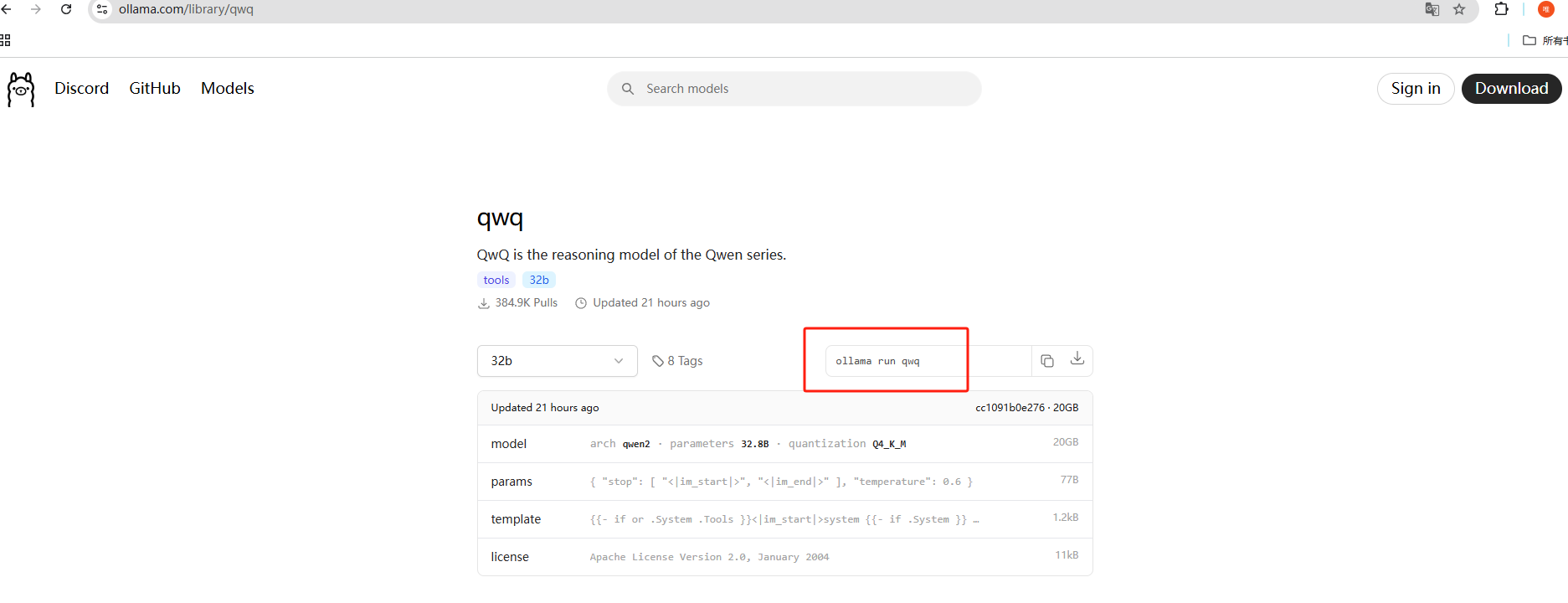

2.QwQ-32B模型安裝與運行

在Ollama的官網點擊Models,搜索qwq就可以看到模型:

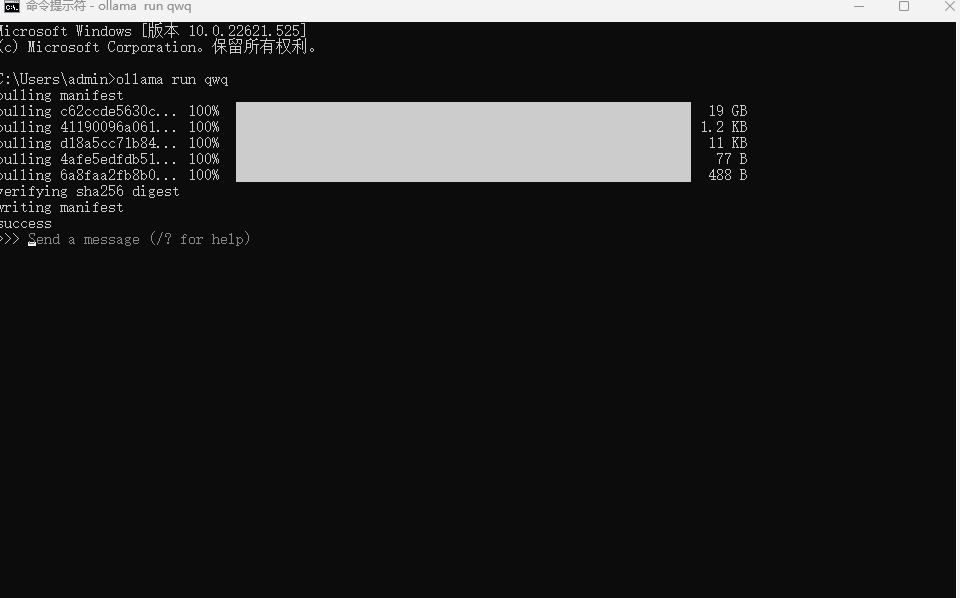

Ollama安裝完成之后,就可以開始去下載 QwQ-32B 模型了,使用這個命令就能下載:

ollama run qwq

ps:需要預留20個G以上的儲存空間,默認下載到C盤,如果想修改下載位置,可以在終端中執行下方命令來指定模型文件的存放目錄,這里以d:\ollama為例,大家可以自定義:

set OLLAMA_MODELS=d:\ollama

下載中,時間有點長,等待進度條完成即可,模型安裝成功后會提示success,并可以進行提問了:

3.Cursor安裝與配置

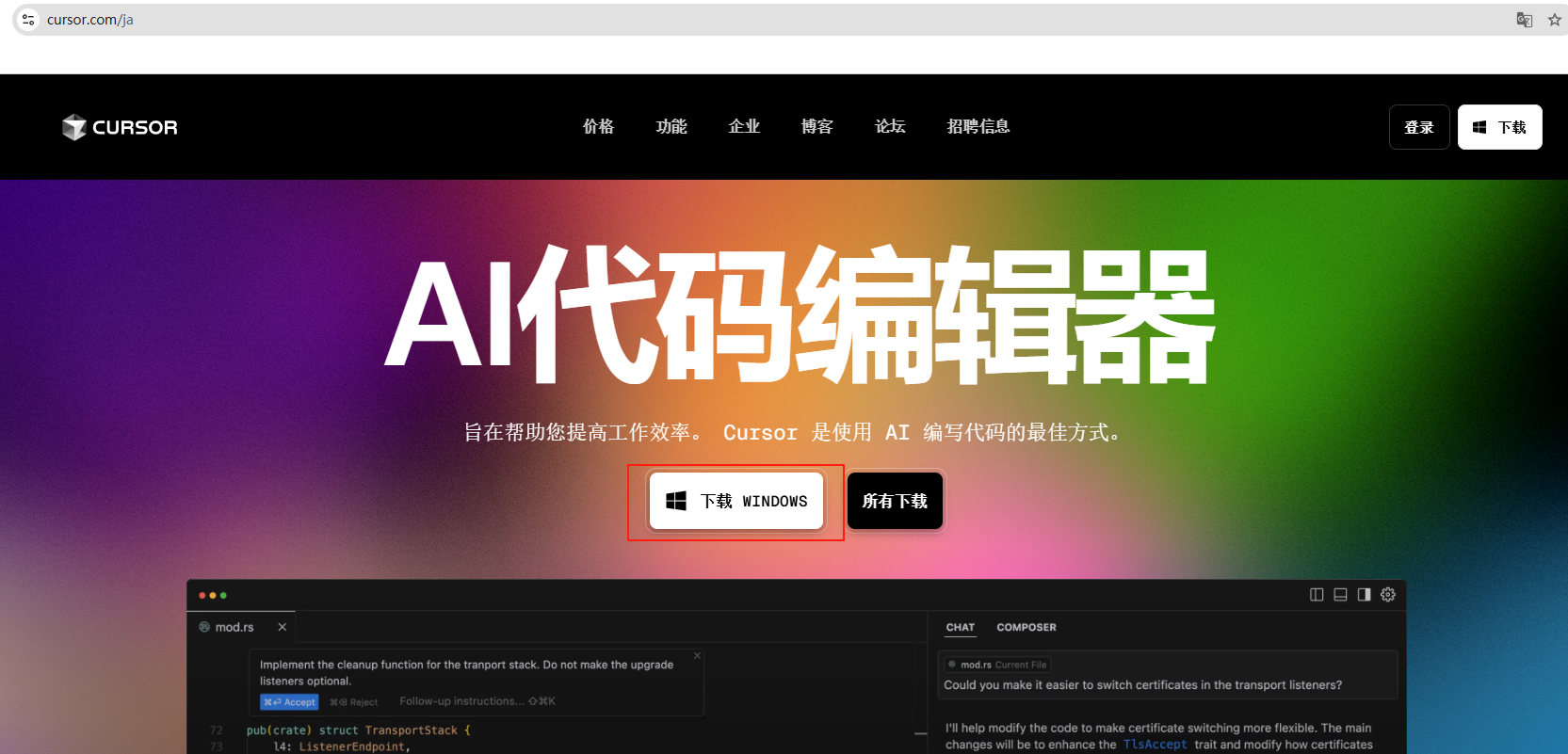

訪問cursor官網下載Windows版本: https://www.cursor.com/

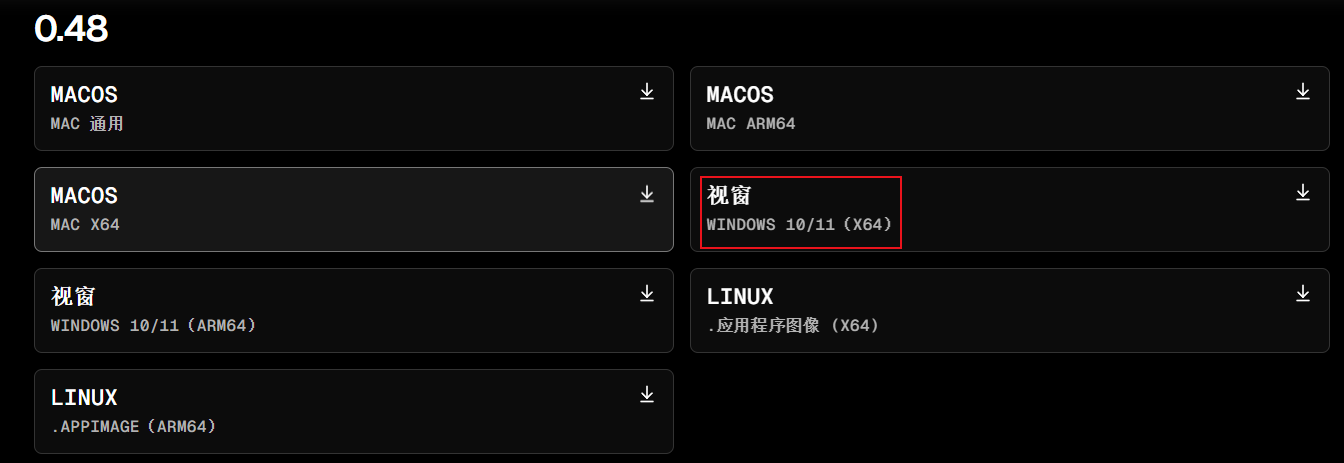

我這里下載的是Windows X64的0.48版本:

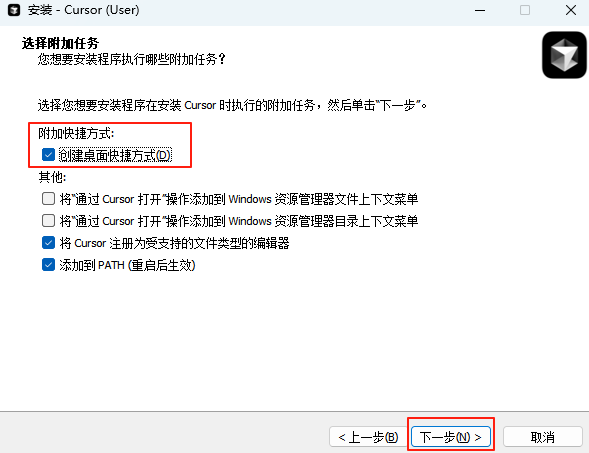

下載后,按照提示一步步安裝,如需創建桌面快捷方式,勾選即可:

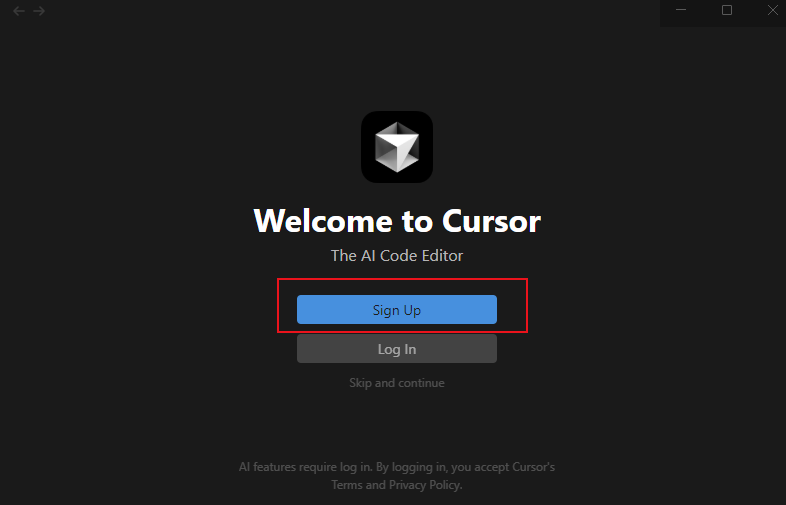

點擊完成后,第一次運行程序會彈出登錄窗口:

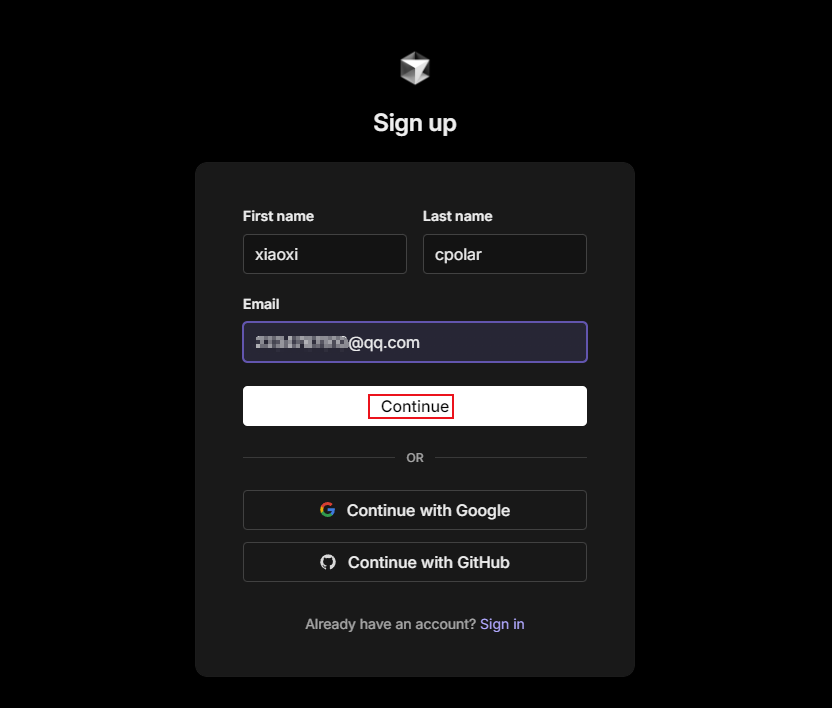

點擊Sign UP注冊一個賬號登錄:

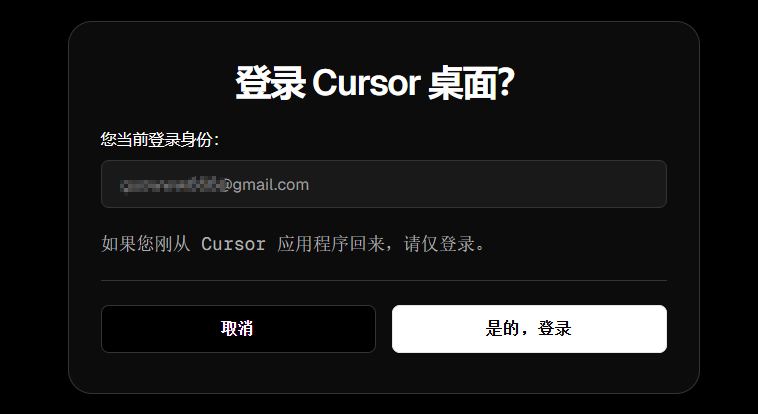

或者使用google或github賬號登錄,都可以:

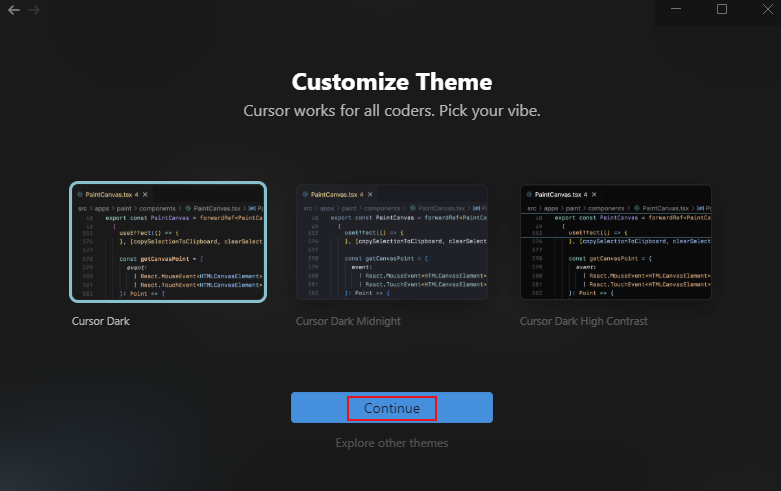

選擇一個主題,點擊繼續:

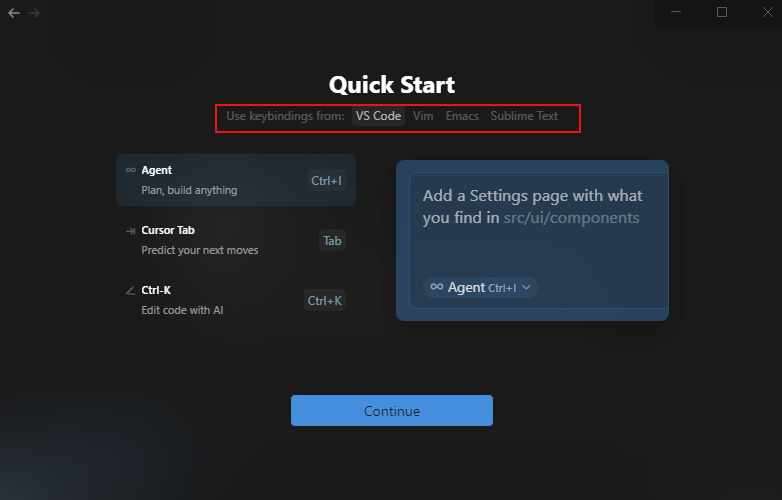

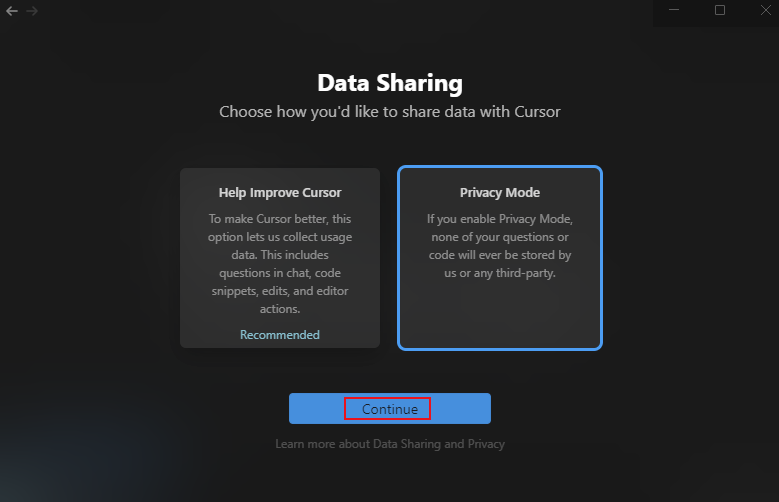

選擇快捷鍵風格,點擊繼續:

數據分享這里選擇了私人模式進行演示,大家可以根據自己情況選擇:

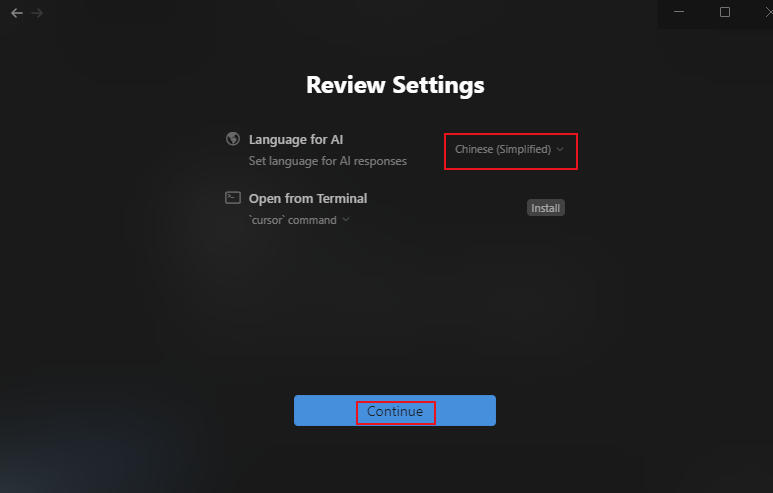

給AI發送信息的語言選擇簡體中文:

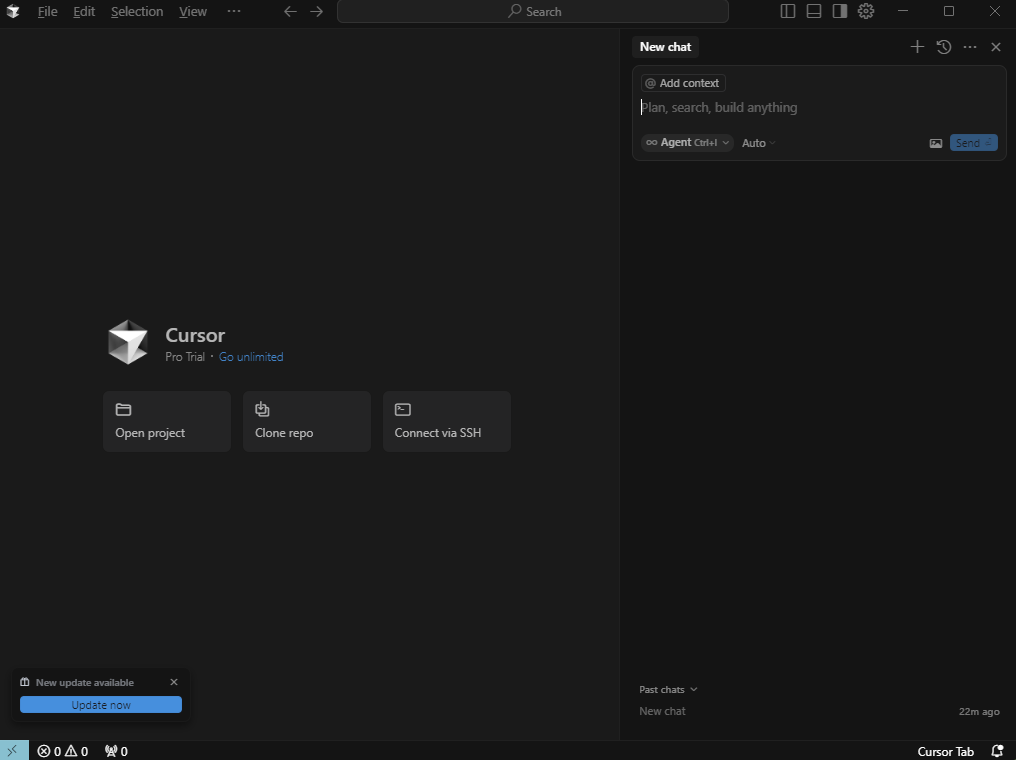

配置完畢后,既可看到Cursor的主界面了:

4. 簡單使用測試

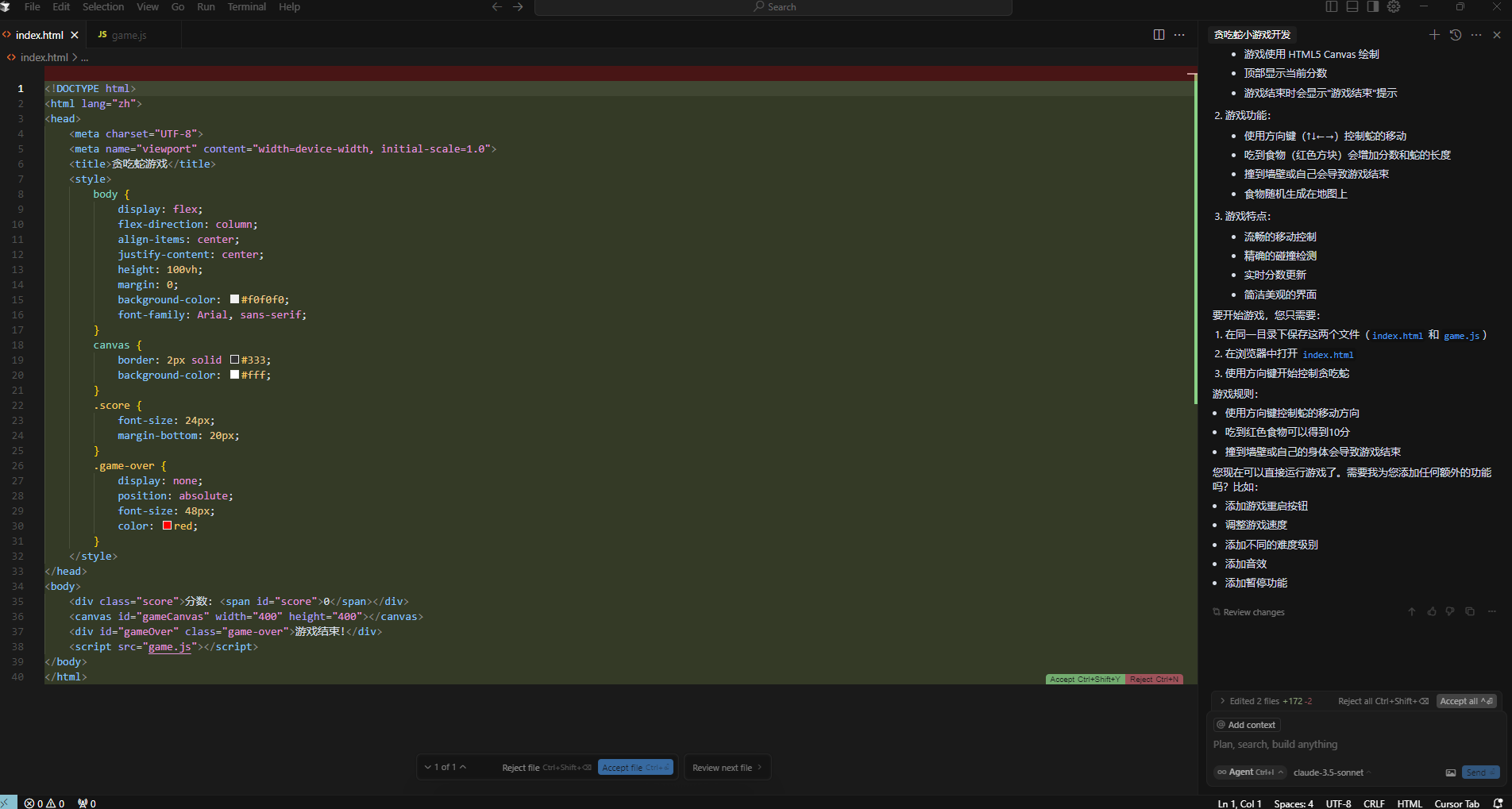

現在我們就可以在右側的輸入框中選擇好AI模型進行提問了,比如我這里要求他幫我寫一個貪吃蛇小游戲:

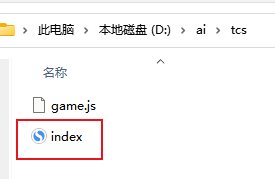

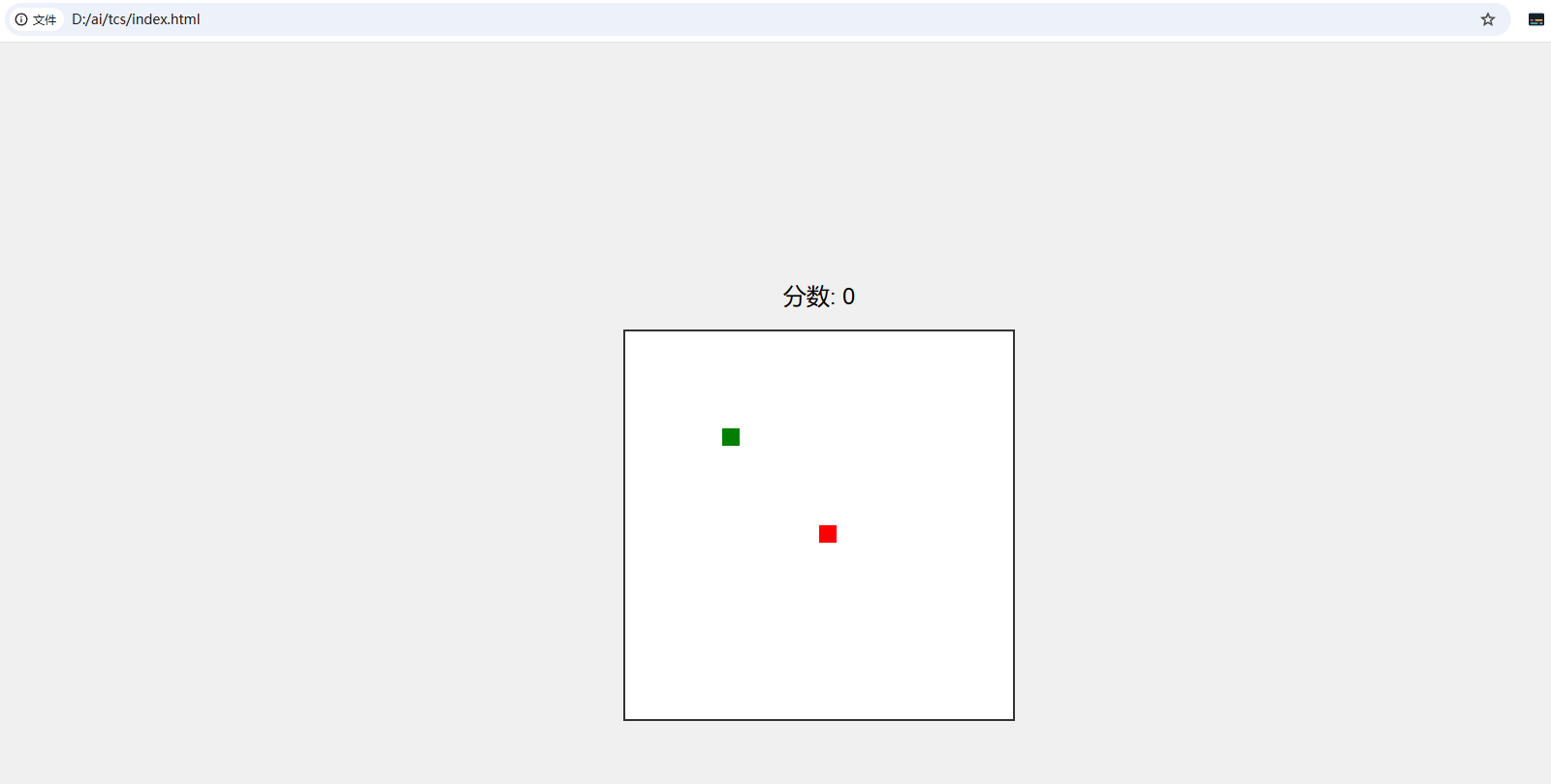

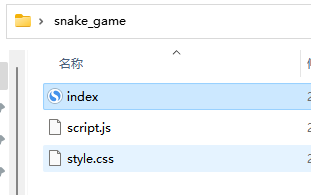

經過兩次確認創建文件,并等待一小會兒后,AI就給我生成了兩個文件(index.html和game.js),在將這兩個文件保存在同一目錄下,在瀏覽器中打開index.html就能看到貪吃蛇小游戲的界面了:

通過控制方向鍵也可以正常玩,不過這只是一個相當初級的版本,但是AI也提供了后續優化的建議,比如:

-

添加游戲重啟按鈕

-

調整游戲速度

-

添加不同的難度級別

-

添加音效

-

添加暫停功能

5. 調用本地大模型

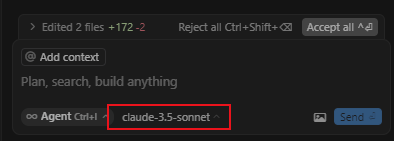

在提問框旁邊,我們能看到使用哪個大模型來輔助你編程的選擇功能:

不過剛才演示的是通過調用在線大模型來輸出回答,現在我們來演示一下如何讓Cursor調用我們剛才在本地部署的qwq-32b大模型來實現輔助開發。

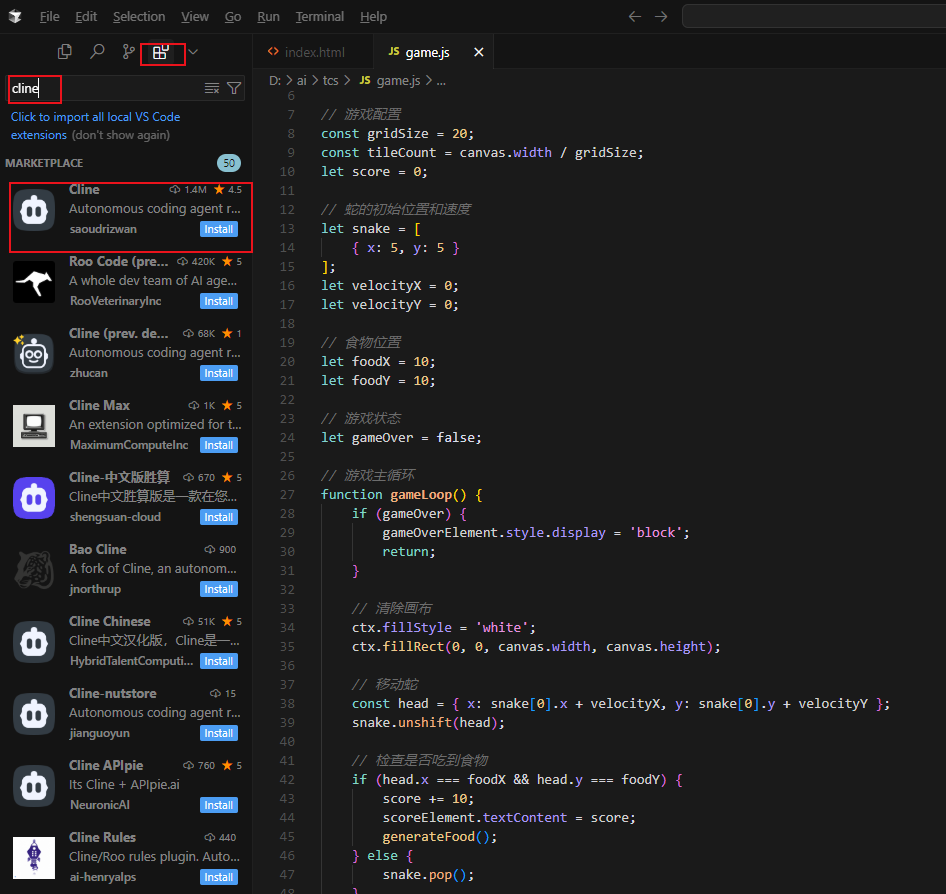

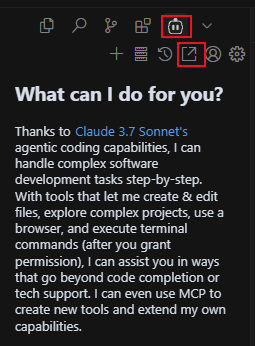

要想實現這個功能,首先我們需要打開Cursor的左邊欄,點擊插件,搜索cline插件,并點擊install進行下載:

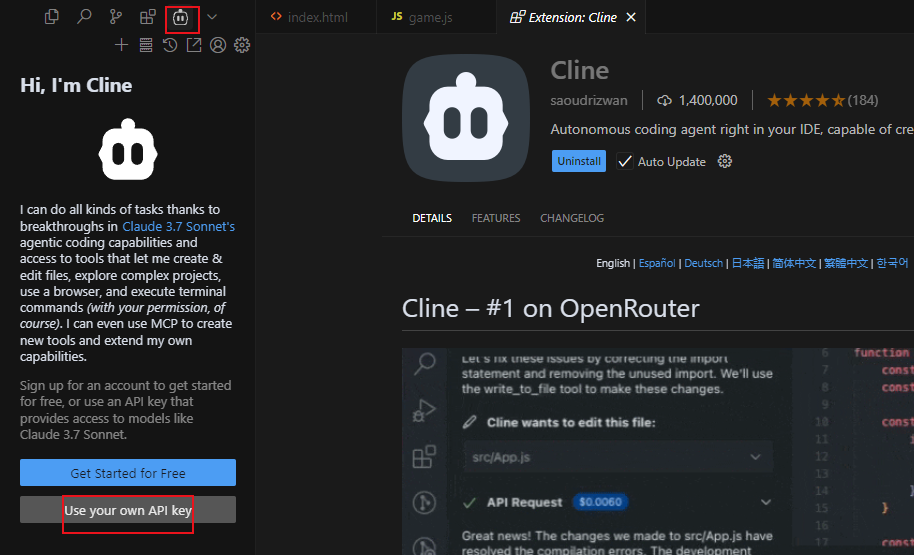

安裝好之后,點擊插件圖標,選擇使用我自己的api key:

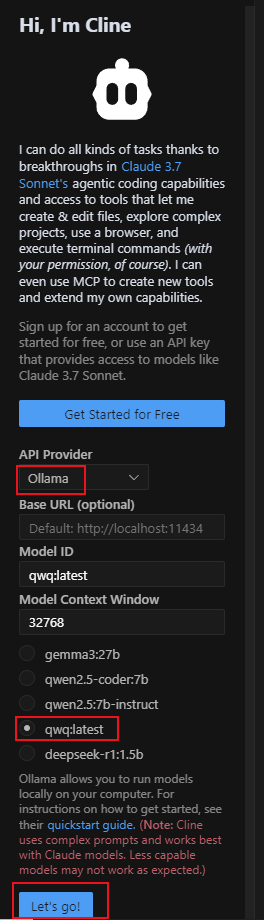

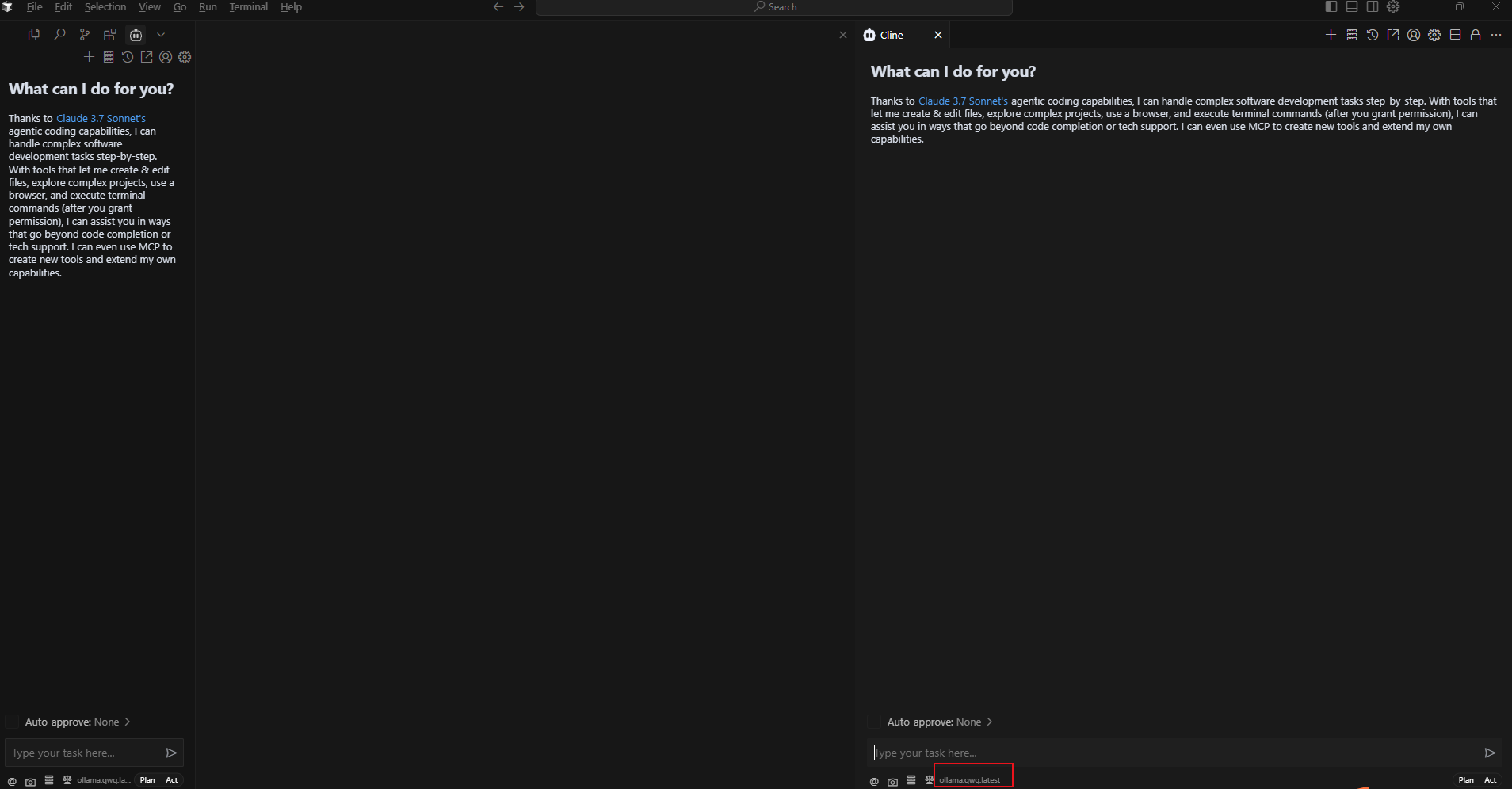

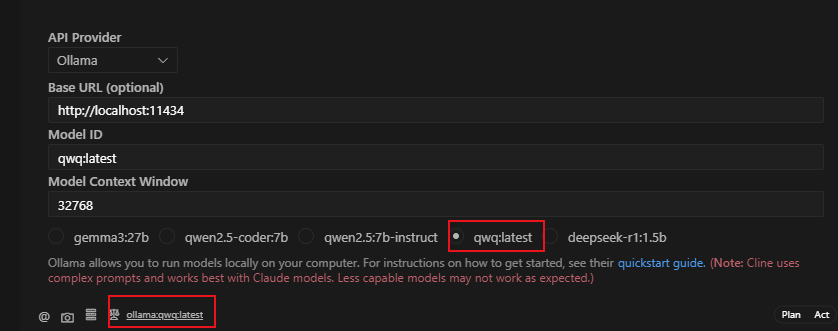

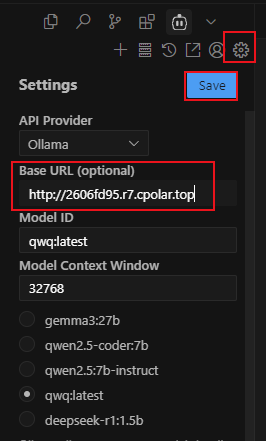

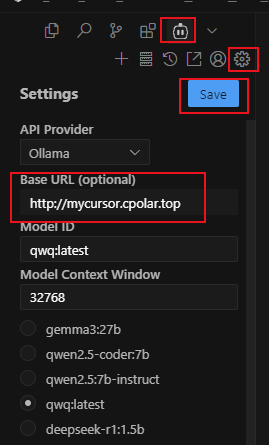

然后在API Provider中選擇剛才安裝的Ollama,模型地址默認http://localhost:11434,模型ID在勾選了要使用本地部署的qwq:latest后會自動填寫,然后點擊Let”go!

配置完成后,點擊cline插件下方的在編輯器中打開:

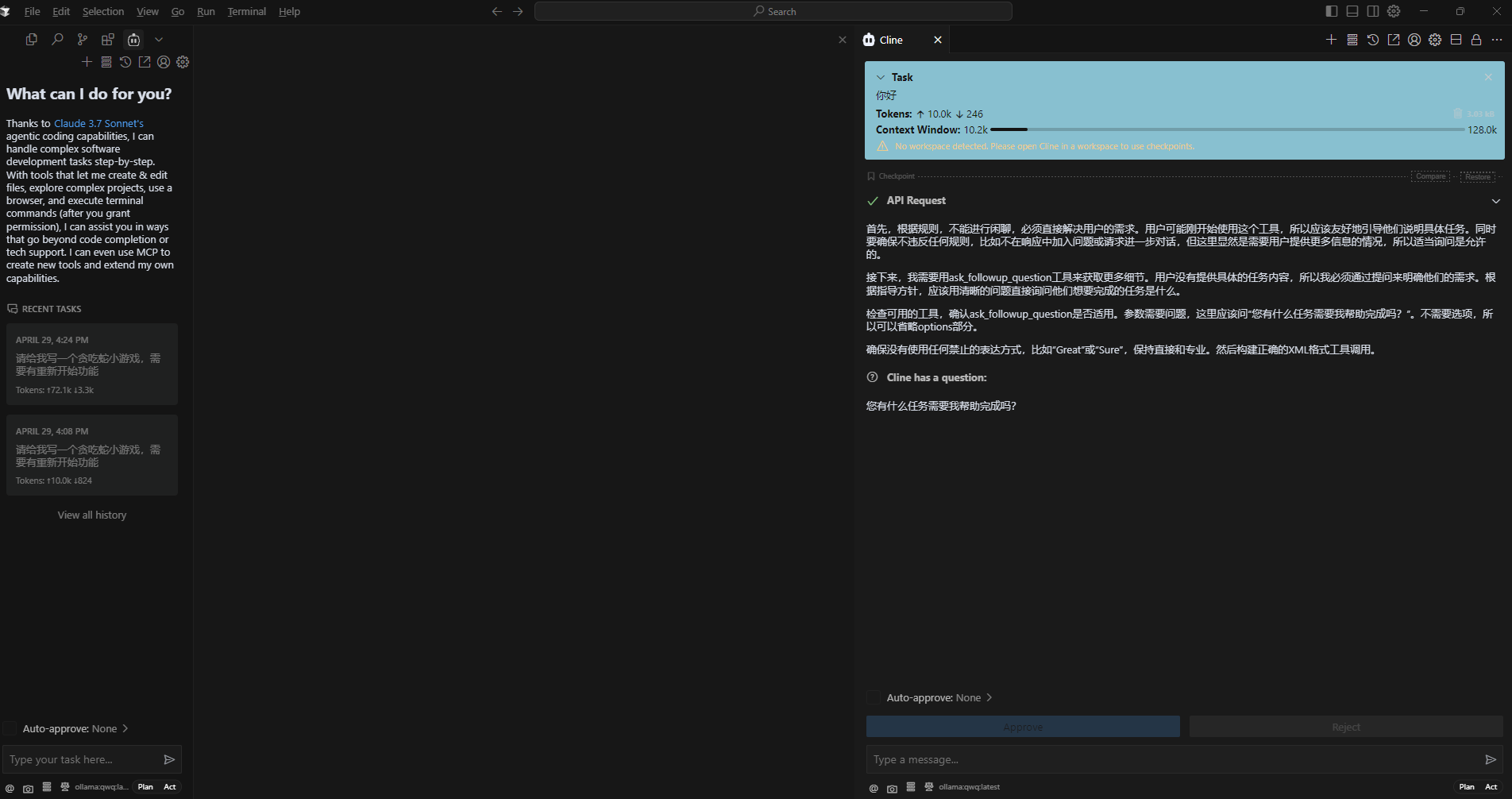

在彈出的新輸入框中,可以看到現在已經調用的是本地部署的qwq-32b(名稱為qwq:latest)模型了!

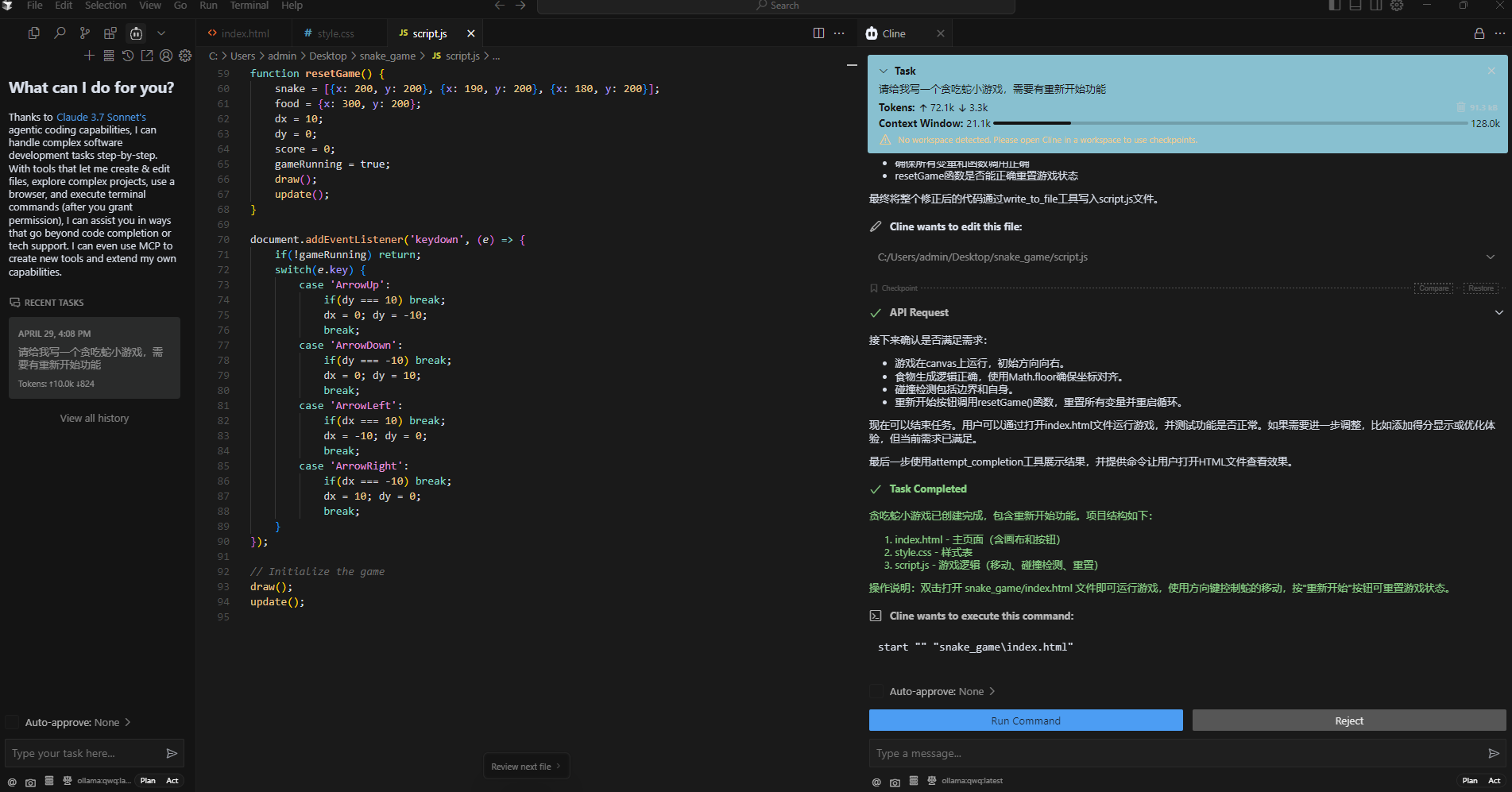

提個要求測試一下:

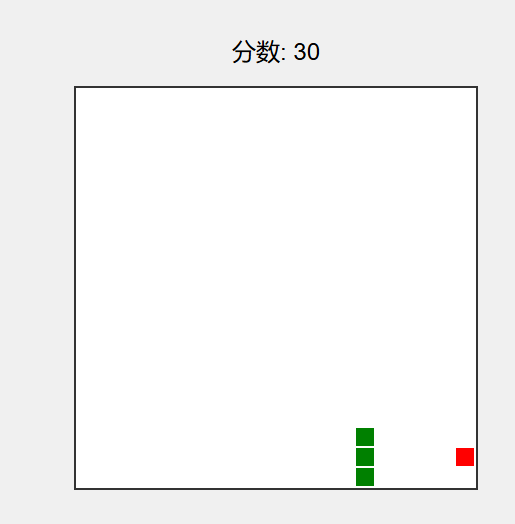

這次使用本地大模型生成的貪吃蛇小游戲不用自己創建文件夾了,自己在桌面上生成了一個目錄:

訪問后同樣可以看到游戲界面,并且這次還加上了重新開始按鈕:

但是同樣也有一些BUG,需要后期進行完善與優化。

6. 安裝內網穿透

但如果想要像文章開頭說的那樣,當和本地部署的大模型不在同一網絡環境下,也能隨時隨地在線使用Cursor調用與本地部署的大模型輔助代碼開發,那就需要借助cpolar內網穿透工具來實現公網訪問了!接下來介紹一下如何安裝cpolar內網穿透,過程同樣非常簡單,只需使用它為Ollama配置一個公網地址就可以了。

首先進入cpolar官網:

cpolar官網地址: https://www.cpolar.com

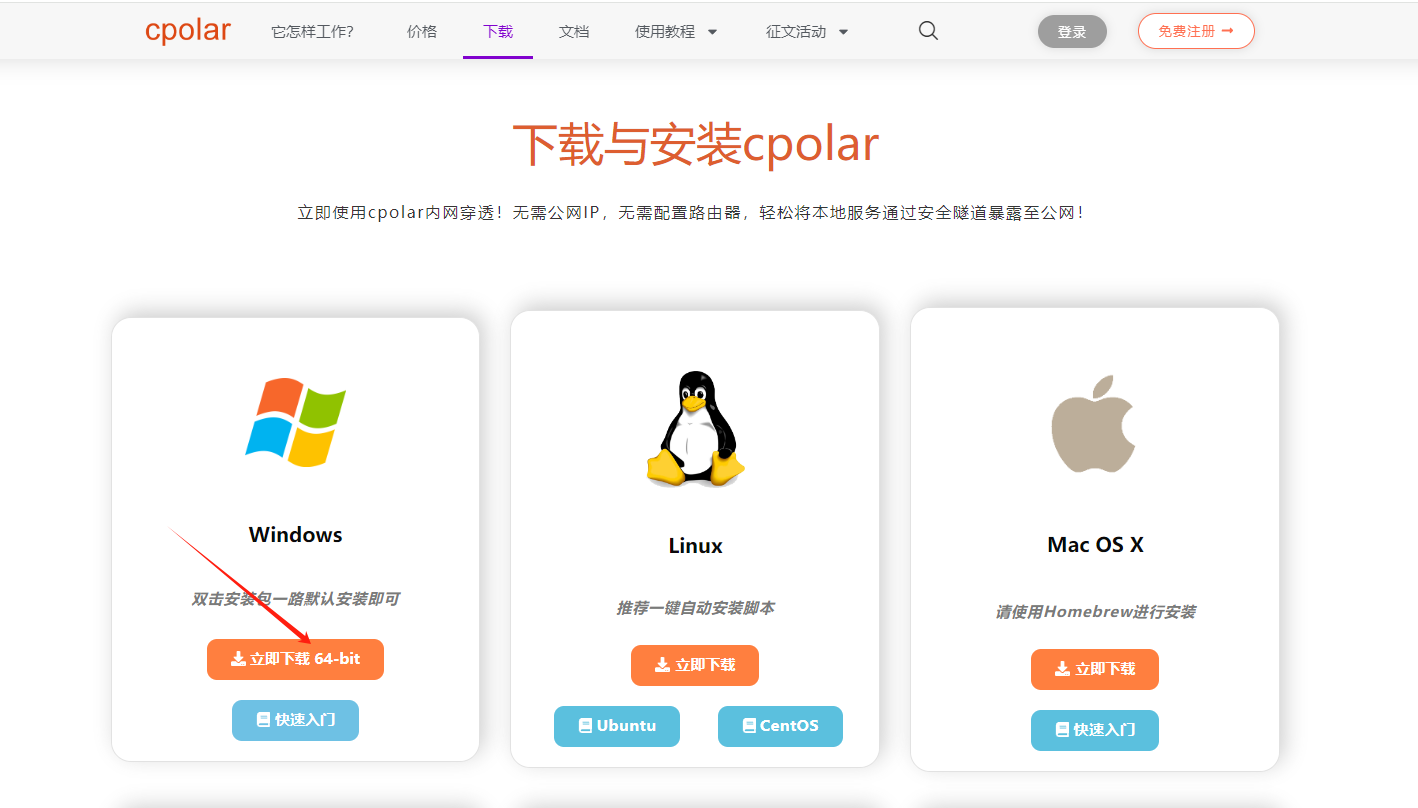

點擊免費使用注冊一個賬號,并下載最新版本的cpolar:

登錄成功后,點擊下載cpolar到本地并安裝(一路默認安裝即可)本教程選擇下載Windows版本。

cpolar安裝成功后,在瀏覽器上訪問http://localhost:9200,使用cpolar賬號登錄,登錄后即可看到配置界面,結下來在WebUI管理界面配置即可。

接下來配置一下 ollama 的公網地址:

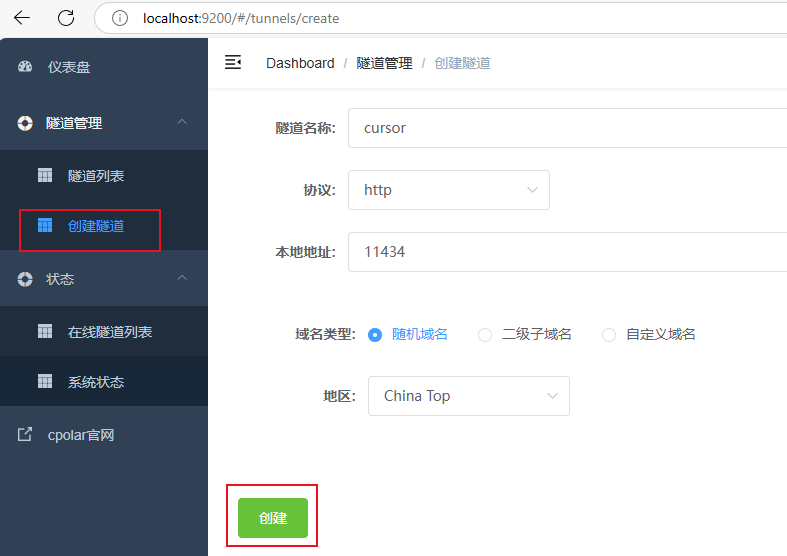

登錄后,點擊左側儀表盤的隧道管理——創建隧道,

- 隧道名稱:cursor(可自定義命名,注意不要與已有的隧道名稱重復)

- 協議:選擇 http

- 本地地址:11434

- 域名類型:選擇隨機域名

- 地區:選擇China Top

隧道創建成功后,點擊左側的狀態——在線隧道列表,查看所生成的公網訪問地址,有兩種訪問方式,一種是http 和https:

使用上面的任意一個公網地址替換剛才我們在Cursor中的cline插件里填寫的模型地址即可,這樣一來就可以隨時使用Cursor在線調用本地大模型來讓AI輔助我們進行代碼開發了!

小結

為了方便演示,我們在上邊的操作過程中使用cpolar生成的HTTP公網地址隧道,其公網地址是隨機生成的。這種隨機地址的優勢在于建立速度快,可以立即使用。然而,它的缺點是網址是隨機生成,這個地址在24小時內會發生隨機變化,更適合于臨時使用。

如果有長期遠程使用Cursor調用本地模型輔助開發,或者異地訪問與使用其他本地部署的服務的需求,但又不想每天重新配置公網地址,還想讓公網地址好看又好記并體驗更多功能與更快的帶寬,那我推薦大家選擇使用固定的二級子域名方式來配置一個公網地址。

7. 配置固定公網地址

接下來演示如何為其配置固定的HTTP公網地址,該地址不會變化,方便分享給別人長期查看你部署的項目,而無需每天重復修改服務器地址。

配置固定http端口地址需要將cpolar升級到專業版套餐或以上。

登錄cpolar官網,點擊左側的預留,選擇保留二級子域名,設置一個二級子域名名稱,點擊保留:

保留成功后復制保留成功的二級子域名的名稱:mycursor,大家也可以設置自己喜歡的名稱。

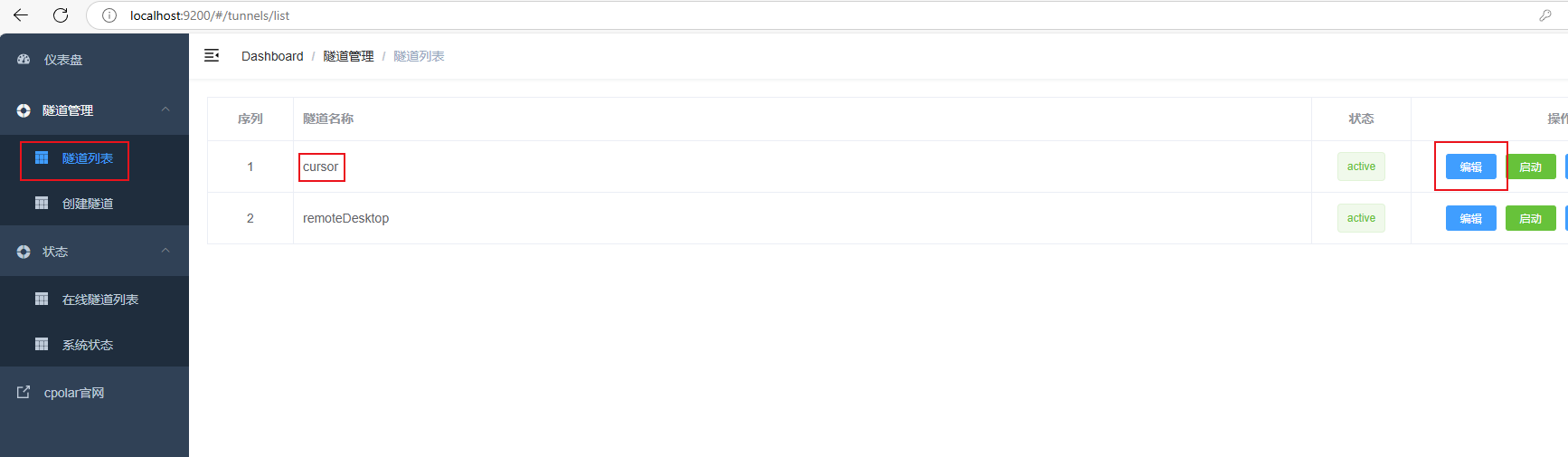

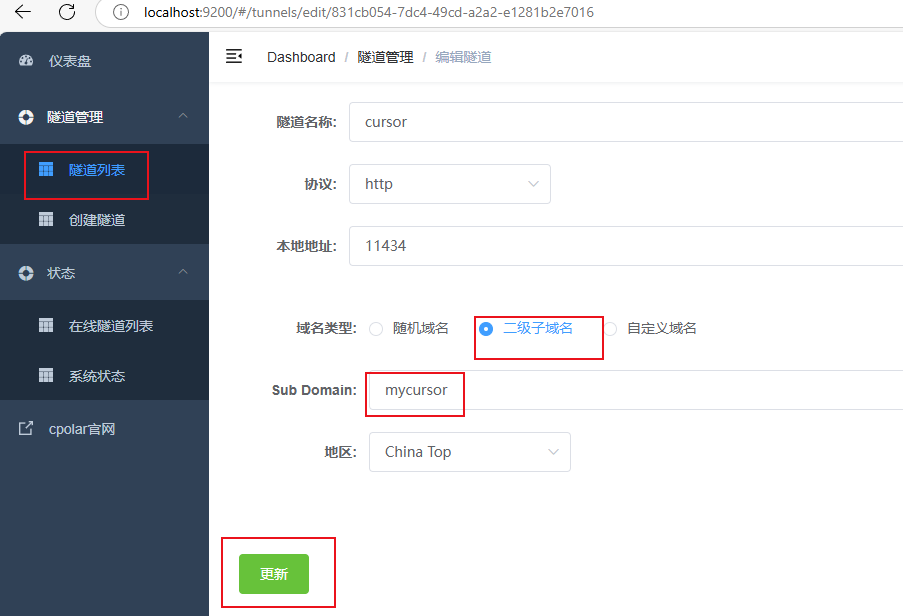

返回Cpolar web UI管理界面,點擊左側儀表盤的隧道管理——隧道列表,找到所要配置的隧道:cursor,點擊右側的編輯:

修改隧道信息,將保留成功的二級子域名配置到隧道中

- 域名類型:選擇二級子域名

- Sub Domain:填寫保留成功的二級子域名:

mycursor

點擊更新(注意,點擊一次更新即可,不需要重復提交)

更新完成后,打開在線隧道列表,此時可以看到公網地址已經發生變化,地址名稱也變成了固定的二級子域名名稱的域名:

最后,我們使用上邊任意一個固定的公網地址訪問,可以看到訪問成功,這樣一個固定且永久不變的公網地址就設置好了,可以隨時隨地在公網環境異地在線訪問本地部署的大模型來使用Cursor輔助代碼開發工作了!

總結

本系統方案已在Windows系統環境中成功構建Cursor智能編程平臺與QwQ-32B大模型的本地化部署架構,通過cline插件構建了本地模型的調用機制。針對傳統云端服務模式存在的運營成本高企與數據安全風險,本方案創造性整合內網穿透技術,成功破解了無公網IP場景下的遠程訪問瓶頸。實測數據顯示,該技術架構在維持開發效率的同時,實現了服務成本的顯著優化,主要體現在:1)本地化處理機制杜絕了數據外傳隱患;2)采用內網穿透技術替代傳統云服務收費模式;3)模塊化插件設計提升了模型響應速度。該解決方案為需要靈活部署環境的開發團隊提供了兼顧安全防護、成本控制和系統擴展的可行性方案,歡迎就技術細節進行深入交流。