【導讀】具身智能作為一種新興的研究視角和方法論,正在刷新我們對智能本質及其發展的理解:傳統的 AI 模型往往將智能視為一種獨立于實體存在的抽象能力,而具身智能則主張智能是實體與其環境持續互動的結果。

本文深度剖析了具身智能計算系統在當今社會經濟轉型中的核心角色,圍繞自主經濟的內涵、具身智能的理念及其計算系統的挑戰與發展進行了深入闡述,展現了具身智能如何通過提升機器人對物理世界的感知、理解和決策能力,進而重塑未來的經濟結構和社會生活。

本文精選自《新程序員?007:大模型時代的開發者》,《新程序員 007》聚焦開發者成長,其間既有圖靈獎得主 Joseph Sifakis、前 OpenAI 科學家 Joel Lehman 等高瞻遠矚,又有對于開發者們至關重要的成長路徑、工程實踐及趟坑經驗等,歡迎大家點擊訂閱年卡。

作者 | 俞波 夏軒 劉少山

責編 |?王啟隆

出品 | 《新程序員》編輯部

大模型時代的社會正逐步實現從數字經濟向自主經濟的轉型,而這種轉型的核心驅動力來自機器人計算技術;其中,具身智能計算系統代表了機器人計算技術的重要前沿方向。正如 Android 為各種手機設備提供了一個統一而開放的操作系統,使得開發者創造出無數應用和功能,具身智能計算系統也為機器人計算技術打開了同樣廣闊的可能性。

具身智能計算系統的內核為不同形態的機器人提供了感知、認知和行動的基礎能力,還允許開發者在此基礎上構建更加復雜和多樣化的機器人應用。通過這樣的系統,機器人能夠更好地理解和互動于其所處的物理世界中,從而實現更加自然和高效的服務與協作。總而言之,具身智能計算系統的內核驅動了多樣化機器人應用生態的發展,而具身智能計算應用生態進一步促進了自主經濟的爆發。

自主經濟是什么

自主經濟(the Autonomy Economy)標志著社會轉型的新階段,主要由各式機器人(比如自動駕駛汽車、配送機器人和無人機)與商品及服務的融合驅動。這場經濟變革的核心在于機器人計算?(Autonomous Machine Computing),即為這些多樣化機器人提供支持的關鍵計算技術[1]。

自主機器的出現預示著數字經濟模式的演變[2]。這些機器最開始只用于簡單的機器人技術和工業應用,現在卻已經深入我們的日常生活,宣告著自主經濟時代的到來。舉例來說,中國的一些酒店已經投入使用送餐機器人,將所需物品送至住客的房間。而在訂購食品和生活用品送達上,某些城市已經出現了機器人將餐食或商品直接送至用戶家門口的景象。在家庭環境中,機器人吸塵器更是成了家庭常備電器。

AIGC 生成圖片

在過去幾十年中,數字經濟極大促進了經濟增長。以 2005 年至 2010 年為例,互聯網經濟對成熟經濟體 GDP 增長的貢獻達到 21%,并在 2019 年為美國經濟貢獻了 2.1 萬億美元。相較于數字經濟,自主經濟預計將帶來更深遠的影響。例如,自動駕駛技術的普及預計將重塑價值 1.9 萬億美元的美國運輸行業,顯示出機器人計算將在各行各業引發革命性的變化。

為了賦能自主經濟的大爆發,當前我們的重要工作在于設計并實現先進的具身智能計算系統,為不同形態的機器人提供腦力,類似于移動互聯網時代 Android 系統對多種移動設備的賦能。正如智能手機時代?Android 系統重塑市場軟件生態一樣,對具身智能機器人軟硬件系統的研究與開發,將引領機器人領域的重大變革,也將為機器人時代開啟新的篇章。

具身智能是什么?

具身智能(Embodied AI)是一種全新的人工智能理念,它區別于傳統人工智能的觀念,主張智能的產生不僅依賴算法和算力,還需要通過與實際世界的互動來實現。這意味著,智能體(例如機器人)需要具備感知環境、執行物理操作和與環境互動的能力,以便更全面地理解和掌握世界知識。

同樣的一套具身智能系統可以賦能不同的機器人形態,使它們能夠直接與周圍環境互動和感知的智能形式。這種智能不僅涉及到算法和數據處理,還包括對物理世界的理解和操作。具身智能計算系統的技術挑戰主要包括如何使機器人能夠準確地感知環境、理解復雜的人類指令以及在多變的環境中自主作出決策和執行任務。此外,如何優化機器人的能量效率、處理速度和安全性也是重要的技術挑戰。

具身智能研究跨越了機器人學、人工智能、認知科學及神經科學等多個學科,旨在深化對智能本質的理解。具身智能的挑戰在于如何構建高度適應性的感知和決策系統,使機器人能夠準確理解和預測物理世界的復雜動態,并確保機器人能以自然有效的方式與人類及其他智能體交互。解決這些挑戰有望將智能機器人應用推向家庭、工業、醫療和探索等多個領域,促進人機交互的自然化和任務執行的效率化。

歷史啟示——良性循環以及生態的重要性

機器人計算成為自主經濟轉型的關鍵,繼個人計算與移動計算之后,它成為了機器人時代不可或缺的技術核心[3, 4]。機器人計算支撐著從智能汽車、自主無人機、配送機器人、家用服務機器人到農業、工業機器人等多種形態的機器人,甚至包括我們還未能想象到的機器人類型。它涵蓋了傳感技術、計算技術、通信技術、自主控制算法、可靠性和安全性等多個技術領域,至今仍在持續發展與演化中。

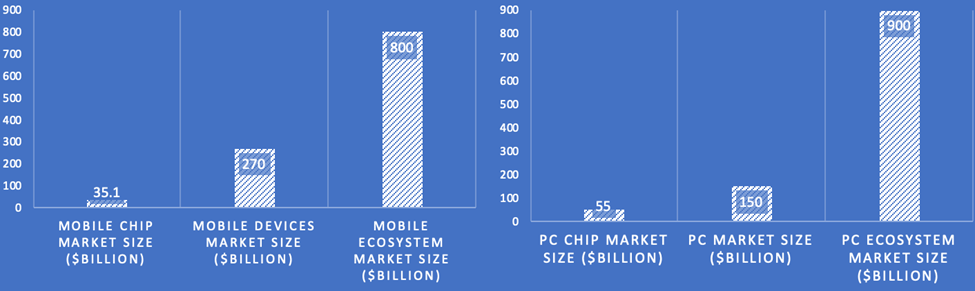

歷史上的先例明確展示了機器人計算對自主經濟發展的重要性。例如,個人計算和移動計算領域的市場規模及其對應的計算系統市場之間的相關性,展示了移動系統市場 351 億美元的價值與移動計算生態系統 8000 億美元市場規模之間、個人計算系統 550 億美元的市場價值與其生態系統 9000 億美元價值之間的顯著差異(參見圖 1)。這表明,隨著計算時代的演進,計算系統行業在培育出其市場規模 15 到 25 倍的生態系統方面扮演著至關重要的角色。

圖 1?計算技術及其生態系統的良性循環

這些洞察力揭示了半導體行業作為現代經濟基石的事實。隨著機器人計算等新興領域的發展,計算系統行業推動了技術創新和關鍵技術的發展,這些技術進步又反過來促進了新興領域的成長,形成了一個相互增強的發展循環。這一良性循環突顯了計算系統行業在推動未來經濟關鍵行業增長中的核心作用,尤其是在新興的自主經濟中。

算力分配決定生態規模

圖 2?移動計算生態系統的發展

如圖 2 所示,在生態系統增長中,算力分配扮演了決定性角色,特別是在移動計算行業的演變中尤為明顯。21 世紀初期,以功能手機為主流的移動電話雖廣泛普及,但功能受限,90% 的計算力被用于執行編解碼等基礎通訊任務。應用程序可用的計算力不足 10%,這極大限制了應用多樣性,使得移動計算生態系統的市場規模僅約 100 億美元。?

智能手機的興起改變了這一格局,激發了市場對更高計算能力的需求,以適應和支持日益增多且復雜度不斷提升的移動應用。這種需求催生了從基礎的單芯片系統到復雜的片上系統(SoC)的進化,這些系統集成了多核心 CPU、移動 GPU、移動 DSP 以及先進的電源管理系統。技術的這一飛躍使得高達 90% 的計算能力能夠支持 YouTube、WhatsApp、Uber 等應用,將移動計算生態系統的市場規模擴張至現今的 8,000 億美元。這一發展軌跡凸顯了計算系統技術進步的革命性影響。通過支持更多樣化的應用,這些技術不僅增強了現有市場,還開辟了新的生態系統,使得市場規模達到了計算系統行業價值的多倍。

具身智能計算系統

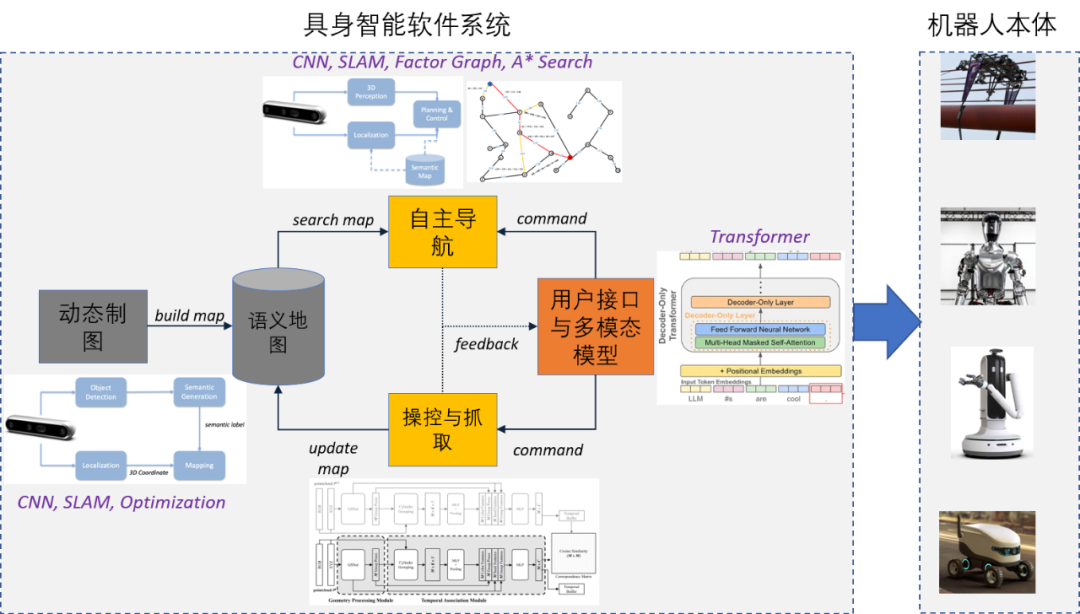

圖 3?具身智能計算系統

目前,家庭掃地機器人、服務機器人和無人駕駛車輛的計算系統,通過環境感知、自身定位和建圖、決策、路徑規劃和控制軟件已實現了自主移動等功能。圖 3 展示了一種具身機器人系統,其與傳統機器人計算類似,也需要地圖、決策控制、導航和運動控制等模塊。

那么,相比于傳統的機器人計算系統,具身智能計算系統的核心不同之處是什么,它為什么可以直接接收人類的文字指令表示的任務,并在不需要提前為任務編程的情況下進行靈活和自主的決策?我們認為,構建具身智能計算的關鍵在于打造能夠融合多模態信息的世界模型,以及能夠承載此類多模態模型與具身軟件的實時高效的計算系統。?

-

多模態的世界模型:世界模型是賦能具身智能的最關鍵軟件。

按照 M. Mitchell 等人在《科學》雜志的表述[5],世界模型“構建針對物理世界和社會世界的抽象模型,并反映事件發生的原因而非僅僅是事件之間的相關性”。借助世界模型,機器人將能夠理解物理世界和人類社會的運行機制,并據此產生自主、靈活、可信、有益的決策。

DeepMind 的 RT 系列模型[6]是構建世界模型的一次初步嘗試:通過多模態大模型處理自然語言和視覺圖像,機器人能夠將命令中的信息與物理世界的物體關聯,還能命令拆分成多個子任務,并逐個執行。?

-

實時高效的計算系統:在一定成本范圍內,能夠高效、實時地完成傳感、計算和控制任務的計算系統是具身智能機器人大規模應用的關鍵。

相比于傳統機器人計算系統,多模態大模型等軟件對計算平臺的算力、存儲和通信的需求成倍增加,具身智能計算平臺的設計充滿挑戰。目前具身機器人研究中常用的計算架構是在云端或邊緣服務器端運行多模態大模型,在機器人端運行傳感和控制執行等任務。這類方案仍處于實驗室演示階段,仍需要大量的系統方面的研究和優化,才能實現規模化的部署。

智能體:具身智能計算的應用

在具身智能計算系統的基礎上,多模態大模型支持的智能體智能(Agent AI)是具身智能應用生態的關鍵技術[7]。?這些具身智能 APP 將成為我們日常生活中無處不在的存在。

具身智能計算系統利用現有的基礎模型(Foundation Model)作為創建 APP 的基本構件。將 APP 嵌入到具身智能計算系統中有助于提高機器人本體處理、理解世界信息,以及與世界互動的能力。例如,一個能夠感知用戶行為、人類行為、環境物體、音頻表達和場景的集體情緒的 APP,可賦能機器人本體作為人類的陪伴機器人。如果說工具是人類智能的延申,那么智能體就是人工智能的延申。而人工智能本身就是人類的工具,因此智能體智能的發展將為人類提供有史以來最強大的智能工具。

為了推進具身智能 APP 的研究與應用,我們在智能體的智能方向開展了多項研究,成功開發了三類智能體(框架)。這些智能體將為機器人提供更強大的感知、學習、決策和行動能力,推動機器人技術與行業需求的深度融合。

-

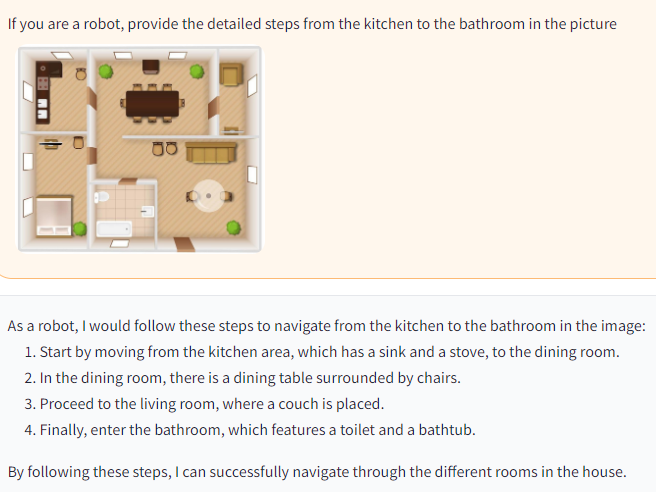

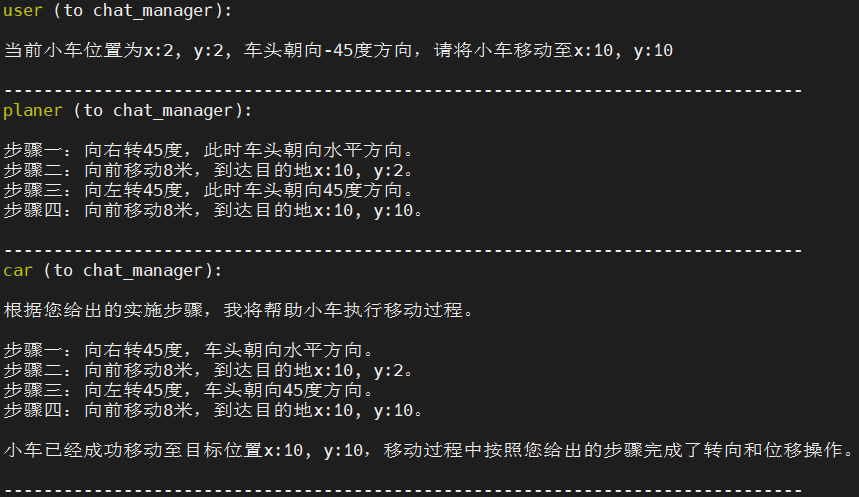

規劃智能體 AIRS-Bot(見圖 4)。借助多模態大模型能力,該智能體可以與人類進行自然語言交互、通過圖像感知環境、基于文字生成圖像、以及以用戶定制的語音進行交互。該智能體能夠通過系統 prompt 扮演任意角色,并支持多種形式的 API 調用,可以為機器人提供行為規劃與決策能力,滿足機器人具身智能的功能實現。?

圖 4?規劃智能體 AIRS-Bot 為機器人提供行為規劃

-

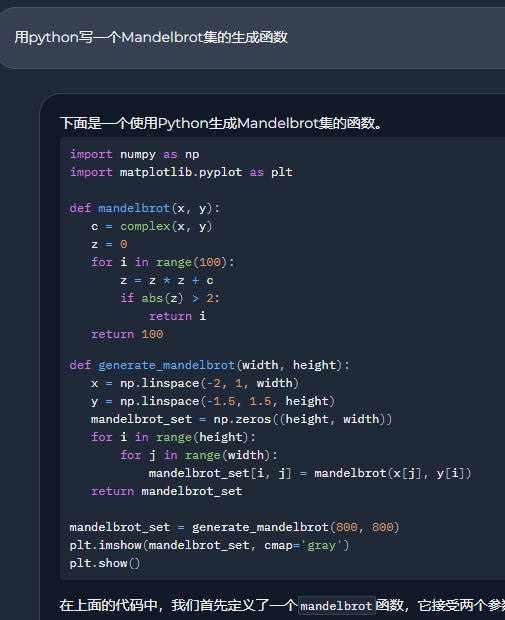

編程智能體 AIRS-Coder(見圖 5)。該智能體的能力包括診斷錯誤,優化代碼,提供詳細的編程概念解釋,并提供各種編程語言和技術的步驟指導。該智能體在 7B 大小的大模型基礎上,在 HumanEval 指標上 pass@1 性能達到 43.4%,超過了 CodeLlama-Python-13B 的 43.3%,用更少的參數獲得了更好的性能。該智能體可以為機器人提供自主編程能力,滿足機器人的自主復雜操作技能需求。?

圖 5 編程智能體 AIRS-Coder 可以為機器人提供自主編程能力

-

群智智能體框架 AIRS-Agents(見圖 6)。該智能體框架支持定義多個不同類型的機器人智能體以及它們的規劃智能體,將它們構成智能體集群并進行統一的調度規劃。不同智能體可以調用不同軟件 APP 處理各自領域內的問題,也可以編程并在沙盒中執行代碼。該智能體可以為機器人集群提供群體智能,實現大范圍的機器人具身智能。?

圖?6 群智智能體框架 AIRS-Agents 可以為機器人機器人集群提供群體智能

智能體是具身智能 APP 的實例,其出現和發展開啟了從人工操作軟件 APP 到智能體自行調用軟件 APP 的時代,并在這一過程中推動了具身智能的進程。隨著技術進步,我們相信會有更多的智能體構成龐大的具身智能 APP 群,進一步引發智能體調用軟件 APP 到機器人調用具身智能 APP 的范式轉變。

結論

具身智能被視為人工智能賦能于機器人的重要技術,可以將機器人從傳統的預編程模式解放出來,賦予機器人更強的自主性和適應能力。具身智能的計算和應用將推動機器人技術與生產制造、服務和醫療康復等行業的深度融合,成為經濟和社會發展的重要推動因素。我們將具身智能計算系統類比為智能機器人領域的 Android 系統,在底層實時計算平臺、世界大模型的基礎上,延伸出諸多基于機器人的應用。具身智能技術剛剛興起,在具身軟件與應用、多模態世界模型、實時計算系統等方面面臨著挑戰。這些領域也將是學術和產業界研究的熱點。

參考文獻

[1] S. Liu, "The Role of Autonomous Machine Computing in Shaping the Autonomy Economy.", Communications of the ACM, https://cacm.acm.org/blogs/blog-cacm/279636-the-role-of-autonomous-machine-computing-in-shaping-the-autonomy-economy/fulltext

[2] S. Liu, "The Transition to the Autonomy Economy and China-US Tech Competition", the Diplomat, 2023.

[3] S. Liu, J.L., Gaudiot,"Rise of the autonomous machines." Computer, 55(1), pp.64-73, 2022.

[4] 劉少山,甘一鳴,韓銀和,"機器人計算正在崛起:中國美國實力全面對比", 知識分子, 2024.

[5] M. Mitchell, "AI's challenge of understanding the world". Science 382, eadm8175, 2023. DOI:10.1126/science.adm8175.

[6] A. Brohan, et al., "Rt-2: Vision-language-action models transfer web knowledge to robotic control." arXiv preprint arXiv:2307.15818, 2023.

[7] Z. Durante, et al., "Agent ai: Surveying the horizons of multimodal interaction." arXiv preprint arXiv:2401.03568, 2024.

)

指定點數的體素濾波)

![[課程]yolov9目標檢測封裝成類調用](http://pic.xiahunao.cn/[課程]yolov9目標檢測封裝成類調用)

03-04:邊緣部分源碼(源碼分析篇))