1、Deep Networks Always Grok and Here is Why

中文標題:深度網絡總是讓人摸不著頭腦,原因如下

簡介:本文探討了深度神經網絡(DNN)中一種稱為"延遲泛化"或"Grokking"的現象。在接近零的訓練誤差之后,DNN的泛化會在較長時間后才發生。先前的研究已經報道了在特定的控制環境下出現延遲泛化的情況,例如使用大范數參數初始化的DNN或在算法數據集上訓練的transformers。本文證明了延遲泛化實際上更為普遍,并出現在許多實際環境中,例如在CIFAR10上訓練的卷積神經網絡(CNN)或在Imagenette上訓練的Resnet。我們引入了延遲魯棒性的新概念,即DNN在插值和/或泛化之后才能理解對抗性示例并變得魯棒。我們基于DNN的輸入輸出映射的局部復雜度提出了延遲泛化和延遲魯棒性的出現解釋。我們的局部復雜度測量了"DNN輸入空間中所謂的"線性區域"(也稱為樣條分區區域)的密度,并作為訓練的有用進展測量。我們首次提供了證據表明,在分類問題中,線性區域在訓練過程中會發生相變,之后它們會遠離訓練樣本(使DNN在那里的映射更平滑),并朝著決策邊界移動(使DNN在那里的映射不那么平滑)。Grokking發生在相變之后,因為DNN映射在訓練點周圍的線性化導致了輸入空間的魯棒分區的出現。更多詳情請參閱網址:https://bit.ly/grok-adversarial

2、DistriFusion: Distributed Parallel Inference for High-Resolution Diffusion Models

中文標題:DistriFusion:高分辨率擴散模型的分布式并行推理

簡介:擴散模型在生成高質量圖像方面已經取得了巨大的成功。然而,由于計算成本的限制,使用擴散模型生成高分辨率圖像仍然面臨挑戰,這導致交互式應用程序的響應延遲無法接受。為了解決這個問題,本文提出了DistriFusion方法,通過充分利用多個GPU之間的并行性。我們的方法將模型輸入分成多個補丁,并將每個補丁分配給一個GPU進行處理。然而,簡單地實現這樣的算法會破壞補丁之間的相互作用并導致失真,而將這種相互作用納入算法中則會增加大量的通信開銷。為了克服這個困境,我們觀察到相鄰擴散步驟的輸入具有很高的相似性,并提出了位移補丁并行性的概念。該方法通過重復使用前一時間步驟的預計算特征圖作為當前步驟的上下文,利用擴散過程的順序性。因此,我們的方法支持異步通信,并可以通過計算進行流水線處理。經過大量實驗證明,我們的方法可以應用于最新的Stable Diffusion XL模型,而不會降低生成圖像的質量。與使用單個NVIDIA A100 GPU的情況相比,在使用8個GPU時,我們實現了高達6.1倍的加速。我們已經在https://github.com/mit-han-lab/distrifuser上公開了我們的代碼。

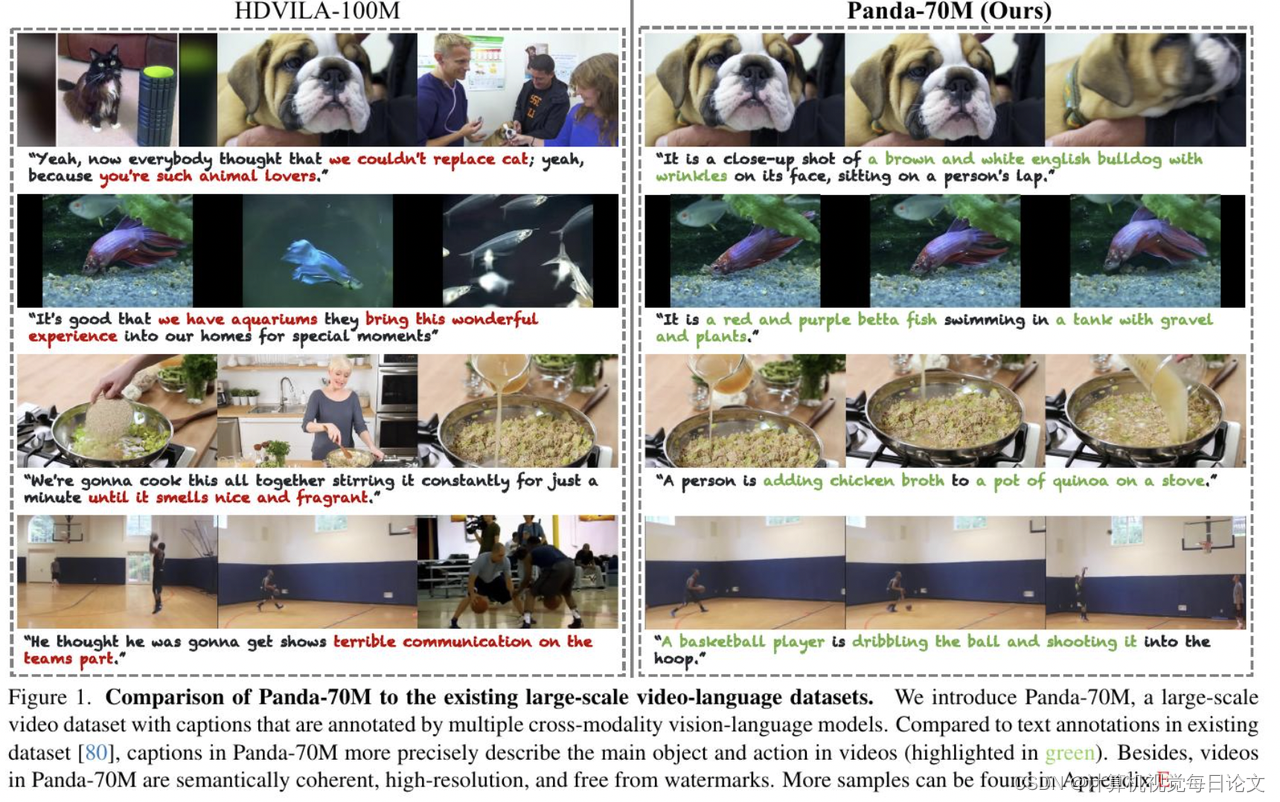

3、Panda-70M: Captioning 70M Videos with Multiple Cross-Modality Teachers

中文標題:Panda-70M:與多個跨模態教師一起為 70M 視頻添加字幕

簡介:數據和注釋的質量對下游模型的質量產生了限制。盡管存在大量的文本語料庫和圖像-文本對,但獲取高質量的視頻-文本數據卻非常困難。首先,手動標注非常耗時,因為需要注釋者觀看整個視頻。其次,視頻具有時間維度,由多個場景和多個動作組成。為了構建一個具有高質量標題的視頻數據集,我們提出了一種自動方法,利用多模態輸入,如文本視頻描述、字幕和單個視頻幀。具體來說,我們從公開可用的HD-VILA-100M數據集中收集了380萬個高分辨率視頻。然后,我們將這些視頻分成語義一致的片段,并使用多個跨模態的教師模型為每個視頻獲取標題。接下來,我們在一個小的子集上微調檢索模型,手動選擇每個視頻的最佳標題,然后將該模型應用于整個數據集,以選擇最佳標題作為注釋。通過這種方式,我們獲得了一個包含70M個視頻與高質量文本標題配對的數據集,稱為Panda-70M。我們展示了該數據集在三個下游任務上的價值:視頻字幕生成、視頻和文本檢索以及文本驅動的視頻生成。在所有任務中,基于我們提出的數據集進行訓練的模型在大多數指標上顯著優于其他模型。

)