文章目錄

- 前言

- 1、DF常用的兩種創建方式

- 方式一:通過np來生成

- 方式二:通過字典來生成

- 2、pandas常用的屬性及方法

- 3、Pandas Select(數據選擇)

- 4、Pandas Set_values設置值

- 5、Pandas Nan處理缺失值

- 方法一:剔除缺失值所在的行或列

- 方法二:填充Nan值

- 方法三:顯示Nan值的位置,做進一步處理

- 6、Pandas導入導出數據

- 7、pandas合并操作(重點)

- 1、concat

- 2、merge(更常用的操作)

- 其他Demo

- 1、從某行讀取數據

- 2、判斷某列是否含有某值

- 3、練手的Demo

前言

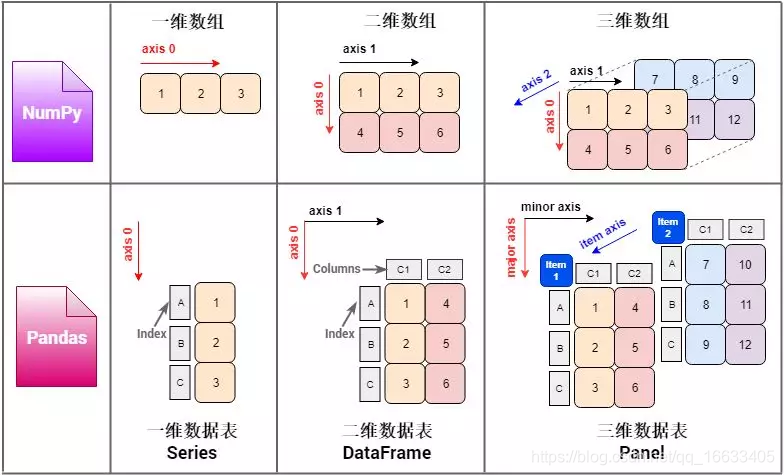

pandas:是一個數據分析包,靈活處理缺失值、類SQL操作,能處理多種類型的數據。

DataFrame:表格型的數據結構,含有一組有序的列,每列的值的類型不同。可以看做是Series組成的字典(key為列名,value為Series)

Series:類map的數據結構,區別是左邊是一個index值,右邊是value值。

1、DF常用的兩種創建方式

兩種方式:通過numpy和字典創建

方式一:通過np來生成

#生成時間序列

dates = pd.date_range('20160101', periods=6)

#index相當于索引參考數據庫中的索引,即行。生成DataFrame的第一種方式:通過np來生成

df = pd.DataFrame(np.random.randn(6,4), index=dates, columns=['A','B','C','D'])#方法1.1、通過數組創建

arr = [0, 1, 2, 3, 4]

df = pd.Series(arr) # 如果不指定索引,則默認從 0 開始

方式二:通過字典來生成

#生成DataFrame的第二種方式:通過字典生成

df2 =pd.DataFrame({'A' : 1.,'B' : pd.Timestamp('20130102'),'C' : pd.Series(1,index=list(range(4)),dtype='float32'),'D' : np.array([3] * 4,dtype='int32'),'E' : pd.Categorical(["test","train","test","train"]),'F' : 'foo'})

2、pandas常用的屬性及方法

df2.dtypes

df.index:索引即行

df.columns:列

df.T:轉置

df.describe():描述df的一些常用的數學值即均值、方差等。基于列來統計的

df.sort_index(axis=1, ascending=False):按行排序

df.sort_values(by=‘B’):按某一列進行排序

3、Pandas Select(數據選擇)

#df['A']與df.A選擇列是等效的

print(df['A'], df.A)#選中列名#選擇行也是等效的。注意[0:3)是左閉(包含)右開(開除)

print(df[0:3], df['20130102':'20130104'])#選中行號

選擇數據的四種方法:

方法一:#通過lab(列或行標簽)來選擇數據

# select by label: loc

print(df.loc[:,["A","B"]])

#方法二

print(df[["A", "C"]])

方法二:#通過位置來選擇數據

# select by position: iloc

#前三行數據

print(df.iloc[0:3])

# 方法二

#df.head(3)

方法三:混合選擇

#結合前面兩種選擇數據的方法:即按標簽和位置選擇數據

# mixed selection: ix

#第1-3行、A和C列的數據

print(df.ix[:3, ['A', 'C']])

方法四:#通過判斷選擇部分數據

# Boolean indexing

#選擇df中A列表大于0的所有的行數據

print(df[df["A"] > 0])

4、Pandas Set_values設置值

設置值的操作直接把選擇值的操作移植過來添加想要設置的值即可

特別注意的一點是:添加數據的時候直接聲明要添加的數據的標簽和值即可

#添加數據

df['F'] = np.nan

5、Pandas Nan處理缺失值

pandas處理缺失值的三種方法:

方法一:剔除缺失值所在的行或列

#剔除df中有Nan的行(也可單獨對某一列進行處理)

print(df.dropna(axis=0, how='any'))

# how={'any', 'all'}:any有一個Nan即剔除;all全部為Nan即剔除。

方法二:填充Nan值

#將Nan值填充為0

print(df.fillna(value=0))

方法三:顯示Nan值的位置,做進一步處理

#顯示出pd的A列中值是否為Nan;是為True否為False

print(df["A"].isnull())

#進一步處理

#判斷pd中是否有nan,有的話返回True,沒有的話返回False。any:只要包含一個true則返回true

print(np.any(pd.isnull(df))==True)

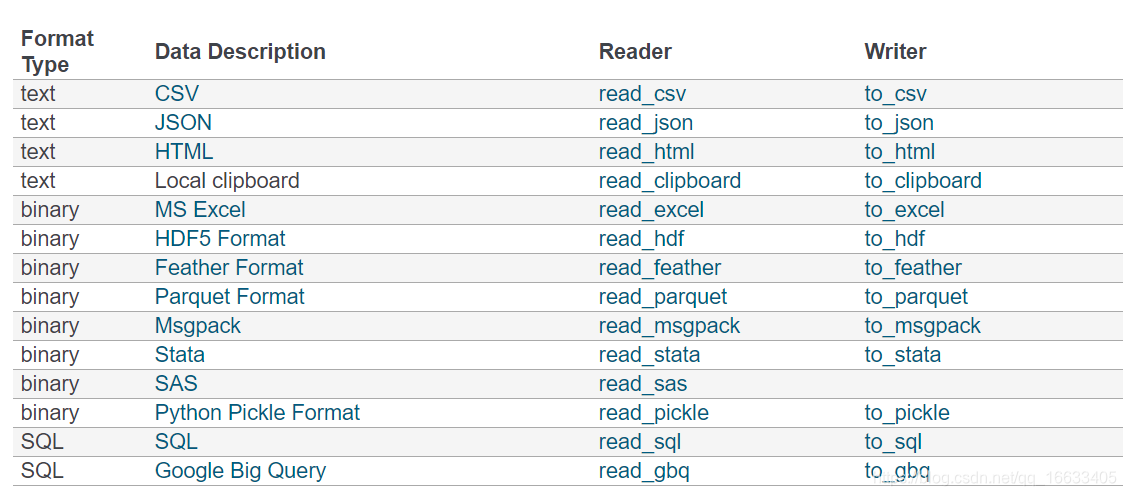

6、Pandas導入導出數據

讀取、保存數據的方法:

# read from

data = pd.read_csv('student.csv')

# save to

data.to_pickle('student.pickle')

7、pandas合并操作(重點)

1、concat

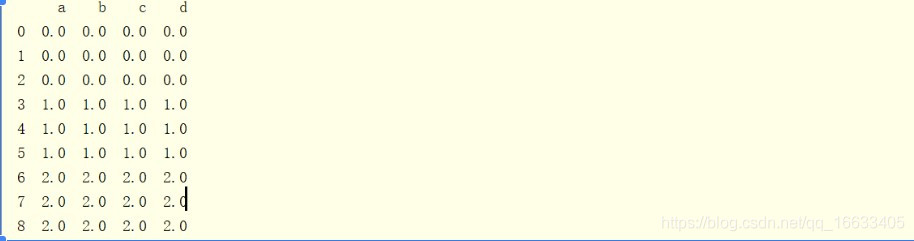

#將三個df進行合并,按行合并,ignore_index:忽略三個df之前的索引

res = pd.concat([df1, df2, df3], axis=0, ignore_index=True)

#參考SQL的join操作:outer join

res = pd.concat([df1, df2], axis=1, join='outer')#inner join:理解為將兩個df的index作為連接條件進行join,所以只保留的2和3

res = pd.concat([df1, df2], axis=1, join='inner')#默認向下追加數據

res = df1.append(df2, ignore_index=True)

concat:不需要指定對應的鏈接條件,按軸進行合并!

merge:必須指定對應的鏈接條件即鏈接的字段!

2、merge(更常用的操作)

知道merge的核心思想也就是SQL的join操作

注意以下幾點:

1、注意連接條件:一個或多個key;還可以通過對比index來連接

2、注意連接方式:[‘left’, ‘right’, ‘outer’, ‘inner’]

# merging two df by key/keys. (may be used in database)

res = pd.merge(left, right, on='key')

# consider two keys

# default for how='inner':即取共用的key

# how = ['left', 'right', 'outer', 'inner']

res = pd.merge(left, right, on=['key1', 'key2'], how='inner')

# indicator:將join的具體信息顯示出來即怎么進行merge。

res = pd.merge(df1, df2, on='col1', how='outer', indicator=True)

#通過對比index來進行join操作

# left_index and right_index

res = pd.merge(left, right, left_index=True, right_index=True, how='outer')

其他Demo

1、從某行讀取數據

(heard=None:列名為None;=0則代表列名為第0行數據),并篩選出其中的幾列數據并自定義列名

all_user_data = pd.read_csv("tf_bank_cus.csv",header=None,skiprows=int(record_number_row),encoding="utf-8")

all_user_data=all_user_data[[1,3,4,10,14,24]]

all_user_data.columns=['applyno','customername','certid','paydate','partnercode','contactno']

2、判斷某列是否含有某值

pause_call_number_row_index = all_user_data[all_user_data['contactno'].isin([pause_call_number])]

#df[df['列名'].isin([相應的值])]返回值為一整行的數據。通過index獲得索引值

3、練手的Demo

**基本操作**import numpy as npdata = {'animal': ['cat', 'cat', 'snake', 'dog', 'dog', 'cat', 'snake', 'cat', 'dog', 'dog'],'age': [2.5, 3, 0.5, np.nan, 5, 2, 4.5, np.nan, 7, 3],'visits': [1, 3, 2, 3, 2, 3, 1, 1, 2, 1],'priority': ['yes', 'yes', 'no', 'yes', 'no', 'no', 'no', 'yes', 'no', 'no']}labels = ['a', 'b', 'c', 'd', 'e', 'f', 'g', 'h', 'i', 'j']df = pd.DataFrame(data, index=labels)1、計算每個不同種類animal的age的平均數

df.groupby('animal')['age'].mean()

2、計算df中每個種類animal的數量

df['animal'].value_counts()

3、先按age降序排列,后按visits升序排列

df.sort_values(by=['age', 'visits'], ascending=[False, True])

4、將priority列中的yes, no替換為布爾值True, False

df['priority'] = df['priority'].map({'yes': True, 'no': False})

5、將animal列中的snake替換為python

df['animal'] = df['animal'].replace('snake', 'python')6、對每種animal的每種不同數量visits,計算平均age,即,返回一個表格,行是aniaml種類,列是visits數量,表格值是行動物種類列訪客數量的平均年齡

df.pivot_table(index='animal', columns='visits', values='age', aggfunc='mean')**進階操作**7、有一列整數列A的DatraFrame,刪除數值重復的行

#判斷是否有重復項

用duplicated()函數判斷

#有重復項,則可以用drop_duplicates()移除重復項

df1 = df.drop_duplicates(subset='A')

print(df1)8、一個全數值DatraFrame,每個數字減去該行的平均數

df = pd.DataFrame(np.random.random(size=(5, 3)))

print(df)

df1 = df.sub(df.mean(axis=1), axis=0)

print(df1)9、一個有5列的DataFrame,求哪一列的和最小

df = pd.DataFrame(np.random.random(size=(5, 5)), columns=list('abcde'))

print(df)

df.sum().idxmin()10、給定DataFrame,求A列每個值的前3大的B的和

df = pd.DataFrame({'A': list('aaabbcaabcccbbc'), 'B': [12,345,3,1,45,14,4,52,54,23,235,21,57,3,87]})

print(df)

df1 = df.groupby('A')['B'].nlargest(3).sum(level=0)

print(df1)11、給定DataFrame,有列A, B,A的值在1-100(含),對A列每10步長,求對應的B的和

df = pd.DataFrame({'A': [1,2,11,11,33,34,35,40,79,99], 'B': [1,2,11,11,33,34,35,40,79,99]})

print(df)

df1 = df.groupby(pd.cut(df['A'], np.arange(0, 101, 10)))['B'].sum()

print(df1)12、給定DataFrame,計算每個元素至左邊最近的0(或者至開頭)的距離,生成新列y

df = pd.DataFrame({'X': [7, 2, 0, 3, 4, 2, 5, 0, 3, 4]})izero = np.r_[-1, (df['X'] == 0).to_numpy().nonzero()[0]] # 標記0的位置

idx = np.arange(len(df))

df['Y'] = idx - izero[np.searchsorted(izero - 1, idx) - 1]

print(df)# 方法二

# x = (df['X'] != 0).cumsum()

# y = x != x.shift()

# df['Y'] = y.groupby((y != y.shift()).cumsum()).cumsum()# 方法三

# df['Y'] = df.groupby((df['X'] == 0).cumsum()).cumcount()

#first_zero_idx = (df['X'] == 0).idxmax()

# df['Y'].iloc[0:first_zero_idx] += 113、一個全數值的DataFrame,返回最大3值的坐標

df = pd.DataFrame(np.random.random(size=(5, 3)))

print(df)

df.unstack().sort_values()[-3:].index.tolist()14、給定DataFrame,將負值代替為同組的平均值

df = pd.DataFrame({'grps': list('aaabbcaabcccbbc'), 'vals': [-12,345,3,1,45,14,4,-52,54,23,-235,21,57,3,87]})

print(df)def replace(group):mask = group<0group[mask] = group[~mask].mean()return groupdf['vals'] = df.groupby(['grps'])['vals'].transform(replace)

print(df)15、計算3位滑動窗口的平均值,忽略NAN

df = pd.DataFrame({'group': list('aabbabbbabab'),'value': [1, 2, 3, np.nan, 2, 3, np.nan, 1, 7, 3, np.nan, 8]})

print(df)g1 = df.groupby(['group'])['value']

g2 = df.fillna(0).groupby(['group'])['value'] s = g2.rolling(3, min_periods=1).sum() / g1.rolling(3, min_periods=1).count()s.reset_index(level=0, drop=True).sort_index()**Series 和 Datetime索引**16、創建Series s,將2015所有工作日作為隨機值的索引

dti = pd.date_range(start='2015-01-01', end='2015-12-31', freq='B')

s = pd.Series(np.random.rand(len(dti)), index=dti)

s.head(10)17、所有禮拜三的值求和

s[s.index.weekday == 2].sum()

18、求每個自然月的平均數

s.resample('M').mean()

19、每連續4個月為一組,求最大值所在的日期

s.groupby(pd.Grouper(freq='4M')).idxmax()

20、創建2015-2016每月第三個星期四的序列

pd.date_range('2015-01-01', '2016-12-31', freq='WOM-3THU')**數據清洗**df = pd.DataFrame({'From_To': ['LoNDon_paris', 'MAdrid_miLAN', 'londON_StockhOlm', 'Budapest_PaRis', 'Brussels_londOn'],'FlightNumber': [10045, np.nan, 10065, np.nan, 10085],'RecentDelays': [[23, 47], [], [24, 43, 87], [13], [67, 32]],'Airline': ['KLM(!)', '<Air France> (12)', '(British Airways. )', '12. Air France', '"Swiss Air"']})

df

21、FlightNumber列中有些值缺失了,他們本來應該是每一行增加10,填充缺失的數值,并且令數據類型為整數

df['FlightNumber'] = df['FlightNumber'].interpolate().astype(int)

df

22、將From_To列從_分開,分成From, To兩列,并刪除原始列

temp = df.From_To.str.split('_', expand=True)

temp.columns = ['From', 'To']

df = df.join(temp)

df = df.drop('From_To', axis=1)

df

23、將From, To大小寫統一

df['From'] = df['From'].str.capitalize()

df['To'] = df['To'].str.capitalize()

df

24、Airline列,有一些多余的標點符號,需要提取出正確的航司名稱。舉例:'(British Airways. )' 應該改為 'British Airways'.

df['Airline'] = df['Airline'].str.extract('([a-zA-Z\s]+)', expand=False).str.strip()

df

25、Airline列,數據被以列表的形式錄入,但是我們希望每個數字被錄入成單獨一列,delay_1, delay_2, …沒有的用NAN替代。

delays = df['RecentDelays'].apply(pd.Series)

delays.columns = ['delay_{}'.format(n) for n in range(1, len(delays.columns)+1)]

df = df.drop('RecentDelays', axis=1).join(delays)df**層次化索引**26、用 letters = ['A', 'B', 'C'] 和 numbers = list(range(10))的組合作為系列隨機值的層次化索引

letters = ['A', 'B', 'C']

numbers = list(range(4))mi = pd.MultiIndex.from_product([letters, numbers])

s = pd.Series(np.random.rand(12), index=mi)

s

27、檢查s是否是字典順序排序的

s.index.is_lexsorted()

# 方法二

# s.index.lexsort_depth == s.index.nlevels

28、選擇二級索引為1, 3的行

s.loc[:, [1, 3]]

29、對s進行切片操作,取一級索引從頭至B,二級索引從2開始到最后

s.loc[pd.IndexSlice[:'B', 2:]]

# 方法二

# s.loc[slice(None, 'B'), slice(2, None)]

30、計算每個一級索引的和(A, B, C每一個的和)

s.sum(level=0)

#方法二

#s.unstack().sum(axis=0)

31、交換索引等級,新的Series是字典順序嗎?不是的話請排序

new_s = s.swaplevel(0, 1)

print(new_s)

print(new_s.index.is_lexsorted())

new_s = new_s.sort_index()

print(new_s)

![BZOJ 3093: [Fdu校賽2012] A Famous Game](http://pic.xiahunao.cn/BZOJ 3093: [Fdu校賽2012] A Famous Game)

(1406數據庫字段超出長度錯誤))

)

![導入Anaconda中的第三方庫運行時報錯:ImportError: Missing required dependencies ['pandas']](http://pic.xiahunao.cn/導入Anaconda中的第三方庫運行時報錯:ImportError: Missing required dependencies ['pandas'])

)