摘要: 這篇文章將會手把手教你安裝hadoop,只要你細心按照文章中的步驟操作,hadoop肯定能正確安裝,絕對不會讓你崩潰

博主福利?給大家贈送一套hadoop視頻課程

授課老師是百度 hadoop 核心架構師?

內容包括hadoop入門、hadoop生態架構以及大型hadoop商業實戰案例。?

講的很細致, MapReduce 就講了 15 個小時。?

學完后可以勝任 hadoop 的開發工作,很多人學的這個課程找到的工作。?

(包括指導書、練習代碼、和用到的軟件都打包了)?

先到先得先學習。聯系老師微信ganshiyu1026,備注OSchina。即可免費領取

部分視頻截圖展示

?

如果你看了我的上一篇文章,那此時你對hadoop已經有了一個大概的了解,那接下來這篇文章就教大家怎么安裝hadoop環境,只要你用心,仔細的跟著文章中講到的做,肯定能正確安裝。

?

? ???安裝hadoop環境

由于大家在學習hadoop時候,主要以Hadoop 1.0環境為主學習就可以,所以這主要介紹如何搭建Hadoop 1.0分布式環境。

整個分布式環境運行在帶有linux操作系統的虛擬機上,至于虛擬機和linux系統的安裝這里暫不做過多介紹。

安裝Hadoop分布式環境:

1)?下載Hadoop安裝包:

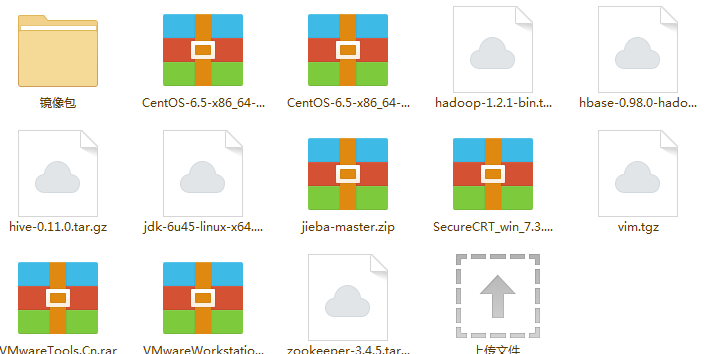

百度網盤下載地址:點擊下載???中可以找到hadoop-1.2.1-bin.tar.gz文件

使用securtCRT的rz功能上傳hadoop-1.2.1-bin.tar.gz這個文件到虛擬機的系統中。

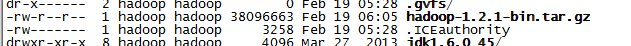

同樣在securtcrt中ll時,能得到

?

?

2)?安裝Hadoop安裝包:

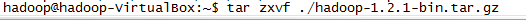

l?首先將安裝包解壓縮:

?

?

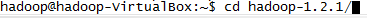

l?Linux終端執行cd進入相應目錄:

?

?

l?新增tmp目錄,mkdir ?/home/hadoop/hadoop-1.2.1/tmp

?

?

3)?配置Hadoop:

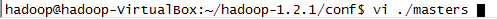

l?使用vim修改master文件內容:

?

?

將localhost修改成master:

?

?

最后保存退出。

l?修改slaves文件

注意,這里準備設置幾臺slave機器,就寫幾個,因為當前分布式環境有四個虛擬機,一臺做master,三臺做slave,所以這里寫成了三個slave

?

?

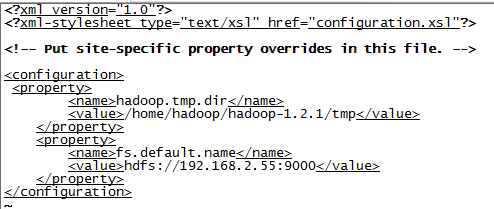

l?修改core-site.xml文件:

?

?

【注意】中間的ip地址,不要輸入192.168.2.55,根據自己的情況設置。

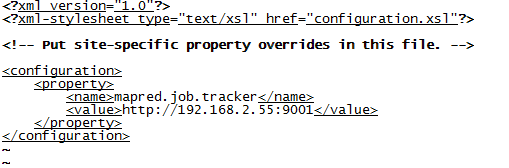

l?修改mapred-site.xml文件:

?

?

【注意】記得value的內容要以http開頭。

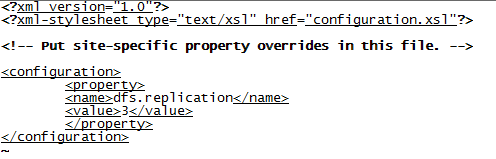

l?修改hdfs-site.xml文件:

?

?

其中,<value>3</value>視情況修改,如果有三臺slave機器,這里設置成3,如果只有1臺或2臺,修改成對應的值即可。

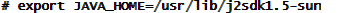

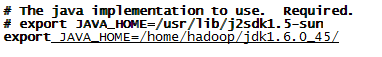

l?修改hadoo-env.sh文件

在

下新增export JAVA_HOME=/home/hadoop/jdk1.6.0_45/

?

?

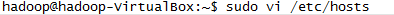

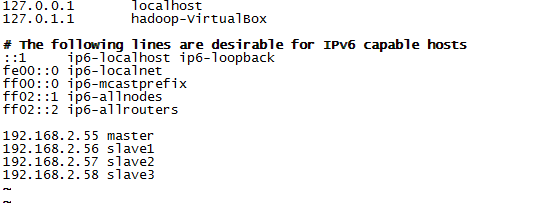

l?修改本地網絡配置:編輯/etc/hosts文件

?

?

?

?

【注意】Ip地址根據具體的情況要進行修改。

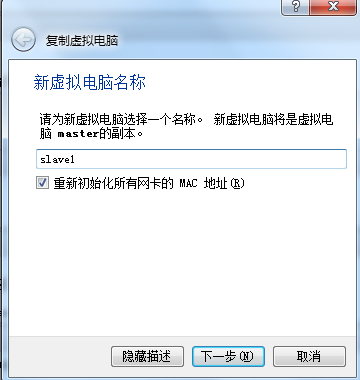

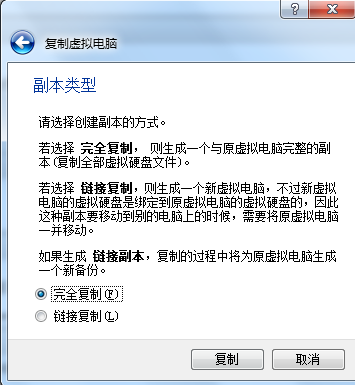

4)?復制虛擬機

l?關閉當前虛擬機,并復制多份

?

?

【注意】要選擇初始化所有網卡的mac地址

?

?

根據自己需求,復制2到3臺虛擬機作為slave,同樣要確認網絡連接方式為橋接。

l?設置所有機器的IP地址

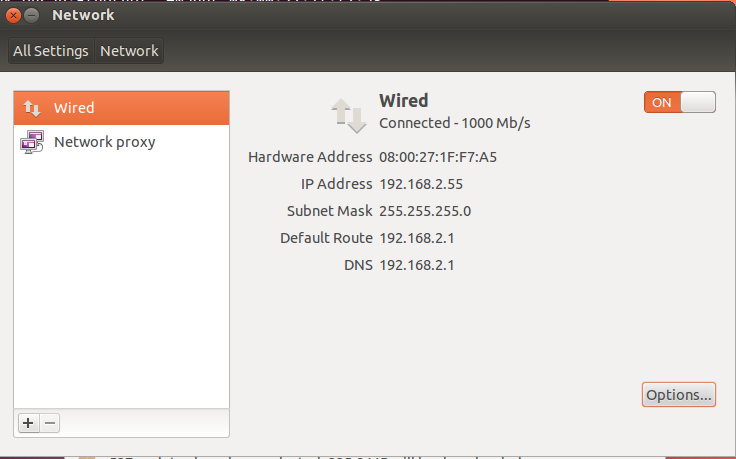

分別啟動虛擬機,修改機器的ip 地址,在虛擬機的圖形界面里,選擇設置 單擊打開,在彈出來的窗口里,選擇

單擊打開,在彈出來的窗口里,選擇

?

?

?

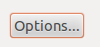

打開 ,修改成如下的形式,選擇ipv4 ,分配方式選擇成manual。

,修改成如下的形式,選擇ipv4 ,分配方式選擇成manual。

【注意】具體的ip地址,根據實際的情況來設置,因為培訓教室里都是192.168.2.x的網段,所以我這里設置成了192.168.2.x,每個人選擇自己的一個ip地址范圍,注意不要和其它人沖突了。

?

?

5)?建立互信關系

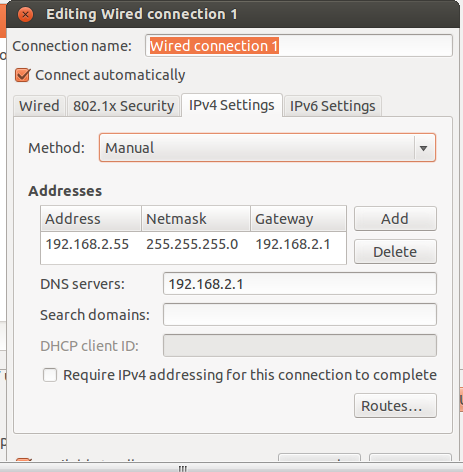

l?生成公私鑰,在master機器的虛擬機命令行下輸入ssh-keygen,一路回車,全默認

?

?

l?復制公鑰

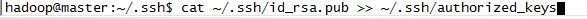

復制一份master的公鑰文件,cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

?

?

同樣,在所有的slave機器上,也在命令行中輸入ssh-keygen,一路回車,全默認

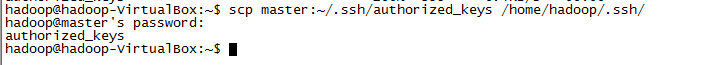

在所有的salve機器上,從master機器上復制master的公鑰文件:

?

?

l?測試連接

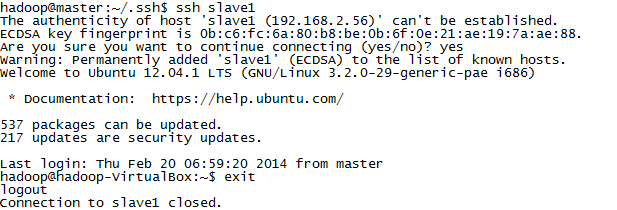

在master機器上分別向所有的slave機器發起聯接請求:

如:ssh slave1

?

?

【注意】記得一旦聯接上,所有的操作,就視同在對應的slave上操作,所以一定要記得使用exit退出聯接。

6)?啟動Hadoop:

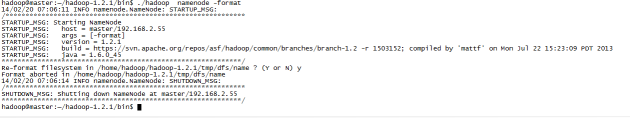

l?初始化:在master機器上,進入/home/hadoop/hadoop-1.2.1/bin目錄

?

?

在安裝包根目錄下運行./hadoop namenode?–format來初始化hadoop的文件系統。

?

?

l?啟動

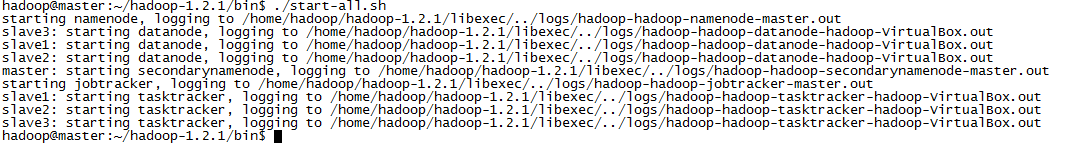

執行./start-all.sh,如果中間過程提示要判斷是否,需要輸入yes

?

?

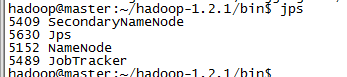

輸入jps,查看進程是否都正常啟動。

?

?

如果一切正常,應當有如上的一些進程存在。

7)?測試系統

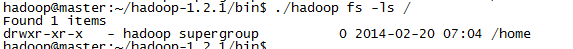

輸入./hadoop fs?–ls /

?

?

能正常顯示文件系統。

如此,hadoop系統搭建完成。否則,可以去/home/hadoop/hadoop-1.2.1/logs目錄下,查看缺少的進程中,對應的出錯日志。

)

)

)

)