百日筑基篇——python爬蟲學習(一)

文章目錄

- 前言

- 一、python爬蟲介紹

- 二、URL管理器

- 三、所需基礎模塊的介紹

- 1. requests

- 2. BeautifulSoup

- 1. HTML介紹

- 2. 網頁解析器

- 四、實操

- 1. 代碼展示

- 2. 代碼解釋

- 1. 將大文件劃分為小的文件(根據AA的ID數量劃分)

- 2. 獲得結果頁面的url

- 3. 獲取結果頁面,提取出所需信息

- 4. 文件合并操作

- 總結

前言

隨著學習的深入,有關從各種不同的數據庫中以及互聯網上的海量信息,如何有選擇性的爬取我們所需的數據以方便我們的數據分析工作,爬蟲的學習是必要的。

一、python爬蟲介紹

Python爬蟲是指使用Python編程語言編寫的程序,通過模擬瀏覽器行為從網頁中提取數據的過程

主要用途包括:

-

數據采集:通過爬蟲可以從互聯網上收集大量的數據,如新聞、論壇帖子、商品信息等。

-

數據分析:爬蟲可以獲取特定網站或多個網站的數據,進行統計和分析。

-

自動化測試:爬蟲可以模擬用戶行為,自動化地訪問網站,并檢查網站的功能、性能等。

-

內容聚合:通過爬蟲可以自動化地從多個網站上獲取信息,并將其聚合成為一個平臺,方便用戶瀏覽。

二、URL管理器

是指對爬取URL進行管理,防止重復和循環爬取,方便新增URL和取出URL。

class UrlManager():"""url管理器"""def __init__(self):self.new_urls = set()self.old_urls = set()def add_newurl(self,url):if url is None or len(url) == 0:returnif url in self.new_urls or url in self.old_urls:returnself.new_urls.add(url)def add_newurls(self,urls):if urls is None or len(urls) == 0:returnfor url in urls:self.add_newurl(url)def get_url(self):if self.has_newurl():url = self.new_urls.pop()self.old_urls.add(url)return urlelse:return Nonedef has_newurl(self):return len(self.new_urls) > 0該類中創建了兩個集合:new_urls和 old_urls ,分別表示新增url和已爬取完的url的存儲集合。

定義了四個方法,

- add_newurl(self, url): 添加新的URL到new_urls集合中。如果URL為空或已經存在于new_urls或old_urls中,則不添加。

- add_newurls(self, urls): 批量添加URL到new_urls集合中。如果URL為空,則不添加。

- get_url(self): 從new_urls中獲取一個未爬取的URL,將其移動到old_urls集合中,并返回該URL。如果new_urls為空,則返回None。

- has_newurl(self): 判斷是否還有未爬取的URL。返回new_urls集合的長度是否大于0。

三、所需基礎模塊的介紹

1. requests

用于發送HTTP請求,并獲取網頁內容。

import requests

requests.post(url=,params=,data=,headers=,timeout=,verify=,allow_redirects=,cookies=)

#里面的參數依次代表請求的URL、查詢參數、請求數據、請求頭、超時時間、SSL證書驗證、重定向處理和Cookies。url = "https://wolfpsort.hgc.jp/results/pLAcbca22a5a0ccf7d913a9fc0fb140c3f4.html"r = requests.post(url)

#查看狀態碼,200為請求成功

print(r.status_code)#查看當前編碼,以及改變編碼

print(r.encoding)

r.encoding = "utf-8"

print(r.encoding)#查看返回的網頁內容

print(r.text)#查看返回的http的請求頭

print(r.headers)#查看實際返回的URL

print(r.url)#以字節的方式返回內容

print(r.content)#查看服務端寫入本地的cookies數據

print(r.cookies)2. BeautifulSoup

用于解析HTML或XML等文檔,提取所需的數據。

1. HTML介紹

HTML指的是超文本標記語言,一種用于創建網頁結構的標記語言。它由一系列的元素(標簽)組成,通過標簽來描述網頁中的內容和結構。

HTML標簽:

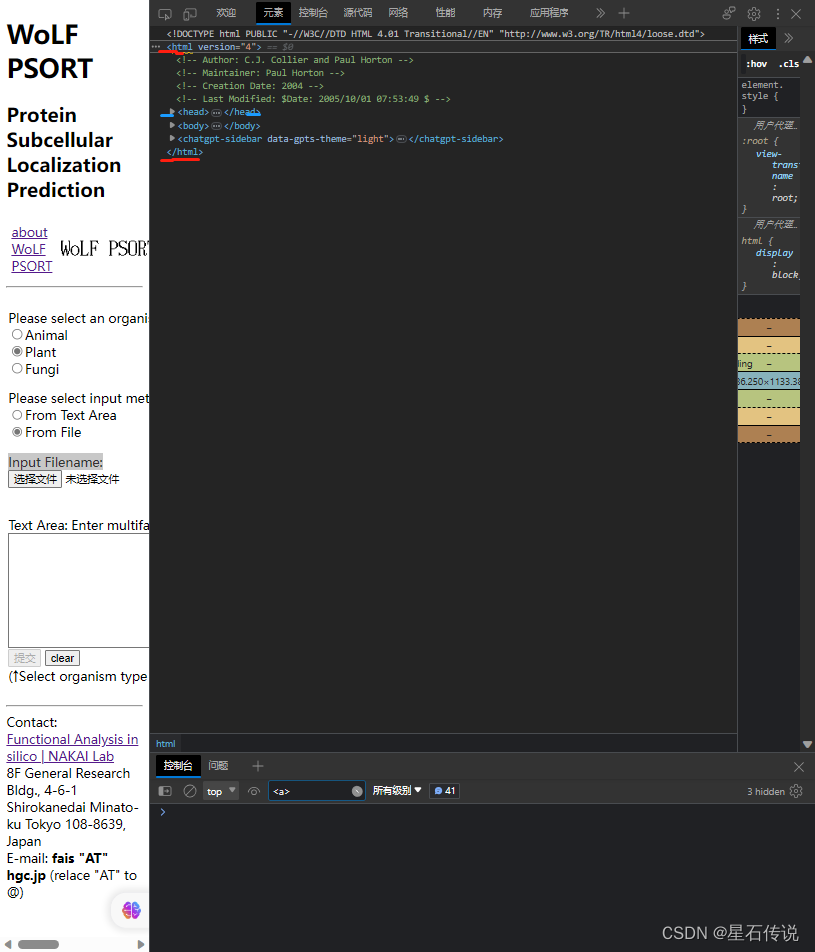

是由< >包圍的關鍵詞,標簽通常成對出現,且標簽對中的第一個標簽是開始標簽,第二個則是結束標簽,如下圖所示:

在HTML語言中,標簽中一般伴隨著屬性,比如:”id、class、herf等"

2. 網頁解析器

導入 BeautifulSoup 模塊

解析的一般步驟是:

- 得到HTML網頁的文本

- 創建BeautifulSoup對象

- 搜索節點 (使用find_all或 find,前者返回滿足條件的所有節點,后者返回第一個)

- 訪問節點 (名稱、屬性、文字等)

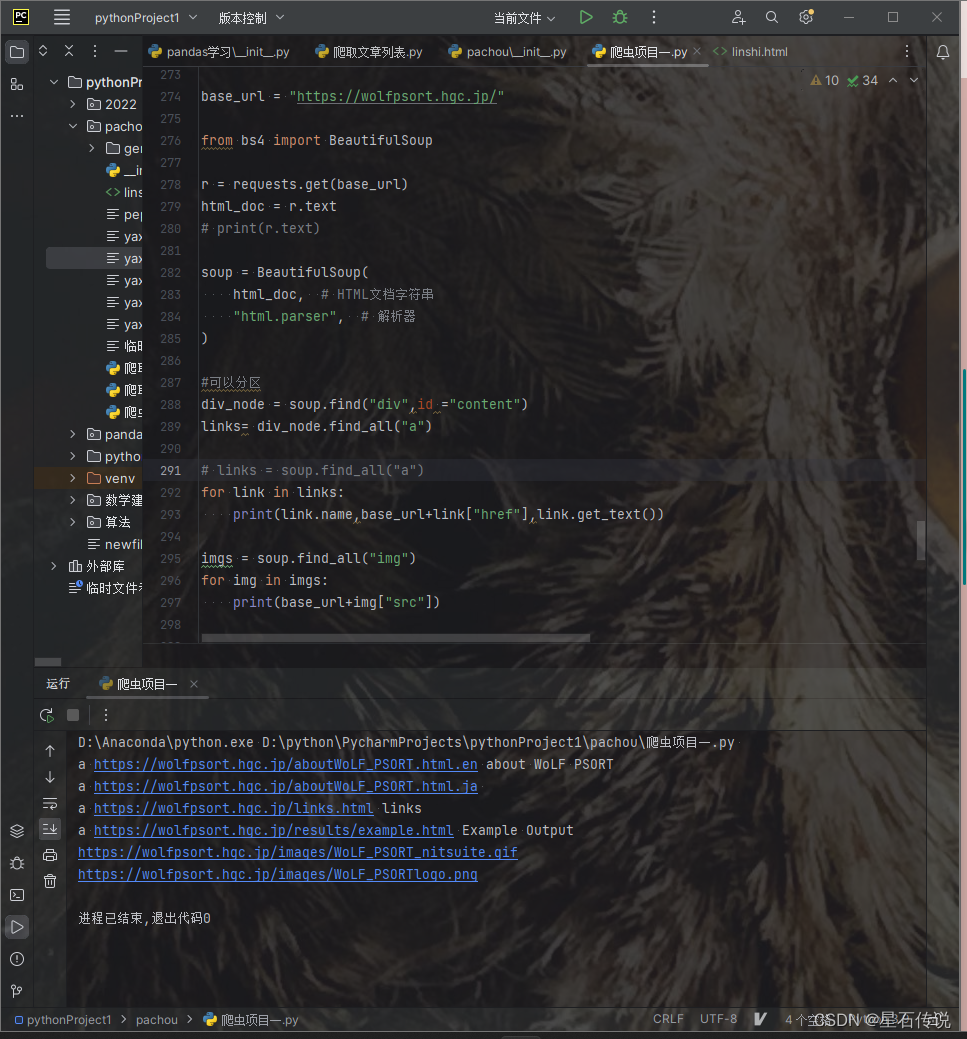

示例代碼如下:

base_url = "https://wolfpsort.hgc.jp/"from bs4 import BeautifulSoupwith open("D:\python\PycharmProjects\pythonProject1\pachou\linshi.html", "r", encoding="utf-8") as f:html_doc = f.read()soup = BeautifulSoup(html_doc, # HTML文檔字符串"html.parser", # 解析器

)#可以分區

div_node = soup.find("div",id ="content")

links= div_node.find_all("a")# links = soup.find_all("a")

for link in links:print(link.name,base_url+link["href"],link.get_text())imgs = soup.find_all("img")

for img in imgs:print(base_url+img["src"])

這是一個基于wolfpsort網頁的頁面內容的爬取,根據該網頁的HTML文本,可以通過標簽以及屬性的設置,來獲得我們所需的指定的節點,再獲取節點中的內容,如"herf"等

四、實操

1. 代碼展示

import time

from selenium import webdriver

from selenium.webdriver.common.by import By

import requests

import os

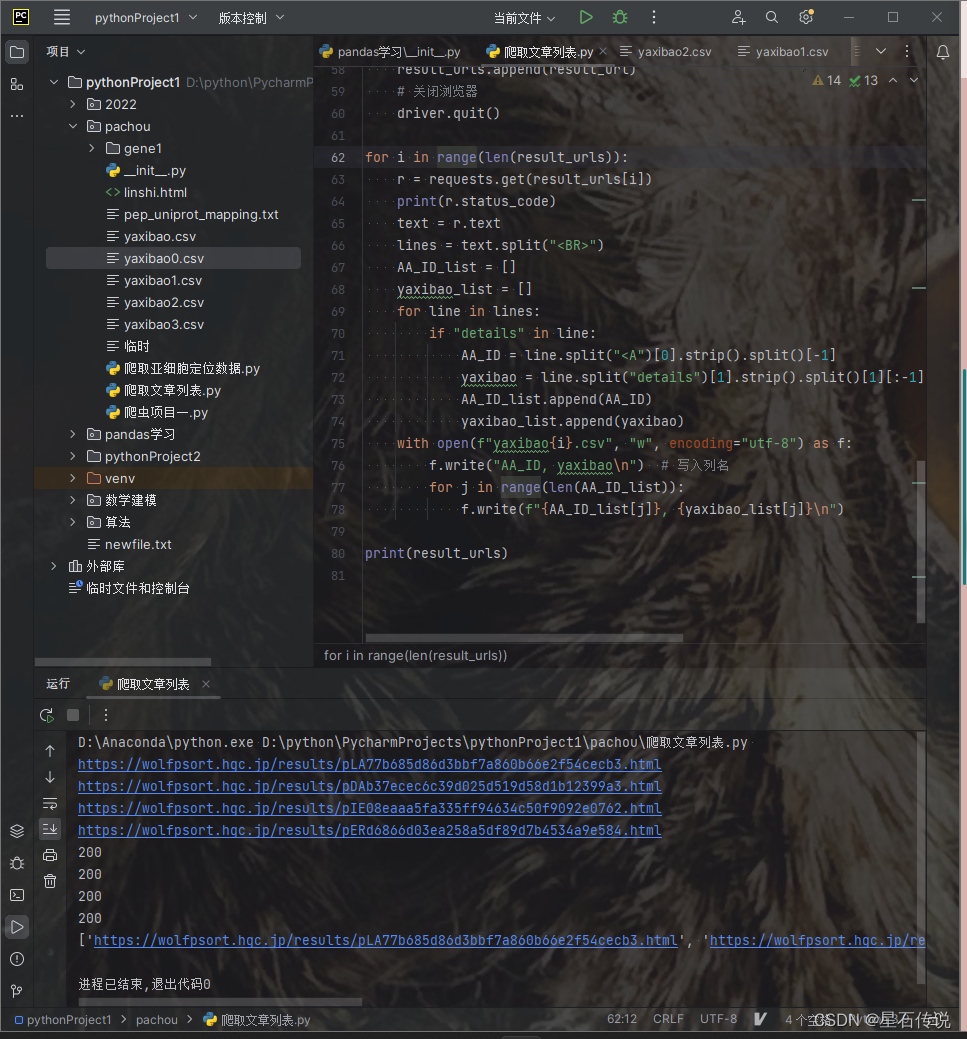

import pandas as pddef split_gene_file(source_file, output_folder, ids_per_file):os.makedirs(output_folder, exist_ok=True)current_file = Nonecount = 0with open(source_file, "r") as f:for line in f:if line.startswith(">"):count += 1if count % ids_per_file == 1:if current_file:current_file.close()output_file = f"{output_folder}/gene_file_{count // ids_per_file + 1}.csv"current_file = open(output_file, "w", encoding='utf-8')current_file.write(line)else:current_file.write(line)if current_file:current_file.close()split_gene_file("D:\yuceji\Lindera_aggregata.gene.pep", "gene1", 500)files = os.listdir("D:\python\PycharmProjects\pythonProject1\pachou\gene1")result_urls = []for i in range(0, 4): #可自行設置所需文件數# 設置WebDriver路徑,啟動瀏覽器driver = webdriver.Edge()# 打開網頁url = "https://wolfpsort.hgc.jp/"driver.get(url)time.sleep(5)wuzhong_type = driver.find_element(By.XPATH, '//*[@id="content"]/form/table/tbody/tr[1]/td[1]/p[1]/input[2]')wuzhong_type.click()wenjian_type = driver.find_element(By.XPATH, '//*[@id="content"]/form/table/tbody/tr[1]/td[1]/p[2]/input[2]')wenjian_type.click()input_element = driver.find_element(By.XPATH, '//*[@id="content"]/form/table/tbody/tr[1]/td[1]/p[3]/input')input_element.send_keys(f"D:\python\PycharmProjects\pythonProject1\pachou\gene1\gene_file_{i + 1}.csv")time.sleep(10)# 提交表單submit_button = driver.find_element(By.XPATH, '//*[@id="content"]/form/table/tbody/tr[2]/td/p/input[1]')submit_button.click()time.sleep(30)with open("result_urls","a",encoding="utf-8") as f:# 獲取結果頁面的URLresult_url = driver.current_urlf.write(result_url+ "\n")# 輸出結果頁面的URLprint(result_url)result_urls.append(result_url)# 關閉瀏覽器driver.quit()for i in range(len(result_urls)):r = requests.get(result_urls[i])print(r.status_code)text = r.textlines = text.split("<BR>")AA_ID_list = []yaxibao_list = []for line in lines:if "details" in line:AA_ID = line.split("<A")[0].strip().split()[-1]yaxibao = line.split("details")[1].strip().split()[1][:-1]AA_ID_list.append(AA_ID)yaxibao_list.append(yaxibao)with open(fr"D:\python\PycharmProjects\pythonProject1\pachou\result_dir\yaxibao{i}.csv", "w", encoding="utf-8") as f:f.write("AA_ID, yaxibao\n") # 寫入列名for j in range(len(AA_ID_list)):f.write(f"{AA_ID_list[j]}, {yaxibao_list[j]}\n")print(result_urls)# 再將所有的結果文件合并為一個大文件

result_csv = r"D:\python\PycharmProjects\pythonProject1\pachou\result_dir"

# 獲取結果文件列表

result_files = os.listdir(result_csv)[:-1]

print(result_files)

# 創建一個空的DataFrame用于存儲合并后的結果

merged_data = pd.DataFrame()

# 遍歷每個結果文件

for file in result_files:# 讀取結果文件df = pd.read_csv(result_csv + "\\" + file)#print(df)# 將結果文件的數據添加到合并后的DataFrame中merged_data = pd.concat([merged_data, df])

#print(merged_data)

# 保存合并后的結果到一個大文件

merged_data.to_csv("merged_results.csv", index=False)我運行了這個代碼,遍歷前面四個文件,發現都很好的得到了結果頁面的URL。說明這個代碼是可行的。

2. 代碼解釋

這個代碼差不多可以分為四個部分:

- 將大文件劃分為小的文件

- 使用selenium庫進行模擬用戶行為,以獲得結果頁面的url

- 使用requests模塊,通過上一步獲得的url,發送請求,獲取結果頁面,并提取出所需信息

- 文件合并操作,使用pandas庫中的concat方法,將前面得到的眾多小文件的結果整合到一個大文件中。

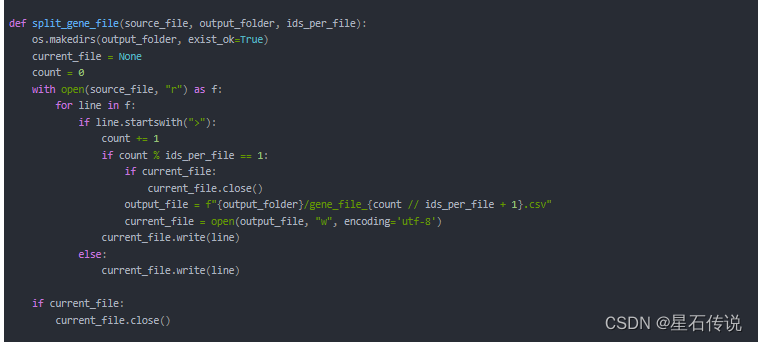

1. 將大文件劃分為小的文件(根據AA的ID數量劃分)

- 定義一個split_gene_file()函數,其中"ids_per_file"參數表示指定每個文件中的ID數

- 創建一個存儲文件的文件夾

- 使用with語句打開源文件,并且遍歷文件中的每一行,之后使用if語句判斷當前行是否是有ID的行,如果不是,就直接將當前行寫入當前文件(current_file);如果是,就將count(表示已讀取到的ID數)的數加上1,然后再判斷已讀取的ID數量是否達到了自己指定的每個文件的ID數量,如果達到了,就表示需要創建一個新的輸出文件output_file, 并將文件對象賦值給current_file變量,使用"w"模式表示以寫入模式打開文件,并將當前行寫入當前文件。

- 在處理完源文件后,檢查是否存在當前正在寫入的文件對象。如果是,則關閉該文件。

2. 獲得結果頁面的url

這是基于python的selenium庫,

Selenium是一個用于Web自動化的工具,可以用于模擬用戶在網頁瀏覽器上的行為,包括點擊、輸入、提交表單等操作。

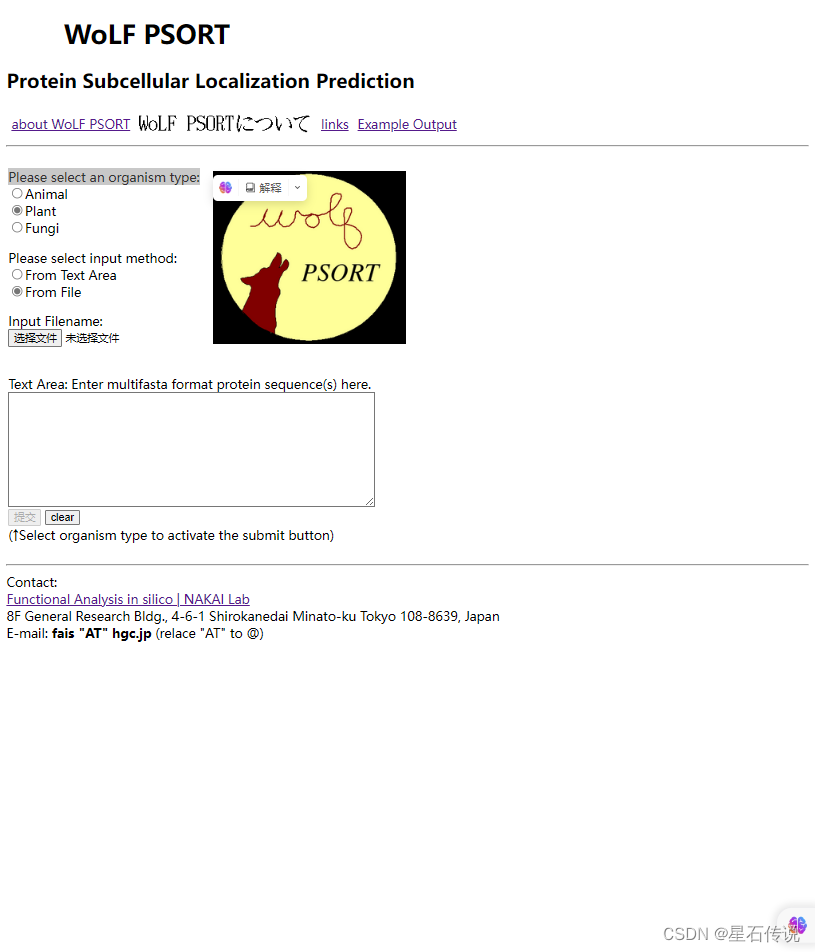

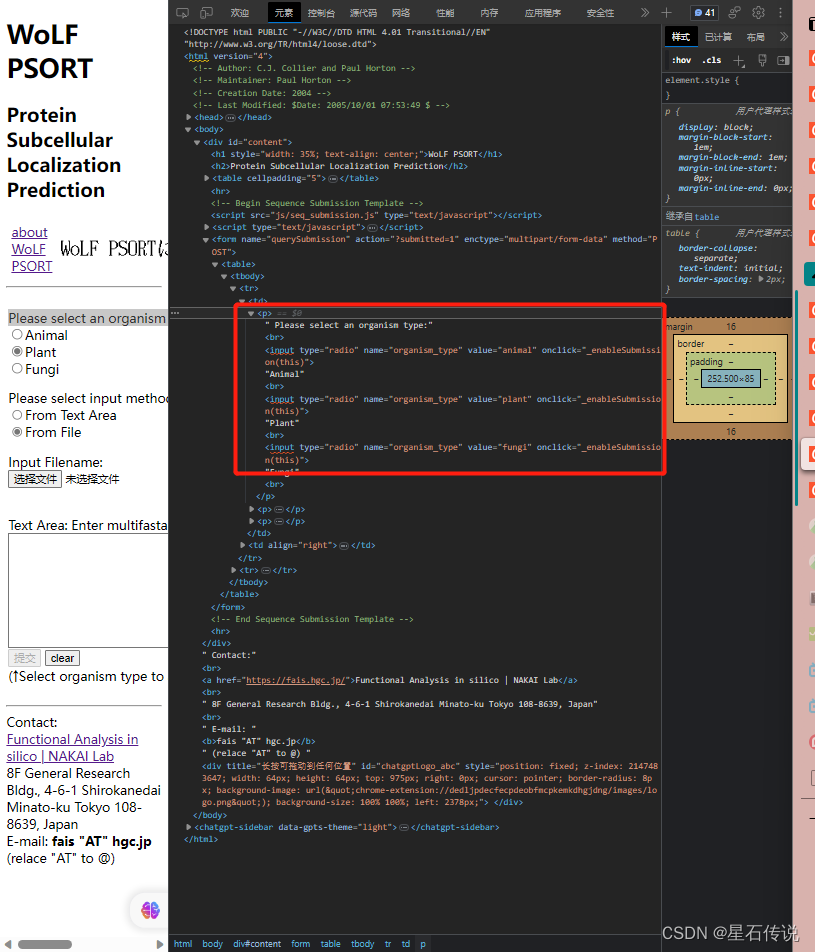

其中最主要的步驟還是查看官網頁面的源代碼,通過HTML文本的標簽獲取元素的定位。

例如:

我要查看”Please select an organism type:" ,可以右鍵單擊,然后點擊檢查

得到有關信息:

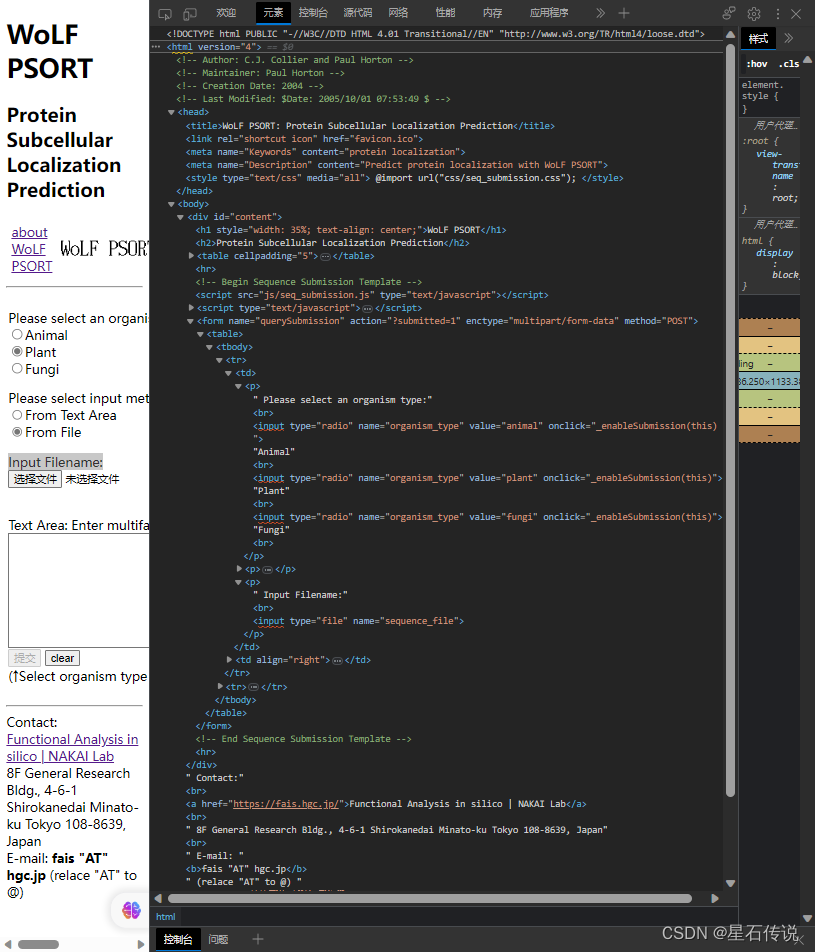

比如我在”Please select an organism type:“框中想選擇"Plant”,那么我只要選擇上圖紅框中表示輸入是"plant"的框就行,然后再右鍵選擇復制 “Xpath”

之后再將復制的Xpath粘貼到函數中,充當參數,如下所示:

wuzhong_type = driver.find_element(By.XPATH, '//*[@id="content"]/form/table/tbody/tr[1]/td[1]/p[1]/input[2]')

因為在這個定位元素函數中,我第一個參數填的是“By.XPATH”,故后面那個參數就便是元素的“Xpath”。

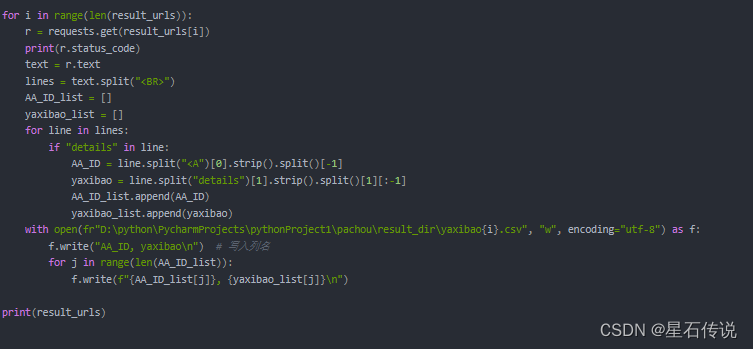

3. 獲取結果頁面,提取出所需信息

對前面得到的URL列表(result_urls)進行循環遍歷,并將得到的結果保存于指定文件中

4. 文件合并操作

前面得到的結果文件是通過循環得到的,故會是眾多小文件。若是欲將所有的結果信息合并于一個大文件中,可以使用pandas庫中的concat方法,來合并文件,最后將循環完畢后的合并結果,保存為一個csv文件。

總結

本章主要簡述了python爬蟲的有關信息,并且進行了一個實操(這個爬蟲是基于WoLF PSORT官網,爬取亞細胞定位結果的數據)。更多有關蛋白質亞細胞定位的信息,請看

亞細胞定位

零落成泥碾作塵,只有香如故。

–2023-8-13 筑基篇

{網絡通信設計①})

)

MyEclipse2019創建項目修改pom文件,加載springboot 及swagger-ui jar包)

)