激活函數的種類

對于激活函數的選擇,通常有以下幾種

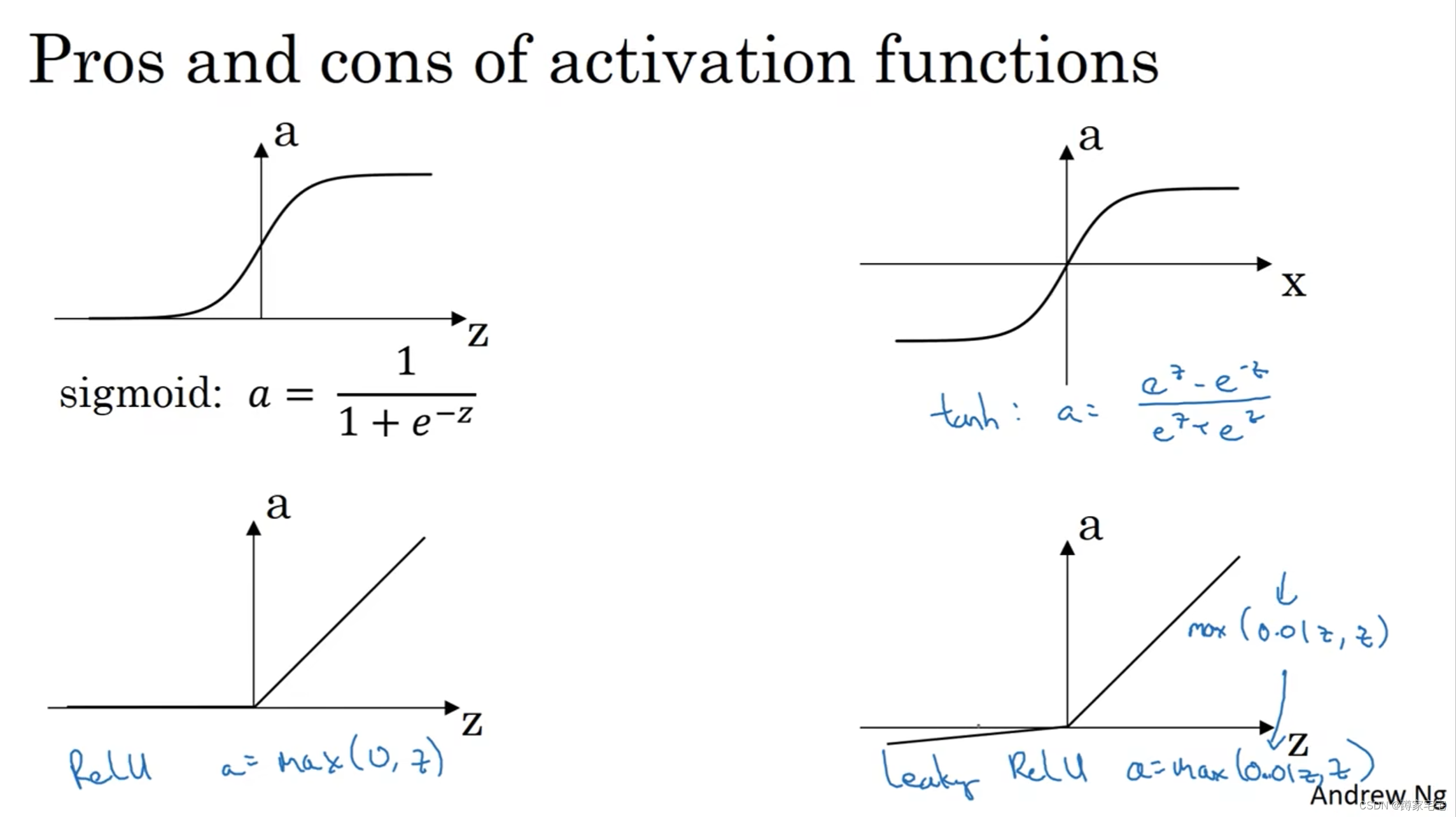

sigmoid,tanh,ReLU,leaky ReLU

激活函數的選擇

激活函數的選擇

之前logistic回歸一直使用的激活函數都是sigmoid函數,但一般來說,tanh函數是比sigmoid函數更加好的選擇

tanh函數會將預測值穩定在0值上下(數據中心化),而sigmoid函數輸出值在0-1間變化,數據中心化對于往后的迭代更加方便

但無論是sigmoid函數,還是tanh函數,都有很明顯的缺點,當z很大或者很小,a的斜率將會趨于0,這將導致學習迭代的速率大大下降

所以ReLU(rectified linear unit)--修正線性單元,是更好的選擇,它保持斜率為1(當z大于0時),當z小于0時,斜率為0

對于負區間的改進,leaky ReLU在負區間的斜率變為k(k為學習率)

一般來說,沒有固定的激活函數選擇,要根據模型選擇,比如對于二元分類,sigmoid函數反而更加常用(因為在0-1區間),只是通常ReLU會更加方便一點

為什么需要非線性的激活函數

如果使用線性激活函數或者不使用激活函數,那么神經網絡實際上只是在計算線性激活函數,隱藏層也沒有必要了,更詳細的解釋之后補充

![[Kadane算法,前綴和思想]元素和最大的子矩陣](http://pic.xiahunao.cn/[Kadane算法,前綴和思想]元素和最大的子矩陣)

)