文章目錄

- 0 前言

- 1 課題背景

- 2 相關技術

- 2.1 Dlib人臉識別庫

- 2.2 疲勞檢測算法

- 2.3 YOLOV5算法

- 3 效果展示

- 3.1 眨眼

- 3.2 打哈欠

- 3.3 使用手機檢測

- 3.4 抽煙檢測

- 3.5 喝水檢測

- 4 最后

0 前言

🔥 優質競賽項目系列,今天要分享的是

🚩 **基于深度學習加駕駛疲勞與行為檢測 **

該項目較為新穎,適合作為競賽課題方向,學長非常推薦!

🥇學長這里給一個題目綜合評分(每項滿分5分)

- 難度系數:4分

- 工作量:3分

- 創新點:5分

🧿 更多資料, 項目分享:

https://gitee.com/dancheng-senior/postgraduate

1 課題背景

為了有效監測駕駛員是否疲勞駕駛、避免交通事故的發?,本項目利??臉特征點進?實時疲勞駕駛檢測的新?法。對駕駛員駕駛時的?部圖像進?實時監控,?先檢測?臉,并利?ERT算法定位?臉特征點;然后根據?臉眼睛區域的特征點坐標信息計算眼睛縱橫?EAR來描述眼睛張開程度,根據合適的EAR閾值可判斷睜眼或閉眼狀態;最后基于EAR實測值和EAR閾值對監控視頻計算閉眼時間?例(PERCLOS)值度量駕駛員主觀疲勞程度,將其與設定的疲勞度閾值進??較即可判定是否疲勞駕駛。

2 相關技術

2.1 Dlib人臉識別庫

簡歷

Dlib是一個基于c++開發的開源數據工具庫,其中包含了不少的機器學習的成熟算法與模型,相對于tensorflow和PyTorch,它用于圖像處理以及人臉面部特征提取、分類及對比這幾個方面比較具有通用性和優越性,因此,Dlib正在越來越廣泛地應用在人臉識別技術領域。

Dlib具有獨立使用的可移植代碼。Dlib中的代碼使用c++語言進行開發而成,使用獨立封裝,在不借助第三方數據庫的情況下,可以直接移植到自己所需要設計的項目中進行使用。

Dlib優點

-

Dlib擁有全面的文檔說明。作為一個開源的人臉數據庫訓練集,Dlib中有很多功能齊全的程序和文件,從人性化的角度而言的,Dlib在這一點上做的是非常不錯的,因為它為每一個程序文檔和文件都做了相對應的注釋,這樣開發者就可以迅速準確的調集程序文檔來完成自己所需要的項目功能。

-

Dlib涵蓋了支持功能完備的深度學習以及圖像處理的各類算法。Dlib為開發者提供了機器深度學習的各類成熟的完備算法,并且在圖像處理方面也為開發者帶來了能夠

相關代碼

?

import` `matplotlib.pyplot as plt

import` `dlib

import` `numpy as np

import` `glob

import` `re#正臉檢測器

detector``=``dlib.get_frontal_face_detector()

#臉部關鍵形態檢測器

sp``=``dlib.shape_predictor(r``"D:LBJAVAscriptshape_predictor_68_face_landmarks.dat"``)

#人臉識別模型

facerec ``=` `dlib.face_recognition_model_v1(r``"D:LBJAVAscriptdlib_face_recognition_resnet_model_v1.dat"``)#候選人臉部描述向量集

descriptors``=``[]photo_locations``=``[]for` `photo ``in` `glob.glob(r``'D:LBJAVAscriptfaces*.jpg'``):``photo_locations.append(photo)``img``=``plt.imread(photo)``img``=``np.array(img)``#開始檢測人臉``dets``=``detector(img,``1``)``for` `k,d ``in` `enumerate``(dets):``#檢測每張照片中人臉的特征``shape``=``sp(img,d)``face_descriptor``=``facerec.compute_face_descriptor(img,shape)``v``=``np.array(face_descriptor)``descriptors.append(v)#輸入的待識別的人臉處理方法相同

img``=``plt.imread(r``'D:test_photo10.jpg'``)

img``=``np.array(img)

dets``=``detector(img,``1``)

#計算輸入人臉和已有人臉之間的差異程度(比如用歐式距離來衡量)

differences``=``[]

for` `k,d ``in` `enumerate``(dets):``shape``=``sp(img,d)``face_descriptor``=``facerec.compute_face_descriptor(img,shape)``d_test``=``np.array(face_descriptor)``#計算輸入人臉和所有已有人臉描述向量的歐氏距離``for` `i ``in` `descriptors:``distance``=``np.linalg.norm(i``-``d_test)``differences.append(distance)#按歐式距離排序 歐式距離最小的就是匹配的人臉

candidate_count``=``len``(photo_locations)

candidates_dict``=``dict``(``zip``(photo_locations,differences))

candidates_dict_sorted``=``sorted``(candidates_dict.items(),key``=``lambda` `x:x[``1``])#matplotlib要正確顯示中文需要設置

plt.rcParams[``'font.family'``] ``=` `[``'sans-serif'``]

plt.rcParams[``'font.sans-serif'``] ``=` `[``'SimHei'``]plt.rcParams[``'figure.figsize'``] ``=` `(``20.0``, ``70.0``)ax``=``plt.subplot(candidate_count``+``1``,``4``,``1``)

ax.set_title(``"輸入的人臉"``)

ax.imshow(img)for` `i,(photo,distance) ``in` `enumerate``(candidates_dict_sorted):``img``=``plt.imread(photo)``face_name``=``""``photo_name``=``re.search(r``'([^\]*).jpg$'``,photo)``if` `photo_name:``face_name``=``photo_name[``1``]``ax``=``plt.subplot(candidate_count``+``1``,``4``,i``+``2``)``ax.set_xticks([])``ax.set_yticks([])``ax.spines[``'top'``].set_visible(``False``)``ax.spines[``'right'``].set_visible(``False``)``ax.spines[``'bottom'``].set_visible(``False``)``ax.spines[``'left'``].set_visible(``False``)``if` `i``=``=``0``:``ax.set_title(``"最匹配的人臉nn"``+``face_name``+``"nn差異度:"``+``str``(distance))``else``:``ax.set_title(face_name``+``"nn差異度:"``+``str``(distance))``ax.imshow(img)plt.show()

2.2 疲勞檢測算法

該系統采用Dlib庫中人臉68個關鍵點檢測shape_predictor_68_face_landmarks.dat的dat模型庫及視頻中的人臉,之后返回人臉特征點坐標、人臉框及人臉角度等。本系統利用這68個關鍵點對駕駛員的疲勞狀態進行檢測,算法如下:

- 初始化Dlib的人臉檢測器(HOG),然后創建面部標志物預測;

- 使用dlib.get_frontal_face_detector() 獲得臉部位置檢測器;

- 使用dlib.shape_predictor獲得臉部特征位置檢測器;

- 分別獲取左、右眼面部標志的索引;

- 打開cv2本地攝像頭。

Dlib庫68個特征點模型如圖所示:

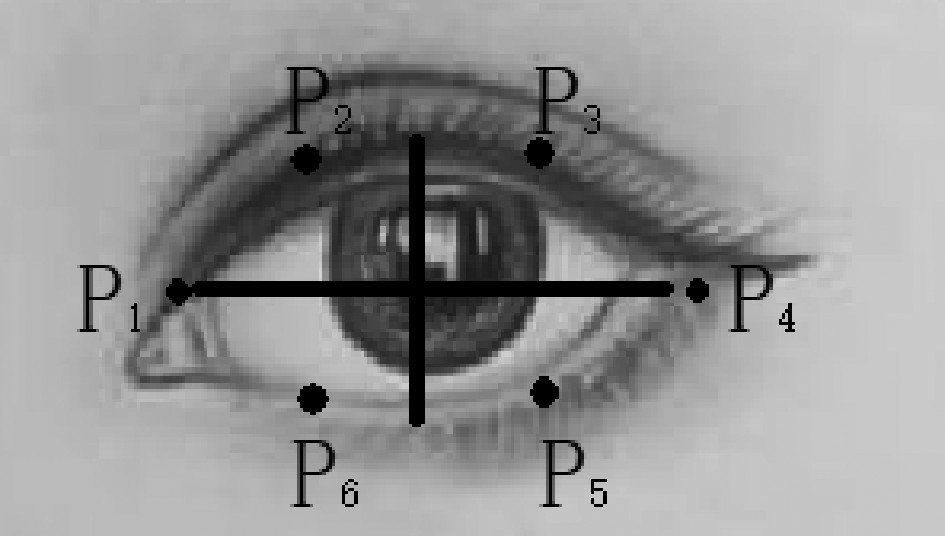

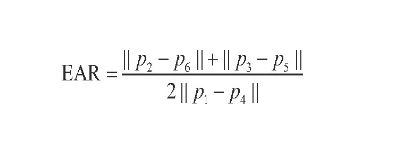

眼睛檢測算法

基于EAR算法的眨眼檢測,當人眼睜開時,EAR在某個值域范圍內波動,當人眼閉合時,EAR迅速下降,理論上接近于0。當EAR低于某個閾值時,眼睛處于閉合狀態;當EAR由某個值迅速下降至小于該閾值,再迅速上升至大于該閾值,則

EAR計算公式如下:

當后幀眼睛寬高比與前一幀差值的絕對值(EAR)大于0.2時,認為駕駛員在疲勞駕駛。(68點landmark中可以看到37-42為左眼,43-48為右眼)

右眼開合度可以通過以下公式:

眼睛睜開度從大到小為進入閉眼期,從小到大為進入睜眼期,計算最長閉眼時間(可用幀數來代替)。閉眼次數為進入閉眼、進入睜眼的次數。通過設定單位時間內閉眼次數、閉眼時間的閾值判斷人是否已經疲勞了。

相關代碼:

?

# 疲勞檢測,檢測眼睛和嘴巴的開合程度from scipy.spatial import distance as dist

from imutils.video import FileVideoStream

from imutils.video import VideoStream

from imutils import face_utils

import numpy as np # 數據處理的庫 numpy

import argparse

import imutils

import time

import dlib

import cv2

import math

import time

from threading import Threaddef eye_aspect_ratio(eye):# 垂直眼標志(X,Y)坐標A = dist.euclidean(eye[1], eye[5]) # 計算兩個集合之間的歐式距離B = dist.euclidean(eye[2], eye[4])# 計算水平之間的歐幾里得距離# 水平眼標志(X,Y)坐標C = dist.euclidean(eye[0], eye[3])# 眼睛長寬比的計算ear = (A + B) / (2.0 * C)# 返回眼睛的長寬比return ear

打哈欠檢測算法

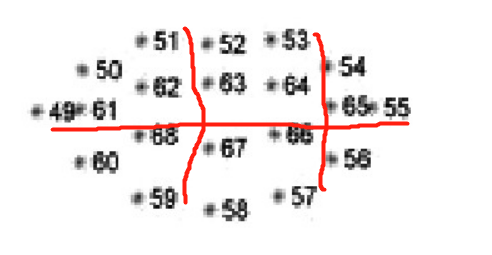

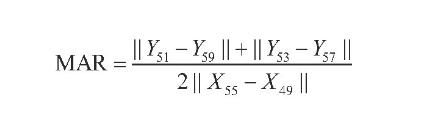

基于MAR算法的哈欠檢測,利用Dlib提取嘴部的6個特征點,通過這6個特征點的坐標(51、59、53、57的縱坐標和49、55的橫坐標)來計算打哈欠時嘴巴的張開程度。當一個人說話時,點51、59、53、57的縱坐標差值增大,從而使MAR值迅速增大,反之,當一個人閉上嘴巴時,MAR值迅速減小。

嘴部主要取六個參考點,如下圖:

計算公式:

通過公式計算MAR來判斷是否張嘴及張嘴時間,從而確定駕駛員是否在打哈欠。閾值應經過大量實驗,能夠與正常說話或哼歌區分開來。為提高判斷的準確度,采用雙閾值法進行哈欠檢測,即對內輪廓進行檢測:結合張口度與張口時間進行判斷。Yawn為打哈欠的幀數,N為1

min內總幀數,設雙閾值法哈欠檢測的閾值為10%,當打哈欠頻率Freq>10%時,則認為駕駛員打了1個深度哈欠或者至少連續2個淺哈欠,此時系統進行疲勞提醒。

相關代碼:

?

# 疲勞檢測,檢測眼睛和嘴巴的開合程度from scipy.spatial import distance as dist

from imutils.video import FileVideoStream

from imutils.video import VideoStream

from imutils import face_utils

import numpy as np # 數據處理的庫 numpy

import argparse

import imutils

import time

import dlib

import cv2

import math

import time

from threading import Threaddef mouth_aspect_ratio(mouth): # 嘴部A = np.linalg.norm(mouth[2] - mouth[10]) # 51, 59B = np.linalg.norm(mouth[4] - mouth[8]) # 53, 57C = np.linalg.norm(mouth[0] - mouth[6]) # 49, 55mar = (A + B) / (2.0 * C)return mar

?

點頭檢測算法

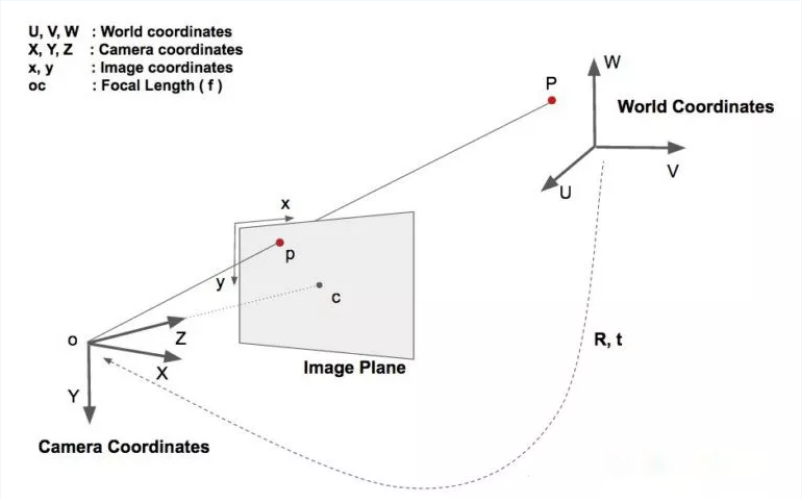

基于HPE算法的點頭檢測:算法步驟:2D人臉關鍵點檢測,3D人臉模型匹配,求解3D點和對應2D點的轉換關系,根據旋轉矩陣求解歐拉角。檢測過程中需要使用世界坐標系(UVW)、相機坐標系(XYZ)、圖像中心坐標系(uv)和像素坐標系(xy)。一個物體相對于相機的姿態可以使用旋轉矩陣和平移矩陣來表示。

- 平移矩陣:物體相對于相機的空間位置關系矩陣,用T表示。

- 旋轉矩陣:物體相對于相機的空間姿態關系矩陣,用R表示。

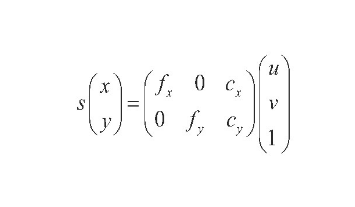

因此必然少不了坐標系轉換。如圖所示:

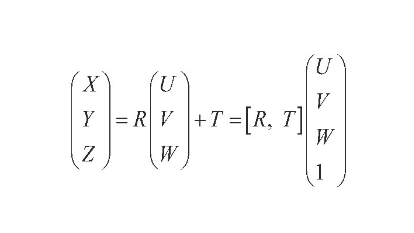

于是世界坐標系(UVW)、相機坐標系(XYZ)、圖像中心坐標系(uv)和像素坐標系(xy)四兄弟閃亮登場。相對關系如:

世界坐標系轉換到相機坐標:

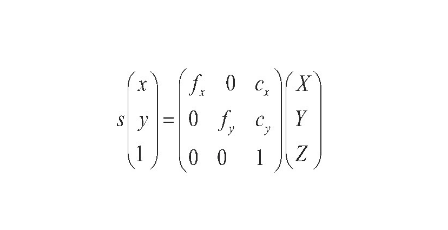

相機坐標系轉換到像素坐標系:

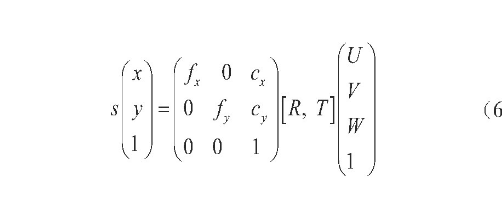

像素坐標系與世界坐標系的關系為:

圖像中心坐標系轉換到像素坐標系:

得到旋轉矩陣后,求歐拉角:

設定參數閾值為0.3,在一個時間段,如10

s內,當低頭歐拉角|Pitch|≥20°或者頭部傾斜歐拉角|Roll|≥20°的時間比例超過0.3時,則認為駕駛員處于瞌睡狀態,發出預警。

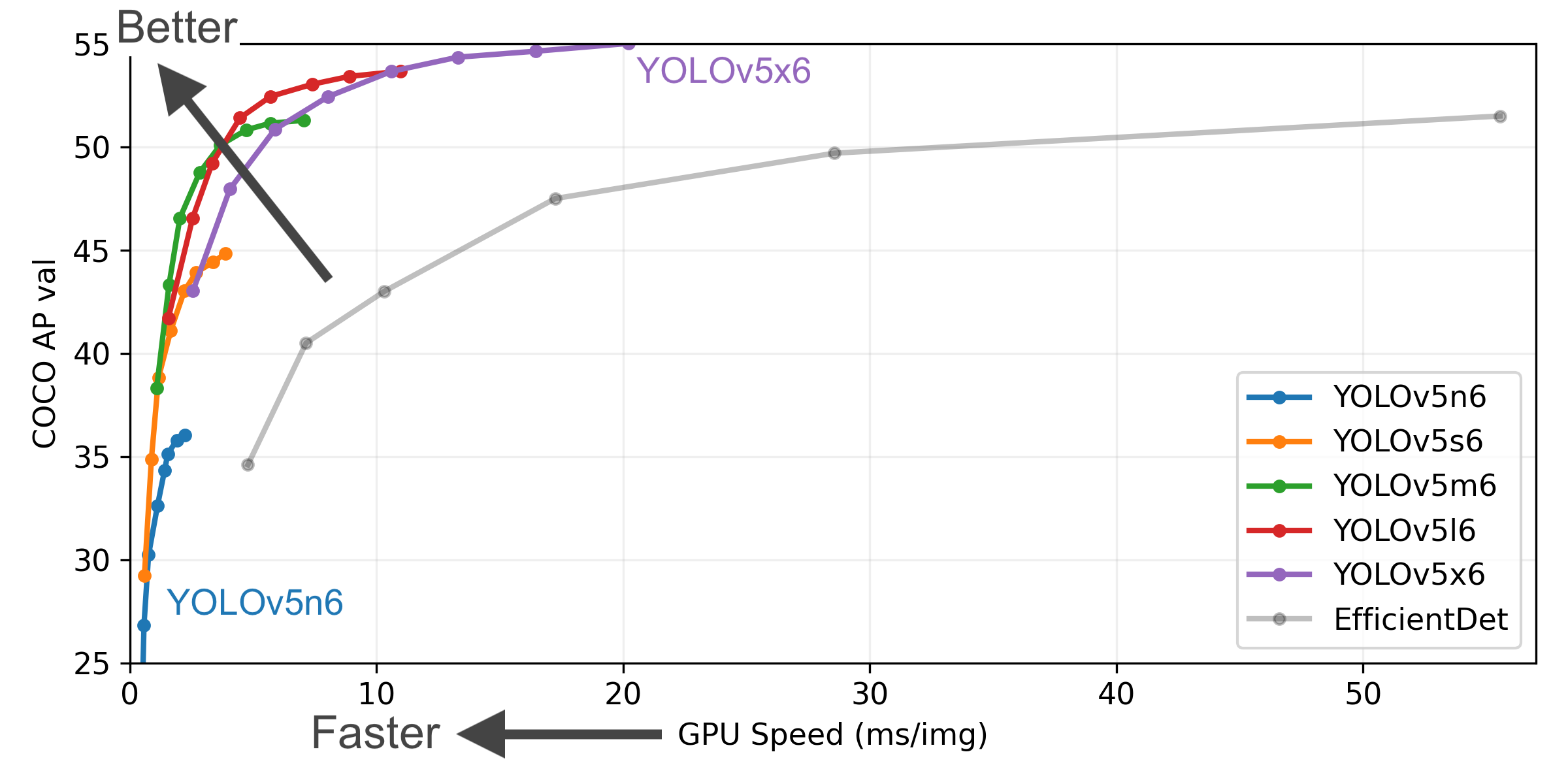

2.3 YOLOV5算法

簡介

我們選擇當下YOLO最新的卷積神經網絡YOLOv5來進行檢測是否存在玩手機、抽

目標檢測架構分為兩種,一種是two-stage,一種是one-stage,區別就在于 two-stage 有region

proposal過程,類似于一種海選過程,網絡會根據候選區域生成位置和類別,而one-stage直接從圖片生成位置和類別。今天提到的 YOLO就是一種

one-stage方法。YOLO是You Only Look Once的縮寫,意思是神經網絡只需要看一次圖片,就能輸出結果。YOLO

一共發布了五個版本,其中 YOLOv1 奠定了整個系列的基礎,后面的系列就是在第一版基礎上的改進,為的是提升性能。

YOLOv5有4個版本性能如圖所示:

網絡架構圖

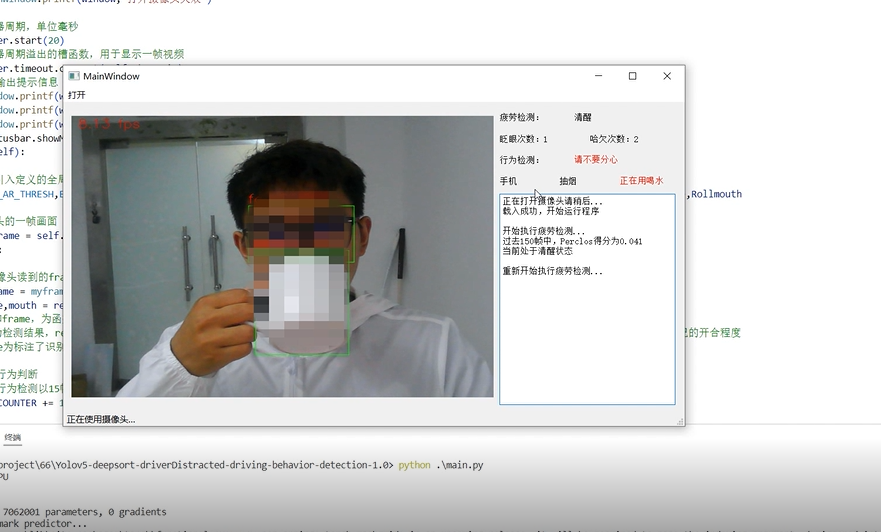

3 效果展示

3.1 眨眼

3.2 打哈欠

3.3 使用手機檢測

3.4 抽煙檢測

3.5 喝水檢測

4 最后

🧿 更多資料, 項目分享:

https://gitee.com/dancheng-senior/postgraduate

)

-Mybatis查詢中返回值四種情況)

)