參考博客:

https://blog.csdn.net/duchenlong/article/details/114597944

與上面這個博客幾乎差不多,就是java環境配置以及后面的hadoop的hdfs-site.xml文件有一些不同的地方。?

準備工作

1.更新

# 更新

sudo apt update

sudo apt upgrade

2.關閉防火墻( 不用單獨開辟端口)

sudo ufw disable

創建Hadoop用戶

# 創建Hadoop用戶,并使用/bin/bash作為shell

sudo useradd -m hadoop -s /bin/bash# 為Hadoop設置登錄密碼

sudo passwd hadoop# 增加管理員權限

sudo adduser hadoop sudo

創建一個Hadoop用戶,是因為可以避免Hadoop在運行的過程中影響到其他用戶的正常使用。

增加管理員權限可以避免Hadoop在運行時,出現一些權限的問題,比如在一些目錄下創建文件等。

如何后續的安裝在hadoop用戶下進行

# 切換為 Hadoop用戶

su hadoop

或者退出當前用戶:

方法一:使用快捷鍵Ctrl+D組合鍵

方法二:在終端中輸入$exit或者$logout命令,然后按下回車鍵就可退出當前用戶會話

安裝Java?

如果安裝的Hadoop是2.*版本的,那么需要安裝的java版本最好是1.8,默認安裝的是11,在配置偽分布式節點時會報一些警告

sudo apt install openjdk-8-jdk

配置環境變量( Ctrl + s 保存,Ctrl + x 退出)

nano ~/.bashrc

在結尾添加

export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64

export JRE_HOME=/usr/lib/jvm/java-8-openjdk-amd64/jre

export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib

export PATH=${JAVA_HOME}/bin:$PATH然后更新環境變量

# 更新環境變量

source ~/.bashrc

查看是否安裝成功,以及java的版本信息

# 查看是否安裝成功

whereis java# java的版本信息

java-version# 環境變量是否導入成功

echo $JAVA_HOME

?

?

設置ssh免密登錄

# 登錄localhost

ssh localhost

(忘記直接截圖在哪了,放上面博客博主的圖吧,操作一樣)

然后會在~/目錄下發現一個.ssh文件。

配置秘鑰,免密登錄

# 到.ssh 目錄下

cd ~/.sshssh-keygen -t rsa

# 加入授權

cat ./id_rsa.pub >> ./authorized_keys

再次輸入$ssh localhost不需要密碼的話,就是配置成功了

Hadoop下載安裝

安裝地址:https://blog.csdn.net/m0_62110645/article/details/134403165?spm=1001.2014.3001.5502

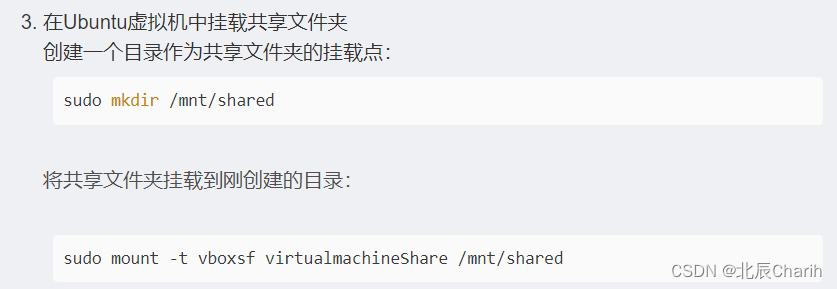

我是使用共享文件夾安裝的:

在在virtualbox的ubuntu虛擬機上設置共享文件夾步驟:

1.設置共享文件夾

自行設定共享文件夾路徑以及名稱,記得勾選自動掛載(A),運行虛擬機的時候才會自動加載該文件夾。

# 將hadoop 壓縮包在/usr/local 目錄下解壓

sudo tar -zxvf hadoop-2.10.1.tar.gz -C /usr/local/# 進入該目錄

cd /usr/local# 更新名字文hadoop

sudo mv ./hadoop-2.10.1/ ./hadoop# 修改文件權限

sudo chown -R hadoop ./hadoop

?配置java環境變量在hadoop中

# 進入配置文件目錄

cd /usr/local/hadoop/etc/hadoop# 打開文件

nano hadoop-env.sh

查看hadoop版本信息?

# 進入bin目錄

cd /usr/local/hadoop/bin./hadoop version

?

?

?

?

偽分布式安裝

# 進入配置文件的目錄

cd /usr/local/hadoop/etc/hadoop

?需要修改的兩個文件core-site.xml和hdfs-site.xml文件

修改core-site.xml文件為:

nano core-site.xml

<configuration><property><name>hadoop.tmp.dir</name><value>file:/usr/local/hadoop/tmp</value><description>Abase for other temporary directories.</description></property><property><name>fs.defaultFS</name><value>hdfs://localhost:9000</value></property>

</configuration>

修改hdfs-site.xml文件為:

nano hdfs-site.xml

<configuration><property><name>dfs.replication</name><value>1</value></property><property><name>dfs.namenode.name.dir</name><value>file:/usr/local/hadoop/tmp/dfs/name</value></property><property><name>dfs.datanode.data.dir</name><value>file:/usr/local/hadoop/tmp/dfs/data</value></property><property><name>dfs.http.address</name><value>localhost:50070</value></property>

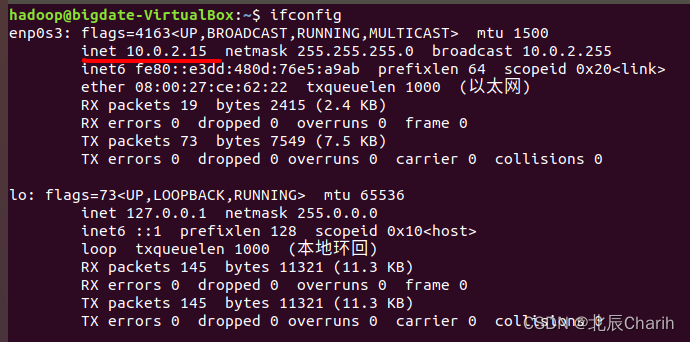

</configuration>這里我直接是localhost:50070,在自己主機上訪問。因為我按教程來,但是得不到一樣的結果,就啟動不出教程192.168.*的界面。后來經過四處搜索方法。在終端輸入$ifconfig,顯示我的是10.0.2.15 。

嘗試過什么修改為橋接網絡等等各種方法,但始終不成功,所以我干脆修改為只在自己主機運行。

:構建純凈版的drf項目,不再使用django的后臺管理,django的認證,django的session等功能,作為一個純接口項目)

)

![④【Set】Redis常用數據類型: Set [使用手冊]](http://pic.xiahunao.cn/④【Set】Redis常用數據類型: Set [使用手冊])

)