?

?

抽象

在計算機視覺和更廣泛的深度學習領域,Transformer 架構已被公認為許多應用程序的最先進技術。然而,對于多任務學習,與單任務模型相比,可能需要更多的查詢,考慮到實際的硬件限制,它的多頭注意力通常接近計算可行的極限。這是因為注意力矩陣的大小隨任務數量呈二次方比例(假設所有任務的查詢數量大致相等)。 作為一種解決方案,我們提出了用于多任務模型的新穎可變形任務間自注意力,該模型能夠更有效地聚合來自不同任務的特征圖的信息。 在我們對 NYUD-v2 和 PASCAL-Context 數據集的實驗中,我們證明了 FLOP 計數和推理延遲都減少了一個數量級。同時,我們還在單個任務的預測質量指標上實現了高達 7.4% 的大幅改進。

關鍵字:

多任務學習 變形注意力 多任務注意力。1介紹

多任務學習的兩個主要目標是減少每個任務所需的計算資源量,并通過使模型能夠使用來自一項任務的信息來提高另一項任務的性能來實現更好的泛化[5].這是通過在任務之間共享模型的部分可學習權重來實現的。最近,隨著 Transformer 模型的興起[28],架構的這個共享部分通常是一個注意力模塊,因為在給定足夠的訓練數據的情況下,它為各種應用程序提供了很好的適應性[2,33,31]. 然而,這種適應性確實存在一個重大缺點,即注意力計算所需的計算資源隨查詢數量呈二次方比例。 特別是對于需要跨任務引起注意力的多任務模型,這種縮放行為會成為問題。假設不同任務的查詢數量大致相當,這種模型中注意力機制的計算成本現在隨任務數量呈二次方縮放,這違背了多任務學習減少每個任務所需的計算資源量的目的。對于通常需要大量與輸入像素計數成正比的查詢的多任務視覺轉換器模型,這個問題更為相關。 以前的工作通過減少查詢數量來解決這個問題,例如[32]或者通過合并任務特征圖,從而關注更少的值[31].在可變形混頻器變壓器 (DeMT)?[33],徐等人。接受計算開銷,以支持更好的預測指標[32]和[31]. 靈感來自朱的《變形注意力》作品等。[38],我們取代了 DeMT 模型中使用的全局注意力[33]使用我們的可變形任務間自注意力,該功能專為具有多個任務特征圖的應用程序而設計。通過這樣做,我們允許模型克服上述先前工作的弱點,通過更有效地計算跨任務的注意力和更好的擴展屬性,此外還實現了改進的性能指標。 正如[38],預測質量的提高可能是由于每個查詢鍵對之間的學習全局注意力收斂性差。這表明,為了使多任務模型能夠最佳地利用來自其他任務的信息并提高一項任務的性能,有效地訪問這些信息非常重要。 我們在多個特征提取主干和不同的多任務計算機視覺(CV)數據集上評估了我們的方法。

我們工作的主要貢獻可以概括如下:

- 我們介紹了我們新穎、更高效的可變形任務間自注意力 (ITSA)?機制。

- 我們將這種注意力機制集成到最先進的 DeMT 模型架構中。

- 我們在 NYUD-v2 和 PASCAL-Context 數據集上廣泛評估了生成的模型,證明了其減少的計算資源需求和改進的預測質量。

2相關工作

視覺轉換器。在引入圖像分類后[12],近年來,Vision Transformer 已被確立為最先進的計算機視覺模型架構,特別是對于更復雜的任務。Vision Transformers 的一個共同特征是它們將查詢分配給輸入圖像的小塊。對于像圖像分類這樣的任務,這些補丁可能會稍大一些,但對于像分割這樣的密集預測任務,如果選擇的補丁大小太大,預測質量會受到顯著影響。雖然 Dosovitskiy?等人。?在[12]能夠使用 16 x 16 像素的補丁(在 Segmenter 模型中大于 8 x 8 的補丁)實現良好的分類性能[26]作者:Strudel?等人。導致結果相當差,而 Xie?等人。甚至在[30]。這證明了視覺轉換器的缺點,即它們需要大量查詢,從而導致昂貴的注意力計算。對于多個任務,這個問題會顯著加劇。

可變形注意力。如第?1?節所述,減少與注意力計算相關的計算開銷是一個高度相關的問題。通過利用低級優化,可以顯著提高注意力計算的效率,例如[10,9]充分考慮了所用硬件的特定限制。工作方式[19,7]通過在注意力計算中引入門控來解決這個問題,這樣實際上只需要執行完整的多頭注意力計算的相關子集。然而,對于許多應用程序,特別是對于可以利用某些局部性偏差的輸入,沒有必要計算每對查詢之間的完整注意力矩陣,并且可以通過可變形注意力很好地近似。這種注意力作的靈感來自可變形卷積[8]它通過允許從特征圖中的任意位置采樣來概括卷積運算。這些由使用卷積核計算的偏移量定義。將相同的想法應用于注意力計算,[38]引入可變形注意力:在這里,通過可學習的線性層,查詢特征定義了采樣偏移量和注意力權重:它們允許我們通過對該查詢參考點周圍的偏移量處的特征圖進行采樣,按各自的注意力權重對這些樣本進行加權,最后對加權樣本求和來計算該查詢的注意力輸出。通常,每個查詢選擇的偏移量數量很少(16 個是常見的選擇),因此使得此作比傳統的全注意力更有效,在傳統的全注意力中,對于每個查詢,都需要計算其彼此之間的交互。盡管如此,[38]表明可變形注意力實際上可以勝過全注意力,同時節省計算資源。 在[29], 夏等人。認為注意力計算中缺少鍵[38]限制了它的表示能力,因此不適合作為特征提取主干。相反,他們修改了可變形注意力計算,以從每個采樣位置生成一個鍵和值,并將注意力計算為查詢與每個采樣位置的鍵之間的余弦相似度。然而,在我們的例子中,由于我們使用的是卷積主干,并在其提取的特征上應用了可變形注意力,因此這對我們來說不是問題,并且我們觀察到遵循更簡單的方法的強結果[38].

多任務學習。大多數多任務學習 (MTL) 工作都探索了新穎的模型架構[2,33,4,31,32],或專注于任務平衡和損失加權的優化方法[21,13,36,3]. 雖然 MTL 已應用于自然語言處理等各種學習領域[6,37]、雷達信號處理[15]和 LiDAR 點云分析[17],它的主要應用之一——也是這項工作的重點——是計算機視覺。多任務簡歷中的常見任務包括對象檢測[16,14]、視覺問答[14]或 3D 簡歷任務[35,18,34].我們專注于處理密集預測任務的多任務轉換器模型,例如語義分割、單眼深度估計、表面法線預測、顯著性估計和物體邊界檢測。這些模型通常需要大量查詢,但也有可能通過利用其特征的網格結構來大幅提高效率。在該領域具有重大建筑創新和強勁成果的有影響力的作品包括:在 MulT[2]由 Bhattacharjee?等人,每個任務解碼器的共享注意力模塊從模型編碼器中相應的共享表示接收其查詢和鍵。MQTransformer[32]展示了一種通過用更少的特定于任務的查詢替換每像素查詢來跨任務進行更有效的注意力計算的方法。MTMamba 是用于密集視覺任務的 MTL 的最新發展[20]作者:Lin?等人。它是一個狀態空間模型而不是一個 Transformer,它根據查詢數量提供更好的擴展行為,同時仍達到相當水平的預測質量。然而,與實現類似結果的基于 Transformer 的模型相比,它使用了更多的可學習參數和計算資源。

可變形混音器變壓器。我們基于 Xu 等人引入的有影響力的 Multitask Vision Transformer 架構?DeMT?實現了我們的方法。在[33]以證明其對既定基線的影響。該模型取得了最先進的結果,在所有任務中都受到全球關注。它首先使用在 Imagenet 上預訓練的主干網[11]從圖像域中的輸入數據中提取特征圖。該主干網可以從多個選項中進行選擇,包括 HRNetV2[27]和 Swin 變壓器的變體[22].然后,作為 Transformer 編碼器的一部分,提取的特征被傳遞到多個可變形混音器模塊,每個任務一個,然后針對每個任務進行細化。此后,來自這些可變形混頻器的輸出特征圖被輸入到模型的解碼器部分,即任務感知轉換器解碼器。該解碼器由一個任務交互塊組成,它允許將來自一個任務的信息傳播到其他任務。最后,對于每個任務,其特征圖在由多頭自注意力(MHSA)模塊和全連接多層感知器(MLP)組成的特定任務任務查詢塊中得到進一步細化。 我們在這項工作中重點關注的架構部分是任務交互塊。在 DeMT 中,此塊接受所有任務的編碼器輸出的串聯作為其輸入查詢集,并對其執行 MHSA,然后執行 MLP。如前所述,對于多個任務,此任務交互塊表現出較差的縮放行為和次優的預測質量。因此,我們將其替換為第?? 3?節中描述的更有效的版本。

3方法論

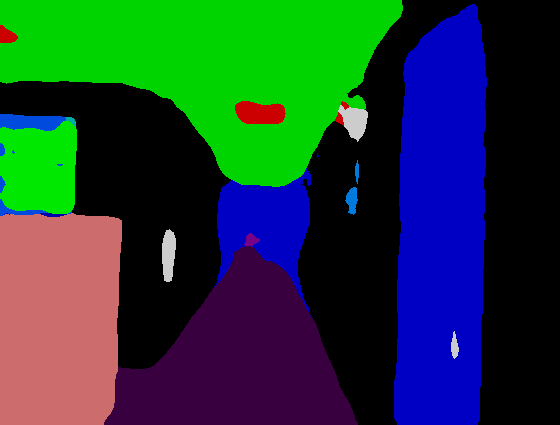

圖 1:我們的任務交互塊的示意圖。LN 指的是層規范,FFN 是指前饋網絡,sMLP 是線性層后跟層規范的小型 MLP。

下面,我們將詳細描述我們的可變形任務間自注意力(ITSA)方法。它是一種自注意力,即它的查詢集關注自己。我們方法背后的主要直覺是,對于特定任務的任何查詢,它允許模型從所有任務特征圖中相對較少的位置自由采樣。因此,它可以有效地聚合來自所有任務的信息,以響應來自一個任務的查詢。這種方法也適用于 CV 之外的各種 MTL 架構,前提是它們使用的查詢涉及來自不同任務的網格結構特征。

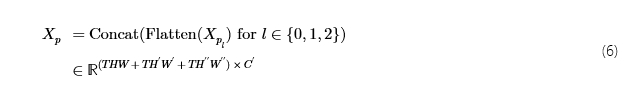

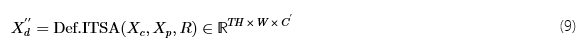

我們的 DeMT 模型任務交互塊的核心組件是可變形 ITSA。 如圖?? 1?所示,我們的任務交互塊接收來自所有任務的先前可變形混合器模塊的輸出特征的串聯,就像在 DeMT 中一樣。在下文中,讓H,W和C分別表示所有任務的全尺度特征圖的高度、寬度和通道數,以及T模型中的任務數。對于屬于任務的可變形混合器的輸出特征t,Xm(t)∈?H×W×C,則交互塊接受沿高度維度的串聯:

圖2:一個查詢的可變形任務間自注意力的圖示qh,w從任務t.任務的特征圖t左側包含位置查詢(h,w),所有任務的特征金字塔(綠色和紅色張量)是可變形注意力的輸入,右側的輸出包含用于查詢的細化特征qh,w的任務t在 ITSA 之后。\vectimes指示參考點Rh,w′查詢qh,w.在此圖中,我們僅顯示兩個特征金字塔級別和三個頭,每個頭部有三個偏移量,這些標部的實際值更高。

?

在下一步中,我們將連接一個二維正弦位置嵌入P∈?T?H×W×c之c通道,產生該功能

?

Xc作為查詢特征傳遞給可變形 ITSA,輸入特征從中派生。 為了提高對輸入數據中可變尺度圖案的魯棒性,可變形ITSA的輸入特征是一個特征金字塔,如圖?? 2所示。 我們得到這些特征如下:對于任務的全尺寸特征圖t,即Xc=:Xp0與任務相對應的t,Xp0t,我們計算了兩個較小金字塔級別的下采樣版本。為了在每個下采樣步驟中將每個空間維度的大小大約減半,我們使用 3x3 卷積,步幅為 2。 下采樣映射定義如下:

?

為t∈{1,…,T},

?

和

?

跟Xp2來自[Xp21,…,Xp2T]類似于Xp1.由此,我們得到Xp通過展平和串聯:

?

?

我們定義了所有查詢的采樣輸入特征的參考點,如下所示:對于查詢qh,w在索引處(h,w)對于任何任務,其分配的參考點為

?

即,其單元格在查詢網格中的中心Xc. 對于下采樣的要素,參考點與上述相同,因為參考點是相對于要素大小定義的,而不是絕對坐標。展平后 的高度和寬度尺寸R′合二為一,對所有任務和三個金字塔水平重復它,我們得到參考點的張量

?

表1:將我們的方法與 NYUD-v2 數據集上以前最先進的方法進行比較。Δ%表示相對于 DeMT 的改進百分比[33].

| 型 | 骨干 |

|

|

|

| Δ%↑ | ||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 德蒙特[33]? | 人力資源網18 | 0.3760 | 0.6286 | 20.80 | 0.7718 | 0.00 | ||||||||

| 我們 | 人力資源網18 | 0.4039 | 0.5819 | 20.34 | 0.7712 | 4.25 | ||||||||

| 單任務基線[33]? | 斯溫-T | 0.4292 | 0.6104 | 20.94 | 0.7622 | -3.42 | ||||||||

| 多任務基線[33]? | 斯溫-T | 0.3878 | 0.6312 | 21.05 | 0.7560 | -6.87 | ||||||||

| MQTransformer[32]? | 斯溫-T | 0.4361 | 0.5979 | 20.05 | 0.7620 | -1.44 | ||||||||

| 德蒙特[33]? | 斯溫-T | 0.4636 | 0.5871 | 20.65 | 0.7690 | 0.00 | ||||||||

| 我們 | 斯溫-T | 0.4806 | 0.5567 | 20.14 | 0.7769 | 3.08 | ||||||||

| 單任務基線[33]? | 斯溫-S | 0.4892 | 0.5804 | 20.94 | 0.7720 | -4.20 | ||||||||

| 多任務基線[33]? | 斯溫-S | 0.4790 | 0.6053 | 21.17 | 0.7690 | -6.21 | ||||||||

| MQTransformer[32]? | 斯溫-S | 0.4918 | 0.5785 | 20.81 | 0.7700 | -3.89 | ||||||||

| 德蒙特[33]? | 斯溫-S | 0.5150 | 0.5474 | 20.02 | 0.7810 | 0.00 | ||||||||

| 我們 | 斯溫-S | 0.5259 | 0.5356 | 19.87 | 0.7859 | 1.42 |

表2:將我們的方法與 PASCAL-Context 數據集上以前最先進的方法進行比較。Δ%表示相對于 DeMT 的改進百分比[33].

| 型 | 骨干 |

|

|

|

|

| Δ%↑ | ||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 德蒙特[33]? | 人力資源網18 | 0.5582 | 0.5708 | 0.8417 | 14.21 | 0.7490 | 0.00 | ||||||||||

| 我們 | 人力資源網18 | 0.5821 | 0.5706 | 0.8453 | 14.02 | 0.7526 | 1.29 | ||||||||||

| 單任務基線[33]? | 斯溫-T | 0.6781 | 0.5632 | 0.8218 | 14.81 | 0.7090 | -1.38 | ||||||||||

| 多任務基線[33]? | 斯溫-T | 0.6474 | 0.5325 | 0.7688 | 15.86 | 0.6900 | -6.60 | ||||||||||

| MQTransformer[32]? | 斯溫-T | 0.6824 | 0.5705 | 0.8340 | 14.56 | 0.7110 | -0.31 | ||||||||||

| 德蒙特[33]? | 斯溫-T | 0.6971 | 0.5718 | 0.8263 | 14.56 | 0.7120 | 0.00 | ||||||||||

| 我們 | 斯溫-T | 0.6987 | 0.5828 | 0.8485 | 14.03 | 0.7746 | 3.46 |

我們通過Xc作為查詢特征,Xp作為輸入特征和參考點R到中定義的“可變形注意力”功能[38]. 對于這些輸入張量,我們將對它們執行可變形注意力稱為可變形任務間自注意力。 作為輸出,我們收到特征Xd′′,即在關注可變形ITSA中所有任務特征后,細化的任務特征圖。圖?? 2?顯示了如何為一個查詢計算可變形 ITSAqh,w從任務t.對于每個參考點和任務特征圖,固定數量的偏移量Δp通過線性層從查詢特征計算。這些定義了相對于輸入采樣的參考點的位置。由于偏移量和參考點通常不是積分的,因此應用雙線性插值來生成樣本。與偏移量類似,根據查詢,使用線性層后跟軟max生成注意力權重。與多頭注意力類似[28],輸入特征映射Xp不是直接采樣,而是對它們進行多個學習投影,每個頭部一個。然后,注意力權重用于聚合不同頭部、任務和特征金字塔級別的樣本,以生成用于查詢的可變形 ITSA 輸出。 將此作應用于Xc,產生以下輸出:

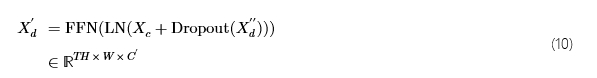

?

對于正則化,我們喂食Xd′′通過 Dropout 層[25]在 0.1 的下降概率下,為了更好地保留高頻特征,我們將Xc通過殘差連接到它。此后,我們應用層范數 (LN)[1]以及一個小型前饋網絡 (FFN) 以生成

我們總共執行了三個 ITSA 細化步驟,即我們更新Xc:=Xd′再重復特征金字塔計算、可變形ITSA、Dropout、LN和FFN兩次,得出最終的Xd′.從中,我們刪除最后一個c包含位置信息的通道,以及以下[33],應用線性層的小 MLP,然后應用層范數來生成Xd∈?T?H×W×C作為我們的任務交互塊的最終輸出。

表3:在具有 HRNet18 主干的 NYUD-v2 數據集上評估的任務交互塊組件的消融。可變形的 ITSA?用我們的版本取代了任務交互塊。3 x 3 轉換下采樣是指以 2 步幅的 3 x 3 卷積執行下采樣,而不是 1 x 1 卷積,然后是 2 x 2 最大池化。3 個細化步驟是指執行 3 個可變形 ITSA 步驟而不是 1 個。

| 型 |

|

|

|

| Δ%↑ | ||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| DeMT 基線[33]? | 0.3760 | 0.6286 | 20.80 | 0.7718 | 0.00 | ||||||||

| 可變形 ITSA | 0.3907 | 0.5877 | 20.41 | 0.7721 | 3.08 | ||||||||

| + 3 x 3 轉換下采樣 | 0.3958 | 0.5954 | 20.34 | 0.7737 | 3.25 | ||||||||

| + 位置編碼 | 0.4004 | 0.5943 | 20.30 | 0.7732 | 3.63 | ||||||||

| + 3 個細化步驟 | 0.4039 | 0.5819 | 20.34 | 0.7712 | 4.25 |

表4:梯度比例因子的消融λ在具有 HRNet18 主干的 NYUD-v2 數據集上進行評估。

| λ |

|

|

|

| Δ%↑ | ||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 1× | 0.3989 | 0.6010 | 20.35 | 0.7743 | 0.00 | ||||||||

| 10× | 0.4020 | 0.5939 | 20.28 | 0.7737 | 0.56 | ||||||||

| 30× | 0.4031 | 0.5920 | 20.31 | 0.7730 | 0.65 | ||||||||

| 50× | 0.4088 | 0.5915 | 20.32 | 0.7729 | 1.01 | ||||||||

| 100× | 0.4039 | 0.5819 | 20.34 | 0.7712 | 1.02 | ||||||||

| 200× | 0.0199 | 1.5089 | 45.34 | 0.4169 | -104 |

表5:在具有 HRNet18 主干的 NYUD-v2 數據集上評估的特征金字塔水平數量的消融。

| 金字塔級別 |

|

|

|

| Δ%↑ | ||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 1 | 0.3979 | 0.5901 | 20.42 | 0.7734 | 0.00 | ||||||||

| 2 | 0.4028 | 0.5853 | 20.43 | 0.7707 | 0.41 | ||||||||

| 3 | 0.4039 | 0.5819 | 20.34 | 0.7712 | 0.75 |

| 輸入圖像 | Sem. Seg. | 深度 | 正常 | 邊界 |

|---|---|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

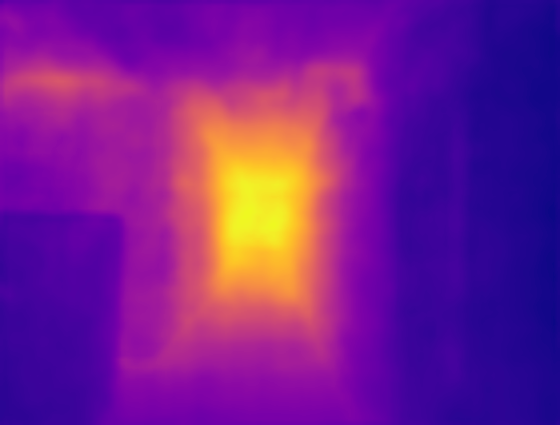

圖 3:使用我們的模型生成的 NYUD-v2 驗證集中的定性示例。

4實驗

為了驗證我們的方法并證明其在多個主干架構、模型大小和數據集中的一致有效性,我們在三個不同的主干和兩個著名的多任務視覺數據集上進行了實驗。

4.1實驗設置

實現詳細信息。我們評估集成到 DeMT 中的可變形 ITSA 方法[33]體系結構,如前所述。為了確保與 DeMT 的可比性,我們使用 SGD 優化器訓練模型,其學習率值相同10?3和重量衰減5?10?4.我們的損失函數是單個任務損失的加權總和。為了與之前的工作進行比較,我們使用相同的任務損失函數和來自 DeMT 的損失權重,無需修改。作為訓練硬件,我們為每個實驗使用了一個 A100 80GB GPU。

模型超參數。我們的任務交互塊的輸入和輸出都有一個通道號C=256,從而保持與 DeMT 架構的兼容性。對于可變形 ITSA 模塊,位置編碼c=24通道連接,導致總通道計數C′=280.在我們的網格搜索中,我們發現使用更多通道進行位置嵌入并沒有產生額外的改進。在可變形 ITSA 模塊中,我們使用 4 個頭部,并在每個參考點周圍取樣 16 個偏移量。在最初的實驗中,我們觀察到學習到的偏移量非常接近它們的初始化。因此,作為一個新的超參數,我們引入了一個縮放因子λ用于可變形 ITSA 模塊的梯度,允許模型學習有意義的采樣偏移并顯著提高其性能。我們發現 100 倍數在我們的實驗中表現最好。在?LABEL:gradient_scale_ablation?中,對λ可見,說明不同選擇對它的影響。

數據。我們在公共 NYUD-v2 上評估我們的方法[24]和 PASCAL-Context[23]數據。在多任務計算機視覺文獻中,這些已被確立為基準數據集。 NYUD-v2 包含 795 張用于訓練的圖像和 654 張用于驗證的圖像。這些圖像中的每一個的分辨率560×425像素并描繪室內場景。這些圖像用語義分割、深度信息、表面法線和對象邊界進行了密集的注釋。 PASCAL-Context 數據集分為 4998 張訓練圖像和 5105 張驗證圖像。它的圖像描繪了各種室內和室外場景。每個圖像都有密集的像素標簽,用于訓練語義分割、人體部位分割、顯著性估計、表面法線預測和物體邊界估計。 對于 HRNet18 主干網,我們的結果無法與 DeMT 論文的結果直接比較,因為作者沒有發布該設置所需的配置文件。因此,對于該主干網,我們必須創建自己的文件,并使用這些文件訓練 DeMT 基線和我們自己的模型。

骨干。我們的方法在基于 CNN 的 HRNet-V2-W18-small (HRNet18) 主鏈(3.9 M 參數)上進行了評估[27],以及 Vision Transformer 主干網 Swin-T (27.5 M) 和 Swin-S (48.8 M)[22].

指標。在這兩個數據集中,我們總共評估了六項任務。對于這些,它們各自的性能指標如下:對于語義分割和人體部分分割,我們報告平均交集多于并集 (mIoU)?分數,深度估計任務的性能通過均方根誤差 (RMSE)?來衡量,表面正態估計質量通過平均誤差 (mErr)?來判斷,對于邊界估計任務,我們報告最佳數據集尺度 F 度量 (odsF),顯著性估計的質量通過最大 F 度量 (maxF)?進行量化。對于所有任務,這些是相關文獻中常見報道的標準指標。我們還提供平均改善百分比 (Δ%)在與 DeMT 相關的所有任務中,這是我們的基線。

4.2結果

NYUD-v2 數據集。在?LABEL:NYUD_results?中,我們顯示了 NYUD-v2 數據集的結果。對于所有骨架,與 DeMT 基線相比,我們的方法取得了顯著增強的結果。評估平均改進,很明顯,對于較小的骨干,質量的提高更為明顯。這是可以預料的,因為對于來自更大主干的更強大功能,指標已經明顯更好,因此使得大型改進更具挑戰性。特別是對于較小的 HRNet-18 主干網,我們觀察到了顯著的改進:在那里,我們實現了7.4%語義分割和深度估計的得分都更好,同時仍然大大改進了其他兩項任務。同樣對于 Swin-T 主干網,我們看到性能提升5.2%對于深度估計任務,而所有其他任務也至少提高了1%.

PASCAL-Context 數據集。?LABEL:PASCAL_results?顯示 PASCAL-Context 數據集上的結果。除了使用 HRNet18 主干的人體部分分割任務外,與 DeMT 基線相比,我們觀察到使用任務交互塊在每個任務指標中都有更好的性能。對于評估的兩個主干,我們觀察到任務的平均改進1.29%和3.46%分別。

4.3運行時指標

為了說明我們的方法對所需計算資源的顯著改進,我們計算了所需的 FLOP,并測量了推理過程中任務交互塊中注意力模塊的延遲。我們將這兩個指標與 DeMT 實現的指標進行了比較[33].對于這兩個版本,我們在同一硬件上測量了推理時間,即具有 3000GB GPU 內存的 RTX A6 GPU。對于這兩個實驗,我們在 NYUD-v2 數據集上使用 HRNet18 主干進行評估,批量大小為 1、3 個特征金字塔級別和單個細化層。

表6:比較 DeMT 基線和我們的方法之間注意力計算的計算資源需求。

| 型 | 失敗↓ | 推理延遲↓ |

|---|---|---|

| 德蒙特[33]? | 3.75噸 | 10.72秒 |

| 我們 | 0.24噸 | 1.34秒 |

正如?LABEL:runtime_metrics_table?所示,我們的方法將計算注意力所需的資源量減少了大約一個數量級。

4.4消融

任務交互塊。為了展示我們實現的各個功能的影響,在?LABEL:component_ablation?中可以看到對任務交互塊組件的消融。從與 DeMT 基線相比的改進百分比來看,很明顯,用我們的可變形 ITSA(第二行)的精簡版本替換全局 MHSA 已經導致所有任務指標的平均值有了很大的相對改善。此版本僅執行單個可變形 ITSA 步驟,沒有附加位置編碼Xc,并使用 1 x 1 卷積和 2 x 2 最大池化對特征金字塔生成執行下采樣。應用步幅為 2 的 3 x 3 卷積進行下采樣、附加位置編碼以及使用 3 個細化步驟都具有較小的相對影響。然而,與基線相比,它們較小的個人貢獻仍然使功能齊全的模型有了實質性的改進。

梯度縮放因子。?標簽:gradient_scale_ablation顯示了梯度比例因子的消融λ用于可變形ITSA,強調為該超參數選擇適當值的重要性。將平均改進百分比與因子 1 的版本進行比較,該版本根本不縮放梯度,我們觀察到 10 和 30 的因子已經導致指標的改善,但縮放 50 或 100 似乎接近最佳值。為了說明超出我們選擇的 100 不會產生顯著的進一步改進,我們還嘗試了 200 的系數,此時模型的指標崩潰了。這是因為,對于如此大的縮放因子,很大一部分采樣點將位于特征圖之外,因此需要將它們裁剪到地圖邊緣周圍的位置。這將模型置于一個深的局部最小值中,對于大多數查詢和偏移量,只能對那些邊緣位置進行采樣,這解釋了糟糕的結果。

特征金字塔級別。?標簽:feature_pyramid_ablation表明,額外的金字塔級別對語義分割的改善最大,對深度估計任務的影響較小。由于其余兩個任務的性能大致保持不變,因此總體平均提升不是特別大。然而,我們仍然認為,僅為了提高分割性能,在模型中保留多個特征金字塔水平是值得的。

5結論

在這項工作中,我們引入了可變形的任務間自注意力,這是一種顯著降低與在具有許多查詢的 Vision Transformer 模型中任務之間進行相關的計算成本的方法。我們證明,我們的方法使 FLOP 計數和推理延遲提高了大約 10 倍。同時,我們仍然能夠在不同的主干和數據集中大幅度提高模型中任務的預測質量。

目前我們方法的一個局限性是它專注于密集的預測任務。在未來的工作中,我們打算將我們的方法推廣到其他結構化程度較低的任務中。特別是,我們也想擴展我們的方法以支持對象檢測任務。這將涉及必須學習從對象查詢中計算參考點,因為我們不能再僅使用特征圖中查詢的位置作為其參考點。

?

)

HTML基礎教程:文檔類型聲明與字符編碼詳解)

接口文檔自定義排序(萬能大法,支持任意swagger版本))