引言:Stable Diffusion 概述

? 在人工智能圖像生成領域,商業工具如Midjourney憑借其集成化服務與高質量輸出占據市場,而Stable Diffusion(簡稱SD)則以開源特性構建了差異化優勢。與商業工具依賴云端資源、受限于訂閱費用及使用配額不同,SD采用完全免費開源的開發模式,允許用戶本地部署并規避資源限制,這一特性為個人創作者與專業團隊提供了靈活定制與成本優化的雙重價值。作為基于深度學習的擴散模型(diffusion model),SD的核心功能包括通過文本描述(Prompt)生成逼真圖像、藝術風格作品及對現有圖像進行修改,其源代碼與模型權重均在GitHub公開,支持開發者與用戶進行二次開發,推動生成式人工智能技術的普及應用。

?自2022年由Stability AI、慕尼黑大學機器視覺學習組(CompVis)及Runway聯合推出以來,SD經歷了多代技術迭代:2022年發布的SD1.5奠定主流應用基礎,2023年的SDXL版本提升細節呈現與風格多樣性,2024年的SD3與Flux模型進一步優化精度與智能化水平。截至2025年,最新版本Stable Diffusion 3.5(SD3.5)實現了關鍵技術突破:作為多模態擴散變換器(MMDiT)模型,其在圖像生成質量、排版準確性、復雜提示理解及資源效率方面均有顯著改進,支持百萬像素級輸出與多模態輸入,可精準生成色彩還原度高、細節豐富的視覺內容。此外,SD3.5首次開放免費商用授權,進一步拓展了商業項目的應用場景,成為連接創意與技術落地的重要工具。

?SD的開源生態與技術演進為用戶提供了從基礎應用到高級定制的全流程支持。后續章節將圍繞其安裝部署指南、版本特性對比、核心功能解析及高級應用場景展開詳細探討,為不同需求的用戶提供系統性技術參考。

Windows安裝指南

系統要求與環境準備

在進行Stable Diffusion安裝前,需明確設備的硬件與軟件兼容性,以下從系統要求、設備自查及環境配置三方面進行說明。

一、系統與硬件要求

1. 操作系統

最低配置為Windows 10及以上版本;推薦使用Windows 10/11專業版以保障穩定性。若計劃使用SD3.5版本,建議升級至Windows 11 23H2或更高版本;Mac設備需升級至macOS 15及以上。

2. 硬件配置

- CPU:無強制性最低要求,但推薦8代酷睿I5級別及以上處理器以提升運算效率。

- 內存:最低8GB,推薦16GB及以上,以支持模型加載與多任務處理。

- 顯卡與顯存:

- 最低配置:需Nvidia獨立顯卡,顯存至少4GB(如GTX 1650);A卡或集成顯卡僅支持CPU渲染,速度顯著降低。

- 推薦配置:Nvidia RTX 2060(6GB顯存)及以上型號(如RTX 3060、RTX 4060 8GB),顯存8GB及以上;SD3.5版本對顯存要求更高,Medium版需至少12GB,Large版需24GB及以上。

- 移動端設備需確認顯卡是否支持CUDA(Nvidia)或Metal(Mac)框架。

- 磁盤空間:最低30GB可用空間,推薦使用固態硬盤(SSD)存放整合包及模型文件,以提升加載速度。

| 配置項 | 最低配置 | 推薦配置 |

|---|---|---|

| 操作系統 | Windows 10+ | Windows 10/11專業版 或 Windows 11 23H2+ (SD3.5) |

| CPU | 無強制要求 | 8代酷睿I5級別及以上處理器 |

| 內存 | 8GB | 16GB及以上 |

| 顯卡 | NVIDIA獨立顯卡(4GB顯存) | RTX 2060(6GB顯存)及以上型號 SD3.5要求: - Medium版:12GB顯存 - Large版:24GB顯存 |

| 顯存 | 4GB (如GTX 1650) | 8GB及以上 (如RTX 3060/4060) |

| 磁盤空間 | 30GB | SSD固態硬盤30GB以上 |

二、設備兼容性自查

用戶可通過Windows任務管理器查看GPU顯存:打開任務管理器(快捷鍵Ctrl+Shift+Esc),切換至“性能”選項卡,選擇“GPU”,在“專用GPU內存”處查看顯存容量,確認是否滿足對應版本的顯存要求。

三、環境準備

1. Python環境配置

必須安裝Python 3.10.6版本(官網:python.org/downloads),安裝時需勾選“Add Python 3.10 to PATH”以配置環境變量;若已安裝其他Python版本,需先卸載舊版本。

2. Git安裝與配置

需安裝Git工具(官網:https://git-scm.com/download,選擇64位Windows安裝包),安裝時確保勾選“Add?Git to PATH”以配置環境變量。

3. 其他注意事項

- 關閉360等安全軟件及防火墻,避免攔截文件下載;

- Windows系統需解除Powershell執行策略限制:以管理員身份運行Powershell,執行命令“Set-ExecutionPolicy Unrestricted”并確認;

- Nvidia用戶需確保顯卡驅動支持CUDA,可通過NVIDIA官網下載對應驅動;

- 首次啟動時將自動下載約10GB的VAE和CLIP模型文件,需確保系統盤(通常為C盤)有足夠空間。

安裝方法:整合包與手動部署

Stable Diffusion 的安裝方法主要分為整合包安裝與手動部署兩種,二者適用于不同需求的用戶群體。整合包安裝(又稱“懶人安裝法”)適合新手用戶,其核心優勢在于簡化依賴配置流程,通過預打包的環境和工具實現快速啟動;手動部署則面向進階用戶,支持按需定制插件與環境,靈活性更高。以下從優缺點對比、分步教程及安全驗證三方面展開說明。

整合包安裝:新手友好的快速部署方案

整合包安裝的核心優勢在于“開箱即用”,無需手動配置依賴環境,且通常自帶基礎模型與優化插件。其優點包括:安裝流程簡化(解壓后雙擊啟動器即可)、自動更新依賴組件、集成常用插件(如xformers加速模塊);缺點則表現為靈活性受限,可能集成冗余插件,第三方整合包還存在缺失關鍵組件或植入廣告程序的風險。

推薦工具與分步教程:

主流整合包包括秋葉aaaki整合包(適合新手)和獨立研究員-星空整合包(優化AMD/低配置設備)。以秋葉整合包為例,具體步驟如下:

- 下載與解壓:從官方或可信渠道下載整合包,解壓至無中文路徑的磁盤(建議預留至少50GB空間)。

- 安裝依賴:運行整合包內的“啟動器運行依賴-dotnet-6.0.11.exe”,完成基礎依賴配置。

- 啟動與優化:雙擊“A啟動器”,首次啟動時系統自動更新組件;若顯存≤8GB,可在啟動器設置中添加“--medvram”參數優化內存占用;AMD用戶需在高級選項中將生成引擎切換為A卡模式。

- 訪問界面:啟動成功后,通過瀏覽器訪問默認地址“http://127.0.0.1:7860”進入WebUI。

手動部署:進階用戶的定制化方案

手動部署適合需深度定制插件或進行模型訓練的用戶,其優點為可按需選擇插件、便于問題排查;缺點是需手動配置環境依賴與模型文件,對技術基礎有一定要求。

分步教程:

-

環境準備:

- 安裝Python 3.10.6(勾選“Add Python 3.10 to PATH”以配置環境變量)。

- 安裝Git(官網下載64位版本,默認配置即可)。

- 解除Powershell安全鎖(管理員模式運行Powershell,執行“Set-ExecutionPolicy RemoteSigned”)。

-

代碼克隆與配置:

- 在無中文路徑的文件夾中打開命令行,執行克隆命令:

git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui.git。 - 進入克隆目錄,編輯“webui-user.bat”文件,添加優化參數:

set COMMANDLINE_ARGS=--xformers(啟用xformers加速);若顯存≤8GB,追加“--medvram”。

- 在無中文路徑的文件夾中打開命令行,執行克隆命令:

-

啟動與模型部署:

- 運行“webui-user.bat”,系統自動下載依賴組件并啟動服務。

- 從Hugging Face等官方渠道下載基礎模型(如SD 1.5的“v1-5-pruned-emaonly.safetensors”),放入“stable-diffusion-webui/models/Stable-diffusion”目錄。

-

訪問界面:啟動成功后,通過瀏覽器訪問“http://127.0.0.1:7860”進入WebUI。

模型文件的合法性與安全驗證

為避免惡意文件風險,需對下載的安裝包與模型文件進行安全校驗:

- 官方渠道優先:推薦從Stability AI官網(stability.ai)下載安裝包,檢查數字簽名(證書頒發者為“Stability AI Ltd.”);第三方平臺選擇帶藍色認證徽標的倉庫(如GitHub的AUTOMATIC1111項目)。

- SHA-256校驗:官網提供壓縮包的SHA-256哈希值(可在“下載校驗”頁面查詢),通過工具計算本地文件哈希值并比對,確保文件未被篡改。

- 模型完整性:官網下載包包含完整模型庫與安全校驗文件,第三方整合包需確認無組件缺失(如SD 3.5需包含Large/Turbo模型及Clip文件)。

| 驗證方法 | 適用場景 | 具體操作 | 驗證目標 |

|---|---|---|---|

| 數字簽名 | 官網安裝包驗證 | 檢查證書頒發者為"Stability AI Ltd." | 文件來源合法性 |

| 哈希校驗 | 第三方平臺文件驗證 | 計算SHA-256值并與官網"下載校驗"頁面比對 | 文件完整性 |

| 組件完整性 | 模型文件驗證 | 確認SD 3.5包含Large/Turbo模型及Clip文件 | 關鍵組件完備性 |

| 倉庫認證 | GitHub資源驗證 | 認準藍色認證徽標倉庫 | 資源來源可靠性 |

通過上述方法,可有效降低惡意軟件感染風險,確保安裝環境的安全性與穩定性。

SD 3.5特殊安裝步驟

Stable Diffusion 3.5(SD 3.5)因采用MMDiT架構及支持多模態輸入,其安裝流程與舊版本存在顯著差異。核心區別在于需通過ComfyUI部署,且模型文件與文本編碼器需分離存放。以下為具體安裝步驟及優化方案:

一、環境準備與文件部署

-

ComfyUI安裝

需使用最新版本ComfyUI以支持SD 3.5的技術特性。建議下載ComfyUI免安裝版并更新至最新版本,無需復雜配置即可直接運行。 -

模型與文本編碼器分離存放

- 基礎模型:將SD 3.5模型文件(如sd3.5_large.safetensors或sd3.5_large_turbo.safetensors)放入ComfyUI/models/checkpoint目錄。

- 文本編碼器:SD 3.5的多模態輸入依賴獨立文本編碼器,需將Clip模型(clip_g.safetensors、clip_l.safetensors)及T5XXL系列模型(如t5xxl_fp16.safetensors或t5xxl_fp8_e4m3fn.safetensors)存放于ComfyUI/models/clip目錄。其中,T5XXL模型提供FP16(高精度)和FP8(低顯存)兩種版本,FP8量化模型(如t5xxl_fp8_e4m3fn_scaled.safetensors)適用于顯存受限設備。

二、啟動與工作流配置

-

啟動ComfyUI

運行ComfyUI根目錄下的一鍵啟動腳本(run_nvidia_gpu.bat),腳本將自動配置環境并啟動服務。啟動成功后,通過瀏覽器訪問本地地址http://127.0.0.1:8188即可進入操作界面. -

加載官方工作流

在ComfyUI界面中,拖入官方提供的SD 3.5工作流文件(如SD3.5L_Turbo_example_workflow.json),系統將自動加載模型及編碼器配置。對于Large Turbo版本,需注意采樣步數默認設為4步,CFG參數建議降低至1以匹配模型特性;Medium版本(參數量為Large版的30%)則可直接使用默認參數,顯存占用更低。

三、顯存優化方案

針對SD 3.5的高顯存需求,可通過以下方式優化:

- 啟動參數調整:在啟動腳本中添加--medvram參數,減少顯存占用。

- 量化模型應用:使用FP8量化的T5XXL模型(如t5xxl_fp8_e4m3fn_scaled.safetensors)及fp8_scaled工作流文件,實驗數據表明可降低約40%顯存占用。

- 模型版本選擇:優先選用Medium或Large Turbo版本,其設計目標為平衡性能與顯存消耗,適合中端硬件設備。

四、注意事項

- 環境依賴:安裝過程需保持網絡暢通,以確保實時下載依賴庫;首次啟動時,系統會進行硬件性能測試,未通過測試的設備可強制啟用“基礎模式”運行。

- 驅動兼容性:若提示顯卡驅動不兼容,需前往NVIDIA或AMD官網更新至最新版驅動(建議NVIDIA驅動版本≥550.00,AMD驅動版本≥24.7.1)。

- 文件校驗:模型加載失敗多因文件路徑錯誤或版本不匹配,建議從官方渠道獲取模型文件,并核對存放目錄是否符合ComfyUI規范。

版本區別與選擇指南

經典版本對比:SD 1.5/SDXL/SD3

版本核心維度對比表

| 維度 | SD 1.5 | SDXL | SD3 |

|---|---|---|---|

| 硬件門檻 | 4GB顯存即可運行,兼容低配設備(如6GB顯存顯卡) | 需8GB顯存以流暢運行,推薦高性能顯卡(如RTX 40系) | 硬件要求更高,具體配置未明確,但多模態功能對計算資源需求顯著 |

| 功能強度 | 生態最豐富(大量插件、Lora及Checkpoint模型),支持512×512分辨率,生成速度快 | 35億參數量(較SD 1.5的8.9億提升60%細節處理能力),支持1024×1024高清生成,細節接近專業攝影,新增智能提示詞補全和25種藝術風格預設 | 多模態輸入(文本、草圖、風格參考),優化Prompt理解力(減少偏差、提高一致性),支持復雜場景生成 |

| 適用用戶 | 新手、低配置設備用戶,需快速出圖或社交媒體內容(頭像、插畫) | 專業創作者(設計師、商業插畫師),需高精度渲染(廣告海報、電影預覽圖) | 高級用戶或企業級場景,需復雜多模態創作(電影級概念設計、3D建模結合) |

版本選擇建議

從硬件適配角度,SD 1.5以4GB顯存的低門檻成為低配設備(如老舊顯卡或筆記本)的首選,其輕量化特性確保在有限資源下仍能快速生成圖像。對于配備RTX 3060及以上顯卡(8GB顯存)的用戶,SDXL憑借1024×1024分辨率和細膩細節,可滿足專業級畫質需求,尤其在色彩光影還原和復雜場景表現上接近專業攝影水平。而SD3作為新一代模型,雖未明確最低顯存要求,但其多模態輸入和精準控制力更適合擁有高性能硬件且需處理復雜創作場景(如多主體融合、跨模態風格遷移)的進階用戶。

從需求場景看,若目標是快速出圖或二次創作(如二次元、卡通風格),SD 1.5豐富的生態資源(如預制模型和插件)可顯著降低操作成本。SDXL則更適合對畫質有嚴格要求的場景,例如商業插畫或 advertising 素材,其智能提示詞補全和格式兼容性(WebP/PSD)進一步提升專業工作流效率。SD3目前處于預覽階段,多模態功能(如草圖驅動生成)使其在概念設計和跨媒介創作中具備潛力,但需注意其尚未廣泛可用且可能受安全措施影響性能。

SD 3.5版本解析:Large/Turbo/Medium

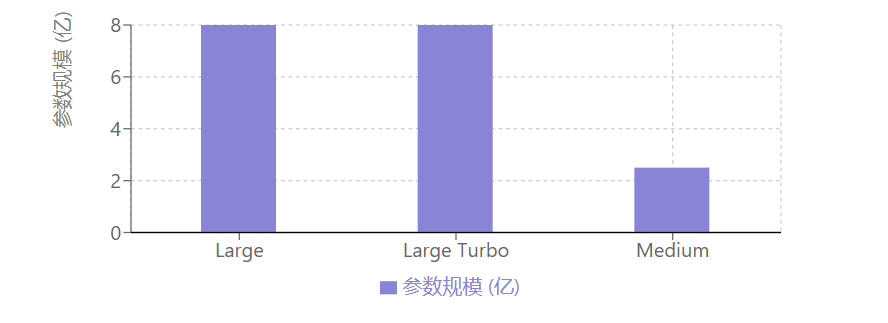

Stable Diffusion 3.5(SD3.5)在技術架構上實現了顯著突破,核心改進包括QK歸一化(大型Transformer模型的標準優化方法)和雙注意力層(在MMDiT結構中引入兩個注意力模塊),這些創新提升了模型的特征提取精度與生成穩定性,為不同應用場景提供了性能基礎。該版本包含三個子模型,分別針對專業需求、實時交互與輕量化應用進行優化,其真實感表現優于前代SDXL,在商業場景中具備較強競爭力。

SD3.5 Large作為完整模型,參數規模達80億,原生支持百萬像素級分辨率輸出(如1024×1024,即1兆像素),圖像細節與真實感表現卓越。該模型需20個采樣步驟,單張圖像處理時間約20秒,推薦配置16GB以上顯存以確保流暢運行,適用于專業設計、商業營銷內容創作等高精度需求場景,如游戲概念藝術、高端廣告素材制作等專業商業用途。

| 參數 | SD3.5 Large | SD3.5 Large Turbo | SD3.5 Medium |

|---|---|---|---|

| 參數規模 | 80億 | 與Large相近 | 25億 |

| 分辨率支持 | 百萬像素級<br>(如1024×1024) | 與Large相同 | 0.25-2百萬像素 |

| 生成步驟 | 20步 | 4步 | 未明確 |

| 單張處理時間 | ≈20秒 | ≈10秒 | 未明確 |

| 推薦顯存 | ≥16GB | ≥8GB | 12GB可流暢運行 |

| 核心優勢 | 專業高精度圖像 | 實時交互速度 | 消費級硬件優化 |

| 適用場景 | 專業設計/商業營銷 | 直播草圖生成 | 個人創作者日常使用 |

SD3.5 Large Turbo是Large版本的蒸餾優化模型,通過時間步蒸餾技術將生成步驟壓縮至4步,單張圖像生成時間縮短至10秒(部分場景可實現更快速度),參數規模與Large相近但計算效率顯著提升,推薦8GB以上顯存即可運行。其核心優勢在于快速迭代能力,適合實時交互場景,如直播中的草圖即時生成、設計方案快速預覽等對響應速度要求高的應用。

SD3.5 Medium則以25億參數實現了質量與效率的平衡,支持0.25至2百萬像素分辨率輸出,針對消費級硬件優化,在12GB顯存的普通設備上即可流暢運行。該模型采用改進的MMDiT-X架構及訓練方法,通過在變換器前13層引入自注意力模塊增強多分辨率生成能力與圖像一致性,兼顧了生成質量與硬件友好性,適用于個人創作者、低配設備用戶的日常使用及輕量化商業需求。

綜合來看,SD3.5系列通過技術創新與模型細分,在真實感表現上較前代有顯著提升,其三個子版本分別覆蓋了專業高精度、實時交互與輕量化應用場景,憑借卓越的圖像質量與靈活的部署能力,在商業生成式設計領域展現出強勁競爭力。

核心功能解析

WebUI界面與基礎操作

完成Stable Diffusion安裝后,通過運行懶人包的run.bat或標準安裝的webui-user.bat啟動服務,首次啟動將自動彈出瀏覽器界面,或手動訪問http://127.0.0.1:7860進入AUTOMATIC1111開發的WebUI界面,該界面基于瀏覽器運行,支持直觀調整參數和管理插件,核心功能圍繞“文生圖(txt2img)”工作流展開。

文生圖工作流核心步驟

1. 模型選擇

界面左上角的下拉框用于切換Stable Diffusion大模型,模型決定生成圖像的基礎風格與類型,其存放目錄為stable-diffusion-webui/models/Stable-diffusion,拷貝模型文件后刷新或重新加載即可生效。此外,VAE模型(存放于stable-diffusion-webui/models/VAE)可通過設置界面添加至快速選項,用于濾鏡效果和畫面微調,常用型號如“840000”,能優化圖像色彩與細節表現。

2. 提示詞編寫

提示詞分為正向與反向兩類:

- 正向提示詞:明確生成內容的細節描述,如“1girl, blue dress, sunset”,需精準傳達主體、場景、風格等要素。

- 反向提示詞:指定需規避的特征,如“malformed hands, extra fingers, lowres”,可有效降低畸形手腳、模糊等不良特征的生成頻率,其效果優于通過括號調整關鍵詞權重的強調符方法。

3. 參數配置

- 采樣方法與迭代步數:人物圖像推薦使用“DPM++ 2S a”采樣器,迭代步數設置為25-30,可在保證生成質量的同時平衡效率;若步數過低(如<20)可能導致圖像出現視覺缺陷。

- 無分類指導比例(CFG值):建議設置為7-10,低數值(如5-7)適合創意場景,高數值(如9-12)適合需要嚴格匹配提示詞的具體輸出。

- 圖像尺寸:基礎分辨率推薦方圖512×512(SD 1.x)、768×768(SD 2.x)或1024×1024(SDXL),豎圖或橫圖需保持等比例縮放以避免變形。

4. 高清修復與生成優化

“高清修復”功能可對生成圖像進行放大處理,提升細節清晰度,適合基礎分辨率生成后進一步優化畫質。生成批次與每批數量參數控制圖像產出效率,每批數量建議設為1以降低顯存占用。

漢化設置(降低中文用戶門檻)

通過安裝漢化插件(如stable-diffusion-webui-localization-zh_Hans)可將界面轉為中文。具體步驟為:在WebUI的“Extensions”選項卡中搜索插件名稱,安裝后重啟界面,在“Settings→User interface→Localization”中選擇“zh-Hans”并應用,即可完成漢化。

高級功能:ControlNet與多模態輸入

ControlNet作為Stable Diffusion的核心高級控圖工具,通過引入外部控制圖(如邊緣檢測結果、人體姿勢骨架、深度圖等)實現生成過程的精準調控,其核心機制在于將輸入控制信號與生成模型的中間特征層綁定,從而約束圖像生成的結構與細節。該功能支持Canny邊緣檢測、Openpose姿勢估計、Depth深度估計等10余種預處理器,可根據需求選擇對應工具生成控制圖,顯著提升復雜場景下的生成可控性。

在具體應用中,ControlNet與輔助工具的聯動可實現高度定制化的控圖效果。例如,結合Openpose-editor插件生成的人體骨架圖作為控制輸入時,模型能夠嚴格遵循骨架定義的關節位置與肢體姿態,生成符合自定義動作要求的人物圖像。這一流程突破了傳統生成中人物姿勢隨機性的限制,尤其適用于動漫角色、虛擬偶像等需要精準動作設計的場景。此外,通過Depth預處理器生成的深度圖可作為控制信號,輔助Depth2img模型保留原始圖像的空間結構關系,在場景重構或視角調整任務中,能夠有效維持物體間的前后位置與比例關系,避免傳統生成中常見的空間扭曲問題。

Stable Diffusion 3.5(SD 3.5)的多模態輸入功能進一步拓展了可控性邊界,支持文本、草圖、風格參考圖的聯動輸入,其核心改進在于引入結構化提示詞語法,解決了舊版“關鍵詞堆砌”模式下語義解析精度低、風格控制模糊的局限性。結構化提示詞通過[風格:XXX]語法(如[風格:賽博朋克])實現對生成風格的精準錨定,系統能夠優先解析標簽內的風格指令,并將其與文本描述、參考圖像等多模態信息融合,確保風格特征在生成過程中的一致性與主導性。相較于舊版依賴關鍵詞權重調整(如“賽博朋克, 未來感, 霓虹燈光::5”)的粗放式控制,結構化語法顯著降低了風格偏移風險,尤其在復雜風格混合(如[風格:巴洛克]+[風格:蒸汽波])場景下,可實現更細膩的視覺過渡效果。

此外,SD 3.5的多模態輸入支持跨模態信息的協同優化。例如,用戶可同時輸入文本描述(“未來城市夜景”)、草圖輪廓(勾勒建筑布局)及風格參考圖(賽博朋克色調樣本),系統通過結構化提示詞[風格:賽博朋克]統一風格基準,結合ControlNet的Depth預處理器保留草圖的空間布局,最終生成既符合構圖要求又精準匹配目標風格的圖像,體現了“文本-圖像-控制信號”多維度協同的高級生成能力。

模型類型與應用

基礎模型(Checkpoint)

基礎模型(Checkpoint,簡稱底模或大模型)是Stable Diffusion生成圖像的“畫風基石”,作為核心知識庫決定生成內容的整體風格走向,如二次元、真人寫實、2.5D等類型,其文件格式通常為.ckpt或.safetensors,體積普遍在2GB至8GB之間。該類模型通過控制畫面構圖、色彩基調、細節表現等核心要素,為后續生成任務提供基礎框架,是AI繪畫風格的根本決定因素。例如,動漫風格可選用Counterfeit-V3.0(厚涂油質感)、AbyssOrangeMix3(油光質感人物/景物),真實風格可選用AWPortrait(高逼真肖像)、ChilloutMix(逼真風景與人物)等專用模型,而通用基礎模型如SD1.5(輕量級入門)、SDXL(高畫質)、SD3(專業級)及其衍生版本(如Anything V5、majicMIX系列)則需根據場景需求選擇或融合使用。

在模型管理方面,不同工具的存放路徑存在差異:WebUI環境下通常存放于stable-diffusion-webui/models/Stable-diffusion目錄,ComfyUI則對應ComfyUI/models/checkpoints路徑,用戶可通過WebUI頂部的模型切換欄快速切換不同底模,實現多風格任務的靈活調度。以SD 3.5版本為例,其基礎模型系列包括Large(80億參數,支持1MP+高清圖像生成與微調)、Large Turbo(精簡版,四步快速生成,速度優先但質量略降)及Medium(25億參數,支持2MP圖像,低內存占用適配消費級硬件),用戶可根據硬件性能與畫質需求選擇對應模型文件。

文件格式方面,.ckpt與.safetensors是兩種主流類型。.ckpt為TensorFlow格式,包含模型權重及訓練狀態信息,適用于需要保留訓練細節的微調場景,但存在潛在惡意代碼風險且體積較大;.safetensors由HuggingFace設計,僅存儲張量權重數據,具有無惡意代碼風險、加載速度快、體積更精簡等優勢,因此在直接出圖場景中推薦優先使用。需注意,部分舊版WebUI需升級后才能支持.safetensors格式加載。

微調模型:LoRA與Embedding

在Stable Diffusion的模型微調技術中,LoRA(低秩自適應模型)與Embedding(文本反轉模型)是兩種針對不同需求設計的輕量化工具,二者在功能定位、體積規模及應用場景上存在顯著差異,且可通過組合使用實現更精準的生成控制。

從功能特性來看,LoRA的核心價值在于對特定角色、物品或藝術風格的精細化微調。作為基于大模型的低秩自適應技術,其通過優化模型參數的低秩矩陣,實現對目標特征的定向強化,例如固定角色的面部特征、特定畫風(如二次元、寫實)或物品細節的復刻。相比之下,Embedding的功能聚焦于提示詞的簡化與打包:正向提示詞中,它可將多個描述性詞匯壓縮為單個觸發詞(如用“鳴人”代替“黃色頭發、藍色眼睛、護額”等長串特征描述);負向提示詞中,其能將“低畫質、模糊、變形”等常見負面詞匯打包為統一向量,典型案例如EasyNegative模型,通過單個關鍵詞即可調用預設的負面提示詞集合。

體積規模上,二者差異懸殊。LoRA模型因需存儲微調后的低秩矩陣參數,文件體積通常為幾十至幾百MB,常見規格包括36M、72M、144M等,格式多為.ckpt、.safetensors或.pt。而Embedding作為文本向量的壓縮結果,僅需存儲訓練得到的文本反轉向量,文件體積極小(通常為幾十KB),格式為.pt。

使用場景的分化進一步體現了二者的互補性。LoRA適合對固定角色或風格進行深度微調,例如通過訓練特定角色的LoRA模型,在生成時保持角色特征的一致性,部分LoRA需通過觸發詞激活(如“jellyfishforest”),且支持多模型同時加載以疊加效果。Embedding則更適用于簡化提示詞流程,尤其在負向提示詞管理中優勢顯著,例如通過EasyNegative(下載地址:https://civitai.com/models/7808/easynegative)可快速調用標準化的負面詞匯集合,減少重復輸入。

在實際應用中,LoRA與Embedding的組合使用可顯著提升生成效率與質量。典型流程為:以通用基礎模型(如SD1.5)為底模,通過LoRA模型調整細節特征(如角色服飾、場景光影風格),同時加載Embedding優化提示詞結構(如正向用Embedding簡化角色描述,負向用EasyNegative打包負面詞匯)。例如,在ComfyUI工作流中,可通過串聯LoRA模型實現風格微調,并同步調用Embedding觸發詞以精簡提示詞輸入,形成“底模+LoRA細節控制+Embedding提示詞優化”的協同模式,兼顧生成精度與操作便捷性。

綜上,LoRA與Embedding通過差異化的“功能-體積-場景”定位,共同構成了輕量化微調的核心工具鏈:LoRA以中等體積實現高精度風格/角色控制,Embedding以極小體積簡化提示詞流程,二者的組合應用為 Stable Diffusion 的精細化生成提供了靈活解決方案。

輔助模型:VAE與Hypernetwork

在Stable Diffusion的圖像生成流程中,基礎模型(底模)可能面臨色彩暗淡、細節模糊等問題,導致輸出圖像呈現“灰蒙蒙”的視覺效果。這一問題的核心在于基礎模型在圖像解碼過程中對色彩和細節的還原能力有限,而變分自編碼器(VAE)作為輔助模型,通過優化解碼階段的特征映射,成為解決該問題的關鍵方案。

VAE的核心功能是通過調整圖像的色彩映射與細節重構,改善生成結果的視覺質量。具體而言,當基礎模型生成的圖像存在顏色暗淡、對比度不足等問題時,外掛VAE模型可顯著提升色彩飽和度與亮度,同時增強細節銳利度。其文件格式通常為.ckpt、.pt或.safetensors,體積約300MB,需存放于models/VAE目錄下,使用時通過WebUI頂部設置欄切換sd_vae參數實現啟用。需注意的是,部分大模型(如Chilloutmix)已內置VAE功能,額外添加外部VAE可能導致色彩失真(如生成“藍色廢圖”),此時需將VAE模式切換為“Automatic”以避免沖突。常用的VAE模型包括Stability AI發布的EMA(銳利風格,對應文件vae-ft-ema-560000-ema-pruned.safetensors)和MSE(平滑風格,對應文件vae-ft-mse-840000-ema-pruned.safetensors),用戶可根據生成需求選擇適配類型。

與VAE不同,Hypernetwork作為另一類輔助模型,其設計初衷是通過微調網絡權重影響生成風格,但在實際應用中逐漸被LoRA取代。Hypernetwork的核心特點是模型體積較小(通常幾十MB),文件格式為.pt,存放于models/hypernetwork目錄,使用時需在提示詞中通過\<hypenet:filename:multiplier>格式調用。然而,相較于LoRA,Hypernetwork存在顯著局限性:其一,其對模型特征的調控能力較弱,被視為“低配版LoRA”;其二,訓練過程難度較高,難以穩定生成高質量效果;其三,隨著LoRA技術的成熟,Hypernetwork的功能已被更高效的LoRA覆蓋。因此,目前Hypernetwork的適用場景極為有限,僅在特定 legacy 工作流中可能保留使用,大多數情況下建議優先選擇LoRA以實現更精準、高效的風格調控。

插件系統與常用插件

插件安裝與管理

Stable Diffusion WebUI的插件安裝主要通過WebUI界面完成,具體流程可分為兩種方式。第一種是通過插件市場搜索安裝:在WebUI中進入“Extensions”頁面,選擇“Available”選項卡,點擊“Load from”加載插件列表,隨后搜索目標插件(如漢化插件“hans”和“bilingual”),選中后點擊安裝,完成后需點擊“Apply and restart”使插件生效。第二種是通過GitHub鏈接安裝,適用于需指定版本或未在市場收錄的插件(如ControlNet):在“Extensions”頁面選擇“Install from URL”,輸入插件的GitHub倉庫鏈接(例如ControlNet的官方鏈接https://github.com/Mikubill/sd-webui-controlnet),點擊“install”,待提示“installed?into”后重啟WebUI即可啟用。

插件安裝后需特別注意版本兼容性。由于Stable Diffusion核心版本升級可能導致API變化,例如SD3.5因核心API更新,要求ControlNet插件版本需為4.0及以上,否則可能出現功能異常或無法加載。對于存在兼容性問題的經典插件(如LoRA訓練器),官方已推出兼容層轉換工具,可通過該工具適配新版本WebUI。

插件管理功能可通過WebUI的“Installed”頁面實現,用戶可在此查看所有已安裝插件,并根據需求禁用或卸載沖突插件,以避免功能重疊或運行異常。此外,推薦安裝Civitai Helper插件,該插件可解決模型預覽圖缺失、插件版本更新檢測、模型斷點續傳下載等實際使用痛點,提升插件與模型管理的效率。

必備插件推薦

在Stable Diffusion的創作流程中,插件的合理搭配能夠顯著提升效率與成果質量。以下按“前期準備-中期生成-后期優化”的創作流程,結合顯存優化與局部編輯等實操需求,提供插件組合方案,并說明SD3.5版本的插件兼容性要點。

一、前期:提示詞優化與準備

前期核心需求為提升提示詞(Prompt)的準確性與完整性,減少手動輸入負擔。TagComplete是該階段的核心插件,其支持自動補全Embeddings、LoRA、Hypernetwork等模型名稱,通過輸入\<e:>(觸發Embeddings)、\<l:>(觸發LoRA)、\<h:>(觸發Hypernetwork)等前綴即可快速調用資源,大幅提升提示詞編寫效率。輔助工具可搭配sd-webui-prompt-all-in-one(實現提示詞翻譯與順序調整)及Tag反推插件(通過圖片獲取提示詞,輔助逆向學習),形成“提示詞生成-補全-優化”的完整前期流程。

二、中期:圖像生成與控制

中期聚焦于圖像生成過程的精準控制、大分辨率輸出及局部調整,需結合顯存優化策略。

- 控圖核心:ControlNet插件通過輸入圖像(如姿勢圖、邊緣圖)或控制參數引導生成,支持人體姿勢、物體邊緣等精細控制,是實現“所想即所得”的關鍵工具。配合Inpaint局部重繪(支持普通局部重繪與手涂蒙版),可對生成圖像的特定區域進行針對性調整,例如修正局部構圖或細節。

- 放大與顯存優化:Tiled Diffusion + Tiled VAE組合專為小顯存設備設計,可生成大分辨率圖像。文生圖場景下僅啟用Tiled VAE即可,圖生圖場景需同時啟用兩者以平衡顯存占用與生成質量。實操中建議同步啟用

--xformers參數優化顯存分配,進一步提升大分辨率生成的穩定性。若需分塊放大或修改原圖,可補充Ultimate Upscaler插件,通過ESRGAN、GFPGAN等算法實現高清放大。

三、后期:細節修復與增強

后期重點在于修復生成圖像中的細節瑕疵,提升整體質感。Adetailer(After Detailer)?插件可自動識別并增強人臉、手部等關鍵區域的細節,無需手動蒙版即可實現精準修復,是后期優化的核心工具。若需針對性修復臉部,可補充Face Editor插件,通過圖生圖模式進一步調整 facial features 的清晰度與自然度。

SD3.5插件兼容性說明

當前SD3.5版本的插件生態存在一定限制:WebUI(Automatic1111)暫未完全支持其插件系統,多數經典插件(如ControlNet、Tiled Diffusion)的功能適配仍在開發中。建議優先使用ComfyUI的插件生態,其支持中文語言包(如AIGODLIKE-ComfyUI-Translation)、語法檢查插件及兼容層轉換工具,可適配SD3.5的新特性與模型架構。

高級應用與優化

性能優化:顯存與速度平衡

Stable Diffusion的高效運行需在顯存占用與生成速度間實現動態平衡,針對不同硬件配置(低配、中配、高配)需采取差異化優化策略。以下結合具體硬件場景與技術參數,提供系統性解決方案,以解決顯存不足、生成緩慢等核心問題。

一、低配硬件(顯存≤8GB,如GTX 1060等)

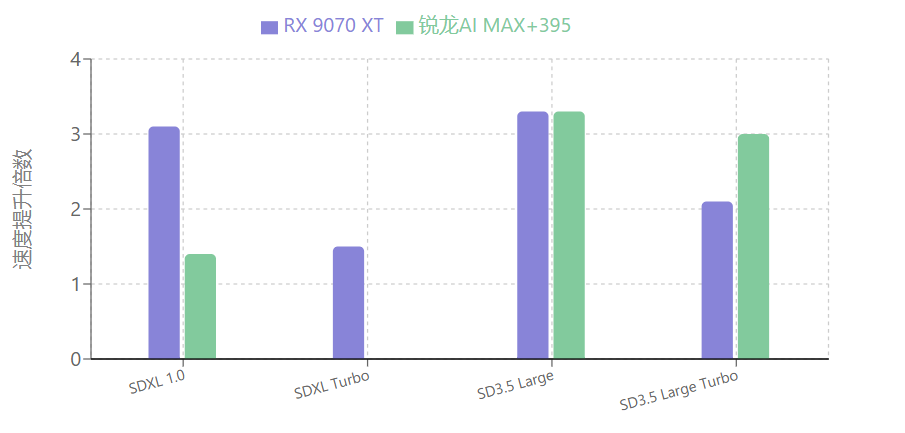

此類設備需優先解決顯存瓶頸,同時保障基礎生成效率。顯存優化方面,可通過啟動參數與精度控制實現資源高效利用:開啟“--medvram”參數(適用于8GB以下顯存)并配合FP16混合精度模式(在WebUI設置中啟用“Use mixed precision (FP16)”),可將512×512圖像生成的顯存需求從6GB降至3GB。啟用xFormers加速(啟動參數添加“--xformers”)可提升注意力計算速度,進一步降低顯存占用。速度優化方面,推薦使用SD 3.5 Large Turbo模型,其僅需4步采樣即可生成圖像,單張處理時間約10秒,適配低配設備算力限制。存儲層面,建議將模型文件存放于SSD,相較機械硬盤可減少3-5倍加載時間。

二、中配硬件(顯存8-12GB,如RTX 3060等)

中配設備可在顯存控制基礎上進一步提升生成效率。針對RTX 3060等NVIDIA顯卡,啟用“--medvram-sdxl”參數可針對性適配SDXL模型,結合xFormers加速與FP16模式,實現顯存占用與速度的雙重優化。對于AMD Radeon 7000系列顯卡,安裝24.30+版本驅動后,使用ONNX優化版模型(后綴“_amdgpu”)可使SD 3.5 Large Turbo生成速度提升2.1倍。顯存優化還可采用bitsandbytes量化技術,通過Diffusers庫加載NF4精度模型(需安裝transformers與bitsandbytes依賴),在保持生成質量的前提下降低顯存需求。此外,SD 3.5系列通過架構優化降低了顯存占用,Medium版本因參數量較少,更適合中配設備運行更大模型。

三、高配硬件(顯存≥12GB,如RTX 3090、AMD Radeon RX 9070 XT等)

高配設備可聚焦速度優化與高級功能啟用,同時通過精細化控制實現資源高效利用。顯存管理上,SD 3.5推薦配置為12GB(最低)、24GB(最佳)、32GB(更好),Large型號需重點優化推理階段顯存占用,結合SDXL智能緩存技術可提升30%顯存利用率,支持生成更大尺寸圖像。速度優化方面,SD 3.5 Large Turbo僅需4步采樣,AMD顯卡配合ONNX優化模型可使SD 3.5 Large生成速度提升3.3倍;生成4K分辨率圖像時,多級渲染技術可將處理時間縮短40%。對于ComfyUI用戶,可采用實驗性fp8_scaled工作流(如使用t5xxl_fp8_e4m3fn_scaled.safetensors替代t5xxl_fp16模型),在32GB以上內存環境下進一步優化顯存占用。此外,合理調整批處理大小(根據顯存容量設置)可避免OOM錯誤,配合SSD存儲實現模型快速加載,最大化硬件性能。

通過上述策略,不同硬件配置可實現針對性優化:低配設備顯存占用降低40%以上,中高配設備生成速度提升2-3.8倍,從而在各類硬件環境下實現Stable Diffusion的高效運行。

商業應用與版權規范

在Stable Diffusion的商業應用中,版權合規是不可忽視的核心議題,實踐中因版權意識薄弱導致的法律風險已多次顯現。例如,某設計公司因誤用未經授權的社區修改版模型被追責,最終造成12萬美元的經濟損失,這一案例凸顯了商業用戶明確許可條款、規避版權風險的重要性。

Stable Diffusion系列模型的商業使用權限因版本和許可類型存在明確界定。以Stable Diffusion 3.5為例,其在社區許可證框架下發布,免費使用范圍包括研究或非商業用途,以及年總收入不足100萬美元的組織或個人的商業用途;若商業用戶年營收超過100萬美元,則需申請企業許可證。此外,不同版本的許可條款存在差異:SD 1.5、2.1及XL版本采用CreativeML Open RAIL許可,允許廣泛商業使用;而SD 3.x系列則更新了條款,明確將年收入100萬美元作為商業用途的閾值,超過該標準的用戶需通過官方渠道獲取授權。

| SD版本 | 許可類型 | 免費商業使用條件 | 收入閾值 | 授權要求 |

|---|---|---|---|---|

| SD 3.5 / SD 3.x | 社區許可證 | 年收入 < 100萬美元 | 100萬美元 | 超過閾值需企業許可證 |

| SD 1.5/2.1/XL | CreativeML Open RAIL | 允許廣泛商業使用 | 無 | 無需額外授權 |

為降低法律風險,商業用戶需采取針對性措施確保合規。首先,應嚴格區分模型許可類型:對于年營收達到或超過100萬美元的企業,需通過Stability AI官網的“企業服務”通道申請正式授權;個人創作者或小型企業(年營收低于100萬美元)可在免費許可范圍內商用,但需避免使用未授權的衍生模型,此類模型可能因訓練數據或修改權限問題存在版權瑕疵。其次,推薦通過專業平臺篩選合規模型,例如在Civitai等社區中利用許可類型過濾功能,選擇明確標注“可商用”的模型,從源頭確保使用權限無爭議。

版權合規是Stable Diffusion商業應用的前提,任何忽視許可條款、誤用未授權模型的行為都可能導致法律追責。商業用戶應建立完善的版權審查機制,結合自身營收規模選擇合適的授權方式,確保AI生成內容的合法使用,從根本上規避法律風險。

總結與資源推薦

核心要點總結

Stable Diffusion作為當前AI繪畫領域的主流工具,其核心優勢體現在三個方面:一是免費開源特性,降低了技術使用門檻,允許用戶自由部署與二次開發;二是功能體系完善,覆蓋文生圖、圖生圖、控圖(如ControlNet插件支持)等全流程創作需求;三是生態系統豐富,提供多樣化模型(動漫、真實風格等)與插件支持(如Deforum動畫生成),適用于藝術創作、設計開發等多元場景。

定制化學習建議

針對不同用戶需求,建議采取差異化學習路徑:

- 入門用戶:優先選擇低門檻工具與輕量模型。硬件配置有限時,推薦SD1.5版本(資源豐富、易于上手)或SD 3.0 Lite輕量版(8GB顯存即可運行,內置200+預設風格模板及智能提示詞優化器);若需降低學習成本,可嘗試SDXL版本,其智能提示功能與預設模板能簡化參數調試流程。

- 專業用戶:聚焦高畫質與技術深度。推薦使用SDXL(需8GB以上顯存)或SDXL Turbo企業版,搭配RTX 3060及以上顯卡以保障4K圖像處理效率;工具方面,建議掌握ComfyUI進行節點式工作流設計,結合ControlNet等插件實現精準控圖,并通過Hugging Face、Civitai等平臺獲取專業模型(如寫實風格、行業專用模型)。

- 商業用戶:注重效率與規模化應用。可優先采用在線平臺(如DreamStudio、Clipdrop)快速生成內容,或通過Stability AI開發者API(https://platform.stability.ai/)集成至業務系統;模型管理推薦使用千帆大模型開發與服務平臺,實現模型下載、訓練與協作流程的一體化管理,同時關注Siliconflow等優化平臺以提升部署效率。

| 用戶類型 | 推薦工具 | 硬件要求 | 核心功能優勢 |

|---|---|---|---|

| 入門用戶 | SD1.5 / SD 3.0 Lite輕量版 | 8GB顯存 | 200+預設風格模板 智能提示詞優化器 |

| 專業用戶 | SDXL / SDXL Turbo企業版 | RTX 3060+顯卡<br>8GB+顯存 | 4K圖像處理 節點式工作流設計 |

| 商業用戶 | DreamStudio/Clipdrop在線平臺 Stability AI開發者API | 無特定要求 | 快速內容生成 業務系統集成 |

權威資源平臺推薦

為支持用戶持續學習與資源獲取,推薦以下權威渠道:

- 官方核心渠道:Stability AI官網(https://stability.ai)提供最新公告與研究成果;GitHub倉庫(如AUTOMATIC1111/stable-diffusion-webui、comfyanonymous/ComfyUI)包含開源代碼、安裝指南及社區貢獻插件。

- 中文學習資源:Stable Diffusion中文網(www.stablediffusion-cn.com)提供漢化教程、模型下載、中文語言包插件(如AIGODLIKE-ComfyUI-Translation)及技術社群支持(通過網站右側二維碼加入萬人交流群)。

- 模型與插件獲取:Hugging Face(https://huggingface.co)、Civitai(https://civitai.com)為核心模型庫,覆蓋從基礎模型到風格化模型;Liblib.art(https://www.liblib.art/)提供中文模型分享,Lexica(https://lexica.art/)可參考提示詞案例。

- 工具與平臺:在線生成工具包括stablediffusionweb.com、Replicate;本地部署需配置Python 3.10.6、Git及WebUI/ComfyUI;云服務推薦HyperAI超神經(提供免費算力時長)與haoee.com的ComfyUI云鏡像(內置預設工作流)。

AI創作的協作理念

Stable Diffusion的發展始終強調“人類引導+AI輔助”的協作模式。AI工具通過高效生成與技術賦能拓展創作邊界,而人類創作者則在創意構思、審美判斷、參數調控中發揮主導作用。建議用戶以開放心態探索技術與藝術的融合,通過精準提示詞設計、插件工具組合與模型微調,將AI輔助轉化為個性化創作能力,最終實現技術效率與藝術表達的協同提升。

:Pandas 進階)

![【BUUCTF系列】[HCTF 2018]WarmUp1](http://pic.xiahunao.cn/【BUUCTF系列】[HCTF 2018]WarmUp1)

基礎知識)

如何重構AI工具生態?)

html基礎)