?PaperWeekly 原創 ·?作者 |?史文浩

單位 |?電子科技大學

論文題目:

Math-LLaVA: Bootstrapping Mathematical Reasoning for Multimodal Large Language Models

論文鏈接:

https://arxiv.org/abs/2406.17294

開源鏈接:

https://github.com/HZQ950419/Math-LLaVA

動機和背景

近年來,大語言模型在數學推理中取得優異的表現,隨著多模態大模型的發展,模型能夠處理視覺語言輸入進行多模態數學推理。然而,現有的視覺指令數據集中,每張圖像對應有限的問題答案數據對,沒有充分利用視覺信息來增強多模態大模型的數學推理能力。

為此,我們從多種數據集中收集 4 萬張高質量圖像和問答數據對。通過對圖像各部分視覺信息充分提問,以及對問題數據進行增強,構建了一個高質量、多樣化的合成多模態問答數據集,從而增強多模態大模型數學推理的能力。本項工作強調合成高質量的多模態問答數據集在提高多模態大模型數學推理能力方面的重要性。

數據集合成

2.1 源數據收集

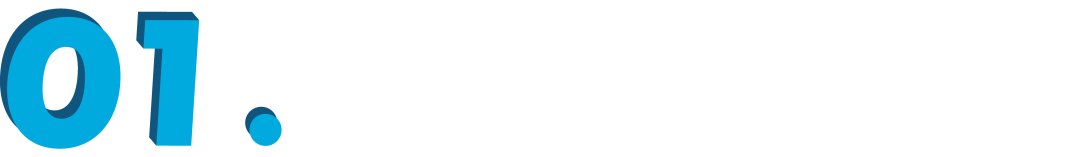

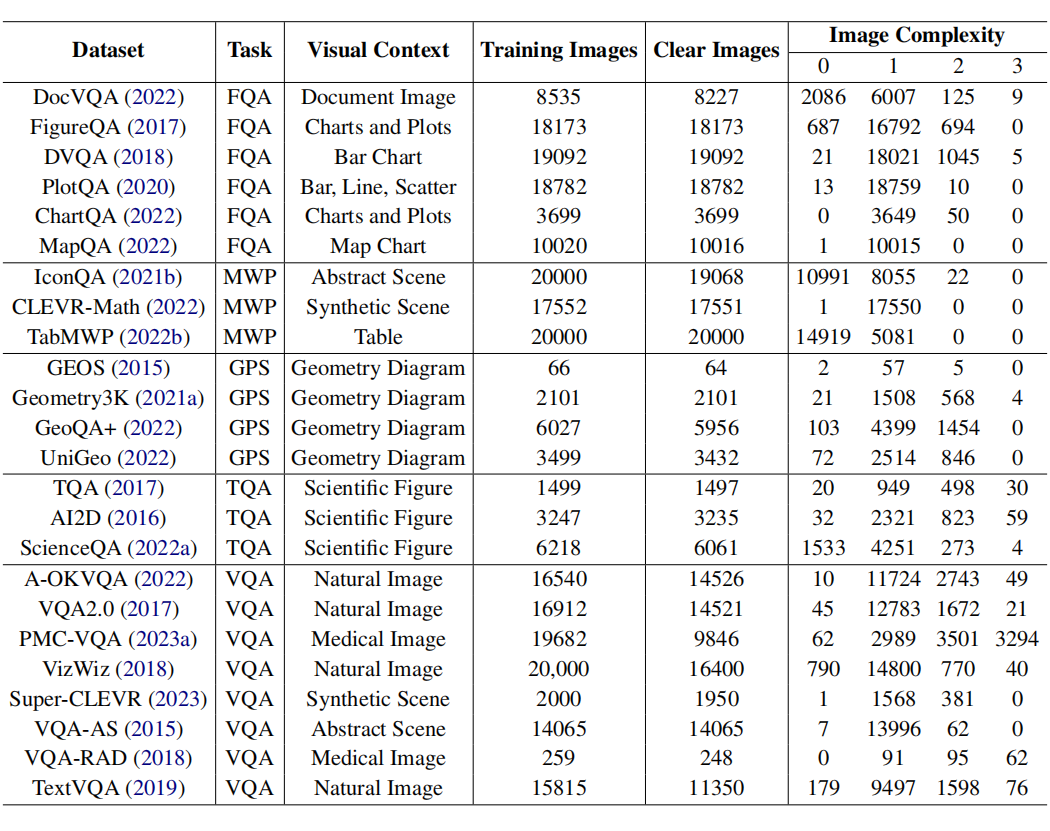

我們針對五種需要高水平推理能力的問題任務類型收集了 24 個多模態視覺問答和數學推理源數據集,任務類型包括 Figure Question Answering(FQA),Geometry Problem Solving(GPS),Math Word Problem(MWP),Textbook Question Answering(TQA),Visual Question Answering(VQA)。

在獲取源數據集后,我們根據圖像清晰質量和理解復雜度從中挑選高質量,理解難度分布合適的圖像集。具體地,我們使用 GPT4-V 對隨機均勻采樣的 1 萬張圖像的清晰度和理解復雜度進行標注,對于圖像清晰度,標簽 0 表示圖像模糊質量差,標簽 1 表示圖像清晰質量好。

圖像理解復雜度取決于物體數量、位置關系、細節程度、紋理、材料屬性以及是否涉及數學計算,分值設為 0 到 3 分。之后根據圖像標注數據微調圖像分類器,分別對源數據集的圖像清晰度和理解復雜度進行打分。如下表所示,包含每個源數據集的任務類型、視覺背景以及圖像清晰度和理解復雜度的分布。

我們過濾掉低質量的圖像,按圖像理解復雜度從簡單到復雜漸進地采樣,由于分值為 3 的圖像數量最少,因此收集全部。最終我們根據復雜度 2:3:4:1 的比例均勻選取 4 萬張圖像,這些數據的圖像信息多樣且難度逐步遞增。

2.2 數據增強

在收集的多模態問答數據中,每個圖像對應有限的問題,沒有充分利用圖像的視覺信息。因此,我們使用 GPT-4V 以 few-shot 的方式為每幅圖像生成更多問題答案對。具體地,對于屬于某任務類別的圖像,首先將屬于該類別的每個源數據集內部的問題進行聚類,再從每個源數據集的每個聚類中隨機采樣一個問題來共同構建注釋參考。以此,GPT-4V 新合成與原始問題分布接近,多樣的 20 萬個問答數據對。

我們再使用 GPT-4V 對原始問題進行增強,生成了 4 萬個更復雜的問題,4 萬個簡化的問題和 4 萬個邏輯一致的問題,以進一步提高模型的推理能力和魯棒性。最終我們構建了 36 萬高質量、多樣化的合成多模態問答數據集 MathV360K.

實驗結果

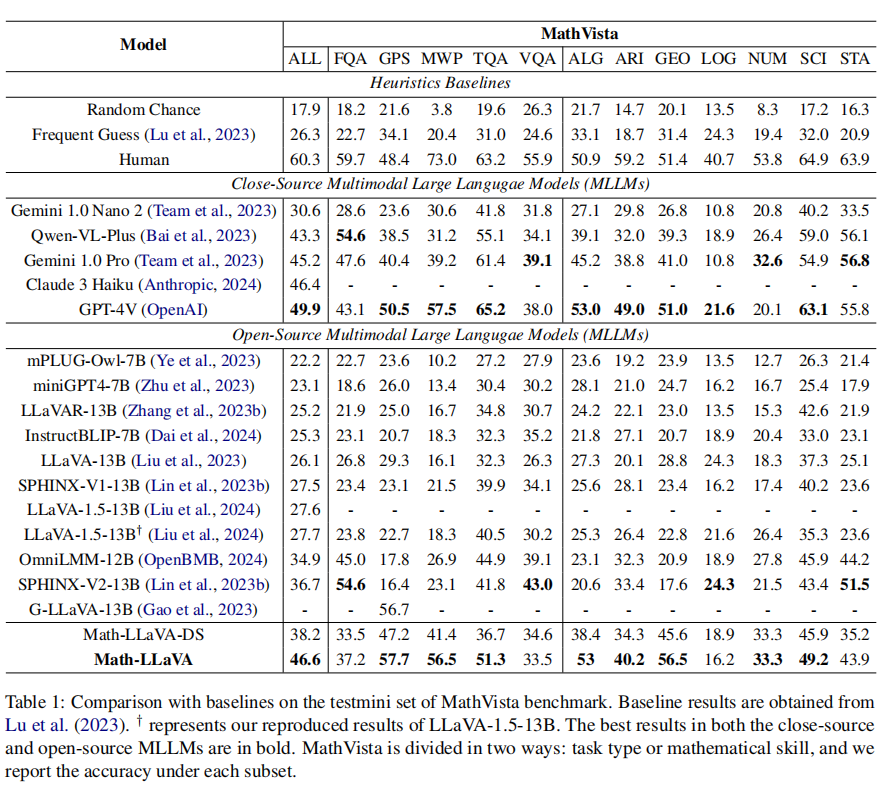

我們使用 MathV360K 對 LLaVA-1.5-13B 進行微調得到我們的模型 Math-LLaVA,并在 MathVista 和 MATH-Vision 數據集上進行了測試。其中 Math-LLaVA 在 MathVista minitest 中達到了46.6%,相對于 base model 提升了 19 個百分點。此外,在更困難的 MATH-Vision 數據集上達到 15.69%,超過了 Qwen-VL-Max(15.59%)。

MathVista minitest 數據集上不同方法模型的測試結果如下:

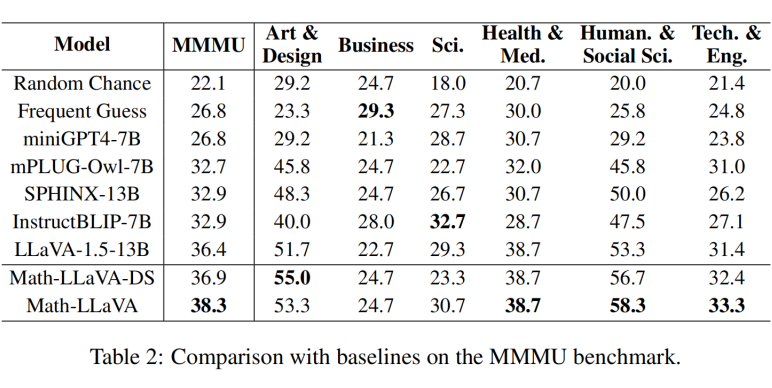

為了驗證 Math-LLaVA 的泛化性以及使用我們的合成數據微調不會削弱模型在其他領域的推理能力,我們在 MMMU 數據集上進行驗證。MMMU validation 數據集上不同方法模型的測試結果如下:

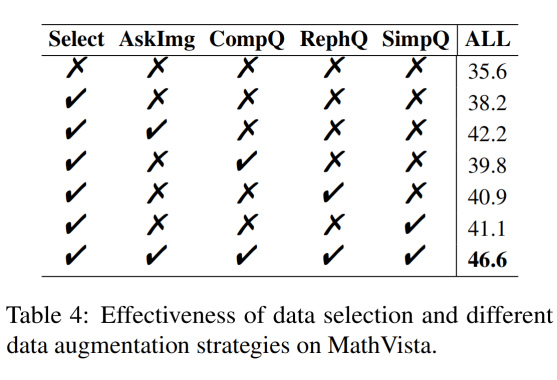

我們對數據收集和增強方式進行消融實驗,結果如下,說明我們的數據收集和不同增強方法都能提高多模態大模型的數學推理能力。

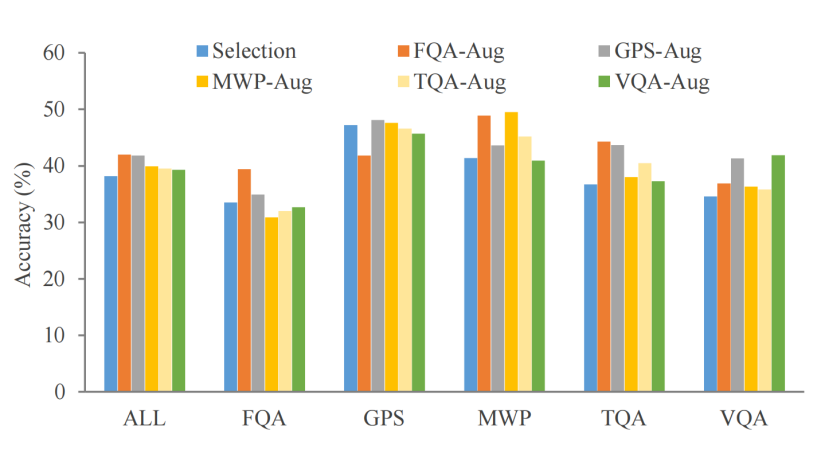

此外,為了探究對每種任務類型的源數據進行增強的有效性,結果如下:

總結

我們構建了一個高質量和多樣化的多模態問答數據集 MathV360K,可供社區在多模態大模型上使用,我們的合成數據集充分利用了圖像的視覺信息進行提問并對原始問題進行增強,提高了多模態數學問題的廣度和深度,可進一步提高多模態數學推理能力和模型魯棒性。

通過使用 MathV360K,我們對 LLaVA-1.5 進行微調得到 Math-LLaVA,顯著提高了其多模態數學推理能力,在 MathVista testmini 上取得 46.6% 的準確率,比基礎模型提高了 19%。在 MATH-Vision 數據集上達到 15.69%,超過了Qwen-VL-Max 的 15.59%。此外,Math-LLaVA 還在 MMMU 數據集上展現了一定的泛化性。對于未來的工作,我們將引入帶注釋的中間步驟,構建更全面、更高質量的數據集,進一步增強多模態大模型的推理能力。

更多閱讀

#投 稿?通 道#

?讓你的文字被更多人看到?

如何才能讓更多的優質內容以更短路徑到達讀者群體,縮短讀者尋找優質內容的成本呢?答案就是:你不認識的人。

總有一些你不認識的人,知道你想知道的東西。PaperWeekly 或許可以成為一座橋梁,促使不同背景、不同方向的學者和學術靈感相互碰撞,迸發出更多的可能性。?

PaperWeekly 鼓勵高校實驗室或個人,在我們的平臺上分享各類優質內容,可以是最新論文解讀,也可以是學術熱點剖析、科研心得或競賽經驗講解等。我們的目的只有一個,讓知識真正流動起來。

📝?稿件基本要求:

? 文章確系個人原創作品,未曾在公開渠道發表,如為其他平臺已發表或待發表的文章,請明確標注?

? 稿件建議以?markdown?格式撰寫,文中配圖以附件形式發送,要求圖片清晰,無版權問題

? PaperWeekly 尊重原作者署名權,并將為每篇被采納的原創首發稿件,提供業內具有競爭力稿酬,具體依據文章閱讀量和文章質量階梯制結算

📬?投稿通道:

? 投稿郵箱:hr@paperweekly.site?

? 來稿請備注即時聯系方式(微信),以便我們在稿件選用的第一時間聯系作者

? 您也可以直接添加小編微信(pwbot02)快速投稿,備注:姓名-投稿

△長按添加PaperWeekly小編

🔍

現在,在「知乎」也能找到我們了

進入知乎首頁搜索「PaperWeekly」

點擊「關注」訂閱我們的專欄吧

·

·

·

)

![[Java]Swing版坦克大戰小游戲項目開發(1)——new出一個窗口](http://pic.xiahunao.cn/[Java]Swing版坦克大戰小游戲項目開發(1)——new出一個窗口)