當前,在人工智能領域,大模型在豐富人工智能應用場景中扮演著重要的角色,經過不斷的探索,大模型進入到落地的階段。而大模型在落地過程中面臨兩大關鍵難題:對龐大計算資源的需求和對數據隱私與安全的考量。為應對這些挑戰,在邊緣側私有化部署大模型成為了一個有效的解決方案。

將大模型部署到邊緣側,不僅能夠減少延遲和帶寬消耗,使得大模型能夠在邊緣節點快速進行推理和應用;還能增強數據隱私保護,這對于維護企業的數據安全至關重要。

▎邊緣計算盒子

基于BM1684X推出的高性能邊緣計算盒子,INT8算力高達32Tops,配置了16GB大內存,支持適配Llama2-7B/ChatGLM3-6B/Qwen-7B和SAM/StableDiffusion等大模型,是業內少數能同時兼容國內外深度學習框架,并且能夠流暢運行大語言模型推理的邊緣計算設備之一。

▎大模型推理加速卡

算力可達64 TOPS@INT8和72 TOPS@INT8,顯存配置32GB和48GB,支持多芯分布式推理及支持大語言/提示型/圖像生成模型等大模型推理;這兩款云邊大模型推理加速卡均可應用于邊緣大語言、文生圖等通用大模型、垂直行業私有模型的推理應用。

迭代500次

python3 run.py --model_path ../models/BM1684X --stage singlize --prompt "A parrot resting on a branch" --neg_prompt "worst quality" --num_inference_steps 500 --dev_id 0

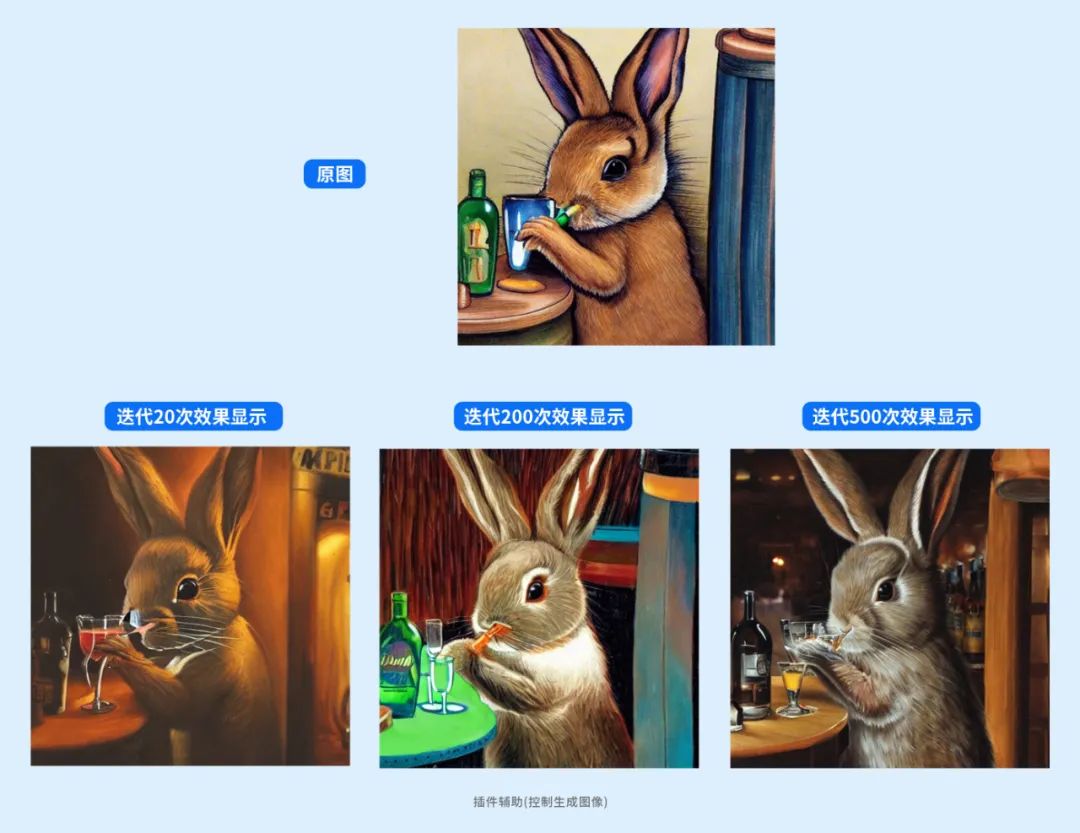

②?Controlnet插件輔助控制 生成圖像

一只小兔子晚上在酒吧喝酒 :迭代次數,20次

python3 run.py --model_path ../models/BM1684X --stage multilize --controlnet_name scribble_controlnet_fp16.bmodel --processor_name scribble_processor_fp16.bmodel --controlnet_img ../pics/generated_img.jpg --prompt "a rabbit drinking at the bar at night" --neg_prompt "worst quality" --num_inference_steps 100 --dev_id 0一只小兔子晚上在酒吧喝酒 :迭代次數,200次

python3 run.py --model_path ../models/BM1684X --stage multilize --controlnet_name scribble_controlnet_fp16.bmodel --processor_name scribble_processor_fp16.bmodel --controlnet_img ../pics/generated_img.jpg --prompt "a rabbit drinking at the bar at night" --neg_prompt "worst quality" --num_inference_steps 200 --dev_id 0

項目jdk版本不兼容,修改Java編譯器配置)

)