LLaMA Factory 是一款開源低代碼大模型微調框架,集成了業界最廣泛使用的微調技術,支持通過 Web UI 界面零代碼微調大模型,目前已經成為開源社區內最受歡迎的微調框架之一。但是在矩池云上如何使用LLaMA-Factory多機多卡訓練模型呢?接下來就讓小編給大家介紹如何在矩池云中使用LLaMA- Factory進行多機多卡訓練吧😊

GitHub地址:https://github.com/hiyouga/LLaMA-Factory

一、租用機器

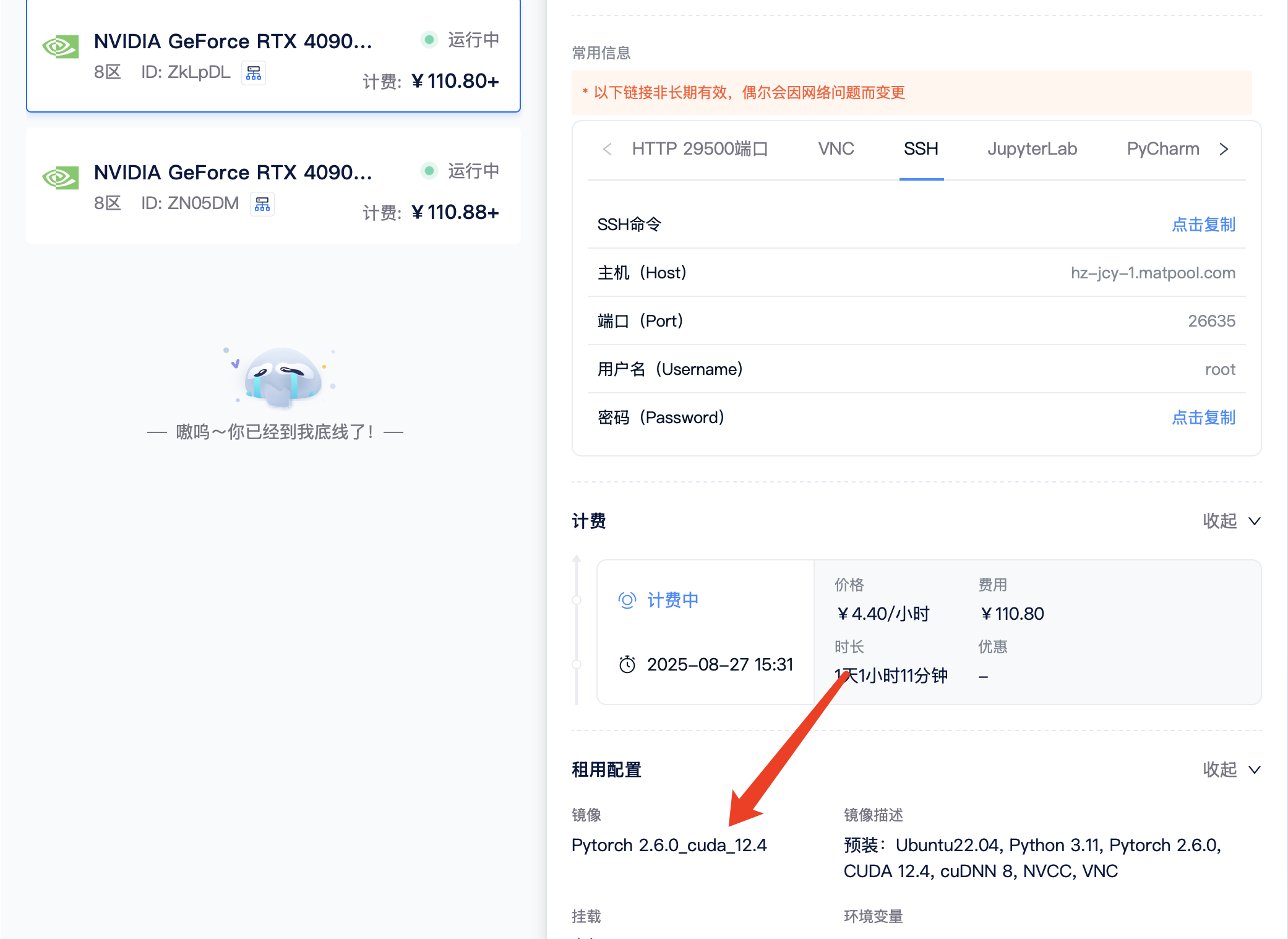

先租用兩臺兩卡的機器,小編使用的的機器類型是8區4090,機器驅動為550,鏡像使用的是Pytorch 2.6.0_cuda_12.4,小編建議驅動可以選擇高一點。

二、加入集群

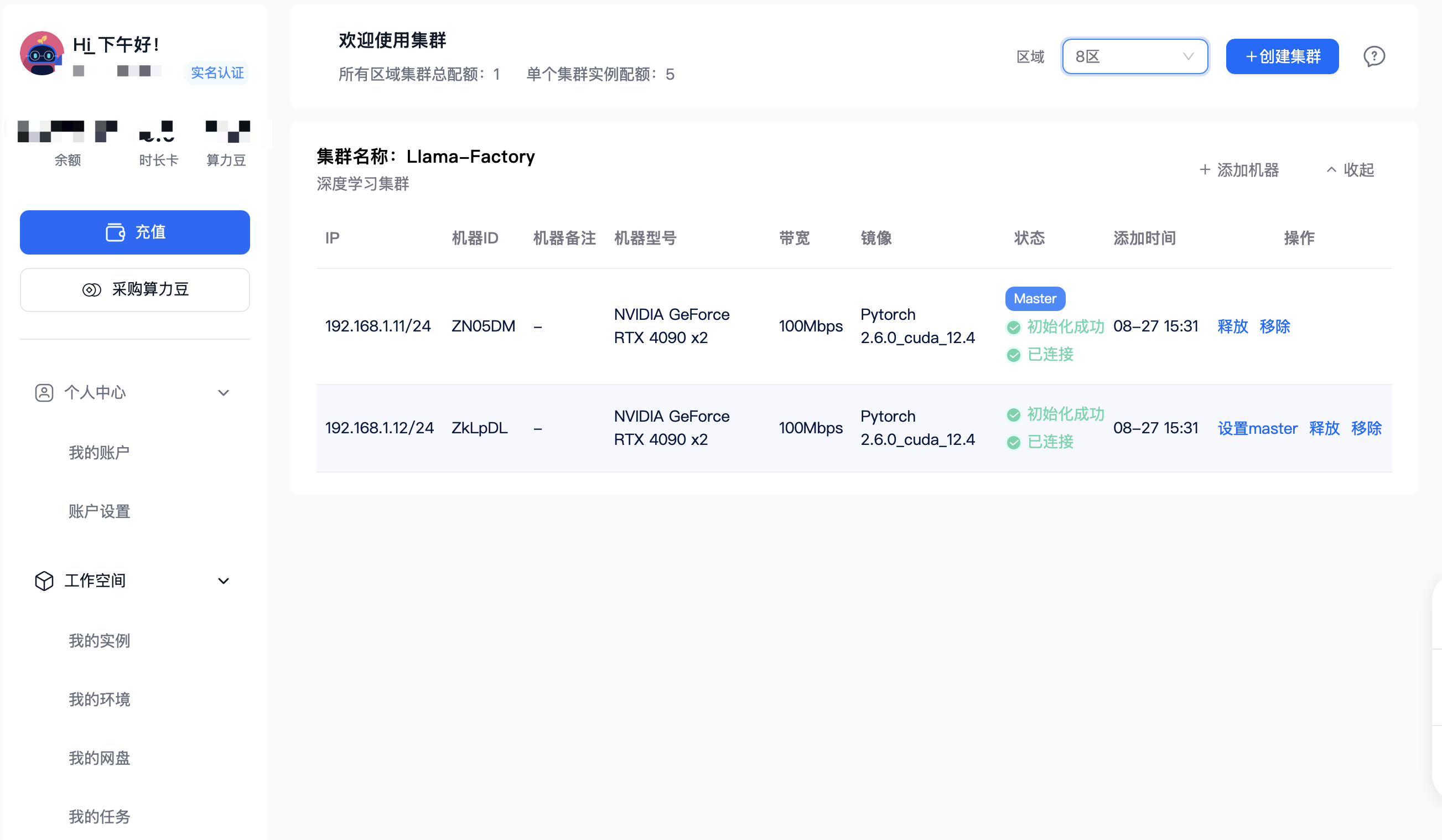

首先需要創建一個集群,在矩池云主頁左下角點擊我的集群,然后在右上角選擇區域,最后點擊創建集群

接下來就是把所租用的機器加入集群中,并設置好master機器

三、安裝LLaMA-Factory

我們需要在主從機器上都安裝LLaMAFactory

git clone https://github.com/hiyouga/LLaMA-Factory.git

cd LLaMA-Factory

pip install -e ".[torch,metrics]"

需要注意的是,第三部必須執行,才能使用llamafactory-cli命令執行訓練。否則會提示報錯

四、訓練測試

執行完前面三步操作之后,我們就測試一下是否能正常運行多機多卡訓練

FORCE_TORCHRUN=1 NNODES=2 NODE_RANK=0 MASTER_ADDR=192.168.1.11 MASTER_PORT=29500 \

llamafactory-cli train examples/train_lora/gpt_lora_sft.yaml #在主服務器上運行FORCE_TORCHRUN=1 NNODES=2 NODE_RANK=1 MASTER_ADDR=192.168.1.11 MASTER_PORT=29500 \

llamafactory-cli train examples/train_lora/gpt_lora_sft.yaml #在第二個服務器上運行,MASTER_ADDR和MASTER_PORT仍寫主服務的ip和端口需要注意的是,模型運行需要下載數據集,除亞太二區外其他區域的機器需要開代理

如需使用WebUI,參考鏈接:

https://editor.csdn.net/md/?articleId=147334646

如遇斷點重訓問題,參考鏈接:

https://blog.csdn.net/xiong_wq/article/details/143189413

:原理、方案與實踐)

![[嵌入式embed][Qt]Qt5.12+Opencv4.x+Cmake4.x_測試Qt編譯的opencv4.x的庫](http://pic.xiahunao.cn/[嵌入式embed][Qt]Qt5.12+Opencv4.x+Cmake4.x_測試Qt編譯的opencv4.x的庫)