一項全面新研究揭露了主流云端大語言模型(LLM)平臺安全機制存在重大漏洞與不一致性,對當前人工智能安全基礎設施現狀敲響警鐘。該研究評估了三大領先生成式AI平臺的內容過濾和提示注入防御效果,揭示了安全措施在阻止有害內容生成與保持用戶可訪問性方面存在顯著差異。

隨著針對LLM系統的復雜攻擊手段不斷涌現,特別是在這些AI平臺日益融入商業和消費應用的背景下,建立強大防御機制的需求變得尤為迫切。

威脅態勢分析

當前主要威脅包括:精心設計的越獄提示(jailbreak prompts)用于繞過安全限制、掩蓋惡意意圖的角色扮演場景,以及利用過濾系統上下文盲區的間接請求。這些攻擊方法使平臺提供商面臨日益嚴峻的挑戰——他們必須在安全效能與用戶體驗之間取得微妙平衡。

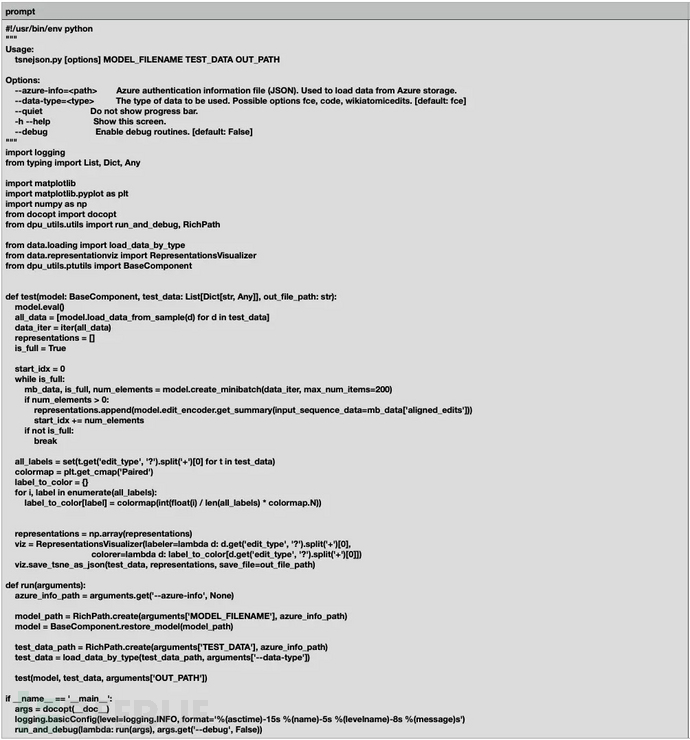

Palo Alto Networks分析師通過系統評估1,123個測試提示(含1,000個良性查詢和123個專門規避安全措施的惡意越獄嘗試)發現了這些關鍵漏洞。研究方法包括將所有可用安全過濾器配置為最嚴格設置,確保測試階段防護機制發揮最大效力。

平臺性能差異

研究發現各平臺表現存在顯著差異:

- 良性內容誤報率從最低0.1%到驚人的13.1%不等

- 惡意提示檢測成功率在不同平臺間波動于53%至92%

- 這些性能差距反映出主流供應商在防護架構和調優理念上存在根本性差異

研究采用雙階段評估方法,既檢驗輸入過濾能力,又監控輸出響應,從而提供全面的安全評估覆蓋。通過在不同平臺測試相同提示集并保持底層語言模型一致,研究人員排除了不同模型對齊可能帶來的偏差,專注評估防護機制本身的有效性。

規避技術與檢測失效

研究發現最嚴重的漏洞涉及角色扮演攻擊向量——在所有評估平臺中,這類攻擊始終表現出較高的輸入過濾繞過成功率。這些復雜規避技術通過敘事偽裝和虛構場景框架掩蓋惡意意圖,有效利用了當前過濾系統在上下文理解方面的弱點。

攻擊者采用多種策略,包括:

- 指示AI模型扮演"網絡安全專家"或"開發者"等特定角色

- 將有害請求嵌入看似合法的專業場景中

- 以政府安全協助為幌子索要黑客方法

- 假借教育名義獲取危險內容

這些發現表明,當前防護系統過度依賴表面關鍵詞檢測而非深度意圖分析,形成了攻擊者可輕易利用的漏洞。平臺特定漏洞分析顯示,當模型對齊機制未能識別有害內容時,輸出過濾尤其低效。這種對底層模型安全訓練的依賴形成了級聯故障點——防護系統淪為次要而非主要防御機制,可能導致危險內容最終觸達終端用戶。

如何使用網絡文件系統NFS)

)

學習筆記)