文章目錄

- 前言

- 電腦配置:

- 安裝的Deepseek版本:

- 使用的UI框架:

- 體驗效果展示:

- 本地部署體驗總結

- 部署過程

- Ollama部署

- 拉取模型

- 運行模型

- Openwebui部署

- 運行Ollama服務

- 在Openwebui中配置ollama的服務

- 后話

前言

deepseek最近火的一塌糊涂,誰還不知道deepseek感覺就已經是上古時期的人了,趁著有時間我趕緊研究了一下本地部署,deepseek有很多蒸餾版的模型,對硬件要求不是很高,這就讓本地部署變成了可能,于是我迫不及待的在我的mac電腦上試了一下,嘿,還挺絲滑。

現在將部署的過程分享如下:

電腦配置:

芯片 Apple M1 pro

內存 16G

macOs Sequoia 版本15.3.1

安裝的Deepseek版本:

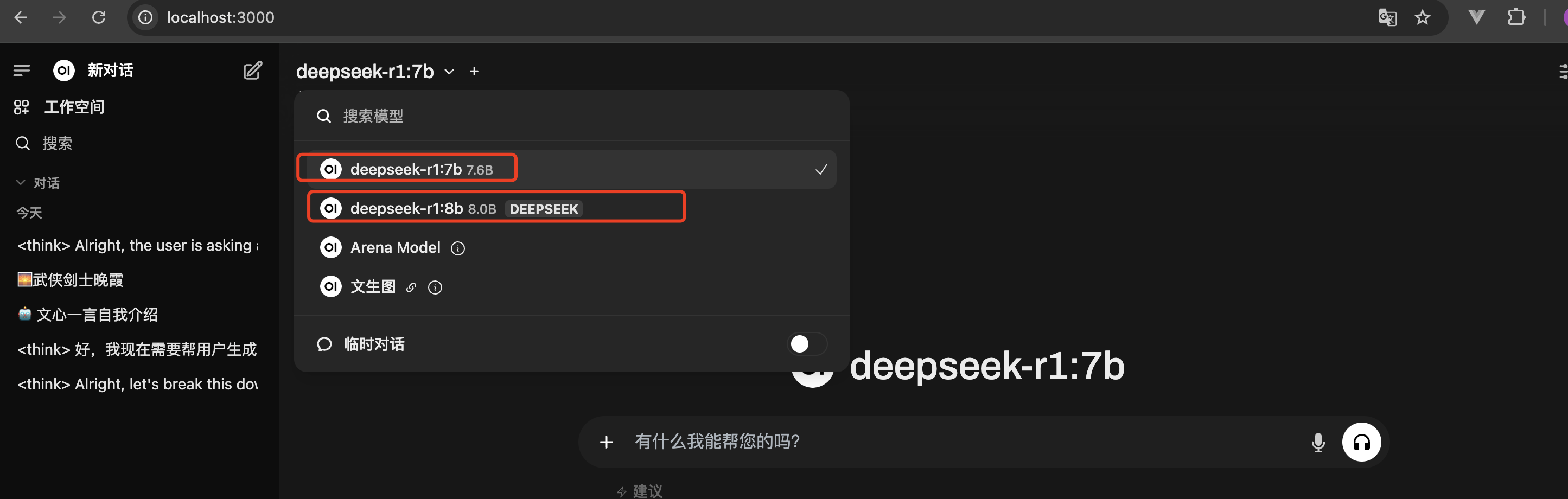

Deepseek-r1:8b(我之前裝的是8b版本)

Deepseek-r1:7b(為了演示截圖,我再裝一個7b版本)

使用的UI框架:

Openwebui(基于docker部署的)

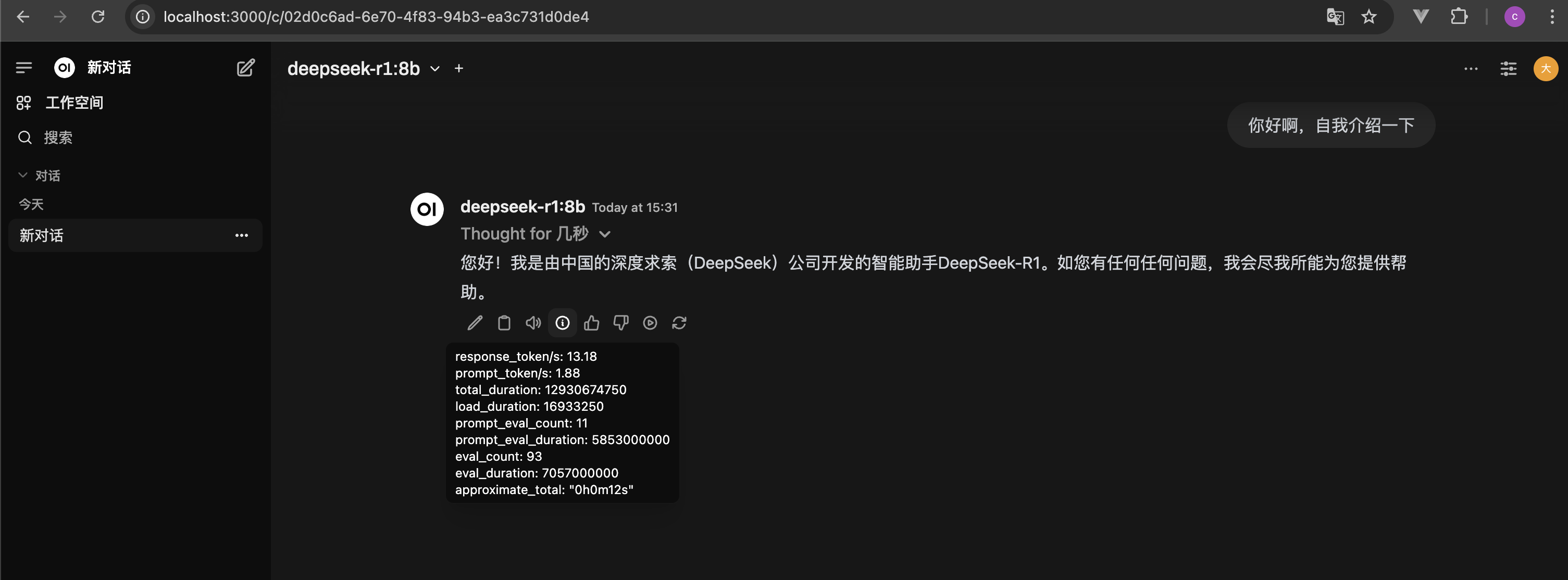

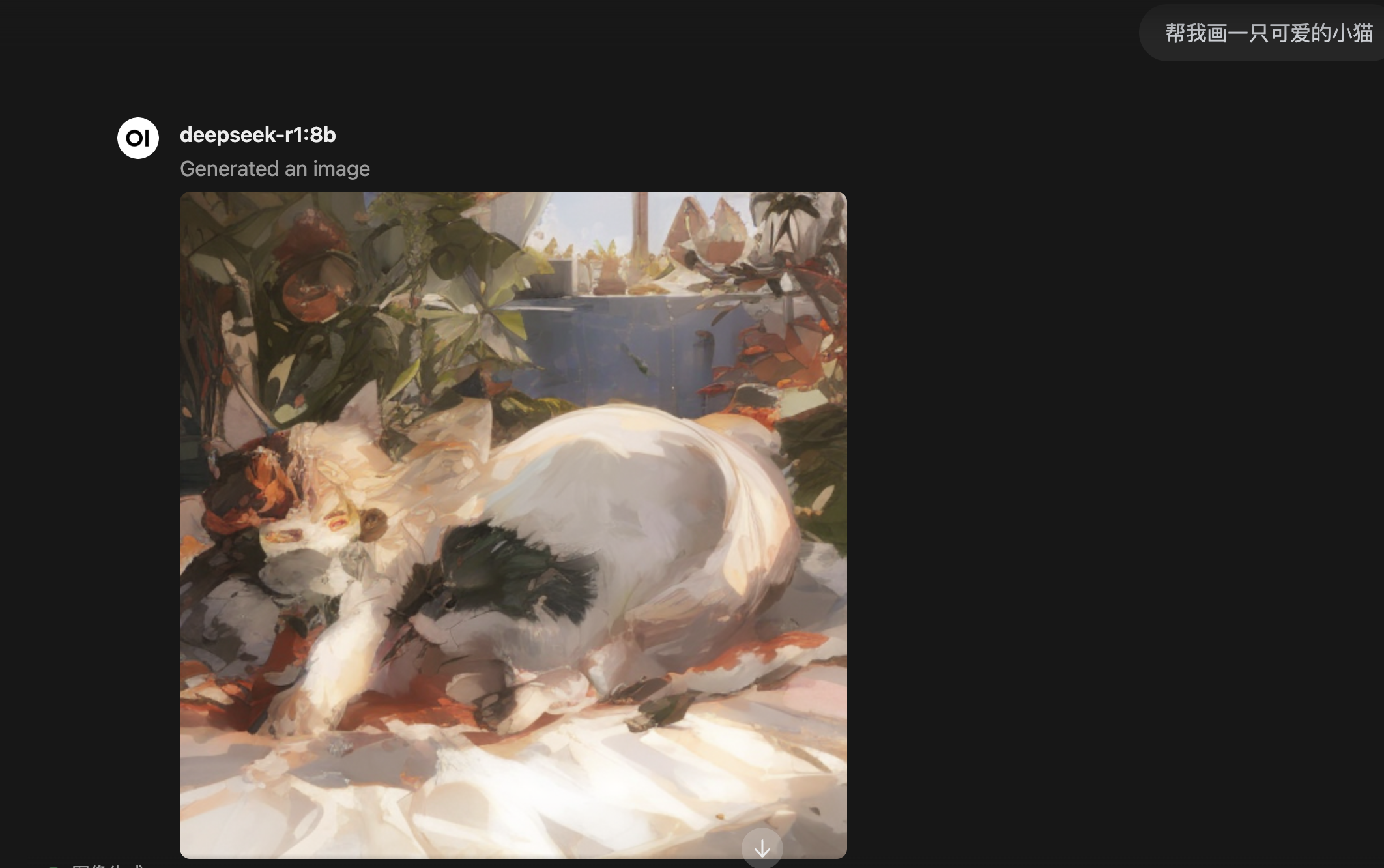

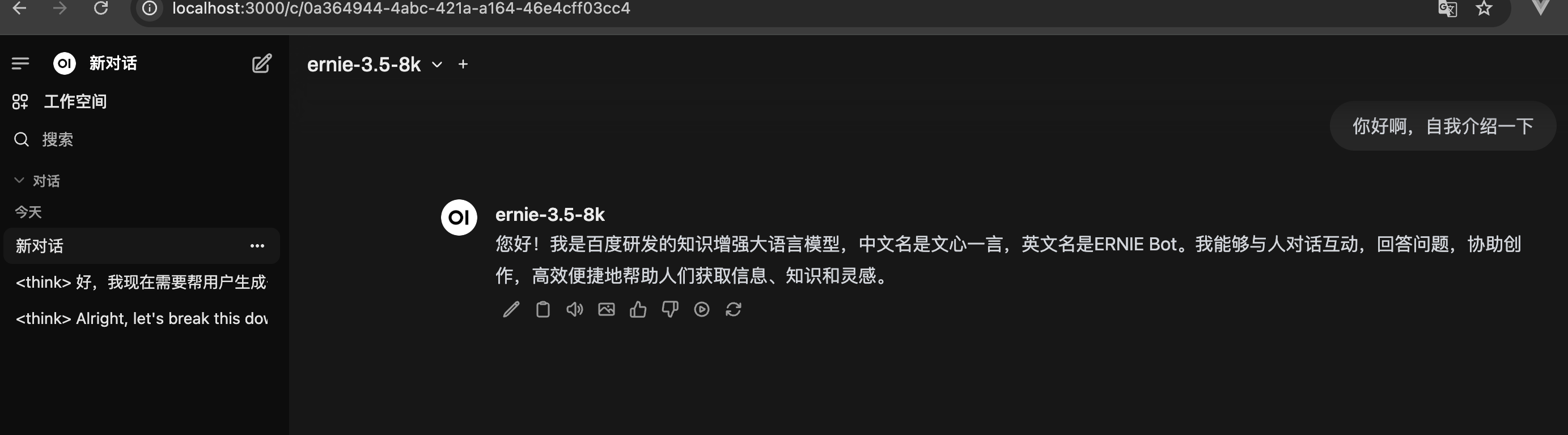

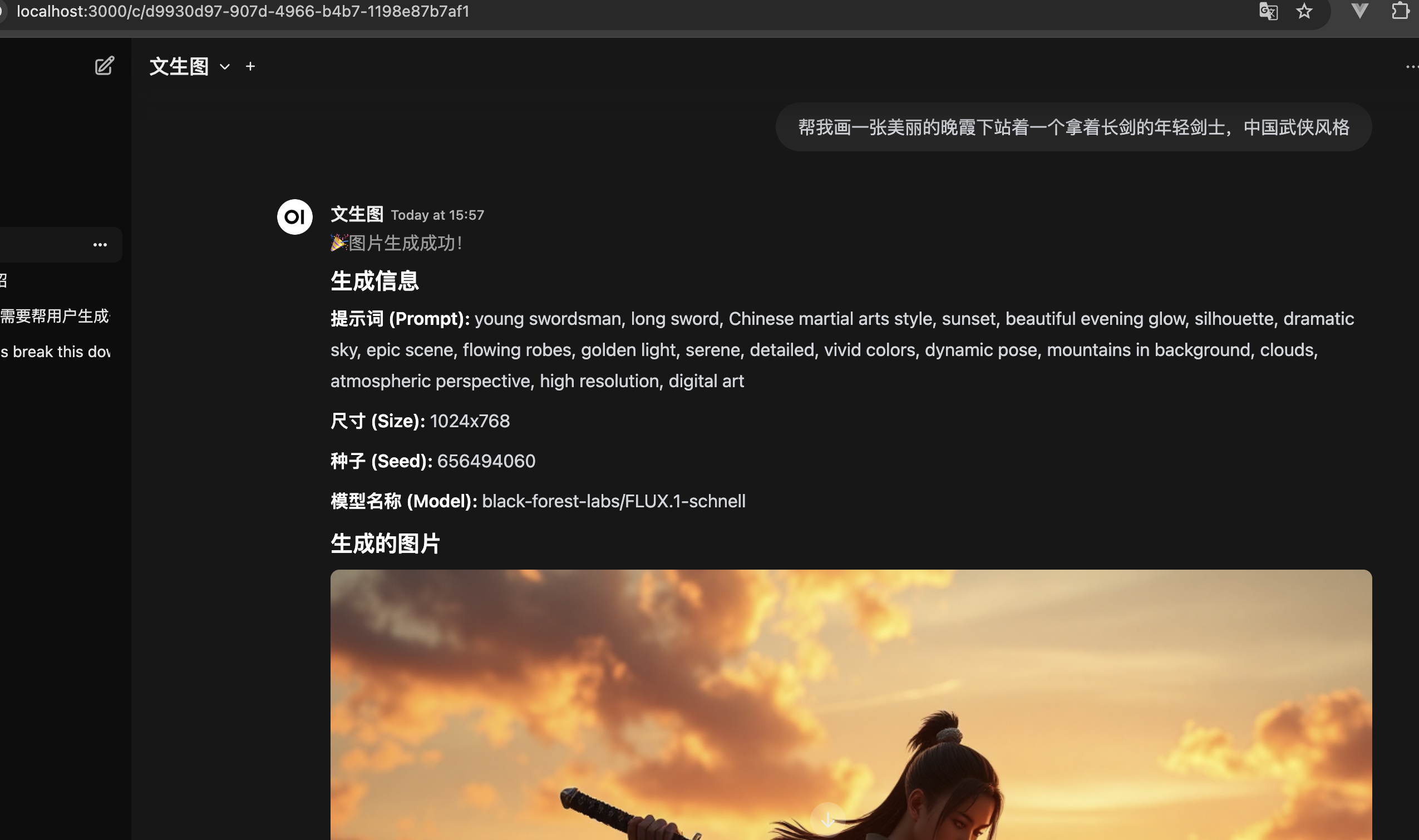

體驗效果展示:

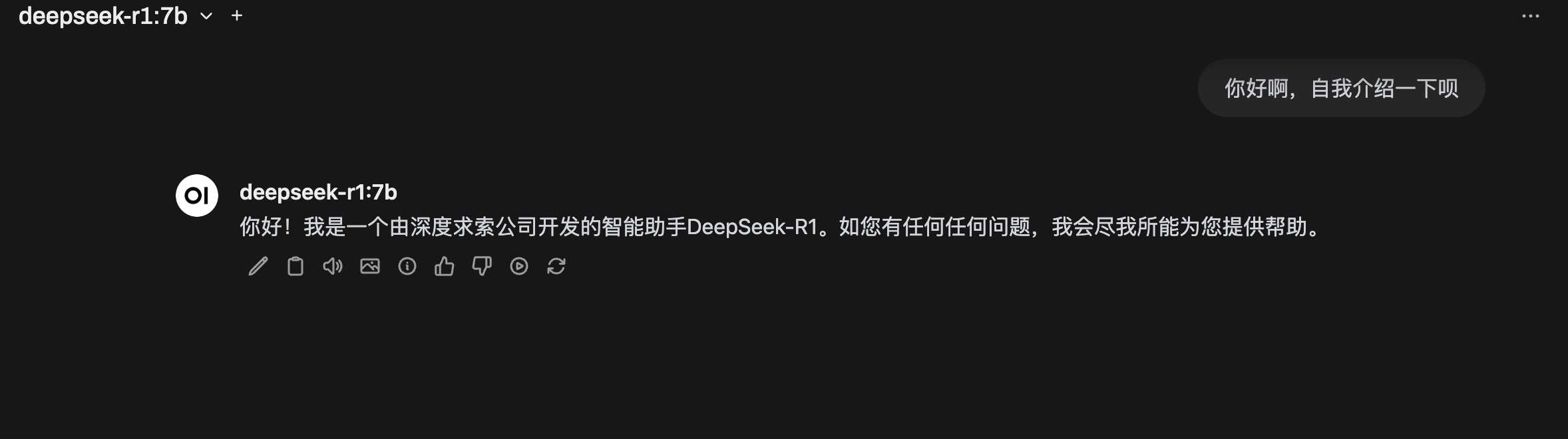

整體來說部署到本地是可以玩的,響應的速度也在可以接受的范圍內,配合上openwebui,還可以有文生圖,聯網搜索,調用API接口等玩法。

本地部署體驗總結

由于機器配置有限,我僅僅部署了7b的模型,智商非常有限,所以僅限于玩玩了,如果有比較土豪的大佬,部署更大參數的模型,那部署在本地,作為生產力工具也是可以的。

但是真正的處理工作啥的,我建議還是老實用線上版本,畢竟線上是滿血版,不是咱們這些小破電腦能跑起來的。

deepseek線上版:https://chat.deepseek.com/

如果老是顯示服務器繁忙,也可以找平替,有很多大廠都已經接入了deepseek,響應速度都還非常不錯,比如:

百度搜索:https://chat.baidu.com/

騰訊元寶:https://yuanbao.tencent.com/(默認是混元大模型,需要自己手動切換成deepseek-r1)

秘塔AI搜索:https://metaso.cn/

360納米AI搜索:https://www.n.cn/

天工AI:https://www.tiangong.cn/

部署過程

廢話不多說,直接來跟著我一步步進行部署:

Ollama部署

直接上官網:https://ollama.com/download,然后下載自己電腦適合的版本,安裝即可。

下載完成后,解壓,然后安裝:

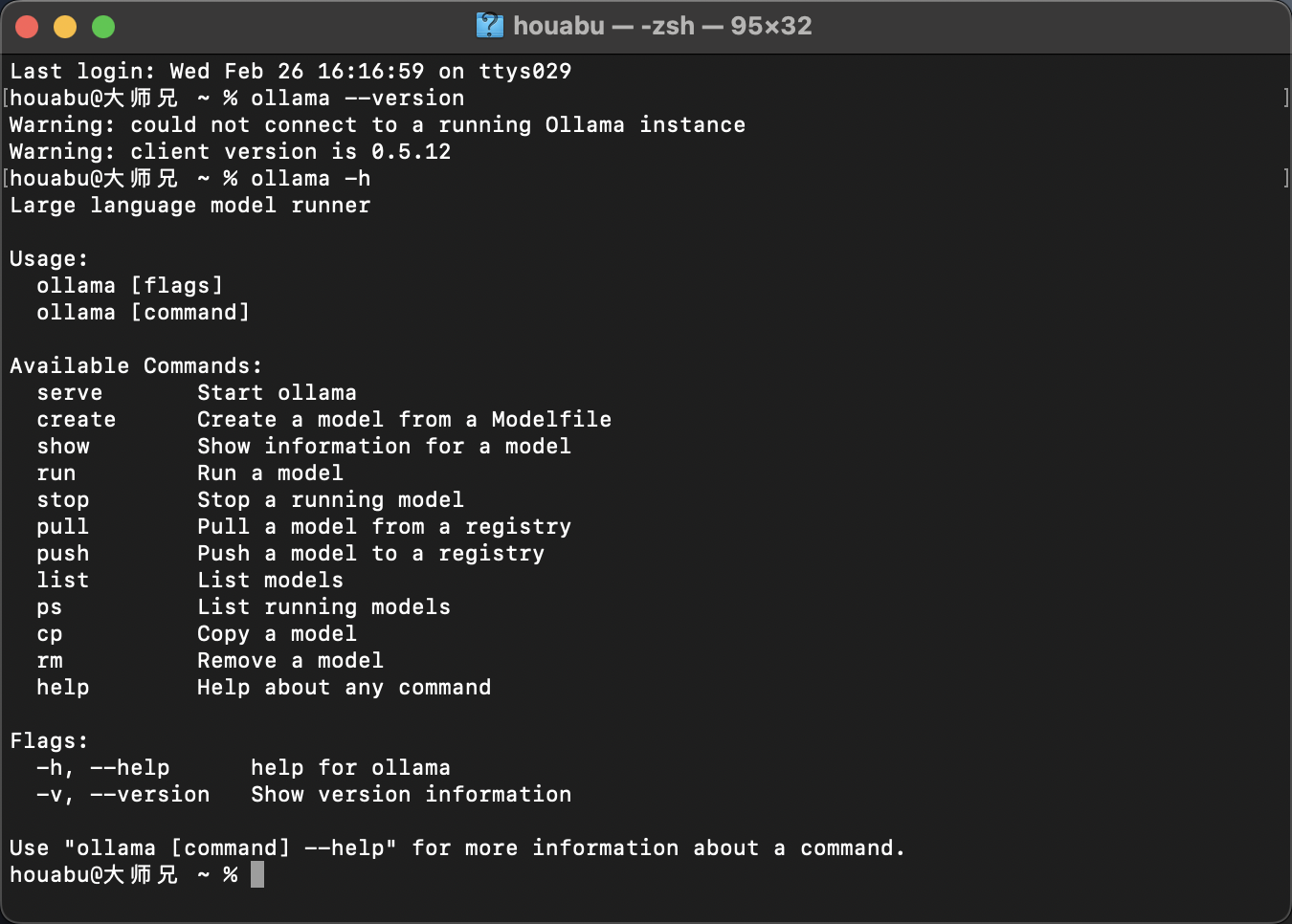

安裝成功后,即可在終端進行調用了。

# 查看 Ollama 版本

ollama --version

# Ollama 命令幫助

ollama -h

如此,ollama的安裝就搞定了。

接下來我們就來拉取deepseek的模型

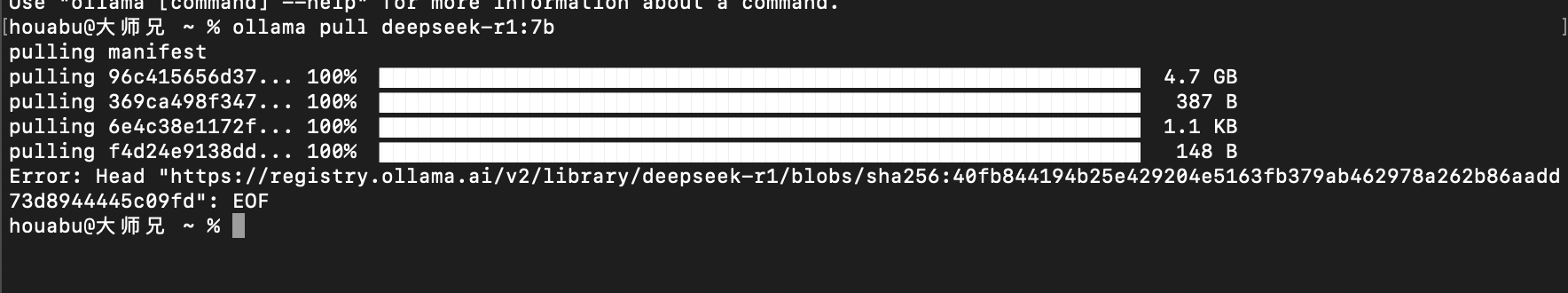

拉取模型

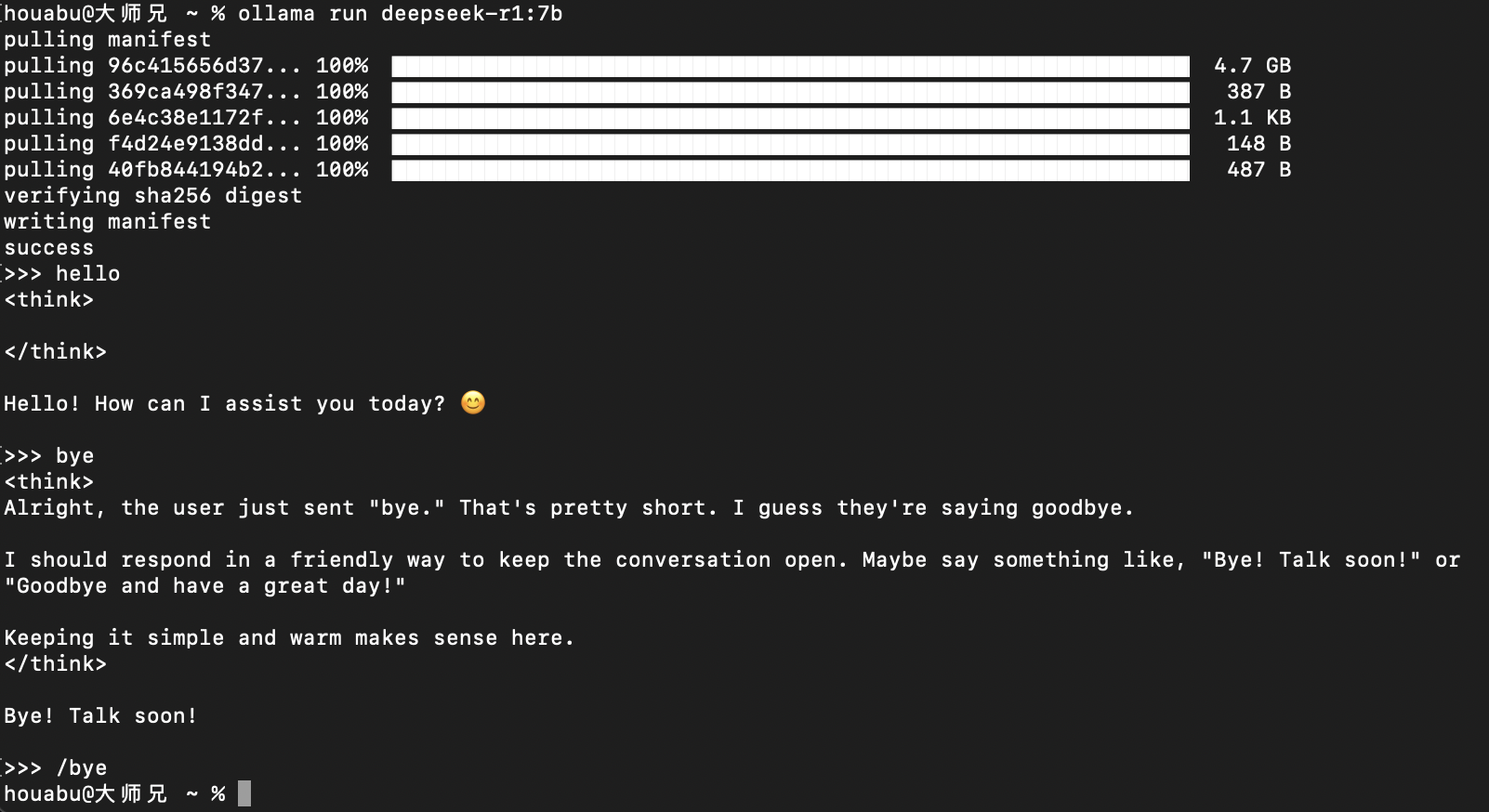

# 拉取模型(我這里用的是先拉取,再運行)

ollama pull deepseek-r1:7b

運行模型

等待拉取結束,運行模型

#運行 deepseek-r1:7b模型

ollama run deepseek-r1:7b

可以看到已經模型已經正常運行了,可以正常進行對話了。輸入 /bye 可以結束在終端的對話。

此時已經成功將deepseek-r1:7b模型在本地跑起來了,但是這和別人用的都不太一樣,而且在終端對話始終不是那么的方便,那么怎么辦呢?

Openwebui部署

接下來就祭出 Openwebui,相對可玩性比較高的一個大語言模型的UI框架,我們來用ollama作為服務端,Openwebui作為前端,部署起來進行訪問。

這里我只介紹使用docker進行部署,因為比較方便,其他方式有興趣的朋友自己研究即可。

什么?電腦沒有安裝docker?mac電腦安裝docker可以說是有手就會,我就不過多介紹了,實在不會的,參考這個教程:https://www.runoob.com/docker/macos-docker-install.html

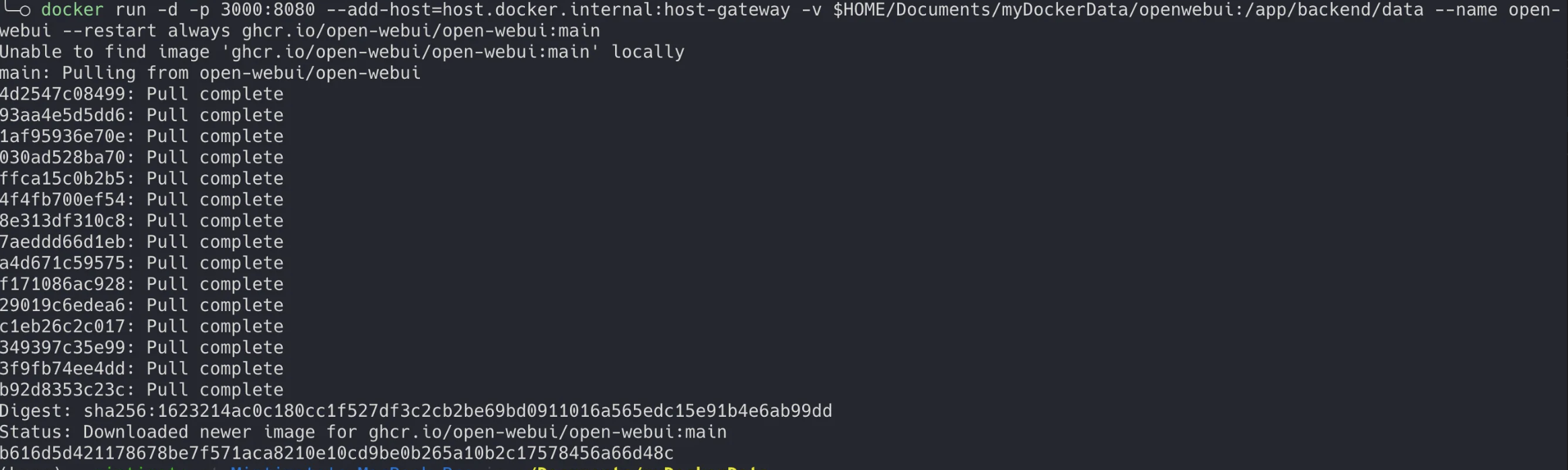

docker安裝成功后,我們來使用docker安裝Openwebui

# 拉取鏡像并映射端口運行

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v $HOME/Documents/myDockerData/openwebui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

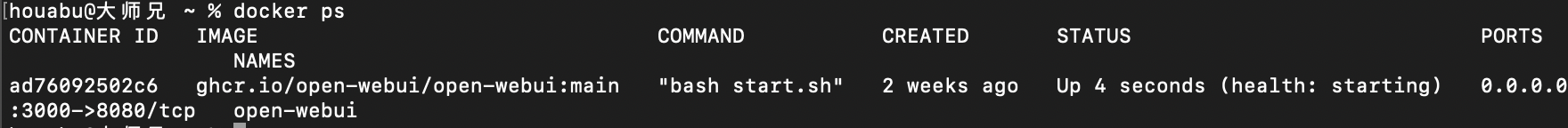

可以看到 已經拉取鏡像成功,并且端口映射好,而且啟動起來了

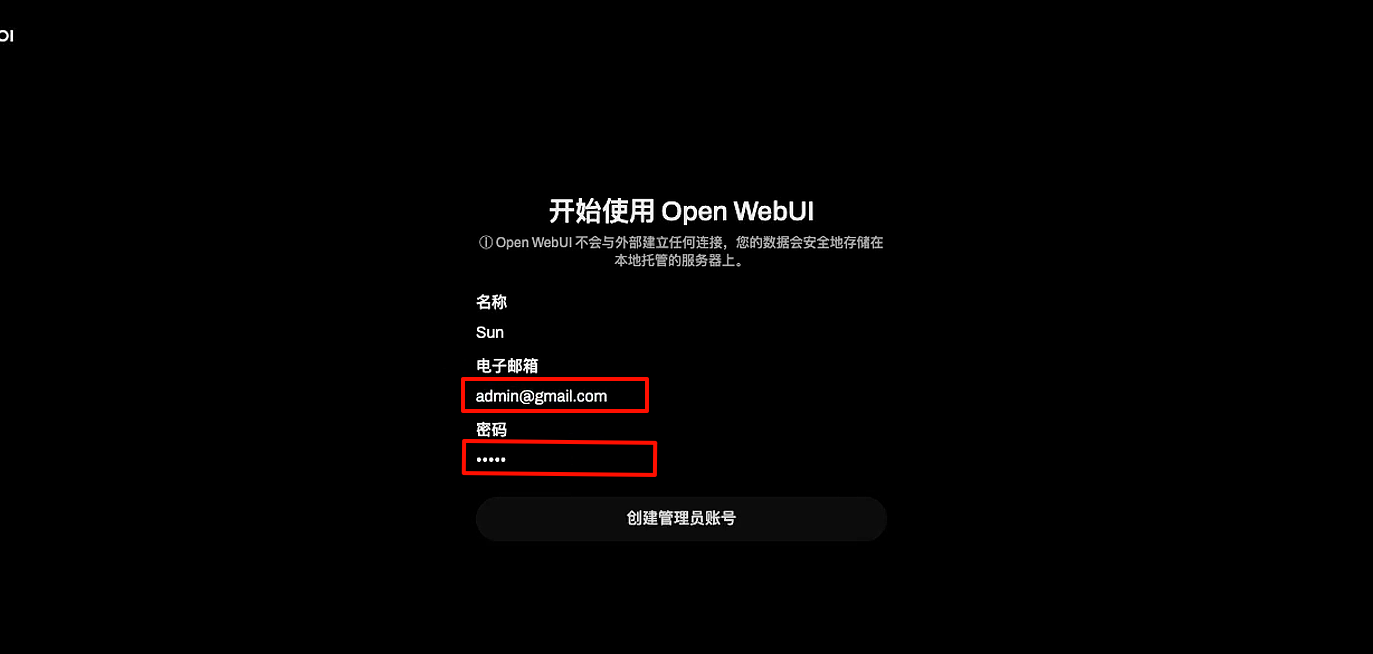

此時訪問 http://localhost:3000/ 就可以進入到Openwebui的界面了。

首次進入可能需要稍微等待幾分鐘,然后就會出來界面,

點擊開始使用,然后進行注冊,登錄即可使用。首次注冊的賬號即為管理員賬號。

運行Ollama服務

我們需要使用Ollama作為后端,提供API接口的服務,所以需要將這個服務啟動起來。

#啟動ollama服務,默認監聽端口是11434

ollama serve

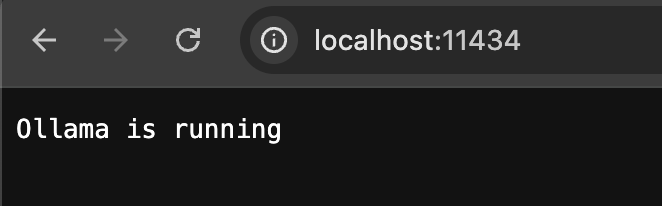

訪問http://localhost:11434/可以看到服務是否啟動成功:

顯示Ollama is running 說明服務已經成功啟動了。

在Openwebui中配置ollama的服務

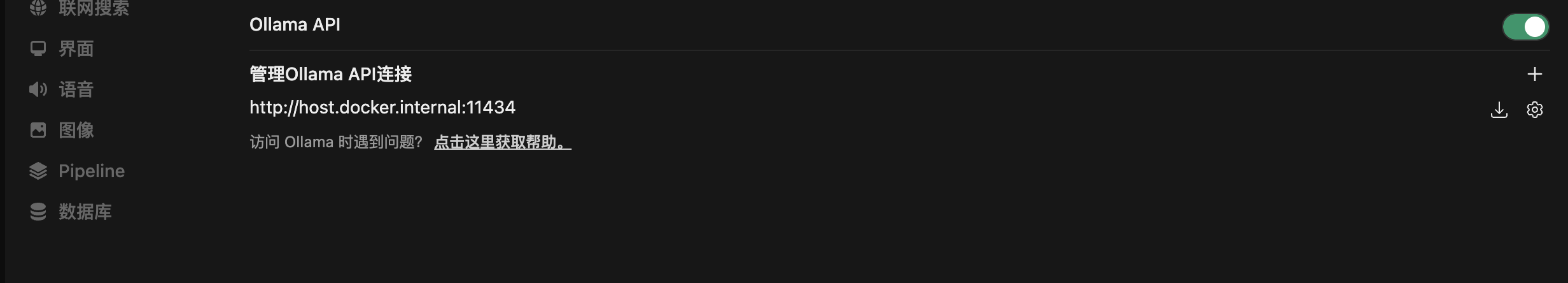

在個人頭像-設置-管理員面板-外部連接頁面,打開Ollama API的開關,填寫API的地址:http://host.docker.internal:11434

注意:由于此處是在docker中進行運行的Openwebui,但是ollama是在本地直接運行的,所以配置到這里必須這樣配置才可以生效,如果配置為localhost:3000 是不起作用的。

配置完成之后,就可以測試聊天了。

選擇相應的模型,然后直接開始對話即可。

至此,大功告成!你已經可以在本地運行大模型,并且可以使用網頁進行對話了。

后話

至于文章開始展示的集成本地文生圖模型、調用api文生圖功能,或者調用api接口chat,以及調用聯網搜索功能的這些分支,還需要再逐一進行講解。

如果你有以上某方面的需要,請在評論區進行留言,我將視情況再做后續的文章更新。

感謝各位大佬的觀看~ 下期再見~

)

)

——203移除鏈表元素)