?

?

使用 DALLE-3 模型生成的圖像

目錄

一、說明

二、為什么校準對 LLM 模型至關重要

三、校準 LLM 概率的挑戰

四、LLM 的高級校準方法

4.1 語言置信度

4.2 增強語言自信的先進技術

4.3 基于自一致性的置信度

4.4 基于 Logit 的方法

五、代理模型或微調方法

5.1 使用代理模型進行置信度評估

5.2 識別不確定性:R-tuning

5.3 LITCAB:小改變,大影響

5.4 ASPIRE:更智能的模型響應

六、結論

一、說明

????????語言模型,尤其是大型語言模型 (LLM),憑借其理解和生成類人語言的能力,徹底改變了人工智能領域。這些模型不僅能夠在零樣本設置下或通過定制提示執行各種任務,而且它們的靈活性和多樣性也使它們在多個領域中非常有用。

????????然而,盡管它們很有效,但一個經常面臨挑戰的關鍵方面是這些模型的校準——確保它們提供的關于各種輸出的概率真實反映這些輸出正確的真實可能性。

????????本文探討了 LLM 校準的必要性,確定了圍繞其概率評估的核心問題,并探討了實現更好模型校準的當代方法。

二、為什么校準對 LLM 模型至關重要

????????LLM 的本質是圍繞處理和生成基于語言的輸出,這些輸出不僅準確,而且被分配了正確的置信水平。校準(或使模型的置信度與其準確性保持一致的過程)是必不可少的,因為:

????????-?值得信賴的 AI 決策:正確校準的置信度分數使用戶能夠信任和依賴 AI 做出的決策,了解模型何時可能正確或不正確。

????????-?風險管理:在醫療診斷或自動駕駛等安全關鍵應用中,過度自信但不正確的預測可能會導致災難性后果。

????????-?模型調試和改進:?校準可以幫助開發人員了解模型的弱點并相應地對其進行優化。

三、校準 LLM 概率的挑戰

????????大型語言模型通常面臨幾個影響其概率校準的障礙:

????????-?封閉模型約束:許多 LLM 以黑匣子的形式運行,直接訪問對數概率的訪問受到限制,使理解和調整置信度分數的過程變得復雜。

????????-?訓練中的錯位:使用人類反饋強化學習 (RLHF) 等技術改進的模型可能會變得天真地校準錯誤。根據論文[1],使用最廣泛的LLMs是通過人類反饋的強化學習(RLHF-LLMs)進行微調的。一些研究表明,RLHF-LLMs產生的條件概率校準非常差。研究結果表明,RLHF-LLMs可能會優先考慮嚴格遵守用戶偏好,而不是產生校準良好的預測,這可能導致校準不良。這顯示了一個關鍵挑戰,即使用 RLHF 訓練的模型可能缺乏準確可靠輸出所需的必要概率校準。

????????-?特定任務的校準需求:?LLM 的通用訓練通常不會針對特定任務或領域進行調整,需要額外的校準以使其與特定需求或應用程序保持一致。

四、LLM 的高級校準方法

為了應對校準挑戰,我們可以嘗試多種技術,如下所述:

?

?

描述各種校準技術

4.1 語言置信度

????????“語言置信度”是指語言模型(LLM)不僅提供答案,而且還明確地評估其響應的置信度的技術。這種方法涉及使用某些方法來獲得對模型對其答案的置信度的更可靠評估。

????????基本實現

????????在最簡單的形式中,口頭信心涉及向 LLM 提出問題和任何相關上下文,然后明確要求提供信心分數。這種直接方法為更復雜的技術奠定了基礎。

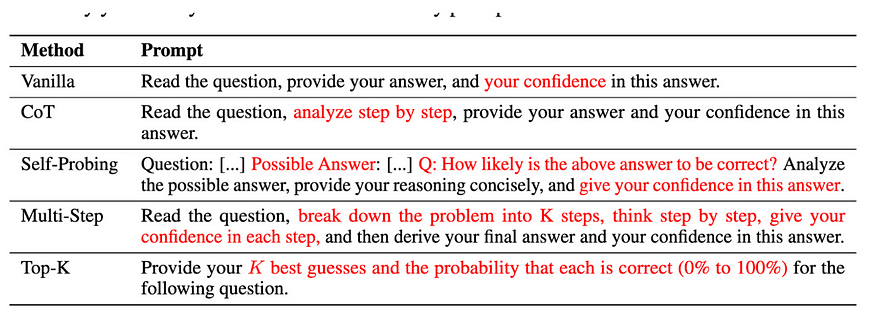

4.2 增強語言自信的先進技術

- 思維鏈 (CoT) 提示:?思維鏈提示涉及在模型提供答案之前從模型中引出分步推理過程。該方法不僅增強了模型響應的清晰度和豐富性,還可以通過觀察推理步驟中的邏輯一致性來提高置信水平的估計。

- 多步驟置信度激發:該技術通過在推理或解決問題過程的各個步驟捕獲置信度分數來優化置信度測量。最終置信水平是所有個人置信度分數的乘積,提供了確定性的復合度量。

- Top-K 響應和置信度評分:?該模型生成多個可能的答案(Top-K 響應),而不是單個響應,每個答案都伴隨著一個單獨的置信度分數。然后,選擇置信度得分最高的答案作為最終答案。這種方法反映了涉及評估多個假設的決策過程。

- 多種提示技術:利用各種提示可以更準確地校準置信度估計。提示的多樣性可能源于不同的措辭、上下文或概念角度,使模型的評估對有偏見或信息不足的響應更加穩健。

- 數值概率與語言表達式:在某些情況下,模型通過與正確可能性直接相關的數值概率來表達其置信度。相反,也可以使用“極有可能”或“可能不會”等語言表達方式。

- 使用多個假設進行提示:?最初,模型會生成多個沒有置信度評級的答案候選者。在隨后的交互中,他們評估每個答案的正確概率。研究表明,以這種方式評估多個假設可以顯著改善校準。

?

?

參考論文

有效表達置信度的能力因模型而異,在不同的模型架構和世代中觀察到一些差異。

4.3 基于自一致性的置信度

????????基于自一致性的置信度方法是一種復雜的方法,通過生成對同一查詢的多個響應并分析這些響應之間的一致性來評估語言模型的置信度。該技術基于這樣一種想法,即不同條件下的高一致性表明對響應準確性的高度置信度。

????????生成多個響應

????????為了從模型中獲得一系列答案,采用了幾種策略:

????????自我隨機化:?這涉及在不同的設置下多次輸入相同的問題。調整“溫度”參數是這里的常用方法,它通過改變輸出的預測性或隨機性來操縱模型響應的多樣性。

????????提示擾動:?通過釋義改變問題的措辭,以喚起不同角度的回答。這通過檢查模型是否在措辭不同但概念相似的提示中保持一致來測試模型的穩健性。

????????誤導性提示:在提示中引入故意錯誤或誤導性提示,以評估模型的穩定性。與人體測試類似,這種方法觀察模型是否像一個自信的人一樣,可以忽略誤導性信息并堅持正確或一致的反應。

????????聚合策略

為了綜合調查結果并分配最終置信度分數,可以考慮不同的聚合策略:

????????一致性測量:?這檢查了模型在不同條件下提供相同答案的一致性,反映了穩定性和可靠性。

????????平均置信度(平均值):計算加權平均值,其中對具有較高一致性和個人置信度得分的答案給予更多權重,從而提供總體置信度的精細度量。

????????配對排名策略:?此策略在使用模型的 Top-K 預測的場景中特別有用,它強調模型預測中的排名信息,有助于評估最可能和最一致的響應。

4.4 基于 Logit 的方法

????????基于 Logit 的校準是提高大型語言模型 (LLM) 概率預測可靠性的關鍵技術。當模型輸出原始分數(如對數)時,它們通常不會直接轉換為真正的概率分布。校準技術調整這些對數以反映更準確的概率,這對于實際應用中的穩健決策至關重要。下面,我們將深入探討用于基于 logit 的校準的一些方法:

????????1. 對代幣(token)的平均置信度

????????為了在語言模型的預測中得出更一致的置信度估計,一種常用的方法是對標記的置信度(對數概率)進行平均。這可以針對所有令牌或選擇性子集完成,具體取決于特定應用程序或數據集的特征。其結果是更平滑、更通用的模型確定性度量,減少了任何單個代幣可變性的影響。

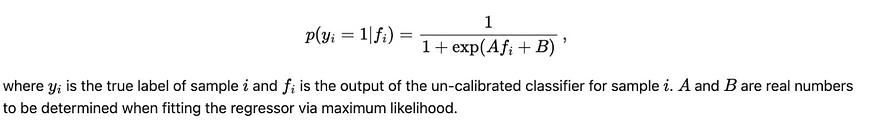

????????2. 普拉特縮放(Sigmoid)

????????Platt 縮放或 S 形標定是一種邏輯回歸模型,應用于原始模型的輸出對數。通過在 logit 上擬合 sigmoid 函數,此方法將它們轉換為校準概率。校準涉及學習兩個參數,通常表示為“A”和“B”,它們縮放和移動對數以更好地與實際觀察到的概率保持一致。這種方法特別有用,因為它對于二元分類任務簡單且有效。

?

?

參考

????????3. 等滲回歸

????????與 Platt 縮放不同,等滲回歸在對數和概率之間不假定任何函數形式。它是一種非參數方法,擬合非遞減函數,使預測概率與目標概率對齊。這種分段常數函數非常靈活,可以更準確地反映某些場景中的真實分布,特別是當對數和概率之間的關系更復雜或非線性時。

?

?

????????4. 溫度標度

????????溫度縮放是一種后處理技術,可在不更改模型預測的情況下調整模型的置信度。它涉及在應用 softmax 函數將它們轉換為概率之前,將 logits 除以稱為“溫度”的常量。最佳溫度通常通過最小化驗證數據集上的交叉熵損失來確定。這種方法很有吸引力,因為它對校準過程產生了極簡主義的影響,保持了原始對數的相對順序。

五、代理模型或微調方法

微調是一種高級校準方法,它使用特定數據和目標調整模型,以便更好地為特定任務做好準備。讓我們探索幾種創新方法,這些方法有助于微調這些模型,以提供更可靠、更精確的置信度分數。

5.1 使用代理模型進行置信度評估

一種引人入勝的方法[2]使用第二種通常更簡單的模型來評估主要模型(如 GPT-4)的答案的可信度:

-?它的作用:例如,LLAMA2 等輔助模型可用于通過提供相同的提示并提取 GPT-4 模型響應的分數來獲取其他模型(如 GPT-4)生成的答案的對數概率

-?令人驚訝的效果:盡管二級模型可能不那么強大,但與單獨使用語言線索相比,這種方法已被證明可以產生更好的結果(通過曲線下面積或 AUC 測量)。

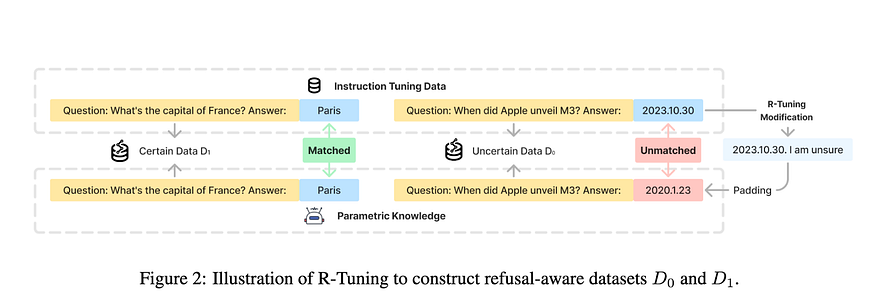

5.2 識別不確定性:R-tuning

R-tuning 在可以說“我不知道”的時候教一個模型——認識到它自己的局限性。微調過程包括以下步驟

-?識別不確定性:?它通過進行預測并將其與地面事實進行比較,發現模型的答案在火車集中可能不穩定或有問題的情況

-?有把握地訓練:然后,它使用標記為“確定”或“不確定”的示例來教授模型,確保它從這些區別中學習。在訓練期間使用“我確定”或“我不確定”等短語來表達置信度,重點是從令牌生成到降低錯誤。

?

?

參考

5.3 LITCAB:小改變,大影響

LITCAB 引入了一個微小而有效的校準層:

-?簡單添加:它在模型末尾添加一個線性層,該層根據輸入文本調整每個響應的預測可能性。

- 高效和有效:?這種微小的調整增強了模型的判斷力,而不會增加太多復雜性——原始模型大小的變化不到 2%。

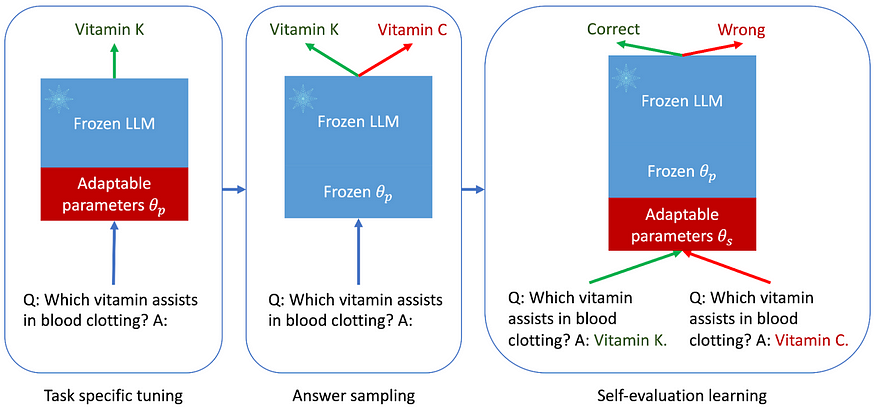

5.4 ASPIRE:更智能的模型響應

為預測分配置信度分數并允許選擇性預測。ASPIRE,包括三個階段:

1.T Ask 特定調優:它使用 PEFT 技術修改特定的自適應參數,同時保持主模型不變,優化特定任務的響應。

2.?答案抽樣:它使用這些調整為每個問題生成多個可能的答案,它使用波束搜索作為解碼算法來生成高似然輸出序列,并使用 Rouge-L 度量來確定生成的輸出序列是否正確基于真實

3.自我評價學習:最后,引入另一組調整,幫助模型自行判斷其反應是對還是錯,提高其自我評價能力。

?

?

????????通過這些方法,語言模型不僅變得更加先進,而且更符合用戶的上下文和期望,從而實現更可靠和更上下文感知的交互。

六、結論

????????校準大型語言模型是一項復雜而重要的工作,可以提高 AI 應用程序的可靠性和安全性。通過使用和組合上面討論的各種創新方法,我們可以顯著改善這些模型在無數上下文中的理解和交互方式,為真正的智能系統鋪平道路,這些系統可以以高度的可信度和正確性做出決策。

)

IP 地址)

)

)

)