目錄

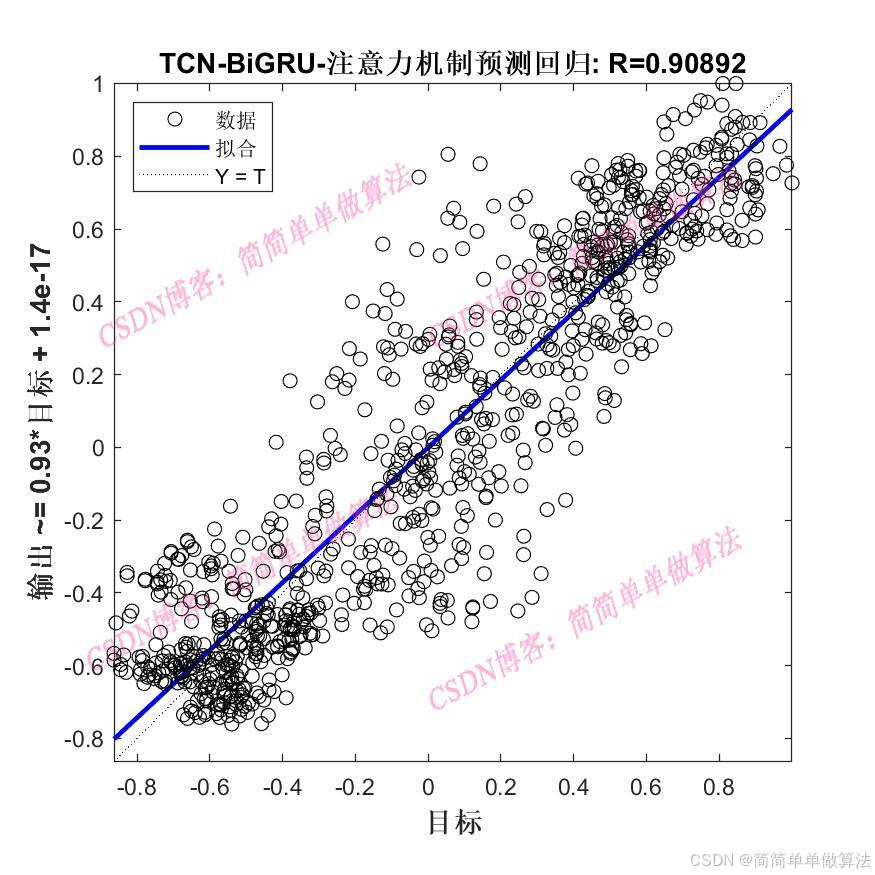

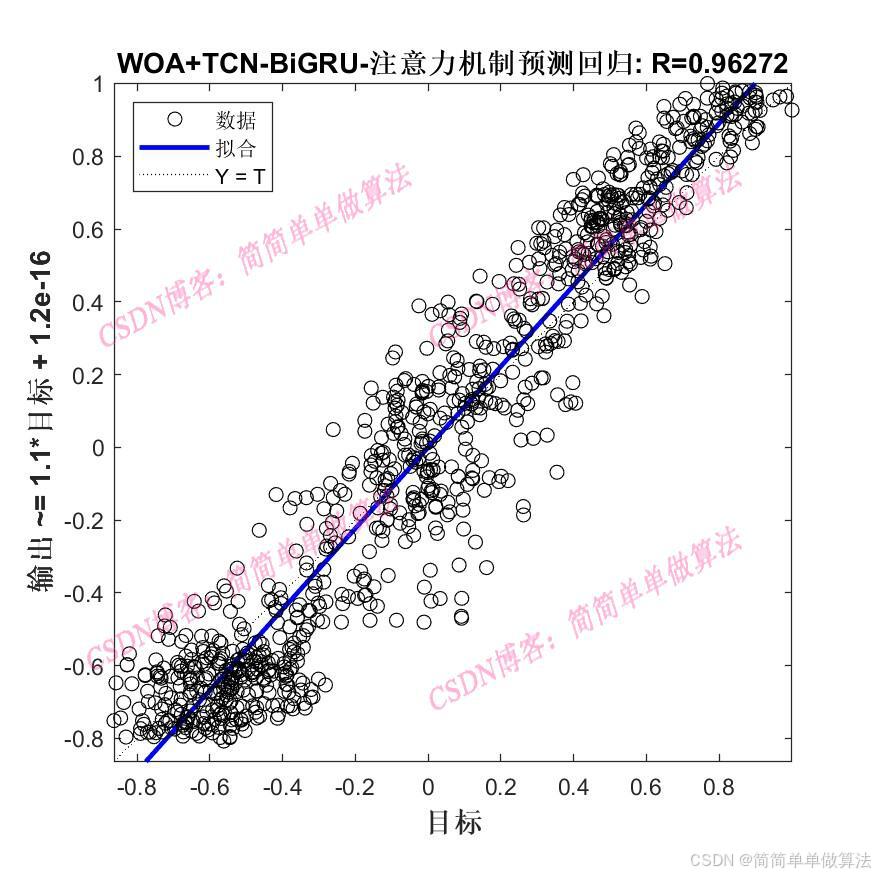

1.算法運行效果圖預覽

2.算法運行軟件版本

3.部分核心程序

4.算法理論概述

5.算法完整程序工程

1.算法運行效果圖預覽

(完整程序運行后無水印)

2.算法運行軟件版本

matlab2022a/matlab2024b

3.部分核心程序

(完整版代碼包含詳細中文注釋和操作步驟視頻)

..................................................................%設置網絡參數

%卷積核

Nfilter = floor(X(1));%8;

%卷積核大小

Sfilter = floor(X(2));%5;

%丟失因子

drops = X(3);%0.025;

%殘差塊

Nblocks = floor(X(4));%4;

%特征個數

Nfeats = Dims; %設置網絡參數

lgraph=func_layers2(Dims,Dimso,X);%參數設置

options = trainingOptions("adam",... 'InitialLearnRate',X(5),... 'MaxEpochs',500,... 'miniBatchSize',2,... 'Plots','training-progress',... 'Verbose', false); %訓練

[net,INFO] = trainNetwork(Ptrain_reshape, Ttrain_reshape, lgraph, options);Rerr = INFO.TrainingRMSE;

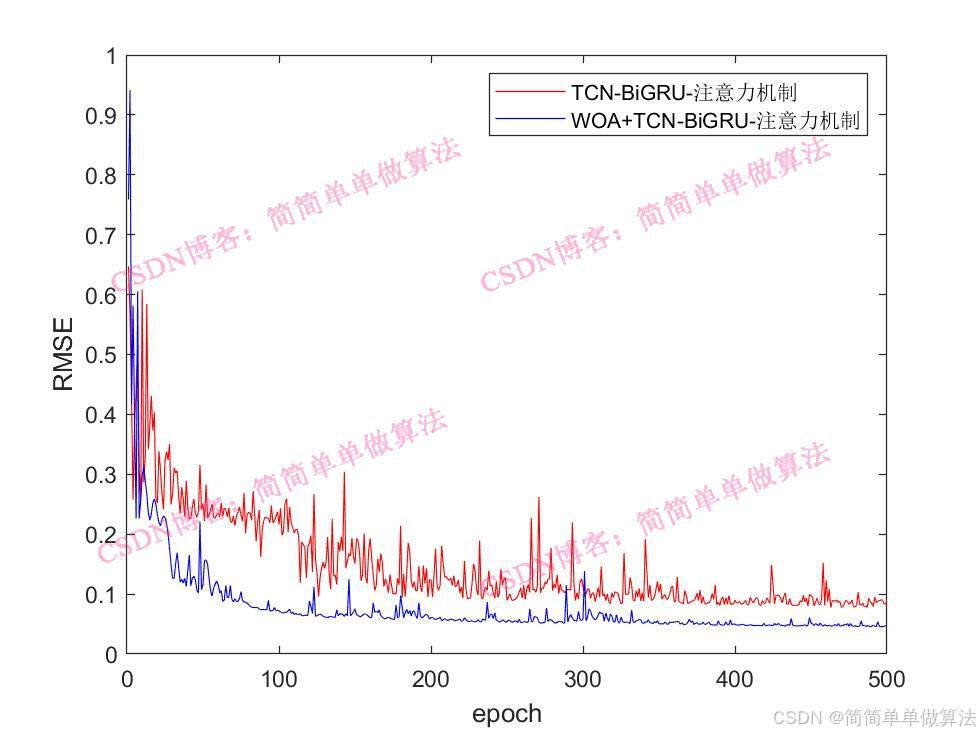

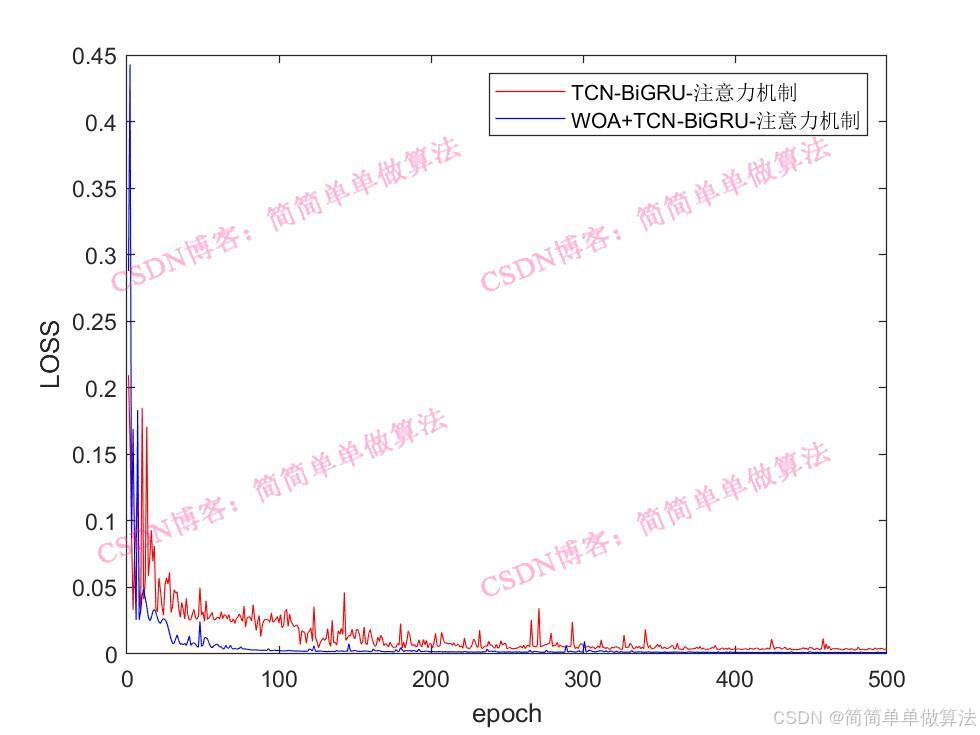

Rlos = INFO.TrainingLoss;figure

subplot(211)

plot(Rerr)

xlabel('迭代次數')

ylabel('RMSE')

grid onsubplot(212)

plot(Rlos)

xlabel('迭代次數')

ylabel('LOSS')

grid on%仿真預測

tmps = predict(net, Ptest_reshape );

T_pred = double(tmps{1, 1});

%反歸一化

T_pred =T_pred-mean(T_pred);

T_pred =T_pred/max(abs(T_pred));

%反歸一化

% T_pred = mapminmax('reverse', T_pred, vmax2);

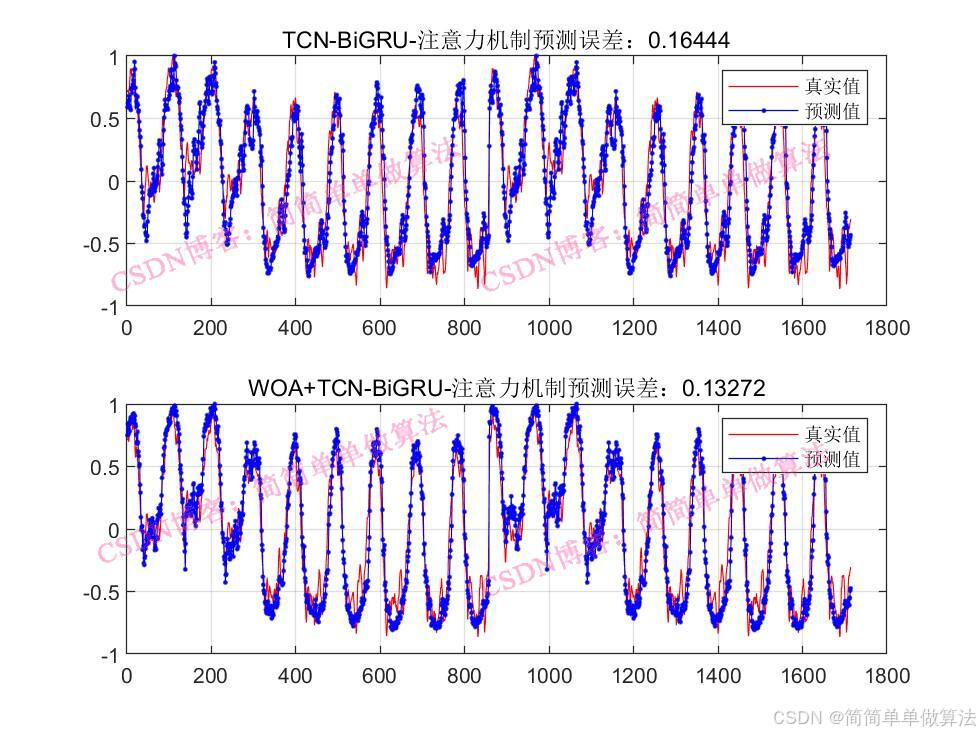

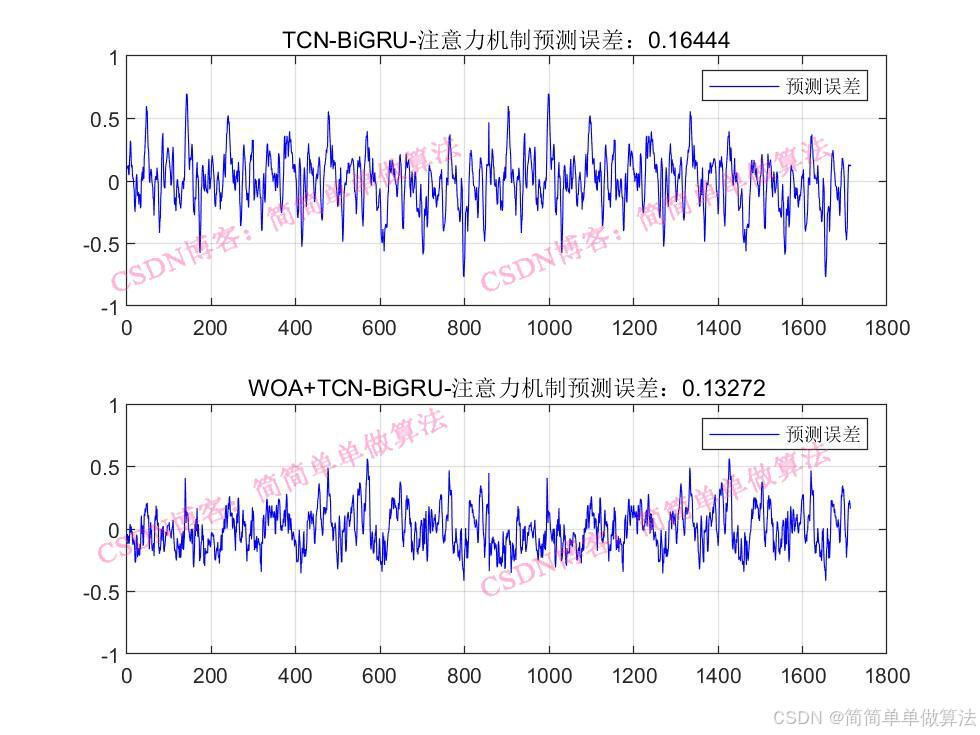

ERR = mean(abs(T_test-T_pred));

ERRfigure

plot(T_test, 'b','LineWidth', 1)

hold on

plot(T_pred, 'r','LineWidth', 1)

legend('真實值','預測值')

xlabel('預測樣本')

ylabel('預測結果')

grid onfigure

plotregression(T_test,T_pred,['回歸']);save R2.mat Rerr Rlos T_test T_pred ERR

2164.算法理論概述

? ? ? ? TCN主要由因果卷積層、擴張卷積和殘差連接構成。因果卷積保證了模型在時間序列上的因果關系,即當前時刻的輸出僅依賴于過去時刻的輸入,符合時間序列的特性。擴張卷積通過增加卷積核的間隔來擴大感受野,能以較少的層數捕捉到長距離的時間依賴關系。殘差連接則有助于緩解梯度消失問題,加快模型的收斂速度。

? ? ? GRU是循環神經網絡(RNN)的一種改進變體,通過門控機制來控制信息的流動,解決了 RNN中梯度消失的問題。BiGRU則是由前向GRU和后向GRU組成,能夠同時從正向和反向兩個方向對時間序列進行處理,從而更好地捕捉時間序列中的長期依賴關系和上下文信息。 ? ??

? ? ? ?注意力機制的核心思想是讓模型在處理時間序列時,能夠自動學習到不同時間步的重要程度,為不同的時間步分配不同的權重,從而突出關鍵時間步的特征信息,提高模型的預測精度。? ? ? ?

? ? ? ?在本系統中,根據個體所代表的超參數組合,構建相應的 TCN-BiGRU 注意力機制網絡模型。先搭建 TCN 層,確定因果卷積、擴張卷積和殘差連接的參數;再搭建 BiGRU 層,設置隱藏單元數量和層數等;最后添加注意力機制層,確定相關權重矩陣等參數。

5.算法完整程序工程

OOOOO

OOO

O

啟用usart串口)