一、引言:數據導出的演進驅動力

????????在數字化時代,數據導出功能已成為企業數據服務的基礎能力。隨著數據規模從GB級向TB級甚至PB級發展,傳統導出方案面臨三大核心挑戰:

- ?數據規模爆炸?:單次導出數據量從萬級到億級的增長

- ?業務需求多樣化?:實時導出、增量同步、跨云傳輸等新場景

- ?系統穩定性要求?:避免導出作業影響在線業務

????????本文將基于Java技術棧,通過架構演進視角解析不同階段的解決方案,特別結合阿里EasyExcel等開源工具的最佳實踐。

二、基礎方案演進

1. 全量內存加載(原始階段)

?實現思想?:

- 一次性加載全量數據到內存

- 直接寫入輸出文件

// 反模式:全量內存加載

public void exportAllToExcel() {List<Data> allData = jdbcTemplate.query("SELECT * FROM big_table", rowMapper);EasyExcel.write("output.xlsx").sheet().doWrite(allData); // OOM風險點

}?優缺點?:

- ? 實現簡單直接

- ? 內存溢出風險

- ? 數據庫長事務問題

?適用場景?:開發測試環境,數據量<1萬條

2. 分頁流式處理(安全邊界)

?實現思想?:

- 分頁查詢控制單次數據量

- 流式寫入避免內存堆積

// EasyExcel分頁流式寫入

public void exportByPage(int pageSize) {ExcelWriter excelWriter = null;try {excelWriter = EasyExcel.write("output.xlsx").build();for (int page = 0; ; page++) {List<Data> chunk = jdbcTemplate.query("SELECT * FROM big_table LIMIT ? OFFSET ?",rowMapper, pageSize, page * pageSize);if (chunk.isEmpty()) break;excelWriter.write(chunk, EasyExcel.writerSheet("Sheet1").build());}} finally {if (excelWriter != null) {excelWriter.finish();}}

}?優化點?:

- 采用游標分頁替代LIMIT/OFFSET(基于ID范圍查詢)

- 添加線程休眠避免數據庫壓力過大

?適用場景?:生產環境,1萬~100萬條數據

三、高級方案演進

1. 異步離線導出

?架構設計?:

[ API請求 ] → [ 消息隊列 ] → [ Worker 消費 ] → [ 分布式存儲 ] → [ 通知下載 ]

?關鍵實現?:

// Spring Boot集成示例

@RestController

public class ExportController {@Autowiredprivate JobLauncher jobLauncher;@Autowiredprivate Job exportJob;@PostMapping("/export")public ResponseEntity<String> triggerExport() {JobParameters params = new JobParametersBuilder().addLong("startTime", System.currentTimeMillis()).toJobParameters();jobLauncher.run(exportJob, params);return ResponseEntity.accepted().body("導出任務已提交");}

}// EasyExcel批處理Writer

public class ExcelItemWriter implements ItemWriter<Data> {@Overridepublic void write(List<? extends Data> items) {String path = "/data/export_" + System.currentTimeMillis() + ".xlsx";EasyExcel.write(path).sheet().doWrite(items);}

}?優缺點?:

- ? 資源隔離,不影響主業務

- ? 支持失敗重試

- ? 時效性較差(分鐘級)

?適用場景?:百萬級數據,對實時性要求不高的后臺作業

2. 堆外內存優化方案

?實現思想?:

- 使用ByteBuffer分配直接內存

- 通過內存映射文件實現零拷貝

- 結合分頁查詢構建雙緩沖機制

public class OffHeapExporter {private static final int BUFFER_SIZE = 64 * 1024 * 1024; // 64MB/緩沖區public void export(String filePath) throws IOException {// 1. 初始化堆外緩沖區ByteBuffer buffer = ByteBuffer.allocateDirect(BUFFER_SIZE);// 2. 創建文件通道(NIO)try (FileChannel channel = FileChannel.open(Paths.get(filePath), StandardOpenOption.CREATE, StandardOpenOption.WRITE)) {// 3. 分頁填充+批量寫入while (hasMoreData()) {buffer.clear(); // 重置緩沖區fillBufferFromDB(buffer); // 從數據庫分頁讀取buffer.flip(); // 切換為讀模式channel.write(buffer); // 零拷貝寫入}}}private void fillBufferFromDB(ByteBuffer buffer) {// 示例:分頁查詢填充邏輯List<Data> chunk = jdbcTemplate.query("SELECT * FROM table WHERE id > ? LIMIT 10000",rowMapper, lastId);chunk.forEach(data -> {byte[] bytes = serialize(data);if (buffer.remaining() < bytes.length) {buffer.flip(); // 立即寫入已填充數據channel.write(buffer);buffer.clear();}buffer.put(bytes);});}

}方案優缺點

| 優勢 | 局限性 |

| ? 規避GC停頓(實測降低90%以上) | ?? 需手動管理內存釋放 |

| ? 提升吞吐量(實測提升30%~50%) | ?? 存在內存泄漏風險 |

| ? 支持更大數據量(突破JVM堆限制) | ?? 調試工具支持較少 |

| ? 減少CPU拷貝次數(DMA技術) | ?? 需處理字節級操作 |

適用場景

- ?數據規模?

- 單次導出數據量 > 500萬條

- 單文件大小 > 1GB

- ?性能要求?

- 要求導出P99延遲 < 1s

- 系統GC停頓敏感場景

- ?特殊環境?

- 容器環境(受限堆內存)

- 需要與Native庫交互的場景

四、進階方案詳解

方案1:Spark分布式導出

?實現步驟?:

- 數據準備:將源數據加載為Spark DataFrame

- 轉換處理:執行必要的數據清洗

- 輸出生成:分布式寫入Excel

// Spark+EasyExcel集成方案

public class SparkExportJob {public static void main(String[] args) {SparkSession spark = SparkSession.builder().appName("DataExport").getOrCreate();// 讀取數據源Dataset<Row> df = spark.read().format("jdbc").option("url", "jdbc:mysql://host:3306/db").option("dbtable", "source_table").load();// 轉換為POJO列表List<Data> dataList = df.collectAsList().stream().map(row -> convertToData(row)).collect(Collectors.toList());// 使用EasyExcel寫入EasyExcel.write("hdfs://output.xlsx").sheet("Sheet1").doWrite(dataList);}

}?注意事項?:

- 大數據量時建議先輸出為Parquet再轉換

- 需要合理設置executor內存

?適用場景?:

- 數據規模:TB級結構化/半結構化數據

- 典型業務:全庫歷史數據遷移、跨數據源合并報表

方案2:CDC增量導出

?架構圖?:

[ MySQL ] → [ Debezium ] → [ Kafka ] → [ Flink ] → [ Excel ]

?實現步驟:

- ?數據捕獲?

- MySQL事務提交觸發binlog生成

- Debezium解析binlog,提取變更事件并轉為JSON/Avro格式

- ?隊列緩沖?

- Kafka按"庫名.表名"創建Topic

- 主鍵哈希分區保證同一主鍵事件有序

- ?流處理?

- Flink消費Kafka數據,每小時滾動窗口聚合

- 通過狀態管理實現主鍵去重和版本覆蓋

- ?文件輸出?

- 觸發式生成Excel文件(行數超100萬或超1小時滾動)

- 計算CRC32校驗碼并保存斷點位置

- ?容錯機制?

- 異常數據轉入死信隊列

- 校驗失敗時自動重試最近3次Checkpoint

關鍵代碼?:

// Flink處理CDC事件

public class CdcExportJob {public static void main(String[] args) throws Exception {StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();KafkaSource<String> source = KafkaSource.<String>builder().setBootstrapServers("kafka:9092").setTopics("cdc_events").setDeserializer(new SimpleStringSchema()).build();env.fromSource(source, WatermarkStrategy.noWatermarks(), "Kafka Source").process(new ProcessFunction<String, Data>() {@Overridepublic void processElement(String json, Context ctx, Collector<Data> out) {Data data = parseChangeEvent(json);if (data != null) {out.collect(data);}}}).addSink(new ExcelSink());env.execute("CDC Export");}

}// 自定義Excel Sink

class ExcelSink extends RichSinkFunction<Data> {private transient ExcelWriter writer;@Overridepublic void open(Configuration parameters) {writer = EasyExcel.write("increment_export.xlsx").build();}@Overridepublic void invoke(Data value, Context context) {writer.write(Collections.singletonList(value), EasyExcel.writerSheet("Sheet1").build());}@Overridepublic void close() {if (writer != null) {writer.finish();}}

}適用場景?:

- 數據規模:高頻更新的百萬級數據

- 典型業務:實時訂單導出、財務流水同步

五、架構視角總結

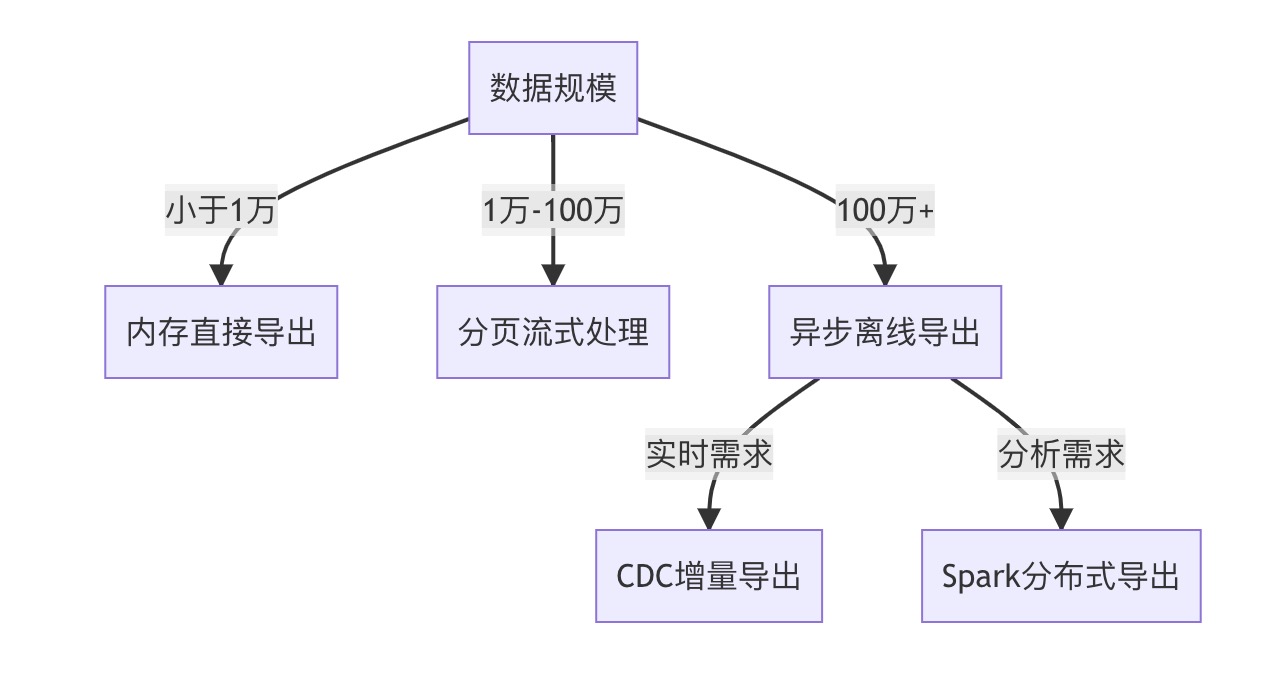

?架構選型建議?:

- ?成本敏感型?:分頁流式+EasyExcel組合性價比最高

- ?實時性要求?:CDC方案配合Flink實現秒級延遲

- ?超大規模數據?:采用Spark分布式處理+分階段存儲

通過架構的持續演進,數據導出能力從簡單的功能實現發展為完整的技術體系。建議企業根據自身業務發展階段,選擇合適的演進路徑實施。

)

)

)

{ :|: };:)

Java/python/JavaScript/C/C++/GO最佳實現)